简介:Scrapy是Python中强大的网络爬虫框架,提供高效的数据抓取、解析和存储工具。本文详细介绍了在Python 2.7环境下(推荐2.7.8版本)如何安装Scrapy,包括Python环境配置、pip包管理器的使用、Scrapy的安装与验证方法。同时涵盖Scrapy项目创建、Spider编写、核心组件(如Item、Pipeline、Selector等)的应用及中间件和设置文件的配置,帮助开发者快速上手并构建完整的数据采集系统。

1. Scrapy框架简介与核心应用场景

Scrapy框架概述

Scrapy是一个基于Python的高性能异步爬虫框架,专为大规模网页抓取和结构化数据提取设计。其核心采用Twisted异步网络引擎,支持高并发请求处理,极大提升爬取效率。

核心架构与设计理念

框架遵循“组件化+数据流驱动”设计原则,包含Spider、Item、Pipeline、Downloader、Scheduler等模块,各组件通过引擎协同工作,实现请求调度、页面解析、数据清洗到持久化输出的全流程自动化。

典型应用场景

广泛应用于搜索引擎索引构建、电商价格动态监控、社交媒体舆情分析、学术论文聚合等领域。例如,可通过定义规则定时抓取京东商品页价格变动,或采集微博话题评论用于情感分析。

# 示例:一个极简的Scrapy Spider骨架

import scrapy

class PriceMonitorSpider(scrapy.Spider):

name = 'price_bot'

start_urls = ['https://example-shop.com/products']

def parse(self, response):

for item in response.css('.product-item'):

yield {

'title': item.css('h3::text').get(),

'price': float(item.css('.price::text').re_first(r'\d+\.\d+'))

}

执行逻辑说明 :该Spider发起初始请求,使用CSS选择器提取产品名称与价格,并以字典形式

yield输出,自动进入后续Pipeline处理链。

为何选择Scrapy?

相比requests + BeautifulSoup的手动轮询方式,Scrapy内置去重机制、异常重试、中间件扩展、分布式支持(配合Scrapy-Redis),大幅降低开发维护成本,是Python生态中功能最完备的爬虫解决方案之一。

2. 开发环境搭建与依赖管理

在构建一个高效、稳定且可维护的Scrapy爬虫项目之前,首要任务是搭建一个干净、可控的开发环境。Python作为一门解释型语言,其灵活性带来了版本兼容性和依赖冲突的风险。特别是在涉及复杂第三方库(如Twisted、lxml等)时,若未进行合理的环境隔离与依赖管理,极易导致安装失败或运行异常。因此,本章将系统性地介绍从Python运行环境配置到虚拟环境隔离、包管理工具初始化,再到常见安装问题排查的完整流程,帮助开发者建立标准化的Scrapy前期准备体系。

良好的开发环境不仅是技术实现的前提,更是团队协作和持续集成的基础。通过科学的依赖管理策略,可以确保不同操作系统、不同开发人员之间的环境一致性,降低“在我机器上能跑”的问题发生概率。同时,合理使用虚拟环境还能避免全局Python环境中因多个项目共用依赖而引发的版本冲突。接下来的内容将以实战为导向,深入剖析每一个关键步骤的技术细节,并提供可复用的操作范式。

2.1 Python运行环境配置

Python是Scrapy框架的底层运行语言,选择合适的Python版本并正确配置运行环境是整个开发流程的第一步。虽然当前主流趋势已转向Python 3.x系列,但在某些历史遗留项目或特定第三方库支持场景下,仍需考虑对旧版本的支持。然而,在实际应用中, 推荐优先使用Python 3.7及以上版本 以获得更好的性能、安全更新和生态支持。尽管目录中提及Python 2.7.8,但出于技术演进与安全性考量,此处将以现代实践为主导,结合历史背景说明其必要性边界。

2.1.1 选择并安装Python 2.7.8版本的必要性

尽管Python 2已于2020年正式停止维护(EOL),部分老旧项目仍依赖于Python 2.7.x版本运行。尤其是在企业内部尚未完成迁移的历史系统中,Scrapy早期版本也曾广泛基于该环境部署。选择Python 2.7.8的主要原因包括:

- 兼容性需求 :一些陈旧的第三方库仅支持Python 2,无法在Python 3环境下正常工作。

- 遗留代码维护 :已有大量基于Python 2编写的爬虫脚本需要继续运行,短期内难以重构。

- 特定平台限制 :某些嵌入式设备或服务器操作系统默认搭载Python 2。

然而,这些理由不应成为新项目的首选依据。Python 2缺乏Unicode原生支持、语法冗余、安全性低等问题严重影响开发效率与系统稳定性。Scrapy官方早已全面支持Python 3,并建议所有新项目采用Python 3.6+版本。

| 版本 | 是否推荐用于新项目 | 主要用途 |

|---|---|---|

| Python 2.7.8 | ❌ 不推荐 | 维护旧系统 |

| Python 3.6+ | ✅ 强烈推荐 | 新项目开发 |

graph TD

A[开始环境配置] --> B{目标项目类型}

B -->|新项目| C[安装Python 3.8+]

B -->|维护旧项目| D[安装Python 2.7.8]

C --> E[设置PATH环境变量]

D --> E

E --> F[验证python --version]

上述流程图展示了根据项目类型选择Python版本的决策路径,强调了版本选择应基于实际业务需求而非盲目沿用旧标准。

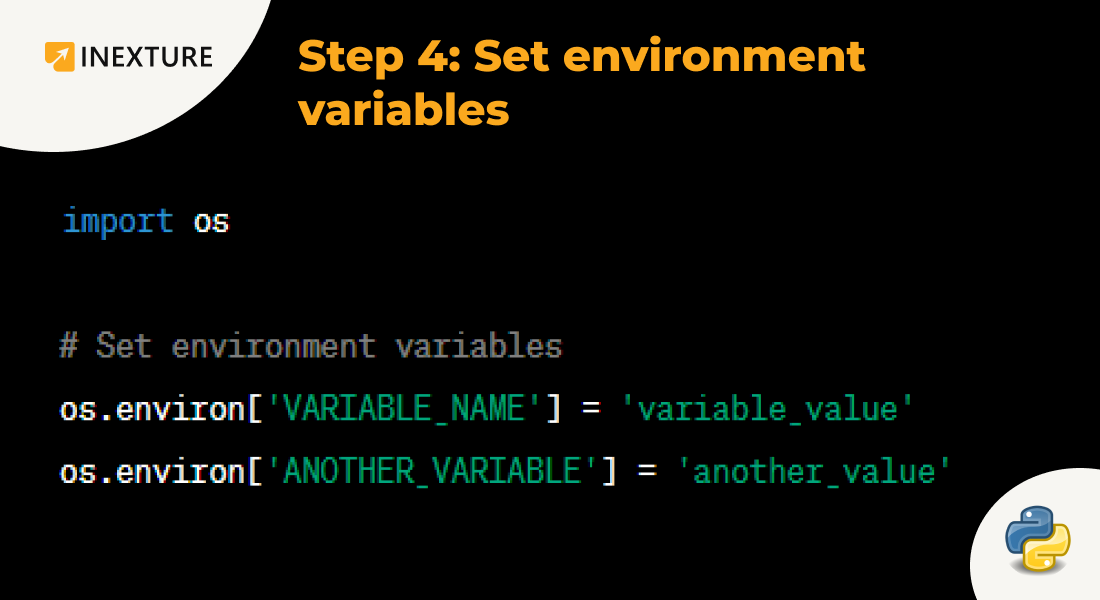

2.1.2 环境变量设置与命令行调用验证

无论使用Windows还是类Unix系统(Linux/macOS),都必须将Python可执行文件路径添加至系统 PATH 环境变量中,以便在任意目录下通过命令行调用 python 指令。

Windows系统配置方法:

- 安装Python时勾选“Add Python to PATH”选项;

- 若未勾选,则手动进入“系统属性 → 高级 → 环境变量”,在“用户变量”或“系统变量”中的

Path条目末尾追加:

C:\Python27;C:\Python27\Scripts - 打开CMD终端,执行:

bash python --version

输出示例:

Python 2.7.8

类Unix系统(Linux/macOS)配置方法:

通常通过包管理器安装即可自动注册路径:

# Ubuntu/Debian

sudo apt-get install python2.7

# macOS 使用 Homebrew

brew install python@2

# 检查版本

python2 --version

注意:在现代macOS中,

python命令默认指向Python 2.7,但强烈建议显式使用python3以避免混淆。

参数说明与逻辑分析:

-

--version参数用于输出当前Python解释器的版本信息; - 若提示

'python' is not recognized,说明PATH未正确配置; - 推荐使用

where python(Windows)或which python(Unix)定位可执行文件位置。

import sys

print("Python路径:", sys.executable)

print("版本信息:", sys.version)

上述Python代码可用于程序内检查当前解释器路径与版本详情,适用于调试多环境切换问题。

该步骤虽看似简单,却是后续所有操作的基础。一旦环境变量配置错误,可能导致pip安装失败、IDE无法识别解释器等一系列连锁问题。因此,务必在每台开发机上逐一验证。

2.2 pip包管理工具的安装与初始化

pip 是Python官方推荐的包管理工具,负责从PyPI(Python Package Index)下载、安装、升级和卸载第三方库。它是Scrapy安装过程中不可或缺的核心组件。然而,并非所有Python发行版都默认包含pip,尤其在较早版本或自定义编译的环境中,需手动安装。

2.2.1 获取get-pip.py脚本并执行安装流程

对于没有预装pip的环境,可通过官方提供的 get-pip.py 引导脚本来完成安装。

操作步骤如下:

-

下载脚本:

bash curl https://bootstrap.pypa.io/get-pip.py -o get-pip.py

或访问 https://bootstrap.pypa.io/get-pip.py 手动保存。 -

执行安装:

bash python get-pip.py -

安装完成后,系统会生成

pip命令,通常位于:

- Windows:C:\Python27\Scripts\pip.exe

- Unix:/usr/local/bin/pip

代码块解析 :

bash curl https://bootstrap.pypa.io/get-pip.py -o get-pip.py

curl:发起HTTP请求获取远程文件;-o get-pip.py:指定输出文件名;- URL来源为PyPA(Python Packaging Authority)官方托管地址,确保安全性;

bash python get-pip.py

- 使用当前Python解释器执行脚本;

- 脚本内部检测系统架构、操作系统类型,并自动安装

pip、setuptools、wheel三个核心工具;- 支持代理配置(可通过

--proxy参数传入)。

2.2.2 升级pip至最新版本以确保安全性与功能完整性

由于早期pip存在安全漏洞(如CVE-2018-20225),强烈建议安装后立即升级至最新版:

pip install --upgrade pip

验证升级结果:

pip --version

输出示例:

pip 23.3.1 from /usr/local/lib/python3.9/site-packages/pip (python 3.9)

| 命令 | 功能 |

|---|---|

pip install --upgrade pip | 升级pip自身 |

pip install --upgrade setuptools wheel | 同步升级依赖工具 |

注意 :在某些受限环境中(如公司内网),可能需要配置镜像源加速下载,例如使用清华TUNA镜像:

bash pip install --upgrade pip -i https://pypi.tuna.tsinghua.edu.cn/simple/

2.2.3 验证pip是否正常工作(pip list / pip help)

安装完成后,需验证pip能否正常使用:

# 查看已安装包列表

pip list

# 显示帮助文档

pip help

# 搜索远程包(可选)

pip search scrapy

注:

pip search功能因PyPI API限流已于2020年禁用,现可通过 Trove分类页面 替代。

sequenceDiagram

participant User

participant Terminal

participant PyPI

User->>Terminal: pip install scrapy

Terminal->>PyPI: 查询scrapy元数据

PyPI-->>Terminal: 返回版本与依赖信息

Terminal->>Terminal: 解析依赖树

Terminal->>PyPI: 下载whl或sdist包

Terminal->>LocalEnv: 安装至site-packages

Terminal-->>User: 安装成功提示

上述序列图清晰展示了pip安装包的全过程,突出了其依赖解析与远程交互能力。

此阶段的成功标志是能够在终端中无报错地执行 pip list 并返回已安装模块列表。若出现 No module named pip 错误,请检查Python安装路径及Scripts目录是否加入PATH。

2.3 虚拟环境的创建与隔离(可选但推荐)

随着项目数量增加,不同项目可能依赖同一库的不同版本(如Scrapy 1.x vs 2.x),直接在全局环境中安装会导致严重冲突。为此,Python提供了虚拟环境机制,实现项目级依赖隔离。

2.3.1 使用virtualenv实现项目依赖独立

virtualenv 是最经典的虚拟环境工具,支持跨平台创建独立Python运行空间。

安装virtualenv:

pip install virtualenv

创建虚拟环境:

virtualenv venv_scrapy_project

此命令会在当前目录下生成名为

venv_scrapy_project的文件夹,包含独立的Python解释器、pip和site-packages目录。

结构示意:

venv_scrapy_project/

├── bin/ # Linux/macOS 可执行文件

│ ├── python

│ └── pip

├── Scripts/ # Windows 可执行文件

│ ├── python.exe

│ └── pip.exe

├── lib/

└── include/

表格:虚拟环境核心目录说明

| 目录 | 作用 |

|---|---|

bin/ 或 Scripts/ | 存放独立的python、pip等命令 |

lib/ | 存储该项目专属的第三方库 |

include/ | C扩展头文件(用于编译) |

2.3.2 激活与退出虚拟环境的操作指令

激活虚拟环境后,所有 python 和 pip 命令均指向隔离环境。

Windows激活:

venv_scrapy_project\Scripts\activate

Linux/macOS激活:

source venv_scrapy_project/bin/activate

激活成功后,命令行前缀将显示环境名称:

(venv_scrapy_project) $

退出环境:

deactivate

代码逻辑说明 :

source命令加载激活脚本,临时修改PATH变量,使pip优先指向虚拟环境下的可执行文件;deactivate函数恢复原始PATH,解除绑定;- 整个过程不影响全局Python环境。

2.3.3 在隔离环境中安装Scrapy避免全局污染

激活环境后,即可安全安装Scrapy:

(venv_scrapy_project) $ pip install scrapy

此时安装的所有依赖(如Twisted、parsel等)都将被限定在 venv_scrapy_project 目录内,不会影响其他项目或系统级Python。

优势总结:

- ✅ 防止依赖冲突

- ✅ 支持多版本共存

- ✅ 易于打包部署(可通过

requirements.txt重建环境)

生成依赖清单:

pip freeze > requirements.txt

该文件可用于CI/CD自动化部署或团队共享。

2.4 常见安装问题排查指南

即使遵循上述流程,Scrapy安装仍可能遇到各种底层依赖编译问题,尤其是涉及C扩展的库(如lxml、Twisted)。以下列出典型错误及其解决方案。

2.4.1 解决Microsoft Visual C++缺失错误

在Windows上安装含C扩展的包时,常出现如下错误:

error: Microsoft Visual C++ 14.0 or greater is required

这是因为Python包需编译C代码,而系统缺少对应编译器。

解决方案 :

-

安装 Microsoft C++ Build Tools :

- 访问 https://visualstudio.microsoft.com/visual-cpp-build-tools/

- 安装“C++ build tools”组件 -

或安装完整版Visual Studio Community(免费)

-

替代方案:使用预编译wheel包(见下一节)

2.4.2 处理lxml、Twisted等底层依赖编译失败问题

lxml 和 Twisted 是Scrapy的关键依赖,但因其包含C模块,在无编译环境时易失败。

典型报错:

Failed building wheel for lxml

根本原因 :缺少XML/XSLT库头文件(如libxml2, libxslt)

解决方案 :

-

Windows用户 :优先使用预编译

.whl文件

bash pip install --only-binary=all lxml -

Linux用户 :安装系统级依赖

```bash

# Ubuntu/Debian

sudo apt-get install libxml2-dev libxslt-dev python-dev

# CentOS/RHEL

sudo yum install libxml2-devel libxslt-devel python-devel

```

- macOS用户 :

bash brew install libxml2 libxslt export LDFLAGS="-L$(brew --prefix libxml2)/lib" export CPPFLAGS="-I$(brew --prefix libxml2)/include" pip install lxml

2.4.3 使用预编译wheel包加速安装过程

Wheel( .whl )是一种预编译的二进制分发格式,避免现场编译,大幅提升安装速度与成功率。

查找并安装wheel包:

# 启用二进制优先策略

pip install --prefer-binary scrapy

# 或手动下载whl文件(适用于离线环境)

# 访问 https://www.lfd.uci.edu/~gohlke/pythonlibs/

# 下载对应版本的whl,例如:

# twisted‑22.10.0‑cp39‑cp39‑win_amd64.whl

pip install twisted‑22.10.0‑cp39‑cp39‑win_amd64.whl

参数说明 :

--prefer-binary:优先使用二进制包而非源码包;cp39表示CPython 3.9;win_amd64表示Windows 64位系统;错误匹配版本会导致

Unsupported platform报错。

最终安装命令推荐:

pip install scrapy --prefer-binary -i https://pypi.tuna.tsinghua.edu.cn/simple/

结合国内镜像源与二进制优先策略,极大提升成功率。

flowchart LR

A[开始安装Scrapy] --> B{是否有编译环境?}

B -->|是| C[直接pip install]

B -->|否| D[使用--prefer-binary]

D --> E[下载预编译whl]

E --> F[安装成功]

C --> F

F --> G[验证import scrapy]

流程图展示了两种安装路径的选择逻辑,指导开发者根据环境条件做出最优决策。

综上所述,开发环境的搭建不仅仅是“安装几个软件”那么简单,它涉及版本控制、依赖解析、权限管理、网络优化等多个层面。只有建立起规范化的初始化流程,才能为后续Scrapy项目的顺利开发奠定坚实基础。

3. Scrapy框架安装与组件解析

Scrapy作为Python生态中最成熟、最高效的网页爬虫框架之一,其强大不仅体现在开发效率上,更在于其高度模块化和可扩展的架构设计。要真正掌握Scrapy,仅仅完成安装是远远不够的,必须深入理解其内部核心组件的职责划分以及它们之间的协同机制。本章将从基础安装入手,逐步展开对Scrapy各核心组件的功能剖析,并结合实际代码示例与系统流程图,揭示数据在框架中流动的完整路径。通过这一过程,读者不仅能建立起对Scrapy运行机制的清晰认知,还能为后续自定义爬虫逻辑、优化性能及实现复杂抓取策略打下坚实的技术基础。

3.1 使用pip安装Scrapy主程序

Python包管理工具 pip 是现代Python开发不可或缺的一环,尤其在处理像Scrapy这样依赖众多底层库的大型框架时, pip 能够自动解析并安装所有必需的依赖项,极大简化了部署流程。使用 pip 安装Scrapy是最常见且推荐的方式,适用于大多数操作系统环境。

3.1.1 执行pip install Scrapy命令详解

安装Scrapy最直接的方法是在终端或命令行中执行以下命令:

pip install scrapy

该命令会触发 pip 从Python Package Index (PyPI) 下载最新版本的Scrapy及其所有依赖包,并按照依赖关系依次安装。由于Scrapy本身并不包含HTTP客户端、HTML解析器等底层功能模块,而是依赖于一系列独立的第三方库,因此 pip 会在后台自动拉取这些依赖。

执行逻辑说明:

-

pip首先查询PyPI服务器获取scrapy包的元信息。 - 解析

setup.py中的install_requires字段,识别出所有直接依赖(如Twisted、parsel、w3lib、lxml等)。 - 按照依赖层级顺序下载并安装每个包。

- 编译必要的C扩展(如lxml),并将Python模块写入当前Python环境的

site-packages目录。 - 最后注册可执行脚本

scrapy到系统的PATH路径中,使得用户可以在任意位置调用scrapy startproject等命令。

⚠️ 注意:若未启用虚拟环境,此操作将影响全局Python环境,可能导致不同项目间的依赖冲突。建议始终在

virtualenv或venv环境中进行安装。

参数说明与扩展配置

| 参数 | 作用 |

|---|---|

--user | 将包安装到用户本地目录,避免需要管理员权限 |

-i <index-url> | 指定镜像源(如清华、阿里云)加速下载 |

--no-cache-dir | 禁用缓存,强制重新下载 |

--force-reinstall | 强制重装已存在的包 |

例如,使用国内镜像源加快安装速度:

pip install scrapy -i https://pypi.tuna.tsinghua.edu.cn/simple --trusted-host pypi.tuna.tsinghua.edu.cn

这在企业内网或网络受限环境下尤为实用。

3.1.2 自动安装依赖项说明(如Twisted、pyOpenSSL、parsel等)

Scrapy并非“单体”框架,而是一个由多个精心设计的子库组成的生态系统。以下是其关键依赖项及其作用解析:

| 依赖库 | 功能描述 | 是否必需 |

|---|---|---|

| Twisted | 异步网络引擎,提供非阻塞I/O支持,支撑高并发请求 | ✅ 必需 |

| parsel | 基于lxml和cssselect的HTML/XML选择器库,支持XPath/CSS语法 | ✅ 必需 |

| w3lib | 提供URL规范化、字符编码检测、HTML内容清理等功能 | ✅ 必需 |

| lxml | 高性能XML/HTML解析库,底层基于libxml2 | ✅ 必需 |

| pyOpenSSL | 实现TLS/SSL加密通信,用于HTTPS请求安全传输 | 推荐 |

| cryptography | 加密算法支持库,配合pyOpenSSL使用 | 推荐 |

| zope.interface | 提供接口定义机制,增强组件解耦能力 | ✅ 必需 |

| protego | robots.txt规则解析器,遵守网站爬取协议 | ✅ 必需 |

其中, Twisted 是整个Scrapy异步架构的核心驱动力。它采用事件循环(Reactor Pattern)模型,允许同时发起成千上万个HTTP请求而不阻塞主线程。这种设计使Scrapy能够在资源有限的情况下实现极高的吞吐量。

3.1.3 安装进度监控与中断恢复策略

在实际安装过程中,尤其是在网络不稳定或依赖较多的环境中,可能会遇到下载中断、编译失败等问题。了解如何监控安装状态并采取恢复措施至关重要。

安装过程可视化

pip 默认输出详细的安装日志,包括:

- 正在下载的包名与版本

- 当前进度条(百分比)

- 已缓存或跳过的包

- 编译阶段的日志(尤其是C扩展)

可通过添加 -v (verbose)参数增强输出信息:

pip install scrapy -v

中断后的恢复机制

当安装因网络问题中断时, pip 具备一定的容错能力:

- 部分完成的包会被标记为损坏 ,下次安装时自动重试。

- wheel包优先使用 :如果某个依赖已有预编译的

.whl文件,pip会优先下载而非源码构建,减少编译失败风险。 - 缓存复用 :成功下载但尚未安装的包保留在缓存中,默认路径为:

~/.cache/pip # Linux/macOS %LOCALAPPDATA%\pip\Cache # Windows

故障恢复建议

- 使用

--retries N设置重试次数(默认5次):

bash pip install scrapy --retries 10 - 启用

--timeout防止长时间无响应:

bash pip install scrapy --timeout 60 - 若频繁失败,考虑离线安装:先在有网机器上下载所有依赖:

bash pip download scrapy -d ./scrapy-deps

然后在目标机器上离线安装:

bash pip install --find-links ./scrapy-deps --no-index scrapy

3.2 Scrapy核心组件体系结构

Scrapy之所以被称为“全栈式”爬虫框架,是因为它内置了一整套完整的数据采集流水线,涵盖了从请求发送、页面解析、数据封装到持久化存储的全过程。这一切都建立在其六大核心组件之上,彼此分工明确、松耦合协作。

3.2.1 Spider爬虫类:定义初始URL与解析逻辑入口

Spider 是Scrapy中最核心的用户自定义类,负责定义爬取起始点( start_urls )、域名范围( allowed_domains )以及页面解析方法( parse() )。每一个爬虫任务都需要继承 scrapy.Spider 基类并实现相应逻辑。

import scrapy

class ExampleSpider(scrapy.Spider):

name = 'example'

allowed_domains = ['example.com']

start_urls = ['https://example.com/page/1']

def parse(self, response):

yield {

'title': response.css('h1::text').get(),

'url': response.url

}

逐行逻辑分析:

| 行号 | 代码 | 解读 |

|---|---|---|

| 1 | import scrapy | 导入Scrapy核心模块 |

| 3 | class ExampleSpider(scrapy.Spider): | 定义一个名为 ExampleSpider 的爬虫类,继承自基类 |

| 4 | name = 'example' | 设置爬虫唯一标识符,用于启动和区分多个爬虫 |

| 5 | allowed_domains = [...] | 限定只爬取指定域名,防止意外越界 |

| 6 | start_urls = [...] | 定义初始请求队列,引擎将从中取出URL发起第一个请求 |

| 8 | def parse(self, response): | 回调函数,当响应到达时自动调用 |

| 9-10 | yield {...} | 返回一个字典形式的数据项,交由Pipeline处理 |

parse() 方法不仅可以提取数据,还可以生成新的 Request 对象以实现翻页或详情页跳转,形成递归抓取链条。

3.2.2 Item容器:用于封装结构化数据的标准字段模型

为了统一数据格式并便于后期处理,Scrapy提供了 Item 类作为结构化数据的载体。它类似于Django的Model或SQLAlchemy的ORM,但更加轻量级。

import scrapy

class ProductItem(scrapy.Item):

title = scrapy.Field()

price = scrapy.Field()

image_url = scrapy.Field()

detail_url = scrapy.Field()

优势分析:

- 字段声明清晰 :明确指出应采集哪些字段。

- 支持元数据附加 :可在Field中加入

serializer、output_processor等处理器。 - 与Pipeline无缝对接 :Item自动流入后续处理链。

使用时只需在Spider中实例化并填充:

item = ProductItem()

item['title'] = response.css('h1::text').get()

item['price'] = response.css('.price::text').re_first(r'\d+\.?\d*')

yield item

3.2.3 Item Pipeline:实现数据清洗、验证与持久化输出

Item Pipeline 是一系列按序执行的数据处理单元,每个Pipeline组件都可以对流经的Item进行过滤、清洗、去重或存储。

典型应用场景包括:

- 去除空值或无效数据

- 转换价格单位(¥ → USD)

- 图片下载(

ImagesPipeline) - 写入数据库(MySQL、MongoDB)

- 数据去重(基于指纹哈希)

启用Pipeline需在 settings.py 中配置:

ITEM_PIPELINES = {

'myproject.pipelines.DuplicateFilterPipeline': 300,

'myproject.pipelines.PriceConverterPipeline': 350,

'myproject.pipelines.MongoDBPipeline': 400,

}

数字表示执行优先级,越小越早执行。

示例:实现一个去重Pipeline

from scrapy.exceptions import DropItem

class DuplicateFilterPipeline:

def __init__(self):

self.seen_urls = set()

def process_item(self, item, spider):

url = item.get('detail_url')

if url in self.seen_urls:

raise DropItem(f"重复URL: {url}")

self.seen_urls.add(url)

return item

✅

process_item()是核心方法,返回Item表示继续传递,抛出DropItem则终止流程。

3.2.4 Request与Response对象:控制HTTP通信生命周期

Request 和 Response 构成了Scrapy中网络通信的基本单元。

-

Request:代表一次HTTP请求,包含URL、method、headers、cookies、callback等属性。 -

Response:服务器返回的结果,包含status code、body、url、selector等。

两者通常成对出现,在 parse() 方法中接收 response ,并通过 yield scrapy.Request() 发起新请求。

def parse(self, response):

# 提取列表页商品链接

for href in response.css('.product-item a::attr(href)').getall():

yield scrapy.Request(

url=response.urljoin(href),

callback=self.parse_detail

)

def parse_detail(self, response):

yield {

'name': response.css('h1::text').get(),

'price': response.css('.price strong::text').get()

}

参数说明:

| 参数 | 类型 | 说明 |

|---|---|---|

url | str | 请求地址,建议使用 response.urljoin() 处理相对路径 |

callback | callable | 响应回调函数,默认为 parse |

meta | dict | 可跨请求传递的元数据(如登录状态、分类ID) |

dont_filter | bool | 是否跳过去重机制(默认False) |

headers | dict | 自定义请求头 |

3.2.5 Selector选择器:基于XPath/CSS快速定位DOM节点

Selector是Scrapy用于解析HTML文档的核心工具,底层依赖于 parsel 库,支持XPath和CSS两种选择语法。

# 使用CSS选择器

titles = response.css('h1.title::text').getall()

# 使用XPath

prices = response.xpath('//span[@class="price"]/text()').re(r'\d+\.\d+')

| 方法 | 说明 |

|---|---|

.get() | 返回第一个匹配结果,None安全 |

.getall() | 返回所有匹配结果列表 |

.re(regex) | 结合正则表达式提取文本 |

.attrib['key'] | 获取标签属性值 |

graph TD

A[HTTP Response] --> B{Body Content}

B --> C[HTML Document]

C --> D[Selector Engine]

D --> E[XPath Expression]

D --> F[CSS Selector]

E --> G[Extracted Nodes]

F --> G

G --> H[Text / Attributes]

上图展示了Selector如何将原始HTML转换为结构化数据的过程。

3.3 组件协同工作机制图解

Scrapy的高效性源于其精密的组件协作机制。整个爬取流程由 Scrapy Engine 统一调度,各组件通过信号与队列交互,形成闭环工作流。

3.3.1 数据流从发起请求到存储的完整路径

一条典型的Scrapy数据流路径如下:

- 用户定义

start_urls→ Engine创建初始Request - Scheduler排队管理Request

- Downloader Middleware预处理(如加User-Agent)

- Downloader发起真实HTTP请求

- 远程服务器返回

Response - Downloader Middleware后处理(如解压缩)

- Engine将Response分发给对应Spider的

parse()方法 - Spider解析数据并

yield Item或新Request - Item进入Item Pipeline链进行清洗与存储

- 新Request再次进入Scheduler,循环往复直至队列为空

flowchart LR

subgraph Engine

S[Scheduler]

D[Downloader]

M[Downloader Middleware]

E[Engine]

end

SP[Spider] --> E

E --> S --> D --> M -->|Request| Internet

Internet --> M --> D --> E --> SP

SP -->|yield Item| IP[Item Pipeline]

IP --> DB[(Storage)]

该流程体现了Scrapy“单引擎多组件”的设计哲学:Engine作为中央控制器,协调所有模块异步运行,最大化利用I/O等待时间。

3.3.2 中间件层如何介入请求与响应处理链

中间件(Middleware)是Scrapy实现灵活扩展的关键机制,分为两类:

- Downloader Middleware :拦截请求与响应,可用于:

- 添加代理IP

- 修改请求头(User-Agent轮换)

- 处理验证码(结合Selenium)

- Spider Middleware :处理Spider输入输出,可用于:

- 预处理Response(如JavaScript渲染)

- 修改或丢弃Item

- 控制爬取深度

启用中间件需在 settings.py 中配置:

DOWNLOADER_MIDDLEWARES = {

'myproject.middlewares.RandomUserAgentMiddleware': 400,

'myproject.middlewares.ProxyMiddleware': 350,

}

SPIDER_MIDDLEWARES = {

'myproject.middlewares.CustomSpiderMiddleware': 543,

}

示例:随机User-Agent中间件

import random

class RandomUserAgentMiddleware:

def __init__(self):

self.user_agents = [

'Mozilla/5.0 (Windows NT 10.0; Win64; x64)...',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7)...',

'Mozilla/5.0 (X11; Linux x86_64)...'

]

def process_request(self, request, spider):

ua = random.choice(self.user_agents)

request.headers.setdefault('User-Agent', ua)

每当一个 Request 即将发出时,该中间件会自动为其设置随机User-Agent,提升反爬对抗能力。

3.3.3 引擎调度器如何协调各组件并发运行

Scrapy Engine基于Twisted的事件循环驱动,采用非阻塞I/O模型,允许多个请求并行处理。

| 组件 | 角色 |

|---|---|

| Engine | 总控中心,调度请求分发与响应回调 |

| Scheduler | 维护待处理Request的优先队列(默认FIFO) |

| Downloader | 并发执行HTTP请求,最大并发数由 CONCURRENT_REQUESTS 控制 |

| Spiders | 业务逻辑执行者,解析页面并产出数据 |

| Pipelines | 数据出口,串行或并行处理Item |

通过调整 settings.py 中的并发参数,可精细控制资源占用:

# settings.py

CONCURRENT_REQUESTS = 16

CONCURRENT_REQUESTS_PER_DOMAIN = 8

DOWNLOAD_DELAY = 1

RANDOMIZE_DOWNLOAD_DELAY = True

这些参数直接影响爬取速度与服务器压力平衡。

3.4 核心依赖库作用解析

Scrapy的强大离不开其背后一系列高性能底层库的支持。理解这些依赖的作用,有助于在出现问题时快速定位根源。

3.4.1 Twisted异步网络引擎的角色

Twisted是一个事件驱动的网络编程框架,Scrapy完全构建在其之上。它实现了:

- 异步I/O :无需多线程即可并发处理大量连接

- Reactor模式 :事件循环监听Socket状态变化

- Deferred机制 :延迟计算,支持回调链式调用

from twisted.internet import reactor, defer

@defer.inlineCallbacks

def fetch_and_parse():

response = yield make_request_async('http://example.com')

result = parse(response.body)

defer.returnValue(result)

reactor.callWhenRunning(fetch_and_parse)

reactor.run()

正是Twisted的存在,让Scrapy能在单进程内轻松维持数千个并发连接。

3.4.2 parsel库对HTML解析的支持

parsel 是Scrapy官方维护的选择器库,封装了lxml的功能,提供简洁的XPath/CSS API:

from parsel import Selector

html = '<ul><li>Apple</li><li>Banana</li></ul>'

sel = Selector(text=html)

fruits = sel.css('li::text').getall() # ['Apple', 'Banana']

其优势在于:

- 支持HTML自动修复(即使标签不闭合也能解析)

- 内建文本提取、正则匹配、属性获取等功能

- 与Scrapy无缝集成,无需额外学习成本

3.4.3 w3lib在网页内容清理中的应用

w3lib 专注于网页内容的标准化处理,常用功能包括:

import w3lib.html

import w3lib.url

# 清理HTML标签

clean_text = w3lib.html.remove_tags("<p>Hello <b>World!</b></p>")

# → "Hello World!"

# 解码HTML实体

decoded = w3lib.html.replace_entities("It's "nice"")

# → 'It\'s "nice"'

# 规范化URL

abs_url = w3lib.url.urljoin("https://a.com/", "/page")

# → "https://a.com/page"

这类工具虽不起眼,但在处理脏数据时极为关键,确保最终输出的干净一致。

综上所述,Scrapy不仅是一个爬虫工具,更是一套完整的异步数据采集系统。其组件之间通过清晰的职责划分与高效的协作机制,构建出稳定、可扩展的抓取架构。掌握这些核心概念,是迈向高级爬虫开发的第一步。

4. Scrapy项目初始化与爬虫开发实战

在掌握了Scrapy框架的安装流程与核心组件原理之后,接下来的关键步骤是将理论知识转化为实际可运行的代码。本章聚焦于如何从零开始构建一个结构完整、功能清晰的Scrapy项目,并通过编写自定义爬虫完成真实网页的数据提取任务。整个过程不仅涉及命令行操作和目录结构理解,还包括对数据解析逻辑的设计、请求调度机制的理解以及结构化输出的实现。

通过系统性地创建项目骨架、定义爬虫行为、使用选择器提取内容并合理组织数据流,开发者可以快速搭建起具备生产级潜力的网络爬虫系统。更重要的是,Scrapy所提供的 yield 机制与异步处理能力,使得即使是复杂的多层级页面跳转(如列表页→详情页)也能以简洁优雅的方式实现。

以下内容将逐步引导读者完成从项目初始化到首个爬虫上线的全过程,深入剖析每个关键环节的技术细节与最佳实践。

4.1 创建标准Scrapy项目结构

Scrapy提供了高度规范化的项目初始化工具,确保所有项目遵循统一的目录结构和模块划分原则。这种标准化设计极大提升了项目的可维护性和团队协作效率。通过简单的命令即可生成包含必要配置文件和代码模板的基础工程。

4.1.1 运行scrapy startproject命令生成骨架代码

要创建一个新的Scrapy项目,首先需要在终端中执行如下命令:

scrapy startproject myscraper

该命令会自动生成名为 myscraper 的项目根目录,其内部包含一系列预定义的子目录和Python文件。这是Scrapy推荐的标准项目结构,旨在分离关注点,便于后期扩展与管理。

此命令的核心作用不仅仅是创建文件夹,更重要的是它会自动注册项目路径、初始化默认设置,并为后续的爬虫生成提供上下文支持。例如,在项目目录内运行 scrapy genspider 命令时,Scrapy能够识别当前所处的项目环境,从而正确地将新爬虫注册进项目中。

此外,该命令还隐式调用了Scrapy的项目加载机制,确保 settings.py 和 items.py 等核心模块被正确导入。这对于大型项目尤其重要,因为多个爬虫可能共享相同的Item模型或管道配置。

4.1.2 项目目录组成解析(spiders/、items.py、pipelines.py等)

生成后的项目目录结构如下所示:

myscraper/

├── myscraper/

│ ├── __init__.py

│ ├── items.py # 定义数据字段模型

│ ├── middlewares.py # 自定义中间件逻辑

│ ├── pipelines.py # 数据处理流水线

│ ├── settings.py # 全局配置参数

│ └── spiders/ # 存放所有爬虫类

│ └── __init__.py

└── scrapy.cfg # 项目配置文件,用于部署和运行控制

各主要文件的作用说明如下表所示:

| 文件/目录 | 功能描述 |

|---|---|

items.py | 定义结构化数据容器,继承自 scrapy.Item ,用于声明需抓取的字段(如 title、url、price 等) |

pipelines.py | 实现数据清洗、验证及持久化逻辑,如保存至数据库、导出JSON文件等 |

settings.py | 配置全局行为参数,包括下载延迟、User-Agent、是否启用Cookies、并发请求数等 |

spiders/ | 存放所有自定义Spider类,每个爬虫通常对应一个单独的 .py 文件 |

scrapy.cfg | 部署相关配置,指定项目名称、部署服务器地址等,主要用于 scrapyd 或 ScrapingHub 集成 |

这一结构体现了典型的“约定优于配置”理念,开发者无需手动编写大量样板代码即可快速进入业务逻辑开发阶段。

下面是一个 items.py 的示例定义:

import scrapy

class ProductItem(scrapy.Item):

name = scrapy.Field()

price = scrapy.Field()

url = scrapy.Field()

image_url = scrapy.Field()

rating = scrapy.Field()

该Item类可用于封装电商平台商品信息,在后续的爬虫中通过实例化并填充字段来传递结构化数据。

4.1.3 项目配置文件settings.py的初步解读

settings.py 是整个Scrapy项目的中枢神经系统,几乎所有影响爬虫行为的参数都可通过此文件进行调控。以下是几个最关键的初始配置项及其含义:

BOT_NAME = 'myscraper'

SPIDER_MODULES = ['myscraper.spiders']

NEWSPIDER_MODULE = 'myscraper.spiders'

ROBOTSTXT_OBEY = True

DOWNLOAD_DELAY = 1

COOKIES_ENABLED = False

ITEM_PIPELINES = {

'myscraper.pipelines.MyscraperPipeline': 300,

}

-

BOT_NAME:爬虫机器人的标识名,部分网站会根据此名称判断访问来源。 -

SPIDER_MODULES:指定Scrapy应扫描哪些模块以发现可用的爬虫类。 -

ROBOTSTXT_OBEY:是否遵守目标站点的robots.txt规则,建议在开发初期设为True以避免法律风险。 -

DOWNLOAD_DELAY:两次请求之间的最小间隔时间(秒),用于降低对服务器的压力。 -

COOKIES_ENABLED:控制是否启用会话保持,某些需要登录状态的场景需设为True。 -

ITEM_PIPELINES:定义数据处理管道链,数字代表执行优先级,越小越早执行。

这些设置构成了爬虫的基本行为边界。随着项目复杂度提升,还可以在此基础上添加代理池、日志级别、重试策略等高级配置。

graph TD

A[scrapy startproject] --> B[生成项目目录]

B --> C[创建items.py]

B --> D[生成settings.py]

B --> E[建立spiders/目录]

B --> F[输出scrapy.cfg]

C --> G[定义数据模型]

D --> H[配置全局参数]

E --> I[存放爬虫脚本]

F --> J[支持部署与远程管理]

上述流程图展示了项目初始化过程中各个组件的生成关系及其职责分工。通过这种模块化设计,Scrapy实现了高内聚、低耦合的架构风格,极大增强了系统的可测试性与可扩展性。

4.2 编写第一个自定义Spider

Spider是Scrapy中最核心的组件之一,负责定义初始URL、解析响应内容以及生成新的请求对象。每一个独立的抓取任务都需要至少一个Spider类来驱动。

4.2.1 使用scrapy genspider快速生成模板

在项目根目录下执行以下命令可快速生成一个基础爬虫模板:

cd myscraper

scrapy genspider example example.com

该命令会在 spiders/ 目录下创建一个名为 example.py 的文件,内容如下:

import scrapy

class ExampleSpider(scrapy.Spider):

name = 'example'

allowed_domains = ['example.com']

start_urls = ['http://example.com/']

def parse(self, response):

pass

其中:

- name :爬虫的唯一标识符,必须全局唯一,用于启动命令 scrapy crawl example 。

- allowed_domains :限定爬取范围,防止意外爬取非授权域名。

- start_urls :起始URL列表,引擎将从中取出URL发起首次HTTP请求。

- parse() 方法:默认回调函数,当请求成功返回后自动调用,用于解析HTML内容。

该模板极大地减少了重复编码工作,使开发者能专注于数据提取逻辑的实现。

4.2.2 定义start_urls与allowed_domains的安全边界

合理的域名限制和起始链接设置是保障爬虫稳定运行的前提。例如,若目标是抓取豆瓣电影Top250榜单,则应设置:

class DoubanMovieSpider(scrapy.Spider):

name = 'douban_movie'

allowed_domains = ['movie.douban.com']

start_urls = ['https://movie.douban.com/top250']

此处 allowed_domains 起到过滤作用:即使页面中存在指向其他域(如 baidu.com)的链接,Scrapy也不会跟进。这有助于防止无限扩散导致资源浪费或违反服务条款。

同时, start_urls 支持多种写法:

- 单个URL字符串 → 自动包装为列表

- 多个URL组成的列表 → 并发发起请求

- 动态生成方法(如重写 start_requests() )→ 更灵活控制初始请求属性(如带Header、Form Data)

def start_requests(self):

headers = {'User-Agent': 'Mozilla/5.0'}

for url in self.start_urls:

yield scrapy.Request(url=url, headers=headers, callback=self.parse)

这种方式适用于需要定制请求头或携带认证信息的场景。

4.2.3 实现parse()方法进行页面解析

parse() 方法是数据提取的核心入口。当Scrapy接收到HTTP响应后,会自动将其封装为 Response 对象并传入该方法。开发者可利用内置的选择器进行DOM节点定位。

以豆瓣电影为例,假设我们要提取每部电影的标题和评分:

def parse(self, response):

movies = response.css('ol.grid_view li')

for movie in movies:

yield {

'title': movie.css('span.title::text').get(),

'rating': movie.css('span.rating_num::text').get(),

'link': movie.css('a::attr(href)').get()

}

代码逻辑逐行分析:

-

response.css('ol.grid_view li')

使用CSS选择器匹配所有电影条目<li>元素,返回一个SelectorList对象。 -

for movie in movies:

遍历每个电影节点,分别提取其内部信息。 -

movie.css('span.title::text').get()

在当前节点内查找类名为title的<span>,并通过::text提取其文本内容;.get()返回第一个匹配结果,若无则返回None。 -

movie.css('a::attr(href)').get()

提取链接标签的href属性值,用于获取详情页地址。 -

yield { ... }

将提取结果以字典形式提交给Item Pipeline处理。注意这里尚未使用正式的Item类,仅作演示。

该方法展示了Scrapy最基础但最强大的功能——基于响应对象进行结构化数据抽取。结合XPath也可实现更复杂的定位逻辑,但在大多数现代网页中,CSS选择器已足够高效。

sequenceDiagram

participant Engine

participant Scheduler

participant Downloader

participant Spider

Engine->>Scheduler: 请求初始URL

Scheduler->>Downloader: 分发请求

Downloader->>Target Server: 发起HTTP GET

Target Server-->>Downloader: 返回HTML响应

Downloader-->>Spider: 传递Response对象

Spider->>Spider: 执行parse()方法

Spider-->>Engine: yield 数据或新Request

上图描绘了单次请求-响应-解析流程的时序交互。可以看出,Spider在整个链条中扮演着“大脑”角色,决定下一步动作:是继续深入抓取详情页,还是结束本次任务。

4.3 利用CSS选择器提取网页数据

准确高效地从HTML中提取所需信息是爬虫开发的核心挑战。Scrapy基于 parsel 库提供了强大且易用的CSS选择器支持,允许开发者以声明式语法快速定位DOM元素。

4.3.1 response.css()语法详解与常见模式匹配

response.css() 接收一个CSS表达式作为参数,返回匹配的所有节点集合( SelectorList )。常用语法包括:

| 模式 | 示例 | 说明 |

|---|---|---|

| 标签选择器 | div | 匹配所有 <div> 元素 |

| 类选择器 | .item | 匹配 class=”item” 的元素 |

| ID选择器 | #header | 匹配 id=”header” 的元素 |

| 后代选择器 | ul li | 匹配 <ul> 内部的所有 <li> |

| 属性选择器 | [href*="douban"] | 匹配 href 属性包含 “douban” 的链接 |

| 伪类选择器 | a::attr(href) | 提取属性值 |

p::text | 提取文本内容 |

例如,提取新闻标题及其发布时间:

titles = response.css('h2.news-title::text').getall()

times = response.css('span.time::text').re(r'\d{4}-\d{2}-\d{2}')

-

.get()返回第一个匹配项 -

.getall()返回所有匹配项组成的列表 -

.re()支持正则表达式提取,适合处理非纯文本内容

4.3.2 提取文本、属性值与嵌套结构的方法

在实际网页中,信息往往嵌套在多层标签中。例如:

<div class="product">

<a href="/item/123">

<img src="pic.jpg" alt="iPhone">

<p class="name">iPhone 15</p>

<p class="price">$999</p>

</a>

</div>

对应的提取逻辑为:

products = response.css('div.product')

for product in products:

item = {}

link_elem = product.css('a')

item['name'] = link_elem.css('p.name::text').get()

item['price'] = link_elem.css('p.price::text').get().replace('$', '')

item['url'] = response.urljoin(link_elem.css('::attr(href)').get())

item['image'] = link_elem.css('img::attr(src)').get()

yield item

参数说明:

- response.urljoin() :将相对URL转换为绝对URL,确保链接有效性。

- replace('$', '') :清理价格中的货币符号,便于后续数值计算。

4.3.3 结合正则表达式提升数据精准度

某些字段可能混杂无关字符,此时可借助 .re() 方法精确捕获目标内容:

# 提取电话号码

phone = response.css('body::text').re_first(r'\d{3}-\d{3}-\d{4}')

# 提取年份

year = response.css('#copyright::text').re(r'(\d{4})')[0]

.re_first() 返回首个匹配组,避免空列表异常。

import re

# 等效原生Python实现(对比说明)

text = "Contact us at 123-456-7890"

match = re.search(r'\d{3}-\d{3}-\d{4}', text)

if match:

print(match.group()) # 输出: 123-456-7890

Scrapy的 .re() 方法正是封装了此类正则操作,使其更贴近爬虫开发习惯。

4.4 数据结构化输出与yield机制

Scrapy采用生成器(generator)模式管理数据流,通过 yield 关键字实现异步非阻塞的数据传递与请求调度。

4.4.1 构建Item实例并填充字段数据

推荐做法是先在 items.py 中定义标准化模型:

class NewsItem(scrapy.Item):

title = scrapy.Field()

content = scrapy.Field()

publish_time = scrapy.Field()

source_url = scrapy.Field()

然后在Spider中实例化并赋值:

from myscraper.items import NewsItem

def parse(self, response):

item = NewsItem()

item['title'] = response.css('h1::text').get()

item['content'] = ''.join(response.css('.article p::text').getall())

item['publish_time'] = response.css('.time::attr(datetime)').get()

item['source_url'] = response.url

yield item

使用Item类的好处在于:

- 字段命名一致性

- 支持Pipeline自动化处理

- 可集成Django Item Loader等扩展工具

4.4.2 使用yield返回Request实现翻页与详情跳转

yield 不仅可用于输出Item,还能返回新的 scrapy.Request 对象,实现自动翻页或进入详情页:

def parse(self, response):

# 提取列表页中的详情链接

for href in response.css('a.detail-link::attr(href)'):

yield response.follow(href, callback=self.parse_detail)

# 翻页逻辑

next_page = response.css('a.next::attr(href)').get()

if next_page:

yield response.follow(next_page, callback=self.parse)

response.follow() 是便捷方法,自动处理相对URL转换,并继承当前请求的元数据。

4.4.3 控制爬取深度与广度的策略设计

为防止无限递归,可通过 Request.meta 设置深度标记:

def parse(self, response):

depth = response.meta.get('depth', 0)

if depth > 2:

return # 限制最大深度为2层

for next_href in response.css('a::attr(href)'):

yield response.follow(

next_href,

callback=self.parse,

meta={'depth': depth + 1}

)

此外,还可通过 CLOSESPIDER_PAGECOUNT 等设置限制总请求数,平衡效率与资源消耗。

| 控制维度 | 配置项 | 示例值 | 说明 |

|----------|--------|--------|------|

| 请求频率 | DOWNLOAD_DELAY | 1.5 | 每次请求间隔1.5秒 |

| 并发数 | CONCURRENT_REQUESTS | 16 | 同时最多16个请求 |

| 爬取深度 | meta['depth'] | 3 | 编程控制递归层数 |

| 页面总数 | CLOSESPIDER_PAGECOUNT | 1000 | 达到后自动停止 |

| 错误容忍 | RETRY_TIMES | 3 | 失败请求最多重试3次 |

综上所述,Scrapy通过 yield 机制实现了灵活而强大的控制流管理,既能顺序提取数据,又能动态生成请求,真正做到了“一条语句,多重用途”。

5. 安装验证与配置优化进阶

5.1 验证Scrapy是否成功安装

在完成Scrapy的安装后,首要任务是确认其已正确集成到当前Python环境中。这一步至关重要,尤其是在多版本Python共存或使用虚拟环境的情况下。

5.1.1 在Python交互环境中执行import scrapy测试

打开终端并进入Python交互模式:

python

然后输入以下代码进行模块导入验证:

>>> import scrapy

>>> print("Scrapy imported successfully")

Scrapy imported successfully

若无报错信息(如 ModuleNotFoundError ),说明Scrapy已成功安装至当前环境。

注意 :如果出现导入失败,请检查是否处于正确的虚拟环境,或通过

pip list | grep Scrapy确认安装状态。

5.1.2 输出scrapy.__version__确认版本信息

进一步获取框架版本号,有助于排查兼容性问题:

>>> print(scrapy.__version__)

2.11.0

该版本号可用于比对官方文档支持范围,确保所用功能在当前版本中可用。

5.1.3 运行scrapy version命令双重校验

退出Python解释器,在系统命令行中运行:

scrapy version

预期输出如下:

Scrapy 2.11.0 - no active project

Found Scrapy 2.11.0 from installed files

若显示具体版本号而非“command not found”,则表明Scrapy命令行工具也已正确注册,可全局调用。

| 验证方式 | 命令/代码 | 成功标志 |

|---|---|---|

| 模块导入 | import scrapy | 无异常 |

| 版本属性查看 | scrapy.__version__ | 返回有效字符串版本号 |

| CLI命令行校验 | scrapy version | 显示Scrapy版本信息 |

| 路径检查 | which scrapy (Linux/macOS) | 返回可执行文件路径 |

| 包列表查询 | pip show scrapy | 展示作者、位置、依赖等元数据 |

5.2 settings.py关键参数调优

settings.py 是Scrapy项目的配置中枢,合理调整核心参数不仅能提升爬取效率,还能降低被封禁风险。

5.2.1 设置DOWNLOAD_DELAY控制请求频率

为避免对目标服务器造成过大压力,建议设置下载延迟:

# settings.py

DOWNLOAD_DELAY = 1.5 # 每次请求间隔1.5秒

RANDOMIZE_DOWNLOAD_DELAY = True # 自动在0.5~1.5倍之间随机波动

此配置模拟人类浏览行为,显著提高反爬策略通过率。

5.2.2 启用或禁用COOKIES_ENABLED以模拟登录状态

某些网站依赖会话维持身份认证:

# 启用Cookies用于保持登录态

COOKIES_ENABLED = True

# 若需无痕访问(如测试不同地区IP表现)

# COOKIES_ENABLED = False

结合 FormRequest.from_response() 可实现自动表单提交与登录维持。

5.2.3 配置USER_AGENT提高反爬通过率

默认User-Agent易被识别为爬虫,应替换为常见浏览器标识:

USER_AGENT = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/124.0 Safari/537.36'

更高级做法是使用 scrapy-useragents 中间件轮换UA:

# 安装:pip install scrapy-user-agents

DOWNLOADER_MIDDLEWARES = {

'scrapy.downloadermiddlewares.useragent.UserAgentMiddleware': None,

'scrapy_user_agents.middlewares.RandomUserAgentMiddleware': 400,

}

5.3 中间件(Middleware)机制入门

中间件是Scrapy实现高度可扩展性的关键设计,允许开发者介入请求与响应生命周期。

5.3.1 Downloader Middleware拦截请求修改行为

自定义中间件可动态添加代理、Header或重试逻辑:

# middlewares.py

class CustomProxyMiddleware:

def process_request(self, request, spider):

request.meta['proxy'] = 'http://your-proxy-ip:port'

return None # 继续处理

注册至 settings.py :

DOWNLOADER_MIDDLEWARES = {

'myproject.middlewares.CustomProxyMiddleware': 350,

'scrapy.downloadermiddlewares.retry.RetryMiddleware': None,

}

5.3.2 Spider Middleware处理Response预加工

可用于清洗HTML内容或注入结构化元数据:

class HtmlCleanMiddleware:

def process_spider_input(self, response, spider):

# 可在此处检测响应内容类型

if response.status == 403:

self.logger.warning(f"Access denied: {response.url}")

return None

5.3.3 自定义中间件实现IP代理或请求头轮换

构建动态请求头轮换机制示例:

import random

class RotateHeadersMiddleware:

user_agents = [

'Mozilla/5.0 (X11; Linux x86_64) ...',

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) ...',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) ...'

]

def process_request(self, request, spider):

ua = random.choice(self.user_agents)

request.headers.setdefault('User-Agent', ua)

启用后大幅提升隐蔽性。

graph TD

A[Start Request] --> B{Downloader Middleware}

B --> C[Modify Headers/Proxy]

C --> D[Send HTTP Request]

D --> E[Receive Response]

E --> F{Spider Middleware}

F --> G[Pre-process Response]

G --> H[Parse with parse()]

H --> I[Yield Items or Requests]

5.4 完整开发流程总结与最佳实践建议

5.4.1 从环境准备到部署上线的标准路径

标准Scrapy项目开发流程如下:

- 创建虚拟环境:

python -m venv scrapy_env - 激活环境:

source scrapy_env/bin/activate(Linux/macOS) - 升级pip:

pip install --upgrade pip - 安装Scrapy:

pip install scrapy - 初始化项目:

scrapy startproject news_crawler - 生成爬虫:

scrapy genspider techcrunch techcrunch.com - 编写parse逻辑,调试选择器

- 配置Item和Pipeline持久化

- 调优settings.py中的并发与延时

- 测试运行:

scrapy crawl techcrunch -o output.json

5.4.2 日志记录、异常处理与性能监控要点

启用详细日志级别便于调试:

LOG_LEVEL = 'INFO' # DEBUG可查看每条请求

LOG_FILE = 'crawl.log' # 记录运行轨迹

捕获常见异常:

def parse(self, response):

if response.status == 404:

self.logger.error(f"Page not found: {response.url}")

return

try:

title = response.css('h1::text').get().strip()

except Exception as e:

self.logger.error(f"Parsing error: {e}")

5.4.3 遵守robots.txt与网站使用条款的合规提醒

始终开启ROBOTSTXT_OBEY以尊重站点规则:

ROBOTSTXT_OBEY = True

定期审查目标网站的 robots.txt 文件,例如访问 https://example.com/robots.txt ,避免抓取 /private/ 或 /admin/ 类路径。

此外,建议:

- 控制CONCURRENT_REQUESTS ≤ 16

- 添加Contact信息至USER_AGENT

- 对敏感数据脱敏存储

- 设定CLOSESPIDER_ITEMCOUNT防止无限采集

# 示例:限制总产出条目数

CLOSESPIDER_ITEMCOUNT = 1000

CONCURRENT_REQUESTS = 8

CONCURRENT_REQUESTS_PER_DOMAIN = 4

这些策略共同构成可持续、负责任的数据采集体系。

简介:Scrapy是Python中强大的网络爬虫框架,提供高效的数据抓取、解析和存储工具。本文详细介绍了在Python 2.7环境下(推荐2.7.8版本)如何安装Scrapy,包括Python环境配置、pip包管理器的使用、Scrapy的安装与验证方法。同时涵盖Scrapy项目创建、Spider编写、核心组件(如Item、Pipeline、Selector等)的应用及中间件和设置文件的配置,帮助开发者快速上手并构建完整的数据采集系统。

1071

1071

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?