本文提出了一种与CNN模型参数量相近,但性能与类MLP模型媲美的轻量级模型---ALOFT

在本工作中,我们首先研究了现有的类MLP模型在领域泛化任务中的有效性。我们从频域的角度对现有的类MLP模型进行了分析,发现相比于CNN模型,类MLP模型能够更好地利用样本中的全局结构信息,因此具有更好的领域泛化性能。受此启发,我们进一步提出了一种轻量级类MLP模型,该模型使用两种不同的策略来建模特征级低频谱分布,通过重采样来实现动态低频谱转换,从而充分增强模型对全局信息的表达能力。我们的轻量级模型ALOFT仅使用与ResNet-18相近的参数量,在多个公开数据集上均取得了优于以往方法的结果。文章和代码已公开。

论文链接:

https://arxiv.org/abs/2303.11674

代码链接:

https://github.com/lingeringlight/ALOFT/

Background

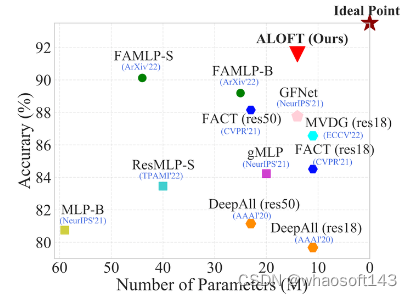

领域泛化旨在利用多个可观测源域来训练模型,使得该模型能够泛化到任意未知领域上。目前大部分DG的工作都是基于卷积神经网络(CNNs)实现的。然而,受限于卷积核的局部操作,这些基于CNN的方法往往会过度关注局部表征,导致模型难以避免地对源域过拟合。最近,一些先驱性的工作提出使用类MLP模型来解决DG任务。这些工作通过使用注意力机制,来帮助模型学习图片块之间的全局依赖关系。尽管这些工作已经展现出引人注目的能力,它们并未深入分析CNN和类MLP模型之间的差异,以及这些差异是如何影响模型的泛化能力。此外,这些方法也存在着参数量过多和计算量过大等问题,这也阻碍了它们在现实场景中的应用。在本论文中,我们首先分析了在DG任务中,CNN与类MLP模型之间的泛化能力差异以及原因。然后,我们提出了一种与CNN模型参数量相近,但性能与类MLP模型媲美的轻量级模型---ALOFT。

ALOFT的参数量与ResNet-18相近(14M),但性能超过了基于MLP-like models的SOTA方法。

Observations

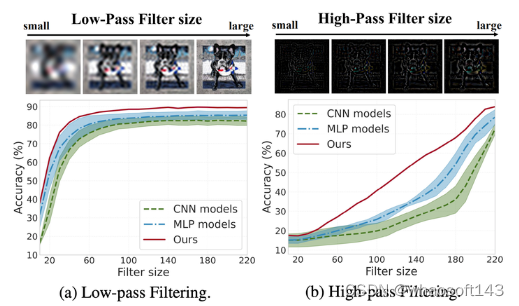

DG任务中最具挑战性的问题是领域偏移问题。在不同的领域中,分布的变化会导致同一类别的目标有不同的表征。已有的DG工作通常将目标特征区分为领域不变特征和领域相关特征。其中,领域不变特征往往包含更多形状相关的语义信息,领域相关特征则包含更多与纹理相关的风格信息。受到频谱特性的启发,我们首先使用离散傅里叶表换(Discrete Fourier Transform, DFT)将图像分为高频部分(包含更多全局信息)和低频部分(包含更多局部信息),然后定量分析了 CNN models 和 MLP-like models 分别在低频和高频部分上的性能差异。

具体地,我们选择了三种具有代表性的 CNN-based DG models (DeepAll, FACT, MVDG),和三种 SOTA 的 MLP-like models (GFNet, RepMLP, ViP),并且分别比较了两类方法在图像低频部分和高频部分上的性能。比较结果展示在下图中,蓝色的曲线代表 MLP-like models,绿色的曲线代表 CNN-based models。图(a)表明,MLP-like models在低频部分上的表现与CNN-based models接近,这说明二者的差异主要体现在高频部分上;图(b)表明,在高频部分上,MLP-like models的表现显著优于CNN-based models,这说明相比于CNN-based models,MLP-like models能够更好地利用样本中的全局结构信息,因此对于领域偏移问题具有更强的鲁棒性。

MLP-like models在图像低频部分上表现与CNN-based models相近,但高频部分上表现明显优于CNN-based models。

Our ALOFT

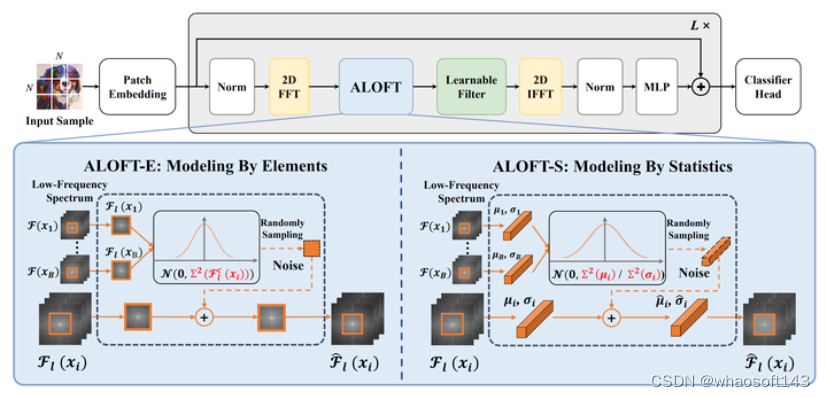

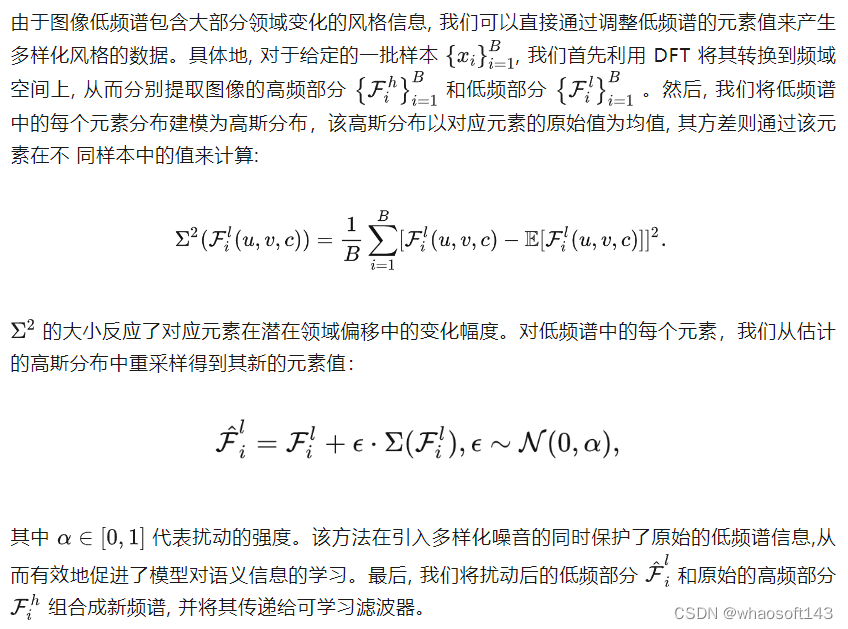

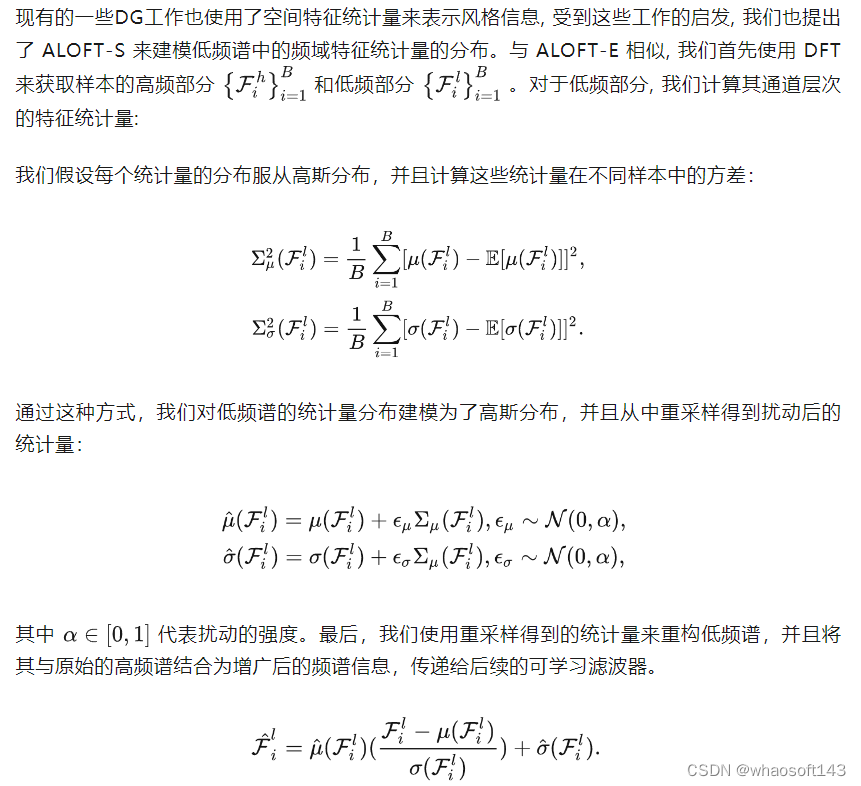

为了增强模型对全局结构信息的学习,我们提出了一种叫做“动态低频谱转换”(ALOFT)的模块。考虑到图像的高频部分包含更多的全局结构特征,ALOFT旨在通过充分地扰动低频部分来增强模型对高频部分的学习。与以往将图像低频谱视为确定值的方法不同,我们的ALOFT将来自不同样本的低频谱建模为多元高斯分布,然后从中重采样得到新的低频谱来取代原来的低频谱,从而在频域空间中模拟领域偏移。我们考虑了两种建模策略,分别是对不同样本低频谱元素分布建模(ALOFT-E)和对不同样本低频谱统计量分布建模(ALOFT-S)。

基于低频谱元素的分布建模 (ALOFT-E)

基于低频谱统计量的分布建模 (ALOFT-S)

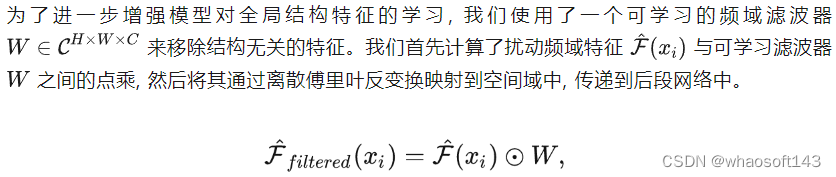

可学习频域滤波器 (Learnable Filter)

Experiments

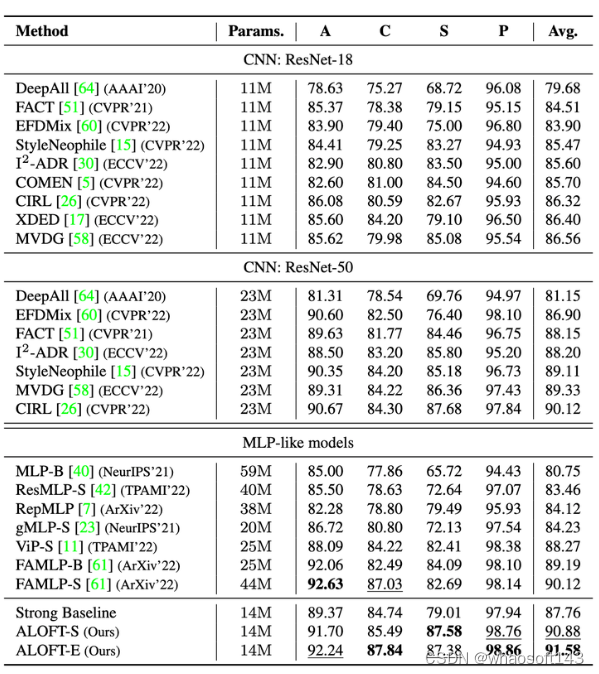

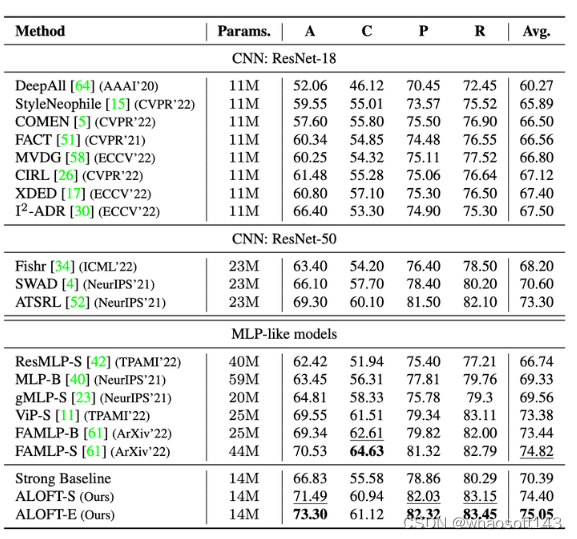

我们在四个公开数据集上验证了 ALOFT 模型的有效性,包括:PACS,OfficeHome,Digits-DG 和 VLCS。实验结果证明,ALOFT模型在所有数据集上均取得了最优的性能,参数量仅与 ResNet-18 相近,远小于ResNet-50以及现有的类MLP模型。这里只展示部分数据集上的结果,更多数据集请参考论文。

与SOTA方法的比较:PACS

PACS 中一共包含9991张图像,分别来自4个不同分布的领域,涵盖7个类别。

PACS

与SOTA方法的比较:OfficeHome

OfficeHome 中一共包含约15500张图像,分别来自4个领域,涵盖65个类别。

OfficeHome

消融实验

这里只展示部分消融实验,更多的消融实验请参考论文。

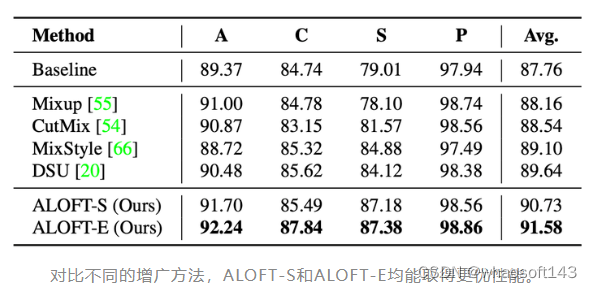

ALOFT与其他增广方法的对比

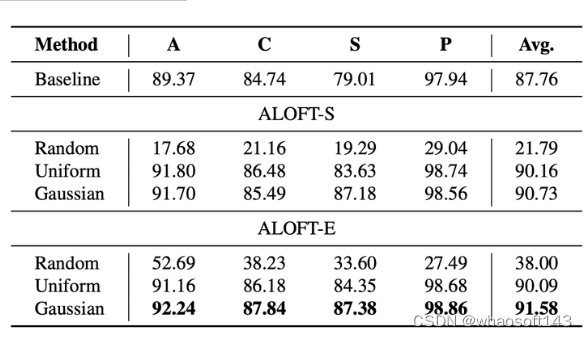

ALOFT中不同分布建模方法的对比

对比不同的分布建模方法,使用高斯分布对低频谱分布进行建模能够产生更多样的数据。

总结

在本工作中,我们研究了在DG任务中 CNN-based methods 与 MLP-like models 之间的性能差异,发现相比于CNN-based models, MLP-like models 能够更好地学习图像中的全局结构信息,因此具有更强的泛化能力。我们进一步提出了一种轻量级的 MLP-like 架构,利用动态低频谱转换来提高模型的泛化性能。我们最终的模型仅使用与ResNet-18相近的参数量,在多个通用数据集上均取得了最优的性能。

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?