前段时间,写了爬虫,在新浪搜索主页面中,实现了输入关键词,爬取关键词相关的新闻的标题、发布时间、url、关键字及内容。并根据内容,提取了摘要和计算了相似度。下面阐述自己的思路并将代码的githup链接给出:

1、获取关键词新闻页面的url

在新浪搜索主页,输入关键词,点击搜索后会自动链接到关键词的新闻界面,想要获取这个页面的url,有两种思路,本文提供三种方法。

1)静态抓取

从新浪搜索主页,输入keywords,进入kerwords相关的新闻页面,手动获取url链接,然后用你需要输入的关键词取替换url中的keywords,得到新的url,发送新的url请求,获取该网页页面源代码。缺点:对于动态网页,这样的方式获得url,发送请求得到的网页源代码与人工在搜索界面输入关键词获得的页面源代码不一致。

2)动态抓取

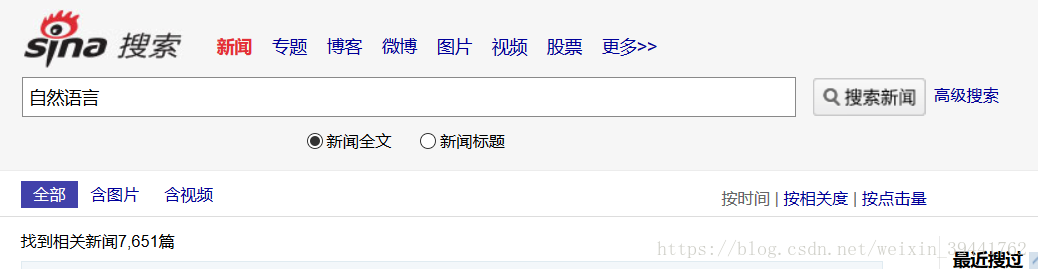

模拟浏览器行为,抓取关键词新闻相关的页面。两种方法,一种是确定使用的浏览器,用程序调用浏览器,操作输入和搜索过程;另一种是,不确定使用的浏览器,无界面的,用程序实现模拟浏览器行为抓取关键词页面的url和页面源代码。如图,进入搜索主页,输入关键词语,则会跳转到搜索结果页面。

2、分析关键词新闻页面的信息

1)查找搜索到的新闻篇数,根据一页中新闻的数量,计算出与关键词次相关的新闻有多少页。找出不同页面之间url的联系,生成翻页的url。

如上图,新闻界面中出现"找到相关新闻7,651篇",使用正则匹配等方法,将'7,651'获取下来,并根据新浪新闻搜索页面一页中出现的新闻数量m,计算出相关新闻的页数:int(7651/m)。

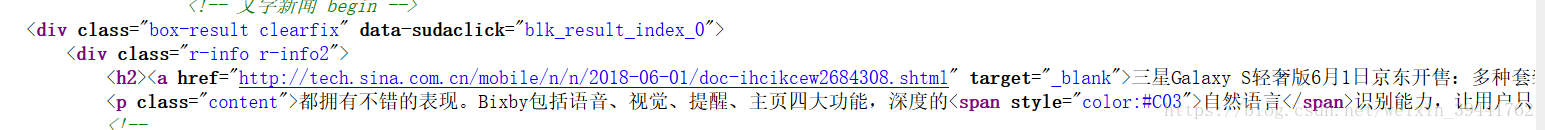

2)在一个页面中,查找出新闻的url。

查看页面源代码,找到新闻对应的url,如上图,新闻url出现时,有相同的规则是"<h2>",故可以根据这样的规则将页面源代码中的url全部提取出来。

3、提取新闻页面的信息

根据新闻的url,进入新闻页面,找到标题、发布时间、关键字、内容、描述内容并提取。其中需要注意的是解码问题,网页源代码编写有不同的编码格式,注意解码。

1)新闻中无关键字,采取生成关键词方式。根据新闻内容,计算内容中词语的频率,以词语频率确定输出的词语作为关键词;

2)新闻中的摘要生成,采用抽取式,借鉴石头木博客的代码(链接如下:https://www.cnblogs.com/little-horse/p/6701974.html)。

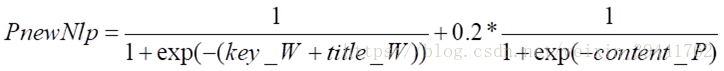

3)关键词与新闻的相似度。根据新闻标题、关键词及内容,赋予不同的权重,计算出相似度。具体思路如下:

a)关键字和标题

关键字和标题中均包含与输入词语相关的词语,赋权值kT_W=0.8;仅标题中包含输入词语,相关的词语赋权值kT_W=0.7;仅关键字中包含输入词语相关的词语,赋权值kT_W=0.6;其他赋权值kT_W=0.6。

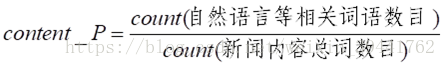

b) 新闻内容中:自然语言相关词语等在新闻内容中的词频content_P

c) 相似度最终计算公式为:

4、代码(运行环境python)

代码链接:https://gitee.com/someone317/sina_news_crawler/tree/master/Sinacrawler

里面已经附带了安装相关模块后,还需要下载的文件和代码中需要的文件。并给出了对应python2和python3代码

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?