摘要

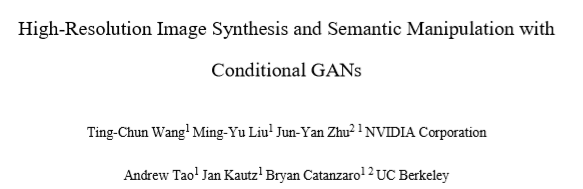

本文提出了一种使用条件生成对抗网络(条件GAN)从语义标签图上合成高分辨率照片级逼真的图像的新方法。 条件GAN已启用了多种应用程序,但结果通常仅限于低分辨率,并且距离实际还很远。在这项工作中,本文以新的对抗性损失以及新的多尺度生成器和鉴别器架构生成了2048×1024的视觉吸引力结果。此外,本文将框架扩展到具有两个附加功能的交互式视觉操作。首先,本文合并了对象实例分割信息,该信息使对象能够进行操作,例如删除/添加对象和更改对象类别。其次,本文提出一种在给定相同输入的情况下生成各种结果的方法,允许用户以交互方式编辑对象外观。人类意见研究表明,本文的方法大大优于现有方法,从而提高了深度图像合成和编辑的质量和分辨率。

1.介绍由于必须明确模拟几何形状,材料和光传输,因此需要使用标准图形技术进行逼真的图像渲染。尽管现有的图形算法可以胜任该任务,但是构建和编辑虚拟环境既昂贵又耗时。 那是因为本文必须对世界的各个方面进行建模。 如果本文能够使用从数据中学到的模型来渲染逼真的图像,则可以将图形渲染过程转变为模型学习和推理问题。然后,本文可以通过在新数据集上训练模型来简化创建新虚拟世界的过程。 通过允许用户仅指定总体语义结构,而不是对几何图形,材质或照明进行建模,本文甚至可以使自定义环境更加容易。

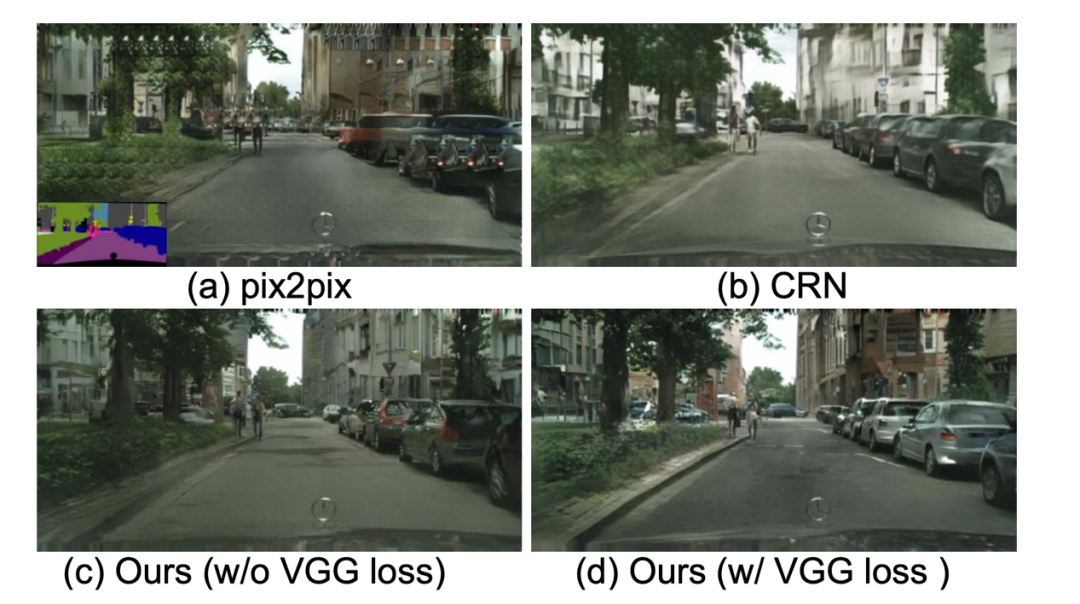

在这里,本文解决了上述最新方法的两个主要问题:(1)使用GAN 生成高分辨率图像的难度,以及(2)以前的高级算法缺乏细节和逼真的纹理 分辨率结果。本文表明,通过一个新的,强大的对抗学习目标,以及新的多尺度生成器和鉴别器体系结构,本文可以以2048×1024分辨率合成照片级逼真的图像,比以前的方法计算出的图像更具视觉吸引力。本文首先仅通过对抗训练获得本文的结果,而无需依靠任何手工制造的损失或预训练的网络(例如VGGNet )获得感知损失(图7c,9b)。 然后,本文表明,如果存在预训练网络,则在某些情况下(图7d,9c),增加来自预训练网络的感知损失可以稍微改善结果。 在图像质量方面,这两个结果都大大优于以前的工作。

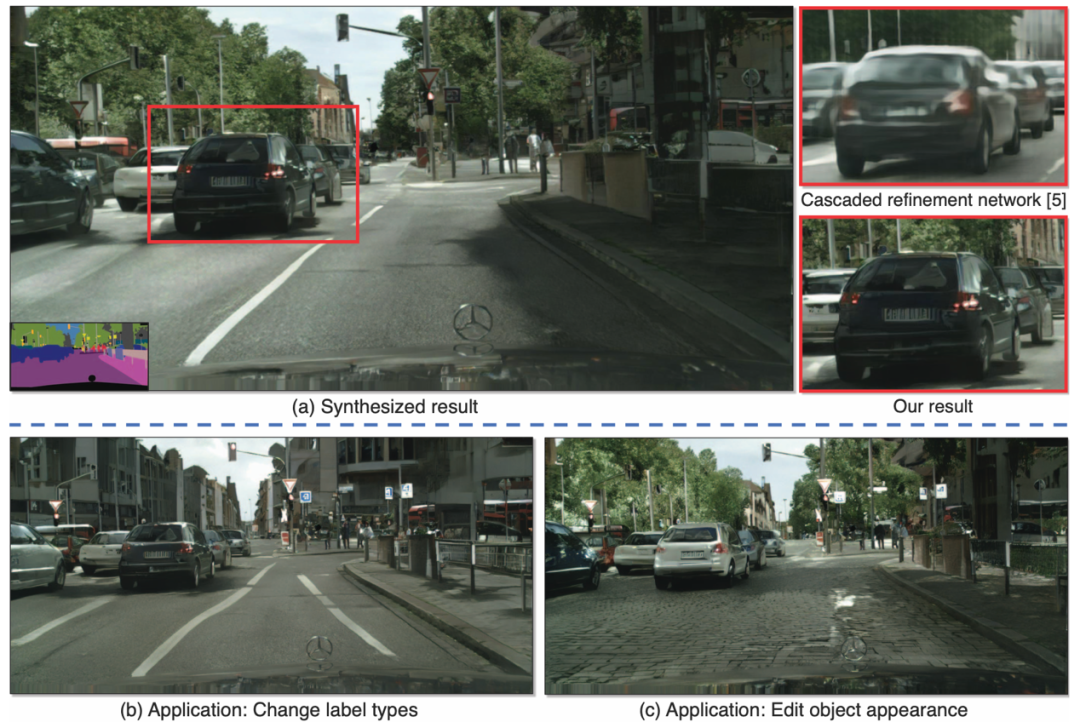

图2.使用CelebA-HQ 和互联网猫图像,使用本文的框架将边缘描线转换为高分辨率自然照片的示例结果

此外,为了支持交互式语义操纵,本文在两个方向上扩展了本文的方法。首先,本文使用实例级对象细分信息,该信息可以将同一类别内的不同对象实例分开。 这样可以进行灵活的对象操作,例如添加/删除对象和更改对象类型。 其次,本文提出了一种在给定相同输入标签图的情况下生成各种结果的方法,从而允许用户以交互方式编辑同一对象的外观。

本文将其与最先进的视觉合成系统进行比较,并表明本文的方法在定量评估和人类感知研究方面均优于这些方法。

2.实例级图像合成2.1 提高图像写实度和分辨率

通过使用从粗到细的生成器,多尺度鉴别器体系结构和强大的对抗学习目标函数,本文改进了pix2pix框架。

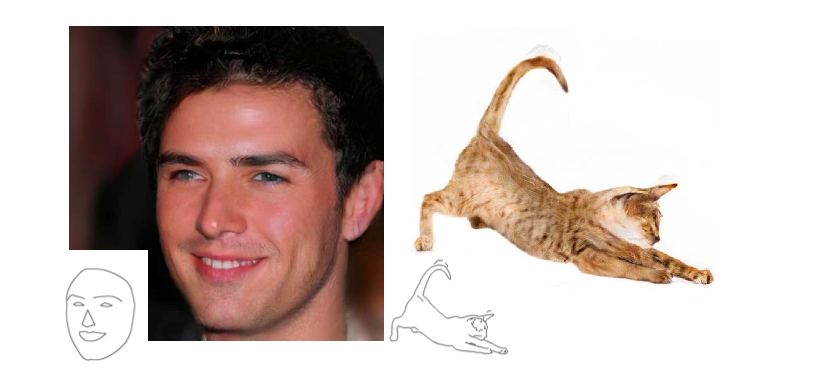

粗到细生成器本文将发生器分解为两个子网:G1和G2。本文将G1称为全局生成器网络,将G2称局部增强网络。 然后,生成器由元组G = {G1,G2}给出,如图3所示。全局生成器网络以1024×512的分辨率运行,本地增强器网络输出分辨率为4×的图像。 前一个的输出尺寸(每个图像尺寸的2倍)。 为了以更高的分辨率合成图像,可以使用其他本地增强器网络。例如,生成器G = {G1,G2}的输出图像分辨率为2048×1024,而G = {G1,G2,G3}的输出图像分辨率为4096×2048。

本文的全局生成器基于Johnson等人提出的架构,它已被证明可以成功地在高达512×512的图像上进行神经样式转换。它由3个组成部分组成:一个前端卷积,一系列残差块,和一个反卷积后端。依次将分辨率为1024×512的语义标签图通过这三个组件,以输出分辨率为1024×512的图像。

本地增强器网络还包括3个组成部分:卷积前端,一系列残残差和反卷机后端。输入标签映射到G2的分辨率为2048×1024。与全局生成器网络不同,残差块的输入是两个特征图的逐元素求和:输出的特征图和全局网络后段输出的特征图。

在训练过程中,本文首先训练全局生成器,然后按照其解决方案的顺序训练本地增强器。然后,本文共同微调所有网络。 本文使用此生成器设计为图像合成任务有效地聚合全局和局部信息。

图3.生成器的网络架构

多尺度鉴别器高分辨率图像合成对GAN鉴别器设计提出了巨大挑战。 为了区分高分辨率的真实图像和合成图像,鉴别器需要具有较大的接收场。这将需要更深的网络或更大的卷积内核。

为了解决这个问题,本文建议使用多尺度鉴别器。本文使用3个鉴别器,它们具有相同的网络结构,但以不同的图像比例运行。本文将区分符称为D1,D2和D3。具体来说,本文以2和4的系数对真实和合成的高分辨率图像进行下采样,以创建3个比例的图像金字塔。然后训练鉴别器D1,D2和D3分别区分3个不同比例的真实和合成图像。尽管鉴别器具有相同的架构,但以最粗糙的规模运行的鉴别器具有最大的接收场。它具有更全局的图像视图,并且可以引导生成器生成全局一致的图像。

有了鉴别器,学习问题就变成了一个多任务学习问题。

本文设计扩展到不同图像比例的多个鉴别器,以对高分辨率图像进行建模。

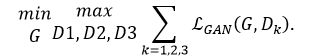

改善对抗损失本文改善了方程式中的GAN损失。 (1)通过结合基于鉴别器的特征匹配损失。 这种损失使培训稳定了,因为生成器必须生成多个尺度的自然统计数据。 具体来说,本文从鉴别器的多层提取特征,并从实际图像和合成图像中学习匹配这些中间表示。为了便于表示,本文将鉴别器的第i层特征提取器表示为D(i)k。特征匹配损失LFM(G,Dk)为:

本文整个目标包括了GAN损失和特征值匹配损失表示如下:

2.2.使用实例图

本文认为实例图提供的最重要信息是对象边界。例如,当多个相同类的对象彼此相邻时,仅查看语义标签图就无法区分它们。 对于街道场景而言尤其如此,因为许多停放的汽车或步行的行人经常彼此相邻。 但是,使用实例图,分离这些对象变得更加容易。

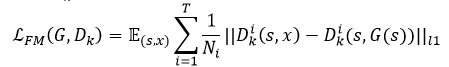

本文首先计算实例边界图(图4a)。 在本文的实现中,如果实例边界图中的像素与其4个邻居中的任何一个都不相同,则实例边界图中的像素为1,否则为0。 然后将实例边界图与语义标签图的一键矢量表示连接起来,并馈入生成器网络。类似地,向鉴别器的输入是实例边界图,语义标签图和真实/合成图像的通道级联。 图4显示了一个示例,演示了通过使用对象边界进行的改进。 本文的用户研究位于 图4还显示了带有边界贴图的模型,该模型渲染了更多逼真的对象边界。

图4.使用实例图:(a)从实例图提取边界图。(b)(c)利用此信息,分离不同的对象变得更加容易

2.3.学习实例级的特征嵌入

从语义标签图的图像合成是一对多的映射问题。理想的图像合成算法应该能够使用相同的语义标签图生成各种逼真的图像。目前的方法存在着许多弊端。首先,用户无法直观地控制模型将生成哪种类型的图像。其次,这些方法着眼于全局颜色和纹理变化,并且不对生成的内容进行对象级控制。

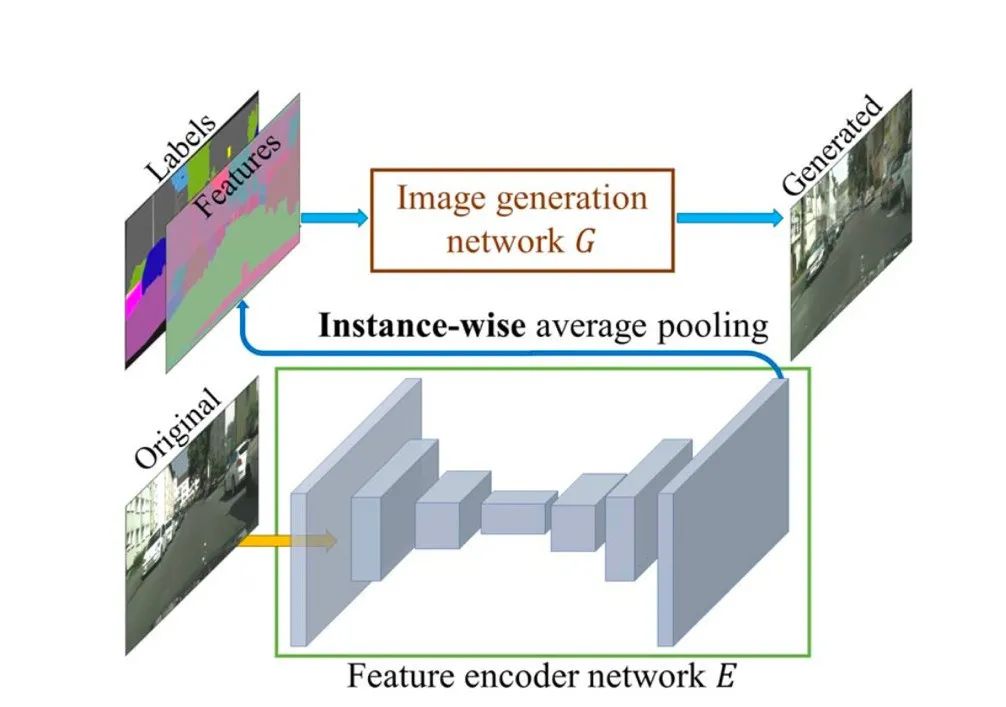

本文训练编码器E来学习与真实图像相对应的特征图。 为了使功能在每个实例中保持一致,本文在编码器的输出中添加了一个实例平均池化层。 然后将平均特征广播到同一实例的所有像素位置。 图5显示了编码特征的示例。

在获得该特征图E(x)之后,本文在等式中用G(s,E(x))替换G(s)。 (4)通过将标签图s和E(x)串联在一起,并与端到端的生成器一起训练编码器。 这使编码器能够捕获供发电机使用的最具代表性的功能,而无需明确告诉编码器“纹理”是什么。

训练编码器后,本文首先在训练图像中的所有实例上运行它,然后记录获得的特征。然后,本文针对每个语义类别对这些功能执行K-均值聚类。 因此,每个群集对特定样式的特征进行编码,在推理时,本文随机选择一个聚类中心并将其用作编码特征。对于每个对象,本文仅提供K种模式供用户选择。

图5.本文应用实例化池来使每个对象内的特征统一。然后将这些特征与标签连接起来,对E和G进行端到端训练,以重建原始图像。这使要素可以捕获高级对象信息

3.结果

实施细节本文使用LSGAN 进行稳定训练。 在所有实验中,本文设置权重λ= 10,K均值K = 10。本文使用一个三维容器为每一个目标特征进行编码。本文在训练目标(公式4)中加入感知损失,其中λ= 10并且代表第i层具有个特征数据的VGG网络。本文观察到这种损失会稍微改善结果。 本文将这两个变量命名为本文的变量和本文的变量(无VGG损失)。

3.1. 质量比较

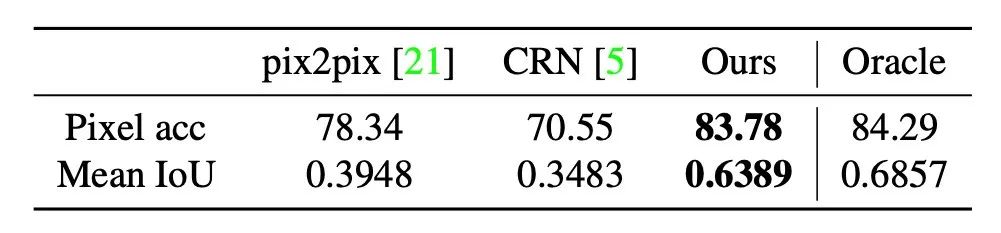

为了量化结果的质量,本文对合成图像执行语义分割,然后比较预测的分割与输入的匹配程度。如果本文能够产生与输入标签图相对应的逼真的图像,那么现成的语义分割模型应该能够预测地面真实标签。所获得的分割精度报告在表1中。可以看出,对于像素级精度和均值相交(IoU),本文的方法在很大程度上优于其他方法。 此外,本文的结果与原始图像的结果非常接近,从理论上讲,这是本文可以实现的现实的“上限”。

表1.在Cityscapes数据集上通过不同方法对结果进行的语义分割得分

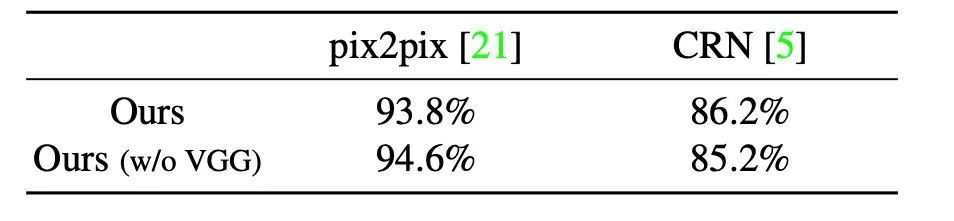

表2.Cityscapes数据集上的成对比较结果

3.2.人类感知研究

本文通过人类主观研究进一步评估了本文的算法。本文执行在Cityscapes数据集上的Amazon Mechanical Turk(MTurk)平台上部署的成对A / B测试。 本文进行两种不同类型的实验:无限时间和有限时间。

无限的时间对于此任务,人会立即获得两张图像,对于同一张标签图,每张图像都是通过不同的方法合成的。 然后给他们无限的时间来选择看起来更自然的图像。 左右顺序和图像顺序是随机的,以确保无偏比较。将所有500张Cityscapes测试图像进行10次比较,每种方法得出5,000人的判断。在本实验中,本文仅使用在标签上训练的模型(没有实例图)来确保公平的比较。 表2表明,本文方法的两个变体均明显优于其他方法。

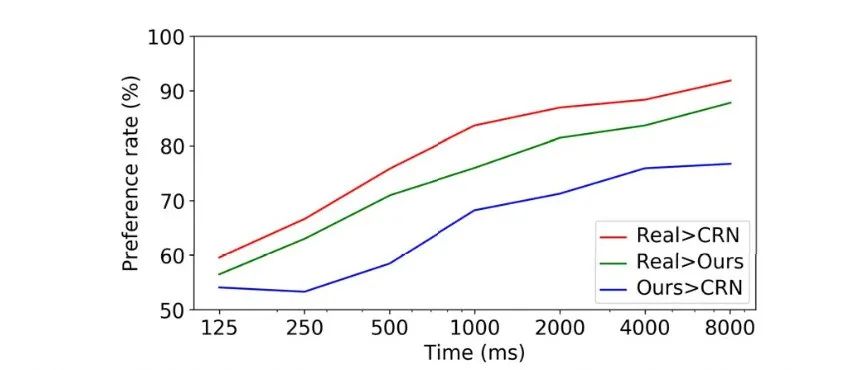

有限的时间对于有限的时间实验,在每个比较中,会拾取三个图像中的两个,并在短时间内显示它们。 本文根据先前的工作随机选择1/8秒和8秒之间的持续时间。这样可以评估图像之间差异的感知速度。 在不同时间间隔的比较结果如图6所示。可以看出,随着给定时间越来越长,这三个图像之间的差异变得更加明显并且易于观察。图7和9显示了示例综合结果。

图6.限时比较结果

损失函数的分析本文还使用无限时间实验研究每个项在目标函数中的重要性。 具体来说,本文的最终损失包含三个成分:GAN损失,基于鉴别器的特征匹配损失和VGG感知损失。 本文将最终实现与使用(1)仅GAN损失和(2)GAN +特征匹配损失(即无VGG损失)的结果进行比较。 获得的偏好率分别为68.55%和58.90%。 可以看出,增加特征匹配损失会大大提高性能,而增加感知损失会进一步提高结果(图7c,9b)。

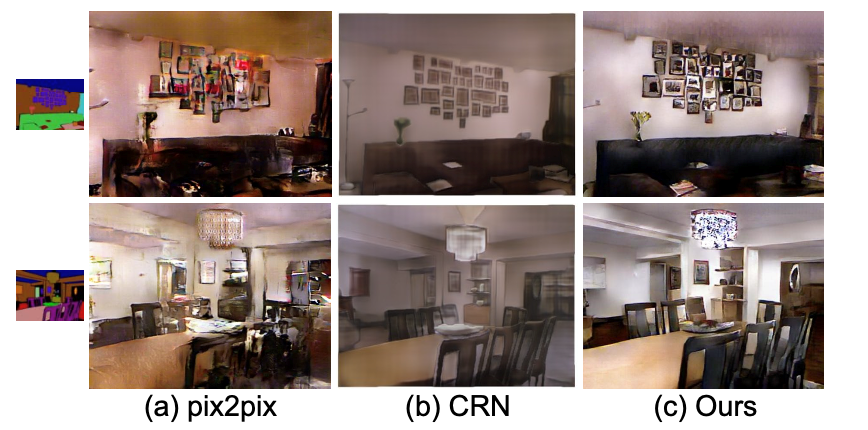

其他数据集此外,本文对NYU数据集执行无限时间比较(图8)。 本文分别获得pix2pix和CRN的86.7%和63.7%。最后,本文在ADE20K数据集(图10)和edge2photo应用程序(图2)上显示了结果。

3.3交互式物体编辑

本文的特征编码器使本文能够对结果图像执行交互式实例编辑。例如,本文可以更改图像中的对象标签以快速创建新颖的场景,例如用建筑物替换树木(图1b)。 本文还可以更改单个汽车的颜色或道路的纹理(图1c)。

图7.对Cityscapes数据集的比较(标签图显示在(a)的左下角)

另外,本文在Helen Face数据集上实现了交互式对象编辑功能,在该数据集上可以使用不同面部部位的标签(图11)。 这样可以轻松编辑人像,例如更改脸部颜色以模仿不同的化妆效果或在脸上添加胡须。

图8.在NYU数据集上的比较(标签图显示在最左列)

图9.在Cityscapes数据集上使用CRN 的其他比较结果

图10.ADE20K数据集上的结果(标签图显示在(a)的左下角)

图11.Helen Face数据集上的不同结果(标签图显示在左下角)

4.讨论与总结

本文的结果表明,条件GAN能够合成高分辨率的真实感图像,而无需任何手工制作的损失或预先训练的网络。本文的方法允许许多应用,并且对于需要高分辨率结果但未提供预训练网络的领域可能很有用。

本文还显示了图像到图像合成管道可以扩展以产生不同的输出,并在给定适当的训练输入-输出对(例如本例中的实例图)的情况下启用交互式图像处理。 在没有被告知什么是“纹理”的情况下,本文的模型学会了使用逼真的纹理对不同的对象进行样式化。这些学习的纹理也可以用于合成新数据集中的图像。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?