前言

录音采用的是AudioRecord,通过MediaCodec进行编码,用MediaMuxer合成输出MP4文件。

1.

这里用AudioRecord来得到从麦克风录制的声音,AudiorRecord的用法还是比较简单的,首先初始化AudioRecord

fun prepare(file: File?, outputFormat: Int = MediaMuxer.OutputFormat.MUXER_OUTPUT_MPEG_4, audioSource: Int = MediaRecorder.AudioSource.MIC, sampleRateInHz: Int = 44100, channelConfig: Int = AudioFormat.CHANNEL_IN_STEREO, audioFormat: Int = AudioFormat.ENCODING_PCM_16BIT, bufferSizeInBytes: Int = AudioRecord.getMinBufferSize(sampleRateInHz, channelConfig, audioFormat))

{

//初始化AudioRecord

prepareAudioRecord(audioSource, sampleRateInHz, channelConfig, audioFormat, bufferSizeInBytes)

//初始化输出文件

prepareOutputFile(file)

//初始化AudioEncoder

prepareAudioEncoder(sampleRateInHz, outputFormat)

}

private fun prepareAudioRecord(audioSource: Int, sampleRateInHz: Int, channelConfig: Int, audioFormat: Int, bufferSizeInBytes: Int)

{

minSize = AudioRecord.getMinBufferSize(sampleRateInHz, channelConfig, audioFormat)

audioRecord = AudioRecord(audioSource, sampleRateInHz, channelConfig, audioFormat, bufferSizeInBytes)

}

AudioRecord的构造函数需要出入几个参数。

(1).

audioSource代表音频来源,这里传入MediaRecorder.AudioSource.MIC,代表音频来源于麦克风。

(2).

sampleRateInHz代表以赫兹表示的采样率,传入44100,这个数值可以保证所有设备都正常工作。

(3).

channelConfig代表声道配置,AudioFormat.CHANNEL_IN_STEREO代表传入立体声。

(4).

audioFormat代表音频数据将被返回的格式。传入AudioFormat.ENCODING_PCM_16BIT。

(5).

bufferSizeInBytes写入音频数据的缓冲区的总大小(以字节为单位)这里默认传入getMinBufferSize,这个方法返回成功创建AudioRecord实例所需的缓冲区大小的最小值。

开始录音时,启动一个线程

private val recordRunnable = Runnable {

val data = ByteArray(minSize)

//AudioRecord开始录音

audioRecord?.startRecording()

while (isRecording)

{

//将音频数据写入ByteArray

audioRecord?.read(data, 0, data.size)

audioEncoder.start()

audioEncoder.drainEncoder(data)

}

audioEncoder.release()

audioRecord?.stop()

audioRecord?.release()

audioRecord = null

}

这样就把音频数据写入一个bytearray,然后将数据传入AudioEncoder进行编码输出。

2.

AudioRecord得到的音频数据格式是pcm的,一般情况下无法bofang(可以通过AudioTrack播放),所以我们需要一次编码转换,这里用到的就是MediaCodec,MediaCodec这里我封装在AudioEncoder里。

我们首先要初始化MediaCodec:

private fun prepareAudioCodec(bitrate: Int, sampleRate: Int)

{

bufferInfo = MediaCodec.BufferInfo()

val mediaFormat = MediaFormat()

mediaFormat.setInteger(MediaFormat.KEY_AAC_PROFILE, MediaCodecInfo.CodecProfileLevel.AACObjectLC)

mediaFormat.setString(MediaFormat.KEY_MIME, MediaFormat.MIMETYPE_AUDIO_AAC)

mediaFormat.setInteger(MediaFormat.KEY_BIT_RATE, bitrate)

mediaFormat.setInteger(MediaFormat.KEY_CHANNEL_COUNT, 2)

mediaFormat.setInteger(MediaFormat.KEY_SAMPLE_RATE, sampleRate)

audioCodec = MediaCodec.createEncoderByType(MediaFormat.MIMETYPE_AUDIO_AAC)

audioCodec.configure(mediaFormat, null, null, MediaCodec.CONFIGURE_FLAG_ENCODE)

}

这里需要创建一个MediaFormat,具体需要传入的参数大家可以参考开发者文档,需要注意的是音频和视频的MediaFormat设置的参数是不一样的,接着调用MediaCodec的configure,此时MediaCodec已经进入了configured的状态,可以开始进行编码了。

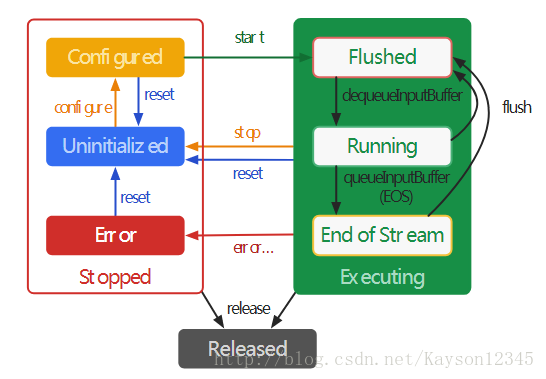

这里说到MediaCodec的状态,大家可以看来自开发者文档的MediaCodec的状态机图片。

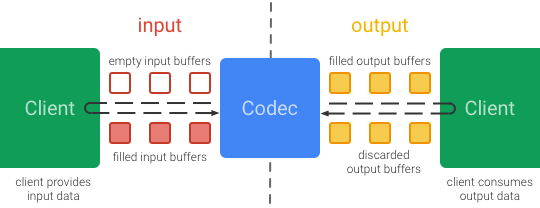

看一下MediaCodec的工作过程:

可以将MediaCodec理解为传送带,将空的buffers传给audiorecord,audiorecord将得到的bytearray放入空的buffers,然后传入MediaCodec,mediaCodec编码后,传入MediaMuxer,MediaMuxer写入编码后的数据再讲buffers传给MediaCodec,MediaCodec清空使用过的Buffers,再传给AudioRecord。buffer是java nio库里的类,这里就不详述了,不清楚的请自行google。

调用configure后,我们就进入了configred状态,之后当audiorecord得到数据后,当MediaCodec调用start方法后,将ByteArray传入MediaCodec,进行编码:

fun drainEncoder(data: ByteArray)

{

val inIndex = audioCodec.dequeueInputBuffer(0)

if (inIndex > 0)

{

val inBuffer = getInBuffer(inIndex)

inBuffer.clear()

inBuffer.put(data)

if (!isEncoding)

{

audioCodec.queueInputBuffer(inIndex, 0, 0, System.nanoTime() / 1000, BUFFER_FLAG_END_OF_STREAM)

} else

{

audioCodec.queueInputBuffer(inIndex, 0, data.size, System.nanoTime() / 1000, 0)

}

}

do

{

val outIndex = audioCodec.dequeueOutputBuffer(bufferInfo, 0)

when

{

outIndex > 0 ->

{

if (bufferInfo.size != 0)

{

val outBuffer = getOutBuffer(outIndex)

outBuffer.position(bufferInfo.offset)

outBuffer.limit(bufferInfo.offset + bufferInfo.size)

mediaMuxer.writeSampleData(trackIndex, outBuffer, bufferInfo)

}

audioCodec.releaseOutputBuffer(outIndex, false)

}

outIndex == MediaCodec.INFO_OUTPUT_FORMAT_CHANGED ->

{

trackIndex = mediaMuxer.addTrack(audioCodec.outputFormat)

mediaMuxer.start()

}

}

} while (outIndex > 0)

if (bufferInfo.flags and MediaCodec.BUFFER_FLAG_END_OF_STREAM != 0)

{

isEncoding = false

}

}

这个方法就对应了MediaCodec对应的工作过程。

3.

MediaMuxer用来合成并输出音频,MediaMuxer用法还是比较简单的,这里就不详述了,需要注意的是,MediaMuxer只能合并一个音频轨道和一个视频轨道,还要注意的是要在addTrack调用之后再调用star方法。

最后附上项目地址

总结

以上就是这篇文章的全部内容了,希望本文的内容对大家的学习或者工作具有一定的参考学习价值,如果有疑问大家可以留言交流,谢谢大家对脚本之家的支持。

1478

1478

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?