EM算法在很多博客中都被描述成最为简单的算法,甚至不能称之为算法。但是我却花费了很长时间试图来理解这个70年代就被提出来的概念,却也是雾里看花,似懂非懂的状态。其中很大的一个原因就在于虽然讲述Expectation-Maximization文章虽然很多,但是其中很多作者都是在不加咀嚼地转述Andrew Ng视频,或者就是把Jensen不等式一列,炫技一把就撤了。每次都是眼看着要明白了,结果突然之间就戛然而止,让人唏嘘不已,直到有一天我实在是无法忍受这种感受,便学着Kevin Knight斗胆来说一说我理解的EM算法。

1. 参数估计

说到EM算法,最为原始的冲动在于参数估计,也就是我们对某个系统yy了一个公式,然后希望用一套科学的方法来推算出公式中的未知参数。这时候你脑子里可能就翻出了陈希孺老师在《概率论与数理统计》里面讲述的点估计、极大似然估计(MLE)、贝叶斯估计以及最大后验估计(MAP),实际上EM算法也没有跳脱出这个范围,只是EM给我们提出了新的挑战:如果我们观测到数据不是事情的真相,而只是浮在海面上的冰山一角,或者说是只见花开,而不知春天的到来,在这种情况下我们该怎么去参数估计呢? 首先我们看一下最为简单的最大似然估计,通过最大化样本出现的概率从而获得参数

![]()

的估计值,也就是

![]()

,这个神奇的想法是参数估计中一个重要的发展。 既然说到这里就不得不说起贝叶斯学派的思想(为后面介绍MAP奠定一点基础):第一个变态的想法就是所有的参数都需要服从一个分布

![]()

;第二个假设在很多文章中都没有提到:所有的样本的概率是确定的,关于这个假设大家可以参考一下陈希孺先生写的《数理统计学简史》。不得不承认这一点确实很高明,因为如果样本的概率是确定,这里以贝叶斯参数估计模型:

![]()

注意到上面公式两个很巧妙的地方没有,

![]()

是一个关于

![]()

分布,而

![]()

又是确定的,既然是确定的,那么我们就可以只考虑联合分布函数:

![]()

的概率,归一化之后就是

![]()

的分布了,有了

![]()

的分布,那么参数估计也就成功了。只不过这里需要引入一个人为制定的先验概率

![]()

,也就是先验知识。在这种情况下借鉴一下MLE的思路,我们是否可以找到一个

![]()

使后验概率

![]()

最大,把

![]()

看做是

![]()

的一个点估计,MAP就是这样一个点估计参数的模型,只不过较之MLE增加了后验概率

![]()

,作用就相当于一个平滑,让模型不要太过相信样本量比较少的估计值。

2. 隐变量的参数估计

写了这么一大段,EM算法与上述MLE和MAP有什么关系呢?其实这些问题最后都是转换为一个最优化问题,找到那个最理想的$

![]()

$让目标函数最大,只不过MLE是

![]()

,而MAP是

![]()

。如果你理解了以上的简明介绍,这里可以悄悄地告诉你EM可以算是MLE的私生子,都是

![]()

,那么区别在哪儿呢?其实特别简单,那就是

![]()

跟

![]()

之间不存在一个直接的关系,而是需要通过一个隐变量

![]()

才能建立联系。如果这里把

![]()

和

![]()

比作潘金莲和西门庆,那么

![]()

就是那位伟大的女性王婆了。如果理解了这样的关系,后面你就不会疑惑为什么要搞一个关于隐变量

![]()

的联合概率了。把一个问题转换成一个带中间隐变量的问题向来是各路算法流派中重要的套路,比如PCA、SVD、MF、pLSA以及LDA,这种思路其实就是某种意义上Factorization。如果你拿着Factorization的有色眼镜去观察DNN、Inception在某些细节,会发现其实都是这个套路:把一个复杂的问题通过有限的隐变量来表示,可以让原始问题更加容易解,并且得到的模型泛化能力更强。 既然前面介绍了为什么要引入隐变量

![]()

,

![]()

是

![]()

的概率分布函数,那么概率公式就需要改变一下了:

![]()

这个形式的东西我们自然是不习惯了,既然EM最优化公式是:

![]()

,那么与上面的公式是怎么联系起来的呢? 其实一个简单的积分就可以求得:

![]()

好了,我们已经通过一个简单的操作把隐变量

![]()

引入进来了,这里

![]()

是一个连续的变量,对于人类来说不是特别容易理解,所以很多情况下我们把

![]()

简化成离散的变量,比如GMM就是不同的高斯函数分布,那么上面的积分公式就可以表示成下面的公式了:

![]()

上面式子中的

![]()

表示的是样本

![]()

,样本概率之间的独立的,所以就变成了一个连乘的式子。好了,最优化的目标总算是确定了,那就是:

3. 最优化求解

写到这里我也有摆出Jensen不等式的冲动了,在打消了这个罪恶的念头之后,我觉得我们需要先来看一下上面公式中让人很为难的部分:

![]()

为什么说这个问题让我们为难呢? 首先

![]()

是个什么玩意?或者说我们在用EM算法的时候这个联合概率分布到底是个什么鬼?其实大家不要被它的数学表达式唬住了,本质上这个东西就是一个假设,使我们对于数据服从什么分布的一种假设,例如如果是GMM模型,这个假设就是:

![]()

,

![]()

表示的是不同的正态分布

![]()

,而

![]()

就是

![]()

组成的集合(注意这里是没有下标

![]()

的)。如果是HMM问题呢?我们需要求的是一个序列问题,而不是一个一个独立分布的样本了,这个时候

![]()

和

![]()

都变成序列

![]()

和

![]()

了,所以

![]()

,这里面看起确实复杂了很多,但是HMM做了一些简化:同一个序列中输出只与当前状态有关,当前状态只依赖前一个状态,这样我们在求序列概率时就可以用动态规划来求解了。

![]()

分别是其实状态概率、emit矩阵和transfor矩阵,也就是我们需要估计的参数

![]()

,注意这里不同词的隐变量之间并不是独立的,而是存在一个转移概率的。 这里涉及到了两个常见的模型,如果没有对应的知识,看起来确实蛮累的,不过我有点偷懒了,不熟悉的同学看看我的其他笔记吧。既然是一个假设,意思就是怎么着都是合理的,你也不必太纠结,唯一要时刻牢记的是:这里面有一个隐变量

![]()

以及要估计的一堆参数

![]()

。 其次让我们为难的地方就是

![]()

里面有一个求和的公式,这个东西实在不是很友好,如果是连乘那模型是不是就可以得到简化很多了呢?所以EM算法也是想到了这点,并且做到了这点。在进入到EM算法描述之前,我们需要提一下Jensen不等式了,只能说能够想到这个公式的同学真是大神,可见数学功底是多么得重要。一般人推到公式

![]()

就没什么办法了,因为这个公式是一个

![]()

在

![]()

里面的运算,无法化简了。于是就有人想是不是可以把

![]()

和

![]()

交换一下位置,这样不就可以搞成一个更加和谐的模型,于是大神就想到了,Jensen不等式好像可以处理这个问题啊,我们不妨列出Jensen不等式:

![]()

当然这个不等式要是成立还需要一些条件:第一个条件就是

![]()

;第二个条件是

![]()

要是一个凸函数,也就是Hessian矩阵是个正定矩阵;另外什么时候可以取到

![]()

呢?这样就可以找到一个最大的下界了,等式条件成立的条件就是:

![]()

是个常数。

我们发现

![]()

就是满足Jensen不等式要求的函数

![]()

,但是不等式中需要一个

![]()

的存在,但是公式

![]()

好像什么都没有啊,别着急如果没有我们可以强势加入一个

![]()

,是时候来一波转换了:

![]()

所以我们就可以来写一下这个不等式在公式

![]()

中的表现形式了:

公式

![]()

给出了一个所有样本出现概率的下界,而且需要注意到的是:这个下界竟然还有取

![]()

的时候。如果我们贪心一点,把等号的条件满足了,那我们是不是就拿到了最优化目标函数的最大下界呢?有了这样的一种设定之后,我们再来看看等式成立的条件:

这里你有没有想起来贝叶斯估计里面的第二个假设:样本出现的概率

![]()

是已知的,所以

![]()

,同时

![]()

,所以我们惊喜地发现我们只需要把

![]()

取成

![]()

不就可以让不等式成立了嘛,所以

你有没有感觉这个公式好像有点问题啊,我们还不知道最优的

![]()

应该取什么值,做了这么长时间的变换以及推导好像并没有解决最优化的问题啊,毕竟直接对

做最优化时还需要知道

![]()

的具体值,而显然我们是不知道的。 该怎么办呢?这就是EM大法施展魔法的时刻了,我们把最优化的公式变动一下:

看出来没有,公式

![]()

实际上只是把

![]()

换成了

![]()

了,而且我们假设这里面的

![]()

是一个固定值,那么我们就可以求得:

上面的公式我们可以看到

![]()

也是一个定值了。这个时候最优化的问题变成了:

貌似我们就可以做最优化了,从而求得最优解

![]()

,但是其实我们也太乐观了,因为目前为止

![]()

是否能够给出一个完美的数学表达也会影响我们是否可以直接求得解析解,或者利用随机梯度下降才能够求得最优解,甚至有些假设太过复杂无法用数学公式给出,所以重点又回到了这个假设我们该怎么构造上了。

4. Expectation-Maximization

写到这里你有没有一点点感受,我们好像抓到了EM的脉络了,公式

![]()

不就是我们经常提起的EM中Expectation吗?那么Maximization不就是我上面提到的最优化的过程吗?哇喔,一切是不是就变得特别清晰了啊。 在Expection阶段,我们把最优化的问题搞成一个期望,这个是目标函数的一个最优下界:

然后在Maximization阶段,我们把公式

![]()

当做一个关于

![]()

的最优化问题:

![]()

现在就只剩下一个问题了,

![]()

该怎么取值呢?其实如果你知道EM算法是个迭代的过程,那么取值也就迎刃而解了:一开始我们可以随机给个值,然后每次迭代中我们取上一次迭代最优化的结果

![]()

。 好了写到了这里,我们大概就知道EM是怎么运作的了,但是又有一个问题浮现了:这样的Expectation-Maximization不断交替迭代的过程为什么能够保证我们最终能够取得最优值呢?其实这个里面蕴含着一个朴实的道理:当目标函数有两个不可知的变量

![]()

和

![]()

,我们可以事先固定一个参数

![]()

,然后最优化计算另外一个参数

![]()

,然后固定

![]()

最优化求解

![]()

,依次迭代交替,我们每次都选择一个最好的选择(steepest gradient),最终我们就可以找到那个终极的目标值,好像跟我们人类做决策也是有异曲同工之妙。类似上述的最优化过程,在EM中每次Expectation的过程实际上最大化下界,接着固定好这个下界,利用Maximization去最优化估计

![]()

这个参数,最优化参数

![]()

把下限函数推向一个更优的方向,接着我们又在这个最优的方向上再估计一个下界函数,以此类推迭代下去。如果目标函数是一个凸函数,随着迭代的进行,我们每次进步一点,最终就可以到达那个最优解了。

5. 用EM来理解HMM

按照常规的套路这里我们应该举一个GMM(Gaussian Mixture Model)的例子结束,然后根据GMM的假设我们竟然可以求得解析解,哇喔皆大欢喜。但是事实上EM应用的场景肯定不是这么简单任性的,问题假设也不会像GMM那样是一个高斯函数的线性组合。所以这里我最想讲的一个例子是:HMM(Hidden Markov Model),这是一个很典型的具有隐变量,同时又是一个Generative Model的假设,而且我们在训练HMM的时候用的最常见的方法是Baum-Welch算法。有很多文章点出来Baum-Welch算法其实就是一个EM算法的一个特例,但是两者该怎么联系到一起呢?所以接下来的内容我想要的做的事就是用EM来估计HMM的参数。

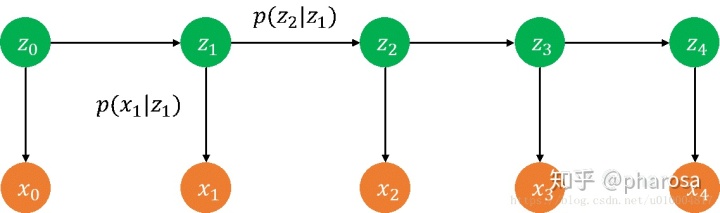

首先我们来看一下HMM的模型假设,类似于图中所描述的,

![]()

表示的是我们观测到一个序列(一句话或者是一条语音),

![]()

就是我们想要求得隠变量,在分词问题中

![]()

表示的是BIES(B-开头词,I-中间词,E-末尾词,S-单独成为词)标注中的4种状态。不同变量之间的依赖关系用带有箭头的直线表示,那么这个模型的参数就包含了3个部分:

- 起始状态的分布:

![]()

,也就是图中的

![]()

节点的概率分布

- 状态之间的transfor概率:

![]()

,表示当前节点的转态分布只跟前一个节点的转态相关

- 输出的Emition概率:

![]()

,表示当前节点的输出只跟当前节点的状态有关

有了模型的假设之后,我们就可以做一件无脑套公式的事了,把EM算法中的

![]()

替换成HMM的模型假设就可以了:

这里假设把

![]()

看做是一个一个不同的序列,那么

![]()

表示的就是这个序列以及它的隐变量的联合概率 分布了。按照HMM的模型假设,我们可以直接给出:

除了上面的联合概率公式,我们还需要计算一个概率分布,也就是

![]()

,这里的

![]()

是上轮优化得到的最优化的

![]()

,是个定值,这个地方值得注意的是

![]()

是个序列,所以

![]()

指的是所有可能出现的序列的具体概率。这个概率该如何来求解呢?聪明的同学应该立刻就回忆起HMM中的forward-backward算法了,其实就是简单的动态规划问题,这里就不继续展开了。如果你不了解这个算法也没有关系,你只需要知道有一个算法能够根据已经给定的参数

![]()

和输出的数据计算出两个概率

![]()

和

![]()

,分别表示:

这两个类参数我们已经通过某个算法求得了具体的值,就是两个关于

![]()

的查询表,根据上面的公式,我们还可以得到在序列

![]()

位置,状态为

![]()

的概率如下:

上面这些就是HMM最为重要的背景知识,本质上就是两个不同维度推导出来的联合概率,有了这两个联合概率,我们回过头来再来看一下最大似然函数:

上面的式子如果我们换一个角度来看,比如以

![]()

、

![]()

以及

![]()

的在样本中所有的可能取值进行求和,本质上面的式子没有变换,只是换了个角度求和而已:

如果你观察上面的公式,其实就是三个不同状态的计数

![]()

、

![]()

以及

![]()

而已。上面式子其实也很清晰了,只是剩下一个

![]()

悬而未决了,这个式子表达的含义:假设参数已经求解出来了,是给定一个输出

![]()

,对应的隐变量序列

![]()

的概率。有同学一看到前面搞的一堆公式,心里可能就有点犯怵,事实上要想完整地推导出

![]()

这个概率还是不太容易的。这个时候我们还是要回到EM算法的本质上来,回想一下我们每次只需要找一个下界函数,然后优化下界函数,至于这个下界函数是不是非要符合一个完整统一的定义,其实并不特别重要。那么我们是不是考虑把优化函数中的三个式子改造一下,分别搞一个我们能够通过forward-backward计算出来的条件概率,三个条件概率的形式不同:

这样做的目的其实也非常简单:我们搞一个可以根据前面公式

![]()

求得的条件概率(已知联合分布,归一化一下就可以求得条件概率了)。虽然看起来不是一个我们期待的EM算法公式,特别是求期望的时候用到了3种不同的条件概率,仔细考虑一下:这种改变实际上还是一个函数下界,还是可以纳入EM这个大的框架下的。所以在应用EM算法的时候不要照本宣科,重要的是把握EM这种思想,这也是为什么很多同学不把EM看做一个算法,而只是一种思想。

其实写到这里问题已经讲的很明白了,如果大家再看看Baum-Welch算法或者其他的博客内容,大家应该就容易理解这些内容了,后面的流程无非是根据三个概率总和等于1的约束条件,利用拉格朗日乘子就可以求得不同参数的解析解了。这个不是我讲EM算法的重点,后面的内容我就偷懒一下了。还是回到前面的那句话:EM算法的精髓在于逐渐逼急最优的思想,而不是Jensen不等式或者是最优化过程,这样你就能理解为什么K-Means也可以被称为EM算法了,所以懂得利用这种思想远比懂得推导本身要来得重要得多。

6. 总结

其实说到EM算法的理解,你可以延伸到很多领域,某种程度上它就是非监督学习的一个重要的基石,有一篇很好的导引《EM算法的九层境界》,按照上面的说法这里最多也只是介绍了功法的前三重,后面还有很多融汇贯通,打通任督二脉的事。理解EM算法也是修炼非监督学习重要基石之一,后面如果有时间我会再来介绍一下后面的六重天,祈祷我也能打通EM的任督二脉吧。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?