又到一年升级时—手头TF卡横评乱斗!

一年之计在于春,各行各业都忙着开工复产。作为在数码IT爱好者的各位值友,谁手上没有个几张TF卡?

趁着这个新春之计的时节,各个厂家品牌都推出了自己的新品TF卡。自己趁着这个假期也整理了手头的TF卡,来一个小规模的横向测评吧。

一、搞清TF卡

在我的印象中,当时为了使用诺基亚的扭腰式音乐手机5700,第一次为手机配备TF卡,这才是TF卡第一次真正走进了我的生活,

在此之前一直傻傻搞不清TF卡与SD卡的区别与关联,直到第一次入手TF卡才明白,它们二者之间真正的区别和联系。

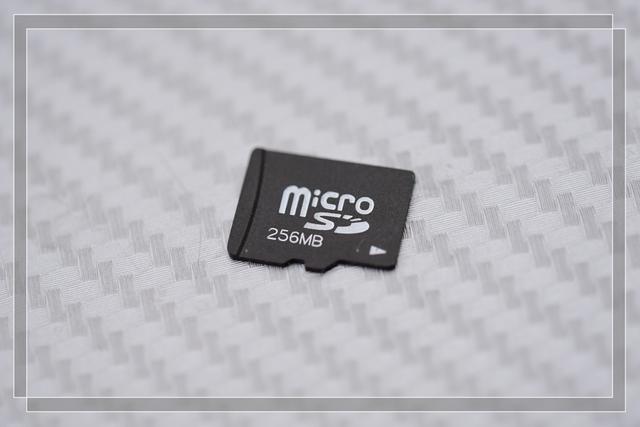

这是我目前手头最久远的TF卡,容量256MB,品牌未知。

二、手头的TF卡

这些TF卡,从最早的到最晚的,前后时间跨度也将近15年了,看看TF性能进化到了什么程度。

1、不知名TF卡,品牌未知,容量256MB,由于容量太小现在基本无法使用。

进行速度测试已经没有意义,不再测试。

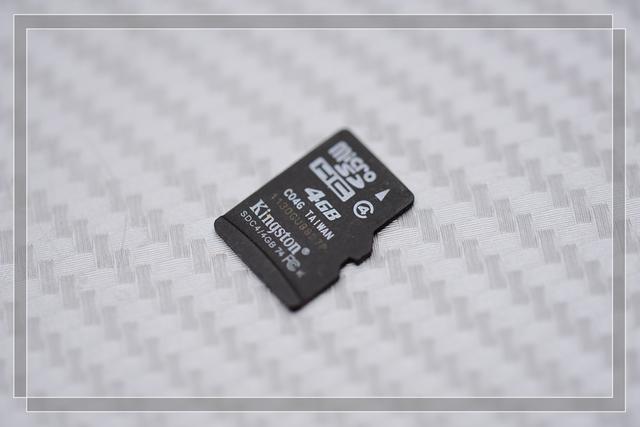

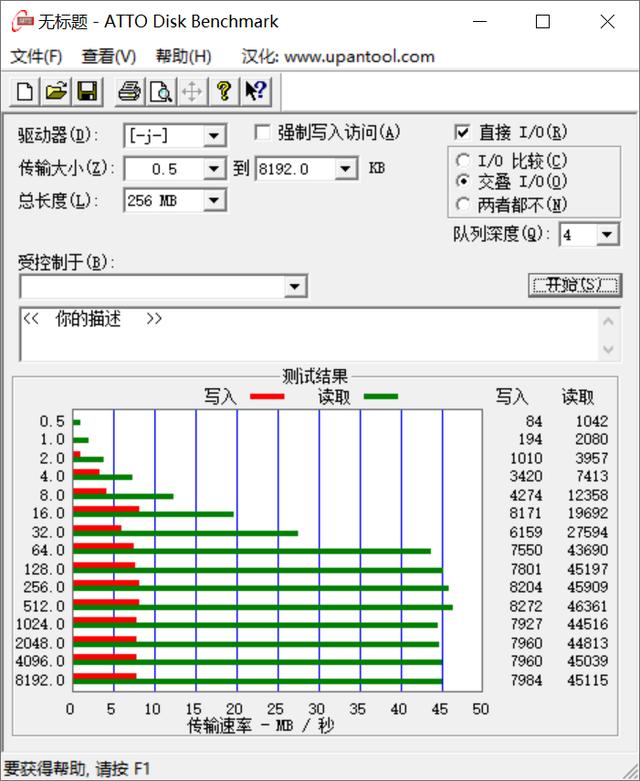

2、金士顿4G TF卡,现在用于随身调频音响,非常适合晨练的时候,不想听广播了,可以听音乐。

进行速度测试:

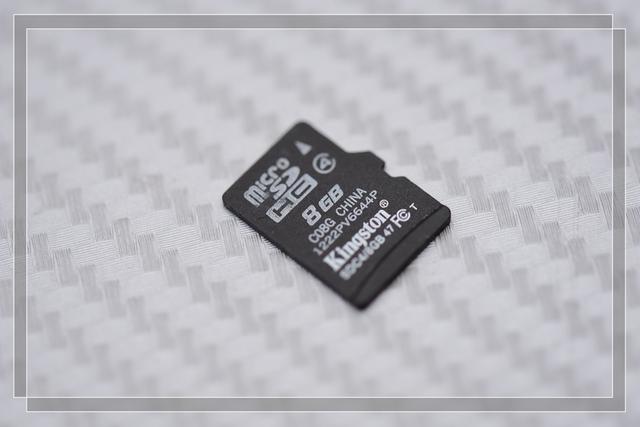

3、金士顿8G TF卡,现在已经坏掉,个人闲置,后来查询不是正品,当年被电脑城坑了。

进行速度测试:TF卡损坏,无法完成。

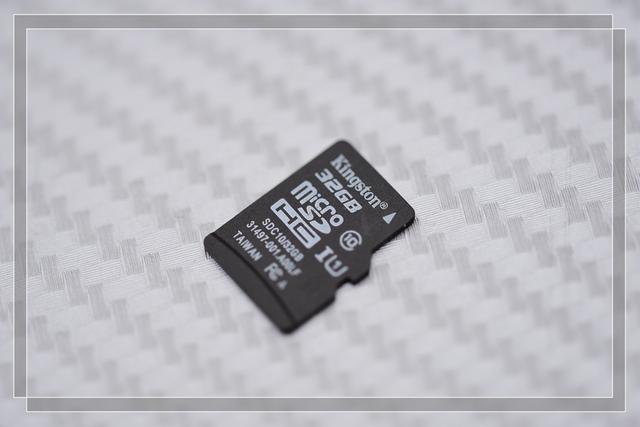

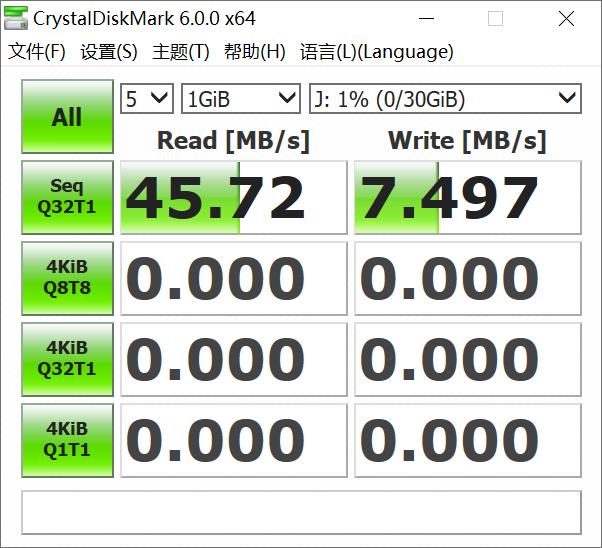

4、金士顿32G TF卡,曾经用于行车纪录仪,由于TF卡容量逐渐升级,现在个人闲置。

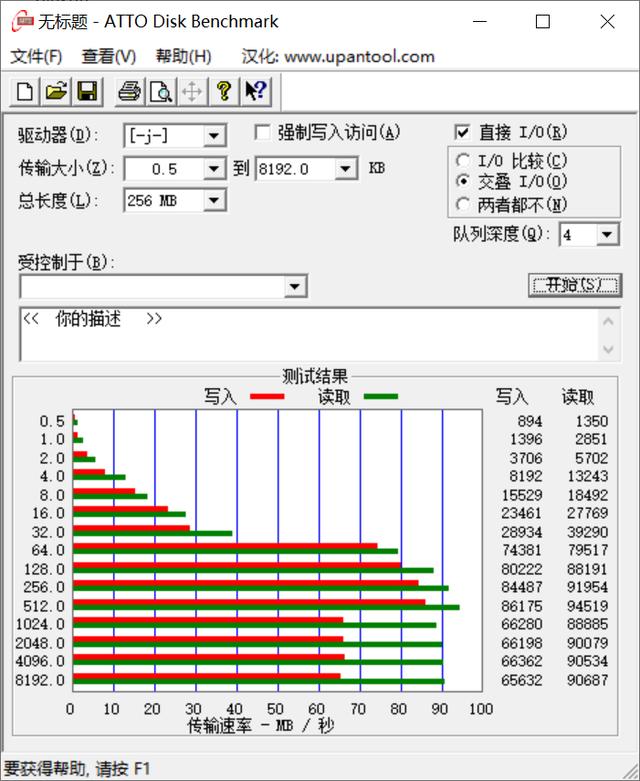

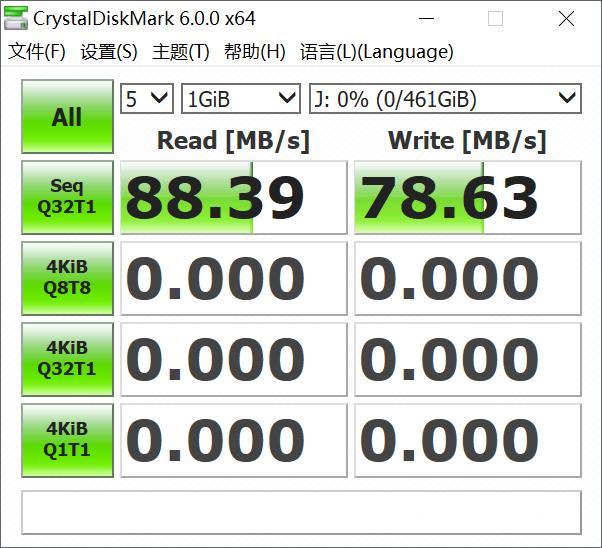

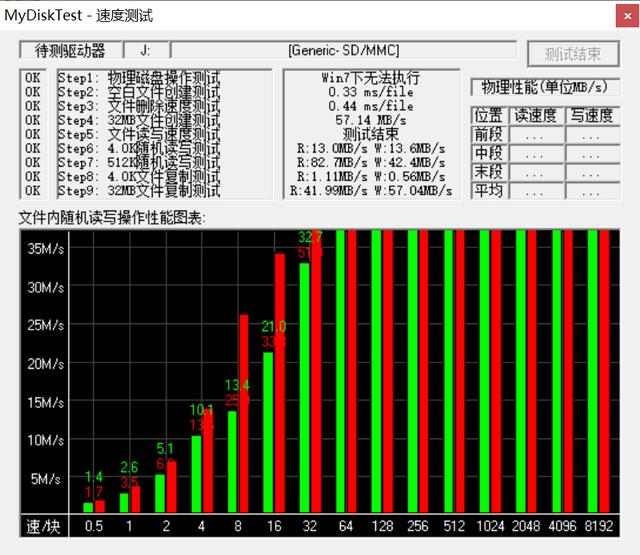

进行速度测试:

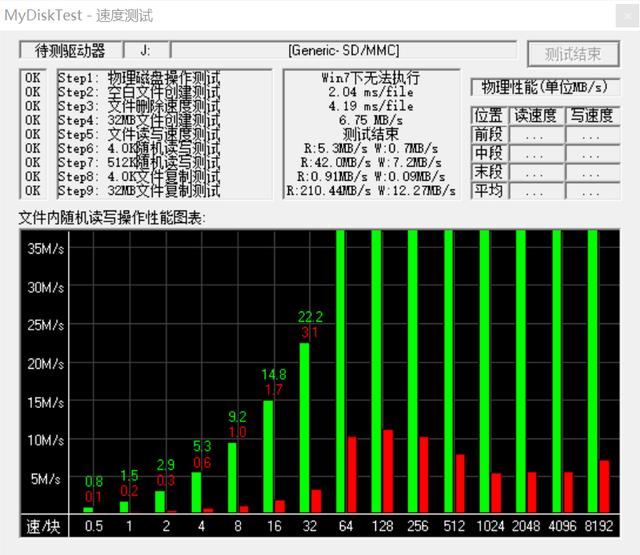

5、金士顿C10 32G TF卡,某外设论坛活动奖品,此卡具有三防功能,适合野外、模型、水下等场景使用。

进行速度测试:

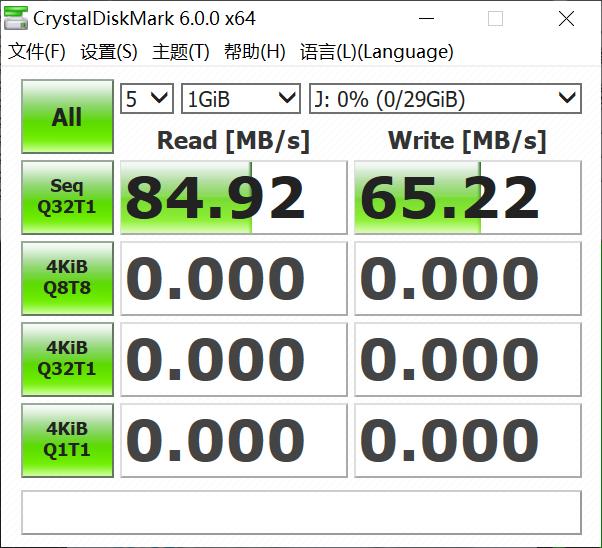

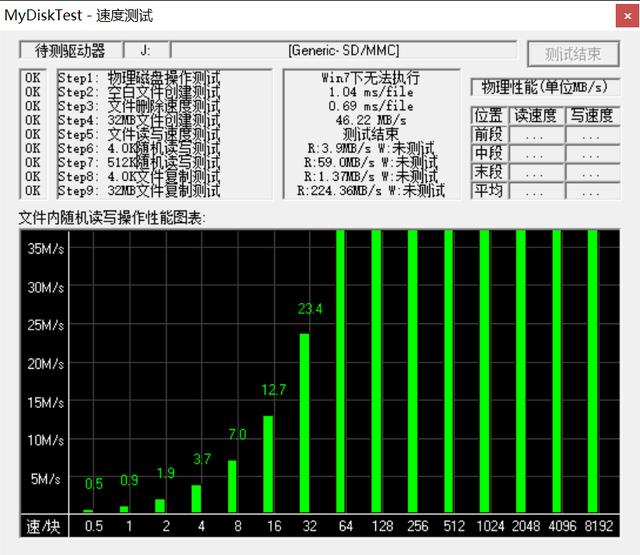

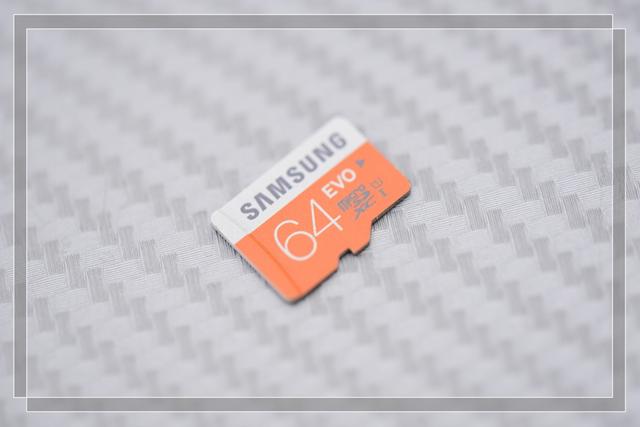

6、三星64G EVO TF卡,曾经用于单反相机,现在个人闲置,准备用于HIFI播放器。

进行速度测试:

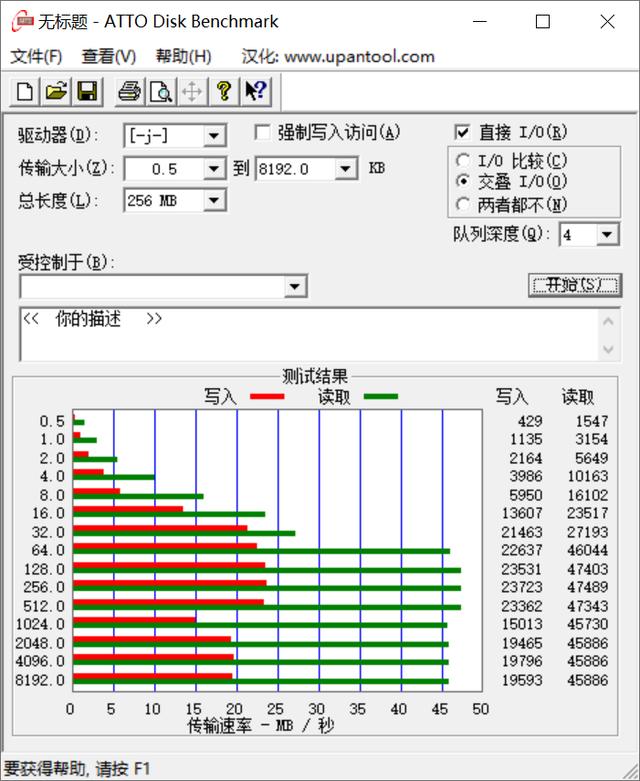

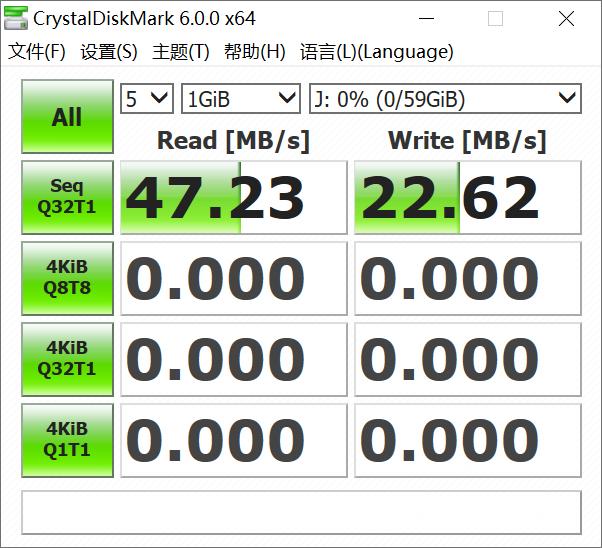

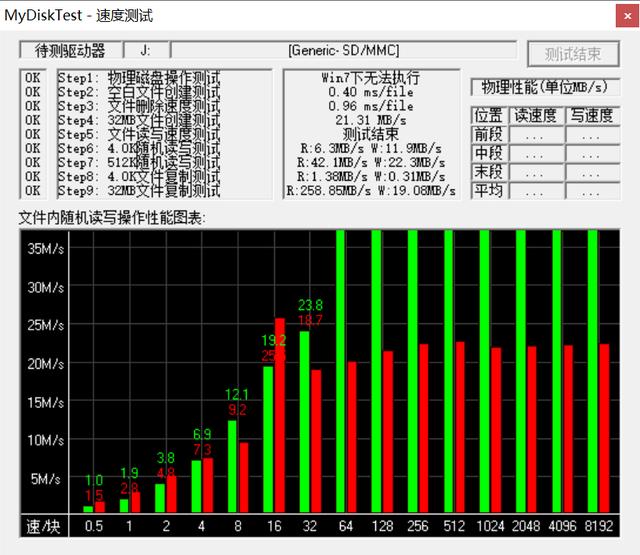

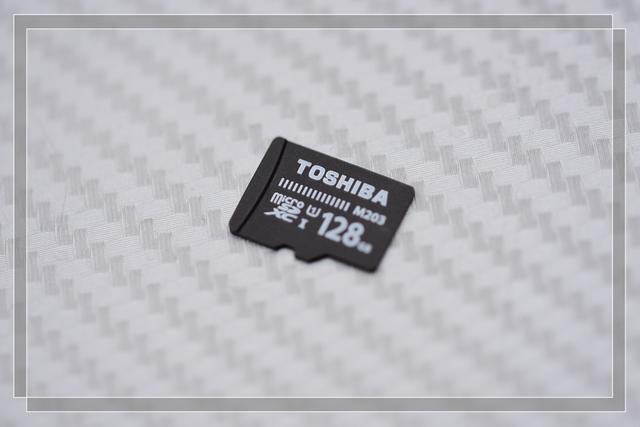

7、东芝128G M203 TF卡,东芝存储VIP会员俱乐部活动奖品,以速度快作为主要卖点。

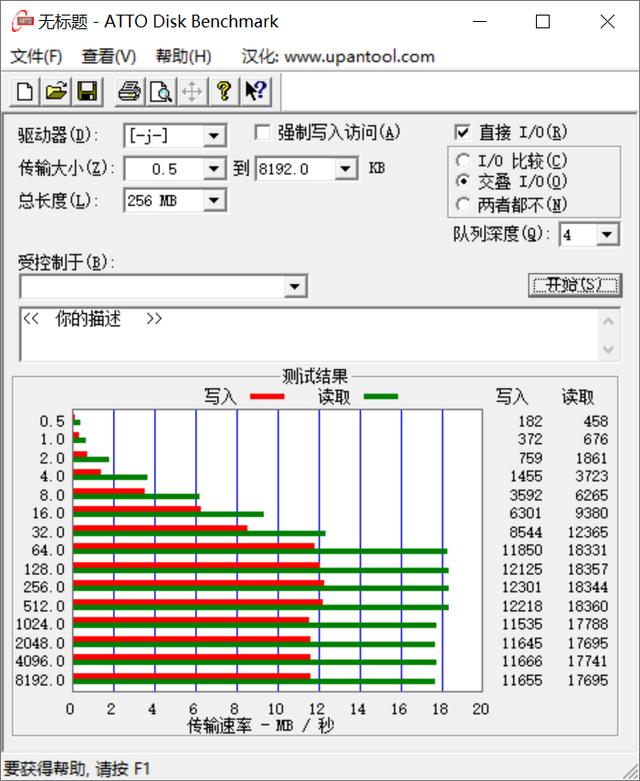

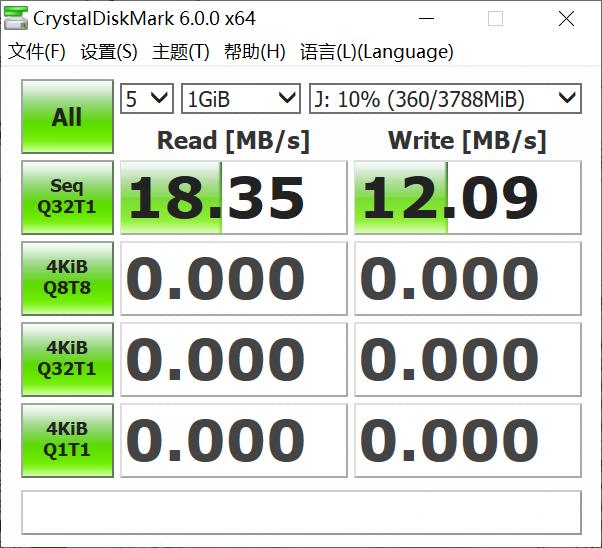

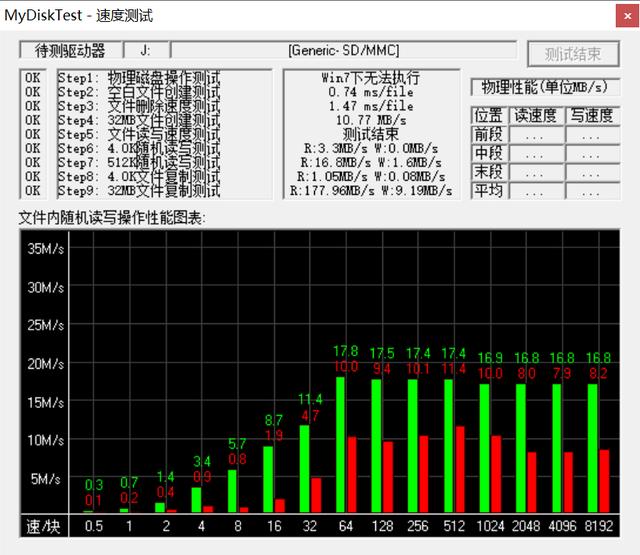

进行速度测试:

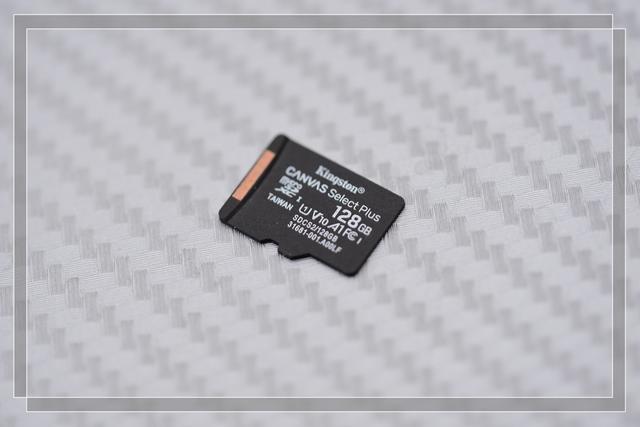

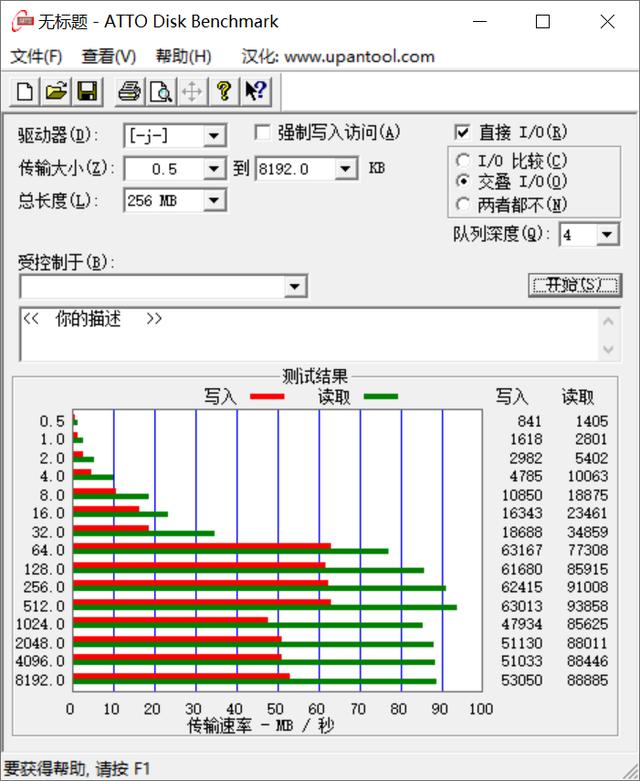

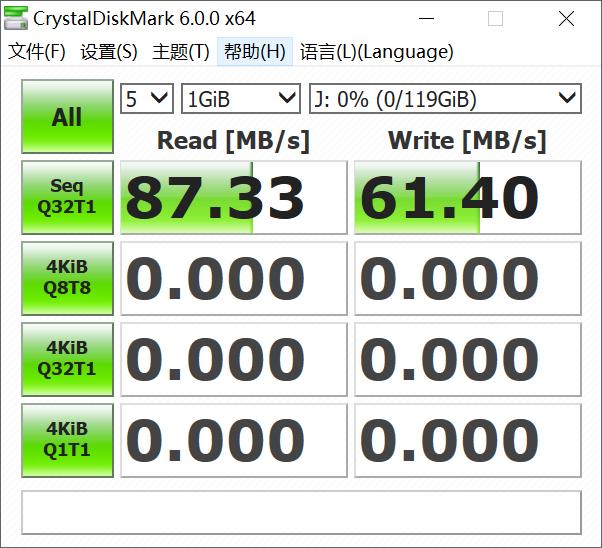

8、金士顿128G SELECT TF卡,春节前购买于JD商城,现在用于行车记录仪,主打数据安全和可靠。

进行速度测试:

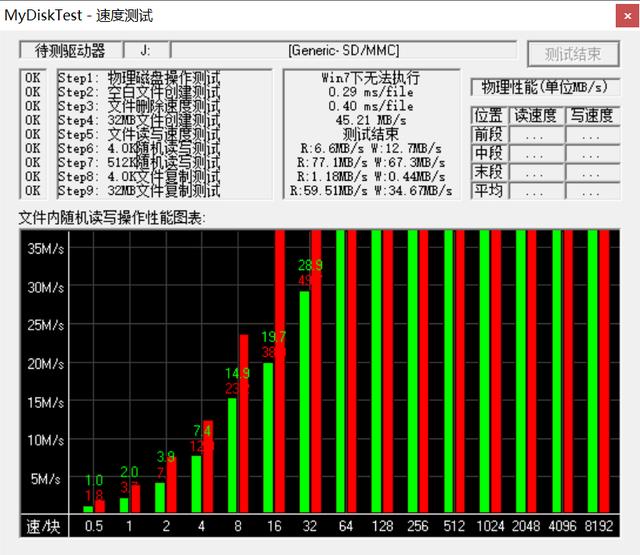

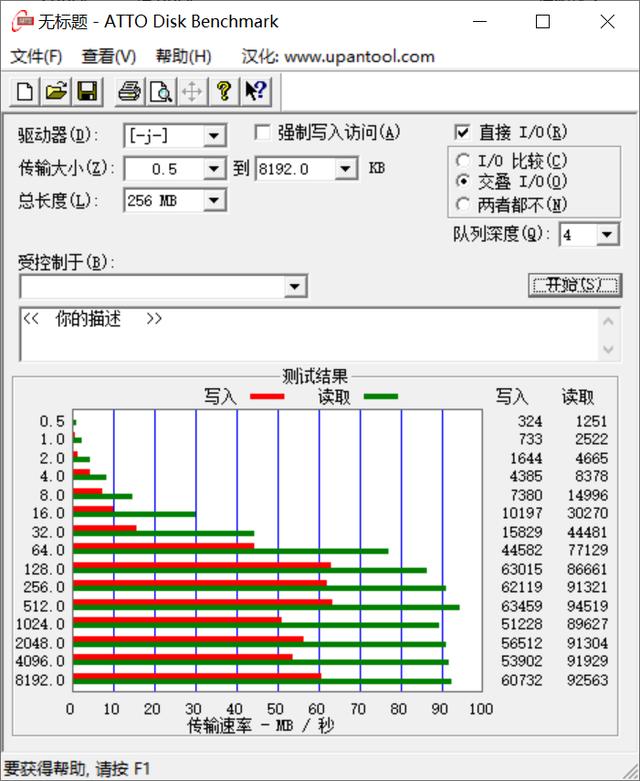

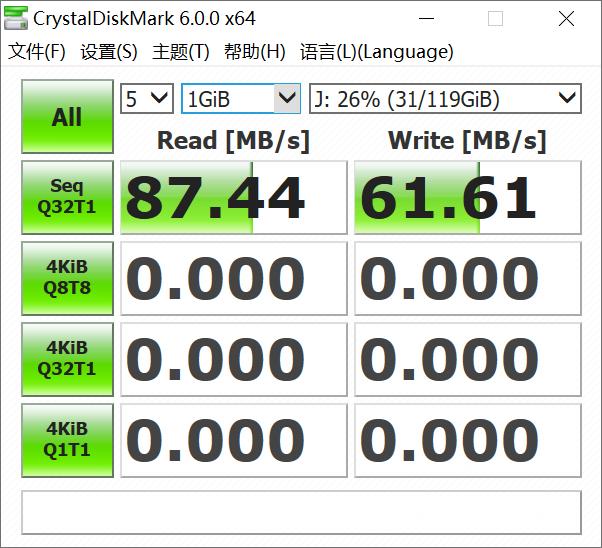

9、闪迪128G ULTRA TF卡,主要用于HIFI播放器,在马爸爸家赠买HI-RES音乐的载体。

进行速度测试:

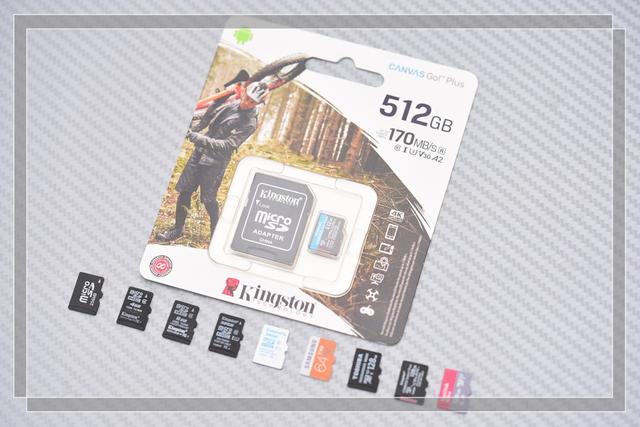

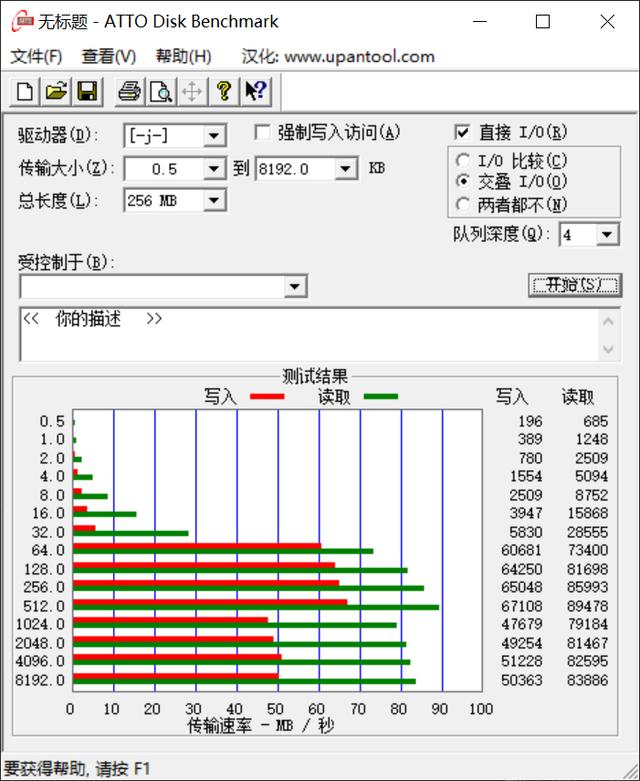

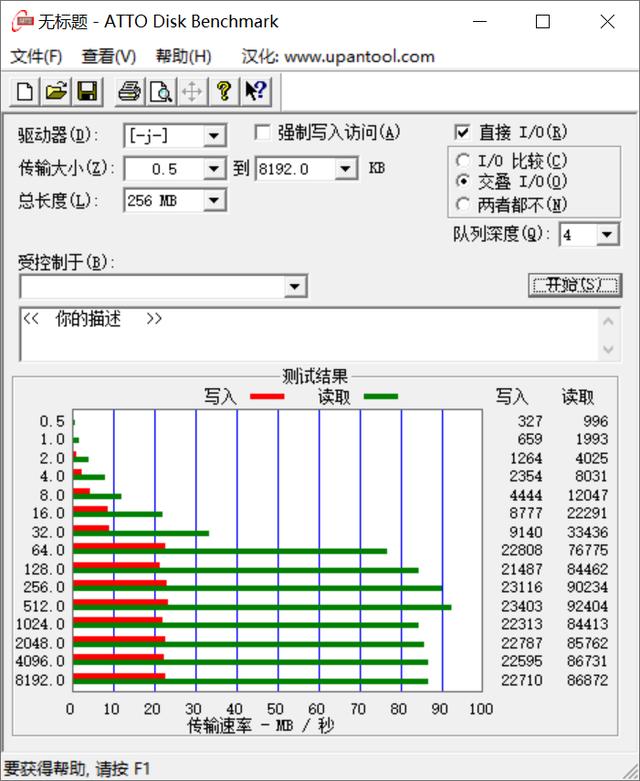

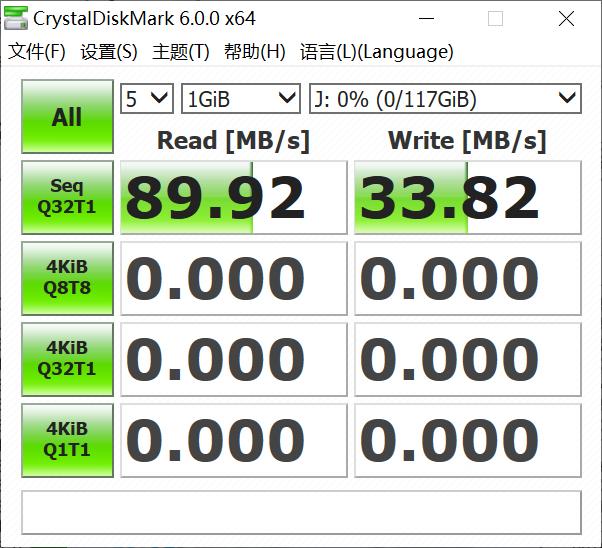

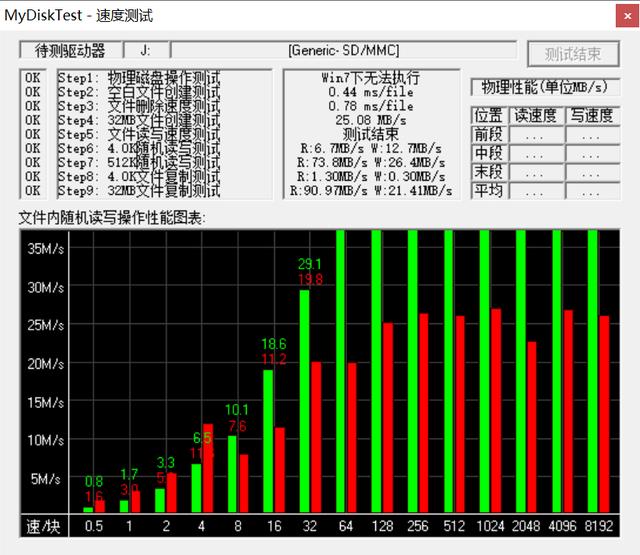

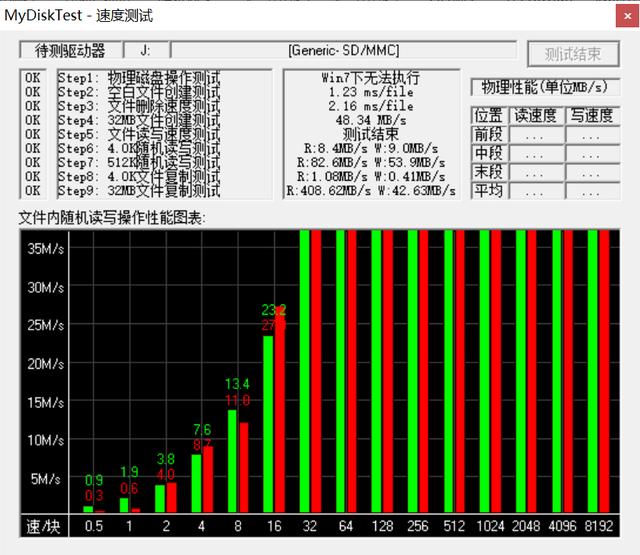

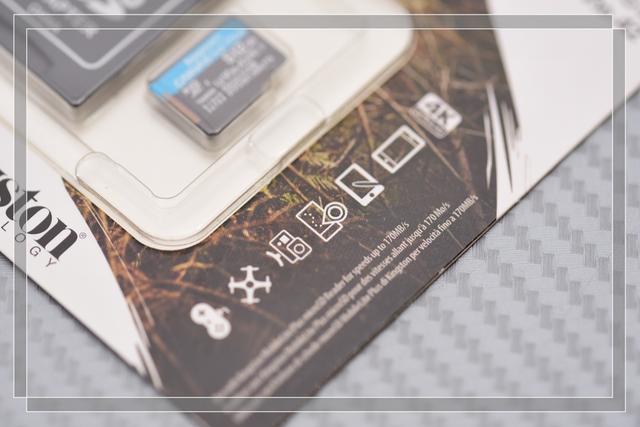

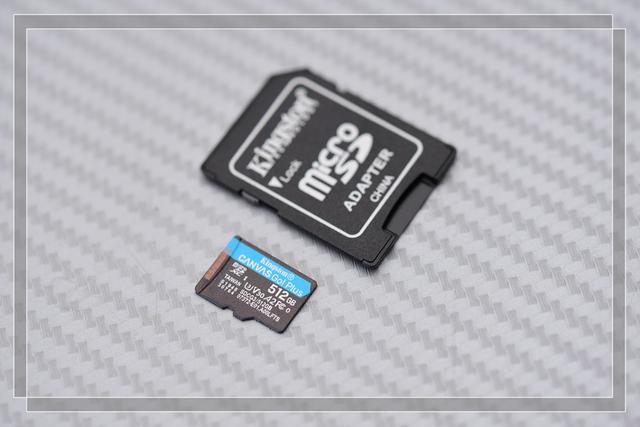

10、金士顿 512G GO TF卡,主打快速读取和写入,2020年的新款,最大读取速度170MB/S。

包装,终生质保。

TF卡本体为黑蓝色系,并赠送了转SD卡托。

进行速度测试:

可以看到,基本上TF卡的性能进化本着换代长档的原则,即经过技术的积累和进步,下一代中端TF卡的性能基本上达到或超载上一代高端TF卡的现状。

三、总结

本着张大妈的分享精神,自己依次测试了手头的这几张TF卡,由于时代不同,技术不同,各张TF卡性能对比是没有意义的。随着时间的流淌,TF卡的容量和性能也将发生着翻天覆地的变化。

3417

3417

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?