@TOC

<hr style=" border:solid; width:100px; height:1px;" color=#000000 size=1">

1.数据结构分析(欧几里德和非欧几里德数据)

- 欧几里德数据 如上图所示,每个节点之间都是排列整齐的,所以很容易的可以定义出距离来,如下图所示:

- 非欧几里德数据 排列不整齐,比较的随意。具体体现在:对于数据中的某个点,难以定义出其邻居节点出来,或者是不同节点的邻居节点的数量是不同的。

https://blog.csdn.net/imsuhxz/article/details/91361977

2.inception V1 V2 V3 V4

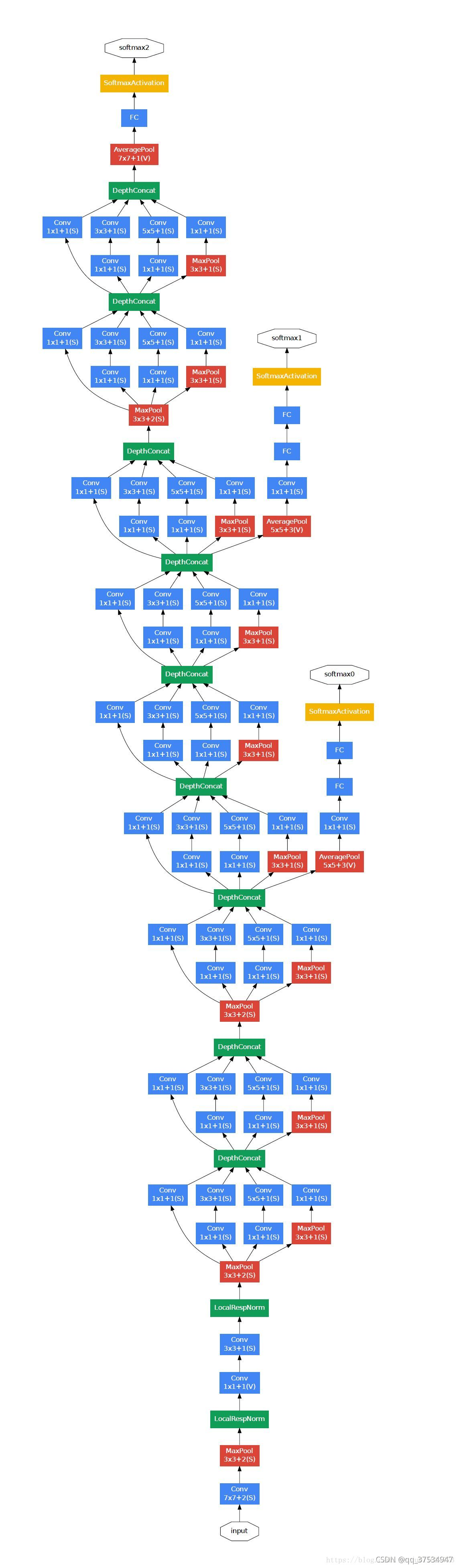

inception V1

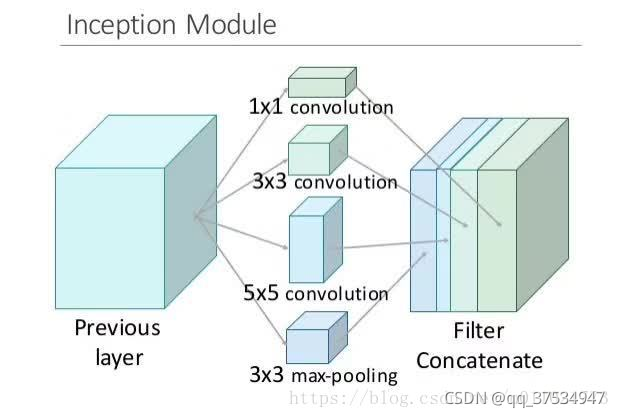

卷积了几步之后就开始出现并行的过程,换成几个 1 * 1, 3 * 3, 5 * 5的卷积并列。然后再把分别卷积的结果作为层数维度上的合并。 比方说这一层本来是一个2828大小的卷积核,一共输出224层,换成inception以后就是64层1 * 1, 128层3 * 3, 32层5 * 5。这样算到最后依然是224层,但是参数个数明显减少了,从2828*224 = 9834496 变成了1 * 1 * 64+3 * 3 * 128+5 * 5 *32 = 2089,减小了几个数量级。

再上一张形象的图:

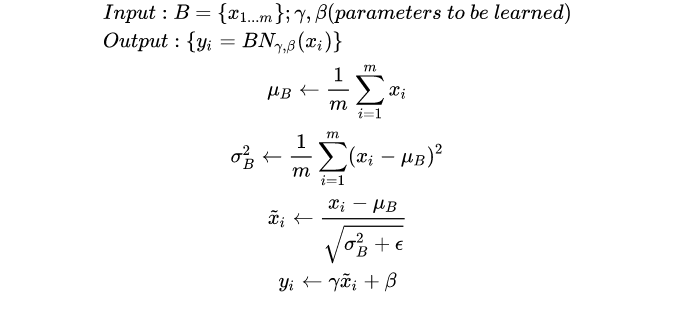

Inception V2

inception V2 其实在网络上没有什么改动,只是在输入的时候增加了batch_normal,所以他的论文名字也是叫batch_normal,加了这个以后训练起来收敛更快,学习起来自然更高效,可以减少dropout的使用。

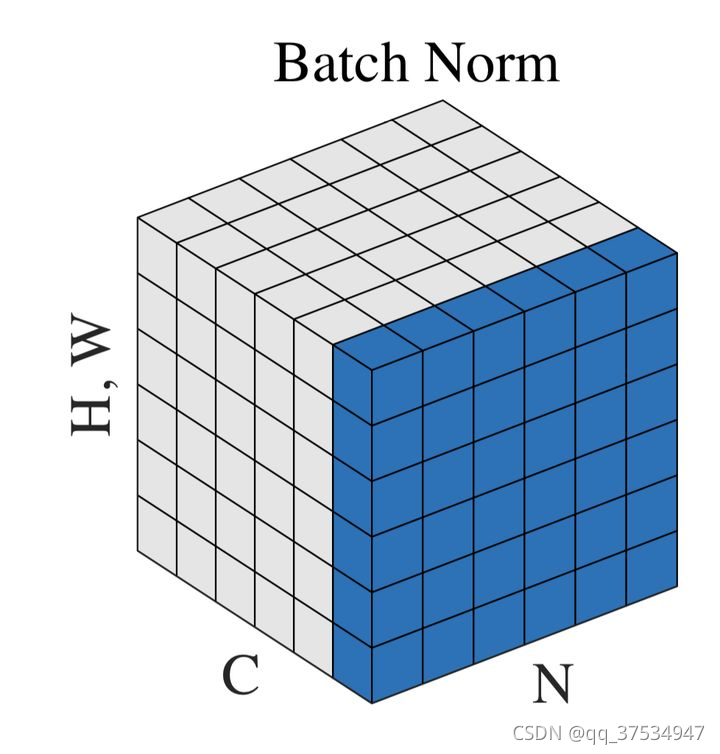

BN 理解

神经网络中传递的张量数据,其维度通常记为[N, H, W, C],其中N是batch_size,H、W是行、列,C是通道数。那么上式中BN的输入集合 [公式] 就是下图中蓝色的部分。

https://zhuanlan.zhihu.com/p/93643523

Inception V3

Inception V3把googlenet里一些7 * 7的卷积变成了1 * 7和7 * 1的两层串联,3 * 3 的也一样,变成了1 * 3和3 * 1,这样加速了计算,还增加了网络的非线性,减小过拟合的概率。另外,网络的输入从224改成了299.

Inception V4

inception v4实际上是把原来的inception加上了resnet的方法,从一个节点能够跳过一些节点直接连入之后的一些节点,并且残差也跟着过去一个。另外就是V4把一个先1 * 1再3 * 3那步换成了先3 * 3再1 * 1.论文说引入resnet不是用来提高深度,进而提高准确度的,只是用来提高速度的 https://blog.csdn.net/u011021773/article/details/80791650

3.GNN简单理解

- 聚合

- 更新

- 传递

https://www.bilibili.com/video/BV1Tf4y1i7Go/?spm_id_from=333.788.recommend_more_video.-1

4.GCN简单理解

对于上面聚合没有考虑到自己的信息以及对于GNN中聚合里的B、C、D点的权重如何确定?

- 聚合(包含自己)

- 平均法(由特例,如:收入不均衡)

- 解决(公式中D是度的意思,来限制权重) https://www.bilibili.com/video/BV1Xy4y1i7sq?spm_id_from=333.999.0.0

5067

5067

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?