# 扩散模型与图像编辑

针对图像编辑中的扩散模型,中科院联合Adobe和苹果公司的研究人员发布了一篇重磅综述。

全文长达26页,共1.5万余词,涵盖297篇文献,全面研究了图像编辑的各种前沿方法。

同时,作者还提出了全新的benchmark,为研究者提供了便捷的学习参考工具。

在这份综述中,作者从理论和实践层面,详尽总结了使用扩散模型进行图像编辑的现有方法。

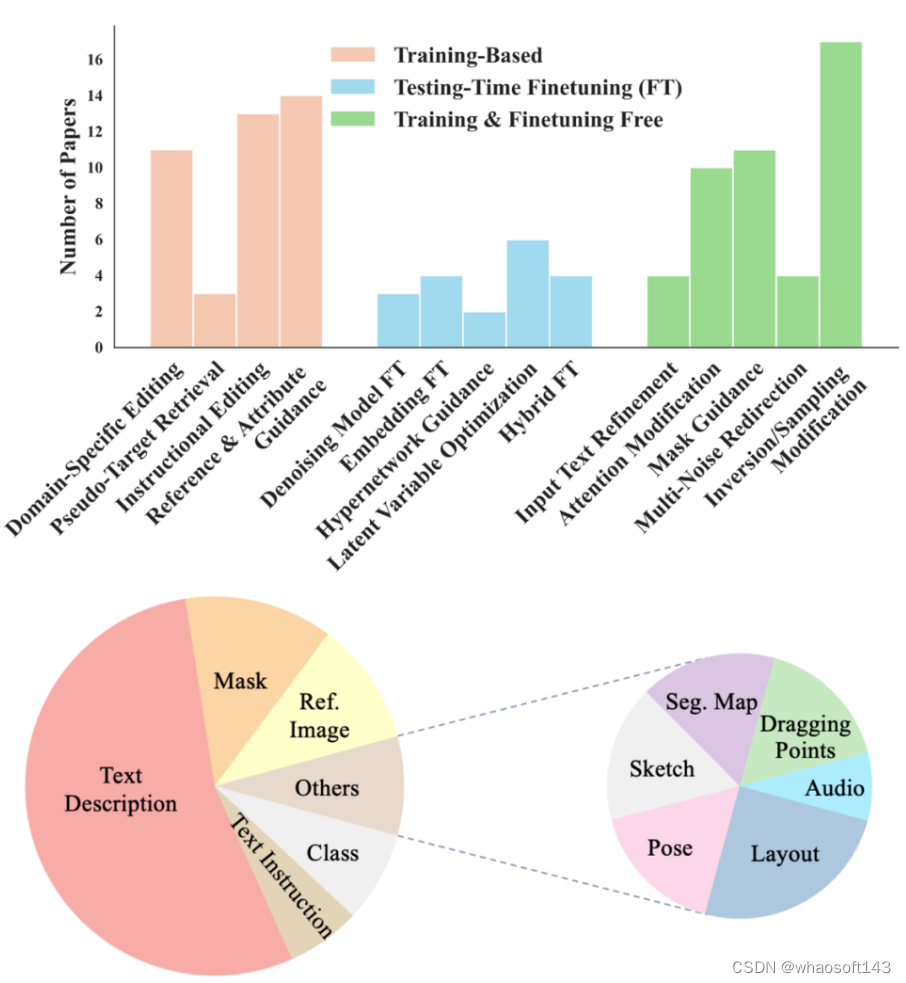

作者从学习策略、输入条件等多个角度对相关成果进行分类,并展开了深入分析。

为了进一步评估模型性能,作者还提出了一个测评基准,并展望了未来研究的一些潜在方向。

下面,作者将从任务分类、实现方式、测试基准和未来展望四个方面介绍基于扩散模型的图像编辑成果。

图像编辑的分类

除了在图像生成、恢复和增强方面取得的重大进步外,扩散模型在图像编辑方面也实现了显著突破,相比之前占主导地位的生成对抗网络(GANs),前者具有更强的可控性。

不同于“从零开始”的图像生成,以及旨在修复模糊图像、提高质量的图像恢复和增强,图像编辑涉及对现有图像外观、结构或内容的修改,包括添加对象、替换背景和改变纹理等任务。

在这项调查中,作者根据学习策略将图像编辑论文分为三个主要组别:基于训练的方法、测试时微调方法和无需训练和微调的方法。

此外,作者还探讨了控制编辑过程使用的10种输入条件,包括文本、掩码、参考图像、类别、布局、姿势、草图、分割图、音频和拖动点。

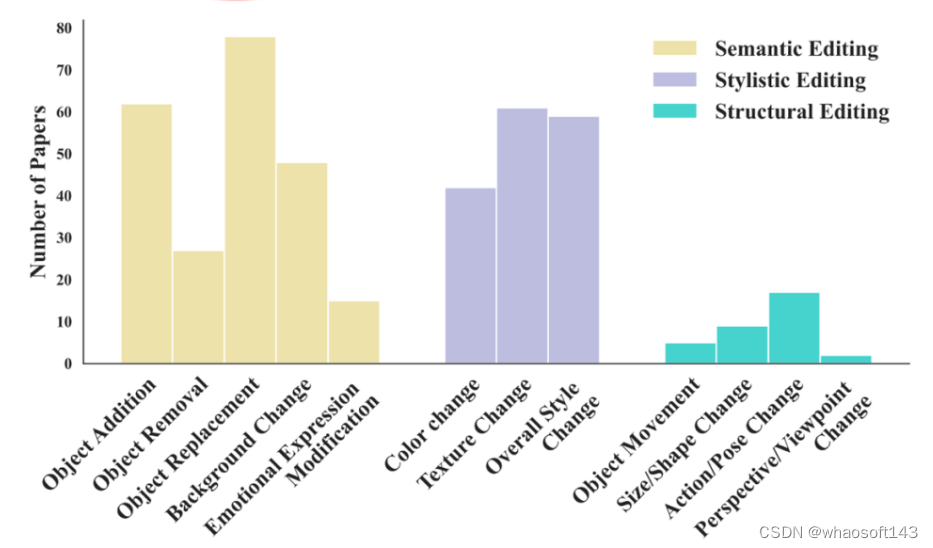

进一步地,作者调查了这些方法可以完成的12种最常见的编辑类型,它们被组织成以下三个广泛的类别:

- 语义编辑:此类别包括对图像内容和叙述的更改,影响所描绘场景的故事、背景或主题元素。这一类别内的任务包括对象添加、对象移除、对象替换、背景更改和情感表达修改。

- 风格编辑:此类别侧重于增强或转换图像的视觉风格和审美元素,而不改变其叙述内容。这一类别内的任务包括颜色更改、纹理更改和整体风格更改,涵盖艺术性和现实性风格。

- 结构编辑:此类别涉及图像内元素的空间布局、定位、视角和特征的变化,强调场景内对象的组织和展示。这一类别内的任务包括对象移动、对象大小和形状更改、对象动作和姿势更改以及视角/视点更改。

图像编辑的实现方式

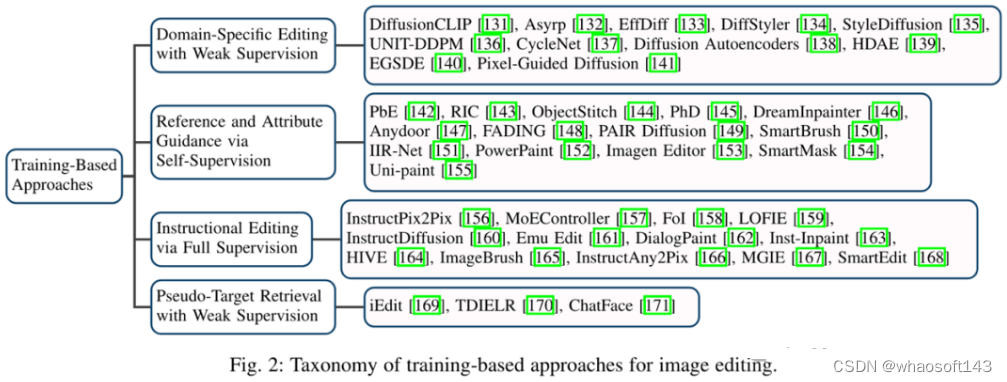

基于训练的方法

在基于扩散模型的图像编辑领域,基于训练的方法已经获得了显著的突出地位。

这些方法不仅因其稳定的扩散模型训练和有效的数据分布建模而著名,而且在各种编辑任务中表现可靠。

为了彻底分析这些方法,作者根据它们的应用范围、训练所需条件和监督类型将它们分类为四个主要组别。

根据核心编辑方法,这些主要组别中的方法又可以细分为不同的类型。

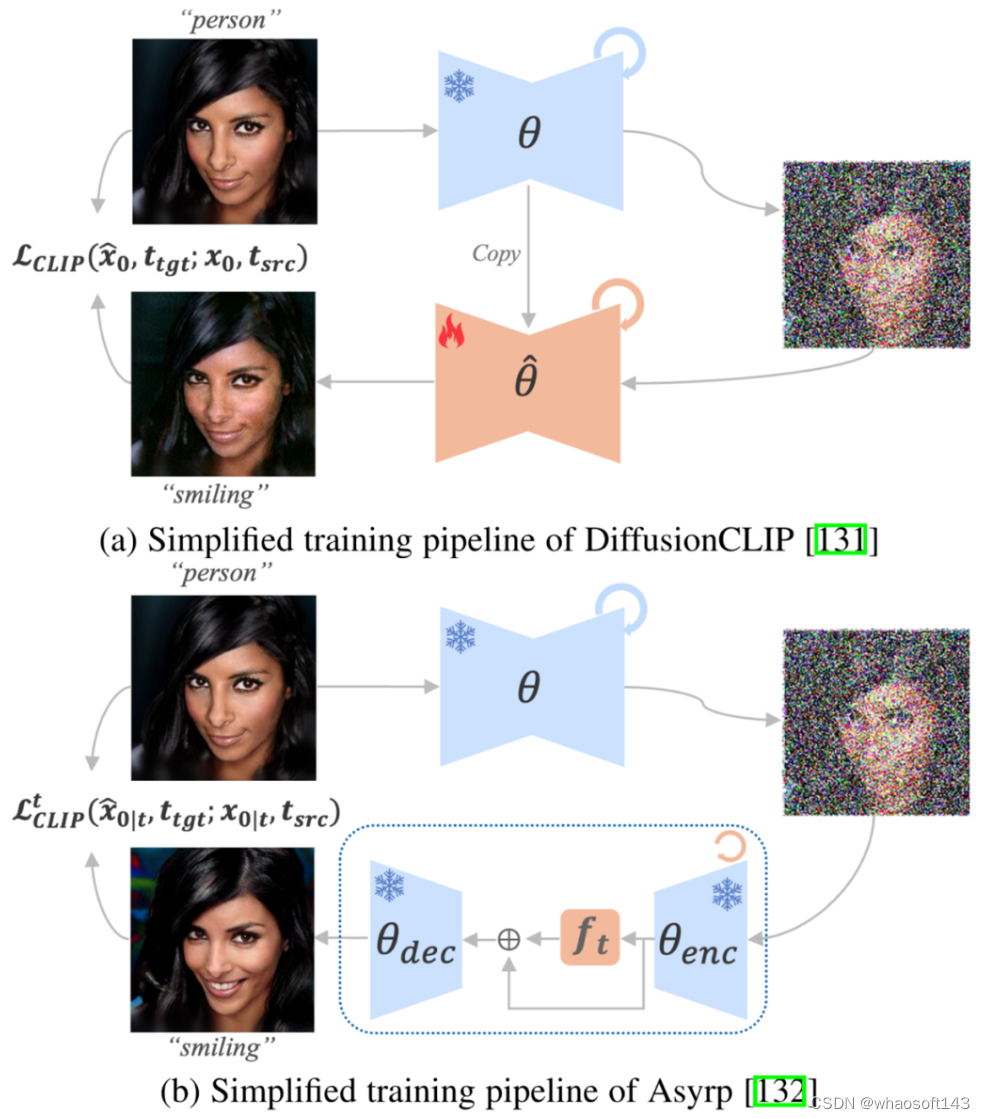

下图展示了两种有代表性的CLIP指导方法——DiffusionCLIP和Asyrp的框架图。

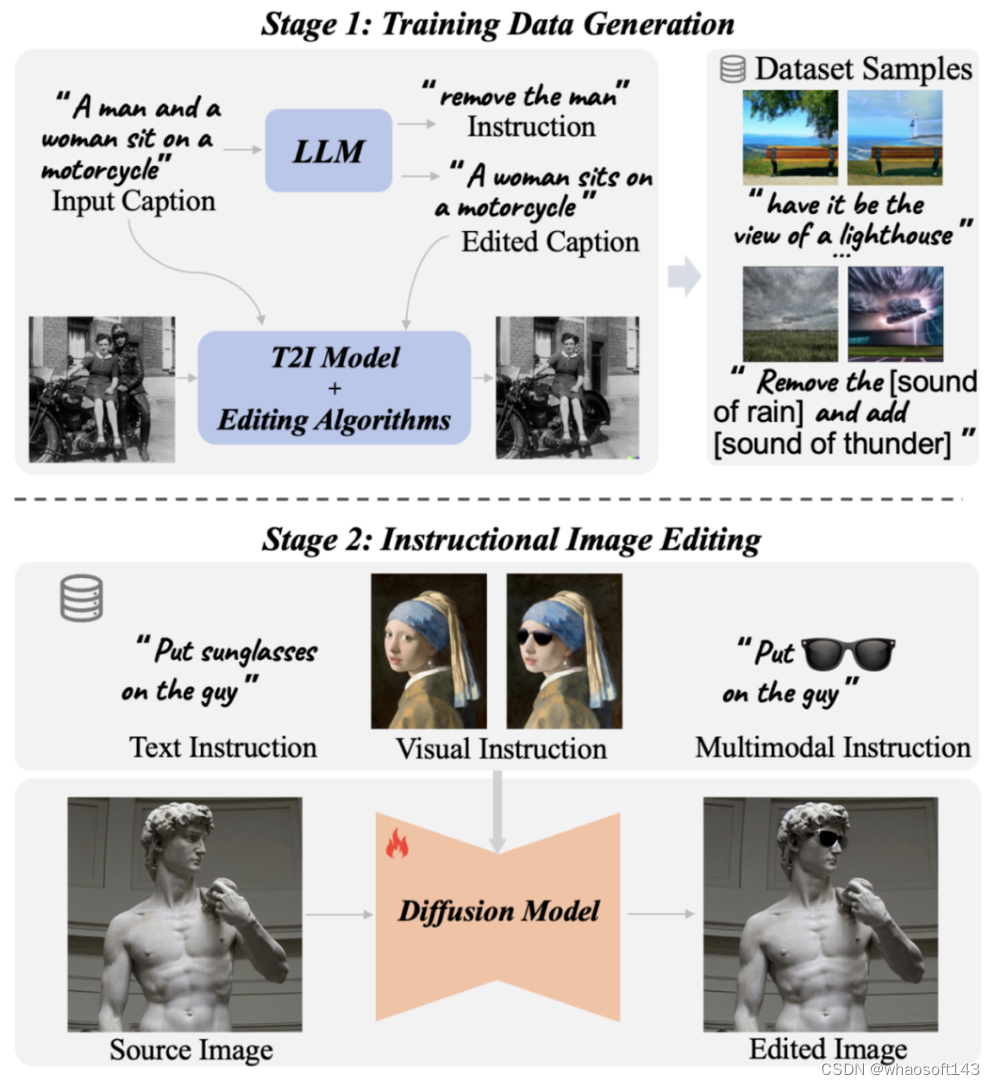

下面的图片,展示的是指令图像编辑方法的通用框架。

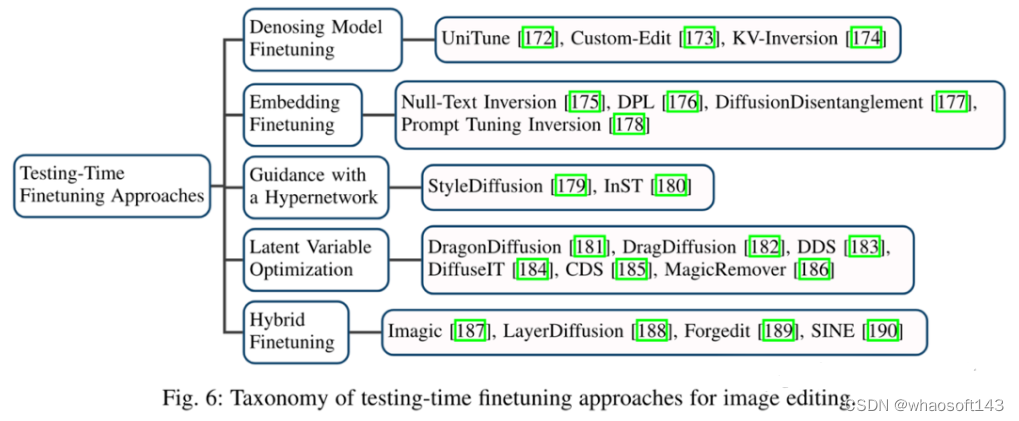

测试时微调的方法

在图像生成和编辑中,还会采用微调策略来增强图像编辑能力,测试时微调带来了精确性和可控制性的重要提升。

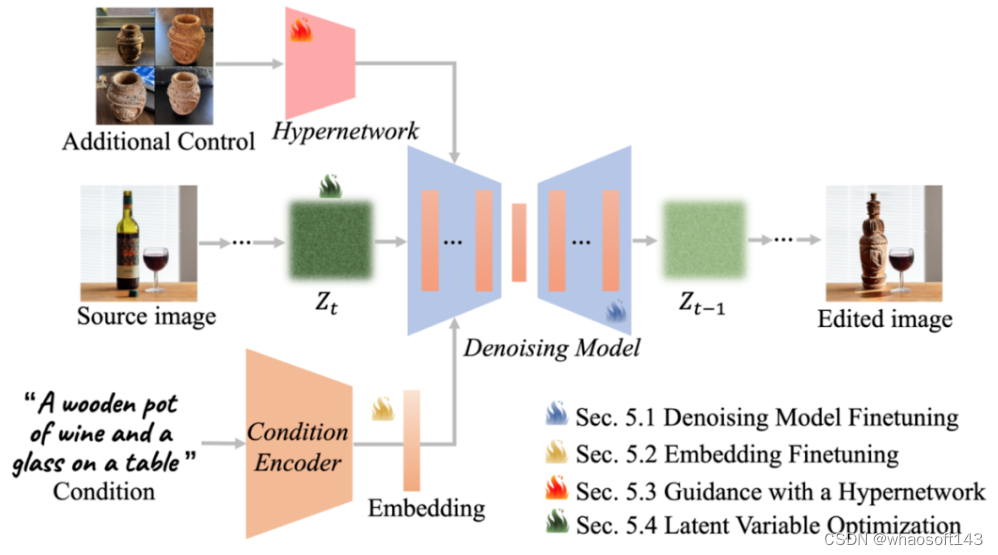

如下图所示,微调方法的既包括微调整个去噪模型,也包括专注于特定层或嵌入。

此外,作者还讨论了超网络的集成和直接图像表示优化

下图展示了使用不同微调组件的微调框架。

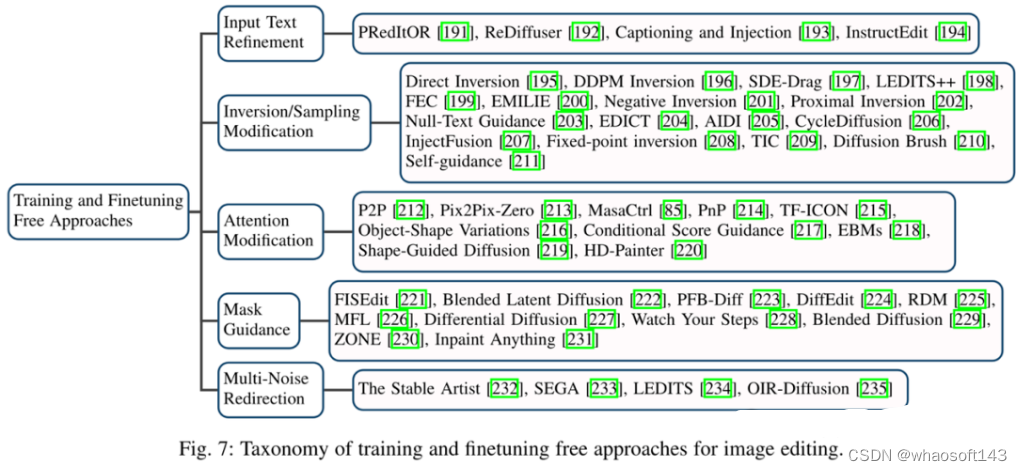

免训练和微调方法

在图像编辑领域,无需训练和微调的方法起点是它们快速且成本低,因为在整个编辑过程中不需要任何形式的训练(在数据集上)或微调(在源图像上)。

根据它们修改的内容,可以分为五个类别,这些方法巧妙地利用扩散模型内在的原则来实现编辑目标。

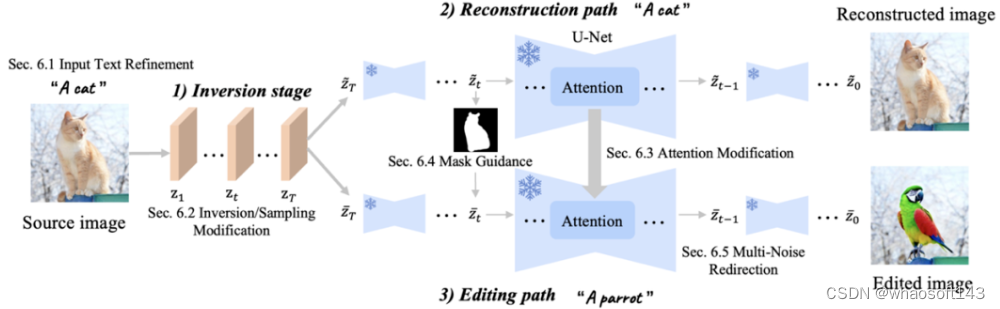

下图是免训练方法的通用框架。

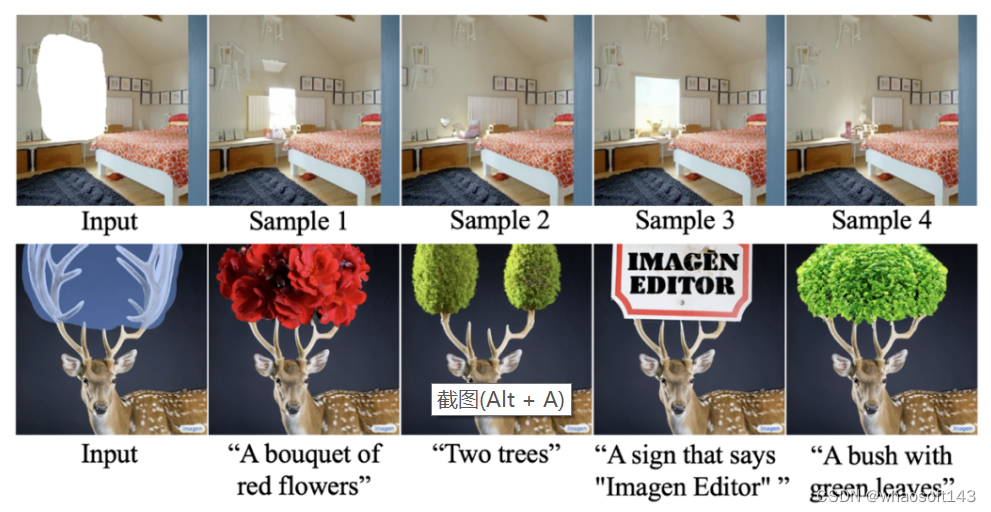

图像inpainting(补全)和outpainting(外扩)

图像补全和外扩通常被视为图像编辑的子任务,可以分为两大类型——上下文驱动的补全(上排)与多模态条件补全(下排)。

全新测试基准

除了分析各种方法的实现原理,评估这些方法在不同编辑任务中的能力也至关重要,但现有的图像编辑测试标准存在局限。

例如,EditBench主要针对文本和掩码引导的补全,但忽略了涉及全局编辑的任务(如风格转换);TedBench虽然扩展了任务范围,但缺乏详细指导;EditVal试图提供更全面的任务和方法覆盖范围,但图像通常分辨率低且模糊……

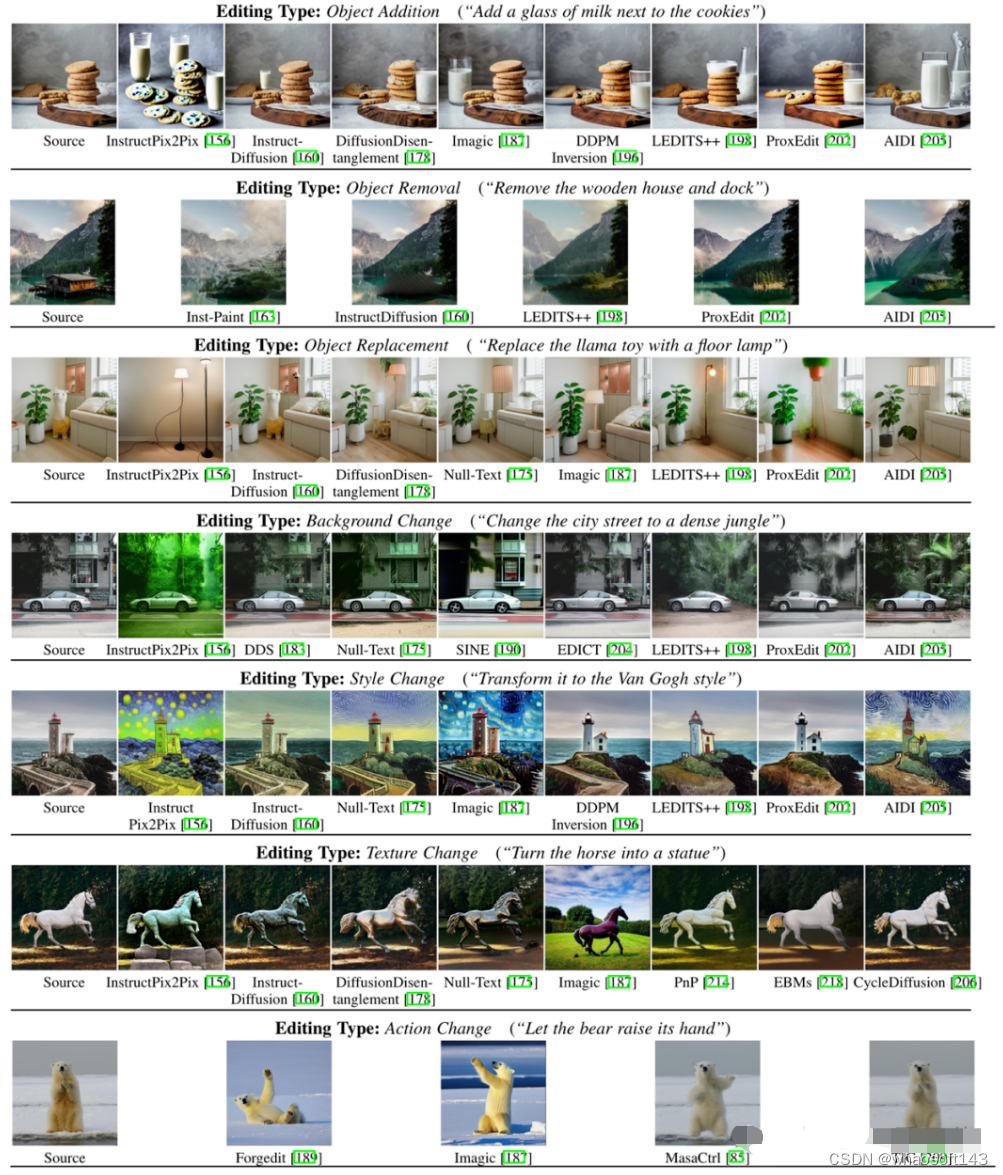

为了解决这些问题,作者提出了EditEval基准,包括一个50张高质量图像的数据集,且每张图像都附有文本提示,可以评估模型在7个常见编辑任务的性能。

这7种任务包括物体添加/移除/替换,以及背景、风格和姿势、动作的改变。

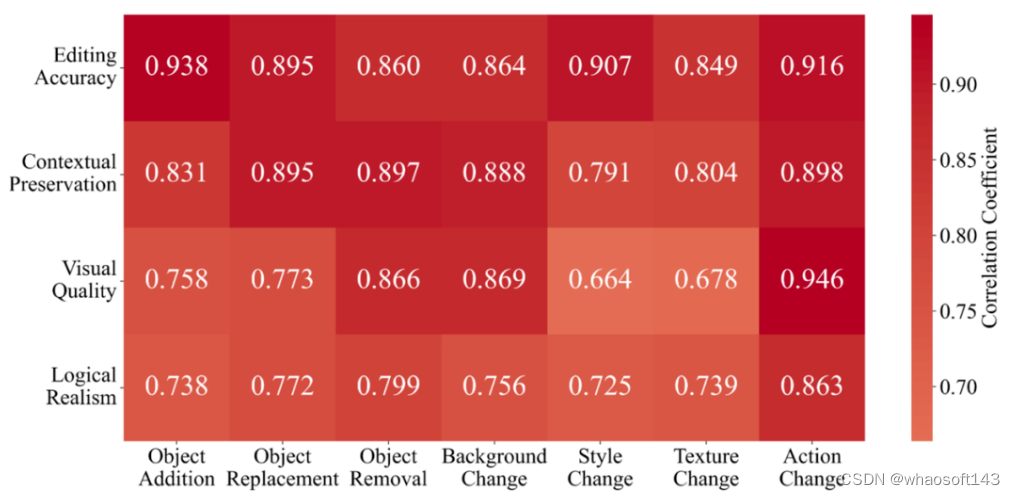

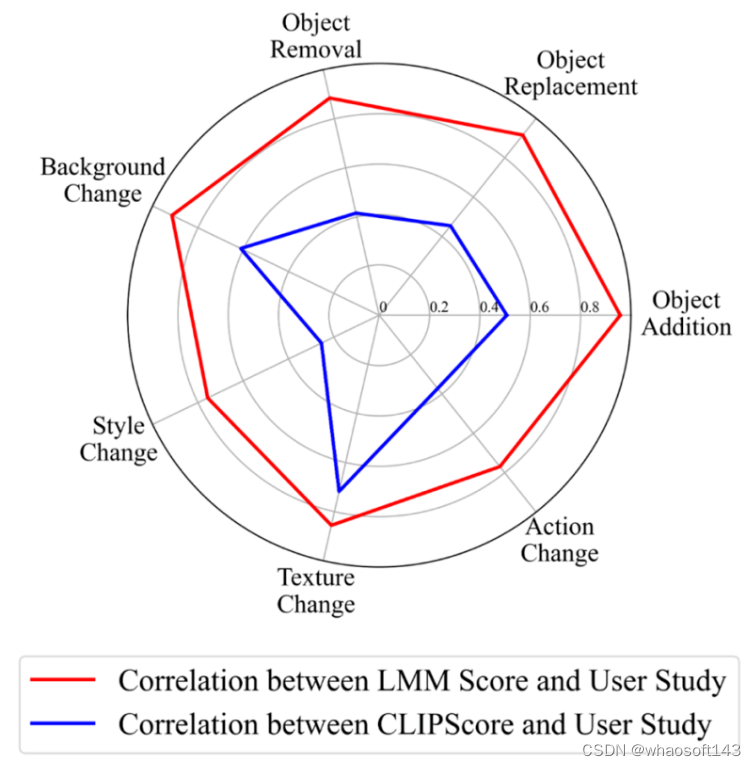

此外,作者还提出了LMM分数,利用多模态大模型(LMMs)评估不同任务上的编辑性能,并进行了真人用户研究以纳入主观评估。

下图比较了LMM Score/CLIPScore与用户研究的皮尔逊相关系数。

挑战和未来方向

作者认为,尽管在使用扩散模型进行图像编辑方面取得了成功,但仍有一些不足需要在未来的工作中加以解决。

减少模型推理步骤

大多数基于扩散的模型在推理过程中需要大量的步骤来获取最终图像,这既耗时又耗费计算资源,给模型部署和用户体验带来挑战。

为了提高推理效率,已经由团队研究了少步骤或一步生成的扩散模型。

近期的方法通过从预训练的强扩散模型中提取知识来减少步骤数,以便少步骤模型能够模仿强模型的行为。

一个更具挑战性的方向是直接开发少步骤模型,而不依赖于预训练的模型(例如一致性模型)。

提高模型效率

训练一个能够生成逼真结果的扩散模型在计算上是密集的,需要大量的高质量数据。

这种复杂性使得开发用于图像编辑的扩散模型非常具有挑战性。

为了降低训练成本,近期的工作设计了更高效的网络架构作为扩散模型的骨干。

此外,另一个重要方向是只训练部分参数,或者冻结原始参数并在预训练的扩散模型之上添加一些新层。

复杂对象结构编辑

现有的工作可以在编辑图像时合成逼真的颜色、风格或纹理,但处理复杂结构时仍然会产生明显的修改痕迹,例如手指、标志和文字。

研究者已经在尝试解决这些问题,常用的策略是把“六个手指”等常见问题作为负面提示,以使模型避免生成此类图像,这在某些情况下是有效的,但不够稳健。

近期的工作中,已有团队开始使用布局、边缘或密集标签作为指导,编辑图像的全局或局部结构。

复杂的光照和阴影编辑

编辑对象的光照或阴影仍然是一个挑战,因为这需要准确估计场景中的光照条件。

以前的工作(如Total Relighting)使用网络组合来估计前景对象的法线、反照率和阴影,以获得逼真的重新照明效果。

最近,也由有团队提出将扩散模型用于编辑面部的光照,ShadowDiffusion也探索了基于扩散模型的阴影合成,可以生成合理的对象阴影。

然而,使用扩散模型在不同背景条件下准确编辑对象的阴影仍然是一个未解决的问题。

图像编辑模型的泛化性

现有基于扩散的图像编辑模型能够为给定的一部分条件合成逼真的视觉内容,但在许多现实世界场景中仍然会失败。

这个问题的根本原因在于,模型无法准确地对所有可能的样本在条件分布空间中进行建模。

如何改进模型以始终生成无瑕疵的内容仍然是一个挑战,解决这个问题有以下几种思路:

首先是扩大训练数据规模,以覆盖具有挑战性的场景,这种方式效果显著,但成本较高,如在医学图像、视觉检测等领域数据难以收集。

第二种方法是调整模型以接受更多条件,如结构引导、3D感知引导和文本引导,以实现更可控和确定性的内容创作。

此外,还可以采用迭代细化或多阶段训练的方式,以逐步改进模型的初始结果。

可靠的评估指标

对图像编辑进行准确评估,对于确保编辑内容与给定条件的对齐至关重要。

尽管有如FID、KID、LPIPS、CLIP得分、PSNR和SSIM等定量指标,但大多数现有评估工作仍然严重依赖于用户研究,这既不高效也不可扩展。

可靠的定量评估指标仍然是一个待解决的问题。最近,已经有团队提出了更准确的指标来量化对象的感知相似性。

DreamSim测量了两幅图像的中等级别相似性,考虑了布局、姿态和语义内容,并且优于LPIPS。

类似的,前景特征平均(FFA)也是一种简单而有效的方法,可被用于测量对象的相似性。

另外,作者在本文中提出了的LMM score,也是一种有效的图像编辑度量。

更多有关用于图像编辑的扩散模型的详细信息,可以阅读原作,同时作者也在GitHub上发布了附带资源库。

论文链接:

https://arxiv.org/abs/2402.17525

Github:

https://github.com/SiatMMLab/Awesome-Diffusion-Model-Based-Image-Editing-Methods

# 谷歌&北大最新研究

本综述来自加州大学&Google Research的Ming-Hsuan Yang、北京大学崔斌实验室以及CMU、UCLA、蒙特利尔Mila研究院等众研究团队,首次对现有的扩散生成模型(diffusion model)进行了全面的总结分析,从diffusion model算法细化分类、和其他五大生成模型的关联以及在七大领域中的应用等方面展开,最后提出了diffusion model的现有limitation和未来的发展方向。

文章链接:https://arxiv.org/abs/2209.00796

本综述diffusion models论文分类汇总github链接:

https://github.com/YangLing0818/Diffusion-Models-Papers-Survey-Taxonomy

介绍

扩散模型(diffusion models)是深度生成模型中新的SOTA。扩散模型在图片生成任务中超越了原SOTA:GAN,并且在诸多应用领域都有出色的表现,如计算机视觉,NLP、波形信号处理、多模态建模、分子图建模、时间序列建模、对抗性净化等。此外,扩散模型与其他研究领域有着密切的联系,如稳健学习、表示学习、强化学习。然而,原始的扩散模型也有缺点,它的采样速度慢,通常需要数千个评估步骤才能抽取一个样本;它的最大似然估计无法和基于似然的模型相比;它泛化到各种数据类型的能力较差。如今很多研究已经从实际应用的角度解决上述限制做出了许多努力,或从理论角度对模型能力进行了分析。

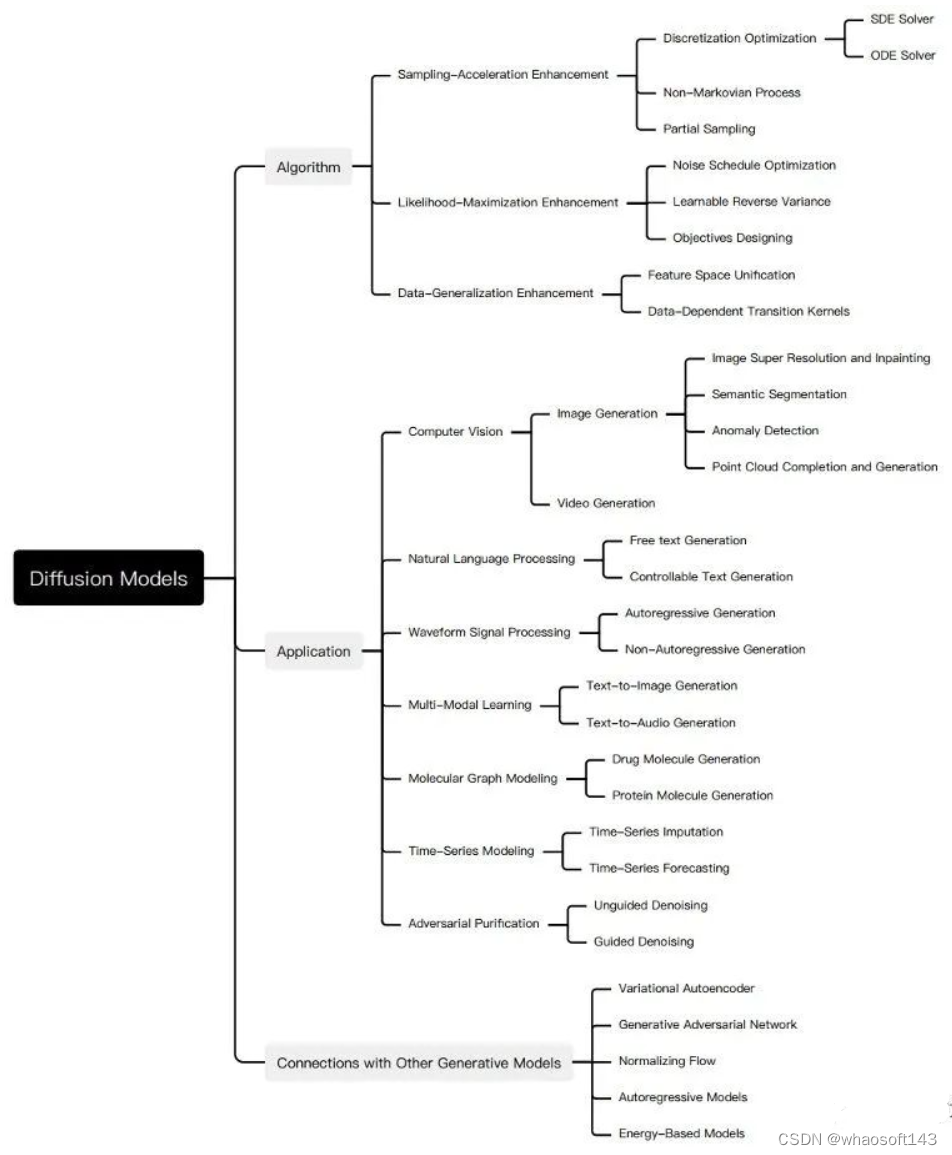

然而,现在缺乏对扩散模型从算法到应用的最新进展的系统回顾。为了反映这一快速发展领域的进展,我们对扩散模型进行了首个全面综述。我们设想我们的工作将阐明扩散模型的设计考虑和先进方法,展示其在不同领域的应用,并指出未来的研究方向。此综述的概要如下图所示:

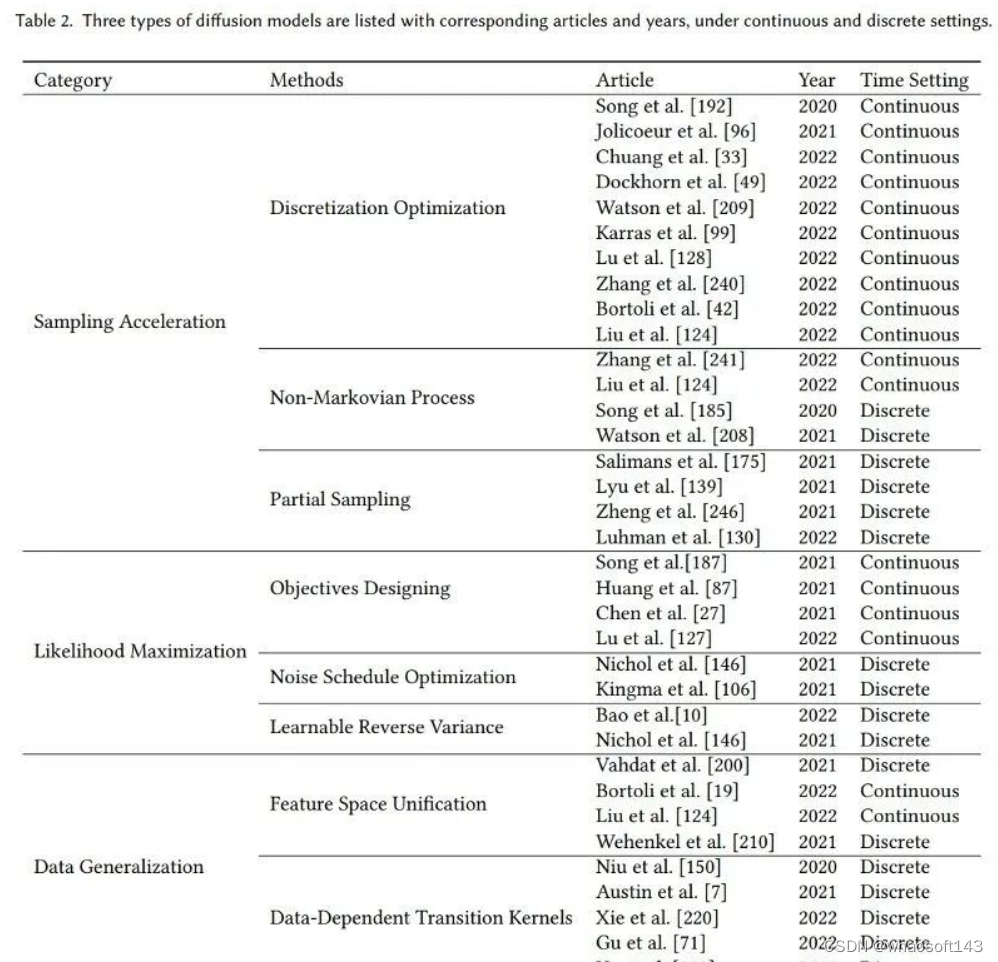

尽管diffusion model在各类任务中都有着优秀的表现,它仍还有自己的缺点,并有诸多研究对diffusion model进行了改善。为了系统地阐明diffusion model的研究进展,我们总结了原始扩散模型的三个主要缺点,采样速度慢,最大化似然差、数据泛化能力弱,并提出将的diffusion models改进研究分为对应的三类:采样速度提升、最大似然增强和数据泛化增强。我们首先说明改善的动机,再根据方法的特性将每个改进方向的研究进一步细化分类,从而清楚的展现方法之间的联系与区别。在此我们仅选取部分重要方法为例, 我们的工作中对每类方法都做了详细的介绍,内容如图所示:

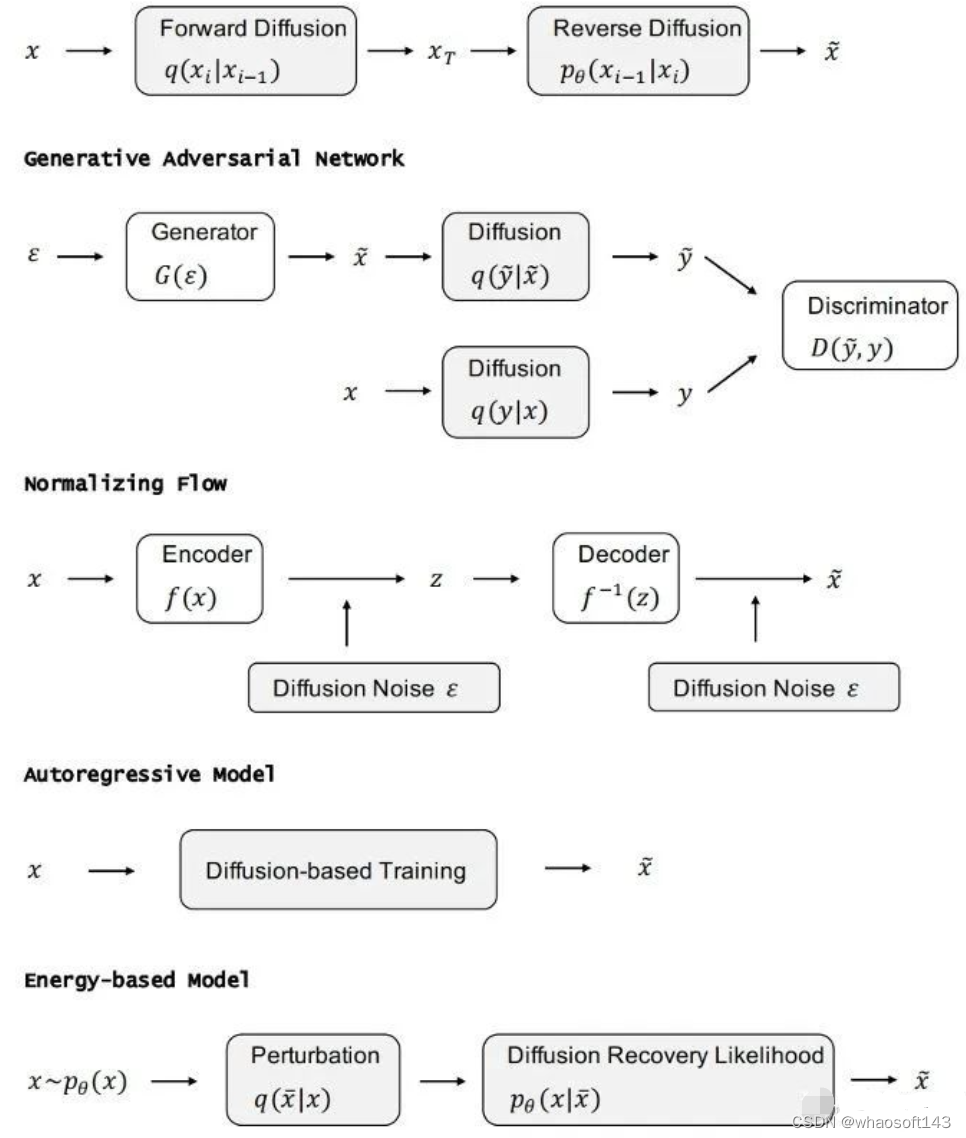

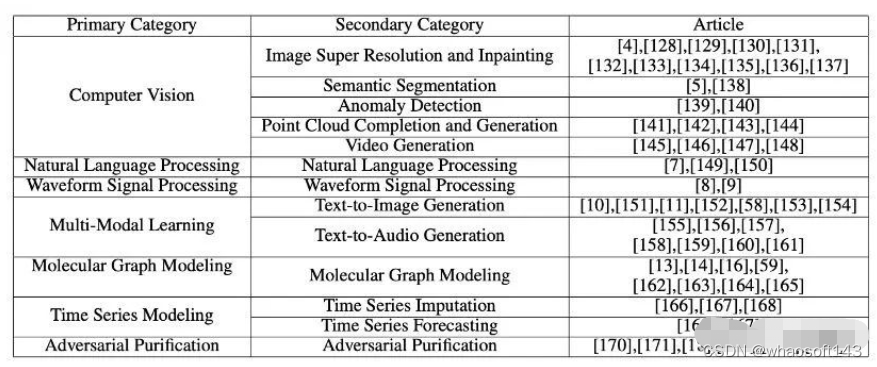

在分析完三类扩散模型后,我们将介绍其他的五种生成模型GAN,VAE,Autoregressive model, Normalizing flow, Energy-based model。考虑到扩散模型的优良性质,研究者们已经根据其特性将diffusion model与其他生成模型结合,所以为了进一步展现diffusion model 的特点和改进工作,我们详细地介绍了diffusion model和其他生成模型的结合的工作并阐明了在原始生成模型上的改进之处。Diffusion model在诸多领域都有着优异的表现,并且考虑到不同领域的应用中diffusion model产生了不同的变形,我们系统地介绍了diffusion model的应用研究,其中包含如下领域:计算机视觉,NLP、波形信号处理、多模态建模、分子图建模、时间序列建模、对抗性净化。对于每个任务,我们定义了该任务并介绍利用扩散模型处理任务的工作,我们将本项工作的主要贡献总结如下:

- 新的分类方法:我们对扩散模型和其应用提出了一种新的、系统的分类法。具体的我们将模型分为三类:采样速度提升、最大似然提升、数据泛化提升。进一步地,我们将扩散模型的应用分为七类:计算机视觉,NLP、波形信号处理、多模态建模、分子图建模、时间序列建模、对抗性净化。

- 全面的回顾:我们首次全面地概述了现代扩散模型及其应用。我们展示了每种扩散模型的主要改进,和原始模型进行了必要的比较,并总结了相应的论文。对于扩散模型的每种类型的应用,我们展示了扩散模型要解决的主要问题,并说明它们如何解决这些问题

- 未来研究方向:我们对未来研究提出了开放型问题,并对扩散模型在算法和应用方面的未来发展提供了一些建议。

扩散模型基础

生成式建模的一个核心问题是模型的灵活性和可计算性之间的权衡。扩散模型的基本思想是正向扩散过程来系统地扰动数据中的分布,然后通过学习反向扩散过程恢复数据的分布,这样就了产生一个高度灵活且易于计算的生成模型。

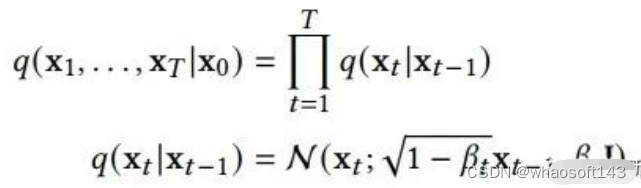

A. Denoising Diffusion Probabilistic Models(DDPM)

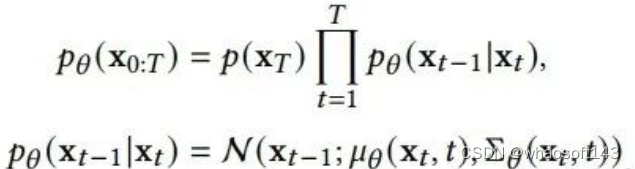

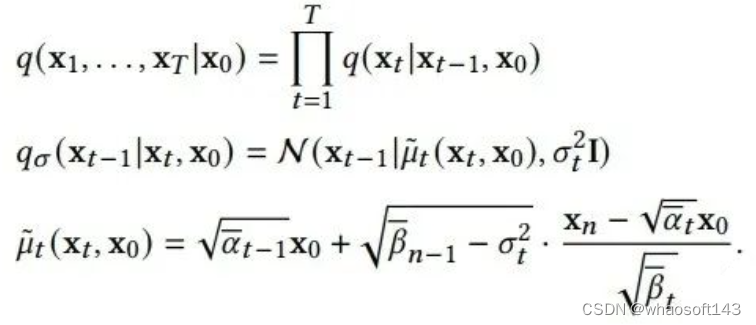

一个DDPM由两个参数化马尔可夫链组成,并使用变分推断以在有限时间后生成与原始数据分布一致的样本。前向链的作用是扰动数据,它根据预先设计的噪声进度向数据逐渐加入高斯噪声,直到数据的分布趋于先验分布,即标准高斯分布。反向链从给定的先验开始并使用参数化的高斯转换核,学习逐步恢复原数据分布。用 x0 ~ q(x0) 表示原始数据及其分布,则前向链的分布是可由下式表达:

这说明前向链是马尔可夫过程, xt 是加入t步噪音后的样本, βt 是事先给定的控制噪声进度的参数。当 ∏t1−βt 趋于1时, xT 可以近似认为服从标准高斯分布。当 βt 很小时,逆向过程的转移核可以近似认为也是高斯的:

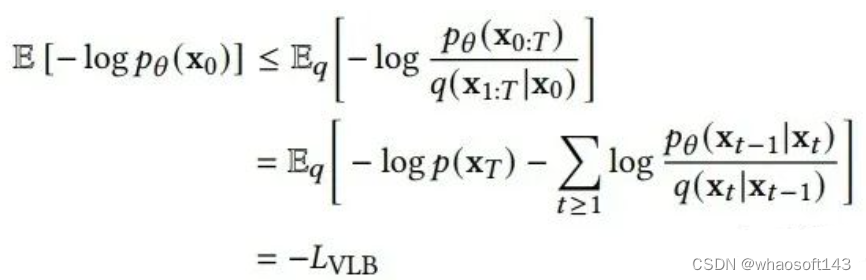

我们可以将变分下界作为损失函数进行学习:

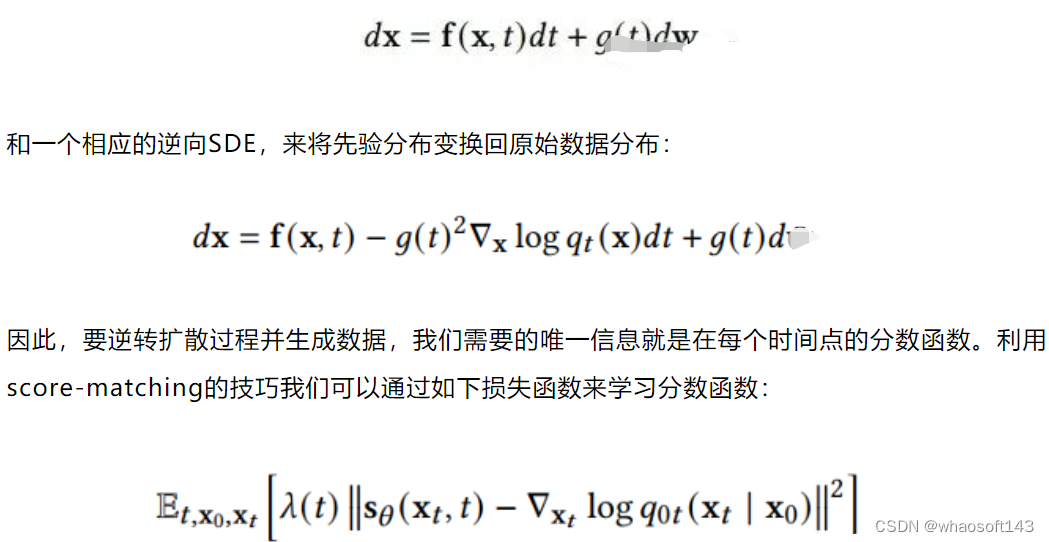

B. Score-Based Generative Models(SGM)

上述DDPM可以视作SGM的离散形式。SGM构造一个随机微分方程(SDE)来平滑的扰乱数据分布,将原始数据分布转化到已知的先验分布:

对两种方法的进一步介绍和两者关系的介绍请参见我们的文章。

原始扩散模型的三个主要缺点,采样速度慢,最大化似然差、数据泛化能力弱。最近许多研究都在解决这些缺点,因此我们将改进的扩散模型分为三类:采样速度提升、最大似然增强和数据泛化增强。在接下来的三、四、五节我们将对这三类模型进行详细的介绍。

采样加速方法

在应用时,为了让新样本的质量达到最佳,扩散模型往往需要进行成千上万步计算来获取一个新样本。这限制了diffusion model的实际应用价值,因为在实际应用时,我们往往需要产生大量的新样本,来为下一步处理提供材料。研究者们在提高diffusion model采样速度上进行了大量的研究。我们对这些研究进行了详细的阐述。我们将其细化分类为三种方法:Discretization Optimization,Non-Markovian Process,Partial Sampling。

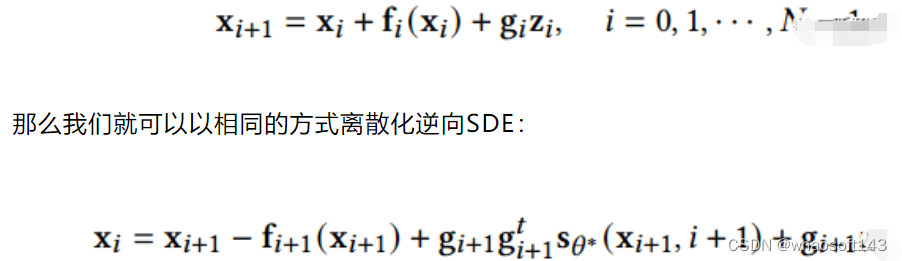

A. Discretization Optimization方法优化求解diffusion SDE的方法。因为现实中求解复杂SDE只能使用离散解来逼近真正的解,所以该类方法试图优化SDE的离散化方法,在保证样本质量的同时减少离散步数。SGM 提出了一个通用的方法来求解逆向过程,即对前向和后向过程采取相同的离散方法。如果给定了前向SDE的离散方式:

这种方法比朴素DDPM效果略好一点。进一步,SGM向SDE求解器中加入了一个矫正器,从而让每一步生成的样本都有正确的分布。在求解的每一步,求解器给出一个样本后,矫正器都使用马尔可夫链蒙特卡罗方法来矫正刚生成的样本的分布。实验表明向求解器中加入矫正器比直接增加求解器的步数效率更高。

B. Non-Markovian Process方法突破了原有Markovian Process的限制,其逆过程的每一步可以依赖更多以往的样本来进行预测新样本,所以在步长较大时也能做出较好的预测,从而加速采样过程。其中主要的工作DDIM,不再假设前向过程是马尔可夫过程,而是服从如下分布:

DDIM的采样过程可以视为离散化的神经常微分方程,其采样过程更高效,并且支持样本的内插。进一步的研究发现DDIM可以视作流形上扩散模型PNDM的特例。

C. Partial Sampling方法通过在generation process中忽略一部分的时间节点,而只使用剩下的时间节点来生成样本,直接减少了采样时间。例如,Progressive Distillation从训练好的扩散模型中蒸馏出效率更高的扩散模型。对于训练好的一个扩散模型,Progressive Distillation会从新训练一个扩散模型,使新的扩散模型的一步对应于训练好的扩散模型的两步,这样新模型就可以省去老模型一半的采样过程。具体算法如下:

不断循环这个蒸馏过程就能让采样步骤指数级下降。

最大似然估计加强

扩散模型在最大似然估计的表现差于基于似然函数的生成模型,但最大化似然估计在诸多应用场景都有重要意义,比如图片压缩, 半监督学习, 对抗性净化。由于对数似然难以直接计算,研究主要集中在优化和分析变分下界(VLB)。我们对提高扩散模型最大似然估计的模型进行了详细的阐述。我们将其细化分类为三类方法:Objectives Designing,Noise Schedule Optimization,Learnable Reverse Variance。

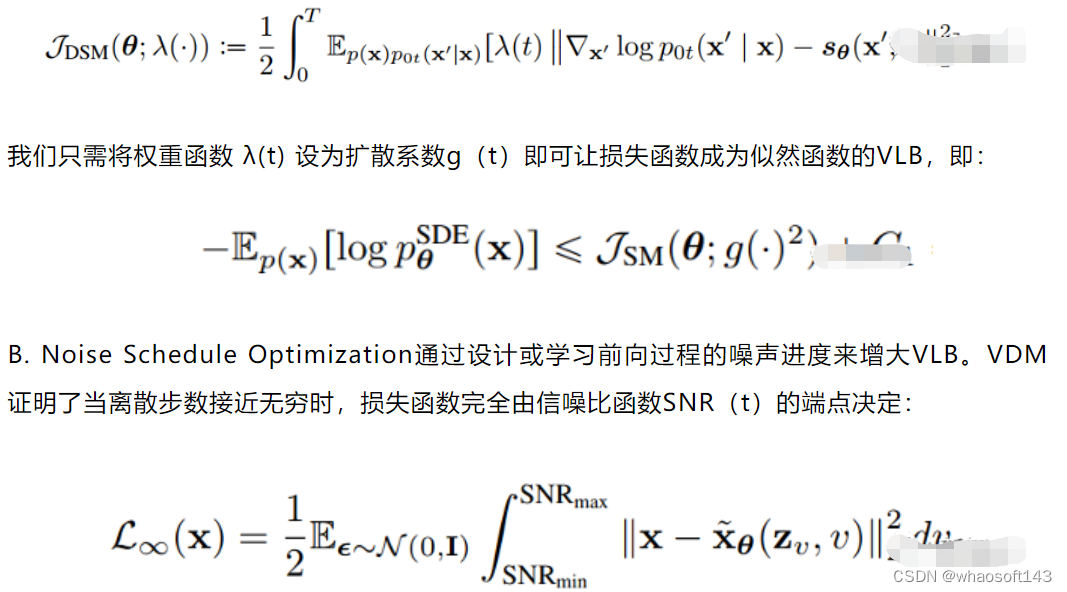

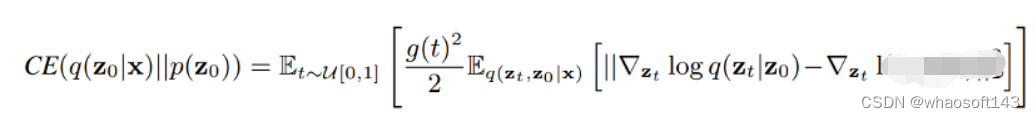

A. Objectives Designing方法利用扩散 SDE推倒出生成数据的对数似然与分数函数匹配的损失函数的关系。这样通过适当设计损失函数,就可以最大化 VLB 和对数似然。Song et al. 证明了可以设计损失函数的权重函数,使得plug-in reverse SDE 生成样本的似然函数值小于等于损失函数值,即损失函数是似然函数的上界。分数函数拟合的损失函数如下:

那么在离散步数接近无穷时,可以通过学习信噪比函数SNR(t)的端点最优化VLB,而通过学习信噪比函数中间部分的函数值来实现模型其他方面的改进。

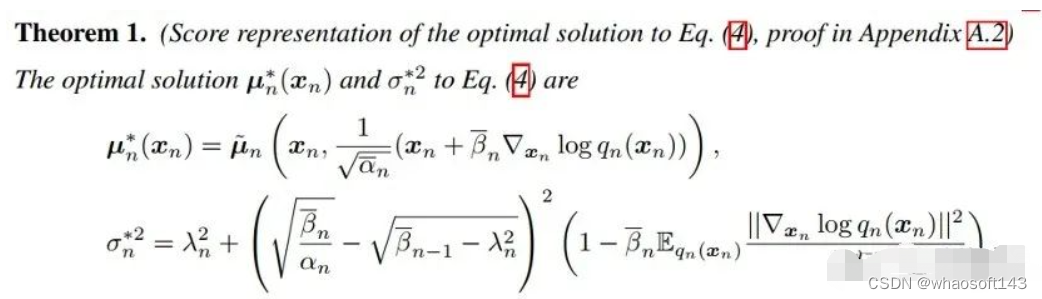

C. Learnable Reverse Variance方法学习反向过程的方差,从而较少拟合误差,可以有效地最大化VLB。Analytic-DPM证明,在DDPM和DDIM中存在反向过程中的最优期望和方差:

使用上述公式和训练好的分数函数,在给定前向过程的条件下,最优的VLB可以近似达到。

数据泛化增强

扩散模型假设数据存在于欧几里得空间,即具有平面几何形状的流形,并添加高斯噪声将不可避免地将数据转换为连续状态空间,所以扩散模型最初只能处理图片等连续性数据,直接应用离散数据或其他数据类型的效果较差。这限制了扩散模型的应用场景。数个研究工作将扩散模型推广到适用于其他数据类型的模型,我们对这些方法进行了详细地阐释。我们将其细化分类为两类方法:Feature Space Unification,Data-Dependent Transition Kernels。

A. Feature Space Unification方法将数据转化到统一形式的latent space,然后再latent space上进行扩散。LSGM提出将数据通过VAE框架先转换到连续的latent space 上后再在其上进行扩散。这个方法的难点在于如何同时训练VAE和扩散模型。LSGM表明由于潜在先验是intractable的,分数匹配损失不再适用。LSGM直接使用VAE中传统的损失函数ELBO作为损失函数,并导出了ELBO和分数匹配的关系:

该式在忽略常数的意义下成立。通过参数化扩散过程中样本的分数函数,LSGM可以高效的学习和优化ELBO。

B. Data-Dependent Transition Kernels方法根据数据类型的特点设计diffusion process 中的transition kernels,使扩散模型可以直接应用于特定的数据类型。D3PM为离散型数据设计了transition kernel,可以设为lazy random-walk,absorbing state等。GEODIFF为3D分子图数据设计了平移-旋转不变的图神经网络,并且证明了具有不变性的初分布和transition kernel可以导出具有不变性的边缘分布。假设T是一个平移-旋转变换,如:

和其他生成模型的联系

在下面的每个小节中,我们首先介绍其他五类重要的生成模型,并分析它们的优势和

局限性。然后我们介绍了扩散模型是如何与它们联系起来的,并说明通过结合扩散模型来改进这些生成模型。VAE,GAN,Autoregressive model, Normalizing flow, Energy-based model和扩散模型的联系如下图所示:

A. DDPM可以视作层次马尔可夫VAE(hierarchical Markovian VAE)。但DDPM和一般的VAE也有区别。DDPM作为VAE,它的encoder和decoder都服从高斯分布、有马尔科夫行;其隐变量的维数和数据维数相同;decoder的所有层都共用一个神经网络。

B. DDPM可以帮助GAN解决训练不稳定的问题。因为数据是在高维空间中的低维流形中,所以GAN生成数据的分布和真实数据的分布重合度低,导致训练不稳定。扩散模型提供了一个系统地增加噪音的过程,通过扩散模型向生成的数据和真实数据添加噪音,然后将加入噪音的数据送入判别器,这样可以高效地解决GAN无法训练、训练不稳定的问题。

C. Normalizing flow通过双射函数将数据转换到先验分布,这样的作法限制了Normalizing flow的表达能力,导致应用效果较差。类比扩散模型向encoder中加入噪声,可以增加Normalizing flow的表达能力,而从另一个视角看,这样的做法是将扩散模型推广到前向过程也可学习的模型。

D. Autoregressive model在需要保证数据有一定的结构,这导致设计和参数化自回归模型非常困难。扩散模型的训练启发了自回归模型的训练,通过特定的训练方式避免了设计的困难。

E. Energy-based model直接对原始数据的分布建模,但直接建模导致学习和采样都比较困难。通过使用扩散恢复似然,模型可以先对样本加入微小的噪声,再从有略微噪声的样本分布来推断原始样本的分布,使的学习和采样过程更简单和稳定。

扩散模型的应用

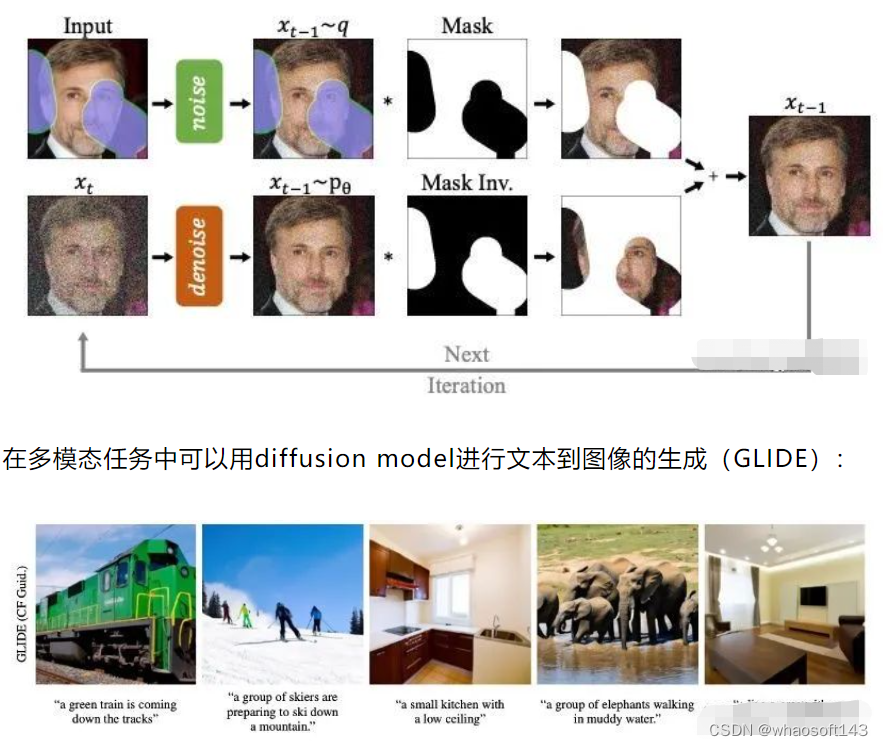

在下面的每个小节中,我们分别介绍了扩散模型在计算机视觉、自然语言处理、波形信号处理、多模态学习、分子图生成、时间序列以及对抗学习等七大应用方向中的应用,并对每类应用中的方法进行了细分并解析。例如在计算机视觉中可以用diffusion model进行图像补全修复(RePaint):

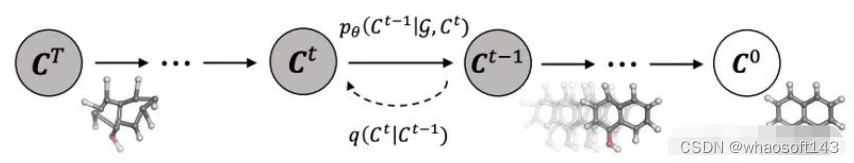

还可以在分子图生成中用diffusion model进行药物分子和蛋白质分子的生成(GeoDiff):

应用分类汇总见表:

未来研究方向

A. 应用假设再检验。我们需要检查我们在应用中普遍接受的假设。例如,实践中普遍认为扩散模型的前向过程会将数据转换为标准高斯分布,但事实并非如此,更多的前向扩散步骤会使最终的样本分布与标准高斯分布更接近,与采样过程一致;但更多的前向扩散步骤也会使估计分数函数更加困难。理论的条件很难获得,因此在实践中操作中会导致理论和实践的不匹配。我们应该意识到这种情况并设计适当的扩散模型。

B. 从离散时间到连续时间。由于扩散模型的灵活性,许多经验方法可以通过进一步分析得到加强。通过将离散时间的模型转化到对应的连续时间模型,然后再设计更多、更好的离散方法,这样的研究思路有前景。

C. 新的生成过程。扩散模型通过两种主要方法生成样本:一是离散化反向扩散 SDE,然后通过离散的反向 SDE 生成样本;另一个是使用逆过程中马尔可夫性质对样本逐步去噪。然而,对于一些任务,在实践中很难应用这些方法来生成样本。因此,需要进一步研究新的生成过程和视角。

D. 泛化到更复杂的场景和更多的研究领域。虽然目前diffusion model已经应用到多个场景中,但是大多数局限于单输入单输出的场景,将来可以考虑将其应用到更复杂的场景,比如text-to-audiovisual speech synthesis。也可以考虑和更多的研究领域相结合。

# AIGC扩散模型diffusion应用

1、机器人规划/智能决策 SkillDiffuser: Interpretable Hierarchical Planning via Skill Abstractions in Diffusion-Based Task Execution

扩散模型已展示在机器人轨迹规划方面的潜力。然而,从高级指令生成连贯的轨迹仍具有挑战性,特别是对于需要多个序列技能的长距离组合任务。

提出SkillDiffuser,一个端到端的分层规划框架,将可解释的技能学习与条件扩散规划相结合。在更高层面上,技能抽象模块从视觉观察和语言指令中学习离散、人类可理解的技能表示。然后,使用这些学习到的技能嵌入来调节扩散模型,以生成与技能相吻合的定制化潜在轨迹。这样可以生成符合可学习技能的多样化状态轨迹。通过将技能学习与条件轨迹生成结合起来,SkillDiffuser能够在不同任务中按照抽象指令生成连贯的行为。

在Meta-World和LOReL等多任务机器人操纵基准上的实验证明了SkillDiffuser在性能和人类可解释的技能表示方面的先进性。https://skilldiffuser.github.io/

2、动作生成/舞蹈序列 Lodge: A Coarse to Fine Diffusion Network for Long Dance Generation Guided by the Characteristic Dance Primitives

提出Lodge,根据给定音乐生成极长舞蹈序列的网络。将Lodge设计为一个两阶段的粗到精扩散架构,提出characteristic dance primitives,作为两个扩散模型之间的中间表示。

第一阶段是全局扩散,重点在于理解粗粒度的音乐-舞蹈关联性和生成特征舞蹈。第二阶段是局部扩散,通过舞蹈和编排规则的指导,同时生成详细的动作序列。此外,提出一个足部精炼模块,优化脚与地面之间的接触,增强了动作的物理逼真感。

方法平衡全局编舞模式和局部动作质量和表现力之间的关系。大量实验证实方法有效性。https://li-ronghui.github.io/lodge

3、视觉叙事/多模态学习 Intelligent Grimm - Open-ended Visual Storytelling via Latent Diffusion Models

生成模型最近在文本到图像生成方面展示了出色的能力,但仍然难以连贯地生成图像序列。这项工作关注一个新颖而具有挑战性的任务,即基于给定故事情节生成连贯的图像序列,被称为开放式视觉叙事。

做出了以下三个贡献:(i)为完成视觉叙事的任务,提出一种基于学习的自回归图像生成模型StoryGen,采用一个新的视觉-语言上下文模块,使得生成的当前帧能够以相关文本提示和之前的image-caption对作为条件;(ii)为解决视觉叙事数据的不足,通过在线视频和开源电子书收集成对的图像-文本序列,建立了一个包含多样化角色、故事情节和艺术风格的大规模数据集的处理流程,命名为StorySalon;(iii)定量实验和人类评估验证StoryGen的优越性,展示了StoryGen可以在没有任何优化的情况下推广到未见过的角色,并生成具有连贯内容和一致性的图像序列。https://haoningwu3639.github.io/StoryGen_Webpage/

4、因果归因 ProMark: Proactive Diffusion Watermarking for Causal Attribution

生成AI(GenAI)通过高级提示的能力,正在改变创意工作流程,合成和操作图像。然而,创意者们缺乏得到对他们在GenAI训练中使用的内容的认可或奖励的支持。为此,提出ProMark,一种因果归因技术,将生成图像归因于其训练数据中的概念,如对象、主题、模板、艺术家或风格。概念信息被主动嵌入到输入训练图像中,使用察觉不到的水印,扩散模型(无条件或条件)被训练以在生成的图像中保留相应的水印。

展示可以将多达2^16个独特的水印嵌入训练数据中,每个训练图像可以包含多个水印。ProMark可以保持图像质量,同时优于基于相关性的归因。最后,展示了一些定性的示例,提供了水印的存在传达了训练数据和合成图像之间的因果关系。

5、隐私保护/对抗估计 Robust Imperceptible Perturbation against Diffusion Models

文本到图像扩散模型可从参考照片中生成个性化图像。然而这些工具如果落入不良之徒手中,可能制造误导性或有害内容,危及个人安全。为解决这个问题,现有防御方法对用户图像进行微不可察觉的扰动,使其对恶意使用者“无法学习”。这些方法两个局限性:一是由于手工设计的启发式方法导致sub-optimal结果;二是缺乏对简单数据转换(如高斯滤波)的鲁棒性。

为解决这些挑战,提出MetaCloak,用元学习框架,通过额外的转换采样过程来构建可转移和鲁棒的扰动。具体而言,用一组替代扩散模型来构建可转移和模型无关的扰动。此外,通过引入额外的转换过程,设计一个简单的去噪误差最大化损失,足以在个性化生成中引起转换鲁棒的语义失真和降级。

在VGGFace2和CelebA-HQ数据集上进行实验,表明MetaCloak优于现有方法。值得注意的是,MetaCloak能够成功欺骗Replicate等在线训练服务,以黑盒方式展示了MetaCloak在实际场景中的有效性。https://github.com/liuyixin-louis/MetaCloak

6、3D相关/流估计 DifFlow3D: Toward Robust Uncertainty-Aware Scene Flow Estimation with

Iterative Diffusion-Based Refinement

场景流估计,是计算机视觉领域的一项基础任务,旨在预测动态场景的每个点的三维位移。然而,前期的工作通常由于局部限制的搜索范围导致相关性不可靠,并且由于粗到细结构而产生累积误差。

为缓解这些问题,提出一种新的基于扩散概率模型的场景流估计网络(DifFlow3D)来推断不确定性。设计迭代扩散的细化过程,以增强相关性的鲁棒性和对挑战性情况(如动态场景、噪声输入、重复图案等)的韧性。为抑制生成多样性,在扩散模型中使用了三个与流相关的关键特征作为条件。

此外,还在扩散中开发了一个不确定性估计模块,用于评估估计的场景流的可靠性。DifFlow3D实现了最先进的性能,在FlyingThings3D和KITTI 2015数据集上分别减少了6.7%和19.1%的EPE3D。值得注意的是,方法在KITTI数据集上实现了空前的毫米级准确性(EPE3D为0.0089m)。此外,基于扩散的细化范式可以轻松地作为即插即用模块集成到现有的场景流网络中,提高它们的估计准确性。

7、运动生成/多模态学习 OMG: Towards Open-vocabulary Motion Generation via Mixture of Controllers

近期在逼真的文本到运动生成方面取得进展。然而,现有方法在处理未见过的文本输入时往往失败或产生不合理的动作,限制了应用的范围。

本文提出一个新框架OMG,从零样本开放词汇的文本提示中生成引人注目的动作。关键思想是将预训练-微调范式精心调整为文本到运动生成。在预训练阶段,模型通过学习丰富的领域外内在运动特征来改善生成能力。为此,将一个大规模无条件扩散模型扩展到10亿个参数,以利用超过2000万个无标签的运动实例数据。在随后的微调阶段,引入运动控制网络(ControlNet),通过一个可训练的预训练模型和提出的新型混合控制器(MoC)块,将文本提示作为调节信息进行融合。MoC块通过交叉注意机制自适应地识别子运动的各个范围,并使用专门针对文本token的专家进行分段处理。这样的设计有效地将文本提示的CLIP令牌嵌入到各种范围的紧凑和富有表现力的运动特征中。

大量实验证明,OMG在零样本文本到运动生成上取得了显著改进,优于最先进方法。https://tr3e.github.io/omg-page/

# 扩散模型diffusion的改进方向

1、Accelerating Diffusion Sampling with Optimized Time Steps

扩散概率模型(DPMs)在高分辨率图像生成方面显示出显著性能,但由于通常需要大量采样步骤,其采样效率仍有待提高。高阶ODE求解在DPMs中的应用的最新进展使得能够以更少的采样步骤生成高质量图像。然而,大多数采样方法仍使用均匀的时间步长,在使用少量步骤时并不是最优的。

为解决这个问题,提出一个通用框架来设计一个优化问题,该优化问题寻求特定数值ODE求解器在DPMs中更合适的时间步长。该优化问题的目标是将基本解和相应的数值解之间的距离最小化。高效解决这个优化问题,所需时间不超过15秒。

在像素空间和潜空间DPMs上进行大量实验,无条件采样和有条件采样,结果表明,与用均匀时间步长相比,当与最先进的采样方法UniPC相结合时,对于CIFAR-10和ImageNet等数据集,以FID分数来衡量,优化时间步长显著提高图像生成性能。

2、DistriFusion: Distributed Parallel Inference for High-Resolution Diffusion Models

用扩散模型生成高分辨率图像巨大计算成本,导致交互式应用的延迟不可接受。提出DistriFusion来解决这个问题,通过利用多个GPU之间的并行性。方法将模型输入分成多个patch,并每个分配给一个GPU。然而,简单地实现这种算法会破坏patch之间的交互并丢失保真度,而考虑这种交互将导致巨大的通信开销。

为解决这个困境,观察到相邻扩散步骤的输入之间具有很高的相似性,并提出位移patch并行性,它利用扩散过程的顺序性质,通过重复使用前一时间步的预计算特征图为当前步骤提供上下文。因此,方法支持异步通信,可以通过计算进行流水线处理。大量实验证明,方法可以应用于最近的Stable Diffusion XL,而不会降低质量,并且相对于一个NVIDIA A100设备,可以实现高达6.1倍的加速。已开源在:https://github.com/mit-han-lab/distrifuser

3、Balancing Act: Distribution-Guided Debiasing in Diffusion Models

扩散模型(DMs)会反映训练数据集中存在的偏差。在人脸情况下尤为令人担忧,DM更偏爱某个人口群体而不是其他人口群体(例如女性比男性)。这项工作提出一种在不依赖于额外数据或模型重新训练的情况下对DMs进行去偏置的方法。

具体而言,提出分布引导(Distribution Guidance)方法,该方法强制生成的图像遵循指定的属性分布。为实现这一点,建立在去噪UNet(denoising UNet)的潜在特征上具有丰富的人口群体语义,并且可以利用这些特征来引导去偏置生成。训练属性分布预测器(ADP),一个将潜在特征映射到属性分布的小型多层感知机。ADP是使用现有属性分类器生成的伪标签进行训练的。引入的Distribution Guidance与ADP能进行公平生成。

方法减少了单个/多个属性上的偏差,并且在无条件和文本条件下的扩散模型方面的基线效果明显优于过去的方法。此外,提出通过生成数据对训练集进行再平衡来训练公平属性分类器的下游任务。

4、Few-shot Learner Parameterization by Diffusion Time-steps

即使用大型多模态基础模型,少样本学习仍具有挑战性。如果没有适当的归纳偏差,很难保留微妙的类属性,同时删除与类标签啡不相关的显著视觉属性。

发现扩散模型(DM)的时间步骤可以隔离微妙的类属性,即随着前向扩散在每个时间步骤向图像添加噪声,微妙的属性通常在比显著属性更早的时间步骤丢失。基于此,提出了时间步骤少样本(TiF)学习器。为文本条件下的DM训练了类别特定的低秩适配器,以弥补丢失的属性,从而在给定提示的情况下可以准确地从噪声图像重建出原始图像。因此,在较小的时间步骤中,适配器和提示本质上是仅含有微妙的类属性的参数化。对于一个测试图像,可以使用这个参数化来仅提取具有微妙的类属性进行分类。在各种细粒度和定制的少样本学习任务上,TiF学习器在性能上明显优于OpenCLIP及其适配器。

5、Structure-Guided Adversarial Training of Diffusion Models

在各种生成应用中,扩散模型展示了卓越的有效性。现有模型主要侧重于通过加权损失最小化来对数据分布进行建模,但它们的训练主要强调实例级的优化,忽视了每个小批量数据内有价值的结构信息。

为解决这个限制,引入结构引导的扩散模型对抗训练(Structure-guided Adversarial training of Diffusion Models, SADM)方法。迫使模型在每个训练批次中学习样本之间的流形结构。为确保模型捕捉到数据分布中真实的流形结构,提出一种新的结构判别器,通过对抗训练与扩散生成器进行游戏,区分真实的流形结构和生成的流形结构。

SADM显著改进了现有的扩散transformer,在图像生成和跨域微调任务中的12个数据集上性能优于现有方法,对于256×256和512×512分辨率下的类条件图像生成,新FID记录分别为1.58和2.11。

6、Tackling the Singularities at the Endpoints of Time Intervals in Diffusion Models

大多数扩散模型假设反向过程服从高斯分布,然而,这种近似在奇异点处(t=0和t=1)尤其在奇异点singularities处尚未得到严格验证。不当处理这些点会导致应用中的平均亮度问题,并限制生成具有极端亮度或深暗度的图像。

本文从理论和实践的角度解决。首先,建立了反向过程逼近的误差界限,并展示了在奇异时间步骤时它的高斯特征。基于这个理论认识,确认t=1的奇异点是有条件可消除的,而t=0时是固有的属性。基于这些重要的结论,提出一种新的即插即用方法SingDiffusion来处理初始奇异时间步骤的采样,它不仅可以在没有额外训练的情况下有效解决平均亮度问题,而且还可以提高它们的生成能力,从而实现显著较低的FID得分。https://github.com/PangzeCheung/SingDiffusion

1258

1258

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?