简介:Elasticsearch-Head是一款基于Chrome浏览器的轻量级可视化插件,为ES集群提供直观的图形化管理界面。该工具支持集群状态监控、索引管理、文档操作、搜索聚合及性能分析等功能,极大简化了开发者和运维人员对Elasticsearch的操作流程。本文详细介绍ES-Head的安装配置方法、核心功能特性及实用技巧,帮助用户高效掌握其在实际场景中的应用,提升ES日常维护与调试效率。

1. Elasticsearch-Head插件介绍与定位

核心设计理念与技术背景

Elasticsearch-Head 以轻量级、低侵入的方式为开发者提供直观的集群可视化入口,其核心设计聚焦于 快速诊断 与 交互验证 。不同于 Kibana 的全栈分析能力,Head 专注于底层状态暴露——如分片分配、节点连通性、索引健康度等运维关键指标,通过简洁的 Web UI 将 RESTful 接口返回的 JSON 数据转化为可读性强的树形结构与状态图谱。

架构演进与部署形态变迁

早期版本基于 Node.js 构建独立服务,依赖 grunt 启动本地服务器代理请求;随着浏览器安全策略收紧与开发便捷性需求上升,社区转向 Chrome 扩展模式,利用浏览器的跨域代理能力绕过 CORS 限制,实现“即装即用”的调试体验。该转变显著提升了在本地开发环境中的部署效率。

在现代搜索生态中的定位

Head 并非生产级监控方案,而是 开发者友好的调试助手 ,适用于配置验证、数据探查与故障初筛。它与 Kibana 形成互补:Kibana 面向数据可视化与用户分析,而 Head 面向系统架构与存储布局的底层洞察,是理解 ES 内部机制的理想教学工具与轻量排查终端。

2. Chrome扩展安装步骤与开发者模式配置

在现代搜索系统开发和运维实践中,Elasticsearch-Head 作为轻量级、高响应的可视化调试工具,已成为开发者快速验证集群状态、索引结构和文档数据的重要助手。尤其当其以 Chrome 浏览器扩展形式存在时,具备跨平台兼容性强、无需独立服务部署、即装即用等显著优势。然而,由于官方已不再维护原始项目,当前主流使用方式依赖于社区维护版本(如 GitHub 上活跃的 fork 分支),因此从源码获取到最终成功加载至浏览器的过程涉及多个技术环节,包括环境准备、构建打包、权限理解及安全控制。本章将系统性地指导读者完成从零开始的完整安装流程,并深入剖析各关键步骤背后的实现机制。

2.1 插件获取与源码准备

2.1.1 GitHub 项目克隆与版本选择

要使用 Elasticsearch-Head 作为 Chrome 扩展,首先必须从可信的开源仓库中获取最新且稳定的源码。尽管原始项目 mobz/elasticsearch-head 已归档,但可通过其广泛使用的社区分支进行克隆。推荐使用如下命令:

git clone https://github.com/mobz/elasticsearch-head.git

cd elasticsearch-head

该仓库最后一次有效提交通常停留在支持 Elasticsearch 5.x 至 7.x 版本之间。若目标 ES 集群为 8.x 或更高版本,则需注意可能存在的 API 不兼容问题,此时建议寻找适配新版的社区 Fork,例如 aaronqiu/elasticsearch-head-chrome 等经过修改以支持现代 Chrome 扩展 Manifest V3 的分支。

选择合适的版本至关重要。对于生产测试环境或本地开发调试,推荐使用稳定 tag(如 v1.0.0 )而非直接拉取 main 分支的最新代码,以避免引入未测试的功能变更。可通过以下命令列出可用标签并切换:

git tag -l

git checkout v1.0.0

| 项目 | 推荐值 | 说明 |

|---|---|---|

| 源码来源 | mobz/elasticsearch-head (fork 维护版) | 原始项目已停更,需找活跃维护分支 |

| 支持 ES 版本 | 5.x ~ 7.17 | 不适用于默认配置下的 8.x+ |

| Chrome Manifest 版本 | V2(原始)/ V3(需手动升级) | 当前多数 Fork 使用 V2 |

逻辑分析 :Git 克隆操作是构建本地工作空间的第一步,确保后续所有构建和调试都在可控环境中进行。版本锁定有助于复现问题和团队协作一致性。

graph TD

A[确定使用场景] --> B{ES 版本是否 ≥8?}

B -- 是 --> C[寻找支持 V3 的 Fork]

B -- 否 --> D[克隆 mobz 主干或稳定 fork]

C --> E[检查 manifest.json 是否为 V3]

D --> F[执行 git clone]

F --> G[检出指定 tag]

G --> H[进入目录准备构建]

上述流程图清晰展示了从判断环境到完成源码获取的决策路径,帮助开发者规避因版本错配导致的后续失败。

2.1.2 源码目录结构解析:src、dist、Gruntfile.js

进入项目根目录后,观察其核心文件与目录布局:

elasticsearch-head/

├── Gruntfile.js # 构建任务定义

├── _site/ # Jekyll 静态站点输出(旧 Web 形式)

├── src/ # 前端源码(HTML/CSS/JS)

│ ├── app.js # 主应用入口

│ ├── main.css # 样式表

│ └── vendor/ # 第三方库(如 jQuery、AngularJS)

├── dist/ # 构建输出目录(扩展所需)

├── plugin-descriptor.properties # 插件描述元信息

└── manifest.json # Chrome 扩展清单文件(V2)

其中最关键的是 src/ 和 dist/ 目录:

-

src/包含所有前端资源,采用 AngularJS 1.x 框架编写,通过 AJAX 调用 ES REST API 实现交互。 -

dist/是通过 Grunt 构建生成的目标文件夹,包含压缩后的 JS/CSS 和完整的扩展结构。 -

Gruntfile.js定义了如何将源码编译、合并、压缩并输出到dist/,是自动化打包的核心。

特别说明 manifest.json 文件内容示例:

{

"manifest_version": 2,

"name": "ElasticSearch Head",

"version": "1.0.0",

"description": "A web front end for browsing and interacting with your ElasticSearch cluster.",

"permissions": [

"http://*/*",

"https://*/*",

"activeTab"

],

"browser_action": {

"default_popup": "index.html"

},

"icons": {

"16": "icon-16.png",

"48": "icon-48.png",

"128": "icon-128.png"

}

}

参数说明 :

-manifest_version: 当前为 2,Chrome 计划淘汰 V2,未来应迁移至 V3。

-permissions: 请求对任意 HTTP/HTTPS 站点的访问权限,这是实现连接任意 ES 实例的基础。

-browser_action.default_popup: 点击插件图标时弹出的主界面页面。

此结构决定了整个扩展的行为边界和运行方式,任何后续打包都必须保留这些关键元素。

2.1.3 构建依赖环境:Node.js 与 npm 包管理器初始化

由于该项目使用 Grunt 构建系统,必须预先安装 Node.js 和 npm(随 Node 自带)。验证安装是否成功:

node -v

npm -v

推荐使用 LTS 版本(如 v16.x 或 v18.x),避免因新版语法不兼容引发异常。

接下来初始化项目依赖:

npm install

该命令会读取 package.json 并下载所有声明的依赖包,主要包括:

"devDependencies": {

"grunt": "~1.0.1",

"grunt-contrib-clean": "~1.0.0",

"grunt-contrib-concat": "~1.0.0",

"grunt-contrib-cssmin": "~2.2.0",

"grunt-contrib-uglify": "~3.0.0"

}

安装完成后,可查看 node_modules/ 目录确认模块加载情况。

随后执行构建命令:

npm run build

或直接调用:

grunt build

这将触发 Grunt 任务流,依次执行 clean → concat → cssmin → uglify,最终生成优化后的静态资源至 dist/ 目录。

逐行逻辑解读 :

-npm install解析package.json中的依赖项,从 npm registry 下载对应版本至本地 node_modules。

-grunt build加载Gruntfile.js,执行注册的build任务组合,完成资源压缩与整合。

- 输出结果可用于 Chrome 扩展加载,也可用于独立 Web 服务运行(需额外启动 HTTP Server)。

构建成功后, dist/ 目录将成为后续加载的核心目录,其完整性直接影响扩展能否正常运行。

2.2 扩展打包与本地加载

2.2.1 使用 Grunt 构建 dist 发布包

Grunt 是基于 Node.js 的任务运行器,通过 Gruntfile.js 配置任务流程。以下是典型构建任务定义节选:

module.exports = function(grunt) {

grunt.initConfig({

clean: ['dist'],

concat: {

js: {

src: ['src/*.js'],

dest: 'dist/app.js'

},

css: {

src: ['src/*.css'],

dest: 'dist/main.css'

}

},

cssmin: {

minify: {

expand: true,

cwd: 'dist/',

src: ['main.css'],

dest: 'dist/',

ext: '.min.css'

}

},

uglify: {

build: {

files: {

'dist/app.min.js': ['dist/app.js']

}

}

}

});

grunt.loadNpmTasks('grunt-contrib-clean');

grunt.loadNpmTasks('grunt-contrib-concat');

grunt.loadNpmTasks('grunt-contrib-cssmin');

grunt.loadNpmTasks('grunt-contrib-uglify');

grunt.registerTask('build', ['clean', 'concat', 'cssmin', 'uglify']);

};

参数说明与逻辑分析 :

-clean: 清理旧dist/内容,保证构建纯净。

-concat: 将多个 JS/CSS 文件合并为单一文件,减少请求数。

-cssmin和uglify: 分别压缩 CSS 和 JS,提升加载性能。

- 最终生成app.min.js和main.min.css,供index.html引用。

执行 grunt build 后,可在 dist/ 中看到如下结构:

dist/

├── index.html

├── app.min.js

├── main.min.css

├── icon-*.png

└── manifest.json

该目录即为可加载的 Chrome 扩展包。

2.2.2 Chrome 浏览器进入扩展管理页面(chrome://extensions/)

打开 Chrome 浏览器,在地址栏输入:

chrome://extensions/

此页面展示所有已安装的扩展程序及其状态。为加载自定义扩展,需启用“开发者模式”。

点击右上角开关开启“开发者模式”,界面将出现三个新按钮:

- 加载已解压的扩展程序

- 打包扩展程序

- 更新扩展程序

选择“加载已解压的扩展程序”,弹出文件选择框,导航至项目中的 dist/ 目录并确认。

若加载成功,页面将显示新扩展条目:“ElasticSearch Head”,图标为绿色大象头像,ID 自动生成。

注意事项 :

- 若提示“清单文件缺失”,说明dist/缺少manifest.json或格式错误(见下一节排查)。

- 加载后每次刷新chrome://extensions/页面不会自动重载扩展,需手动点击“重新加载”图标。

2.2.3 开启“开发者模式”并加载已解压的扩展程序

开发者模式是 Chrome 提供的高级功能,允许加载本地未签名的扩展,常用于调试和测试阶段。

一旦加载成功,可在浏览器工具栏看到 Head 插件图标。点击图标弹出主界面,默认连接地址为 http://localhost:9200 。

此时若 Elasticsearch 正在本地运行(如 Docker 启动),即可直接访问集群信息。

操作流程总结 :

1. 进入chrome://extensions/

2. 开启“开发者模式”

3. 点击“加载已解压的扩展程序”

4. 选择elasticsearch-head/dist/目录

5. 确认加载成功并测试连接

sequenceDiagram

participant User

participant Chrome

participant DistFolder

User->>Chrome: 打开 chrome://extensions/

Chrome-->>User: 显示扩展列表

User->>Chrome: 开启开发者模式

Chrome-->>User: 显示加载按钮

User->>Chrome: 点击“加载已解压的扩展程序”

Chrome->>DistFolder: 读取 manifest.json

alt 文件完整且合法

DistFolder-->>Chrome: 返回扩展资源

Chrome-->>User: 成功加载插件

else 文件缺失或错误

DistFolder-->>Chrome: 报错

Chrome-->>User: 显示“清单文件缺失”

end

该序列图直观呈现了加载过程中的关键交互节点,有助于定位失败环节。

2.3 安装常见问题排查

2.3.1 “清单文件缺失”错误处理方案

最常见的加载失败提示是:“清单文件缺失”。原因主要有三类:

| 原因 | 解决方法 |

|---|---|

dist/ 目录中无 manifest.json | 检查构建脚本是否正确复制该文件 |

manifest.json 格式非法(JSON 错误) | 使用 JSON 校验工具检查语法 |

字段缺失(如 manifest_version ) | 补全必要字段 |

解决方案示例:

# 检查 manifest 是否存在

ls dist/manifest.json

# 查看内容是否合法

cat dist/manifest.json | python -m json.tool

若发现构建过程中未复制 manifest.json ,应在 Gruntfile.js 中添加 copy 任务:

grunt.loadNpmTasks('grunt-contrib-copy');

// 在 config 中添加

copy: {

main: {

files: [

{expand: true, src: ['manifest.json', 'icon-*.png'], dest: 'dist/'}

]

}

}

// 在 build 任务中加入 copy

grunt.registerTask('build', ['clean', 'copy', 'concat', 'cssmin', 'uglify']);

参数说明 :

-expand: true:启用通配符匹配。

-src:指定要复制的文件。

-dest:目标目录。

此举确保关键元数据文件被正确输出。

2.3.2 跨域请求失败(CORS)的根源分析

即使插件加载成功,也可能无法连接到本地 Elasticsearch 实例,表现为浏览器控制台报错:

Access to XMLHttpRequest at 'http://localhost:9200/'

from origin 'chrome-extension://...' has been blocked by CORS policy.

这是因为 Chrome 扩展运行在独立 origin 下,而 ES 默认禁止非同源请求。

解决方法有二:

方案一:修改 ES 配置启用 CORS

编辑 elasticsearch.yml :

http.cors.enabled: true

http.cors.allow-origin: "*"

http.cors.allow-methods: GET, POST, PUT, DELETE, OPTIONS

http.cors.allow-headers: X-Requested-With, Content-Type, Content-Length, Authorization

重启 ES 服务生效。

安全提醒 :生产环境中不应设置

allow-origin: "*",应限定具体域名或 IP。

方案二:使用代理中间层(推荐开发环境)

搭建一个支持 CORS 的反向代理,如 Nginx:

location / {

proxy_pass http://localhost:9200;

add_header 'Access-Control-Allow-Origin' '*' always;

add_header 'Access-Control-Allow-Methods' 'GET, POST, OPTIONS' always;

add_header 'Access-Control-Allow-Headers' 'DNT,Authorization,X-CustomHeader,Keep-Alive,User-Agent,X-Requested-With,If-Modified-Since,Cache-Control,Content-Type' always;

}

然后在 Head 插件中连接 http://localhost:8080 (代理端口)。

2.3.3 扩展无法连接本地 ES 实例的网络调试技巧

当连接失败时,应按以下顺序排查:

-

确认 ES 是否运行

bash curl http://localhost:9200

应返回集群基本信息。 -

检查防火墙或绑定地址

确保 ES 绑定到0.0.0.0而非仅127.0.0.1:

yaml network.host: 0.0.0.0 -

查看 Chrome 控制台错误

F12 打开 DevTools,切换至 Network Tab,观察请求是否发出、响应码为何。 -

尝试手动发送请求

在控制台执行:

javascript fetch('http://localhost:9200').then(r => r.json()).then(console.log)

验证是否能绕过插件逻辑获取数据。 -

更换连接地址

在 Head 界面顶部输入框改为http://host.docker.internal:9200(Docker 场景)或实际 IP。

通过层层递进的方式,可精准定位网络链路中的断点。

2.4 安全注意事项与权限控制

2.4.1 扩展权限说明:为何需要“读取和更改所有网站数据”

在 manifest.json 中声明的权限:

"permissions": ["http://*/*", "https://*/*"]

意味着该扩展可以向任意 HTTP/HTTPS 站点发起请求,并读取响应内容。这是其实现连接任意 ES 实例的技术前提。

但这也带来了安全隐患:

- 可窃取敏感接口返回的数据(如内部 API 响应)

- 若扩展被恶意篡改,可能成为 XSS 攻击载体

Chrome 因此会在安装时警告用户:“此扩展可以访问您在所有网站上的数据”。

建议做法 :

- 仅从可信源(如 GitHub 官方 fork)获取代码

- 审查manifest.json权限范围

- 不在公共电脑或高安全要求设备上安装

2.4.2 生产环境中禁用 Head 插件的安全建议

虽然 Head 对调试极为便利,但在生产环境中应严格禁止使用,理由如下:

| 风险点 | 说明 |

|---|---|

| 无认证机制 | Head 不支持 Basic Auth 或 JWT,易暴露无防护接口 |

| 权限过大 | 可执行删除索引、关闭节点等高危操作 |

| 数据泄露 | 可浏览全部文档内容,违反最小权限原则 |

最佳实践建议 :

1. 仅在开发/测试环境启用

2. 使用完毕后立即卸载或禁用

3. 替代方案采用 Kibana + Role-Based Access Control(RBAC)

4. 对外暴露的 ES 节点配置严格的防火墙规则和身份验证

综上所述,Elasticsearch-Head 的 Chrome 扩展安装虽看似简单,实则涉及构建、打包、加载、权限与安全等多个维度的技术细节。只有全面掌握这些环节,才能高效、安全地将其应用于日常开发工作中。

3. 集群健康状态实时监控与解读

在现代分布式系统中,Elasticsearch 作为核心的搜索与分析引擎,其运行稳定性直接决定了上层应用的数据可访问性、查询延迟和整体服务质量。因此,对集群健康状态进行持续、准确的监控是运维工作的重中之重。Elasticsearch-Head 插件提供了一套简洁而强大的可视化界面,使得开发者和运维人员能够以图形化方式实时掌握集群的整体运行状况。本章将深入剖析 Head 插件如何呈现关键指标,并结合底层机制解释这些数据背后的含义,帮助用户不仅“看到”问题,更能“理解”问题。

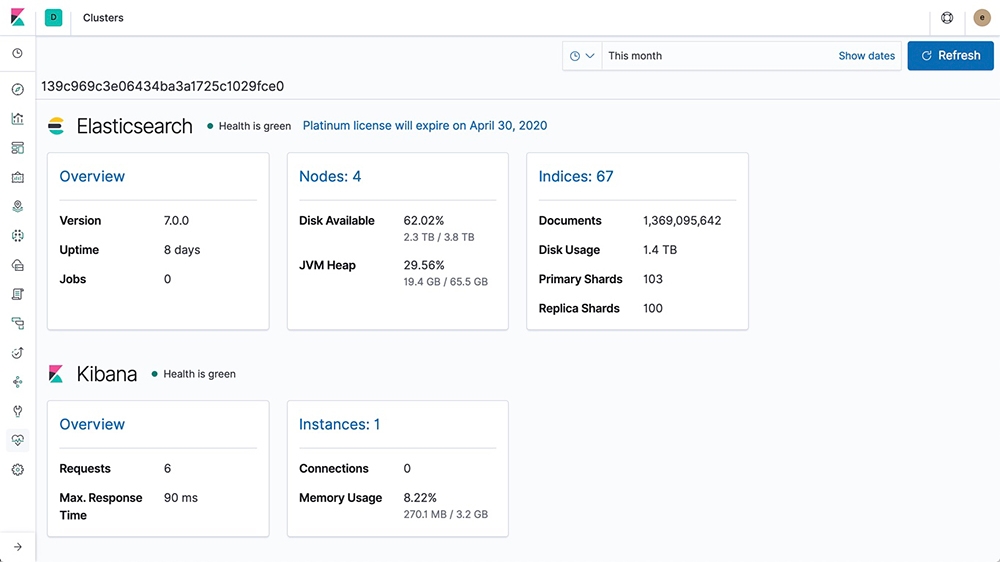

通过 Head 的“Overview”视图,用户可以快速获取集群名称、节点数量、分片总数等宏观信息;更重要的是,它用颜色编码的方式直观展示集群当前的健康等级——绿色(Green)、黄色(Yellow)或红色(Red)。这种设计虽看似简单,实则蕴含了 Elasticsearch 内部复杂的分片管理逻辑与容错机制。接下来的内容将从集群概览出发,逐步深入到分片分配策略、索引级健康评估以及动态刷新机制,构建一个由表及里的完整认知链条。

此外,我们将引入实际操作场景中的典型异常案例,例如未分配分片(Unassigned Shards)的成因分析、节点失联后的再平衡过程模拟等,辅以流程图、参数表格和代码片段,确保理论与实践紧密结合。最终目标是让读者具备独立诊断常见集群问题的能力,并能根据监控数据做出合理的优化决策。

3.1 集群概览信息可视化展示

Elasticsearch-Head 在主界面顶部提供了清晰的集群概览区域,集中展示了若干关键运行指标。这一部分不仅是视觉上的入口,更是判断集群是否处于正常状态的第一道防线。理解每一个字段的意义及其背后的技术原理,对于后续深入排查问题至关重要。

3.1.1 集群名称、节点数量、分片总数的图形化呈现

当成功连接至 Elasticsearch 实例后,Head 首先会发起一次 GET /_cluster/health 请求,获取集群的基本健康信息。返回结果通常如下所示:

{

"cluster_name": "my-es-cluster",

"status": "yellow",

"timed_out": false,

"number_of_nodes": 3,

"number_of_data_nodes": 3,

"active_primary_shards": 5,

"active_shards": 8,

"relocating_shards": 0,

"initializing_shards": 0,

"unassigned_shards": 3,

"delayed_unassigned_shards": 0,

"number_of_pending_tasks": 0,

"task_max_waiting_in_queue_millis": 0,

"active_shards_percent_as_number": 72.72727272727273

}

该响应被 Head 解析并在前端渲染为可视化的卡片式布局,主要包括以下三项核心内容:

| 指标 | 含义说明 |

|---|---|

| Cluster Name | 集群唯一标识符,用于区分不同环境下的 ES 实例(如 dev/test/prod) |

| Node Count | 当前注册到集群中的节点总数,包括主节点(master-eligible)和数据节点(data node) |

| Shard Count (Total) | 所有活跃分片的数量总和,含主分片与副本分片 |

注:Head 显示的“Total Shards”一般等于

active_shards字段值。

为了更直观地展示这些数据之间的关系,我们可以使用 Mermaid 流程图来描绘 Head 获取并渲染集群概览的过程:

graph TD

A[用户打开 Elasticsearch-Head] --> B{插件发起 GET /_cluster/health}

B --> C[ES 返回 JSON 响应]

C --> D[Head 解析响应数据]

D --> E[提取 cluster_name, number_of_nodes, active_shards]

E --> F[渲染为前端 UI 卡片]

F --> G[用户查看集群基本信息]

上述流程体现了 Head 作为一个轻量级客户端的工作模式:它不存储任何状态,而是通过定期轮询 REST API 来保持数据同步。这也意味着其显示的信息具有一定的时效性,具体取决于自动刷新间隔设置。

值得注意的是, number_of_nodes 反映的是当前加入集群协调协议的节点数,但并不一定代表所有节点都在承担数据负载。例如,某些仅作为协调节点(coordinating-only nodes)存在的实例不会参与分片分配,因此在观察性能瓶颈时需结合其他视图进一步分析。

而关于分片总数的理解尤为关键。假设某索引设置了 5 个主分片和 1 个副本,则理论上应有 5 * (1 + 1) = 10 个分片。但如果实际显示少于该数值,则可能存在未分配分片(unassigned shards),这往往是集群不稳定的表现之一。

3.1.2 集群状态颜色标识系统:green、yellow、red 的深层含义

Head 使用三种颜色来表示集群健康状态,分别对应 green 、 yellow 和 red 三个级别。虽然表面上看只是简单的状态提示,但实际上它们反映了 Elasticsearch 对数据可用性和一致性的保障程度。

状态定义详解

| 状态 | 条件描述 | 数据安全性 | 是否可写入 |

|---|---|---|---|

| ✅ Green | 所有主分片和副本分片均已正确分配 | 完全冗余,支持节点故障 | 是 |

| ⚠️ Yellow | 所有主分片已分配,但部分副本未分配 | 主数据完整,缺乏容灾能力 | 是 |

| ❌ Red | 至少有一个主分片未能分配 | 数据丢失风险存在 | 否(部分索引不可用) |

我们可以通过一段 JavaScript 代码模拟 Head 如何根据 API 返回的状态决定 UI 显示颜色:

function getClusterStatusColor(status) {

switch (status.toLowerCase()) {

case 'green':

return '#28a745'; // Bootstrap success color

case 'yellow':

return '#ffc107'; // Warning color

case 'red':

return '#dc3545'; // Danger color

default:

return '#6c757d'; // Gray for unknown

}

}

// 示例调用

const clusterHealth = { status: 'yellow' };

document.getElementById('status-indicator').style.backgroundColor =

getClusterStatusColor(clusterHealth.status);

代码逻辑逐行解析:

- 第 1 行:定义函数getClusterStatusColor,接收一个字符串参数status。

- 第 2–9 行:使用switch结构匹配三种标准状态,返回对应的十六进制颜色值。

- 第 11–13 行:获取后端返回的健康状态对象,并将其传入函数。

- 第 14–15 行:将计算出的颜色应用于 DOM 元素背景色,实现视觉反馈。

这个小函数揭示了 Head 背后最基本的交互逻辑——将原始 API 数据转化为用户友好的表现形式。然而,真正重要的是理解每种状态背后可能隐藏的问题。

Yellow 状态的常见成因

尽管 Yellow 状态仍允许读写操作,但它通常是潜在问题的预警信号。最常见的情况是:

- 新创建的索引设置了副本数大于 0,但当前集群节点数不足以容纳所有副本;

- 某个数据节点宕机或网络隔离,导致副本无法分配;

- 分片分配策略受限(如使用

allocation filtering或shard allocation awareness)。

例如,若你在单节点环境中创建了一个副本数为 1 的索引:

PUT /logs-2024

{

"settings": {

"number_of_shards": 3,

"number_of_replicas": 1

}

}

由于只有一个节点,Elasticsearch 无法将副本分片分配到不同的物理机器上(避免同点失效),因此副本将处于 UNASSIGNED 状态,集群整体进入 YELLOW 。

此时可通过以下命令检查未分配原因:

GET _cluster/allocation/explain

返回结果会详细说明为何某个分片无法分配,比如:

{

"index": "logs-2024",

"shard": 0,

"primary": false,

"current_state": "unassigned",

"unassigned_info": {

"reason": "NEW_INDEX_RESTORED",

"at": "2024-04-05T10:23:45.123Z"

},

"can_allocate": "no",

"allocate_explanation": "cannot allocate because all nodes have insufficient disk space"

}

此类信息对于定位问题是极其宝贵的。Head 虽然没有内置 allocation/explain 功能,但其展示的 Unassigned Shards 数量足以提醒管理员及时介入排查。

3.2 分片分配机制与异常诊断

分片是 Elasticsearch 实现水平扩展的核心单元。每个索引被划分为多个主分片(Primary Shards),并在集群中复制为副本分片(Replica Shards),以提高可用性与查询吞吐量。Head 提供了专门的“Shards”标签页,用于可视化展示各索引下分片的分布情况。

3.2.1 主分片与副本分片的布局逻辑

在一个典型的多节点集群中,分片的分配遵循“均匀分布 + 故障隔离”的原则。Elasticsearch 的 shard allocator 组件负责决策每个分片应放置在哪台节点上。

考虑如下配置的索引:

PUT /orders

{

"settings": {

"number_of_shards": 3,

"number_of_replicas": 1

}

}

该索引共产生 3 个主分片(P0, P1, P2),每个主分片有一个副本(R0, R1, R2)。理想情况下,6 个分片应在 3 个节点间均匀分布,且同一主-副本对不会落在同一节点上。

Head 的分片视图将以表格形式展示:

| Index | Shard | Type | State | Node |

|---|---|---|---|---|

| orders | 0 | primary | STARTED | node-1 |

| orders | 0 | replica | STARTED | node-2 |

| orders | 1 | primary | STARTED | node-2 |

| orders | 1 | replica | STARTED | node-3 |

| orders | 2 | primary | STARTED | node-3 |

| orders | 2 | replica | STARTED | node-1 |

此分布满足高可用要求:任意一个节点宕机,其余节点仍持有完整的主分片集合。

3.2.2 Unassigned shards 的成因与修复策略

当出现 UNASSIGNED 状态的分片时,Head 中对应条目会以灰色或斜体显示,提示存在异常。

常见的 unassigned 成因包括:

| 原因类型 | 描述 | 解决方案 |

|---|---|---|

| 节点不足 | 副本数超过可用节点数 | 减少副本数或增加节点 |

| 磁盘空间不足 | 节点磁盘使用率高于阈值(默认 85%) | 清理数据或扩容磁盘 |

| 分配禁用 | 手动关闭了分片分配( cluster.routing.allocation.enable ) | 启用分配 |

| 网络分区 | 节点临时失联导致脑裂或剔除 | 恢复网络连接 |

修复步骤示例:

-

查看未分配详情:

bash GET _cluster/allocation/explain?pretty -

若因分配关闭导致:

bash PUT _cluster/settings { "transient": { "cluster.routing.allocation.enable": "all" } } -

若副本过多无法分配,临时降级:

bash PUT /my-index/_settings { "number_of_replicas": 0 }

待稳定后再恢复。

3.2.3 节点失联导致的再平衡过程模拟

当某个数据节点突然断开连接时,Elasticsearch 会触发一系列自动恢复行为。Head 可以实时反映这一过程。

sequenceDiagram

participant MasterNode

participant DataNode1

participant DataNode2

participant Client(Head)

MasterNode->>DataNode1: Ping heartbeat

DataNode1--x MasterNode: No response (timeout)

MasterNode->>MasterNode: Mark node as failed

MasterNode->>DataNode2: Promote replicas to primaries

DataNode2->>DataNode2: Start recovery process

MasterNode->>Client(Head): Update cluster state → YELLOW

Note right of DataNode2: Rebuilding missing shards

DataNode2->>MasterNode: Recovery completed

MasterNode->>Client(Head): Cluster back to GREEN (if new node joins)

此流程表明,Elasticsearch 具备较强的自我修复能力,但在节点恢复前,服务能力会有所下降。Head 的实时更新让用户能清晰看到状态变迁全过程。

3.3 索引级别健康度分析

除了集群整体状态外,Head 还支持按索引维度查看健康情况。

3.3.1 单个索引的状态评估:是否存在未分配副本

点击特定索引可查看其分片分布。若发现某副本长期处于 UNASSIGNED ,则需检查:

- 该索引设置是否合理;

- 是否受限于

index.routing.allocation.*规则; - 是否因

disk.watermark触发保护机制。

3.3.2 索引恢复进度跟踪与耗时预测

在节点重启或网络恢复后,Elasticsearch 会执行分片恢复(Recovery)。Head 可显示恢复进度条(基于 _cat/recovery 接口)。

GET _cat/recovery?v&active_only

输出示例:

index shard time type stage source_host target_host translog_ops

orders 0 12.4s peer done 192.168.1.2 192.168.1.3 1000

Head 可据此绘制进度动画,辅助判断服务恢复时间。

3.4 实时刷新与历史趋势参考

3.4.1 自动轮询间隔设置(Auto-refresh)

Head 支持设置自动刷新频率(如 1s、5s、10s),便于持续监控变化。

配置方式:点击右上角“Auto-refresh”按钮选择周期。

其实现依赖定时器:

let refreshInterval = setInterval(() => {

fetch('/_cluster/health')

.then(res => res.json())

.then(data => updateUI(data));

}, 5000); // 5秒刷新一次

参数说明:

-fetch():发送异步请求获取最新集群状态;

-updateUI():更新前端组件;

-setInterval():设定轮询周期,单位毫秒。

3.4.2 结合日志输出判断集群稳定性波动

建议将 Head 监控与 Elasticsearch 日志联动分析。例如,当日志中频繁出现:

[WARN ][o.e.c.r.a.AllocationService] High shard counts detected...

配合 Head 中突增的 unassigned_shards 数量,即可确认发生了大规模分片重新分配事件。

综上所述,Elasticsearch-Head 不仅是一个静态查看器,更是一个动态诊断工具。通过对集群健康状态的多层次、多角度呈现,结合底层机制理解,用户可迅速识别并响应潜在风险,保障系统的高可用运行。

4. 索引创建、删除与分片分布可视化管理

在 Elasticsearch 的日常运维中,索引作为数据组织的核心逻辑单元,其生命周期管理是保障系统稳定性和查询效率的关键环节。Elasticsearch-Head 提供了一套直观的图形化界面,使得开发者无需依赖命令行工具或复杂的 REST API 调用即可完成索引的创建、删除、配置修改以及物理分布监控等操作。本章将深入探讨如何通过 Head 插件实现对索引全生命周期的高效管控,并结合底层通信机制和集群行为进行技术剖析。

4.1 图形化创建新索引

Elasticsearch-Head 将原本需要编写 JSON 请求体并通过 PUT /index-name 接口提交的索引创建过程,转化为可视化的表单填写流程,极大降低了初学者的使用门槛。用户只需进入主界面左侧导航栏中的“Indices”选项卡,点击“Create Index”按钮即可启动新建向导。

4.1.1 设置副本数与分片数的合理范围

分片(shard)是 Elasticsearch 实现水平扩展的基础单位,而副本(replica)则用于提升容错能力与读取吞吐量。在 Head 中创建索引时,必须明确指定主分片数量(number_of_shards)和副本数量(number_of_replicas)。这两个参数一经设定便不可更改,因此需在设计阶段充分评估。

| 参数 | 默认值 | 建议范围 | 影响说明 |

|---|---|---|---|

number_of_shards | 5 | 1~10(单节点可更低) | 过多分片会增加 JVM 开销与恢复时间 |

number_of_replicas | 1 | 0~3 | 高副本提升可用性但占用更多存储 |

{

"settings": {

"index.number_of_shards": 3,

"index.number_of_replicas": 2

}

}

代码逻辑逐行解读:

- 第 2 行:定义索引设置块。

- 第 3 行:设置主分片数为 3。该值应在集群节点数增长前预估好,避免后期无法调整。

- 第 4 行:每个主分片配备两个副本,即总共有 9 个分片(3 主 + 6 副),提供较高的读并发能力和故障容忍度。

⚠️ 注意:一旦索引创建完成,

number_of_shards不能直接修改。若需变更,只能通过 Reindex API 创建新索引迁移数据。

合理的分片规划应基于预期数据量和硬件资源。例如,单个分片建议控制在 10GB–50GB 范围内;若预计索引最终大小为 200GB,则初始设置 5 个主分片较为合适。

4.1.2 映射模板预填与动态映射行为控制

除基本设置外,Head 还允许在创建时附加 mapping 定义,以约束字段类型并禁用潜在风险的动态映射(dynamic mapping)。

{

"mappings": {

"dynamic": false,

"properties": {

"timestamp": { "type": "date" },

"user_id": { "type": "keyword" },

"message": { "type": "text", "analyzer": "standard" }

}

}

}

参数说明:

-

"dynamic": false:关闭自动字段识别。当插入未知字段时不会自动建模,防止 schema 泛滥。 -

"timestamp"字段设为date类型,支持时间范围查询。 -

"user_id"使用keyword类型,适用于精确匹配(如聚合、过滤)。 -

"message"使用text类型并指定标准分词器,适合全文检索。

该功能特别适用于结构化日志或交易记录场景,确保数据一致性的同时减少后续 mapping 冲突。

4.1.3 创建过程中 HTTP 请求捕获与响应解析

当用户点击“Create”后,Elasticsearch-Head 实际发送如下 PUT 请求:

PUT http://localhost:9200/my_logs_2025-04

Content-Type: application/json

{

"settings": {

"index.number_of_shards": 3,

"index.number_of_replicas": 2

},

"mappings": {

"dynamic": false,

"properties": {

"timestamp": { "type": "date" },

"user_id": { "type": "keyword" },

"message": { "type": "text" }

}

}

}

成功响应返回状态码 200 OK 并包含确认信息:

{

"acknowledged": true,

"shards_acknowledged": true,

"index": "my_logs_2025-04"

}

此时可在 Head 主界面看到新增索引出现在列表中,颜色标识为绿色(green),表示所有主副分片均已正确分配。

sequenceDiagram

participant User

participant Head as Elasticsearch-Head (Frontend)

participant ES as Elasticsearch Cluster

User->>Head: 点击 Create Index

Head->>ES: 发送 PUT /index-name + settings/mappings

ES-->>Head: 返回 acknowledged=true

Head-->>User: 显示“索引创建成功”

Note right of ES: 分片初始化分配开始

此流程体现了前端工具如何封装复杂协议交互,使开发者专注于业务逻辑而非底层通信细节。

4.2 索引生命周期操作

索引并非永久存在,尤其在日志分析、事件流处理等场景下,定期清理过期数据是必要操作。Elasticsearch-Head 提供了便捷的删除入口,但也需警惕误操作带来的严重后果。

4.2.1 安全删除索引前的风险提示机制

在 Head 界面中,每个索引右侧均有“Delete”图标。点击后弹出二次确认对话框,强制用户输入索引名称以防止误删。

// 模拟前端删除逻辑(简化版)

function deleteIndex(indexName) {

const userInput = prompt(`请输入索引名 "${indexName}" 以确认删除:`);

if (userInput === indexName) {

fetch(`http://localhost:9200/${indexName}`, {

method: 'DELETE'

})

.then(res => {

if (res.ok) alert('索引已删除');

else throw new Error('删除失败');

});

} else {

alert('名称不匹配,取消操作');

}

}

执行逻辑说明:

- 第 2 行:调用浏览器原生

prompt弹窗获取用户确认。 - 第 3 行:仅当输入完全匹配索引名才发起 DELETE 请求。

- 第 5 行:使用 Fetch API 向

/index-name发起 DELETE 方法请求。 - 第 6 行:检查响应状态码是否成功(2xx),否则抛出异常。

这种双重验证机制虽简单却有效,显著降低因误触导致的数据丢失风险。

4.2.2 批量操作支持与误删预防策略

尽管当前版本的 Elasticsearch-Head 不原生支持批量删除多个索引(如通配符匹配),但可通过组合操作模拟实现:

- 在“Indices”列表中观察需清理的索引前缀(如

logs-2024-*); - 手动依次选中目标索引并逐一删除;

- 或切换至“Any Request”标签页,手动构造批量删除脚本:

# 使用 curl 批量删除(非 Head 功能,作为补充建议)

for idx in $(curl -s 'http://localhost:9200/_cat/indices/logs-2024-*?h=index'); do

curl -XDELETE "http://localhost:9200/$idx"

done

参数解释:

-

_cat/indices:获取索引列表; -

h=index:仅输出索引名列; - 循环遍历结果并逐个执行 DELETE。

推荐做法是在生产环境中启用 ILM(Index Lifecycle Management)策略,配合 Kibana 或自定义脚本实现自动化归档与删除,避免依赖人工干预。

4.3 分片物理分布视图解读

Elasticsearch-Head 最具价值的功能之一是展示各节点上分片的物理分布情况,帮助管理员快速识别负载倾斜问题。

4.3.1 各节点上分片分布热力图分析

在“Cluster”→“Nodes”视图中,Head 以表格形式列出所有活跃节点及其承载的分片数量。示例如下:

| Node Name | Host | Shards | CPU Load | Heap Used |

|---|---|---|---|---|

| node-1 | 192.168.1.10 | 12 | 65% | 72% |

| node-2 | 192.168.1.11 | 8 | 40% | 50% |

| node-3 | 192.168.1.12 | 5 | 30% | 45% |

结合右侧“Shard Distribution”图表,可直观看出某些节点承担了过多分片(如 node-1),形成性能瓶颈。

pie

title 分片分布比例

“node-1” : 12

“node-2” : 8

“node-3” : 5

理想状态下,分片应在集群内均匀分布。若出现明显偏差,可能原因包括:

- 初始分片数太少(如仅设 1 个主分片),无法跨节点分散;

- 某些节点 recently rejoined,尚未完成 rebalancing;

- 启用了 shard allocation filtering 策略限制分布。

4.3.2 不均衡分布引发的性能瓶颈预警

不均等的分片分布会导致以下问题:

- 查询延迟升高 :热点节点承受更高并发请求;

- GC 频繁触发 :堆内存压力大,影响服务稳定性;

- 恢复速度变慢 :故障节点重启后需从少数节点复制大量数据。

可通过以下命令查看详细分片分布:

GET /_cat/shards?v&h=index,shard,prirep,state,ip,node

响应示例:

index shard prirep state ip node

my_logs_2025 0 p STARTED 192.168.1.10 node-1

my_logs_2025 0 r STARTED 192.168.1.11 node-2

my_logs_2025 1 p STARTED 192.168.1.10 node-1

my_logs_2025 1 r STARTED 192.168.1.12 node-3

观察可知,node-1 承担了两个主分片,而 node-3 仅有一个主分片和一个副本,负载明显不均。

解决方案包括:

- 增加主分片数(需重建索引);

- 调整集群级分片分配权重:

PUT /_cluster/settings

{

"transient": {

"cluster.routing.allocation.balance.shard": 1.0,

"cluster.routing.allocation.balance.index": 0.5

}

}

上述配置鼓励更积极的 rebalance 行为,有助于缓解长期积累的分布失衡。

4.4 索引设置修改与重载

虽然部分设置不可变,但 Elasticsearch 支持动态更新某些运行时参数,Head 对此提供了友好支持。

4.4.1 动态更新副本数实现负载调整

副本数可随时增减,常用于应对流量高峰或节省存储成本。

PUT /my_logs_2025/_settings

{

"index.number_of_replicas": 3

}

参数说明:

- 目标索引:

my_logs_2025 - 新增副本至 3 个,提高读取冗余与高可用性;

- 操作立即生效,无需重启节点。

Head 在“Any Request”面板中允许直接粘贴此类 DSL 查询,执行后可通过“Refresh”按钮查看副本状态变化。新的副本将在符合条件的节点上自动创建并同步数据。

4.4.2 关闭/打开索引的操作流程与用途场景

关闭索引是一种轻量级“冻结”操作,释放内存资源但仍保留磁盘数据。

POST /my_old_index/_close

关闭后,该索引不再参与搜索或写入,也不消耗 JVM 堆内存。适用于:

- 存档历史数据;

- 临时隔离异常索引以便调试;

- 减少恢复时间(closed indices 不参与 recovery)。

重新启用:

POST /my_old_index/_open

注意:关闭期间仍占用磁盘空间,且无法执行 CRUD 操作。

Head 虽未提供专用 UI 按钮,但可通过“Any Request”功能手动发送 _close 和 _open 请求,灵活控制索引状态。

综上所述,Elasticsearch-Head 在索引管理方面不仅提供了基础的增删改查能力,更通过可视化手段揭示了底层架构的运行状态,成为连接开发与运维的重要桥梁。

5. 文档增删改查(CRUD)操作实战

在 Elasticsearch 的数据管理中,文档是存储与检索的基本单元。每个文档以 JSON 格式表示,属于某个索引,并由唯一 _id 进行标识。Elasticsearch-Head 作为一款轻量级图形化工具,极大简化了对文档的增删改查(CRUD)操作流程,使得开发者无需依赖命令行或 Postman 等外部工具即可完成完整的数据交互验证。本章将系统性地讲解如何通过 Head 插件执行各类文档操作,深入剖析其底层 HTTP 请求机制、参数语义及潜在陷阱,并结合实际场景演示高效的数据管理策略。

5.1 文档创建:插入新记录与自动生成ID机制

5.1.1 图形界面操作流程详解

在 Elasticsearch-Head 中,创建文档的操作路径直观明了。用户进入主界面后,在左侧导航栏选择目标索引(如 test_index ),点击右侧“Data”标签页,随后在输入区域填写 JSON 格式的文档内容。例如:

{

"title": "Elasticsearch入门指南",

"author": "张伟",

"publish_date": "2025-04-01",

"views": 1500,

"tags": ["elasticsearch", "search", "bigdata"]

}

填写完毕后,点击下方 “+ Add” 按钮,系统会弹出一个对话框要求输入 _index 、 _type (若使用旧版本 ES)、以及可选的 _id 。如果留空 _id ,Elasticsearch 将自动为其生成一个唯一的字符串 ID,如 AW3fGh2aBxRzT1lKpQoA 。

该过程对应的 RESTful 请求为:

PUT /test_index/_doc/<generated_id>

Content-Type: application/json

{

"title": "Elasticsearch入门指南",

...

}

注意:从 Elasticsearch 7.x 开始,默认类型为

_doc,且不再支持多类型;8.x 版本已彻底移除_type概念。

参数说明:

-

_index:目标索引名称,必须存在或允许自动创建。 -

_id(可选):用户指定的文档唯一标识符。若省略,则由系统自动生成。 - 请求体 :合法的 JSON 对象,字段需符合当前索引的 mapping 定义(除非开启 dynamic mapping)。

5.1.2 自动生成ID的实现原理与性能影响

当用户不提供 _id 时,Elasticsearch 使用基于 UUID 的算法结合时间戳和节点信息生成全局唯一 ID。这一机制确保了分布式环境下不会发生冲突。但值得注意的是,使用自动生成 ID 可能带来轻微的性能开销,因为每次插入都需要额外计算和校验。

相比之下,手动指定有意义的 ID(如业务主键:订单号、用户ID等)有助于提升后续查询效率,并便于与其他系统集成。然而,这也增加了重复写入的风险——若两次使用相同 _id 调用 PUT 请求,后者将覆盖前者(即“upsert”行为)。

| ID 类型 | 是否推荐 | 优点 | 缺点 |

|---|---|---|---|

| 自动生成 | ✅ 初学者友好 | 避免冲突,简单易用 | 查询不便,无业务含义 |

| 手动指定 | ✅ 生产环境常用 | 易于关联业务,提高读取效率 | 需防重机制,设计复杂 |

5.1.3 请求捕获与网络调试技巧

可通过 Chrome 开发者工具中的 Network 面板监控 Head 发出的实际请求。典型响应如下:

{

"_index": "test_index",

"_type": "_doc",

"_id": "AW3fGh2aBxRzT1lKpQoA",

"_version": 1,

"result": "created",

"shards": {

"total": 2,

"successful": 1,

"failed": 0

},

"_seq_no": 0,

"_primary_term": 1

}

关键字段解释:

- _version :文档版本号,每次更新递增;

- result :操作结果,值为 created 表示新建成功;

- shards.successful :表示有多少副本分片成功写入,达到法定数量才返回成功;

- _seq_no 和 _primary_term :用于并发控制与一致性保障。

sequenceDiagram

participant User as 用户界面(Head)

participant ES as Elasticsearch节点

User->>ES: PUT /index/_doc?refresh=true

ES-->>User: 返回201 Created + 自动生成_id

Note right of ES: 写入主分片 → 同步到副本

User->>User: 页面刷新显示新增文档

此流程图清晰展示了文档创建过程中客户端与服务端之间的交互顺序,包括主分片写入、副本同步及最终确认反馈。

5.2 文档读取:精准查询与高亮展示

5.2.1 基于 _id 的单文档获取

最高效的文档读取方式是通过 _id 直接定位。在 Head 工具中,可在 “Any Request” 输入框执行如下请求:

GET /test_index/_doc/AW3fGh2aBxRzT1lKpQoA

返回结果包含原始 JSON 数据及元信息:

{

"_index": "test_index",

"_type": "_doc",

"_id": "AW3fGh2aBxRzT1lKpQoA",

"_version": 1,

"_seq_no": 0,

"_primary_term": 1,

"found": true,

"_source": {

"title": "Elasticsearch入门指南",

"author": "张伟",

"publish_date": "2025-04-01",

"views": 1500,

"tags": ["elasticsearch", "search", "bigdata"]

}

}

其中 _source 字段即为原始文档内容。若文档不存在, found 为 false ,状态码为 404 Not Found 。

5.2.2 批量读取(mget)模拟实现

虽然 Head 未直接提供 mget 图形按钮,但可通过发送自定义请求实现批量获取:

POST /_mget

Content-Type: application/json

{

"docs": [

{

"_index": "test_index",

"_id": "AW3fGh2aBxRzT1lKpQoA"

},

{

"_index": "logs-2025",

"_id": "1001"

}

]

}

响应结构为数组形式,每项对应一个文档的结果:

"docs": [

{ "found": true, "_source": { ... } },

{ "found": false, ... }

]

这种方式适用于需要同时加载多个索引中特定文档的运维场景,如数据迁移验证、跨索引比对等。

5.2.3 性能优化建议:避免 _source 加载过大文档

对于超大文档(如日志全文、Base64 图片),频繁读取 _source 可能造成带宽浪费和页面卡顿。可通过 _source_includes 或 _source_excludes 控制返回字段:

GET /test_index/_doc/AW3fGh2aBxRzT1lKpQoA?_source_includes=title,author

仅返回 title 和 author 字段,显著降低传输体积。

5.3 文档更新:局部修改与乐观锁机制

5.3.1 局部更新(Update API)语法与实践

Elasticsearch 支持部分字段更新,避免整文档重写。在 Head 中可构造如下请求:

POST /test_index/_update/AW3fGh2aBxRzT1lKpQoA

Content-Type: application/json

{

"doc": {

"views": 1800,

"last_updated": "2025-04-05T10:00:00Z"

}

}

该请求仅修改 views 和新增 last_updated 字段,其余内容保持不变。内部机制为:先获取原文档 → 合并更改 → 重新索引(reindex)。

响应示例:

{

"_index": "test_index",

"_type": "_doc",

"_id": "AW3fGh2aBxRzT1lKpQoA",

"_version": 2,

"result": "updated",

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

}

}

注意 _version 已升至 2。

5.3.2 脚本化更新(Scripted Update)进阶应用

更复杂的逻辑可通过 Painless 脚本实现。例如将 views 自增 100:

POST /test_index/_update/AW3fGh2aBxRzT1lKpQoA

Content-Type: application/json

{

"script": {

"source": "ctx._source.views += params.inc",

"params": {

"inc": 100

}

}

}

ctx._source 表示当前文档源数据, params 提供外部参数注入,增强灵活性。

5.3.3 乐观并发控制(Optimistic Locking)防止脏写

Elasticsearch 使用 _version 和 if_seq_no / if_primary_term 实现乐观锁。假设两个客户端同时尝试更新同一文档,系统将拒绝第二个请求(若其携带的版本过期):

PUT /test_index/_doc/AW3fGh2aBxRzT1lKpQoA?if_seq_no=0&if_primary_term=1

Content-Type: application/json

{ "views": 2000 }

如果此时文档已被其他操作修改, _seq_no 不再为 0,则本次请求失败并返回 409 Conflict 。这有效防止了并发写入导致的数据覆盖问题。

5.4 文档删除:安全清除与批量清理策略

5.4.1 单文档删除操作与不可逆风险

删除操作极为简单:

DELETE /test_index/_doc/AW3fGh2aBxRzT1lKpQoA

成功响应:

{

"_index": "test_index",

"_type": "_doc",

"_id": "AW3fGh2aBxRzT1lKpQoA",

"_version": 3,

"result": "deleted",

"_shards": {

"total": 2,

"successful": 1,

"failed": 0

}

}

但需强调: 删除操作不可撤销 。一旦提交,文档即从倒排索引中移除,仅能在下一次段合并前通过 _recover 接口尝试恢复(极难实现)。因此,在生产环境中应启用审计日志并限制删除权限。

5.4.2 批量删除(Delete By Query)模拟实现

尽管 Head 不支持图形化批量删除,但可通过 _delete_by_query API 实现:

POST /test_index/_delete_by_query

Content-Type: application/json

{

"query": {

"match": {

"author": "张伟"

}

}

}

此请求将删除所有作者为“张伟”的文档。响应中包含处理统计:

{

"took": 45,

"timed_out": false,

"total": 3,

"deleted": 3,

"batches": 1,

"version_conflicts": 0

}

建议在执行前先用 Search API 验证匹配范围,避免误删。

5.4.3 删除后的资源释放机制

删除操作并不会立即释放磁盘空间。被标记为“已删除”的文档仍存在于 segment 中,直到下一次 merge 操作才会物理清除。可通过强制合并优化空间:

POST /test_index/_forcemerge?max_num_segments=1

但此操作代价高昂,应谨慎在低峰期执行。

5.5 批量操作(Bulk API)模拟与性能调优

5.5.1 Bulk 请求格式解析与构造

Bulk API 是高频数据处理的核心手段。虽然 Head 无专用界面,但可通过 “Any Request” 手动构造:

POST /_bulk

Content-Type: application/x-ndjson

{"index":{"_index":"blog","_id":"1"}}

{"title":"第一篇博客","date":"2025-01-01"}

{"update":{"_index":"blog","_id":"2"}}

{"doc":{"status":"published"}}

{"delete":{"_index":"temp","_id":"tmp001"}}

每行必须独立且以 \n 结尾(NDJSON 格式)。支持混合操作类型。

5.5.2 响应分析与错误排查

成功响应为逐条结果列表:

{

"items": [

{

"index": {

"_index": "blog",

"_id": "1",

"status": 201,

"result": "created"

}

},

{

"update": {

"status": 404,

"error": {

"type": "document_missing_exception"

}

}

}

],

"errors": true

}

即使整体响应为 200 OK,也可能存在部分失败项。务必检查 "errors": true 并逐条排查。

5.5.3 批量操作最佳实践表格

| 项目 | 推荐做法 | 原因说明 |

|---|---|---|

| 批次大小 | 5MB~15MB | 避免内存溢出与超时 |

| 并发数 | 2~8 个线程 | 充分利用 I/O,避免竞争 |

| 错误重试 | 指数退避 + 限流 | 应对临时故障 |

| Refresh 策略 | 批次结束后显式 refresh | 减少索引开销 |

通过合理配置,Bulk 操作吞吐量可提升 5~10 倍以上,是数据导入阶段不可或缺的技术手段。

graph TD

A[准备JSON数据] --> B{是否批量?}

B -- 是 --> C[组装NDJSON格式]

B -- 否 --> D[单条PUT/POST]

C --> E[发送_bulk请求]

D --> F[等待响应]

E --> G[解析items数组]

G --> H{是否有失败项?}

H -- 是 --> I[记录错误并重试]

H -- 否 --> J[完成]

I --> J

该流程图完整呈现了批量操作的决策路径与异常处理闭环,适用于自动化脚本开发参考。

6. 可视化查询构建器与搜索语句调试

Elasticsearch-Head 作为一款轻量级但功能强大的前端调试工具,其核心价值之一在于为开发者提供直观、低门槛的查询构建与调试能力。在实际开发中,无论是验证索引数据的存在性、测试复杂布尔逻辑的匹配效果,还是优化全文检索性能,都离不开对查询语句的反复调整和快速反馈。本章将深入剖析 Elasticsearch-Head 中“查询”模块的设计机制,重点围绕可视化查询输入区的功能实现、复杂 DSL 查询的构造方法、结果展示逻辑以及错误调试策略展开系统性讲解。通过结合具体操作流程、底层 HTTP 请求解析及代码示例,帮助读者掌握如何高效利用该工具完成从简单关键字搜索到多条件嵌套聚合查询的全流程调试。

6.1 查询语法输入区功能详解

Elasticsearch-Head 的查询界面设计简洁明了,位于主页面顶部的“Query”标签页下,提供了一个自由文本输入框(通常标记为“Query Bar”),允许用户直接编写 Elasticsearch Domain Specific Language(DSL)或使用 Query String 进行快速检索。这一区域不仅是执行搜索的核心入口,更是理解 ES 搜索机制的重要实验场。

6.1.1 支持 Query String 查询的语法格式与示例

Query String 是一种基于 URI 参数传递的简易查询方式,适用于快速查找包含特定关键词的文档。它无需编写完整的 JSON 结构化请求体,适合初学者或临时排查场景。

其基本语法结构如下:

?q=field:value AND other_field:value*

其中:

- q 表示查询字符串参数;

- 支持布尔操作符: AND , OR , NOT ;

- 支持通配符: * (任意字符)、 ? (单个字符);

- 支持字段前缀限定,如 title:elasticsearch ;

- 支持范围查询: [2020 TO 2023] 或 {100 TO *} ;

- 默认作用于所有可搜索字段(multi_match 行为)。

示例:

GET /my_index/_search?q=status:active AND name:E*

该请求会检索 my_index 索引中 status 字段等于 active 且 name 字段以 E 开头的所有文档。

在 Elasticsearch-Head 中,只需在查询输入框中键入:

status:active AND name:E*

并选择目标索引后点击“Search”,即可看到返回结果。

✅ 实际操作步骤:

- 打开 Elasticsearch-Head 插件界面;

- 在左侧导航栏选择目标索引(如

logs-2024); - 切换至 “Query” 标签页;

- 在输入框中填写 Query String 表达式;

- 点击 “Search” 按钮;

- 观察右侧返回的 JSON 响应内容与命中文档列表。

此时,Head 工具会自动构造如下等效 REST 请求:

GET http://localhost:9200/logs-2024/_search?q=status:active%20AND%20name:E*

⚠️ 注意:特殊字符需 URL 编码,例如空格变为

%20,*虽保留但部分版本可能限制其使用。

| 特性 | 说明 |

|---|---|

| 易用性 | 非常适合快速筛选和原型验证 |

| 性能影响 | 因隐式 multi_match 可能扫描多个字段,性能较低 |

| 安全风险 | 若未设置字段白名单,易受注入攻击 |

| 适用场景 | 开发阶段调试、日志排查 |

Mermaid 流程图:Query String 请求处理流程

graph TD

A[用户输入 Query String] --> B{是否指定索引?}

B -->|是| C[构造 GET /index/_search?q=...]

B -->|否| D[构造 GET /_search?q=... 全局搜索]

C --> E[Elasticsearch 解析 q 参数]

E --> F[转换为内部 QueryParser 树]

F --> G[执行倒排索引匹配]

G --> H[返回 hits 和元信息]

H --> I[Head 渲染结果表格]

此流程展示了从用户输入到最终结果呈现的完整链路,体现了 Head 工具如何封装底层通信细节,仅暴露最简接口供交互。

6.1.2 URI 参数传递与请求方法自动识别

Elasticsearch-Head 并非仅仅发送裸查询字符串,而是智能地根据上下文判断应使用的 HTTP 方法与 URI 路径。这背后依赖于对 Elasticsearch REST API 协议的精准建模。

当用户在查询输入框中输入内容时,Head 会进行以下判断:

-

是否存在 JSON 对象语法?

- 如果输入以{开头,则视为 DSL 查询,使用POST方法发送请求体;

- 否则视为 Query String,使用GET方法附加q参数。 -

是否选择了具体索引?

- 是 → 请求路径为/selected_index/_search

- 否 → 请求路径为/_search(跨索引搜索) -

是否启用高级选项(如 from/size)?

- 用户可通过界面设置分页参数,这些将作为额外 URI 参数追加。

示例代码块:Head 内部请求生成逻辑(模拟 JavaScript 实现)

function buildSearchRequest(indexName, queryString, advancedOptions = {}) {

const baseUrl = 'http://localhost:9200';

let url, method, body;

// 判断是否为 JSON DSL 查询

if (queryString.trim().startsWith('{')) {

method = 'POST';

url = `${baseUrl}/${indexName || '_all'}/_search`;

try {

body = JSON.parse(queryString); // 解析为对象用于发送

} catch (e) {

throw new Error('Invalid JSON in query body');

}

} else {

method = 'GET';

const params = new URLSearchParams();

params.append('q', queryString);

if (advancedOptions.from !== undefined) params.append('from', advancedOptions.from);

if (advancedOptions.size !== undefined) params.append('size', advancedOptions.size);

if (advancedOptions.explain) params.append('explain', true);

url = `${baseUrl}/${indexName || '_all'}/_search?${params.toString()}`;

body = null;

}

return { url, method, body };

}

🔍 逐行逻辑分析与参数说明:

| 行号 | 说明 |

|---|---|

| 1–5 | 函数接收三个参数:索引名、查询字符串、高级选项对象 |

| 7–14 | 检查输入是否为 JSON 格式,决定使用 POST + 请求体模式 |

| 15–20 | 若非 JSON,则采用 GET 方法,并通过 URLSearchParams 构造查询参数 |

| 22–26 | 将 from , size , explain 等常见分页与调试参数加入 URL |

| 28–30 | 返回标准化请求配置对象,供后续 fetch/fetch-like 调用 |

💡 提示:这种“语法嗅探”机制虽然方便,但也可能导致误判。建议在复杂查询时显式使用 JSON 格式以确保语义正确。

此外,Head 还会在控制台输出实际发出的请求信息(部分版本支持),便于开发者复制粘贴至 curl 或 Postman 中复现问题。

表格:不同输入类型对应的请求特征对比

| 输入形式 | HTTP 方法 | Content-Type | 请求体 | 典型用途 |

|---|---|---|---|---|

title:Elasticsearch | GET | - | null | 快速关键字搜索 |

{ "match": { "title": "ES" } } | POST | application/json | JSON 对象 | 精确 DSL 控制 |

status:published + size=50 | GET | - | null | 分页浏览结果 |

{ "query": { "bool": {...} } } | POST | application/json | 复杂嵌套结构 | 多条件组合查询 |

该机制使得 Elasticsearch-Head 在保持轻量化的同时,仍能兼容绝大多数标准查询需求,成为连接人类思维与机器协议的桥梁。

6.2 复杂查询语句构造实践

尽管 Query String 适合快速检索,但在真实业务场景中,往往需要更精细的控制能力——例如多字段布尔组合、嵌套条件、评分权重调节等。这就必须借助 Elasticsearch 的完整 DSL(Domain Specific Language)语法。Elasticsearch-Head 允许用户直接输入 JSON 格式的查询体,从而实现对复杂查询的可视化调试。

6.2.1 构建布尔查询(bool query):must、should、must_not 条件组合

布尔查询( bool query)是 Elasticsearch 中最常用的复合查询类型,它允许将多个子查询组合成一个逻辑表达式,支持四种子句类型:

-

must: 所有子句必须匹配,贡献相关性得分; -

filter: 必须匹配,但不计算得分(可用于缓存); -

should: 至少满足其中一个(可设置minimum_should_match); -

must_not: 必须不匹配,也不参与打分。

示例:构建一个多条件订单查询

假设有一个 orders 索引,存储电商订单数据,字段包括:

- status : 订单状态(如 “paid”, “shipped”)

- customer_age : 客户年龄

- product_category : 商品类别

- amount : 订单金额

需求:查找“已支付且未发货”的高价值订单,客户年龄在 25–40 岁之间,属于电子产品类目。

{

"query": {

"bool": {

"must": [

{ "term": { "status": "paid" } },

{ "range": { "amount": { "gte": 1000 } } }

],

"must_not": [

{ "term": { "status": "shipped" } }

],

"filter": [

{ "range": { "customer_age": { "gte": 25, "lte": 40 } } },

{ "term": { "product_category": "electronics" } }

]

}

},

"size": 20

}

🛠 操作步骤(在 Head 中执行):

- 在 Elasticsearch-Head 的“Query”输入框中粘贴上述 JSON;

- 确保左侧已选中

orders索引; - 点击 “Search”;

- 查看返回的 20 条命中记录及其

_score是否一致(因 filter 不影响 score);

🔎 代码逻辑逐行解读:

| 行 | 解释 |

|---|---|

| 2–3 | 定义顶层 query 类型为 bool |

| 4–7 | must 数组要求 status 为 paid 且金额 ≥1000,两者均影响评分 |

| 8–10 | must_not 排除已发货订单 |

| 11–15 | filter 使用 range 和 term 进行结构化过滤,可被 Lucene 缓存提升性能 |

| 16 | 设置返回最大条数为 20,避免响应过大 |

⚠️ 注意:若

must和filter同时存在,推荐将不变条件放入filter以提升查询效率。

Mermaid 图:Bool Query 内部执行流程

graph LR

A[收到 Bool Query] --> B{解析 must 子句}

B --> C[执行 match 查询并累加 _score]

A --> D{解析 filter 子句}

D --> E[应用 BitSet 过滤文档集]

A --> F{解析 must_not 子句}

F --> G[排除符合条件的文档]

A --> H{解析 should 子句}

H --> I[检查 minimum_should_match]

C --> J[合并候选文档]

E --> J

G --> J

I --> J

J --> K[排序并返回 top N]

该图揭示了 Elasticsearch 如何分阶段处理布尔查询:先通过 filter 和 must_not 快速缩小候选集,再对剩余文档计算相关性得分,从而兼顾性能与精度。

6.2.2 范围查询(range)、通配符(wildcard)与正则匹配应用

除了精确匹配,模糊与区间查询在日志分析、时间序列处理中极为常见。Elasticsearch-Head 支持这些高级查询类型的直接输入。

① 范围查询(range)

适用于数值、日期、地理距离等有序字段。

{

"query": {

"range": {

"timestamp": {

"gte": "2024-01-01T00:00:00Z",

"lt": "2024-02-01T00:00:00Z"

}

}

}

}

⚠️ 时间字段需为

date类型且格式正确,否则无法匹配。

② 通配符查询(wildcard)

用于模糊匹配字段值,支持 * 和 ? 。

{

"query": {

"wildcard": {

"email.keyword": "*@gmail.com"

}

}

}

❗ 性能较差,建议避免在高基数字段上频繁使用。

③ 正则表达式查询(regexp)

支持 PCRE 风格的正则语法。

{

"query": {

"regexp": {

"path.exact": "(/user/\\d+/profile)"

}

}

}

⚠️ 极其消耗资源,生产环境慎用!

表格:模糊查询类型对比

| 查询类型 | 是否可缓存 | 是否影响评分 | 适用字段类型 | 性能等级 |

|---|---|---|---|---|

| term | 是 | 是 | keyword, numeric | ⭐⭐⭐⭐⭐ |

| match | 是 | 是 | text | ⭐⭐⭐⭐☆ |

| range | 是 | 否(若在 filter 中) | date, number | ⭐⭐⭐⭐☆ |

| wildcard | 否 | 是 | keyword | ⭐⭐☆☆☆ |

| regexp | 否 | 是 | keyword | ⭐☆☆☆☆ |

建议优先使用 term + keyword 组合替代 wildcard ,并通过索引设计规避低效查询。

6.3 搜索结果展示与性能反馈

Elasticsearch-Head 不仅执行查询,还承担着结果可视化与性能洞察的任务。了解其结果渲染机制有助于更高效地解读数据。

6.3.1 返回文档列表的字段提取与高亮显示

当查询成功执行后,Head 会解析返回的 JSON 响应,并以表格形式展示命中文档的关键字段。

典型响应结构如下:

{

"took": 34,

"timed_out": false,

"_shards": { "total": 5, "successful": 5, "failed": 0 },

"hits": {

"total": { "value": 128, "relation": "eq" },

"max_score": 1.876,

"hits": [

{

"_index": "users",

"_id": "101",

"_score": 1.876,

"_source": {

"name": "Alice",

"email": "alice@example.com",

"age": 30

}

}

]

}

}

Head 会从中提取:

- _source 中的字段值填充表格;

- _id , _index , _score 作为元数据列显示;

- 若启用高亮(需手动添加 "highlight" 子句),则标记匹配词。

示例:启用高亮

{

"query": {

"match": { "bio": "developer" }

},

"highlight": {

"fields": {

"bio": {}

}

}

}

返回结果中将新增 highlight 字段:

"highlight": {

"bio": [

"I am a software <em>developer</em> with 5 years of experience."

]

}

Head 会将 <em> 标签渲染为黄色背景文字,直观标识匹配位置。

6.3.2 查询耗时、命中总数等元数据解读

Head 界面底部通常显示关键性能指标:

- Took : 整个查询耗时(毫秒),反映服务端处理速度;

- Hits Total : 匹配文档总数(注意

relation: "gte"表示估值); - Shards Info : 分片成功/失败数量,用于判断节点健康;

- Max Score : 最高相关性得分,辅助评估查询质量。

📈 建议:若

took > 500ms或shards.failed > 0,应及时排查慢查询或节点异常。

6.4 错误响应调试与语法校验

即使经验丰富的开发者也常因 DSL 语法错误导致查询失败。Elasticsearch-Head 提供即时错误提示,极大加速调试过程。

6.4.1 常见 DSL 语法错误类型与修复建议

| 错误现象 | 可能原因 | 修复方案 |

|---|---|---|

Parse Failure | JSON 格式错误或字段拼写错误 | 使用在线 JSON 校验工具检查 |

Unknown Token | 使用了非法关键字(如 mustt ) | 检查 bool 子句拼写 |

Failed to parse query | range 值类型不匹配(如字符串 vs 数字) | 确保字段映射一致 |

No mapping found | 查询字段未定义或 analyzer 不支持 | 检查索引 mapping |

示例错误响应:

{

"error": {

"root_cause": [

{

"type": "parsing_exception",

"reason": "unknown token [mustt] after [bool]",

"line": 5,

"col": 10

}

]

}

}

Head 会红色高亮显示错误信息,并指出大致出错位置。

6.4.2 利用 Head 工具快速迭代优化查询表达式

推荐采用“小步快跑”策略:

- 从简单

match_all开始:

json { "query": { "match_all": {} } } - 逐步添加过滤条件;

- 每次修改后观察

took和hits.total变化; - 利用

profileAPI(需手动添加)分析各子查询耗时。

{

"profile": true,

"query": { ... }

}

返回中将包含详细的分阶段执行时间,帮助定位瓶颈。

综上所述,Elasticsearch-Head 的查询构建器虽无图形拖拽界面,但凭借对原生 DSL 的完全支持与实时反馈机制,已成为开发者不可或缺的调试利器。合理运用其功能,不仅能提升开发效率,更能加深对 Elasticsearch 查询引擎运作原理的理解。

7. 聚合分析功能应用与结果展示

7.1 聚合查询基础概念与DSL结构解析

Elasticsearch的聚合功能建立在查询DSL(Domain Specific Language)之上,允许用户对数据集执行复杂的统计和分组操作。聚合分为三大类: 指标聚合(Metric Aggregations) 、 桶聚合(Bucket Aggregations) 和 管道聚合(Pipeline Aggregations) 。其中前两类在 Elasticsearch-Head 中可通过手动编写 JSON 查询体直接支持。

一个典型的聚合请求结构如下所示:

{

"size": 0,

"aggs": {

"avg_price": {

"avg": {

"field": "price"

}

},

"group_by_category": {

"terms": {

"field": "category.keyword",

"size": 10

},

"aggs": {

"max_price": {

"max": {

"field": "price"

}

}

}

}

}

}

参数说明:

-"size": 0表示不返回原始文档,仅获取聚合结果。

-"aggs"是聚合根节点,可嵌套多层实现复杂分析。

-"avg_price"是自定义聚合名称,用于标识返回结果中的字段。

-"terms"按指定字段值进行分组,常用于分类统计。

- 嵌套聚合max_price在每个 category 分组内计算最大价格。

该查询将先计算整体平均价格,并按商品类别分组,每组中再求出最高价。

7.2 使用Elasticsearch-Head构造聚合查询

在 Elasticsearch-Head 的“复合查询”或“查询”标签页中,选择请求方式为 POST ,目标路径填写 /index_name/_search ,然后在请求体区域输入上述格式的 JSON 内容。

操作步骤:

- 打开 Elasticsearch-Head 界面

- 在 URL 栏输入:

http://localhost:9200/products/_search - 切换请求方法为

POST - 在请求体中粘贴以下完整示例:

{

"size": 0,

"query": {

"range": {

"timestamp": {

"gte": "now-7d/d",

"lt": "now/d"

}

}

},

"aggs": {

"daily_count": {

"date_histogram": {

"field": "timestamp",

"calendar_interval": "day",

"time_zone": "+08:00"

},

"aggs": {

"unique_users": {

"cardinality": {

"field": "user_id.keyword"

}

},

"avg_duration": {

"avg": {

"field": "session_duration"

}

}

}

}

}

}

- 点击“执行”按钮发送请求

此查询实现了:

- 过滤最近7天的日志记录

- 按天进行时间分桶( date_histogram )

- 统计每日独立访客数(去重 user_id )

- 计算每日平均会话时长

7.3 聚合结果可视化展示与表格化输出

执行成功后,Elasticsearch-Head 将以树形结构展示返回的 JSON 响应。以下是模拟响应的一部分:

| key_as_string | doc_count | unique_users.value | avg_duration.value |

|---|---|---|---|

| 2025-03-20 | 1423 | 897 | 184.3 |

| 2025-03-21 | 1655 | 962 | 201.7 |

| 2025-03-22 | 1876 | 1033 | 223.1 |

| 2025-03-23 | 2001 | 1156 | 245.8 |

| 2025-03-24 | 1944 | 1102 | 231.5 |

| 2025-03-25 | 1768 | 988 | 210.9 |

| 2025-03-26 | 1692 | 951 | 197.4 |

| 2025-03-27 | 1530 | 876 | 188.2 |

注:上表为从 Head 工具响应中提取并整理的结果,便于业务人员阅读。

为了更清晰地理解数据分布,可以使用 mermaid 流程图描述聚合逻辑流:

graph TD

A[原始数据] --> B{是否满足<br>时间范围条件?}

B -->|是| C[进入 daily_count 桶]

C --> D[按日期分组]

D --> E[计算每日文档数量]

D --> F[嵌套聚合: unique_users]

D --> G[嵌套聚合: avg_duration]

F --> H[使用 HyperLogLog+ 算法估算去重数]

G --> I[计算字段均值]

H --> J[输出每日UV]

I --> K[输出平均停留时长]

J --> L[前端表格展示]

K --> L

7.4 高阶聚合应用场景与性能调优建议

场景一:多维度交叉分析(Terms + Terms)

"aggs": {

"by_region": {

"terms": { "field": "region.keyword", "size": 5 },

"aggs": {

"by_status": {

"terms": { "field": "status.keyword", "size": 3 },

"aggs": {

"revenue": { "sum": { "field": "amount" } }

}

}

}

}

}

可用于生成区域-状态维度的营收矩阵报表。

性能优化关键点:

| 参数名 | 推荐设置 | 作用说明 |

|---|---|---|

size | 控制顶层桶数量 | 防止返回过多分组导致OOM |

shard_size | size × 1.5 ~ 2倍 | 提升分布式精度 |

collect_mode | depth_first / breadth_first | 控制内存使用模式 |

precision_threshold | cardinality 聚合中设为100~3000 | 平衡准确率与内存消耗 |

此外,在大规模数据集上执行聚合时,建议结合 sample 聚合进行预览分析:

"aggs": {

"sample_data": {

"sampler": {

"shard_size": 1000

},

"aggs": {

"top_keywords": {

"terms": { "field": "keywords.keyword", "size": 10 }

}

}

}

}

这能显著降低计算开销,适用于探索性数据分析阶段。

通过 Elasticsearch-Head 的即时反馈机制,开发者可以在不断调整 DSL 结构的过程中快速验证语法正确性和性能表现,形成高效的数据洞察闭环。

简介:Elasticsearch-Head是一款基于Chrome浏览器的轻量级可视化插件,为ES集群提供直观的图形化管理界面。该工具支持集群状态监控、索引管理、文档操作、搜索聚合及性能分析等功能,极大简化了开发者和运维人员对Elasticsearch的操作流程。本文详细介绍ES-Head的安装配置方法、核心功能特性及实用技巧,帮助用户高效掌握其在实际场景中的应用,提升ES日常维护与调试效率。

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?