简介:Hadoop-eclipse插件为Java开发者提供了一个方便的工具,用于在Eclipse IDE中直接开发Hadoop MapReduce项目,无需离开Eclipse环境。通过几个简单的步骤,用户可以下载、安装插件,配置Hadoop连接,并开始创建和运行MapReduce程序。此插件简化了Hadoop开发流程,提高了工作效率,并支持调试和任务监控功能。尽管现代开发趋势可能转向更高效的计算框架,Hadoop-eclipse插件对于理解Hadoop MapReduce的基础仍有其价值。

1. Hadoop-eclipse插件概述

在大数据技术的发展历程中,Hadoop作为开源框架的先驱,已经成为了处理大规模数据集的标准技术之一。Hadoop-eclipse插件的出现,则进一步便捷了开发者在Eclipse集成开发环境(IDE)中与Hadoop集群的交互,极大地提高了开发效率和便捷性。本章将探讨Hadoop-eclipse插件的基本功能、使用场景以及它如何帮助开发者更好地管理与优化Hadoop集群中的数据处理任务。

Hadoop-eclipse插件的主要优势在于它提供了一种图形界面,使得用户可以在Eclipse中直观地浏览和管理HDFS文件系统、提交MapReduce作业以及监控任务执行状态等。它不仅让对Hadoop集群的操作变得更加简单,而且也降低了新手入门的门槛,让经验丰富的开发者能够专注于复杂的业务逻辑开发而不是集群的配置和管理。

随着大数据技术的演进,Hadoop-eclipse插件也在不断地进行更新和优化,以适应新的Hadoop版本以及用户的多样化需求。下一章节我们将详细探讨如何搭建Hadoop开发环境,为使用Hadoop-eclipse插件做好准备工作。

2. Eclipse开发环境搭建

在本章节中,我们将探讨如何搭建一个适用于Hadoop项目的Eclipse开发环境。Eclipse是一个功能强大的开源集成开发环境(IDE),广泛应用于Java开发中。它支持插件扩展,能够让我们通过安装特定插件来增强其功能。对于Hadoop项目来说,Eclipse不仅提供了编写和调试代码的基础功能,还能通过插件,如Hadoop-eclipse插件,来与Hadoop集群进行交互。本章将详细指导你如何安装和配置Eclipse IDE以及所需插件,为后续的Hadoop开发打下基础。

2.1 Eclipse IDE的安装与配置

2.1.1 官网下载Eclipse IDE

首先,我们需要从Eclipse官方网站下载适合的Eclipse版本。Eclipse提供了多种版本,如Eclipse IDE for Java EE Developers,Eclipse IDE for Java Developers等。对于Hadoop项目而言,推荐下载Eclipse IDE for Java Developers版本,因为它提供了足够的功能来开发Java应用程序,并且体积相对较小。

下载地址: Eclipse官网

在下载页面,选择对应的操作系统版本,并下载最新稳定版的Eclipse IDE。下载完成后,解压到您选择的目录。

2.1.2 安装Java开发工具包(JDK)

为了在Eclipse中进行Java开发,需要安装Java开发工具包(JDK)。Hadoop主要使用Java编写,因此JDK是开发Hadoop应用不可或缺的组件。

可以从Oracle官网或其他JDK提供商下载JDK。推荐安装JDK 8,因为Hadoop 2.7.6和许多相关的库都是基于Java 8来设计的。

安装JDK后,需要在系统环境变量中设置 JAVA_HOME ,并将其添加到系统的 PATH 中。这样,Eclipse才能正确识别Java运行环境。

2.1.3 配置Eclipse中的Java环境

安装好Eclipse和JDK后,启动Eclipse并进行Java环境的配置。

- 打开Eclipse,选择菜单栏的

Window->Preferences。 - 在弹出的Preferences窗口中,选择

Java->Installed JREs。 - 点击“Add”按钮,选择标准JRE,然后浏览到JDK的安装目录,并确认。

- 点击“Apply and Close”保存设置。

此时,Eclipse已经配置好Java环境,可以开始进行Java相关的项目开发了。

2.2 Eclipse插件的扩展机制

2.2.1 插件的作用与安装方法

Eclipse的插件扩展机制是其强大的原因之一。插件可以为Eclipse增加新功能,比如支持特定的编程语言、版本控制、代码分析工具等。Hadoop-eclipse插件正是这样的一个扩展,它提供了对Hadoop集群的可视化管理功能。

插件的安装通常可以通过以下几种方式进行:

- 使用Eclipse的“Install New Software”向导。

- 通过链接下载更新站点的zip文件,然后手动安装。

- 在Eclipse Marketplace中搜索并安装。

对于Hadoop-eclipse插件,我们将在下一小节详细介绍如何下载和安装。

2.2.2 管理Eclipse插件的工具介绍

除了在Eclipse中直接安装插件外,还有其他工具可以帮助我们管理和维护Eclipse插件。

- p2 Director :Eclipse提供的一种基于命令行的插件安装工具。

- Dropins :通过在Eclipse安装目录下创建一个名为“dropins”的文件夹,并将插件的压缩包或解压后的插件文件夹放入其中来自动安装。

- Eclipse Marketplace :一个在线市场,提供图形化界面,可以搜索、安装和更新插件。

通常情况下,直接在Eclipse中使用“Install New Software”是最简单便捷的安装方式。

在本章节中,我们详细讲解了Eclipse IDE的安装和配置过程,包括从官网下载Eclipse、安装Java开发工具包以及配置Eclipse中的Java环境。接下来,我们将关注如何安装和配置Eclipse插件,为Hadoop开发提供更加丰富和高效的开发环境。

3. ```

第三章:Hadoop 2.7.6配置

3.1 Hadoop集群环境的搭建

3.1.1 安装Hadoop 2.7.6

Hadoop 2.7.6是分布式存储与计算的开源框架,广泛用于大数据分析。搭建Hadoop集群环境是进行大数据处理的第一步。首先需要下载Hadoop 2.7.6的安装包。下载可以通过官方网站或者使用包管理器如 yum 或 apt-get 。

以下是在Linux系统中使用命令行进行安装的步骤:

wget https://downloads.apache.org/hadoop/common/hadoop-2.7.6/hadoop-2.7.6.tar.gz

tar -xzvf hadoop-2.7.6.tar.gz

mv hadoop-2.7.6 /usr/local/hadoop

上述代码块展示了如何下载和解压Hadoop安装包,并将其移动到 /usr/local/ 目录下。

3.1.2 配置Hadoop环境变量

在安装Hadoop之后,需要设置环境变量以便在任何目录下使用Hadoop命令。通常,需要编辑用户的 .bashrc 或 .bash_profile 文件。

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

这里定义了 HADOOP_HOME 环境变量指向安装路径,并将Hadoop的二进制文件路径添加到 PATH 变量中,从而可以在命令行直接运行Hadoop。

3.2 Hadoop集群的配置详解

3.2.1 核心配置文件的修改

Hadoop集群配置主要集中在 $HADOOP_HOME/etc/hadoop 目录下的几个核心文件中,包括 core-site.xml 、 hdfs-site.xml 、 mapred-site.xml 和 yarn-site.xml 。

-

core-site.xml:配置Hadoop核心服务,如文件系统的默认类型和I/O设置。 -

hdfs-site.xml:配置HDFS相关参数,包括副本的数量、文件系统的副本因子等。 -

mapred-site.xml:配置MapReduce作业的运行细节,如作业调度器等。 -

yarn-site.xml:配置YARN(Yet Another Resource Negotiator)相关参数,包括资源管理器地址等。

一个简单的 core-site.xml 配置样例如下:

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

这里配置了Hadoop文件系统的默认名称空间为 hdfs://localhost:9000 。

3.2.2 网络设置与优化

网络设置是Hadoop集群性能的关键。在 hdfs-site.xml 中设置集群中数据块的副本数是保证数据可靠性的基础。

<configuration>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

</configuration>

这里将HDFS文件系统的默认副本数设置为3,意味着每个数据块都会在集群中存储三份副本。

网络优化还需要考虑到数据的本地性,以减少数据在网络中的传输。可以通过调整HDFS和YARN的参数来实现,例如设置数据本地化的策略。

<configuration>

<property>

<name>mapreduce.job.local.dir</name>

<value>/path/to/local/directory</value>

</property>

</configuration>

通过指定 mapreduce.job.local.dir 属性,MapReduce作业的输出被写入到本地目录,从而提高了作业的执行效率。

接下来,我们将探讨如何使用Hadoop-eclipse插件进行Hadoop集群的连接配置,并创建和运行MapReduce程序。

# 4. Hadoop-eclipse插件的使用

## 4.1 插件下载与安装

### 4.1.1 从官网获取Hadoop-eclipse插件

首先,访问Eclipse官方网站或者Hadoop的官方插件库,搜索“Hadoop-eclipse-plugin”。通常情况下,你可以找到对应版本的插件及其下载链接。下载完成后,确保你下载的版本与你的Hadoop集群版本以及Eclipse IDE版本相兼容。

### 4.1.2 安装插件到Eclipse

安装插件的步骤通常是这样的:

1. 打开Eclipse IDE。

2. 从菜单栏选择“Help”(帮助)> “Install New Software...”(安装新软件...)。

3. 点击“Add”(添加),选择“Archive...”(存档...)来添加下载的插件压缩文件。

4. 输入一个名称用于标识这个插件仓库,例如“Hadoop Eclipse Plugin”。

5. 点击“OK”,然后等待Eclipse搜索可用的软件。

6. 一旦搜索完成,勾选“Hadoop Map/Reduce Tools”复选框。

7. 点击“Next”(下一步),然后按照提示完成安装。

8. 安装完成后,重启Eclipse IDE以确保插件完全加载。

安装过程中,可能会出现与安全证书相关的问题,特别是如果你是在公司网络环境下进行下载。在这种情况下,需要按照Eclipse的提示导入相应的证书。

在安装后,确认插件已经成功安装是重要的一步。你可以在Eclipse的“Window”(窗口)> “Show View”(显示视图)> “Other...”(其他...)> “Map/Reduce”(映射/减少)中查找Hadoop视图是否可用。

## 4.2 Hadoop连接配置

### 4.2.1 设置Hadoop连接参数

在Eclipse中使用Hadoop-eclipse插件之前,需要正确设置Hadoop连接参数。这包括配置NameNode的主机地址和端口号,以及其他一些HDFS相关的参数。

1. 在Eclipse中,打开“Window”(窗口)> “Preferences”(首选项)。

2. 在左侧导航栏中,展开“Hadoop”(Hadoop)节点。

3. 点击“User”(用户),然后填写你的Hadoop用户名和相关的配置信息。

4. 在“NameNode”(NameNode)部分,输入你的Hadoop集群的NameNode主机地址和端口号。

5. 你可以在这里配置文件系统的URI格式,例如使用`hdfs://<namenode_host>:<namenode_port>`。

6. 点击“Apply and Close”(应用并关闭)保存你的配置。

### 4.2.2 验证Hadoop集群连接

为了确认Eclipse能够成功连接到Hadoop集群,你需要验证HDFS文件系统的连接状态:

1. 在Eclipse的“Package Explorer”(包资源管理器)视图中,右键点击“HDFS Browser”(HDFS浏览器)标签。

2. 选择“Connect to HDFS”(连接到HDFS)。

3. 如果之前配置正确,你应该能够看到HDFS上的目录结构。

4. 如果连接失败,检查你的网络配置,以及Eclipse中设置的参数是否与集群配置一致。

5. 如果问题依然存在,参考Hadoop集群和Eclipse的日志文件,这些文件通常包含有关连接失败的详细信息。

## 4.3 Hadoop-eclipse插件的其他实用功能

### 4.3.1 使用Hadoop-eclipse插件管理HDFS文件

Hadoop-eclipse插件不仅允许你浏览HDFS文件系统,还可以进行文件的上传、下载、创建、删除、重命名等操作。以下是一些基础的操作步骤:

1. **上传文件到HDFS**:在Eclipse的包资源管理器中找到你想要上传的文件,然后右键点击它,选择“HDFS”(HDFS)> “Upload to HDFS...”(上传到HDFS...)。

2. **下载文件或目录**:选中HDFS上的一个或多个文件,右键点击并选择“Download to Local”(下载到本地)。

3. **创建新目录**:在HDFS浏览器中右键点击,选择“New”(新建)> “Directory”(目录),输入目录名称。

4. **重命名文件或目录**:选中文件或目录,然后右键点击选择“Rename”(重命名),输入新的文件名或目录名。

5. **删除文件或目录**:选中文件或目录,右键点击选择“Delete”(删除),确认删除操作。

### 4.3.2 MapReduce作业的提交与监控

Hadoop-eclipse插件还提供了提交MapReduce作业和监控作业状态的界面。通过以下步骤使用这些功能:

1. **提交MapReduce作业**:在Eclipse中开发并测试完你的MapReduce程序后,右键点击项目,选择“Run As”(运行方式)> “Run Configurations...”(运行配置...)。在打开的对话框中,创建一个新的MapReduce程序运行配置,填入相应的参数,然后运行。

2. **监控作业状态**:提交作业后,可以在“MapReduce Locations”(MapReduce位置)视图中看到作业的运行状态。这个视图会显示作业是否正在运行,完成的百分比,以及任何可能发生的错误。

3. **查看作业详细信息**:在运行配置视图中双击作业,可以看到作业的详细进度和日志信息,这对于调试和理解作业运行过程非常有帮助。

### 4.3.3 集成开发环境的优势

使用Hadoop-eclipse插件的集成开发环境相比直接在命令行操作提供了一些明显的优势:

1. **直观的界面**:Eclipse提供了一个图形界面,使得操作HDFS和提交作业更为直观和简单。

2. **代码编辑与调试**:Eclipse强大的代码编辑和调试功能,可以提高MapReduce程序开发的效率。

3. **项目管理**:Eclipse项目管理工具可以帮助开发者更好地组织和维护MapReduce代码。

4. **版本控制集成**:Eclipse与Git等版本控制系统的集成,简化了代码版本的管理。

在本章节,我们详细介绍了如何在Eclipse中下载、安装和配置Hadoop-eclipse插件,以及如何通过插件与Hadoop集群进行交互和管理HDFS文件。此外,我们还探索了插件提供的MapReduce作业提交与监控功能,以及集成开发环境为Hadoop开发带来的便利。随着Hadoop技术的发展,Eclipse及其Hadoop插件也在不断更新以适应新的开发趋势,使得开发者可以更加高效地完成大数据处理任务。

# 5. MapReduce开发实践

MapReduce是Hadoop的核心编程模型,用于处理大规模数据集的并行运算。本章节将深入探讨如何在Eclipse中利用Hadoop-eclipse插件开发MapReduce程序,包括创建项目、编写和测试MapReduce作业。

## 5.1 创建Hadoop MapReduce项目

### 5.1.1 新建Eclipse项目

在Eclipse中创建一个新的Java项目,用于存放我们的MapReduce代码。选择"File" -> "New" -> "Java Project",填入项目名称,例如"MyMapReduceProject",点击"Finish"完成项目创建。此时项目中应包含一个默认的源文件夹src。

### 5.1.2 设置项目以支持Hadoop

为了让项目支持Hadoop的类库和API,需要添加Hadoop的依赖到项目的构建路径中。这可以通过手动添加jar包或使用构建工具如Maven完成。对于手动添加,需从Hadoop安装目录的`lib`文件夹复制所有jar包到项目的"Referenced Libraries"。对于Maven,可以添加以下依赖到`pom.xml`文件中:

```xml

<dependencies>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.7.6</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-mapreduce-client-core</artifactId>

<version>2.7.6</version>

</dependency>

</dependencies>

5.2 编写MapReduce程序

5.2.1 MapReduce程序结构解析

MapReduce程序通常由两部分组成:Mapper和Reducer。Mapper处理输入数据并产生中间键值对,Reducer对中间结果进行汇总处理。MapReduce程序的基本结构包括:

public class MyMapReduceJob {

public static class TokenizerMapper extends Mapper<Object, Text, Text, IntWritable> {

//Mapper实现

}

public static class IntSumReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

//Reducer实现

}

public static void main(String[] args) throws Exception {

//程序入口,设置作业配置并启动MapReduce作业

}

}

5.2.2 编写一个简单的MapReduce任务

下面是一个简单的MapReduce任务例子,它计算文本文件中每个单词出现的次数。代码中包含了Mapper和Reducer的实现:

public class WordCount {

public static class TokenizerMapper extends Mapper<Object, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

public static class IntSumReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

}

在这个示例中, TokenizerMapper 将每行文本分割成单词,并为每个单词输出一个键值对(单词,1)。 IntSumReducer 接收所有相同的单词,并对它们的计数进行汇总。

5.3 测试与运行MapReduce作业

5.3.1 在Eclipse中运行MapReduce程序

在Eclipse中,您可以直接运行MapReduce程序。首先,需要配置运行环境,确保Hadoop环境变量正确设置。右键点击项目,选择”Run As” -> “Run Configurations…”。创建一个新的Java应用程序配置,选择主类为包含main方法的类,并设置运行参数(例如输入和输出目录)。

5.3.2 查看作业运行结果与日志

一旦MapReduce作业开始执行,可以通过Eclipse的控制台查看作业的执行日志。执行完成后,可以查看输出目录下的文件,这些文件包含了作业的最终结果。如果需要更详细的信息,可以在Hadoop集群上使用 hadoop fs -cat 命令查看输出文件的具体内容。

在MapReduce开发过程中,理解数据流和各个组件如何协同工作是至关重要的。通过本章的实践和代码解析,您应该能够掌握在Eclipse中开发和运行简单的MapReduce程序。随着深入学习,您可以尝试编写更复杂的MapReduce应用,如处理排序、过滤、连接等数据处理任务。

6. 插件的高级特性与开发趋势对比

随着Hadoop生态系统的发展,开发者需要在保持高效开发的同时,也要关注于如何更有效地监控和调试他们的MapReduce作业。本章将深入探讨Hadoop-eclipse插件的高级特性,并将其与现代开发趋势进行对比,以期为读者提供最前沿的Hadoop开发信息。

6.1 插件特性:调试与任务监控

Hadoop-eclipse插件不仅仅是一个连接Hadoop集群的工具,它还提供了强大的调试和任务监控功能,使得在Eclipse环境下进行Hadoop开发变得更加直观和高效。

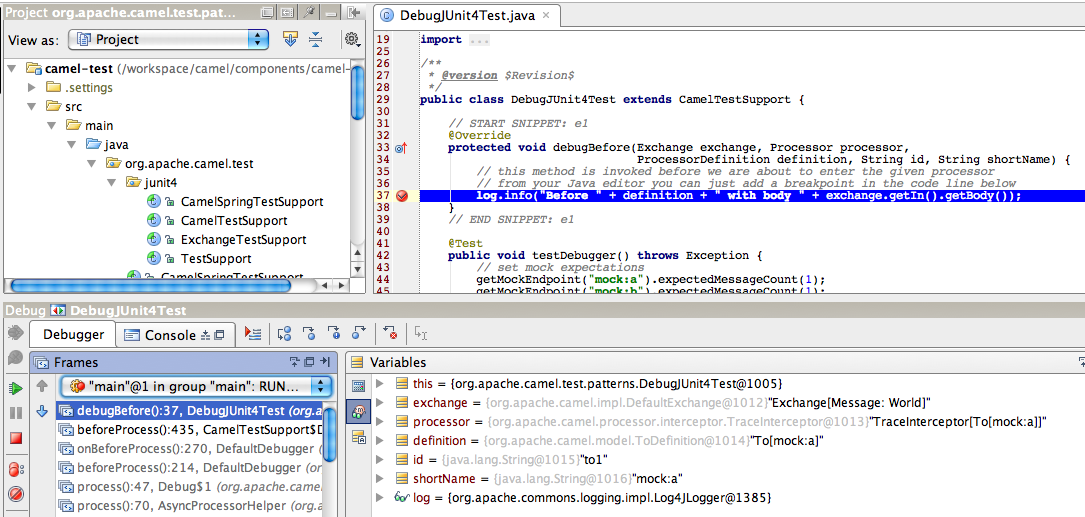

6.1.1 MapReduce作业的调试技巧

MapReduce作业的调试一直以来都是一个挑战,尤其是当涉及到复杂的逻辑处理时。Hadoop-eclipse插件提供了断点、步进以及变量检查等传统调试工具的功能。

具体步骤如下 :

- 在Eclipse中打开你的MapReduce源代码文件。

- 在希望程序暂停执行的地方点击左侧边缘,设置断点。

- 点击“Debug”按钮来启动调试模式。

- 一旦程序到达断点处,可以使用步进功能逐行执行程序,查看变量的实时值。

通过这种方式,开发者可以有效地定位和解决代码中的问题。

6.1.2 实时监控Hadoop集群状态

集群状态监控是维护Hadoop集群稳定性的重要组成部分。Hadoop-eclipse插件提供了一个直观的界面来监控集群的各种指标。

关键功能包含 :

- 实时查看集群状态

- 查看各个DataNode和NameNode的健康情况

- 获取和分析任务执行的详细信息

这些特性使得开发者能够及时发现并解决集群运行中的问题。

6.2 对比现代开发趋势

随着大数据技术的不断演进,传统的Hadoop开发方式正面临新的挑战与机遇。现代的大数据开发环境已经朝着更加高效、易用和集成化的方向发展。

6.2.1 Hadoop开发环境的现代替代方案

在过去的几年中,出现了多个基于云的大数据开发环境,这些环境提供了集成化的服务和简化的配置流程。

现代替代方案 :

- Cloudera DataFlow (CDF) :提供一站式的集成化数据管道开发和管理。

- Amazon EMR :在AWS云上提供高度可扩展的Hadoop服务。

- Google Cloud Dataflow :一个完全托管的、可扩展的数据处理服务。

这些现代替代方案能够在不同的层面上简化Hadoop的配置和管理。

6.2.2 新技术在Hadoop开发中的应用展望

随着技术的发展,一些新技术也开始被整合进Hadoop生态系统,以提高其性能和功能。

新技术展望 :

- Apache Spark :作为一个快速的大数据处理框架,提供了比Hadoop MapReduce更快的处理速度。

- Apache Kafka :主要用于构建实时数据管道和流式应用。

- Kubernetes :用于自动化部署、扩展和管理容器化应用。

这些技术的集成,使得Hadoop不仅仅是一个批处理工具,更成为了一个动态、实时处理和分析数据的强大平台。

通过本章的讨论,我们可以看到Hadoop-eclipse插件在提供便捷的Hadoop开发与管理功能方面所起到的作用。同时,我们也认识到了在现代大数据开发趋势中,开发者需要适应并采纳新技术,以获得更高效和强大的开发体验。

简介:Hadoop-eclipse插件为Java开发者提供了一个方便的工具,用于在Eclipse IDE中直接开发Hadoop MapReduce项目,无需离开Eclipse环境。通过几个简单的步骤,用户可以下载、安装插件,配置Hadoop连接,并开始创建和运行MapReduce程序。此插件简化了Hadoop开发流程,提高了工作效率,并支持调试和任务监控功能。尽管现代开发趋势可能转向更高效的计算框架,Hadoop-eclipse插件对于理解Hadoop MapReduce的基础仍有其价值。

1057

1057

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?