本文是 Least squares approximation 的学习笔记。这个视频从线性代数的角度,对最小二乘法的原理讲解的通俗易懂。

1 提出问题

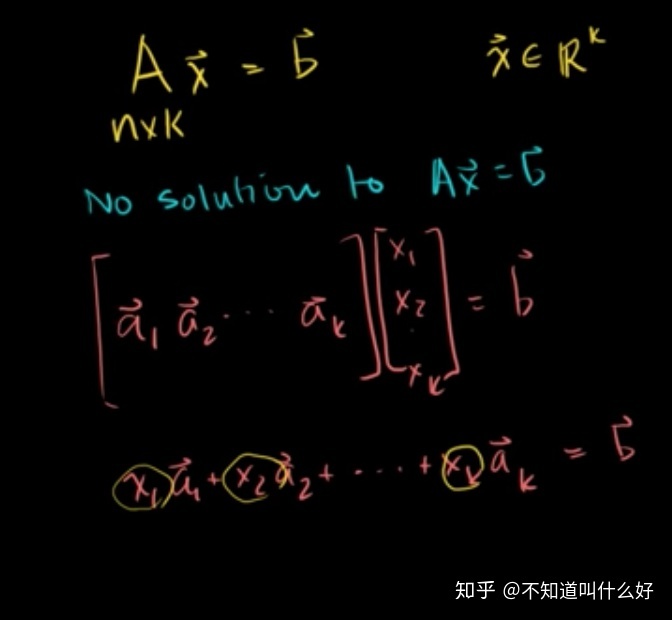

如上图所示:

A: 是一个n行k列的矩阵,每行可以看作是一个观测数据(或者一个训练样本)的输入(features);

b: 是一个n维的列向量,每项表示一个观测数据的目标值(ground truth target value);

x: 是一个k维的列向量,是需要构建的线性模型的参数。

我们希望通过已知的A和b,求解出一个x,使得Ax = b。 但是,一般情况下,不存在满足这个等式的x。 怎么办?

2 分析问题

Ax = b这个等式的左边,可以看作是一个矩阵A的列空间(Column space of A)。 这个等式没有解,可以理解为向量b不在矩阵A的列空间上。 如下图所示:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?