简介:操作系统中的同步互斥问题是多线程编程的核心内容,涉及如何协调并发进程以确保数据一致性和程序正确性。本文重点解析四大经典问题:生产者与消费者、读者与写者、哲学家就餐以及理发师问题,并分别给出基于信号量、互斥量、条件变量等同步机制的解决方案。通过理论分析与实践策略相结合,帮助读者深入理解死锁、饥饿、同步控制等关键概念,提升操作系统并发编程能力。

1. 同步互斥问题概述

在操作系统中,多个进程或线程并发执行时,往往需要访问共享资源(如内存、文件、设备等)。若不加以控制,将可能导致数据不一致、资源竞争甚至死锁等问题。 同步与互斥机制 正是为了解决这些问题而设计的核心机制。

- 互斥(Mutual Exclusion) :确保某一时刻只有一个线程能访问临界资源。

- 同步(Synchronization) :协调多个线程或进程的执行顺序,以实现有序协作。

这些问题的产生源于 并发执行的不确定性 ,尤其是在多核处理器和多线程编程日益普及的今天,掌握同步与互斥机制已成为系统开发与性能优化的关键能力。本章将为后续各章内容打下坚实的理论基础。

2. 生产者与消费者问题原理与实现

生产者与消费者问题是操作系统中经典的同步与互斥问题之一,广泛应用于多线程编程、任务调度、资源管理等场景。该问题不仅体现了并发编程中的资源竞争与协调机制,也展示了如何通过信号量、互斥量和条件变量等同步机制实现对共享资源的安全访问。本章将深入剖析该问题的模型构建、基于信号量的解决方案、条件变量实现策略,并结合实际代码示例进行说明。

2.1 问题描述与模型构建

2.1.1 生产者-消费者问题的背景与应用场景

生产者-消费者模型是一种典型的并发协作模型,其中:

- 生产者 负责生成数据并将其放入共享缓冲区;

- 消费者 负责从缓冲区中取出数据并进行处理;

- 缓冲区 是共享资源,需防止多个线程同时访问造成数据不一致或损坏。

该模型在实际系统中具有广泛的应用,例如:

- 操作系统的进程调度 :任务队列作为缓冲区,调度器为消费者,进程创建为生产者;

- 消息队列系统 :消息发布者为生产者,消费者为消息处理模块;

- 网络服务器请求处理 :客户端请求为生产者,服务器线程为消费者。

该问题的核心挑战在于确保生产者与消费者在访问缓冲区时的互斥与同步,避免出现以下问题:

- 缓冲区 溢出 (生产者写入超过容量);

- 缓冲区 读空 (消费者读取空数据);

- 数据竞争 (多个线程同时修改缓冲区)。

2.1.2 缓冲区的作用与访问控制需求

缓冲区在生产者-消费者模型中起到 中间媒介 的作用,其主要功能包括:

| 功能 | 描述 |

|---|---|

| 数据暂存 | 允许生产者将数据暂存,等待消费者处理 |

| 解耦合 | 降低生产者和消费者之间的直接依赖 |

| 流量控制 | 避免消费者被数据洪峰压垮 |

为了实现安全访问,缓冲区必须满足以下访问控制需求:

- 互斥访问 :同一时刻只能有一个线程访问缓冲区;

- 同步机制 :当缓冲区满时,生产者等待;当缓冲区空时,消费者等待。

这通常通过 信号量 或 条件变量 来实现。例如:

- 一个互斥信号量

mutex控制对缓冲区的互斥访问; - 一个信号量

empty表示缓冲区中空位数量; - 一个信号量

full表示缓冲区中已填充的数据数量。

2.2 基于信号量的解决方案

2.2.1 信号量机制的基本原理

信号量(Semaphore)是由荷兰计算机科学家 Edsger Dijkstra 提出的一种用于控制多个线程对共享资源访问的机制。信号量本质上是一个整数变量,支持两种原子操作:

- P操作(wait) :若信号量值大于0,则减1;否则阻塞线程;

- V操作(signal) :将信号量值加1,唤醒一个等待线程。

根据用途不同,信号量可分为:

| 类型 | 用途 |

|---|---|

| 二值信号量 | 实现互斥锁(mutex) |

| 计数信号量 | 控制资源池的访问 |

在生产者-消费者问题中,使用三个信号量:

-

mutex:保护对缓冲区的互斥访问; -

empty:表示缓冲区中空位数量; -

full:表示缓冲区中已填充的数据数量。

2.2.2 使用互斥量与同步信号量控制访问

生产者线程的执行逻辑如下:

while (1) {

produce_item(); // 生成数据项

wait(empty); // 等待缓冲区有空位

wait(mutex); // 获取互斥锁

put_item_into_buffer(item); // 将数据放入缓冲区

signal(mutex); // 释放互斥锁

signal(full); // 增加已填充数据计数

}

消费者线程的执行逻辑如下:

while (1) {

wait(full); // 等待缓冲区有数据

wait(mutex); // 获取互斥锁

item = remove_item_from_buffer(); // 从缓冲区取出数据

signal(mutex); // 释放互斥锁

signal(empty); // 增加空位计数

consume_item(item); // 消费数据

}

信号量参数说明与逻辑分析

| 信号量 | 初始值 | 作用 |

|---|---|---|

empty | N(缓冲区大小) | 控制缓冲区是否已满 |

full | 0 | 控制缓冲区是否为空 |

mutex | 1 | 保证缓冲区的互斥访问 |

上述代码中:

-

wait(empty):确保缓冲区未满; -

wait(full):确保缓冲区非空; -

wait(mutex)和signal(mutex):保护缓冲区的访问; -

signal(full)和signal(empty):通知对方缓冲区状态变化。

这种基于信号量的解决方案能够有效避免数据竞争与缓冲区溢出,是经典的同步机制之一。

2.3 使用条件变量实现同步

2.3.1 条件变量与互斥量协同工作机制

条件变量(Condition Variable)是另一种同步机制,通常与互斥量(Mutex)一起使用。它允许线程在某个条件不满足时进入等待状态,并在条件满足时被唤醒。

条件变量的典型操作包括:

-

pthread_cond_wait():释放互斥量并进入等待状态; -

pthread_cond_signal():唤醒一个等待的线程; -

pthread_cond_broadcast():唤醒所有等待的线程。

在生产者-消费者问题中,使用条件变量可以实现更灵活的同步策略。例如:

pthread_mutex_t mutex = PTHREAD_MUTEX_INITIALIZER;

pthread_cond_t not_empty = PTHREAD_COND_INITIALIZER;

pthread_cond_t not_full = PTHREAD_COND_INITIALIZER;

int buffer[N]; // 缓冲区

int count = 0; // 当前缓冲区中数据项数

生产者线程逻辑如下:

void* producer(void* arg) {

while (1) {

int item = produce_item();

pthread_mutex_lock(&mutex);

while (count == N) {

pthread_cond_wait(¬_full, &mutex); // 缓冲区满,等待

}

put_item_into_buffer(item);

count++;

pthread_cond_signal(¬_empty); // 通知消费者

pthread_mutex_unlock(&mutex);

}

}

消费者线程逻辑如下:

void* consumer(void* arg) {

while (1) {

pthread_mutex_lock(&mutex);

while (count == 0) {

pthread_cond_wait(¬_empty, &mutex); // 缓冲区空,等待

}

int item = remove_item_from_buffer();

count--;

pthread_cond_signal(¬_full); // 通知生产者

pthread_mutex_unlock(&mutex);

consume_item(item);

}

}

逻辑分析与参数说明

-

pthread_mutex_lock(&mutex):锁定互斥量,防止其他线程访问缓冲区; -

while(count == N)/while(count == 0):使用循环而非 if 判断,防止虚假唤醒; -

pthread_cond_wait():释放互斥量并阻塞当前线程,直到被唤醒; -

pthread_cond_signal():唤醒一个等待线程,通知缓冲区状态变化。

该方案通过条件变量实现更高效的线程调度,适用于多生产者、多消费者的复杂并发环境。

2.3.2 多生产者与多消费者环境下的实现策略

在多生产者与多消费者环境下,需确保多个线程之间的协调机制仍能有效运行。关键点包括:

- 所有线程必须使用相同的互斥量和条件变量;

- 缓冲区结构需支持并发访问(如环形缓冲区);

- 条件变量应使用

pthread_cond_broadcast()以确保所有等待线程被唤醒。

例如,在多个生产者情况下,若一个生产者唤醒了另一个生产者而非消费者,可能导致性能下降。因此,在某些系统中会采用“唤醒所有线程”策略:

pthread_cond_broadcast(¬_empty); // 唤醒所有等待的消费者

这种方式虽然增加唤醒次数,但能有效避免“唤醒错误线程”的问题。

2.4 实际应用与代码示例

2.4.1 C语言实现的生产者-消费者模型

以下是一个完整的 C 语言示例,使用 POSIX 线程和条件变量实现生产者-消费者模型:

#include <pthread.h>

#include <stdio.h>

#include <stdlib.h>

#define N 5 // 缓冲区大小

int buffer[N];

int count = 0;

int in = 0, out = 0;

pthread_mutex_t mutex = PTHREAD_MUTEX_INITIALIZER;

pthread_cond_t not_empty = PTHREAD_COND_INITIALIZER;

pthread_cond_t not_full = PTHREAD_COND_INITIALIZER;

void* producer(void* arg) {

while (1) {

int item = rand() % 100; // 模拟生成数据

pthread_mutex_lock(&mutex);

while (count == N) {

printf("Producer waiting...\n");

pthread_cond_wait(¬_full, &mutex);

}

buffer[in] = item;

in = (in + 1) % N;

count++;

printf("Produced: %d, count: %d\n", item, count);

pthread_cond_signal(¬_empty);

pthread_mutex_unlock(&mutex);

}

return NULL;

}

void* consumer(void* arg) {

while (1) {

pthread_mutex_lock(&mutex);

while (count == 0) {

printf("Consumer waiting...\n");

pthread_cond_wait(¬_empty, &mutex);

}

int item = buffer[out];

out = (out + 1) % N;

count--;

printf("Consumed: %d, count: %d\n", item, count);

pthread_cond_signal(¬_full);

pthread_mutex_unlock(&mutex);

}

return NULL;

}

int main() {

pthread_t prod, cons;

pthread_create(&prod, NULL, producer, NULL);

pthread_create(&cons, NULL, consumer, NULL);

pthread_join(prod, NULL);

pthread_join(cons, NULL);

return 0;

}

代码逐行解读与参数说明

-

buffer[N]:环形缓冲区; -

count:当前缓冲区中数据项数; -

in和out:指针用于定位写入和读取位置; -

pthread_mutex_lock():锁定互斥量; -

pthread_cond_wait():释放互斥量并等待条件; -

pthread_cond_signal():唤醒等待线程; -

rand() % 100:模拟生产随机数据; -

in = (in + 1) % N:环形指针移动。

2.4.2 在操作系统调度中的应用案例分析

在操作系统中,生产者-消费者模型广泛应用于任务调度系统中。例如:

- 线程调度器 :内核线程将任务放入调度队列(生产者),调度器从中取出并执行(消费者);

- 设备驱动程序 :中断服务例程将数据放入缓冲区(生产者),应用程序读取数据(消费者);

- 日志系统 :日志写入线程将日志信息放入队列(生产者),日志处理线程处理日志(消费者)。

此类系统通常采用线程池 + 阻塞队列的方式实现高效的并发处理。例如 Linux 内核中使用 kthread 和 waitqueue 实现任务调度。

示例流程图(mermaid)

graph TD

A[生产者线程] --> B[获取互斥锁]

B --> C{缓冲区是否已满?}

C -->|是| D[等待 not_full 条件]

C -->|否| E[将数据写入缓冲区]

E --> F[增加 count]

F --> G[发送 not_empty 信号]

G --> H[释放互斥锁]

I[消费者线程] --> J[获取互斥锁]

J --> K{缓冲区是否为空?}

K -->|是| L[等待 not_empty 条件]

K -->|否| M[从缓冲区取出数据]

M --> N[减少 count]

N --> O[发送 not_full 信号]

O --> P[释放互斥锁]

该流程图清晰地展示了生产者与消费者在访问缓冲区时的同步与互斥流程,体现了多线程环境下资源协调的重要性。

下一章节将深入探讨读者与写者问题的优先级策略与实现机制,进一步扩展并发编程中的同步与互斥模型。

3. 读者与写者问题原理与实现

在并发编程中,读者与写者问题是一个经典的同步问题,它揭示了共享资源访问时读写操作之间的冲突与协调机制。该问题广泛存在于操作系统、数据库系统、文件系统等场景中。本章将围绕读者与写者问题的基本模型、同步机制的设计与实现展开深入分析,探讨其在实际系统中的应用与优化策略。

3.1 问题定义与优先级策略

读者与写者问题的核心在于:多个读者可以同时读取共享资源,但写者必须独占资源进行写操作。因此,如何协调读者与写者的访问顺序,成为实现该模型的关键。

3.1.1 读者优先与写者优先机制的对比

在实际系统中,常见的策略包括 读者优先 和 写者优先 两种:

| 策略类型 | 描述 | 优点 | 缺点 |

|---|---|---|---|

| 读者优先 | 当有读者正在读取时,允许其他读者继续进入,写者必须等待所有读者完成。 | 提高读操作的吞吐量,适合读多写少场景。 | 可能导致写者“饥饿”,即写操作长时间无法执行。 |

| 写者优先 | 当有写者等待时,禁止新读者进入,优先处理写操作。 | 避免写者饥饿,适合写操作频繁的场景。 | 降低读操作的并发性,可能影响整体性能。 |

例如,在数据库系统中,读操作通常比写操作频繁,因此采用读者优先策略更为合适。但在实时系统中,写操作可能涉及关键数据更新,此时采用写者优先机制更合理。

代码示例:基于信号量的读者优先实现

#include <pthread.h>

#include <semaphore.h>

sem_t rw_mutex; // 控制写者访问

sem_t mutex; // 控制读者计数器的互斥访问

int read_count = 0; // 当前读者数量

// 读者线程函数

void* reader(void* arg) {

sem_wait(&mutex); // 进入临界区,修改read_count

read_count++;

if (read_count == 1) {

sem_wait(&rw_mutex); // 第一个读者获取写锁

}

sem_post(&mutex); // 释放计数器锁

// 读取共享资源

printf("Reader is reading...\n");

sem_wait(&mutex); // 再次进入临界区

read_count--;

if (read_count == 0) {

sem_post(&rw_mutex); // 最后一个读者释放写锁

}

sem_post(&mutex); // 释放计数器锁

return NULL;

}

// 写者线程函数

void* writer(void* arg) {

sem_wait(&rw_mutex); // 获取写锁

// 写入共享资源

printf("Writer is writing...\n");

sem_post(&rw_mutex); // 释放写锁

return NULL;

}

代码逻辑分析:

-

sem_wait(&mutex):用于保护read_count的修改,确保其原子性。 -

read_count++:增加当前读者数量。 - 如果是第一个读者(

read_count == 1),则调用sem_wait(&rw_mutex)获取写锁,防止写者进入。 - 在读者离开时,减少

read_count,若为最后一个读者,则释放写锁。 - 写者始终使用

sem_wait(&rw_mutex)获取写锁,确保其独占访问。

3.1.2 读写锁的引入与设计思路

为了更高效地处理读写冲突,操作系统引入了 读写锁(Read-Write Lock) 。读写锁允许多个读者同时访问资源,但写者必须独占资源。其设计思想如下:

- 读者获取锁 :若当前无写者持有锁,读者可以获取共享读锁。

- 写者获取锁 :若当前无任何读者或写者持有锁,写者可以获取独占写锁。

读写锁的伪代码表示

read_lock():

acquire mutex

while (writers_active > 0 || writers_waiting > 0):

wait

readers_active += 1

release mutex

read_unlock():

acquire mutex

readers_active -= 1

if readers_active == 0:

signal writer_cond

release mutex

write_lock():

acquire mutex

writers_waiting += 1

while (readers_active > 0 || writers_active > 0):

wait

writers_waiting -= 1

writers_active += 1

release mutex

write_unlock():

acquire mutex

writers_active -= 1

signal reader_cond or writer_cond

release mutex

参数说明:

-

readers_active:当前正在读取的读者数量。 -

writers_active:当前正在写入的写者数量。 -

writers_waiting:等待写入的写者数量。 -

reader_cond和writer_cond:条件变量,用于通知读者或写者资源可用。

3.2 信号量与互斥锁的协同实现

在实际并发编程中,往往需要结合信号量与互斥锁实现复杂的同步逻辑。对于读者与写者问题,可以使用多个信号量来控制访问顺序,确保资源安全。

3.2.1 多读者共享资源的访问控制

多个读者可以同时访问共享资源,但必须确保:

- 当有写者正在写时,禁止任何读者或写者进入。

- 当有读者正在读时,写者必须等待所有读者完成。

实现逻辑流程图(Mermaid)

graph TD

A[读者请求读] --> B{是否有写者活动}

B -->|是| C[等待]

B -->|否| D[增加读者计数]

D --> E{是否为第一个读者}

E -->|是| F[获取写锁]

E -->|否| G[继续读操作]

G --> H[完成读操作]

H --> I{是否为最后一个读者}

I -->|是| J[释放写锁]

I -->|否| K[减少读者计数]

3.2.2 写者独占资源的实现机制

写者在访问资源时必须确保其独占性,其核心机制如下:

- 写者尝试获取写锁。

- 若当前无读者或写者占用资源,则允许写者进入。

- 否则,写者进入等待队列,直到资源释放。

示例代码:写者优先机制

sem_t rw_mutex; // 控制写者访问

sem_t reader_mutex; // 控制读者进入

sem_t writer_mutex; // 控制写者进入

int read_count = 0;

int write_count = 0;

void* reader(void* arg) {

sem_wait(&reader_mutex);

sem_wait(&mutex);

read_count++;

if (read_count == 1)

sem_wait(&rw_mutex);

sem_post(&mutex);

sem_post(&reader_mutex);

// 读取操作

printf("Reader is reading...\n");

sem_wait(&mutex);

read_count--;

if (read_count == 0)

sem_post(&rw_mutex);

sem_post(&mutex);

return NULL;

}

void* writer(void* arg) {

sem_wait(&writer_mutex);

sem_wait(&mutex);

write_count++;

if (write_count == 1)

sem_wait(&reader_mutex);

sem_post(&mutex);

sem_post(&writer_mutex);

sem_wait(&rw_mutex);

// 写入操作

printf("Writer is writing...\n");

sem_post(&rw_mutex);

sem_wait(&mutex);

write_count--;

if (write_count == 0)

sem_post(&reader_mutex);

sem_post(&mutex);

return NULL;

}

逻辑分析:

- 使用

reader_mutex和writer_mutex分别控制读者和写者的进入顺序。 - 写者优先体现在写者进入时会阻止新读者进入。

- 写者数量由

write_count维护,最后一个写者释放reader_mutex以允许读者进入。

3.3 防止饥饿现象的优化策略

在并发系统中,若调度策略不合理,可能导致某些线程长期得不到执行,这种现象称为 饥饿 。读者与写者问题中,写者容易因读者持续进入而无法执行。

3.3.1 写者优先机制的实现

一种有效的防止写者饥饿的方法是采用 写者优先策略 ,即当有写者等待时,禁止新读者进入。

实现方式:

- 使用两个互斥信号量:

reader_gate(控制读者进入)和writer_gate(控制写者进入)。 - 写者进入前先获取

writer_gate,并阻止读者进入。 - 写者离开后释放

reader_gate以允许读者进入。

3.3.2 时间片轮转与公平调度方法

在多线程环境中,可以引入 时间片轮转 或 公平队列 机制,确保每个线程都能获得执行机会。

示例调度策略:

| 策略 | 描述 |

|---|---|

| 时间片轮转 | 每个线程获得固定时间片执行,到期后切换到下一个线程。 |

| 公平队列 | 根据等待时间排序,优先执行等待时间最长的线程。 |

实现思路:

typedef struct {

pthread_t thread;

int priority; // 优先级(等待时间)

} Worker;

Worker queue[100]; // 线程队列

int front = 0, rear = 0;

void schedule() {

// 按优先级排序队列

qsort(queue + front, rear - front, sizeof(Worker), compare_by_priority);

// 调度执行

for (int i = front; i < rear; i++) {

pthread_join(queue[i].thread, NULL);

}

}

参数说明:

-

priority:用于排序的优先级字段,可以是等待时间或优先级值。 -

qsort():用于按优先级排序线程队列。

3.4 实际系统中的应用

读者与写者问题在现代操作系统和数据库系统中具有广泛的应用,尤其是在高并发环境下。

3.4.1 文件系统并发访问控制

在文件系统中,多个进程可能同时读取或写入同一文件。操作系统通过读写锁机制控制访问:

- 读操作 :多个进程可同时读取文件内容。

- 写操作 :仅允许一个进程进行写操作,确保数据一致性。

3.4.2 数据库系统中的读写冲突处理

数据库系统中,事务并发执行时可能产生读写冲突。数据库管理系统(DBMS)通过事务隔离级别和锁机制协调:

- 读已提交(Read Committed) :允许读取已提交的数据,防止脏读。

- 可重复读(Repeatable Read) :保证事务多次读取同一数据时结果一致。

- 串行化(Serializable) :完全隔离事务,防止幻读和不可重复读。

示例:SQL中的锁机制

-- 读操作加共享锁

SELECT * FROM table_name WITH (HOLDLOCK, ROWLOCK);

-- 写操作加排他锁

UPDATE table_name SET column = value WHERE condition;

参数说明:

-

WITH (HOLDLOCK, ROWLOCK):在读操作时加共享锁,防止其他事务修改数据。 -

UPDATE语句默认加排他锁,确保写操作独占资源。

通过本章的分析,我们不仅掌握了读者与写者问题的基本原理,还深入理解了其在实际系统中的实现方式与优化策略。下一章将继续探讨哲学家就餐问题,揭示并发系统中死锁与资源分配的挑战。

4. 哲学家就餐问题原理与实现

哲学家就餐问题是操作系统中经典的同步与互斥问题之一,由荷兰计算机科学家艾兹赫尔·戴克斯特拉(Edsger W. Dijkstra)提出。它不仅揭示了并发编程中死锁的潜在风险,还启发了多种解决方案的设计。本章将深入探讨该问题的模型构造、死锁隐患、解决方案实现方式以及其在分布式系统中的扩展应用。

4.1 问题模型与死锁隐患

4.1.1 哲学家就餐问题的描述与资源竞争

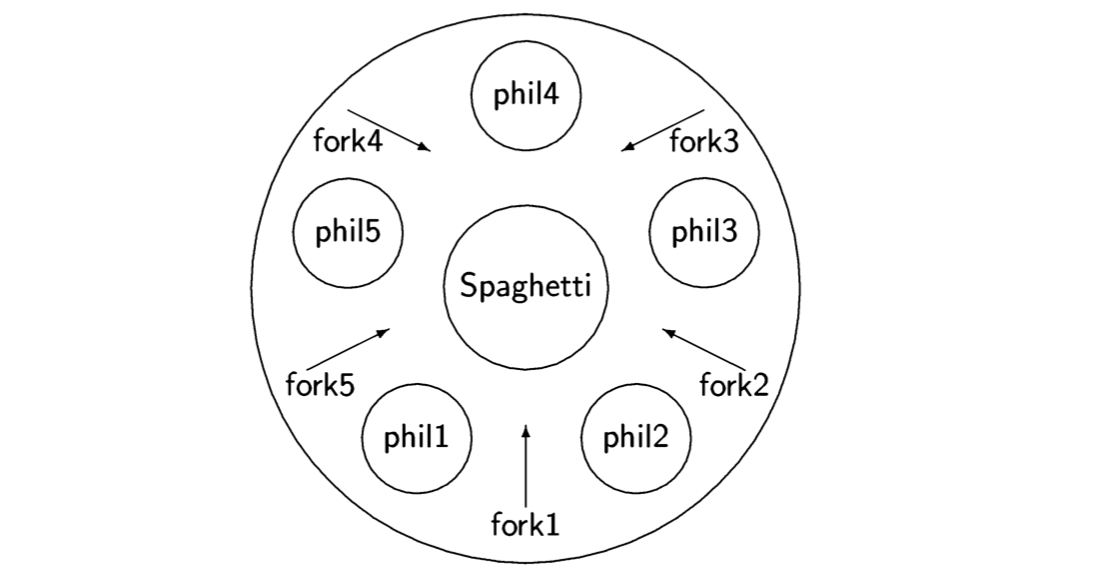

哲学家就餐问题是一个抽象的并发模型,用于描述多个进程(或线程)对共享资源的竞争问题。该模型包含五位哲学家围坐在一张圆桌旁,每位哲学家在思考和进餐之间交替进行。进餐时,哲学家需要同时拿起左右两侧的筷子(共享资源),而筷子一次只能被一位哲学家使用。

模型的关键在于资源的分配和同步机制。每位哲学家必须等待左右筷子都可用时才能进餐,否则只能等待。这种资源请求方式可能导致多个哲学家同时请求资源,从而形成资源循环依赖,最终导致死锁。

以下是一个简化的问题模型描述:

| 哲学家 | 状态 | 所需资源(左右筷子) |

|---|---|---|

| P0 | 思考/进餐 | 筷子0、筷子1 |

| P1 | 思考/进餐 | 筷子1、筷子2 |

| P2 | 思考/进餐 | 筷子2、筷子3 |

| P3 | 思考/进餐 | 筷子3、筷子4 |

| P4 | 思考/进餐 | 筷子4、筷子0 |

该模型清晰地展示了每位哲学家如何依赖两个相邻资源。资源的互斥访问是问题的核心,也是并发控制的难点。

4.1.2 死锁发生的四个必要条件

根据死锁的定义,其发生需要同时满足以下四个必要条件:

- 互斥(Mutual Exclusion) :资源不能共享,一次只能被一个进程使用。

- 持有并等待(Hold and Wait) :进程在等待其他资源的同时不释放已持有的资源。

- 不可抢占(No Preemption) :资源只能由持有它的进程主动释放,不能被强制剥夺。

- 循环等待(Circular Wait) :存在一个进程链,每个进程都在等待下一个进程所持有的资源。

在哲学家就餐问题中,如果每位哲学家都先拿起左边的筷子,然后等待右边的筷子,就会形成一个循环等待的资源依赖链。此时,所有哲学家都无法继续进餐,系统进入死锁状态。

下面是一个可能引发死锁的伪代码示例:

semaphore chopsticks[5] = {1,1,1,1,1}; // 每根筷子初始化为可用

void philosopher(int i) {

while (TRUE) {

think(); // 哲学家思考

P(chopsticks[i]); // 拿起左边筷子

P(chopsticks[(i+1)%5]); // 拿起右边筷子

eat(); // 哲学家进餐

V(chopsticks[i]); // 放下左边筷子

V(chopsticks[(i+1)%5]); // 放下右边筷子

}

}

代码逻辑分析 :

-

P()操作表示申请资源,若资源不可用则阻塞。 -

V()操作表示释放资源。 -

chopsticks[i]表示第i根筷子的信号量。

问题分析 :

- 每位哲学家先拿左边筷子,再拿右边,若所有哲学家同时执行到第一步,则会形成死锁。

- 该实现未考虑资源请求的顺序控制和死锁预防机制。

4.2 解决方案分析

4.2.1 资源编号法(避免循环等待)

资源编号法是一种常见的死锁预防策略,通过为资源(筷子)分配唯一编号,并要求进程按照编号顺序请求资源,从而打破循环等待条件。

在哲学家就餐问题中,可以为每根筷子编号为 0 到 4,并规定哲学家必须先请求编号较小的筷子,再请求编号较大的筷子。例如:

void philosopher(int i) {

int first = i;

int second = (i + 1) % 5;

if (first > second) {

int temp = first;

first = second;

second = temp;

}

while (TRUE) {

think();

P(chopsticks[first]);

P(chopsticks[second]);

eat();

V(chopsticks[second]);

V(chopsticks[first]);

}

}

代码逻辑分析 :

- 通过比较 first 和 second 的编号,确保总是先请求编号较小的筷子。

- 该策略避免了所有哲学家同时请求相邻资源的情况,从而打破了循环等待条件。

流程图说明 (mermaid):

graph TD

A[哲学家开始] --> B{是否先拿编号较小的筷子?}

B -->|是| C[获取筷子first]

B -->|否| D[交换first和second]

D --> C

C --> E[获取筷子second]

E --> F[进餐]

F --> G[释放筷子second]

G --> H[释放筷子first]

H --> A

4.2.2 饥饿问题的解决与公平性保证

在资源竞争中,某些哲学家可能因长期无法获取筷子而陷入饥饿状态。为了确保公平性,可以引入一个 中央协调机制 ,限制同时进餐的哲学家数量。

例如,使用一个额外的信号量来限制最多只有四位哲学家可以同时尝试拿筷子:

semaphore table = 4; // 最多允许4位哲学家同时进餐

void philosopher(int i) {

while (TRUE) {

think();

P(table); // 申请进入餐桌

P(chopsticks[i]);

P(chopsticks[(i+1)%5]);

eat();

V(chopsticks[(i+1)%5]);

V(chopsticks[i]);

V(table); // 离开餐桌

}

}

参数说明 :

- table 信号量控制同时进餐人数,最多为 4。

- 每位哲学家必须先申请 table 资源,才能开始进餐。

优点 :

- 避免死锁,因为最多只有 4 位哲学家在尝试拿筷子。

- 防止饥饿,所有哲学家都有机会获取资源。

4.3 基于信号量与状态机的实现

4.3.1 每个哲学家的状态管理

为了更精细地控制资源访问,可以为每位哲学家引入状态管理机制。哲学家的状态包括思考(THINKING)、饥饿(HUNGRY)和进餐(EATING)。当哲学家饥饿时,检查左右邻居是否在进餐,若否,则允许进餐。

示例代码如下:

#define N 5

#define THINKING 0

#define HUNGRY 1

#define EATING 2

int state[N];

semaphore self[N]; // 每位哲学家对应的信号量

semaphore mutex = 1; // 互斥访问状态数组

void test(int i) {

if (state[(i + 4) % N] != EATING && state[i] == HUNGRY && state[(i + 1) % N] != EATING) {

state[i] = EATING;

V(self[i]); // 通知哲学家i可以进餐

}

}

void take_chopsticks(int i) {

P(mutex);

state[i] = HUNGRY;

test(i);

V(mutex);

P(self[i]);

}

void put_chopsticks(int i) {

P(mutex);

state[i] = THINKING;

test((i + 4) % N); // 检查左边哲学家是否可进餐

test((i + 1) % N); // 检查右边哲学家是否可进餐

V(mutex);

}

代码逻辑分析 :

- test() 函数用于判断当前哲学家是否可以进餐。

- take_chopsticks() 用于请求筷子。

- put_chopsticks() 用于释放筷子并唤醒邻居。

4.3.2 并发控制策略的实现方式

该实现通过状态管理和信号量协同工作,实现了高效的并发控制。哲学家只有在左右邻居都未进餐时才能进餐,避免了死锁和饥饿。

状态转换图 (mermaid):

stateDiagram

[*] --> THINKING

THINKING --> HUNGRY : 请求进餐

HUNGRY --> EATING : 获取左右筷子

EATING --> THINKING : 释放筷子

4.4 分布式系统中的应用延伸

4.4.1 多节点并发访问的模拟

哲学家就餐问题不仅适用于单机系统,也可以扩展到分布式系统中。在分布式环境中,资源可能分布在不同的节点上,哲学家之间的资源请求需要通过网络通信完成。

例如,在一个分布式数据库系统中,多个节点可能需要访问相同的共享资源(如数据表),为了避免死锁和资源竞争,可以采用哲学家就餐问题中的资源编号法和状态管理机制。

4.4.2 系统级资源分配的优化策略

在分布式系统中,资源调度策略尤为重要。可以采用以下优化方法:

- 资源调度优先级 :根据任务紧急程度分配资源。

- 动态负载均衡 :实时调整资源分配,防止某些节点资源过载。

- 分布式锁机制 :使用分布式锁服务(如 ZooKeeper、etcd)管理共享资源的访问。

这些策略可以有效提升分布式系统的并发性能和资源利用率,避免死锁和饥饿问题。

本章从哲学家就餐问题的基本模型出发,分析了死锁的成因,并通过资源编号法、状态机机制和信号量控制等方式提出了多种解决方案。同时,我们还探讨了该问题在分布式系统中的应用延伸,展示了其在实际系统设计中的广泛适用性。

5. 理发师问题原理与实现

5.1 问题建模与现实意义

5.1.1 单服务台队列模型的引入

在操作系统与并发编程中,”理发师问题(Barber Problem)”是一个经典的同步问题,它模拟了单服务台排队系统的并发行为。该问题最早由 Dijkstra 提出,用于描述在共享资源(如线程池、服务端口)场景下的同步与互斥问题。

问题模型描述如下:

一个理发店有一个理发师和一张等待椅。当没有顾客时,理发师会睡觉;当有顾客到来时,如果理发师正在工作,顾客会坐在等待椅上等待;如果等待椅已满,顾客将离开。理发师完成一个顾客的服务后,会唤醒下一个等待的顾客。

这个模型可以抽象为:

- 理发师 :代表资源提供者或服务线程。

- 顾客 :代表请求资源的任务或线程。

- 等待椅 :表示等待队列或任务队列。

该模型具有高度的通用性,适用于任务调度、线程池管理、网络请求处理等多个场景。

5.1.2 等待顾客与空闲理发师的协调机制

在理发师问题中,关键的协调机制包括:

- 顾客到达 :若理发师空闲,立即开始服务;若理发师忙碌,进入等待队列。

- 理发师服务完成 :从队列中取出下一个顾客,若队列为空则进入等待状态。

- 等待队列满 :新顾客无法加入,选择离开。

这些机制涉及多线程间的通信与状态同步,需要用到 信号量 、 互斥量 等同步机制来保证数据一致性与状态转换的正确性。

5.2 同步机制的设计与实现

5.2.1 使用信号量控制顾客与理发师的交互

在实现中,我们可以使用三个同步变量:

-

customers:记录等待中的顾客数量,初始为0。 -

barber:表示理发师是否空闲,初始为0。 -

mutex:保护共享资源(等待队列)的互斥锁,初始为1。

以下是伪代码示例:

semaphore customers = 0;

semaphore barber = 0;

mutex lock = 1;

int waiting_customers = 0;

int waiting_capacity = N; // 等待椅数量

// 理发师线程

void barber_thread() {

while (TRUE) {

wait(customers); // 等待顾客到来

wait(lock); // 进入临界区

waiting_customers--; // 减少等待顾客数

signal(barber); // 通知顾客开始服务

signal(lock); // 释放锁

cut_hair(); // 理发过程

}

}

// 顾客线程

void customer_thread() {

wait(lock); // 进入临界区

if (waiting_customers < waiting_capacity) {

waiting_customers++; // 增加等待顾客数

signal(customers); // 通知理发师有顾客

signal(lock); // 释放锁

wait(barber); // 等待被服务

get_haircut(); // 接受服务

} else {

signal(lock); // 队列已满,离开

leave_shop(); // 离开理发店

}

}

代码逻辑分析:

-

wait()和signal()是信号量操作的基本原语,分别表示等待与释放。 -

customers信号量用于唤醒理发师。 -

barber信号量用于唤醒顾客开始服务。 -

mutex用于保护共享变量waiting_customers的互斥访问。 -

waiting_capacity限制了最大等待人数,防止资源过度消耗。

参数说明:

| 参数名 | 类型 | 含义说明 |

|---|---|---|

customers | semaphore | 表示当前等待的顾客数 |

barber | semaphore | 表示理发师是否准备好服务 |

mutex | mutex | 用于保护共享资源的互斥锁 |

waiting_customers | int | 当前在等待的顾客数量 |

waiting_capacity | int | 等待队列的最大容量 |

5.2.2 等待队列的维护与调度策略

在实际系统中,等待队列的调度策略可以影响系统的响应性能与公平性。常见的策略包括:

- 先进先出(FIFO) :最简单公平的方式,适用于大多数场景。

- 优先级调度 :高优先级任务优先服务,适用于实时系统。

- 轮询机制 :周期性检查队列状态,适用于低延迟系统。

我们可以通过一个队列结构来实现FIFO调度:

#include <stdio.h>

#include <stdlib.h>

#include <pthread.h>

#include <semaphore.h>

#define QUEUE_SIZE 5

typedef struct {

int queue[QUEUE_SIZE];

int front;

int rear;

int count;

} WaitQueue;

WaitQueue wait_queue = { .front = 0, .rear = 0, .count = 0 };

sem_t customers;

sem_t barber;

pthread_mutex_t lock = PTHREAD_MUTEX_INITIALIZER;

void enqueue(WaitQueue *q, int customer_id) {

if (q->count < QUEUE_SIZE) {

q->queue[q->rear] = customer_id;

q->rear = (q->rear + 1) % QUEUE_SIZE;

q->count++;

}

}

int dequeue(WaitQueue *q) {

int customer_id = -1;

if (q->count > 0) {

customer_id = q->queue[q->front];

q->front = (q->front + 1) % QUEUE_SIZE;

q->count--;

}

return customer_id;

}

流程图表示:

graph TD

A[顾客到达] --> B{等待队列是否满?}

B -->|是| C[顾客离开]

B -->|否| D[加入队列]

D --> E[发送信号给理发师]

F[理发师等待顾客信号] --> G{是否收到信号?}

G -->|是| H[取出顾客]

H --> I[发送信号开始服务]

I --> J[开始理发]

5.3 实际应用与系统优化

5.3.1 Web服务器请求调度模拟

在Web服务器中,线程池与请求队列的设计与理发师问题高度相似:

- 线程池中的线程 :相当于理发师。

- HTTP请求 :相当于顾客。

- 请求队列 :相当于等待椅。

我们可以使用类似理发师问题的机制来调度请求处理线程:

import threading

import queue

import time

request_queue = queue.Queue(maxsize=5)

barber_semaphore = threading.Semaphore(0)

customer_semaphore = threading.Semaphore(0)

mutex = threading.Lock()

def barber():

while True:

barber_semaphore.acquire()

with mutex:

request = request_queue.get()

print(f"正在处理请求: {request}")

time.sleep(1)

def customer(req_id):

with mutex:

if request_queue.full():

print(f"请求 {req_id} 被拒绝,队列已满")

return

request_queue.put(req_id)

customer_semaphore.release()

barber_semaphore.release()

# 启动线程

threading.Thread(target=barber, daemon=True).start()

for i in range(10):

threading.Thread(target=customer, args=(i,)).start()

time.sleep(0.3)

逻辑分析:

- 使用

queue.Queue实现线程安全的请求队列。 -

barber_semaphore用于唤醒线程处理请求。 -

customer_semaphore模拟顾客到来。 -

mutex保证队列的互斥访问。 - 请求超过队列容量时,顾客将被拒绝。

5.3.2 线程池与任务队列的实现类比

在现代并发编程中,线程池通常用于管理一组工作线程,任务通过队列提交给线程池执行。这种机制与理发师问题极为相似。

线程池的关键组件包括:

| 组件 | 类比对象 | 功能描述 |

|---|---|---|

| 线程池 | 理发师 | 提供服务的线程集合 |

| 任务队列 | 等待椅 | 存放待处理的任务 |

| 提交任务 | 顾客到达 | 提交任务到队列 |

| 执行任务 | 理发过程 | 处理任务内容 |

| 队列满处理 | 顾客离开 | 拒绝或等待策略 |

线程池类比流程图:

graph TD

A[任务提交] --> B{任务队列是否满?}

B -->|是| C[拒绝任务]

B -->|否| D[加入队列]

D --> E[唤醒线程]

F[线程等待任务] --> G{是否收到信号?}

G -->|是| H[取出任务]

H --> I[执行任务]

总结

第五章深入探讨了“理发师问题”的建模原理与同步机制实现,结合信号量与互斥锁完成了对顾客与理发师之间交互的模拟,并通过实际应用展示了其在Web服务器与线程池调度中的类比与价值。通过队列调度策略的优化,进一步提升了系统的并发性能与公平性。

6. 信号量机制在同步中的应用

在并发编程中,信号量(Semaphore)是一种重要的同步机制,广泛应用于进程或线程间的资源访问控制和同步协调。信号量的核心思想是通过一个整型变量来表示资源的可用状态,借助两个原子操作(P操作和V操作)来实现资源的申请与释放。本章将深入探讨信号量的基本概念、分类及其在同步问题中的典型应用,并分析其优缺点,帮助读者全面掌握信号量在现代操作系统与并发编程中的作用。

6.1 信号量的基本概念与分类

信号量机制由荷兰计算机科学家 Edsger W. Dijkstra 提出,是操作系统中实现进程或线程同步与互斥的重要工具。根据其值的语义,信号量主要分为两类: 二值信号量 (Binary Semaphore)和 计数信号量 (Counting Semaphore)。

6.1.1 二值信号量与计数信号量

| 类型 | 描述 | 应用场景 |

|---|---|---|

| 二值信号量 | 只能取0或1的信号量,用于表示资源是否被占用 | 实现互斥锁(Mutex) |

| 计数信号量 | 可取任意非负整数,表示多个相同资源的可用数量 | 控制多个资源的访问,如线程池中的工作线程数量 |

二值信号量常用于实现互斥访问,确保某一资源在同一时刻只能被一个线程或进程访问;而计数信号量适用于资源池管理,例如缓冲区、线程池等场景。

6.1.2 信号量的操作原语(P/V操作)

信号量的核心操作是 P 操作(也称为 wait 或 down)和 V 操作(也称为 signal 或 up),它们必须是原子操作,确保在并发环境下不会发生竞争条件。

// 伪代码:P/V操作定义

void P(semaphore S) {

while (S.value <= 0) { /* 等待 */ }

S.value--;

}

void V(semaphore S) {

S.value++;

}

逻辑分析

- P操作(申请资源) :

- 若信号量值大于0,表示资源可用,线程可以继续执行,并将信号量减1。

-

若信号量为0,表示资源不可用,线程进入等待状态,直到其他线程调用 V 操作释放资源。

-

V操作(释放资源) :

- 释放一个资源,将信号量值加1。

- 如果有线程正在等待资源,V操作会唤醒其中一个线程继续执行。

参数说明

-

S.value:表示当前资源的可用数量。 -

while (S.value <= 0):线程在此自旋等待资源可用,实际系统中通常使用阻塞机制而非自旋。 -

S.value--和S.value++:原子操作,防止多个线程同时修改信号量值。

流程图表示

graph TD

A[P操作开始] --> B{S.value > 0?}

B -->|是| C[允许访问,S.value--]

B -->|否| D[等待,直到S.value > 0]

C --> E[执行临界区代码]

E --> F[V操作开始]

F --> G[S.value++]

G --> H[唤醒等待线程(如有)]

6.2 在同步问题中的典型应用

信号量机制在多种同步与互斥问题中都有广泛应用,如进程间通信(IPC)、多线程环境下的资源协调等。

6.2.1 进程间通信中的同步控制

在进程间通信中,信号量常用于控制共享内存、消息队列等资源的访问顺序。例如,在生产者-消费者问题中,信号量可以协调生产者与消费者之间的数据存取。

示例代码(C语言)

#include <semaphore.h>

#include <pthread.h>

#define BUFFER_SIZE 10

int buffer[BUFFER_SIZE];

int count = 0;

sem_t empty; // 缓冲区空位数量

sem_t full; // 缓冲区已填充数量

pthread_mutex_t mutex;

void* producer(void* arg) {

int item;

while(1) {

item = produce_item(); // 假设该函数生成数据

sem_wait(&empty); // 等待空位

pthread_mutex_lock(&mutex); // 加锁

insert_item(buffer, item); // 将数据放入缓冲区

pthread_mutex_unlock(&mutex);

sem_post(&full); // 增加已填充数量

}

}

void* consumer(void* arg) {

int item;

while(1) {

sem_wait(&full); // 等待数据

pthread_mutex_lock(&mutex); // 加锁

item = remove_item(buffer); // 从缓冲区取出数据

pthread_mutex_unlock(&mutex);

sem_post(&empty); // 增加空位

consume_item(item); // 假设该函数消费数据

}

}

逻辑分析

-

sem_wait(&empty):生产者等待缓冲区有空位可写。 -

sem_wait(&full):消费者等待缓冲区有数据可读。 -

pthread_mutex_lock:确保插入/取出操作的原子性。 -

sem_post:释放资源,通知对方线程。

6.2.2 多线程环境下的资源访问协调

在多线程环境中,信号量可以用于控制线程对共享资源的访问顺序。例如,控制线程池中线程的启动与等待。

示例代码(Java)

import java.util.concurrent.Semaphore;

public class ThreadPool {

private final Semaphore semaphore;

public ThreadPool(int poolSize) {

semaphore = new Semaphore(poolSize);

}

public void execute(Runnable task) {

new Thread(() -> {

try {

semaphore.acquire(); // 获取一个许可

task.run(); // 执行任务

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

} finally {

semaphore.release(); // 释放许可

}

}).start();

}

}

参数说明

-

semaphore.acquire():尝试获取一个信号量许可,若无可用许可则阻塞。 -

semaphore.release():任务完成后释放一个许可,供其他线程使用。

逻辑分析

- 使用信号量控制线程池中最多同时运行的线程数。

- 避免线程爆炸,控制并发数量。

- 适用于 Web 服务器、任务调度系统等高并发场景。

6.3 信号量机制的优缺点分析

尽管信号量在并发编程中非常强大,但它也存在一些局限性,开发者在使用时需权衡其优缺点。

6.3.1 优点:灵活、高效、通用

- 灵活性 :支持多种同步模式,如互斥、顺序控制、资源池管理等。

- 效率高 :底层实现通常基于原子操作,性能优越。

- 通用性强 :可用于进程间、线程间的同步控制,适用于各种操作系统环境。

6.3.2 缺点:易用性差、容易出错

- 编程复杂 :P/V操作顺序容易出错,如忘记释放信号量将导致死锁。

- 调试困难 :死锁、资源泄漏等问题不易排查。

- 缺乏封装 :相比现代并发库(如 Java 的

ReentrantLock或 C++ 的std::mutex),信号量的使用较为底层,缺乏高级封装。

常见错误示例

// 错误示例:P/V顺序颠倒

sem_wait(&mutex); // 正确

// ... 临界区代码

sem_wait(&mutex); // 错误!重复等待,可能导致死锁

正确做法

sem_wait(&mutex);

// ... 临界区代码

sem_post(&mutex); // 必须对应释放

通过本章的学习,我们了解了信号量的基本概念、分类及其在进程与线程同步中的应用。信号量作为操作系统同步机制的核心之一,其灵活性和高效性使其在多线程、分布式系统中占据重要地位。然而,其底层特性和潜在的编程风险也要求开发者具备良好的并发编程素养。在后续章节中,我们将进一步探讨互斥量与条件变量等更高级的同步机制,以构建更健壮的并发系统。

7. 互斥量与条件变量的使用方法

7.1 互斥量的基本原理与使用场景

互斥量(Mutex,Mutual Exclusion 的缩写)是操作系统中用于实现线程或进程之间互斥访问共享资源的一种同步机制。其核心思想是: 在某一时刻,只允许一个线程持有该互斥锁,其他线程必须等待该锁释放后才能访问共享资源。

7.1.1 互斥量的加锁与解锁机制

互斥量的操作主要包括两个原子操作:

-

lock():线程尝试获取互斥锁。如果锁已被其他线程占用,则当前线程将被阻塞,直到锁被释放。 -

unlock():释放互斥锁,允许其他线程获取该锁。

以下是一个简单的 C++ 使用 std::mutex 的示例:

#include <iostream>

#include <thread>

#include <mutex>

std::mutex mtx; // 定义一个互斥量

int shared_data = 0;

void increment() {

mtx.lock(); // 加锁

shared_data++; // 访问共享资源

std::cout << "Value: " << shared_data << std::endl;

mtx.unlock(); // 解锁

}

int main() {

std::thread t1(increment);

std::thread t2(increment);

t1.join();

t2.join();

return 0;

}

参数说明:

-std::mutex mtx:定义一个互斥变量。

-mtx.lock():线程进入临界区前加锁。

-mtx.unlock():线程退出临界区后解锁。执行逻辑说明:

两个线程t1和t2同时尝试访问共享变量shared_data,通过互斥锁保证了同一时刻只有一个线程可以执行shared_data++,从而避免了数据竞争。

7.1.2 互斥量在多线程程序中的典型应用

互斥量广泛应用于多线程程序中,如:

- 线程安全的计数器更新。

- 线程间共享资源(如文件、网络连接、队列)的访问控制。

- 确保一次只有一个线程执行特定操作(如初始化单例对象)。

7.2 条件变量的协同机制

条件变量(Condition Variable)通常与互斥量配合使用,用于在多线程环境下实现线程间的 等待-通知 机制。它允许一个或多个线程等待某个条件的发生,当条件满足时,由其他线程唤醒等待的线程。

7.2.1 条件变量与互斥量的配合使用

条件变量的典型操作包括:

-

wait():线程等待某个条件成立,进入阻塞状态,同时释放关联的互斥锁。 -

notify_one()/notify_all():唤醒一个或所有等待该条件变量的线程。

以下是一个使用 std::condition_variable 的示例,实现一个简单的生产者-消费者模型:

#include <iostream>

#include <thread>

#include <queue>

#include <condition_variable>

#include <mutex>

std::queue<int> data_queue;

std::mutex mtx;

std::condition_variable cv;

bool ready = false;

void consumer() {

std::unique_lock<std::mutex> lock(mtx);

cv.wait(lock, []{ return ready; }); // 等待 ready 为 true

std::cout << "Consumed: " << data_queue.front() << std::endl;

data_queue.pop();

}

void producer() {

std::this_thread::sleep_for(std::chrono::seconds(1)); // 模拟延迟

{

std::lock_guard<std::mutex> lock(mtx);

data_queue.push(42);

ready = true;

}

cv.notify_one(); // 通知等待的线程

}

int main() {

std::thread t1(consumer);

std::thread t2(producer);

t1.join();

t2.join();

return 0;

}

参数说明:

-std::condition_variable cv:定义条件变量。

-cv.wait(lock, predicate):等待直到条件为真。

-cv.notify_one():唤醒一个等待的线程。执行逻辑说明:

- 消费者线程t1进入等待状态,直到生产者线程t2设置ready = true并调用notify_one()。

- 条件变量与互斥锁配合,确保在等待和唤醒过程中资源访问安全。

7.2.2 wait/notify机制的实现原理

-

wait()会自动释放互斥锁,使其他线程有机会修改条件变量的状态。 - 当

notify被调用后,等待线程被唤醒,重新获取互斥锁,并重新检查条件是否满足。 - 条件检查通常使用 lambda 表达式作为谓词(predicate)传入,确保线程只在条件满足时继续执行。

7.3 综合应用实例

7.3.1 线程安全的队列实现

线程安全队列是多线程编程中常见结构,通常用于任务调度、数据传递等场景。下面是一个基于互斥量和条件变量实现的线程安全队列:

template<typename T>

class ThreadSafeQueue {

private:

std::queue<T> queue;

std::mutex mtx;

std::condition_variable cv;

public:

void push(T value) {

std::lock_guard<std::mutex> lock(mtx);

queue.push(value);

cv.notify_one(); // 通知一个等待线程

}

T pop() {

std::unique_lock<std::mutex> lock(mtx);

cv.wait(lock, [this]{ return !queue.empty(); }); // 等待队列非空

T value = queue.front();

queue.pop();

return value;

}

bool empty() const {

std::lock_guard<std::mutex> lock(mtx);

return queue.empty();

}

};

功能说明:

-push():向队列中添加元素,并通知等待线程。

-pop():从队列中取出元素,若队列为空则等待。

-empty():判断队列是否为空。

7.3.2 多线程服务器中的请求处理模型

在多线程服务器中,主线程接收客户端请求后,将请求放入共享队列,多个工作线程从队列中取出任务并处理。以下是简化模型:

#include <iostream>

#include <thread>

#include <vector>

#include <functional>

#include <condition_variable>

#include <mutex>

#include <queue>

using Task = std::function<void()>;

class ThreadPool {

private:

std::vector<std::thread> workers;

std::queue<Task> tasks;

std::mutex mtx;

std::condition_variable cv;

bool stop = false;

public:

ThreadPool(size_t threads) {

for (size_t i = 0; i < threads; ++i) {

workers.emplace_back([this] {

while (true) {

std::unique_lock<std::mutex> lock(this->mtx);

this->cv.wait(lock, [this] { return this->stop || !this->tasks.empty(); });

if (this->stop && this->tasks.empty()) return;

Task task = std::move(this->tasks.front());

this->tasks.pop();

lock.unlock();

task();

}

});

}

}

template<class F>

void enqueue(F&& task) {

{

std::lock_guard<std::mutex> lock(mtx);

tasks.emplace(std::forward<F>(task));

}

cv.notify_one();

}

~ThreadPool() {

{

std::lock_guard<std::mutex> lock(mtx);

stop = true;

}

cv.notify_all();

for (auto& worker : workers) {

worker.join();

}

}

};

逻辑说明:

-ThreadPool初始化多个线程,每个线程循环等待任务。

-enqueue()将任务放入队列并唤醒一个线程。

- 线程取出任务后执行,实现并发处理。应用场景:

- Web 服务器并发处理 HTTP 请求。

- 游戏服务器处理多个玩家指令。

- 批量任务处理系统。流程图说明:

graph TD

A[主线程接收请求] --> B[将任务放入任务队列]

B --> C{任务队列非空?}

C -- 是 --> D[通知一个工作线程]

D --> E[工作线程取出任务]

E --> F[执行任务]

C -- 否 --> G[工作线程等待]

G --> H[等待通知]

H --> D

总结:

本章详细介绍了互斥量与条件变量的基本原理、使用方法以及在多线程程序中的典型应用。通过线程安全队列与线程池的实现示例,展示了其在实际开发中的重要价值。

简介:操作系统中的同步互斥问题是多线程编程的核心内容,涉及如何协调并发进程以确保数据一致性和程序正确性。本文重点解析四大经典问题:生产者与消费者、读者与写者、哲学家就餐以及理发师问题,并分别给出基于信号量、互斥量、条件变量等同步机制的解决方案。通过理论分析与实践策略相结合,帮助读者深入理解死锁、饥饿、同步控制等关键概念,提升操作系统并发编程能力。

1085

1085

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?