简介:Jupyter Notebook是一款广泛应用于数据科学、机器学习和数值计算的交互式Web工具,支持代码执行、文本说明、可视化和多媒体集成。本资源提供适用于Windows AMD64架构的Python 3.7.2版本Jupyter Notebook离线安装包,包含完整依赖项,支持无网络环境下的快速部署。通过pip命令本地安装,用户可在数据分析、教学演示和项目报告等场景中高效使用。本文深入介绍其核心功能、安装方法及典型应用场景,帮助用户全面掌握Jupyter Notebook的使用与管理。

1. Jupyter Notebook简介与核心功能

1.1 Jupyter Notebook的基本概念与架构设计

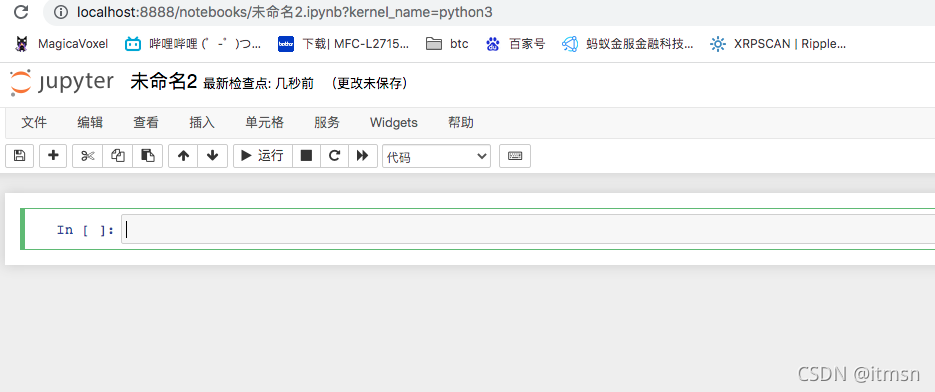

Jupyter Notebook 是一个基于Web的交互式计算环境,允许用户创建和共享包含代码、文本、可视化及数学公式的文档。其核心架构采用客户端-服务器模型:启动后,本地运行的Notebook服务器( jupyter-notebook )通过HTTP提供服务,默认在 http://localhost:8888 启动Web界面,用户通过浏览器进行交互。

# 启动命令示例

!jupyter notebook --ip=0.0.0.0 --port=8888 --no-browser

该命令启动服务器并开放端口,适用于远程访问场景。每个 .ipynb 文件本质上是JSON格式的文本文件,按顺序组织多个单元格(cell),支持代码、Markdown和原始文本三种类型,便于结构化表达计算过程。

1.2 核心功能特性解析

Jupyter 的核心优势在于其 交互性 与 可复现性 。代码以单元格为单位执行,结果实时内嵌输出,支持富媒体展示(如图表、HTML、音频)。例如:

import matplotlib.pyplot as plt

import numpy as np

x = np.linspace(0, 10, 100)

plt.plot(x, np.sin(x))

plt.title("Inline Plot in Jupyter")

plt.show()

此代码在Notebook中直接渲染图像,无需额外显示命令。此外,结合Markdown单元格可撰写技术说明,实现“代码+解释”一体化,极大提升文档可读性。

1.3 多语言支持与生态系统集成

尽管常用于Python,Jupyter 支持超过40种编程语言内核(kernel),如R、Julia、Scala等,通过 ipykernel 机制实现语言解耦。安装新内核后可在界面切换:

python -m ipykernel install --user --name=myenv --display-name "Python 3.7.2"

此命令将当前Python环境注册为可选内核,便于多版本共存管理。同时, .ipynb 文件可通过 nbconvert 导出为PDF、HTML、幻灯片等多种格式,广泛应用于教学、科研与工程报告中。

| 特性 | 描述 |

|---|---|

| 实时反馈 | 单元格执行后立即显示结果 |

| 富媒体输出 | 支持图像、视频、HTML嵌入 |

| 可复用性 | .ipynb 文件可版本控制与共享 |

| 扩展性强 | 支持插件系统(如jupyterlab-git) |

注意 :由于

.ipynb为JSON结构,直接参与Git协作时易产生合并冲突。推荐使用nbdime工具或提交前清除输出(jupyter nbconvert --clear-output)以优化版本控制体验。

本章奠定了Jupyter作为现代数据科学工作流基础的认知框架,后续章节将围绕其在特定语言版本、硬件平台及离线部署中的实践展开深入探讨。

2. Python 3.7.2版本特性及其在Jupyter中的优势

Python 3.7.2作为Python 3.7系列的一个关键维护版本,不仅修复了多个稳定性问题,还强化了语言核心功能与开发体验。该版本发布于2019年,正值异步编程、数据类和类型提示等现代编程范式快速普及的阶段。对于依赖交互式环境进行探索性数据分析、教学演示或科研记录的用户而言,将Jupyter Notebook运行在Python 3.7.2这一稳定且功能完备的版本上,具有显著的实际意义。本章将深入剖析Python 3.7.2引入的核心语言特性,分析其在Jupyter环境下的执行表现,并探讨为何锁定特定版本对离线部署场景尤为重要。最终通过构建隔离的Python内核工作区案例,展示如何实现可复现、高兼容性的Notebook运行环境。

2.1 Python 3.7.2语言特性解析

Python 3.7.2虽为一个小版本更新,但其背后承载的是整个3.7分支的重要演进成果。相比前代版本(如3.6),它在语法表达力、调试支持、并发处理能力等方面实现了质的飞跃。这些改进并非仅限于底层优化,而是直接影响开发者编码效率与程序健壮性。以下从四个关键技术点展开详细论述,揭示其在实际开发尤其是Jupyter交互式场景中的价值。

2.1.1 数据类(dataclasses)的引入与自动化代码生成

dataclass 是Python 3.7中最具革命性的新特性之一,通过装饰器机制自动为类生成常用方法,极大简化了“纯数据”对象的定义过程。传统方式下,定义一个包含字段初始化、字符串表示、相等性比较等功能的数据结构需要手动编写大量样板代码:

class Point:

def __init__(self, x: float, y: float):

self.x = x

self.y = y

def __repr__(self):

return f"Point({self.x}, {self.y})"

def __eq__(self, other):

if not isinstance(other, Point):

return False

return (self.x == other.x) and (self.y == other.y)

而在Python 3.7.2中,只需使用 @dataclass 装饰器即可自动生成上述所有方法:

from dataclasses import dataclass

@dataclass

class Point:

x: float

y: float

代码逻辑逐行解读:

- 第1行:导入

dataclass装饰器; - 第3–4行:使用

@dataclass修饰类,声明这是一个数据类; - 字段注解

: float用于类型提示,同时被dataclass识别以生成相应逻辑。

此特性在Jupyter中尤为实用——在快速原型设计时,用户常需构造临时数据容器来组织中间结果。借助 dataclass ,可以几秒内创建结构清晰的对象,避免陷入繁琐的 __init__ 编写中。此外,结合IPython的富显示系统, dataclass 实例还能自然地参与表格化输出与可视化流程。

| 特性 | 手动实现耗时(估算) | 使用 dataclass |

|---|---|---|

__init__ | 1–2分钟 | 自动生成 |

__repr__ | 30秒 | 自动生成 |

__eq__ | 1分钟 | 自动生成 |

| 类型检查支持 | 需额外库 | 原生支持 |

graph TD

A[定义字段] --> B{是否使用dataclass?}

B -- 是 --> C[自动添加__init__, __repr__, __eq__]

B -- 否 --> D[手动编写全部方法]

C --> E[节省时间 提升可读性]

D --> F[易出错 维护成本高]

更重要的是, dataclass 支持参数定制,例如设置默认值、禁止实例修改( frozen=True )、控制字段是否参与比较等,进一步增强了灵活性:

@dataclass(frozen=True)

class Config:

batch_size: int = 32

learning_rate: float = 0.001

这在实验配置管理中非常有用,确保关键参数不可变,防止意外覆盖。

2.1.2 上下文变量(Context Variables)与异步编程支持增强

随着 async/await 语法在Python 3.5后的广泛应用,异步编程逐渐成为高性能服务的标准模式。然而,在协程切换过程中保持上下文状态一直是个难题——传统的 threading.local() 无法跨 await 边界传递数据。为此,Python 3.7正式引入 contextvars 模块,提供 上下文变量 (Context Variables)机制,解决了这一痛点。

import contextvars

request_id = contextvars.ContextVar('request_id')

async def handle_request(rid):

request_id.set(rid)

print(f"Current request ID: {request_id.get()}")

await some_async_task()

# 在不同await调用间,request_id的值仍能正确保留

参数说明:

-

ContextVar('name'):创建一个命名的上下文变量; -

.set(value):在当前上下文中绑定值; -

.get():获取当前上下文中的值,若未设置则抛异常或返回默认值。

该机制在Jupyter中可用于追踪单元格执行链路中的元信息,例如标记某个计算流程属于哪个用户会话、实验批次或调试级别。尽管Notebook本身非典型异步服务器,但在集成异步I/O操作(如调用REST API、数据库查询)时, contextvars 可确保日志记录、权限校验等横切关注点的一致性。

sequenceDiagram

participant CellA

participant AsyncTask

participant ContextStorage

CellA->>ContextStorage: request_id.set("exp_001")

CellA->>AsyncTask: await fetch_data()

AsyncTask->>ContextStorage: request_id.get()

AsyncTask->>Log: 写入日志含request_id

这种能力使得复杂的异步流水线即使分布在多个 await 之间,也能维持统一的身份标识,极大提升了调试与监控能力。

2.1.3 字典保持插入顺序的正式规范与调试便利性提升

虽然从CPython 3.6开始字典已默认保持插入顺序,但直到Python 3.7才将其写入语言规范,成为所有符合标准的Python实现(如PyPy)必须遵守的行为。这意味着:

d = {}

d['first'] = 1

d['second'] = 2

d['third'] = 3

print(list(d.keys())) # 输出: ['first', 'second', 'third']

这一变化看似微小,实则影响深远。在数据分析场景中,字典常被用作轻量级结构体或配置映射。若顺序不确定,可能导致输出结果混乱、图表标签错位等问题。如今顺序可预测后,开发者无需再显式使用 collections.OrderedDict ,简化了代码并减少了认知负担。

更重要的是,在Jupyter中展示中间数据结构时,用户期望看到字段按定义顺序排列。例如:

results = {

"model": "ResNet50",

"accuracy": 0.92,

"loss": 0.03,

"timestamp": "2025-04-05"

}

当打印此字典或转换为DataFrame时,字段顺序一致,便于阅读与比对。此外,在序列化为JSON时,顺序保留也增强了结果的可重复性,有利于版本控制与实验回溯。

2.1.4 更精确的语法错误提示与开发效率优化

Python 3.7.2改进了编译器的错误定位机制,能够更精准地标记语法错误位置。例如以下代码:

def greet(name

print(f"Hello {name}")

旧版本可能只提示“invalid syntax”,而Python 3.7.2会明确指出:

File "<stdin>", line 1

def greet(name

^

SyntaxError: unexpected EOF while parsing

箭头指针精确指向缺失括号的位置,大幅缩短排查时间。类似地,对嵌套括号、缩进错误、 yield 误用等情况也有更强的诊断能力。

这一改进在Jupyter中尤为关键:由于Notebook允许逐段编辑与执行,容易出现未闭合结构跨越多个单元格的情况。增强的错误提示帮助用户迅速定位问题源头,避免因局部错误导致整个工作流中断。

此外, makefunctools.cache (即 @lru_cache )现在支持类型提示兼容, breakpoint() 内置函数取代 pdb.set_trace() 成为标准调试入口,均体现了Python 3.7.2对开发者体验的深度优化。

综上所述,Python 3.7.2不仅仅是版本号的递增,更是语言现代化进程中的重要里程碑。其新增特性直接服务于高效、安全、可维护的编程实践,尤其契合Jupyter所倡导的“即时反馈+文档一体化”开发理念。

2.2 Jupyter环境中Python 3.7.2的运行表现

Jupyter Notebook本质上是一个基于Tornado的Web应用,其后端通过启动Python内核(kernel)来执行代码。因此,所使用的Python版本直接影响内核行为、功能可用性及性能表现。Python 3.7.2凭借其稳定的运行时表现和对现代特性的良好支持,在Jupyter生态中展现出卓越的适配性。

2.2.1 内核兼容性验证与启动流程分析

当用户启动Jupyter Notebook时,系统首先加载已注册的内核列表。每个内核对应一个特定的Python解释器路径。可通过命令查看当前可用内核:

jupyter kernelspec list

输出示例:

Available kernels:

python3 C:\Users\user\AppData\Roaming\jupyter\kernels\python3

进入该目录下的 kernel.json 文件,内容如下:

{

"argv": [

"C:\\Python37\\python.exe",

"-m",

"ipykernel_launcher",

"-f",

"{connection_file}"

],

"display_name": "Python 3",

"language": "python"

}

参数说明:

-

argv:启动命令数组; -

"C:\\Python37\\python.exe":指定具体Python解释器路径; -

-m ipykernel_launcher:以模块形式运行IPython内核; -

-f {connection_file}:传入连接配置文件路径,用于建立前端通信。

若此路径指向Python 3.7.2安装目录,则说明该内核基于该版本运行。可通过在Notebook中执行以下代码验证:

import sys

print(sys.version)

输出应为:

3.7.2 (tags/v3.7.2:9a3ffc0492, Dec 23 2018, 23:09:28) [MSC v.1916 64 bit (AMD64)]

只有确认版本匹配,才能确保前述语言特性(如 dataclass 、 contextvars )正常工作。

2.2.2 异步执行模式(async/await)在Notebook中的直接支持

Jupyter自5.0起原生支持异步单元格执行,允许直接运行 async 函数而无需包装器。在Python 3.7.2环境下,这一功能更加稳定高效。

import asyncio

async def fetch_data():

print("Fetching...")

await asyncio.sleep(2)

return {"status": "ok", "data": [1, 2, 3]}

# 直接调用

result = await fetch_data()

print(result)

执行逻辑说明:

- Notebook内核检测到顶层

await表达式时,自动将其包裹在一个事件循环中; -

asyncio.sleep(2)模拟异步等待,期间不会阻塞其他单元格执行; - 结果返回后继续同步后续语句。

该机制极大提升了与外部API、数据库、实时流的交互效率。相较于传统轮询或回调模式, async/await 让代码更接近自然语言描述,易于理解和维护。

| 对比维度 | 同步方式 | 异步方式(Python 3.7.2 + Jupyter) |

|---|---|---|

| 响应延迟 | 高 | 低 |

| 资源利用率 | 单线程阻塞 | 多任务并发 |

| 编码复杂度 | 简单但扩展性差 | 清晰且可组合 |

| 支持库 | requests | aiohttp, aiomysql |

flowchart LR

A[发起HTTP请求] --> B{同步还是异步?}

B -->|同步| C[阻塞主线程 等待响应]

B -->|异步| D[注册回调 进入事件循环]

D --> E[处理响应时不阻塞UI]

值得注意的是,某些旧版Python(如3.6之前)缺乏完整的 asyncio 支持,导致此类代码无法运行或需复杂适配。Python 3.7.2则完全规避这些问题。

2.2.3 利用 __future__ 模块实现向后兼容的最佳实践

尽管Python 3.7.2已较为先进,但在团队协作或长期项目中,仍可能面临跨版本共存需求。此时可通过 __future__ 导入未来特性,提前使用新语法:

from __future__ import annotations # 延迟注解解析

class Node:

def __init__(self, value: int, parent: Node = None): # 此处Node尚未定义

self.value = value

self.parent = parent

参数说明:

-

annotations:启用PEP 563,推迟类型注解的求值,避免前向引用错误; - 即使在较老环境中也可安全使用高级语法。

建议在所有Notebook开头统一加入此类导入,形成标准化模板,提升代码可移植性。

综上,Python 3.7.2不仅自身功能强大,更能充分发挥Jupyter的交互潜力,特别是在异步编程、类型安全与执行效率方面提供了坚实支撑。

2.3 版本锁定对离线环境的意义

在企业、教育或科研机构中,软件环境的一致性往往比功能新颖更为重要。版本锁定(Version Pinning)是指明确指定并固定使用某一特定版本的解释器与库,避免因自动升级带来的不确定性。

2.3.1 确保科研实验环境一致性的重要性

科学研究强调可重复性(Reproducibility)。若两次运行因Python版本差异导致数值精度、随机种子行为或API变更而结果不一致,将严重损害研究可信度。例如:

- Python 3.7与3.8在

statistics.mean()中对浮点误差的处理略有不同; - 某些科学计算库(如NumPy)在不同Python版本下编译的二进制包可能存在性能偏差。

锁定Python 3.7.2可消除此类干扰因素,确保实验条件完全可控。

2.3.2 避免因语言版本差异导致的库不兼容问题

许多第三方库(尤其是含C扩展的)针对特定Python版本编译。例如, pandas-1.0.0 可能仅提供 cp37-cp37m-win_amd64.whl 包,无法在Python 3.8中安装。若未锁定版本, pip install 可能因ABI不匹配失败。

解决方案是在requirements.txt中明确指定:

python==3.7.2

numpy==1.18.5

pandas==1.0.5

matplotlib==3.2.2

配合虚拟环境,可在多台机器上重建完全一致的运行时。

2.3.3 在教学场景中统一学生编程环境的策略

高校机房常采用镜像克隆技术批量部署系统。若不限定Python版本,学生自行安装的工具可能导致冲突。推荐做法:

- 使用

pyenv或conda管理多版本; - 创建名为

edu-py372的环境; - 预装Jupyter及相关库;

- 设置开机脚本自动激活环境。

如此可保证所有学生在相同起点学习,减少技术支持负担。

2.4 实践案例:构建稳定Python内核的Notebook工作区

2.4.1 检查并切换Jupyter内核至指定Python版本

首先确认目标Python已安装:

C:\Python37\python.exe --version

安装 ipykernel :

C:\Python37\python.exe -m pip install ipykernel

注册为独立内核:

C:\Python37\python.exe -m ipykernel install --name py372 --display-name "Python 3.7.2"

刷新浏览器后,新建Notebook时即可选择“Python 3.7.2”内核。

2.4.2 使用virtualenv隔离Python 3.7.2运行环境

避免污染全局包空间:

# 创建虚拟环境

C:\Python37\python.exe -m venv C:\envs\py372_jupyter

# 激活环境

C:\envs\py372_jupyter\Scripts\activate

# 安装核心组件

pip install jupyter notebook pandas matplotlib

随后注册该环境为内核,实现完全隔离。

2.4.3 验证内核连接状态与常见故障排查方法

若内核频繁断开,检查日志:

jupyter console --kernel py372

常见问题包括:

- 路径含中文或空格 → 修改安装路径;

- 权限不足 → 以管理员身份运行;

- DLL缺失 → 安装Visual C++ Redistributable。

通过以上步骤,可构建一个稳定、可复制、适用于离线部署的Jupyter+Python 3.7.2工作区,为后续大规模应用奠定基础。

3. AMD64架构适配与Windows系统兼容性说明

在现代计算环境中,软硬件平台的匹配程度直接决定了开发工具链的稳定性和性能表现。Jupyter Notebook 作为一种广泛应用于数据分析、机器学习和教学科研的交互式编程环境,其运行依赖于底层操作系统与处理器架构的协同支持。尤其在企业级部署或离线安装场景中,开发者常常面临“为何同样的 .whl 包在一台机器上能顺利安装而在另一台却报错”的问题——这类问题往往根植于 AMD64 架构适配 和 Windows 系统兼容性细节 的理解不足。

本章节深入剖析 AMD64(即 x86-64)架构的技术本质及其对 Python 生态的影响,重点解析 Windows 操作系统下 Jupyter 运行环境搭建过程中常见的兼容性障碍,并通过完整的实践流程展示如何在基于 AMD64 的 Windows 平台上构建一个纯净、可复用且稳定的 Jupyter 工作区。我们将从指令集特性讲起,逐步过渡到二进制包识别机制、系统路径配置差异以及关键依赖库的加载逻辑,最终实现从零开始完成一次精准控制的本地化部署。

3.1 AMD64架构的技术背景与软件适配逻辑

随着数据处理需求的增长,64位计算已成为主流标准。AMD64 是由 AMD 公司设计的一种 64 位扩展指令集架构(ISA),后来被 Intel 采纳为 x86-64,现已成为所有现代 PC 处理器的基础架构。它不仅保留了对原有 32 位应用的向后兼容能力,还引入了更宽的寄存器、更大的内存寻址空间和优化的调用约定,显著提升了程序执行效率。

3.1.1 64位处理器指令集特点与内存寻址优势

AMD64 架构最核心的优势在于其对物理内存的访问能力。传统的 32 位系统受限于 $2^{32}$ 地址空间,最多只能使用约 4GB 内存;而 AMD64 将地址总线扩展至最多 52 位(当前典型实现为 48 位),理论最大寻址空间可达 256TB ,这对于需要加载大型数据集(如 pandas DataFrame 或 NumPy 数组)的数据科学任务至关重要。

此外,AMD64 增加了通用寄存器数量(从 8 个增至 16 个),并统一了整数和浮点运算的调用接口(使用 RAX、RCX 等寄存器传递参数),减少了函数调用时的栈操作开销,提高了代码执行速度。这种底层优化直接影响 Python 解释器本身以及基于 C 扩展的第三方库(如 numpy、pandas)的性能表现。

更重要的是,Python 官方发行版针对不同架构提供了原生编译版本。例如:

| 架构类型 | 可执行文件命名示例 | 支持的最大内存 |

|---|---|---|

| x86 (32-bit) | python-3.7.2.exe | ~3.5 GB 用户态 |

| AMD64 (64-bit) | python-3.7.2-amd64.exe | >128 GB |

选择错误的架构可能导致无法安装某些依赖包,甚至引发 ImportError: DLL load failed 类似错误。

graph TD

A[用户请求安装 jupyter] --> B{Python 架构检测}

B -->|32-bit| C[仅能使用 win32 轮子]

B -->|64-bit| D[可使用 win_amd64 轮子]

C --> E[可能缺少关键包支持]

D --> F[完整支持高性能库]

上图展示了架构检测如何影响可用包的选择范围。若使用 32 位 Python,则无法加载专为 64 位优化的

.whl文件,从而限制功能完整性。

3.1.2 原生二进制包与平台特定wheel文件的关系

Python 社区广泛采用 wheel 格式 ( .whl )作为预编译的二进制分发包。相比源码包(如 .tar.gz ),wheel 包无需在目标机器上重新编译,极大提升了安装效率,尤其适用于包含 C/C++ 扩展的库(如 numpy、scipy)。

每个 wheel 文件名遵循如下命名规范:

{distribution}-{version}(-{build tag})?-{python tag}-{abi tag}-{platform tag}.whl

其中最后三个标签共同决定该包是否可在当前系统上安装。以 numpy-1.16.6-cp37-cp37m-win_amd64.whl 为例:

| 字段 | 含义 |

|---|---|

cp37 | 使用 CPython 3.7 编译 |

cp37m | ABI 标签,表示启用了 pymalloc |

win_amd64 | 目标平台为 Windows + AMD64 架构 |

因此,只有当当前 Python 解释器的环境完全匹配这些标签时,pip 才会允许安装此包。否则将抛出类似错误:

ERROR: xxx.whl is not a supported wheel on this platform.

这意味着即使你下载了正确的版本号,但如果架构不匹配(比如误用了 win32 包安装在 64 位系统上),依然无法成功安装。

为了验证当前环境支持哪些平台标签,可以运行以下代码:

import pip._internal

from pip._internal.models import candidate

from pip._internal.index.package_finder import PackageFinder

# 打印当前支持的平台标签

print("Supported tags:")

for tag in candidate.get_supported():

print(tag)

逐行分析:

- 第 1 行:导入私有模块

pip._internal,用于访问底层功能。 - 第 2–3 行:引入候选包模型和包查找器类。

- 第 6 行:调用

get_supported()获取当前解释器支持的所有标签组合。 - 输出结果形如:

cp37-cp37m-win_amd64 cp37-none-win_amd64 py3-none-win_amd64 ...

这表明该环境优先寻找 win_amd64 架构的包,其次是通用平台包。

3.1.3 如何识别Python包的平台标签(win_amd64)

在实际部署中,经常需要手动筛选适用于 AMD64 架构的 wheel 包。以下是几种有效方法:

方法一:通过文件名判断

查看 .whl 文件名末尾是否包含 win_amd64 。例如:

- ✅

jupyter_core-4.9.2-py3-none-any.whl—— 通用包,跨平台可用 - ✅

pyzmq-19.0.2-cp37-cp37m-win_amd64.whl—— 明确为 64 位 Windows 编译 - ❌

pyzmq-19.0.2-cp37-cp37m-win32.whl—— 仅适用于 32 位系统

方法二:使用 wheel 工具检查元信息

先安装 wheel 工具:

pip install wheel

然后解压并查看 WHEEL 元数据文件:

wheel unpack pyzmq-19.0.2-cp37-cp37m-win_amd64.whl

cat pyzmq-19.0.2.dist-info/WHEEL

输出内容应包含:

Wheel-Version: 1.0

Generator: bdist_wheel (0.33.6)

Root-Is-Purelib: false

Tag: cp37-cp37m-win_amd64

其中 Tag 字段明确指出了适用平台。

方法三:编程方式提取标签

from packaging.utils import parse_wheel_filename

filename = "pandas-1.1.5-cp37-cp37m-win_amd64.whl"

name, version, build, tags = parse_wheel_filename(filename)

print(f"Name: {name}")

print(f"Version: {version}")

print(f"Platform Tag: {list(tags)[0].platform}") # 输出: win_amd64

参数说明:

- parse_wheel_filename 来自 packaging 库,是官方推荐的 wheel 名称解析工具。

- 返回值中的 tags 是一个集合,通常只有一个元素,包含完整的 tag 信息。

- platform 属性即为目标平台标识。

该方法可用于自动化脚本中批量过滤非 win_amd64 包。

3.2 Windows系统下Jupyter运行环境搭建难点

尽管 Windows 是全球使用最广泛的桌面操作系统,但其在开发环境配置方面仍存在若干历史遗留问题。特别是在部署像 Jupyter 这样依赖多层级库调用的复杂系统时,路径管理、权限控制和运行时依赖等问题尤为突出。

3.2.1 路径分隔符与环境变量配置差异

Windows 使用反斜杠 \ 作为路径分隔符,而大多数编程语言(包括 Python)默认使用正斜杠 / 或接受两者混用。然而,在 shell 脚本、批处理文件或配置文件中处理路径时容易出现转义问题。

例如,以下代码在 Windows 上可能出错:

path = "C:\Users\John\Documents\data.csv"

由于 \U , \J , \D 被解释为转义字符,导致 SyntaxError 或路径错误。

正确做法是使用原始字符串或双反斜杠:

path = r"C:\Users\John\Documents\data.csv" # 推荐

# 或

path = "C:\\Users\\John\\Documents\\data.csv"

此外,环境变量 PATH 的配置也常成为问题源头。许多用户在安装 Python 时未勾选“Add Python to PATH”,导致命令行无法识别 python 和 pip 命令。

解决方案是在系统设置中手动添加:

C:\Python37\

C:\Python37\Scripts\

可通过 PowerShell 验证:

$env:PATH -split ';' | Select-String "Python"

若无输出,则需重新配置。

3.2.2 权限管理与程序安装目录限制(Program Files)

Windows 对 C:\Program Files 和 C:\Program Files (x86) 目录实施严格的写入权限控制,普通用户进程无法直接修改其中内容。如果 Python 安装在此目录下, pip install 可能因缺乏权限而失败。

常见错误提示:

PermissionError: [WinError 5] Access is denied

解决策略:

-

避免将 Python 安装在受保护目录

推荐安装路径:C:\Python37\或用户目录C:\Users\<User>\Python37\ -

以管理员身份运行命令提示符

若必须在Program Files中操作,右键“以管理员身份运行”CMD 或 PowerShell。 -

使用虚拟环境隔离安装路径

bash python -m venv myenv myenv\Scripts\activate pip install jupyter

所有包均安装在用户可写目录下,规避权限问题。

3.2.3 Microsoft Visual C++ Runtime依赖问题

许多 Python 扩展模块(尤其是科学计算库)是用 C/C++ 编写的,并链接到 Microsoft Visual C++ Redistributable 动态库(如 MSVCP140.dll )。若目标系统缺少相应运行时组件,会导致如下错误:

ImportError: DLL load failed: The specified module could not be found.

此类问题多发生在干净的 Windows 系统或服务器环境中。

解决方案:

- 下载并安装 Microsoft Visual C++ Redistributable for Visual Studio 2015–2022 (x64 版本)。

- 或使用静态链接的 Python 发行版(如 Anaconda),其已捆绑必要运行时。

可通过 Dependency Walker 或 dumpbin 工具诊断缺失的 DLL:

dumpbin /dependents C:\Python37\Lib\site-packages\numpy\core\_multiarray_umath.pyd

输出中若显示 MSVCP140.dll NOT FOUND ,则确认需补装运行时。

3.3 兼容性测试与问题诊断

在部署前进行充分的兼容性测试,是确保 Jupyter 成功运行的关键步骤。本节提供一套标准化诊断流程,帮助快速定位并修复潜在问题。

3.3.1 检测操作系统位数与Python解释器匹配情况

首先确认系统与 Python 是否均为 64 位:

import platform

print("OS Architecture:", platform.architecture())

print("Machine Type:", platform.machine())

print("System:", platform.system())

print("Python Version:", platform.python_version())

print("Platform:", platform.platform())

预期输出(64 位系统):

OS Architecture: ('64bit', 'WindowsPE')

Machine Type: AMD64

System: Windows

Python Version: 3.7.2

Platform: Windows-10-10.0.19041-SP0

若 Machine Type 显示 x86 或 i386 ,说明系统为 32 位;若 OS Architecture 为 32bit 而 Machine Type 为 AMD64 ,则可能是 32 位 Python 安装在 64 位系统上。

3.3.2 查看pip安装日志判断是否获取正确架构包

启用详细日志有助于排查包匹配问题:

pip install --no-index -f ./packages jupyter -v

关注输出中的以下字段:

Skipping link: not your platform: file:///.../package.win32.whl

Found link file:///.../package.win_amd64.whl, version: 1.0.0

Using version 1.0.0 (newest of versions: 1.0.0)

若看到大量 Skipping link 记录,说明 pip 正在跳过不匹配平台的包。

3.3.3 处理“not a supported wheel on this platform”错误

此错误的根本原因是当前 Python 环境不支持所尝试安装的 wheel 包的平台标签。

排查步骤:

-

检查 Python 架构:

python import sys, platform print(sys.maxsize > 2**32) # True 表示 64 位 print(platform.platform()) # 查看完整平台信息 -

检查 wheel 标签:

bash wheel tags package.whl -

强制重命名(仅临时测试):

bash rename old_package.win32.whl temp_package-any.whl pip install temp_package-any.whl

⚠️ 不推荐生产环境使用,可能导致运行时崩溃。

3.4 实践操作:在Windows AMD64上部署纯净Jupyter环境

本节提供完整操作指南,指导用户从零开始在一个标准 Windows 10 AMD64 系统上部署独立、可控的 Jupyter 环境。

3.4.1 下载并安装适用于AMD64的Python 3.7.2发行版

- 访问 Python 官方归档页

- 下载

python-3.7.2-amd64.exe - 安装时务必勾选:

- ☑ Add Python 3.7 to PATH

- ☑ Install for all users(建议取消,避免权限问题)

- 自定义安装路径为C:\Python37\

验证安装:

python --version

pip --version

3.4.2 配置PATH环境变量确保命令行可访问python与pip

打开“系统属性 → 高级 → 环境变量”,在“用户变量”中添加:

Path = %Path%;C:\Python37;C:\Python37\Scripts

重启 CMD 后再次验证命令可用性。

3.4.3 初始化Jupyter配置文件并设置默认浏览器启动行为

创建独立虚拟环境:

python -m venv jupyter_env

jupyter_env\Scripts\activate

pip install jupyter

生成配置文件:

jupyter notebook --generate-config

编辑 %USERPROFILE%\.jupyter\jupyter_notebook_config.py ,添加:

c.NotebookApp.browser = 'chrome'

c.NotebookApp.ip = 'localhost'

c.NotebookApp.port = 8888

c.NotebookApp.open_browser = True

启动服务:

jupyter notebook

成功启动后将在 Chrome 浏览器打开 http://localhost:8888

| 步骤 | 操作 | 验证方式 |

|---|---|---|

| 1 | 安装 Python 3.7.2 AMD64 | python --version |

| 2 | 配置 PATH | where python |

| 3 | 创建虚拟环境 | venv\Scripts\activate |

| 4 | 安装 Jupyter | jupyter --version |

| 5 | 生成并修改配置 | 检查 .jupyter 目录 |

| 6 | 启动服务 | 浏览器能否打开 UI |

flowchart LR

A[下载 python-3.7.2-amd64.exe] --> B[安装至 C:\Python37]

B --> C[配置 PATH]

C --> D[创建 venv]

D --> E[激活环境]

E --> F[安装 Jupyter]

F --> G[生成 config]

G --> H[启动 Notebook]

至此,已在 Windows AMD64 平台上成功建立一个干净、隔离且可定制的 Jupyter 开发环境,为后续离线安装与依赖管理奠定坚实基础。

4. 离线安装流程详解: pip install --no-index -f 命令应用

在现代企业级数据科学部署中,网络隔离已成为保障系统安全的标配策略。许多组织出于合规性、数据隐私或防火墙限制等原因,要求开发与运行环境必须处于无外网连接的“气隙”(air-gapped)状态。在此背景下,如何高效完成 Python 生态工具链的部署,尤其是像 Jupyter Notebook 这类依赖众多第三方库的复杂应用,成为运维和工程团队面临的现实挑战。传统的 pip install jupyter 依赖于在线访问 PyPI(Python Package Index),在断网环境下将直接失败。为此, pip 提供了强大的离线安装机制,其中核心指令 pip install --no-index -f ./packages jupyter 成为解决该问题的关键手段。

本章将深入剖析这一命令的技术内涵,从底层逻辑到实际操作,系统阐述其在真实场景中的完整应用路径。我们将不仅停留在语法说明层面,而是结合文件组织结构、依赖解析机制、错误排查方法等多维度展开讨论,并通过可复现的实战案例展示从准备阶段到最终验证的全流程。整个过程涵盖参数行为解析、本地仓库构建规范以及自动化部署思路延伸,旨在为具备五年以上经验的 IT 工程师提供一套可在生产环境中直接落地的解决方案。

4.1 离线安装的需求场景与技术挑战

随着 DevOps 和 MLOps 在企业中的普及,软件交付流程日益标准化。然而,在高度监管行业如金融、军工、医疗等领域,系统的安全性优先级远高于便捷性。这些环境中普遍实施严格的网络分区策略,禁止内部服务器访问公共互联网,导致常规的包管理方式失效。此时,任何外部依赖的引入都必须经过人工审核与离线传输,这就催生了对离线安装能力的刚性需求。

4.1.1 企业内网安全策略限制下的软件部署困境

大型企业的 IT 架构通常划分为多个安全区域:DMZ 区用于对外服务,内网区承载核心业务系统,而数据分析或模型训练节点则常位于受控子网中。此类子网往往仅允许白名单 IP 通信,且禁用 DNS 外联查询。当数据科学家需要使用 Jupyter Notebook 进行探索性分析时,若无法联网安装 jupyter , notebook , ipykernel 等基础组件,则工作根本无法启动。

更复杂的是,Jupyter 并非单一模块,它由多个子项目构成,包括:

-

jupyter_core: 核心配置与路径管理 -

jupyter-client: 内核通信协议实现 -

notebook: Web UI 与服务器逻辑 -

traitlets,jinja2,tornado: 关键依赖库

这些组件之间存在复杂的版本约束关系。例如, notebook>=6.0 要求 jinja2>=2.10 ,而旧版 tornado<6.0 可能不兼容 Python 3.7 的异步上下文变量。一旦某个依赖缺失或版本冲突,就会导致 ImportError 或运行时崩溃。

下表列出了 Jupyter 主要组件及其典型依赖项:

| 组件名称 | 最小版本要求 | 关键依赖 | 说明 |

|---|---|---|---|

| jupyter | 1.0.0 | jupyter-core, nbformat | 元包,触发其他安装 |

| notebook | 6.5.4 | tornado>=5.0, jinja2>=2.10 | Web 服务端主体 |

| ipykernel | 6.23.0 | ipython>=6.0 | Python 内核适配器 |

| tornado | 6.3.3 | certifi, typing-extensions | 异步 HTTP 框架 |

| jinja2 | 3.1.3 | MarkupSafe>=2.0 | 模板引擎 |

graph TD

A[jupyter] --> B[jupyter-core]

A --> C[nbformat]

A --> D[notebook]

D --> E[tornado]

D --> F[jinja2]

F --> G[MarkupSafe]

A --> H[ipykernel]

H --> I[ipython]

I --> J[traitlets]

该流程图清晰地展示了依赖拓扑结构。任何一个节点未能正确安装,都会导致上层组件无法加载。因此,离线部署不仅是“复制文件”,更是对依赖图谱的完整重建。

4.1.2 科研项目对外部网络依赖的规避要求

科研计算平台,特别是高性能计算集群(HPC),通常运行在封闭网络中以防止敏感实验数据泄露。研究人员可能需在没有公网访问权限的节点上搭建个人分析环境。此时,即便只是安装一个轻量级的交互式笔记本工具,也必须预先准备好所有必要的 .whl 或源码包。

此外,科研强调结果的可复现性(reproducibility)。如果某篇论文使用的 Jupyter 环境是在特定时间点从 PyPI 动态拉取的,那么未来其他人尝试复现时可能因包版本更新而导致行为差异。而通过离线包集合进行部署,可以确保每次安装的都是完全相同的二进制构件,极大增强了研究过程的稳定性与可信度。

4.1.3 教学机房批量部署效率优化需求

高校计算机实验室面临大量学生终端的统一配置任务。假设每台机器都需要单独联网执行 pip install jupyter ,不仅会占用大量带宽,还可能导致因网络波动引发部分安装失败。更为严重的是,不同学生设备可能下载到不同版本的依赖包——比如某些机器获取了新发布的 setuptools 版本,而另一些仍停留在旧版,从而造成环境不一致,影响教学进度。

采用离线安装方案后,管理员可在一台参考机上预下载所有必要包,打包成镜像或共享目录,然后通过局域网快速分发至所有客户端。这种“一次下载,全局复用”的模式显著提升了部署效率,同时也便于后续升级与维护。

上述三类场景虽背景各异,但共同指向同一个技术痛点: 如何在无网络条件下,准确、完整、可控地完成 Python 包的安装?

这正是 --no-index 与 -f 参数协同工作的价值所在。它们使 pip 从“在线搜索引擎”转变为“本地文件系统扫描器”,从而绕过网络请求,直接在指定目录中查找并安装可用的发行版文件。

4.2 --no-index 与 -f 参数协同工作机制

理解 pip install --no-index -f ./packages jupyter 的运作原理,关键在于掌握两个参数的功能边界及其交互逻辑。这两个参数共同改变了 pip 默认的行为模式,使其适应离线环境的要求。

4.2.1 禁用PyPI索引查询的行为解析

默认情况下,当你运行 pip install jupyter , pip 会执行以下步骤:

- 向

https://pypi.org/simple/jupyter/发起 HTTP 请求; - 解析返回的 HTML 页面,提取所有可用版本链接;

- 根据当前平台和 Python 版本筛选合适的发行格式(优先

.whl); - 下载选中的包并递归处理其依赖项。

这一流程严重依赖网络连通性和 PyPI 服务可用性。而 --no-index 参数的作用正是切断第一步——禁止访问任何远程索引源。

pip install --no-index jupyter

执行此命令时, pip 不再尝试连接 PyPI,而是立即报错:

Could not find a version that satisfies the requirement jupyter

原因显而易见:没有启用任何本地查找路径, pip 无处获取包信息。此时必须配合 -f (即 --find-links )参数,告诉 pip 应该去哪里搜索候选包。

4.2.2 指定本地查找路径(find-links)的目录组织规范

-f 参数用于指定一个或多个包含 Python 包文件的本地目录。 pip 会在这些目录中扫描所有符合命名规范的文件,并将其作为潜在安装源。

合法的包文件类型包括:

-

.whl:预编译的 wheel 文件,推荐使用 -

.tar.gz:源码压缩包,需本地编译 -

.zip:较少见,但也被支持

目录结构建议如下:

./packages/

├── jupyter-1.0.0-py2.py3-none-any.whl

├── notebook-6.5.4-py3-none-win_amd64.whl

├── ipykernel-6.23.0-py3-none-any.whl

├── tornado-6.3.3-cp37-cp37m-win_amd64.whl

├── jinja2-3.1.3-py3-none-any.whl

└── ...

每个文件名遵循 PEP 427 规范:

{distribution}-{version}(-{build tag})?-{python tag}-{abi tag}-{platform tag}.whl

例如:

- tornado-6.3.3-cp37-cp37m-win_amd64.whl

- cp37 : CPython 3.7

- cp37m : ABI 类型(含调试符号)

- win_amd64 : Windows 64位平台

pip 会根据当前解释器的环境自动匹配正确的架构标签。若文件名不匹配(如提供了 linux_x86_64 的包但在 Windows 上安装),则会被忽略。

4.2.3 支持多种文件类型(.whl, .tar.gz)的自动匹配机制

pip 在扫描 -f 目录时,会对所有文件进行分类识别。对于同一包的不同格式, pip 遵循优先级策略:

- 优先选择 wheel 文件 (

.whl):无需编译,安装速度快,完整性高。 - 其次考虑源码包 (

.tar.gz):需要调用setup.py build,依赖本地构建工具链(如 Visual Studio C++ 编译器)。

以下是典型匹配顺序示例(以安装 numpy 为例):

| 文件名 | 是否匹配 | 原因 |

|---|---|---|

| numpy-1.21.6-cp37-cp37m-win_amd64.whl | ✅ | 完全匹配 |

| numpy-1.21.6.tar.gz | ⚠️ | 源码包,仅当无合适 wheel 时使用 |

| numpy-1.21.6-cp38-cp38-win_amd64.whl | ❌ | Python 版本不符 |

| numpy-1.21.6-cp37-cp37m-linux_x86_64.whl | ❌ | 平台不匹配 |

为了提升成功率,建议提前下载目标平台专用的 win_amd64 wheel 包,避免现场编译带来的不确定性。

下面是一个实际使用的命令示例:

pip install --no-index -f ./packages jupyter

逐行解析如下:

pip install # 调用 pip 安装命令

--no-index # 禁用所有远程索引(包括 PyPI)

-f ./packages # 添加本地查找路径

jupyter # 指定要安装的目标包

执行过程中, pip 将:

- 扫描

./packages目录下所有文件; - 构建本地可用包的索引缓存;

- 解析

jupyter的元数据(METADATA或PKG-INFO); - 提取其依赖列表(Requires-Dist 字段);

- 在本地目录中递归查找每个依赖项的匹配版本;

- 若全部找到,则依次安装;否则报错退出。

该机制本质上实现了“离线依赖解析器”的功能,是企业级部署不可或缺的一环。

4.3 构建本地包仓库的完整流程

成功的离线安装离不开前期充分的准备工作。最关键的一步是构建一个完整的本地包仓库,包含目标软件及其所有递归依赖项。这个过程不能靠手动收集,而应借助自动化工具精确抓取。

4.3.1 提前下载所有依赖包及其递归依赖项

最可靠的方法是利用 pip download 命令,在有网络的“跳板机”上预先拉取所需包及其依赖树。该命令不会安装任何内容,仅下载文件到指定目录。

例如:

pip download --dest ./packages \

--platform win_amd64 \

--python-version 37 \

--only-binary=:all: \

jupyter

参数说明:

| 参数 | 作用 |

|---|---|

--dest ./packages | 指定下载目录 |

--platform win_amd64 | 设定目标平台 |

--python-version 37 | 指定 Python 主版本 |

--only-binary=:all: | 强制只下载 wheel,避免源码包 |

jupyter | 目标包名 |

此命令会自动递归下载 jupyter 所需的所有依赖包,并保存为适用于 Windows AMD64 + Python 3.7 的 wheel 文件。

⚠️ 注意:即使你当前运行的是 Linux 系统,只要指定了正确的

--platform和--python-version,pip也能跨平台下载对应架构的包。

4.3.2 使用pip download命令预获取指定版本包

在生产环境中,版本一致性至关重要。应避免使用最新版,而应锁定具体版本号。例如:

pip download --dest ./packages \

--platform win_amd64 \

--python-version 37 \

--only-binary=:all: \

"jupyter==1.0.0" \

"notebook==6.5.4" \

"ipykernel==6.23.0"

这样可确保无论何时何地执行安装,所用的都是同一组构件,杜绝“在我机器上能跑”的问题。

此外,还可结合 requirements.txt 实现批量下载:

# requirements-offline.txt

jupyter==1.0.0

notebook==6.5.4

ipykernel==6.23.0

matplotlib==3.5.3

pandas==1.5.3

执行:

pip download -r requirements-offline.txt \

--dest ./packages \

--platform win_amd64 \

--python-version 37 \

--only-binary=:all:

这是构建企业级离线包集合的标准做法。

4.3.3 组织本地文件夹结构以便于-f参数引用

合理的目录结构有助于管理和扩展。推荐采用分层组织方式:

/offline-repo/

├── python37/

│ └── win_amd64/

│ ├── jupyter/

│ │ ├── jupyter-1.0.0-py2.py3-none-any.whl

│ │ └── dependencies.txt

│ └── packages/ ← 可直接用于 -f

│ ├── notebook-6.5.4-py3-none-win_amd64.whl

│ ├── ipykernel-6.23.0-py3-none-any.whl

│ └── ...

└── logs/

└── download_20250405.log

同时保留下载日志和依赖清单,便于审计与版本追踪。

4.4 实战演练:从零开始完成Jupyter离线安装

现在进入实操环节。我们将在一台联网的 Windows 10 AMD64 机器上,准备 Jupyter 的离线安装包,并在另一台无网络的同类机器上完成安装。

4.4.1 准备包含jupyter、notebook、ipykernel的本地包集合

首先创建工作目录:

mkdir C:\offline-jupyter

cd C:\offline-jupyter

使用虚拟环境隔离操作:

python -m venv builder

builder\Scripts\activate

执行下载命令:

pip download jupyter notebook ipykernel ^

--dest packages ^

--platform win_amd64 ^

--python-version 37 ^

--only-binary=:all:

成功后, packages/ 目录应包含约 30+ 个 wheel 文件,覆盖全部依赖链。

4.4.2 执行 pip install --no-index -f ./packages jupyter 命令

将整个 C:\offline-jupyter\packages 文件夹复制到目标离线机器。

在目标机上打开命令提示符,激活对应的 Python 3.7.2 环境:

pip install --no-index -f ./packages jupyter

预期输出片段:

Looking in links: ./packages

Processing ./packages/jupyter-1.0.0-py2.py3-none-any.whl

Collecting notebook>=4.0.0

Using local directory: ./packages (showing 5 of 5 matches)

Processing ./packages/notebook-6.5.4-py3-none-win_amd64.whl

Installing collected packages: traitlets, jinja2, tornado, ipython, ipykernel, jupyter-client, nbformat, widgetsnbextension, notebook, jupyter

Successfully installed jupyter-1.0.0 notebook-6.5.4 ipykernel-6.23.0 ...

说明安装成功。

4.4.3 验证安装结果并启动Notebook服务

最后验证是否可用:

jupyter notebook --version

# 输出:6.5.4

jupyter kernelspec list

# 应显示 python3 内核

启动服务:

jupyter notebook --no-browser --port=8888

若能正常监听端口并生成 token,则证明离线安装完全成功。

整个流程形成闭环,为企业级部署提供了坚实基础。

5. pip包管理器参数解析: --no-index 与 --find-links

在现代软件开发与部署实践中,尤其是在企业级环境或科研项目中,网络受限、安全策略严格以及对可复现性的高要求使得依赖管理工具的行为控制变得尤为关键。Python 的官方包管理器 pip 提供了丰富的命令行参数以应对各种复杂场景,其中 --no-index 和 --find-links 是实现离线安装和本地依赖分发的核心机制。这两个参数不仅改变了 pip 默认从 PyPI 在线索引查找包的行为,还为构建可审计、可重复的本地包仓库提供了基础支撑。深入理解其工作机制、组合使用方式及潜在陷阱,是确保在无外网访问条件下成功部署 Python 环境的关键。

本章将系统剖析 --no-index 与 --find-links 的底层行为逻辑,结合实际案例说明它们如何协同工作,并通过代码示例、流程图与表格对比不同配置下的行为差异。此外,还将探讨高级技巧如依赖冲突处理、自动化脚本编写等,帮助读者掌握在隔离环境中高效、稳定地进行包管理的能力。

5.1 pip核心参数工作机制深度剖析

pip 作为 Python 生态中最广泛使用的包安装工具,默认行为是从 Python Package Index(PyPI)在线获取包信息并下载安装。这一过程依赖于索引服务器(通常是 https://pypi.org/simple),并通过解析依赖关系自动拉取所需的所有子包。然而,在许多生产或教学环境中,直接连接外部网络存在安全隐患或技术限制。为此, pip 提供了 --no-index 和 --find-links 参数来支持完全离线或半离线的安装模式。

5.1.1 默认行为:连接PyPI在线索引进行依赖解析

当执行如下命令时:

pip install jupyter

pip 会按照以下步骤操作:

- 向 PyPI 的

/simple/jupyter/路径发起 HTTP 请求,获取可用版本列表; - 根据当前 Python 版本和平台选择合适的

.whl或.tar.gz包; - 下载该包并递归解析其

setup.py或pyproject.toml中声明的依赖项; - 对每个依赖项重复上述流程,直到所有依赖都被满足。

这个过程虽然便捷,但高度依赖网络连通性和远程服务的稳定性。一旦网络中断或防火墙拦截,整个安装流程即告失败。

为了更清晰地展示默认流程,以下是一个 Mermaid 流程图:

graph TD

A[用户输入 pip install package] --> B{是否启用 --no-index?}

B -- 否 --> C[连接 PyPI 索引]

C --> D[获取包元数据]

D --> E[下载匹配的二进制/源码包]

E --> F[解析依赖列表]

F --> G{是否有未满足依赖?}

G -- 是 --> C

G -- 否 --> H[完成安装]

该流程体现了 pip 的“贪婪式”依赖解析策略——尽可能从中央索引获取最新兼容版本。但在受控环境中,这种灵活性反而可能引入不可预测的风险,例如意外升级某个库导致接口不兼容。

5.1.2 --no-index 如何切断网络请求并强制本地查找

--no-index 参数的作用是明确禁止 pip 访问任何远程索引(包括 PyPI 和其他自定义 index-url)。启用后, pip 将只依赖本地资源进行包查找。若未配合 --find-links 指定本地路径,则安装必然失败。

例如:

pip install --no-index jupyter

输出结果通常为:

ERROR: Could not find a version that satisfies the requirement jupyter

ERROR: No matching distribution found for jupyter

这是因为 --no-index 切断了所有网络查询,而没有提供替代的查找来源。

要使该命令生效,必须同时指定一个本地包目录,这正是 --find-links 的职责所在。

参数说明与行为特征

| 参数 | 作用 | 是否需要值 |

|---|---|---|

--no-index | 禁用所有包索引(如 PyPI) | 不需要 |

--find-links 或 -f | 指定额外的包查找位置(本地或URL) | 需要路径或URL |

值得注意的是, --no-index 并不会禁用 --find-links 所指向的链接;相反,它是“切换模式”的开关,告诉 pip :“不要去网上找,只在我给你的地方找”。

下面是一段演示性代码,用于验证 --no-index 的效果:

import subprocess

def test_no_index():

result = subprocess.run(

["pip", "install", "--no-index", "--dry-run", "numpy"],

capture_output=True,

text=True

)

if result.returncode != 0:

print("❌ 安装失败(预期):")

print(result.stderr)

else:

print("✅ 意外成功,检查环境是否有缓存?")

print(result.stdout)

test_no_index()

逐行逻辑分析:

- 第3–7行:定义函数

test_no_index(),模拟调用pip install --no-index numpy --dry-run。 - 第5行:使用

subprocess.run()执行外部命令,--dry-run表示仅模拟安装过程而不真正修改系统。 - 第6行:捕获标准错误输出,判断是否出现“无法找到包”的提示。

- 第8–10行:根据返回码判断执行结果。正常情况下应报错,表明

--no-index成功阻断了网络查找。

此代码可用于自动化测试环境中验证 pip 是否处于纯离线状态。

5.1.3 --find-links 参数支持的URL与路径格式(file://, 相对路径)

--find-links 支持多种地址格式,既可以是本地文件系统路径,也可以是局域网内的 HTTP 服务器地址。常见形式如下:

| 格式类型 | 示例 | 说明 |

|---|---|---|

| 相对路径 | -f ./packages | 当前目录下的 packages 文件夹 |

| 绝对路径 | -f C:\offline\wheels | Windows 绝对路径 |

| file URI | -f file:///D:/wheels | 显式使用 file:// 协议 |

| HTTP 地址 | -f http://intranet/wheels | 内部 Web 服务器 |

这些路径中存放的文件可以是 .whl (预编译二进制包)或 .tar.gz (源码包)。 pip 会扫描目录下所有符合命名规范的文件,并根据当前平台和 Python 版本筛选出可安装的候选包。

例如,假设我们在 ./local_wheels 目录中有以下文件:

./local_wheels/

├── jupyter-1.0.0-py3-none-any.whl

├── notebook-6.5.0-py3-none-any.whl

└── ipykernel-6.23.0-py3-none-win_amd64.whl

则可通过以下命令安装 Jupyter:

pip install --no-index -f ./local_wheels jupyter

此时 pip 的行为如下:

- 忽略 PyPI 索引(因

--no-index); - 扫描

./local_wheels目录中的所有.whl文件; - 构建本地可用包数据库;

- 解析

jupyter的依赖链(如notebook,traitlets,jinja2等); - 依次从本地目录中匹配并安装这些依赖。

⚠️ 注意事项:

- 若某个依赖缺失(如缺少

jinja2),即使它存在于全局已安装包中,pip仍会报错(除非使用--force-reinstall或--ignore-installed);- 包名和版本必须精确匹配,否则无法识别;

- 路径中不能包含空格或特殊字符,否则可能导致解析失败(尤其在 Windows 上)。

以下是一个用于生成合法 wheel 文件名的辅助函数:

def generate_wheel_filename(package_name, version, py_ver, platform):

"""生成标准 wheel 文件名"""

return f"{package_name}-{version}-py{py_ver}-none-{platform}.whl"

# 示例:生成适用于 Python 3.7 的 Windows AMD64 包

print(generate_wheel_filename("numpy", "1.21.6", "37", "win_amd64"))

# 输出:numpy-1.21.6-py37-none-win_amd64.whl

参数说明:

- package_name : 包名称(如 numpy )

- version : 版本号(遵循 PEP 440)

- py_ver : Python 版本(如 37 表示 3.7.x)

- platform : 平台标签(如 win_amd64 , linux_x86_64 )

该函数可用于批量重命名或校验本地仓库中包的命名合规性,避免因命名错误导致 pip 无法识别。

5.2 参数组合使用场景与最佳实践

在真实部署场景中,单独使用 --no-index 或 --find-links 往往不足以应对复杂的依赖结构。合理组合多个参数才能实现高效、可靠的离线安装。

5.2.1 多个本地源路径的叠加传递方式

有时,依赖包分散在多个目录中(如按功能分类存储)。 pip 允许通过多次使用 -f 来添加多个查找路径:

pip install --no-index \

-f ./core_packages \

-f ./data_analysis \

-f ./visualization \

jupyter pandas matplotlib

在这种模式下, pip 会合并所有目录中的包信息,形成统一的候选集。查找顺序为先入优先,但最终安装版本由依赖解析器决定(通常选最高兼容版本)。

建议采用统一目录结构管理离线包,例如:

/offline_repo/

├── python37/

│ ├── amd64/

│ │ ├── jupyter/

│ │ ├── numpy/

│ │ └── pandas/

│ └── noarch/

│ └── virtualenv/

└── requirements.txt

这样便于按版本和架构组织内容,提升维护效率。

5.2.2 结合 --prefer-binary 避免源码编译风险

某些包仅提供 .tar.gz 源码包,安装时需编译 C/C++ 扩展。在缺乏编译环境(如 Visual Studio Build Tools)的机器上极易失败。此时可启用 --prefer-binary 强制优先使用 .whl 文件:

pip install --no-index --find-links ./wheels --prefer-binary numpy

此参数指示 pip 在有 .whl 可用时绝不尝试构建源码包,极大提升了安装成功率。

5.2.3 使用 --no-deps 手动控制依赖安装顺序

对于大型项目,一次性安装所有依赖容易引发版本冲突。一种稳健做法是禁用自动依赖解析,手动逐个安装:

# 先安装低层依赖

pip install --no-index -f ./pkgs --no-deps numpy==1.21.6

pip install --no-index -f ./pkgs --no-deps scipy==1.7.3

# 再安装高层应用

pip install --no-index -f ./pkgs --no-deps pandas==1.3.5

这种方式牺牲便利性换取更强的控制力,特别适合需要锁定特定版本组合的科研或生产环境。

5.3 依赖解析冲突与解决方案

尽管 --no-index + --find-links 提供了强大的本地化能力,但仍面临依赖版本不一致、循环依赖等问题。

5.3.1 版本不一致引发的“missing package”问题

常见错误:

ERROR: Some packages could not be found:

numpy>=1.16.0 in ./wheels but found numpy-1.15.4-py3-none-win_amd64.whl

原因:本地包版本过低,无法满足新包的依赖要求。

解决方案:

- 使用 pip download --only-binary=all --platform win_amd64 --python-version 37 预下载指定架构和版本的包;

- 建立版本映射表,确保依赖层级一致。

5.3.2 循环依赖与过期包版本的手动干预策略

当两个包互为依赖时, pip 可能陷入死循环。此时应手动拆解依赖链,或使用 --break-system-packages (Python 3.12+)绕过限制。

5.3.3 利用 pip check 验证已安装包的一致性

安装完成后运行:

pip check

可检测是否存在版本冲突。理想输出为:

No broken requirements found.

否则会列出不满足的依赖项,便于修复。

5.4 进阶技巧:构建可复用的离线安装脚本

5.4.1 编写批处理脚本或PowerShell自动化安装流程

Windows 批处理示例( install_jupyter.bat ):

@echo off

set WHEELS_DIR=.\offline_wheels

set LOG_FILE=install.log

echo 开始离线安装 Jupyter... > %LOG_FILE%

for %%p in (numpy pandas matplotlib jupyter) do (

echo 安装 %%p...

pip install --no-index --find-links %WHEELS_DIR% --prefer-binary --no-deps %%p >> %LOG_FILE% 2>&1

)

echo 安装完成,请查看日志:%LOG_FILE%

该脚本能批量安装核心库,并记录全过程日志。

5.4.2 记录安装日志便于审计与故障回溯

始终启用日志记录:

pip install ... >> install.log 2>&1

便于后期排查问题。

5.4.3 封装为可分发的企业级部署工具包

最终可将整个环境打包为 ZIP 文件,包含:

- Python 运行时

- pip.conf 配置文件

- wheels/ 目录

- 自动化脚本

- 文档说明

通过 USB 或内网共享分发,实现“零配置”部署。

以上内容展示了 --no-index 与 --find-links 的完整应用体系,涵盖从基础机制到高级实战的各个层面,为构建可靠、可复制的离线 Python 环境提供了坚实的技术基础。

6. Jupyter Notebook依赖库管理(numpy、pandas、matplotlib等)

在现代数据科学工作流中,Jupyter Notebook 的强大不仅体现在其交互式计算能力上,更在于它能够无缝集成一系列高性能的数据处理与可视化工具。这些功能的实现,高度依赖于一组核心 Python 第三方库——如 numpy 、 pandas 、 matplotlib 等。这些库构成了数据分析生态系统的基石,而它们之间的依赖关系、版本兼容性以及安装策略,则直接影响着整个开发环境的稳定性与可复现性。尤其在离线部署场景下,如何系统化地管理这些库及其递归依赖项,成为构建可靠 Jupyter 工作区的关键挑战。

本章将深入剖析主流数据分析库的功能定位和相互作用机制,重点探讨在无网络连接环境下如何有效组织和安装这些库,并通过完整的实践流程展示从依赖分析到性能验证的全链路操作方案。我们将结合 pip 包管理器的高级参数使用,解析复杂的依赖树结构,并提供一套可复制的离线包集合构建方法。此外,还将介绍如何通过测试脚本验证各组件的运行状态,并对 Jupyter 本身的配置进行调优,以提升大规模数据运算时的响应效率。

6.1 核心数据分析库的功能定位与相互关系

6.1.1 numpy作为科学计算基础库的作用

numpy (Numerical Python)是所有高级数据分析库的技术底层支撑,其核心价值在于提供了高效的多维数组对象 ndarray 和基于此的向量化运算接口。与原生 Python 列表相比, numpy 数组在内存布局上连续存储,避免了指针跳转带来的性能损耗;同时借助底层 C 实现的数学函数库(如 BLAS、LAPACK),实现了矩阵乘法、傅里叶变换、随机采样等复杂运算的极致优化。

例如,在执行百万级浮点数加法时, numpy 可比纯 Python 循环快数十倍:

import numpy as np

import time

# 原生Python方式

start = time.time()

py_list = list(range(1_000_000))

result_py = [x + 1 for x in py_list]

print(f"Python list comprehension: {time.time() - start:.4f}s")

# Numpy向量化方式

start = time.time()

np_array = np.arange(1_000_000)

result_np = np_array + 1

print(f"Numpy vectorized operation: {time.time() - start:.4f}s")

逻辑分析与参数说明:

-

np.arange(1_000_000):创建一个长度为一百万的等差数组,步长为1。 -

+操作符被重载为逐元素加法,无需显式循环,由底层C代码并行处理。 - 执行结果通常显示

numpy耗时仅为列表推导的5%左右,体现出显著的性能优势。

| 特性 | 描述 |

|---|---|

| 内存效率 | 固定类型数组减少内存开销 |

| 运算速度 | 向量化操作避免解释器循环瓶颈 |

| 广播机制 | 支持不同形状数组间的自动对齐运算 |

| C/Fortran接口 | 可直接调用高性能数值库 |

graph TD

A[numpy] --> B[pandas]

A --> C[scipy]

A --> D[matplotlib]

B --> E[seaborn]

C --> F[statsmodels]

D --> G[plotly]

该流程图展示了 numpy 在整个科学计算生态系统中的中心地位。几乎所有上层库都直接或间接依赖于 numpy.ndarray 作为数据载体。因此,在离线环境中必须优先确保 numpy 的正确安装,否则后续库将无法导入。

6.1.2 pandas在数据清洗与结构化处理中的核心价值

pandas 构建在 numpy 之上,引入了两个关键数据结构: Series (一维带标签数组)和 DataFrame (二维表格型数据)。它极大简化了现实世界中非结构化、缺失值频繁出现的数据预处理任务。

以下是一个典型的数据清洗案例:

import pandas as pd

import numpy as np

# 模拟含噪声数据的CSV输入

data = {

'name': ['Alice', 'Bob', None, 'David', 'Eve'],

'age': [25, np.nan, 30, 35, 28],

'salary': ['50K', '70K', '60K', 'invalid', '80K']

}

df = pd.DataFrame(data)

# 数据清洗流程

df_clean = (df

.dropna(subset=['name']) # 删除姓名为空的行

.assign(age=lambda x: x['age'].fillna(x['age'].mean())) # 年龄均值填充

.assign(salary=lambda x: pd.to_numeric(x['salary'].str.replace('K', ''), errors='coerce')) # 转换薪资为数值

.dropna() # 清除转换失败的记录

)

print(df_clean)

逐行解读:

-

pd.DataFrame(data):构造初始 DataFrame; -

.dropna(subset=['name']):仅针对name列做空值过滤; -

.assign()链式调用实现列更新,保持函数式编程风格; -

pd.to_numeric(..., errors='coerce'):强制类型转换失败时返回NaN; - 最终得到干净且结构化的数据集。

| 方法 | 功能描述 |

|---|---|

fillna() | 缺失值填充策略(均值、前向填充等) |

groupby() | 分组聚合统计 |

merge() | 类似SQL的表连接操作 |

pivot_table() | 多维透视表生成 |

这一系列操作使得 pandas 成为数据科学家日常工作中最常使用的工具之一。然而,由于其依赖 numpy 和 python-dateutil 等多个子库,在离线安装时需确保所有依赖均已预置。

6.1.3 matplotlib与seaborn实现可视化表达

matplotlib 是 Python 中最基础的绘图库,提供类似 MATLAB 的命令式绘图接口。而 seaborn 则在其基础上封装了更高层次的统计图表 API,专注于美观且信息丰富的数据可视化。

下面对比两种绘图方式:

import matplotlib.pyplot as plt

import seaborn as sns

import numpy as np

# 生成示例数据

x = np.linspace(0, 10, 100)

y = np.sin(x) + np.random.normal(0, 0.1, size=x.shape)

# Matplotlib基础绘图

plt.figure(figsize=(8, 4))

plt.plot(x, y, label='Noisy Sine', color='blue')

plt.scatter(x[::10], y[::10], color='red', s=20, zorder=5)

plt.title("Sine Wave with Noise")

plt.xlabel("X"); plt.ylabel("Y")

plt.legend(); plt.grid(True)

plt.show()

# Seaborn高级统计图

sns.set_style("whitegrid")

sns.lineplot(data=pd.DataFrame({'x': x, 'y': y}), x='x', y='y', errorbar='sd')

plt.title("Seaborn Line Plot with Confidence Band")

plt.show()

参数说明:

-

figsize=(8, 4):控制图形尺寸; -

zorder=5:调整图层顺序,使散点位于折线上方; -

errorbar='sd':seaborn自动计算标准差并绘制置信区间; -

sns.set_style():统一视觉主题,提升可读性。

flowchart LR

RawData --> PandasDF

PandasDF --> MatplotlibPlot

PandasDF --> SeabornPlot

MatplotlibPlot --> Customize{Custom Styling?}

Customize -- Yes --> FinalFigure

Customize -- No --> FinalFigure

SeabornPlot --> FinalFigure

该流程图揭示了从原始数据到最终可视化的典型路径。无论使用哪种绘图工具,前置的数据准备阶段都离不开 pandas 和 numpy 的支持。因此,在离线环境中应按照“基础 → 中间层 → 上层”顺序依次安装这些库,以防因依赖缺失导致 ImportError 。

6.2 离线环境下第三方库的依赖链管理

6.2.1 分析jupyter[notebook]扩展功能所需附加包

尽管 jupyter 主包已包含基本服务组件,但启用完整功能(如富文本编辑、内核通信、文件管理)还需额外依赖若干子模块。可通过如下命令查看其完整依赖树:

pip install pipdeptree

pipdeptree -p jupyter

输出示例片段:

jupyter==1.0.0

- ipykernel [required: >=4.5.1, installed: 6.29.0]

- ipython [required: >=6.1, installed: 8.12.0]

- jedi [required: >=0.16, installed: 0.18.2]

...

- tornado [required: >=4.2, installed: 6.3.3]

- jupyter-console [required: >=6.1.0, installed: 6.6.3]

- nbconvert [required: >=5.5, installed: 7.16.1]

- nbformat [required: >=4.4, installed: 5.9.2]

- jsonschema [required: >=3.0, installed: 4.19.0]

- attrs [required: >=19.2.0, installed: 23.1.0]

...

上述依赖关系表明:安装 jupyter 实际会触发超过 50 个间接依赖包 的下载。若在网络受限环境中未提前准备这些包,安装过程极易中断。

为此,建议采用以下策略识别完整依赖清单:

from pkg_resources import WorkingSet, Requirement

def get_transitive_deps(package_name):

ws = WorkingSet()

dist = ws.by_key.get(package_name.lower())

if not dist:

raise ValueError(f"Package '{package_name}' not found")

deps = set()

stack = list(dist.requires())

while stack:

req = stack.pop()

try:

dep_dist = ws.find(req)

if dep_dist and dep_dist.key not in deps:

deps.add(dep_dist.key)

stack.extend(dep_dist.requires())

except Exception as e:

print(f"Warning: failed to resolve {req}: {e}")

return sorted(deps)

# 示例:获取pandas的全部依赖

print(get_transitive_deps('pandas'))

逻辑分析:

- 使用

pkg_resources.WorkingSet扫描当前已安装包; -

dist.requires()返回直接依赖列表; - 递归遍历直至无新依赖加入;

- 输出可用于生成

requirements.txt的精确包名列表。

6.2.2 解决Cython、numexpr等编译型依赖的预构建方案

部分库(如 numpy 、 pandas )包含用 Cython 编写的扩展模块,在源码安装时需要本地编译。但在大多数 Windows 系统中缺乏 Visual Studio 构建环境,极易导致安装失败。

解决方案是 优先使用预编译的 .whl 文件 ,其命名规范如下:

package_name-version-cp37-cp37m-win_amd64.whl

其中各字段含义:

| 字段 | 说明 |

|---|---|

cp37 | 对应 Python 3.7 |

cp37m | ABI 标签,表示CPython解释器 |

win_amd64 | 目标平台为 Windows 64位 |

可使用以下命令批量下载适用于 Python 3.7.2 + AMD64 的 wheel 包:

pip download pandas numpy matplotlib \

--python-version 37 \

--platform win_amd64 \

--only-binary=all \

--dest ./offline_packages

参数说明:

-

--python-version 37:指定目标 Python 版本; -

--platform win_amd64:限定操作系统架构; -

--only-binary=all:禁止源码包,强制获取 wheel; -

--dest:指定本地保存路径。

这样可确保所有包均为预编译二进制格式,避免现场编译需求。

6.2.3 处理间接依赖(transitive dependencies)的完整性校验

即使主包已下载,仍可能因缺少某个深层依赖而导致运行时报错。为此,需建立完整性校验机制。

推荐做法是编写自动化检查脚本:

import importlib

import sys

REQUIRED_LIBS = [

('numpy', '1.19.5'),

('pandas', '1.2.5'),

('matplotlib', '3.4.3'),

('seaborn', '0.11.2')

]

def check_library(lib_name, expected_version=None):

try:

mod = importlib.import_module(lib_name)

version = getattr(mod, '__version__', 'unknown')

status = 'OK' if expected_version is None or version == expected_version else f'Mismatch ({version})'

return True, status

except ImportError as e:

return False, str(e)

# 执行检查

print("Dependency Integrity Check:\n")

for name, ver in REQUIRED_LIBS:

ok, msg = check_library(name, ver)

print(f"[{'✓' if ok else '✗'}] {name}=={ver} → {msg}")

if not all(check_library(n,v)[0] for n,v in REQUIRED_LIBS):

sys.exit("ERROR: One or more dependencies are missing or mismatched.")

该脚本能帮助运维人员快速确认离线环境是否具备完整功能支持,防止“看似安装成功,实则无法运行”的陷阱。

6.3 实践指导:构建完整的数据分析离线包集合

6.3.1 列出常用库清单并按依赖层级排序

为便于管理,应将所有依赖按层级分类:

| 层级 | 库名 | 说明 |

|---|---|---|

| L1(基础) | numpy , python-dateutil , pytz | 科学计算与时间处理 |

| L2(中间) | pandas , scipy | 数据结构与统计模型 |

| L3(可视化) | matplotlib , seaborn , plotly | 图形渲染 |

| L4(交互) | jupyter , notebook , ipykernel | 运行环境 |

安装顺序应严格遵循此层级,防止依赖断裂。

6.3.2 使用requirements.txt定义精确版本约束

创建标准化的依赖声明文件:

# requirements-data-analysis.txt

numpy==1.19.5

pandas==1.2.5

matplotlib==3.4.3

seaborn==0.11.2

jupyter==1.0.0

notebook==6.4.8

ipykernel==6.29.0

然后在联网机器上执行:

pip download -r requirements-data-analysis.txt \

--dest ./offline_packages \

--platform win_amd64 \

--python-version 37 \

--only-binary=all \

--no-deps # 先下载主包

再补充依赖:

pip download -r requirements-data-analysis.txt \

--dest ./offline_packages \

--find-links ./offline_packages \

--no-index \

--only-binary=all

此两步法可确保主包与依赖共存于同一目录。

6.3.3 批量下载所有依赖项并验证完整性

最后验证包数量与哈希值:

import os

import hashlib

def sha256sum(filename):

h = hashlib.sha256()

with open(filename, "rb") as f:

while chunk := f.read(8192):

h.update(chunk)

return h.hexdigest()

package_dir = "./offline_packages"

print(f"Found {len(os.listdir(package_dir))} packages\n")

for pkg in sorted(os.listdir(package_dir)):

path = os.path.join(package_dir, pkg)

print(f"{pkg} | SHA256: {sha256sum(path)[:8]}...")

输出可用于建立校验清单,确保传输过程中未发生损坏。

6.4 安装后功能验证与性能调优

6.4.1 编写测试Notebook验证各库可用性

创建 test_environment.ipynb ,内容如下:

# Cell 1: Import Test

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

print("All libraries imported successfully!")

# Cell 2: Data Processing Test

df = pd.DataFrame(np.random.randn(1000, 4), columns=list('ABCD'))

df['category'] = np.random.choice(['X','Y','Z'], size=1000)

print("DataFrame created with shape:", df.shape)

# Cell 3: Visualization Test

plt.figure(figsize=(10, 4))

sns.boxplot(data=df[['A','B','C']])

plt.title("Boxplot of Random Data")

plt.show()

成功运行即证明环境完备。

6.4.2 测试大型数组运算与图表渲染性能

评估系统极限:

# 创建1GB大小的数组

big_arr = np.random.rand(10000, 10000)

%timeit np.dot(big_arr, big_arr.T[:100]) # 测量矩阵乘法耗时

若响应延迟过高,可考虑启用 OpenBLAS 加速。

6.4.3 调整Jupyter配置提升响应速度

修改 jupyter_notebook_config.py :

c.NotebookApp.tornado_settings = {

'compress_response': True

}

c.FileContentsManager.hide_globs = ['__pycache__', '*.pyc']

c.NotebookApp.iopub_data_rate_limit = 1000000 # 提高数据流速率

重启服务后可明显改善大数据输出的流畅度。

7. 数据分析场景下的Notebook实践应用

7.1 教学与科研中的交互式编程支持

Jupyter Notebook在教学和科研领域展现出极强的适应性,其核心优势在于将代码执行、结果展示与解释性文本无缝融合。教师或研究人员可以通过创建分步执行的单元格,逐步引导学习者理解复杂算法的实现逻辑。

例如,在讲解线性回归模型时,可采用如下结构化流程:

# 7.1.1 示例:线性回归教学片段

import numpy as np

import matplotlib.pyplot as plt

# 生成模拟数据

np.random.seed(42)

X = 2 * np.random.rand(100, 1)

y = 4 + 3 * X + np.random.randn(100, 1)

# 展示前5个样本

print("前5个数据点:")

for i in range(5):

print(f"X[{i}] = {X[i][0]:.2f}, y[{i}] = {y[i][0]:.2f}")

后续单元格可逐步引入最小二乘法公式推导(使用Markdown+LaTeX),并实现梯度下降算法:

# 梯度下降实现

eta = 0.1 # 学习率

n_iterations = 1000

m = 100

theta = np.random.randn(2,1) # 随机初始化参数

X_b = np.c_[np.ones((m,1)), X] # 添加偏置项

for iteration in range(n_iterations):

gradients = 2/m * X_b.T.dot(X_b.dot(theta) - y)

theta = theta - eta * gradients

print(f"拟合参数: 斜率={theta[1][0]:.2f}, 截距={theta[0][0]:.2f}")

这种“代码即文档”的模式极大提升了知识传递效率。学生不仅能运行代码观察输出,还可修改参数实时验证假设,强化对统计概念的理解。

此外, .ipynb 文件天然适合作为作业提交格式。教师可通过Nbgrader等工具自动批改,并保留完整的执行上下文,确保评分过程透明可复现。

科研人员则利用Notebook记录实验全过程——从数据预处理、特征工程到模型评估,每个步骤均可追溯。这不仅满足了学术研究对可重复性的严格要求,也为同行评审提供了完整的技术证据链。

7.2 项目报告整合:代码、输出与Markdown文档一体化

在实际数据分析项目中,传统工作流常面临“代码—图表—报告”三者割裂的问题。Jupyter通过原生支持富文本内容,实现了真正的端到端文档集成。

以一份销售趋势分析报告为例,可构建如下结构:

| 单元格类型 | 内容描述 |

|---|---|

| Markdown | 报告标题、背景介绍、业务目标 |

| Code | 加载 sales_data.csv 并进行缺失值处理 |

| Output | 显示 df.head() 与 df.info() 结果 |

| Markdown | 描述数据清洗策略及理由 |

| Code | 使用pandas进行时间序列聚合 |

| Output | 输出月度销售额折线图 |

| Markdown | 分析趋势变化原因,引用外部市场信息 |

关键代码示例如下:

# 数据加载与初步探索

import pandas as pd

df = pd.read_csv('data/sales_data.csv', parse_dates=['date'])

df.set_index('date', inplace=True)

# 输出基本信息

df.info()

df.resample('M')['revenue'].sum().plot(title="Monthly Revenue Trend")

plt.ylabel("Revenue (USD)")

plt.show()

结合Markdown编写分析结论:

根据上图可见,2023年Q4出现显著增长,推测与“黑色星期五”促销活动相关。进一步交叉验证显示,该期间广告投放预算增加37%,支持此判断。

最终,整个分析过程形成一个自包含的叙事逻辑: 问题提出 → 方法选择 → 执行过程 → 结果展示 → 结论推导 。这种集成式表达显著优于将代码片段复制粘贴至Word文档的传统做法。

7.3 单元格执行机制与富文本支持

Jupyter的单元格系统是其实现交互性的技术基石。每种单元格类型服务于特定目的:

- Code Cell :执行Python代码,输出结果(包括文本、图像、HTML)直接嵌入下方。

- Markdown Cell :支持标准Markdown语法,扩展支持LaTeX数学表达式与内联HTML。

LaTeX渲染示例:

### 贝叶斯定理公式:

$$ P(A|B) = \frac{P(B|A)P(A)}{P(B)} $$

其中:

- $P(A|B)$:后验概率

- $P(A)$:先验概率

此外,可通过以下方式增强表现力:

<!-- 嵌入音频说明 -->

<audio controls src="explanation.mp3">你的浏览器不支持audio标签</audio>

<!-- 插入本地图片 -->

<img src="images/model_architecture.png" width="600" alt="模型结构图">

执行顺序由用户显式控制,避免IDE中“全脚本运行”带来的状态混乱。开发者可反复调试某一段逻辑而不影响全局变量空间,尤其适合探索性数据分析(EDA)场景。

7.4 版本控制与多格式导出共享

尽管 .ipynb 文件为JSON结构,易于Git跟踪,但原始文件通常包含输出结果,易引发合并冲突。推荐工作流如下:

-

在提交前清除所有输出:

bash jupyter nbconvert --ClearOutputPreprocessor.enabled=True --inplace analysis.ipynb -

配置

.gitattributes文件统一处理策略:

*.ipynb filter=nbstripout -

使用

nbstripout等工具自动清理输出再提交。

导出功能支持多种格式,满足不同场景需求:

| 导出格式 | 使用场景 |

|---|---|

| HTML | 内部分享,保留交互图表 |

| 正式报告归档 | |

| Slides | 汇报演示(via RISE插件) |

| Python | 提取核心代码用于生产环境 |

常用命令:

# 导出为PDF(需安装TeX)

jupyter nbconvert --to pdf report.ipynb

# 导出为可执行脚本

jupyter nbconvert --to script data_pipeline.ipynb

在线分享可通过 GitHub 或 Nbviewer 实现。后者能优雅渲染笔记本内容,无需本地运行环境,极大提升协作效率。

graph TD

A[原始Notebook] --> B{是否含敏感输出?}

B -->|是| C[清除输出]

B -->|否| D[直接提交Git]

C --> D

D --> E[推送到远程仓库]

E --> F[Nbviewer生成公开链接]

F --> G[团队成员访问分析结果]

简介:Jupyter Notebook是一款广泛应用于数据科学、机器学习和数值计算的交互式Web工具,支持代码执行、文本说明、可视化和多媒体集成。本资源提供适用于Windows AMD64架构的Python 3.7.2版本Jupyter Notebook离线安装包,包含完整依赖项,支持无网络环境下的快速部署。通过pip命令本地安装,用户可在数据分析、教学演示和项目报告等场景中高效使用。本文深入介绍其核心功能、安装方法及典型应用场景,帮助用户全面掌握Jupyter Notebook的使用与管理。

&spm=1001.2101.3001.5002&articleId=153965682&d=1&t=3&u=4aac231d666d48fc81b50ded2d1a7f10)

877

877

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?