JAVA高频面试题

- 第一章:Kafka

- 第二章:Spring

- 第三章:并发编程

- 第四章:Map源码分析

- 第五章:MySql

- 第六章:Redis

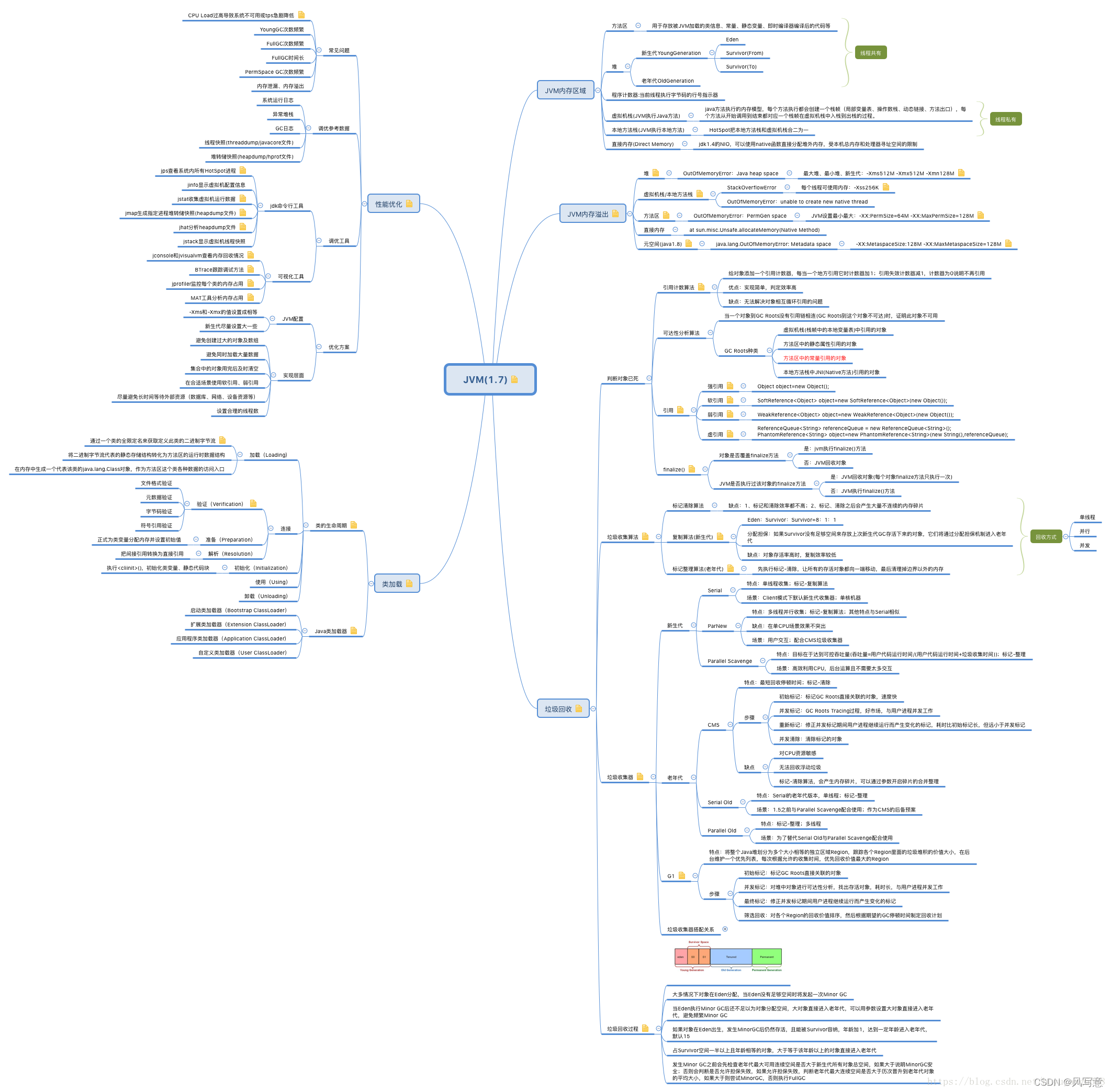

- 第七章:JVM

- 第八章:设计模式

- 第九章:ElasticSearch

- 第十章:SpringCloud

- 第十一章:基础

- 第十二章: 计算机网络

- 第十三章: 算法

第一章:Kafka

zookeeper在kafka中的作用?

1.各个broker相互独立,注册到zookeeper的临时节点znode上,即到/brokers/ids下创建属于自己的节点,如/brokers/ids/[0…N];若broker宕机,zookeeper收不到broker的心跳链接,会删除临时节点,监听zookeeper的生产者会感知到。

2.存储各个topic与partion与broker的分布情况;

/borkers/topics 节点保存着该broker节点下所有topic,每个topic还有各个partion子节点,每个partion还存放在state节点。state节点由该partion的leader节点创建,存放者可靠的从节点列表(ISR)和leader分区。leader宕机会删除state节点,直到选举完成创建新的state节点。

3.保证同一消费者组下只有一个消费者能消费到一个partion(消费者的负载均衡)

4.消费者组中的消费者宕机时的分区重分配

5.partion的主从选举

6.生产者负载均衡

7.kafka1.0版本记录了消息 消费进度Offset 记录,kafka2.0把消息 消费进度Offset 记录存放在一个专门的topic中(_consumer_offsets)

partition分配策略

手动为消费者指定partition列表

consumer.assign(partitions);

topic消息分配原则

public int partition(String topic, Object key, byte[] keyBytes, Object value, byte[] valueBytes, Cluster cluster) {

List<PartitionInfo> partitions = cluster.partitionsForTopic(topic);

int numPartitions = partitions.size();

if (keyBytes == null) {

int nextValue = counter.getAndIncrement();

List<PartitionInfo> availablePartitions = cluster.availablePartitionsForTopic(topic);

if (availablePartitions.size() > 0) {

//如果没有指定key值并且可用分区个数大于0时,在就可用分区中做轮询决定改消息分配到哪个partition。

int part = Utils.toPositive(nextValue) % availablePartitions.size();

return availablePartitions.get(part).partition();

} else {

//如果没有指定key值并且没有可用分区时,在所有分区中轮询决定改消息分配到哪个partition

// no partitions are available, give a non-available partition

return Utils.toPositive(nextValue) % numPartitions;

}

} else {

// hash the keyBytes to choose a partition

//如果指定key值,对key做hash分配到指定的partition。

//所以当同一个key的消息会被分配到同一个partition中。消息在同一个partition处理的顺序是FIFO,这就保证了消息的顺序性

return Utils.toPositive(Utils.murmur2(keyBytes)) % numPartitions;

}

}

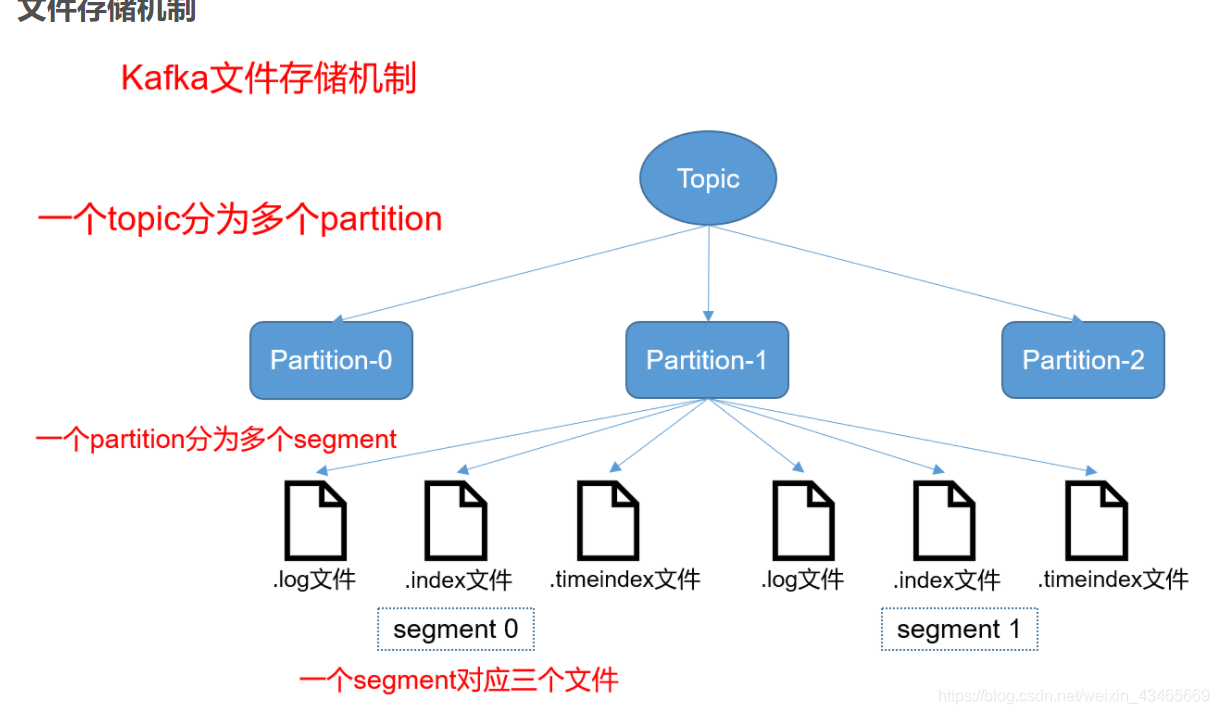

解释一下什么是partion

为了实现扩展性,提高并发能力,一个Topic以多个partion的形式分布在多个broker上,每个partion是个有序队列。一个Topic的每个partion都有一个leader和多个flower,生产者发送消息和消费者消费消息都只用leader,flower只负责数据同步。当leader宕机时,选举一个flower成为新的leader。

kafka消息丢失的场景与解决方案(生产者端)

1.ack设置为0;

就是只发送给broker,不管结果,发送下一条消息,效率最高(安恒使用这种方式);leader挂了还在发送数据

2.ack设置为1,leader宕机;

就是只发送给主节点,等待leader确认才发送下一条消息。此时如果leader宕机,flower来不及同步数据

3.unclear.leader.election.enable设置为true;

此参数默认为false,默认flower只从ISR列表中选举主机点。若设为true,且只发送给主节点就返回成功,leader宕机且此时ISR列表为空,选举OSR中的flower为主节点。由于OSR与主节点本来就落后太多版本号,数据不可靠。

4.broker的刷盘;

当我们把数据写入到文件系统之后,数据其实在操 作系统的page cache里面,并没有刷到磁盘上去。如果此时操作系统挂了,其实数据就 丢了

解决方式

设置ack=-1(即发送数据需要保证主节点和所有ISR列表中的flowe都确认才返回成功);unclean.leader.election.enable=false,只选举ISR;min.insync.replicas>1,即ISR列表中至少是2.失败的offset手动捕获异常到数据库,完成后续逻辑;减小刷盘间隔。

log.flush.interval.messages 在将消息刷新到磁盘之前,在日志分区上累积的消息数量

log.flush.interval.ms 在刷新到磁盘之前,任何topic中的消息保留在内存中的最长时间(以毫秒为单位)。如果未设置,则使用log.flush.scheduler.interval.ms中的值

log.flush.scheduler.interval.ms 日志刷新器检查是否需要将所有日志刷新到磁盘的频率

kafka消息丢失的场景与解决方案(消费者端)

1.自动提交offset;

即先commit再处理业务逻辑;处理业务逻辑时发生异常,这条消息再也消费不到了;

解决方式

手动提交偏移量,处理完业务逻辑再提交offset。但是如果处理完还没来得及提交就宕机了,重启之后会引发重复消费问题,此时需要保证接口幂等性。

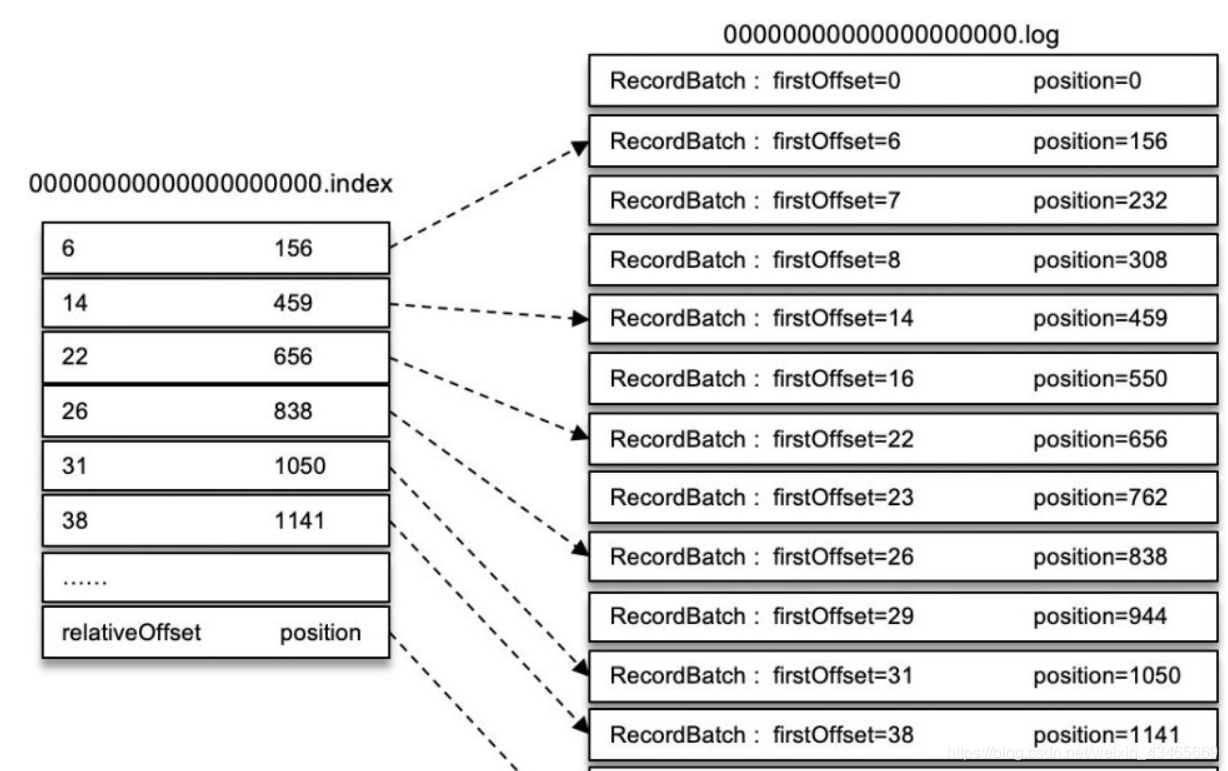

kafka如何通过offset查询到对应的数据

log文件就实际是存储 message 的地方,而 index 和 timeindex 文件为索引文件,用于检索消息。不同segment中log文件大小一致,但是message数量不一定一致(每条消息大小不一)。segment是个逻辑概念,xxxx.log的xxxx

指的是log文件中offset最小的值。000.index 存储offset为0~368795的消息,kafka就是利用分段+索引的方式来解决查找效率的问题。

Message结构

log 文件就是实际存储 message 的地方,在 producer 往 kafka 写入的也是一条一条的 message,消息主要包含消息体、消息大小、offset、压缩类型…等!主要是下面三个:

1、 offset:offset是一个占8byte的有序id号,它可以唯一确定每条消息在parition内的位置。

2、 消息大小:消息大小占用4byte,用于描述消息的大小。

3、 消息体:消息体存放的是实际的消息数据(被压缩过),占用的空间根据具体的消息而不一样。

存储策略

无论消息是否被消费,kafka都会保存所有的消息。那对于旧数据有什么删除策略?

1、 基于时间,默认配置是168小时(7天)。

2、 基于大小,默认配置是1073741824。

xxxx.index文件用来建立消息偏移量(offset)到物理地址之间的映射关系,方便快速定位消息所在的物理文件位置。xxxx.timeindex则根据指定的时间戳(timestamp)来查找对应的偏移量信息。Kafka 中的索引文件,以稀疏索引(sparse index)的方式构造消息的索引,它并不保证每个消息在索引文件中都有对应的索引项。每当写入一定量(由 broker 端参数 log.index.interval.bytes 指定,默认值为 4096,即 4KB)的消息时,偏移量索引文件 和 时间戳索引文件 分别增加一个偏移量索引项和时间戳索引项,增大或减小 log.index.interval.bytes 的值,对应地可以缩小或增加索引项的密度。

.index文件的偏移量是单调递增的,查询指定偏移量时,使用二分查找法来快速定位偏移量的位置,如果指定的偏移量不在索引文件中,则会返回小于指定偏移量的最大偏移量

以偏移量索引文件来做具体分析。偏移量索引项的格式如下图所示。

每个索引项占用 8 个字节,分为两个部分:

(1) relativeOffset: 相对偏移量,表示消息相对于 baseOffset 的偏移量,占用 4 个字节(relativeOffset = offset - baseOffset),当前索引文件的文件名即为 baseOffset 的值。

例如:一个日志片段的 baseOffset 为 32,那么其文件名就是 00000000000000000032.log,offset=35 的消息在索引文件中的 relativeOffset 的值为 35-32=3

(2) position: 物理地址,也就是消息在日志分段文件中对应的物理位置,占用 4 个字节。

上图就是稀疏索引图示。比如寻找offset为23的消息。

1、 先找到 offset=23 的 message 所在的 segment文件(利用二分法查找),先判断.index文件名称offset(baseOffset )是否小于23;

若小于,则继续二分与下一个.inde文件名称offset比较;

若大于,则返回上次小于3的.index文件,这里找到的就是在第一个segment文件。

2、找到的 segment 中的.index文件,用查找的offset 减去.index文件名的offset,也就是00000.index文件,我们要查找的offset为23的message在该.index文件内的索引为22(index采用稀疏存储的方式,它不会为每一条message都建立索引,而是每隔4k左右,建立一条索引,避免索引文件占用过多的空间。缺点是没有建立索引的offset不能一次定位到message的位置,需要做一次顺序扫描,但是扫描的范围很小)。

3、 根据找到的相对offset为22的索引,确定message存储的物理偏移地址为656。

4、 根据物理偏移地址,去.log文件找相应的Message,上下顺序扫描查找offset为23的message。

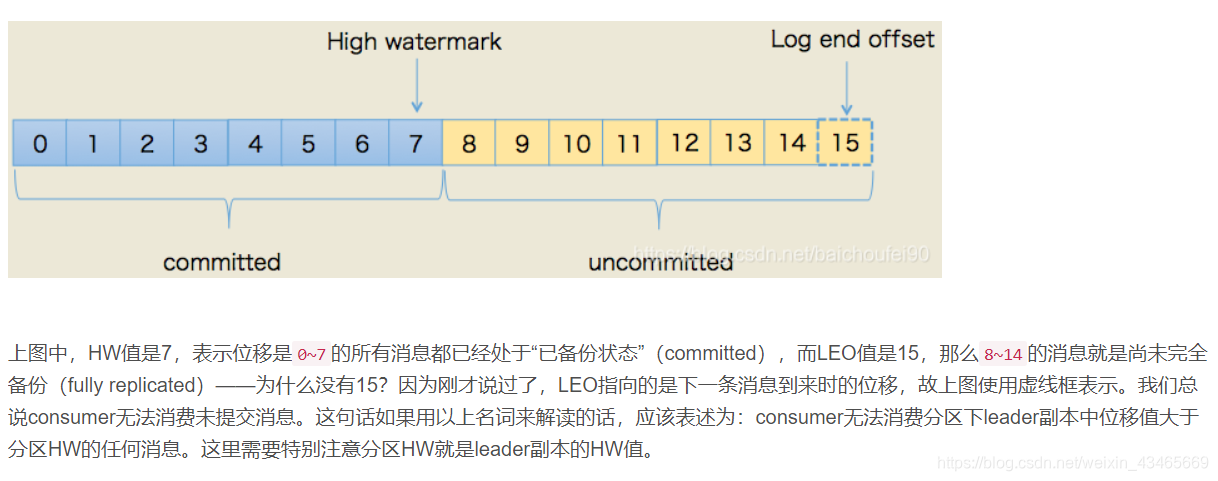

Kafka的HW机制

首先如果没有HW这个概念,一个分区的Leader副本中只要有消息了,就能够被消费者消费掉,那么就可能存在这样一个问题:消费者拉取到了一批Leader副本上面最新的消息之后,Leader副本所在机器宕机了,这批消息还没有同步到ISR集合中的其他机器上面。这时候消费者消费了消息,进行了偏移量提交,与此同时新选举出来的Leader副本,新写入了一批消息,就可能存在因为消息者消费了一批失败的消息,导致偏移量比预想中的大,进而导致新写入的这批消息将不能被消费掉,造成消息丢失。 这里,Kafka设置HW这样一个概念,这样就能避免上面列举情况下的消息丢失。因为根据HW的定义,我们知道HW机制严格保证了所有Broker上面某个唯一偏移量之前的消息是一样的。这样新写入的消息还不能被立即消费,及时这时候宕机了,偏移量最多也只能更新到HW代表的偏移量,这是新的Leader副本有消息写入,也能够从HW代表的偏移量开始消费,不会存在偏移量比预想中的大,导致消息不能被消费的情况发生。

kafka高性能的原因

1.顺序读写

kafka不基于内存,而是基于磁盘存储,因此消息堆积能力更强。

利用磁盘的顺序访问接近内存的速度,kafka的消息都是append操作,partion是有序的,大大节省了磁盘的寻道时间,同时利用批量插入,节省写入次数。partion在物理上分为多个segment,方便删除

2.零拷贝

传统写数据方式是:由于操作系统的限制,用户态和内核态需要切换才能交换数据。内核态线程读取磁盘文件到内核缓冲区,将内核缓冲区的数据copy到用户缓冲区,将用户缓冲区的数据发送到内核态的socket的发送缓冲区,将内核态的socket的发送缓冲区的数据发送到网卡,进行传输。

零拷贝技术是利用操作系统的指令直接把内核缓冲区的数据发送到网卡进行传输。需要操作系统支持,hbase等都采用了零拷贝技术

3.kafka不过度依赖jvm的内存(堆栈),读写数据这方面主要利用操作系统的pageCache,不利于堆内存。pageCache刷盘时间由操作系统决定。如果生产消费速度相当,则直接利用pageCache交换数据,不经过磁盘IO

kafka的rebalance机制

1.何时会发生rebalance?

消费者组中消费者数量改变;consumer消费超时;消费者组订阅的topic数量改变;消费者组订阅的topic的partion数量改变。

2.coordinator是什么?

协调者,partion的leader节点对应的broker,负责维持消费者组中消费者的存活情况,定期向coordinator心跳链接,判断consumer的消费超时情况。

rebalance过程:

a. 比如C1,C2,C3,C4三个消费者在同一个组,C1宕机,coordinator接收不到C1的心跳,通知C2,C3,C4进行rebalance(rebalance过程暂停读写)

b.C2,C3,C4请求加入coordinator,coordinator进行选举产生leader consumer

c.leader consumer从coordinator获取所有同一组下所有消费者,同步syncGroup(分配情况)到coordinator

d.coordinator通过心跳向所有consumer发送syncGroup

e.完成rebalance

f.leader consumer如果感知到topic数量变化/topic的partion数量变化,会通知coordinator进行rebalance

如果C1消费超时,coordinator进行rebalance,将这条消息交给了C2处理。此时C1消费完成提交偏移量,C2处理提交偏移量冲突,报错,kafka是如何解决的?

coordinator每次rebalance,会下发一个Generator(版本号)给消费者组,比如C1,C2,C3,C4的Generator为3,C1超时进行rebalance,下发C2,C3,C4的Generator为4,C1提交偏移量时不会成功,因为coordinator会校验Generator。

第二章:Spring

Spring启动流程

//refresh():543, AbstractApplicationContext (org.springframework.context.support)

public void refresh() throws BeansException, IllegalStateException {

synchronized (this.startupShutdownMonitor) {

//1 刷新前的预处理

prepareRefresh();

//2 获取BeanFactory;刚创建的默认DefaultListableBeanFactory

ConfigurableListableBeanFactory beanFactory = obtainFreshBeanFactory();

//3 BeanFactory的预准备工作(BeanFactory进行一些设置)

prepareBeanFactory(beanFactory);

try {

// 4 BeanFactory准备工作完成后进行的后置处理工作;

// 4.1)、抽象的方法,当前未做处理。子类通过重写这个方法来在BeanFactory创建并预准备完成以后做进一步的设置

postProcessBeanFactory(beanFactory);

/**************************以上是BeanFactory的创建及预准备工作 ****************/

// 5 执行BeanFactoryPostProcessor的方法;

//BeanFactoryPostProcessor:BeanFactory的后置处理器。在BeanFactory标准初始化之后执行的;

//他的重要两个接口:BeanFactoryPostProcessor、BeanDefinitionRegistryPostProcessor

invokeBeanFactoryPostProcessors(beanFactory);

//6 注册BeanPostProcessor(Bean的后置处理器)

registerBeanPostProcessors(beanFactory);

// 7 initMessageSource();初始化MessageSource组件(做国际化功能;消息绑定,消息解析);

initMessageSource();

// 8 初始化事件派发器

initApplicationEventMulticaster();

// 9 子类重写这个方法,在容器刷新的时候可以自定义逻辑;

onRefresh();

// 10 给容器中将所有项目里面的ApplicationListener注册进来

registerListeners();

// 11.初始化所有剩下的单实例bean;

finishBeanFactoryInitialization(beanFactory);

// 12.完成BeanFactory的初始化创建工作;IOC容器就创建完成;

finishRefresh();

}

catch (BeansException ex) {

if (logger.isWarnEnabled()) {

logger.warn("Exception encountered during context initialization - " +

"cancelling refresh attempt: " + ex);

}

// Destroy already created singletons to avoid dangling resources.

destroyBeans();

// Reset 'active' flag.

cancelRefresh(ex);

// Propagate exception to caller.

throw ex;

}

finally {

// Reset common introspection caches in Spring's core, since we

// might not ever need metadata for singleton beans anymore...

resetCommonCaches();

}

}

}

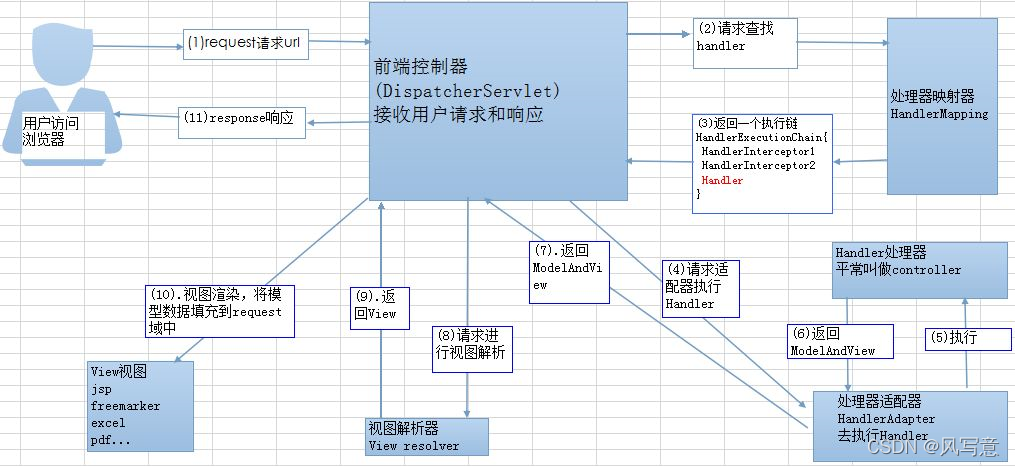

SpringMvc启动流程

FactoryBean和objectFactory

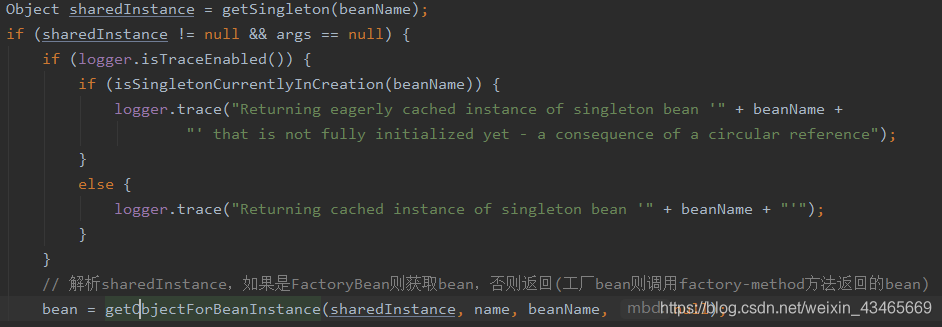

在DefaultSingletonBeanRegistry中getSingleton方法

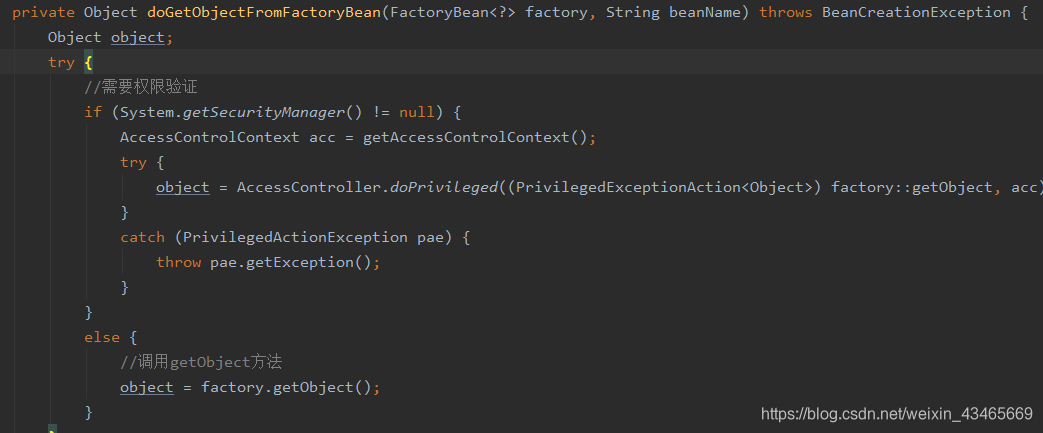

代码追踪到doGetObjectFromFactoryBean才发现创建bean

Feign的 FeignClientFactoryBean,mybatis-spring的MapperFactoryBean、SqlSessionFactoryBean 等都是扩展实现了Spring的FactoryBean接口,自定义了Bean的创建过程,通过动态代理为Feign接口、Mapper接口生成代理对象,底层屏蔽了很多复杂的Http连接、sql拼接等重复的业务逻辑,普通类很少使用factoryBean创建对象。

FactoryBean和beanFactory

BeanFactory是个Factory,也就是IOC容器或对象工厂,FactoryBean是个Bean。在Spring中,所有的Bean都是由BeanFactory(也就是IOC容器)来进行管理的。但对FactoryBean而言,这个Bean不是简单的Bean,而是一个能生产或者修饰对象生成的工厂Bean,它的实现与设计模式中的工厂模式和修饰器模式类似

循环依赖解决

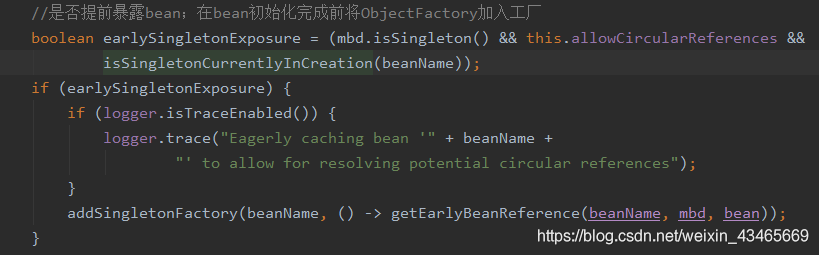

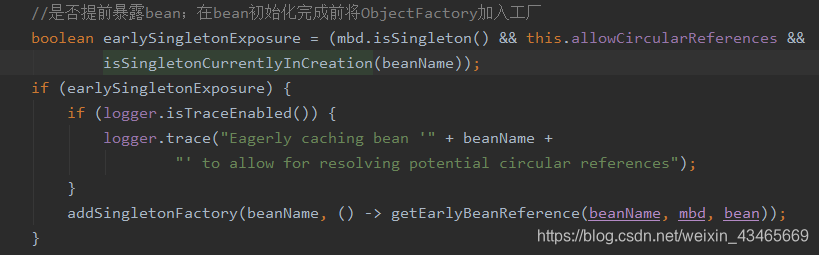

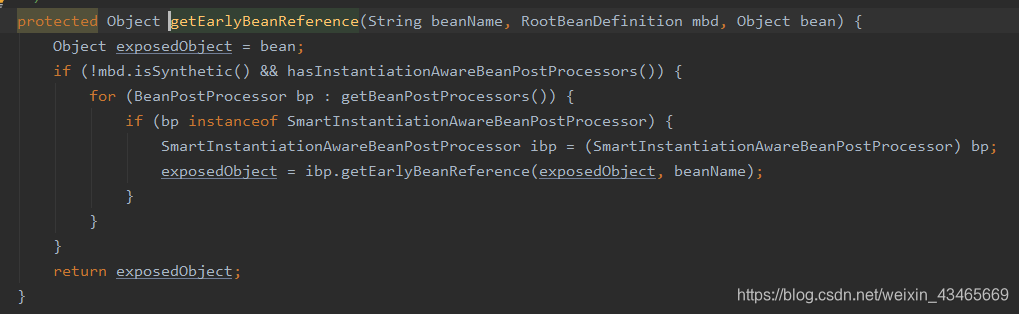

1.构造器循环依赖无法解决,setter循环依赖是通过spring容器提前暴露刚完成构造器注入但未完成其他步骤比如setter注入的bean来完成的,而且只能解决单例作用域的bean循环依赖,通过提前暴露一个单例工厂方法(ObjectFactory),从而使其他bean能引用到该bean

2.singletonObjects,earlySingletonObjects,singletonFactories,其中可不可以删除二级缓存,可不可以删除三级缓存

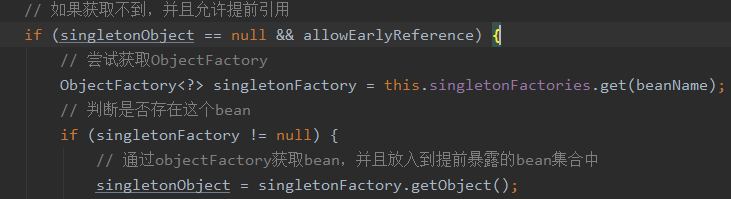

ObjectFactory的getObject方法只能被调用一次,不可以删除earlySingletonObjects,在下图中getObject方法可能被代理成新对象。第二次使用必须从earlySingletonObjects获取并删除singletonFactories暴露的ObjectFactory.

3.什么时候暴露的工厂?

存在循环依赖时才往二级缓存put

4.为什么暴露的是工厂而不是bean?

方便扩展

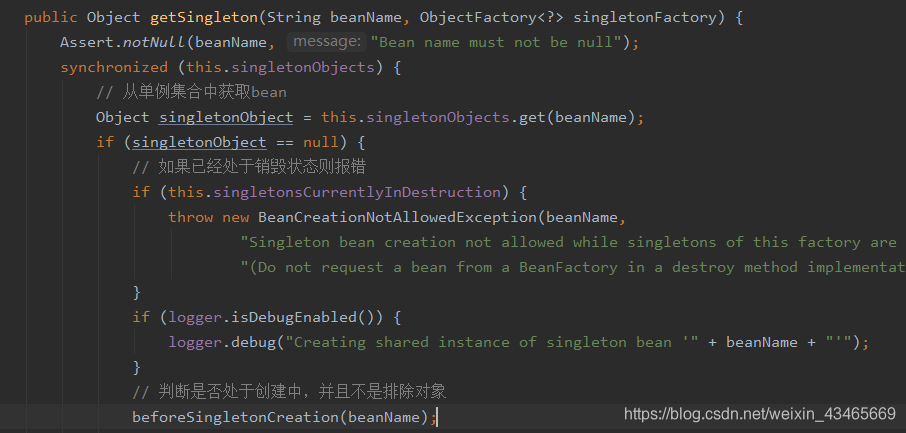

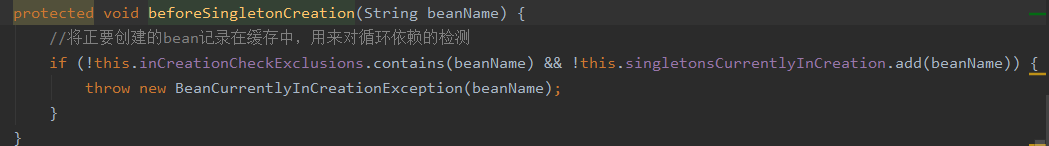

5.什么时候bean被加入singletonsCurrentlyInCreation?

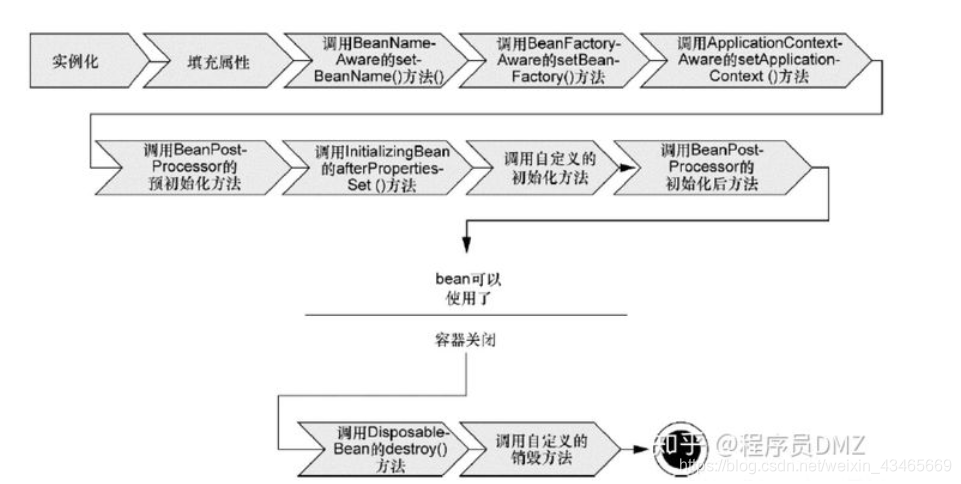

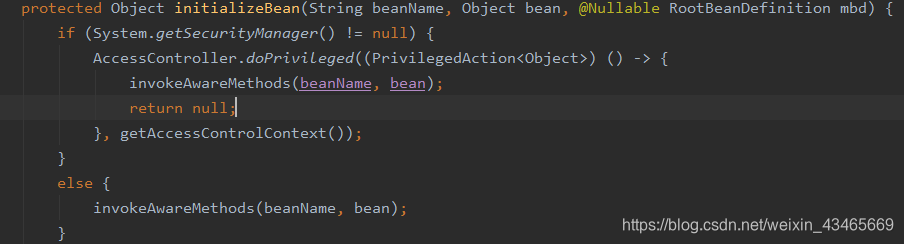

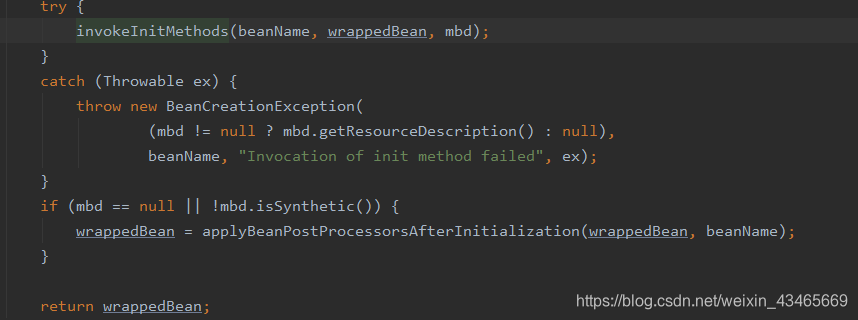

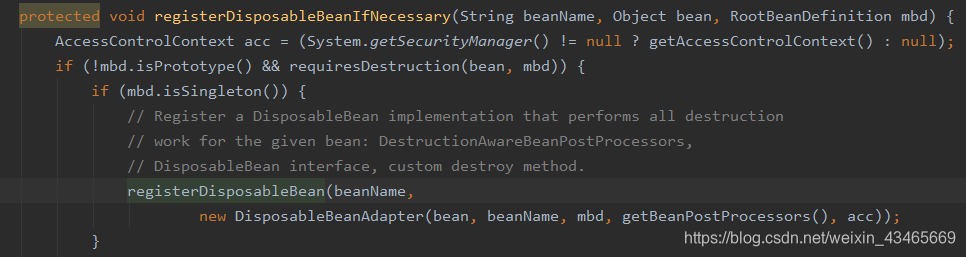

spring生命周期

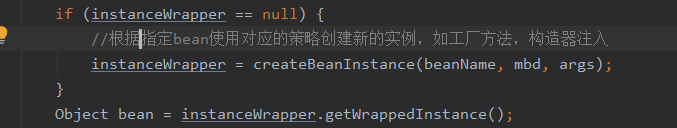

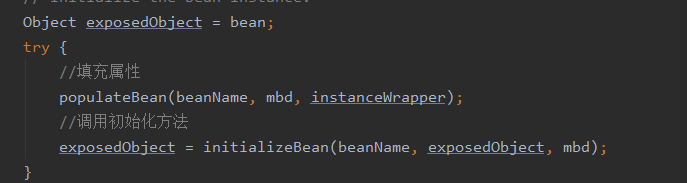

生命周期在AbstractAutowireCapableBeanFactory的doCreateBean方法进行

1.根据构造方法实例化

2.填充属性

3.执行Aware相关接口,注入一些资源(如ApplicationContextAware取得ApplicationContext实例)

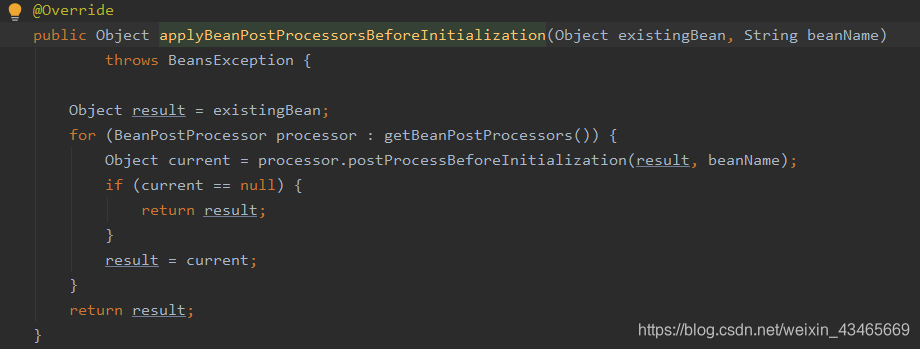

4.调用beanPostProcessord的postProcessorBeforeInitialization方法

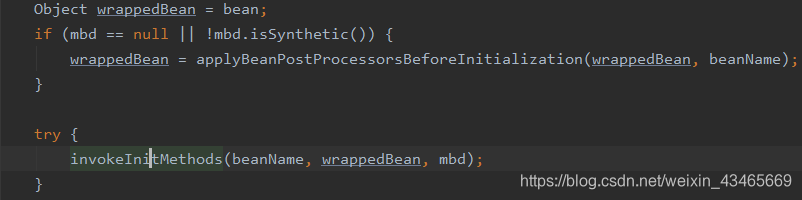

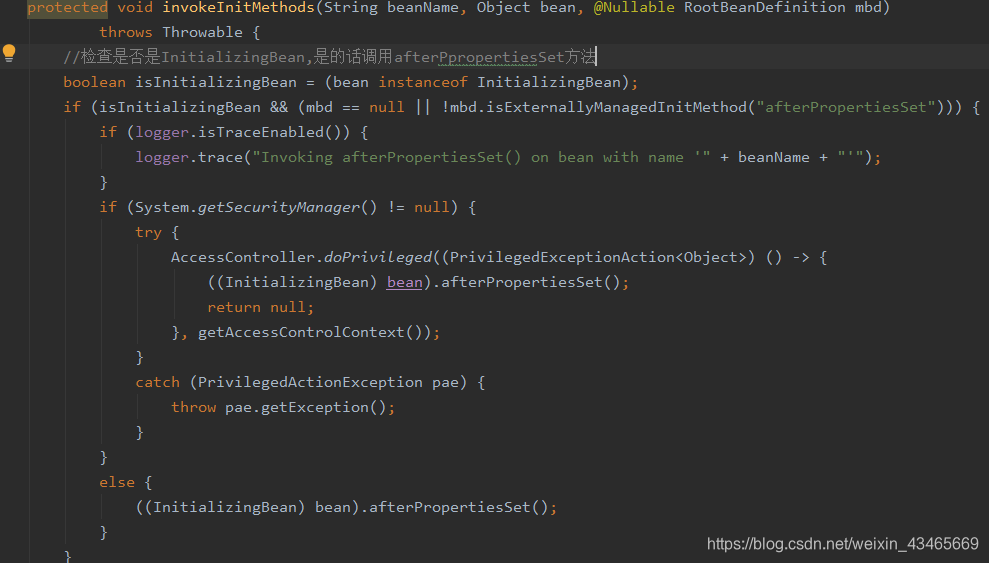

5.调用InitializingBean的afterPpropertiesSet方法

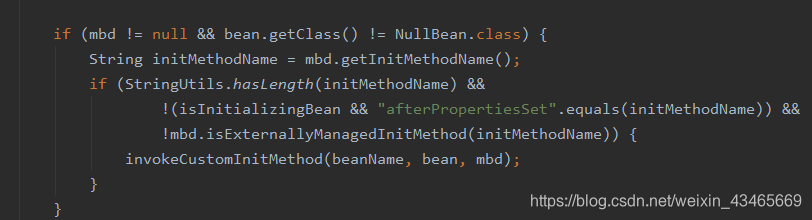

6.调用自定义的初始化方法

7.调用beanPostProcessord的postProcessorAfterInitialization方法

8.销毁

9.为什么Aware接口非要在初始化前执行呢?

这样做的目的是因为,初始化可能会依赖Aware接口提供的状态,例如下面这个例子

@Component

public class A implements InitializingBean, ApplicationContextAware {

ApplicationContext applicationContext;

@Override

public void afterPropertiesSet() throws Exception {

// 初始化方法需要用到ApplicationContextAware提供的ApplicationContext

System.out.println(applicationContext);

}

@Override

public void setApplicationContext(ApplicationContext applicationContext) throws BeansException {

this.applicationContext = applicationContext;

}

}

这种情况下Aware接口当然要在初始化前执行啦!

10.@PostConstruct,afterPropertiesSet跟XML中配置的init-method方法的执行顺序

@PostConstruct实际上是在postProcessBeforeInitialization方法中处理的,严格来说它不属于初始化阶段调用的方法,所以这个方法是最先调用的

其次我们思考下是调用afterPropertiesSet方法的开销大还是执行配置文件中指定名称的初始化方法开销大呢?我们不妨用伪代码演示下

// afterPropertiesSet,强转后直接调用

((InitializingBean) bean).afterPropertiesSet()

// 反射调用init-method方法

// 第一步:找到这个方法

Method method = class.getMethod(methodName)

// 第二步:反射调用这个方法

method.invoke(bean,null)

相比而言肯定是第一种的效率高于第二种,一个只是做了一次方法调用,而另外一个要调用两次反射。

因此,afterPropertiesSet的优先级高于XML配置的方式

所以,这三个方法的执行顺序为:

@PostConstruct注解标注的方法

实现了InitializingBean接口后复写的afterPropertiesSet方法

XML中自定义的初始化方法

spring作用域

当定义一个 在Spring里,我们还能给这个bean声明一个作用域。它可以通过bean 定义中的scope属性来定义。如,当Spring要在需要的时候每次生产一个新的bean实例,bean的scope属性被指定为prototype。另一方面,一个bean每次使用的时候必须返回同一个实例,这个bean的scope 属性 必须设为 singleton。

Spring框架支持以下五种bean的作用域:

1.singleton : bean在每个Spring ioc 容器中只有一个实例。

2.prototype:一个bean的定义可以有多个实例。

3.request:每次http请求都会创建一个bean,该作用域仅在基于web的Spring ApplicationContext情形下有效。

4.session:在一个HTTP Session中,一个bean定义对应一个实例。该作用域仅在基于web的Spring ApplicationContext情形下有效。

5.global-session:在一个全局的HTTP Session中,一个bean定义对应一个实例。该作用域仅在基于web的Spring ApplicationContext情形下有效。

注意: 缺省的Spring bean 的作用域是Singleton。使用 prototype 作用域需要慎重的思考,因为频繁创建和销毁 bean 会带来很大的性能开销。

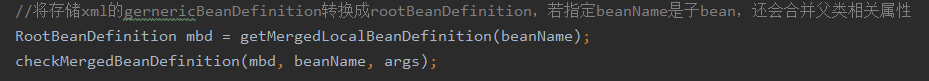

简述BeanDefinition

1.一个接口,定义了bean的描述信息(是否懒加载,作用域等等)

2.AbstractBeanFactory类中doGetBean合并成RootBeanDefinition

3.

后置处理器

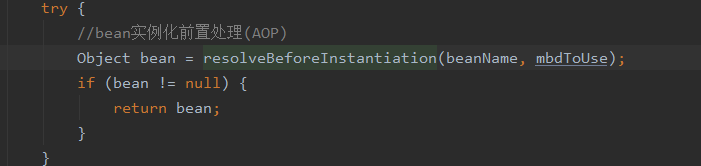

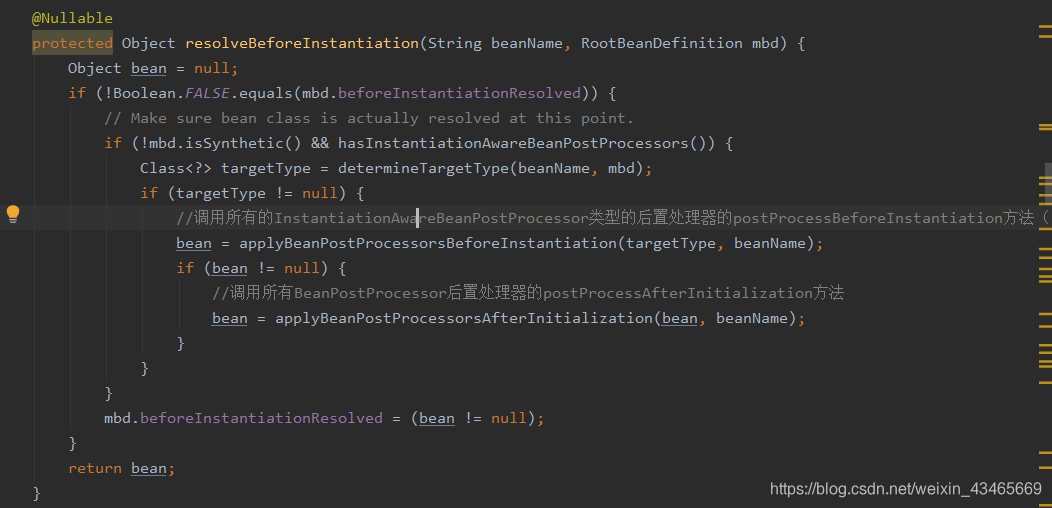

1.在createBean方法中InstantiationAwareBeanPostProcessor

动态代理

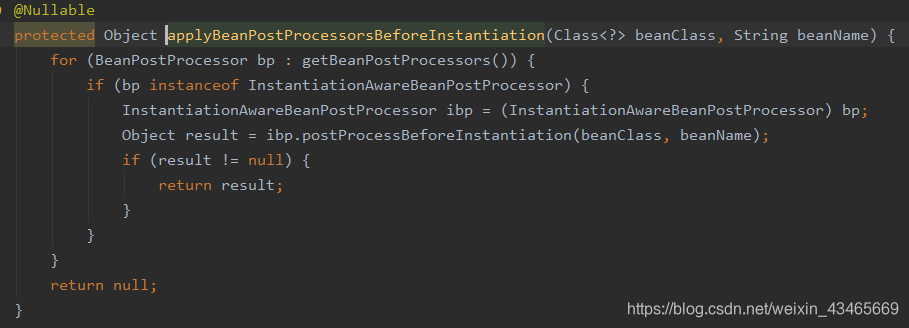

1.spring有几种代理实现方式,什么情况使用什么机制代理?

2.实例化策略

beanDefinition.getMethodOverrides反映了是否配置了replace或lookup方法,配置了就需要使用动态代理将包含两个特性所对应的逻辑的拦截增强器设置进去,才能保证方法被调用时会被相应的拦截增强器增强。

3.AOP实现的关键在于 代理模式,AOP代理主要分为静态代理和动态代理。静态代理的代表为AspectJ;动态代理则以Spring AOP为代表。

(1)AspectJ是静态代理的增强,所谓静态代理,就是AOP框架会在编译阶段生成AOP代理类,因此也称为编译时增强,他会在编译阶段将AspectJ(切面)织入到Java字节码中,运行的时候就是增强之后的AOP对象。

(2)Spring AOP使用的动态代理,所谓的动态代理就是说AOP框架不会去修改字节码,而是每次运行时在内存中临时为方法生成一个AOP对象,这个AOP对象包含了目标对象的全部方法,并且在特定的切点做了增强处理,并回调原对象的方法。

4.JDK动态代理和CGLIB动态代理的区别

JDK动态代理只提供接口的代理,不支持类的代理。核心InvocationHandler接口和Proxy类,InvocationHandler 通过invoke()方法反射来调用目标类中的代码,动态地将横切逻辑和业务编织在一起;接着,Proxy利用 InvocationHandler动态创建一个符合某一接口的的实例, 生成目标类的代理对象。

如果代理类没有实现 InvocationHandler 接口,那么Spring AOP会选择使用CGLIB来动态代理目标类。CGLIB(Code Generation Library),是一个代码生成的类库,可以在运行时动态的生成指定类的一个子类对象,并覆盖其中特定方法并添加增强代码,从而实现AOP。CGLIB是通过继承的方式做的动态代理,因此如果某个类被标记为final,那么它是无法使用CGLIB做动态代理的。

beanFatoryPostProcessor和beanPostProcessor

Spring IoC容器允许BeanFactoryPostProcessor在容器实例化任何bean之前读取bean的定义(配置元数据),并可以修改它。同时可以定义多个BeanFactoryPostProcessor,通过设置’order’属性来确定各个BeanFactoryPostProcessor执行顺序。

注册一个BeanFactoryPostProcessor实例需要定义一个Java类来实现BeanFactoryPostProcessor接口,并重写该接口的postProcessorBeanFactory方法。通过beanFactory可以获取bean的定义信息,并可以修改bean的定义信息。这点是和BeanPostProcessor最大区别,postProcessorBeanFactory方法执行顺序先于BeanPostProcessor接口中方法。

BeanPostProcessor接口有postProcessBeforeInitialization和postProcessAfterInitialization方法对bean扩展。

BeanFactory和ApplicationContext对待bean的后置处理器不同点:

1.ApplicationContext容器会自动检测Spring配置文件中那些bean所对应的Java类实现了BeanPostProcessor

接口,并自动把它们注册为后置处理器。在创建bean过程中调用它们,所以部署一个后置处理器跟普通的bean没有什么太大区别。

2.BeanFactory容器注册bean后置处理器时必须通过代码显示的注册,在IoC容器继承体系中的ConfigurableBeanFactory接口中定义了注册方法

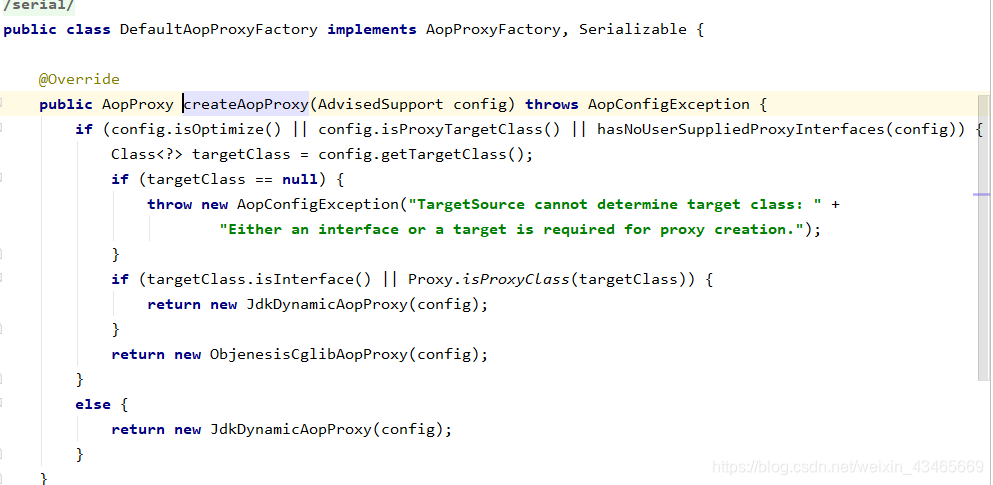

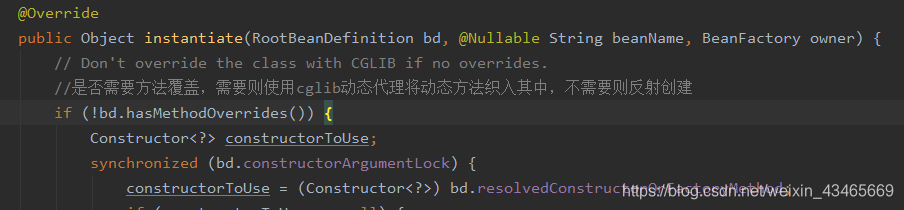

bean的实例化过程

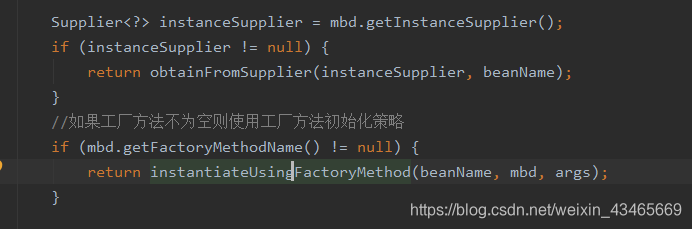

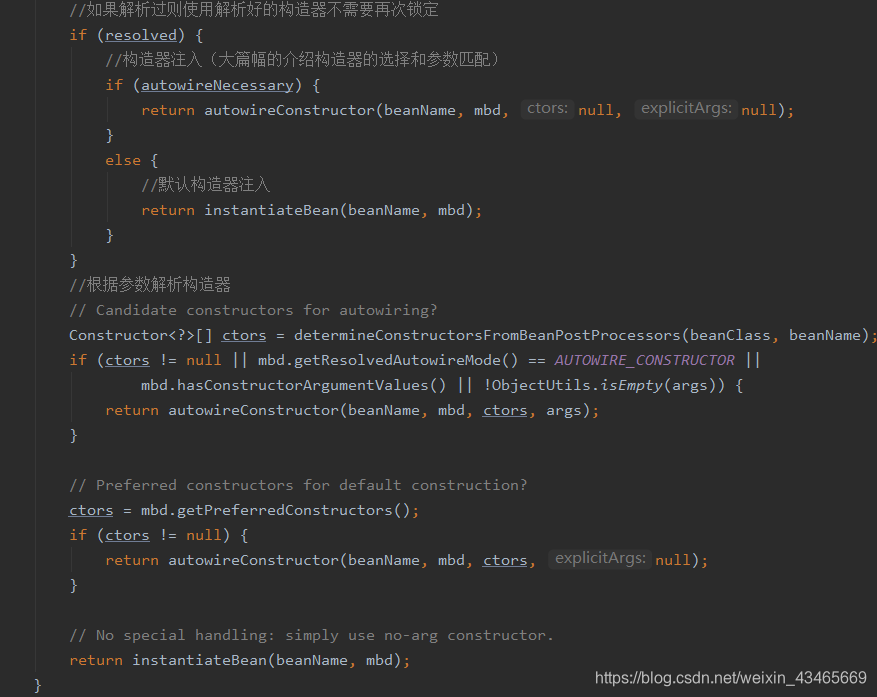

1.如果beanDefintion有指定工厂方法

2.解析构造函数(判断使用那个构造函数消耗性能,采用缓存机制)

若解析过放到beanDefinition的resolvedConstructorOrFactoryMethod属性中

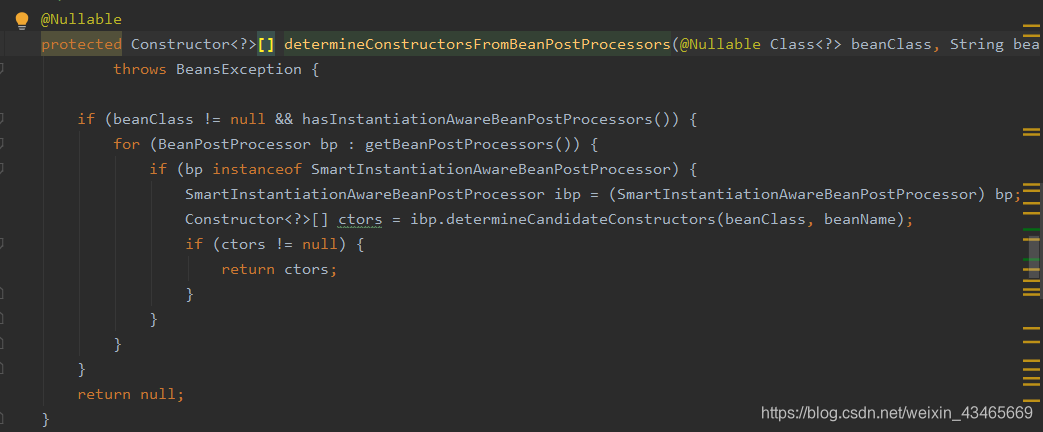

3.缓存中没有,没解析过,解析构造函数(SmartInstantiationAwareBeanPostProcessor)

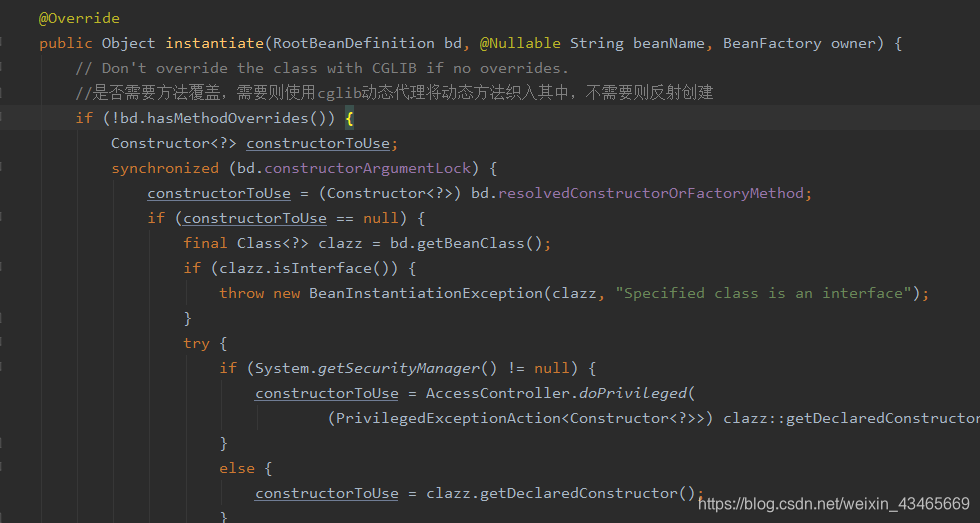

4.实例化过程判断有无cglib代理

getBean方法流程图

循环依赖流程图

Spring事务

Spring 隔离级别

spring 有五大隔离级别,默认值为 ISOLATION_DEFAULT(使用数据库的设置),其他四个隔离级别和数据库的隔离级别一致:

ISOLATION_DEFAULT:用底层数据库的设置隔离级别,数据库设置的是什么我就用什么;

ISOLATION_READ_UNCOMMITTED:未提交读,最低隔离级别、事务未提交前,就可被其他事务读取(会出现幻读、脏读、不可重复读);

ISOLATION_READ_COMMITTED:提交读,一个事务提交后才能被其他事务读取到(会造成幻读、不可重复读),SQL server 的默认级别;

ISOLATION_REPEATABLE_READ:可重复读,保证多次读取同一个数据时,其值都和事务开始时候的内容是一致,禁止读取到别的事务未提交的数据(会造成幻读),MySQL 的默认级别;

ISOLATION_SERIALIZABLE:序列化,代价最高最可靠的隔离级别,该隔离级别能防止脏读、不可重复读、幻读。

Spring的事务传播行为

① PROPAGATION_REQUIRED:如果当前没有事务,就创建一个新事务,如果当前存在事务,就加入该事务,该设置是最常用的设置。

② PROPAGATION_SUPPORTS:支持当前事务,如果当前存在事务,就加入该事务,如果当前不存在事务,就以非事务执行。

③ PROPAGATION_MANDATORY:支持当前事务,如果当前存在事务,就加入该事务,如果当前不存在事务,就抛出异常。

④ PROPAGATION_REQUIRES_NEW:创建新事务,无论当前存不存在事务,都创建新事务。

⑤ PROPAGATION_NOT_SUPPORTED:以非事务方式执行操作,如果当前存在事务,就把当前事务挂起。

⑥ PROPAGATION_NEVER:以非事务方式执行,如果当前存在事务,则抛出异常。

⑦ PROPAGATION_NESTED:如果当前存在事务,则在嵌套事务内执行。如果当前没有事务,则按REQUIRED属性执行。

优秀博客

Spring源码剖析-IOC启动流程(二)

Spring源码剖析-Spring核心类认识(一)

汇总汇总-Spring&Cloud&Alibaba&源码剖析&分布式锁/事务-从入门到进阶到源码-学完保证吊打面试官

第三章:并发编程

进程和线程有什么区别?

进程是系统进行资源分配和调度的独立单位,每一个进程都有自己的内存空间和系统资源。

线程是进程的一个实体,是CPU调度和分派的基本单位,它是比进程更小的能独立运行的基本单位。

多线程是实现并发机制的一个有效手段。进程和线程一样都是实现并发的基本单位

可见性

保证可见性主要由总线lock和mesi协议

使工作内存刷到主内存这一步具有原子性,且使T2线程的i副本失效,不过还是保证不了线程安全

有序性

1.乱序存在的条件?

as-if-serial,(看起来像串行执行),不影响单线程的最终一致性。乱序也是为了提升CPU执行指令的效率

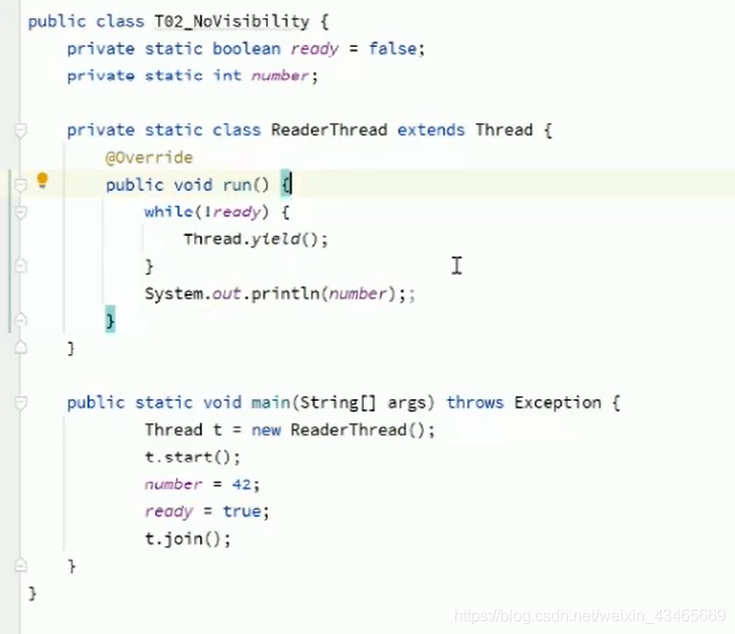

2.下列程序可能的2个问题?

ready和number未用volatile关键字,线程可能一直让渡。

原子性

一系列操作要不同时成功,要不同时失败;

i++为例:

1.从主内存读取i变量到工作内存

2.i+1

3.+1后的值赋值给工作内存中的i,i=i+1

4.将工作内存中的i刷到主内存(什么时候刷入由操作系统决定)

明显不是原子操作,可以加synchronized保证或者AutomicInteger(volatile+cas)

volatile

ThreadLocal

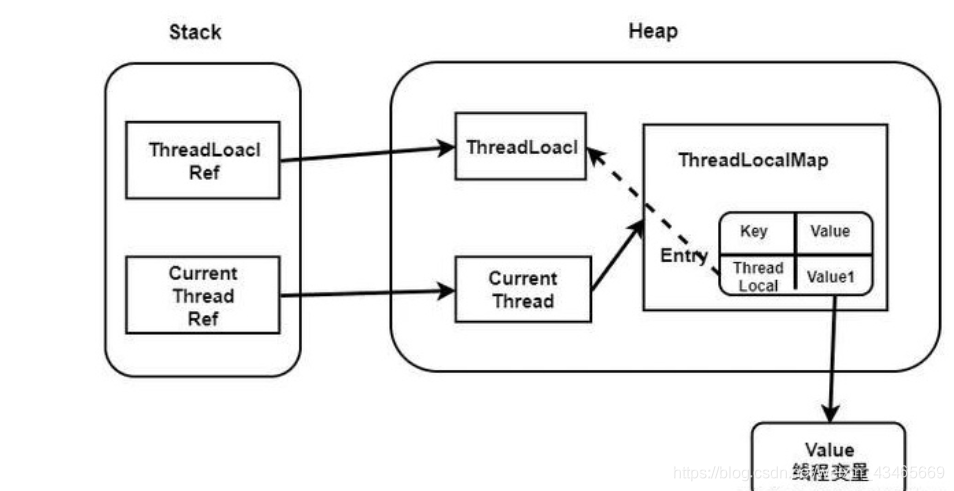

1.ThreadLocal与synchronized区别?

ThreadLocal为每个线程创建一份数据副本,以空间换时间;synchronized所有线程抢占一份数据资源,以时间换空间。

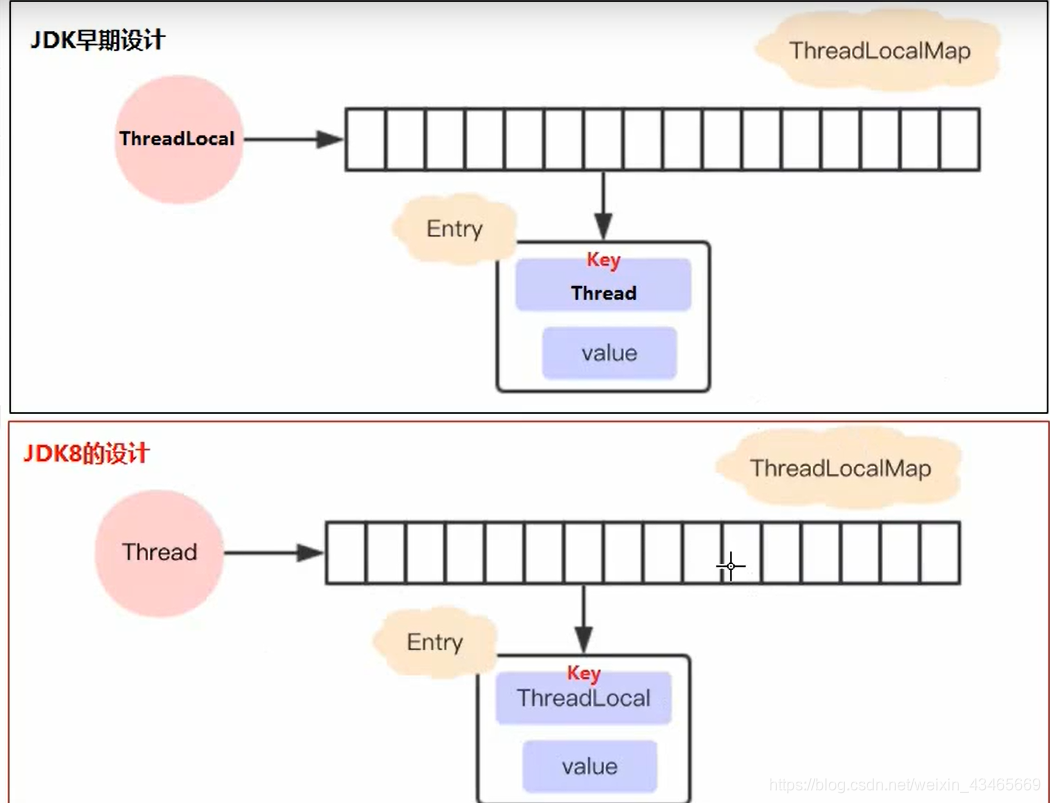

2.1.8之后T和read Local Map为啥由Thread维护?

减少Entry的数量,毕竟ThreadLocal的数量远小于Thread的数量;

节省内存,当线程销毁时,此ThreadLocalMap也被销毁了,原设计由于引用存在,并不会被垃圾回收。

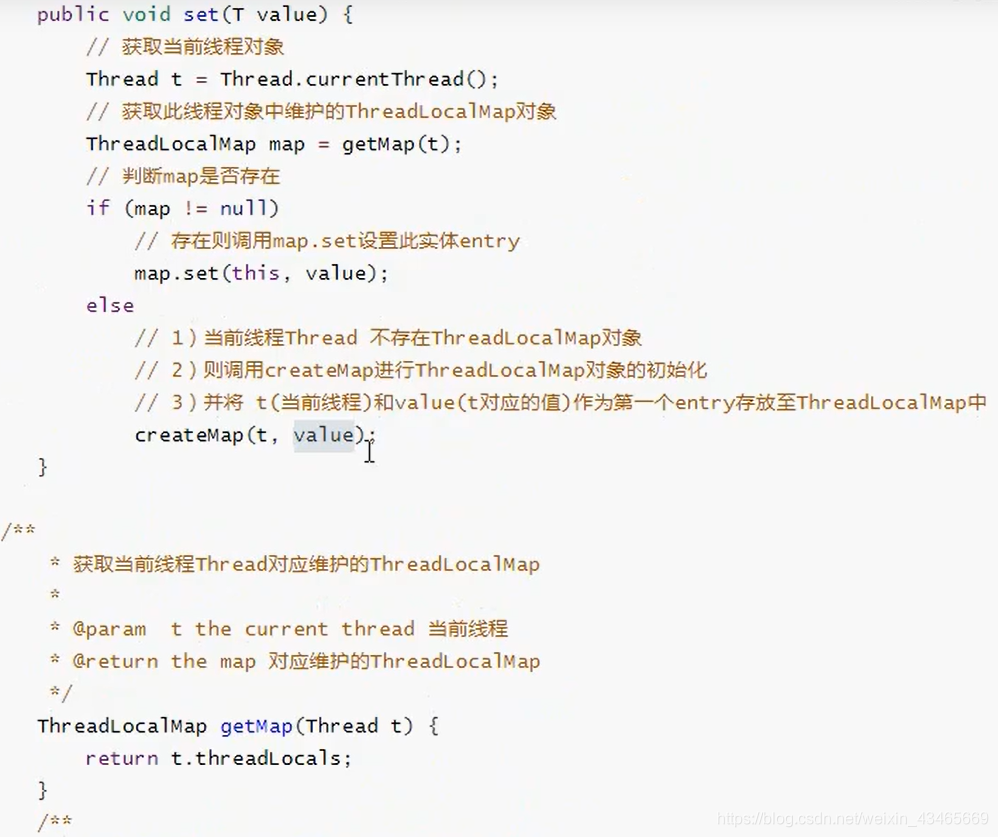

3.set方法过程?

4.get方法过程?

public T get() {

Thread t = Thread.currentThread();

ThreadLocalMap map = getMap(t);

if (map != null) {

ThreadLocalMap.Entry e = map.getEntry(this);

if (e != null) {

@SuppressWarnings("unchecked")

T result = (T)e.value;

return result;

}

}

return setInitialValue();

}

获取当前线程对应的ThreadLocalMap,获取当前threadLocal对象对应的Entry,getValue;如果ThreadLocalMap未被创建或没有当前threadLocal对象对应的Entry,调用初始化方法,默认缺省null。

5.ThreadLocalMap的Entry为啥要继承弱引用?

ThreadLocalMap的key为弱引用,value为强引用;

如果key为强引用,若ThreadLocal的引用被回收,由于key存放的是ThreadLocal对象,导致整个Entry不会被回收,导致内存泄漏;

如果key为弱引用,若ThreadLocal的引用被回收,GC时会自动把key回收,value只要被调用get,set,remove方法时都会被清空;

6.ThreadLocal 的内存泄露是怎么回事?

发生在ThreadLocal threadLocal=new ThreadLocal()时,ThreadLocal 没有被强引用(将threadLocalnull;失去强引用),ThreadLocal 对象会被下次JVM回收,由于key被回收(threadLocalnull且Entry的key是弱引用),value是强引用不会被回收,这样 ThreadLocal 的线程如果一直持续运行,value 就一直得不到回收,这样就会发生内存泄露。

ThreadLocal正确的使用方法

每次使用完ThreadLocal都调用它的remove()方法清除数据(详见remove源码)

将ThreadLocal变量定义成private static,这样就一直存在ThreadLocal的强引用,也就能保证任何时候都能通过ThreadLocal的弱引用访问到Entry的value值,进而清除掉 。

ThreadlLocal内存泄漏

7.ThreadLocal 是怎么解决hash冲突的?

由于ThreadLocalMap的Entry对象没有存储next,在发生hash冲突时,利用固定算法寻找一定步长的下个位置,以此类推找到空位为止,也叫线性探测;

8.使用场景?

多数据源用ThreadLocal绑定当前线程对应的数据源,从request请求到service到dao。对象进行跨层传递时,user从controller传到service,dao等太繁琐。Spring的@Transection注解就是采用ThreadLocal,事务开始时给当前线程绑定一个jdbc连接对象。

可重入锁

指的是同一线程可以反复加锁(不需要先解锁再加锁)。

ReentrantLock和sychronized都是可重入锁。

自写一个不可重入锁

import java.util.concurrent.atomic.AtomicReference;

public class UnreentrantLock {

private AtomicReference<Thread> owner = new AtomicReference<Thread>();

public void lock() {

Thread current = Thread.currentThread();

//这句是很经典的“自旋”语法,AtomicInteger中也有

for (;;) {

if (!owner.compareAndSet(null, current)) {

return;

}

}

}

public void unlock() {

Thread current = Thread.currentThread();

owner.compareAndSet(current, null);

}

}

同一线程两次调用lock()方法,如果不执行unlock()释放锁的话,第二次调用自旋的时候就会产生死锁,这个锁就不是可重入的

import java.util.concurrent.atomic.AtomicReference;

public class UnreentrantLock {

private AtomicReference<Thread> owner = new AtomicReference<Thread>();

private int state = 0;

public void lock() {

Thread current = Thread.currentThread();

if (current == owner.get()) {

state++;

return;

}

//这句是很经典的“自旋”式语法,AtomicInteger中也有

for (;;) {

if (!owner.compareAndSet(null, current)) {

return;

}

}

}

public void unlock() {

Thread current = Thread.currentThread();

if (current == owner.get()) {

if (state != 0) {

state--;

} else {

owner.compareAndSet(current, null);

}

}

}

}

改造成可重入锁

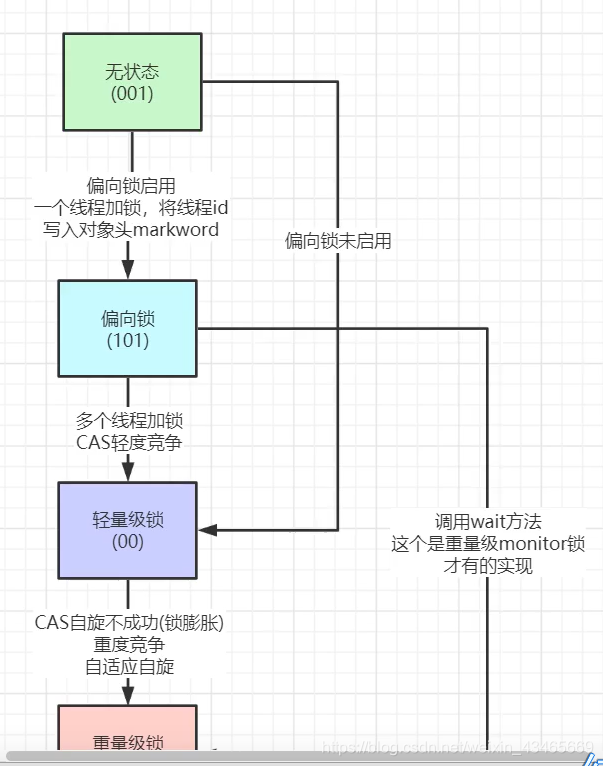

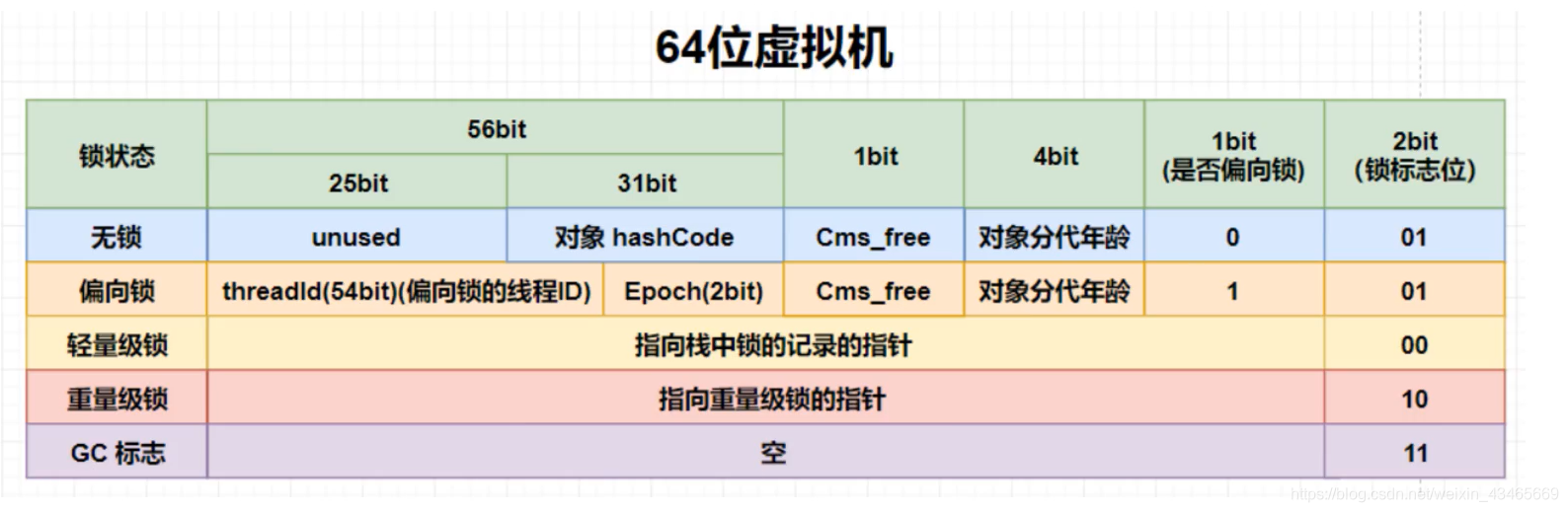

锁的升级过程

偏向锁假定将来只有第一个申请锁的线程会使用锁(不会有任何线程再来申请锁),因此,只需要在Mark Word中CAS记录owner(本质上也是更新,但初始值为空),如果记录成功,则偏向锁获取成功,记录锁状态为偏向锁,以后当前线程等于owner就可以零成本的直接获得锁;否则,说明有其他线程竞争,膨胀为轻量级锁。

1.偏向锁中线程id存储在哪?

存储在对象头的markwor中,

标志位如图

2.重量级锁的标志位的指针指向哪?

指向该对象的monitor的内存地址

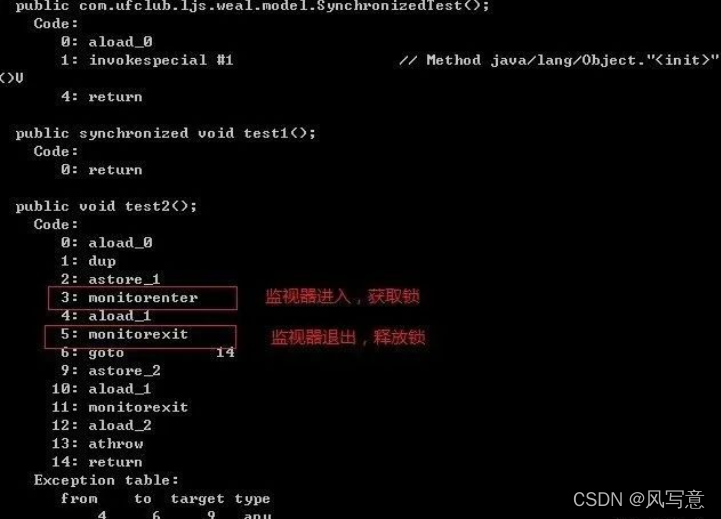

synchronized

1.在jdk1.6之前是重量级锁(线程阻塞,线程上下文切换,用户态内核态的切换,操作系统的系统调用),互斥锁,悲观锁

2.synchronized和Lock的区别?

3.

public class SynchronizedTest {

public synchronized void test1(){

}

public void test2(){

synchronized (this){

}

}

}

我们用javap来分析一下编译后的class文件,看看synchronized如何实现的

从这个截图上可以看出,同步代码块是使用monitorenter和monitorexit指令实现的, monitorenter插入到代码块开始的地方,monitorexit插入到代码块结束的地方,当monitor被持有后,就处于锁定状态,也就是上锁了。

下面我们深入分析一下synchronized实现锁的两个重要的概念:Java对象头和monitor

Java对象头:

synchronized的锁是存在对象头里的,对象头由两部分数据组成:Mark Word(标记字段)、Klass Pointer(类型指针)

Mark Word存储了对象自身运行时数据,如hashcode、GC分代年龄、锁状态标志、线程持有的锁、偏向锁ID等等。是实现轻量级锁和偏向锁的关键,Klass Pointer是Java对象指向类元数据的指针,jvm通过这个指针确定这个对象是哪个类的实例

monitor:

每个Java对象从娘胎里出来就带着一把看不见的锁, 叫做内部锁或者monitor锁,我们可以把它理解成一种同步机制,

它是线程私有的数据结构,

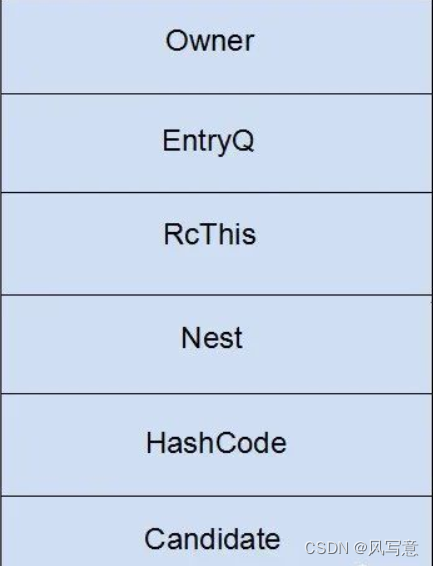

monitor的结构如下:

Owner:初始时为NULL表示当前没有任何线程拥有该monitor record,当线程成功拥有该锁后保存线程唯一标识,当锁被释放时又设置为NULL;

EntryQ:关联一个系统互斥锁(semaphore),阻塞所有试图锁住monitor record失败的线程。

RcThis:表示blocked或waiting在该monitor record上的所有线程的个数。

Nest:用来实现重入锁的计数。

HashCode:保存从对象头拷贝过来的HashCode值(可能还包含GC age)。

Candidate:用来避免不必要的阻塞或等待线程唤醒,因为每一次只有一个线程能够成功拥有锁,如果每次前一个释放锁的线程唤醒所有正在阻塞或等待的线程,会引起不必要的上下文切换(从阻塞到就绪然后因为竞争锁失败又被阻塞)从而导致性能严重下降。Candidate只有两种可能的值0表示没有需要唤醒的线程1表示要唤醒一个继任线程来竞争锁。

锁消除

锁消除用大白话来讲,就是在一段程序里你用了锁,但是jvm检测到这段程序里不存在共享数据竞争问题,也就是变量没有逃逸出方法外,这个时候jvm就会把这个锁消除掉

我们程序员写代码的时候自然是知道哪里需要上锁,哪里不需要,但是有时候我们虽然没有显示使用锁,但是我们不小心使了一些线程安全的API时,如StringBuffer、Vector、HashTable等,这个时候会隐形的加锁。比如下段代码

public void sbTest(){

StringBuffer sb= new StringBuffer();

for(int i = 0 ; i < 10 ; i++){

sb.append(i);

}

System.out.println(sb.toString());

}

上面这段代码,JVM可以明显检测到变量sb没有逃逸出方法sbTest()之外,所以JVM可以大胆地将sbTest内部的加锁操作消除。

偏向锁

当我们创建一个对象时,该对象的部分Markword关键数据如下。

从图中可以看出,偏向锁的标志位是“01”,状态是“0”,表示该对象还没有被加上偏向锁。(“1”是表示被加上偏向锁)。该对象被创建出来的那一刻,就有了偏向锁的标志位,这也说明了所有对象都是可偏向的,但所有对象的状态都为“0”,也同时说明所有被创建的对象的偏向锁并没有生效。

不过,当线程执行到临界区(critical section)时,此时会利用CAS(Compare and Swap)操作,将线程ID插入到Markword中,同时修改偏向锁的标志位。

所谓临界区,就是只允许一个线程进去执行操作的区域,即同步代码块。CAS是一个原子性操作

此时偏向锁的状态为“1”,说明对象的偏向锁生效了,同时也可以看到,哪个线程获得了该对象的锁。

偏向锁是jdk1.6引入的一项锁优化,其中的“偏”是偏心的偏。它的意思就是说,这个锁会偏向于第一个获得它的线程,在接下来的执行过程中,假如该锁没有被其他线程所获取,没有其他线程来竞争该锁,那么持有偏向锁的线程将永远不需要进行同步操作。也就是说:在此线程之后的执行过程中,如果再次进入或者退出同一段同步块代码,并不再需要去进行加锁或者解锁操作,而是会做以下的步骤:

Load-and-test,也就是简单判断一下当前线程id是否与Markword当中的线程id是否一致.

如果一致,则说明此线程已经成功获得了锁,继续执行下面的代码.

如果不一致,则要检查一下对象是否还是可偏向,即“是否偏向锁”标志位的值。

如果还未偏向,则利用CAS操作来竞争锁,也即是第一次获取锁时的操作。

释放锁 偏向锁的释放采用了一种只有竞争才会释放锁的机制,线程是不会主动去释放偏向锁,需要等待其他线程来竞争。偏向锁的撤销需要等待全局安全点(这个时间点是上没有正在执行的代码)。其步骤如下:

1.暂停拥有偏向锁的线程,判断锁对象石是否还处于被锁定状态;

2.撤销偏向锁,恢复到无锁状态或者轻量级锁的状态;

安全点会导致stw(stop the world),导致性能下降,这种情况下应当禁用;

查看停顿–安全点停顿日志

要查看安全点停顿,可以打开安全点日志,通过设置JVM参数 -

XX:+PrintGCApplicationStoppedTime 会打出系统停止的时间,

添加-XX:+PrintSafepointStatistics -XX:PrintSafepointStatisticsCount=1 这两个参数会打印出详细信息,可以查看到使用偏向锁导致的停顿,时间非常短暂,但是争用严重的情况下,停顿次数也会非常多;

注意:安全点日志不能一直打开:

- 安全点日志默认输出到stdout,一是stdout日志的整洁性,二是stdout所重定向的文件如果不在/dev/shm,可能被锁。

- 对于一些很短的停顿,比如取消偏向锁,打印的消耗比停顿本身还大。

- 安全点日志是在安全点内打印的,本身加大了安全点的停顿时间。

所以安全日志应该只在问题排查时打开。

如果在生产系统上要打开,再再增加下面四个参数:

-XX:+UnlockDiagnosticVMOptions -XX: -DisplayVMOutput -XX:+LogVMOutput -XX:LogFile=/dev/shm/vm.log

打开Diagnostic(只是开放了更多的flag可选,不会主动激活某个flag),关掉输出VM日志到stdout,输出到独立文件,/dev/shm目录(内存文件系统)。

此日志分三部分:

第一部分是时间戳,VM Operation的类型

第二部分是线程概况,被中括号括起来

total: 安全点里的总线程数

initially_running: 安全点时开始时正在运行状态的线程数

wait_to_block: 在VM Operation开始前需要等待其暂停的线程数

第三部分是到达安全点时的各个阶段以及执行操作所花的时间,其中最重要的是vmop

spin: 等待线程响应safepoint号召的时间;

block: 暂停所有线程所用的时间;

sync: 等于 spin+block,这是从开始到进入安全点所耗的时间,可用于判断进入安全点耗时;

cleanup: 清理所用时间;

vmop: 真正执行VM Operation的时间。

可见,那些很多但又很短的安全点,全都是RevokeBias, 高并发的应用会禁用掉偏向锁。

jvm开启/关闭偏向锁

开启偏向锁:-XX:+UseBiasedLocking -XX:BiasedLockingStartupDelay=0

关闭偏向锁:-XX:-UseBiasedLocking

轻量级锁

自旋锁的目标是降低线程切换的成本。如果锁竞争激烈,我们不得不依赖于重量级锁,让竞争失败的线程阻塞;如果完全没有实际的锁竞争,那么申请重量级锁都是浪费的。轻量级锁的目标是,减少无实际竞争情况下,使用重量级锁产生的性能消耗,包括系统调用引起的内核态与用户态切换、线程阻塞造成的线程切换等。

顾名思义,轻量级锁是相对于重量级锁而言的。使用轻量级锁时,不需要申请互斥量,仅仅将Mark Word中的部分字节CAS更新指向线程栈中的Lock Record(Lock Record:JVM检测到当前对象是无锁状态,则会在当前线程的栈帧中创建一个名为LOCKRECOD表空间用于copy Mark word 中的数据),如果更新成功,则轻量级锁获取成功,记录锁状态为轻量级锁;否则,说明已经有线程获得了轻量级锁,目前发生了锁竞争(不适合继续使用轻量级锁),接下来膨胀为重量级锁。

当然,由于轻量级锁天然瞄准不存在锁竞争的场景,如果存在锁竞争但不激烈,仍然可以用自旋锁优化,自旋失败后再膨胀为重量级锁。

缺点:同自旋锁相似:如果锁竞争激烈,那么轻量级将很快膨胀为重量级锁,那么维持轻量级锁的过程就成了浪费。

重量级锁

轻量级锁膨胀之后,就升级为重量级锁了。重量级锁是依赖对象内部的monitor锁来实现的,而monitor又依赖操作系统的MutexLock(互斥锁)来实现的,所以重量级锁也被成为互斥锁。

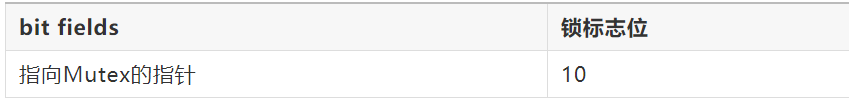

当轻量级所经过锁撤销等步骤升级为重量级锁之后,它的Markword部分数据大体如下

为什么说重量级锁开销大呢

主要是,当系统检查到锁是重量级锁之后,会把等待想要获得锁的线程进行阻塞,被阻塞的线程不会消耗cup。但是阻塞或者唤醒一个线程时,都需要操作系统来帮忙,这就需要从用户态转换到内核态,而转换状态是需要消耗很多时间的,有可能比用户执行代码的时间还要长。

这就是说为什么重量级线程开销很大的。

互斥锁(重量级锁)也称为阻塞同步、悲观锁

总结

偏向所锁,轻量级锁都是乐观锁,重量级锁是悲观锁。

一个对象刚开始实例化的时候,没有任何线程来访问它的时候。它是可偏向的,意味着,它现在认为只可能有一个线程来访问它,所以当第一个

线程来访问它的时候,它会偏向这个线程,此时,对象持有偏向锁。偏向第一个线程,这个线程在修改对象头成为偏向锁的时候使用CAS操作,并将

对象头中的ThreadID改成自己的ID,之后再次访问这个对象时,只需要对比ID,不需要再使用CAS在进行操作。

一旦有第二个线程访问这个对象,因为偏向锁不会主动释放,所以第二个线程可以看到对象时偏向状态,这时表明在这个对象上已经存在竞争了,检查原来持有该对象锁的线程是否依然存活,如果挂了,则可以将对象变为无锁状态,然后重新偏向新的线程,如果原来的线程依然存活,则马上执行那个线程的操作栈,检查该对象的使用情况,如果仍然需要持有偏向锁,则偏向锁升级为轻量级锁,(偏向锁就是这个时候升级为轻量级锁的)。如果不存在使用了,则可以将对象回复成无锁状态,然后重新偏向。

轻量级锁认为竞争存在,但是竞争的程度很轻,一般两个线程对于同一个锁的操作都会错开,或者说稍微等待一下(自旋),另一个线程就会释放锁。但是当自旋超过一定的次数,或者一个线程在持有锁,一个在自旋,又有第三个来访时,轻量级锁膨胀为重量级锁,重量级锁使除了拥有锁的线程以外的线程都阻塞,防止CPU空转。

线程池

CPU密集型任务应配置尽可能小的线程,如配置CPU数目+1个线程的线程池。由于IO密集型任务线程并不是一直在执行任务,则应配置尽可能多的线程,如2*CPU数目

java中提供了几种线程池?

Executors核心方法

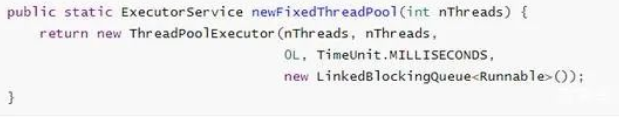

Executors.newFixedThreadPool:创建固定线程数的线程池。核心线程数等于最大线程数,不存在空闲线程,keepAliveTime为0。

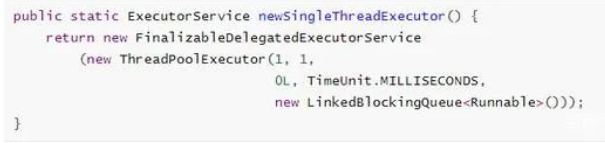

Executors.newSingleThreadExecutor:创建单线程的线程池,核心线程数和最大线程数都为1,相当于串行执行。

Executors.newScheduledThreadPool:创建支持定时以及周期性任务执行的线程池。最大线程数是Integer.MAX_VALUE。存在OOM风险。keepAliveTime为0,所以不回收工作线程。

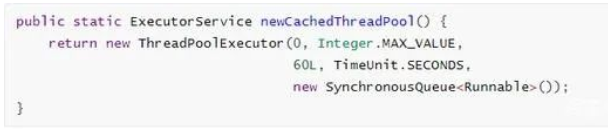

Executors.newCachedThreadPool:核心线程数为0,最大线程数为Integer.MAX_VALUE,是一个高度可伸缩的线程池。存在OOM风险。keepAliveTime为60,工作线程处于空闲状态超过keepAliveTime会回收线程。

Executors.newWorkStealingPool:JDK8引入,创建持有足够线程的线程池支持给定的并行度,并通过使用多个队列减少竞争。

1.ThreadPoolExcutor的参数?

核心线程数,

最大线程数,

线程存活时间

时间单位,

阻塞队列,

线程工厂,

拒绝策略

2.如何实现线程的复用?

阻塞队列传递生产者消费者,while(true)避免线程被销毁

3.禁止直接使用Executors创建线程池原因:

Executors.newCachedThreadPool和Executors.newScheduledThreadPool两个方法最大线程数为Integer.MAX_VALUE,如果达到上限,没有任务服务器可以继续工作,肯定会抛出OOM异常。

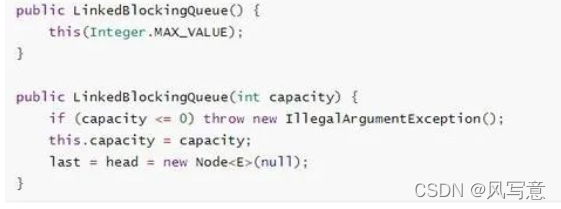

Executors.newSingleThreadExecutor和Executors.newFixedThreadPool两个方法的workQueue参数为new LinkedBlockingQueue(),容量为Integer.MAX_VALUE,如果瞬间请求非常大,会有OOM风险。

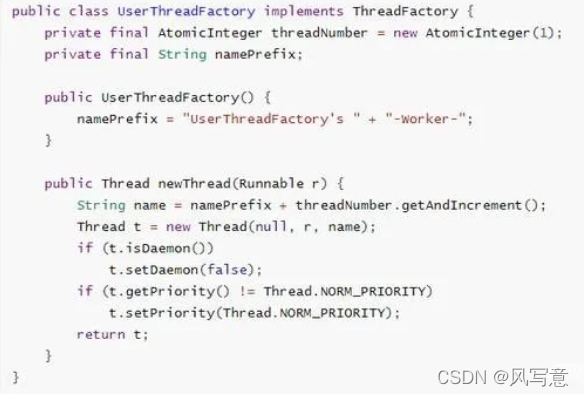

如何自定义ThreadFactory

如上代码所示,实现ThreadFactory接口并在newThread方法中实现设置线程的名称、是否为守护线程以及线程优先级等属性。这样做有助于快速定位死锁、StackOverflowError等问题。如下图所示,绿色框自定义的线程工厂明显比蓝色的默认线程工厂创建的线程名称拥有更多的额外信息。

线程拒绝策略

ThreadPoolExecutor提供了四个公开的内部静态类:

AbortPolicy:默认,丢弃任务并抛出RejectedExecutionException异常。

DiscardPolicy:丢弃任务,但是不抛出异常(不推荐)。

DiscardOldestPolicy:抛弃队列中等待最久的任务,然后把当前任务加入队列中。

CallerRunsPolicy:调用任务的run()方法绕过线程池直接执行。

友好的拒绝策略:

保存到数据库进行削峰填谷。在空闲时再提出来执行。

转向某个提示页面

打印日志

自定义拒绝策略:

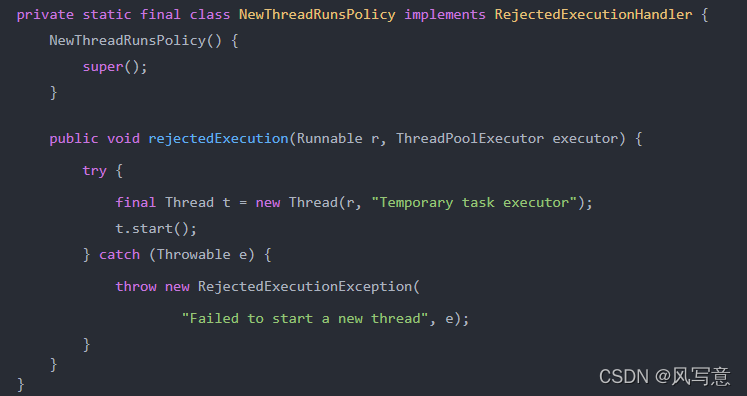

Netty中的线程池拒绝策略

Netty中的实现很像JDK中的CallerRunsPolicy,舍不得丢弃任务。不同的是,CallerRunsPolicy是直接在调用者线程执行的任务。

而 Netty是新建了一个线程来处理的。所以,Netty的实现相较于调用者执行策略的使用面就可以扩展到支持高效率高性能的场景了。

但是也要注意一点,Netty的实现里,在创建线程时未做任何的判断约束,也就是说只要系统还有资源就会创建新的线程来处理,直到new不出新的线程了,才会抛创建线程失败的异常

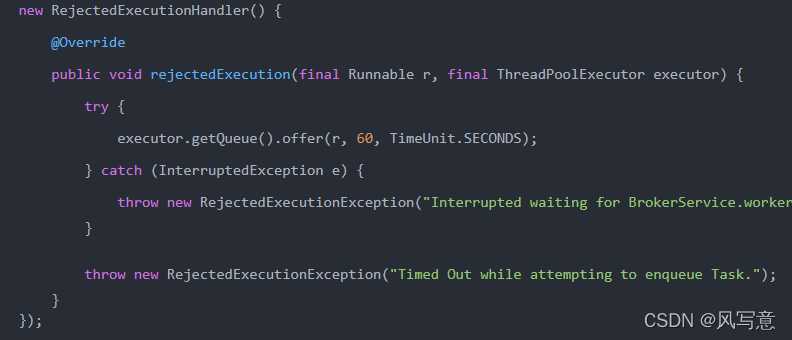

activeMq中的线程池拒绝策略

activeMq中的策略属于最大努力执行型策略,当触发拒绝策略时,会在次努力一分钟。重新将任务塞进任务队列,当一分钟超时还没成功时,就抛出异常

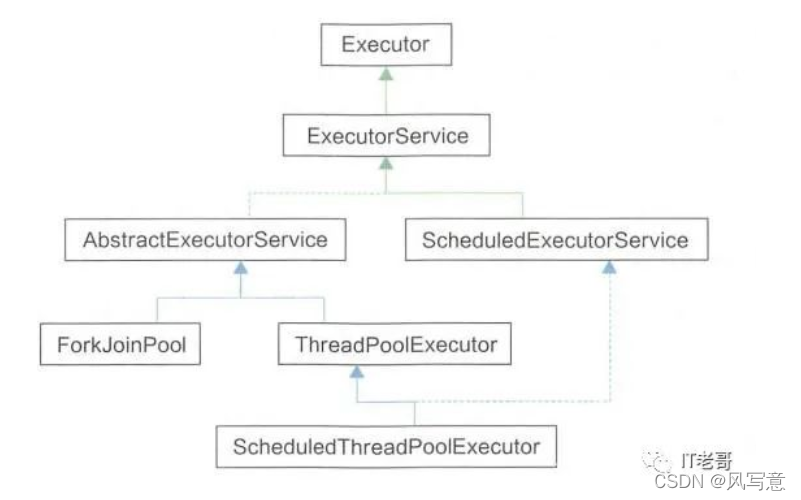

4.线程池原理

ExecutorService接口继承了Executor接口,定义了管理线程任务的方法。ExecutorService的抽象类AbstractExecutorService提供了submit、invokeAll()等部分方法实现,但是核心方法Executor.execute()并没有实现。因为所有任务都在这个方法里执行,不同的线程池实现策略会有不同,所以交由具体的线程池来实现。

ExecutorService接口继承了Executor接口,定义了管理线程任务的方法。ExecutorService的抽象类AbstractExecutorService提供了submit、invokeAll()等部分方法实现,但是核心方法Executor.execute()并没有实现。因为所有任务都在这个方法里执行,不同的线程池实现策略会有不同,所以交由具体的线程池来实现。

//用来标记线程池状态(高3位),线程个数(低29位)

//默认是RUNNING状态,线程个数为0

private final AtomicInteger ctl = new AtomicInteger(ctlOf(RUNNING, 0));

//线程个数掩码位数,并不是所有平台int类型是32位,所以准确说是具体平台下Integer的二进制位数-3后的剩余位数才是线程的个数,

private static final int COUNT_BITS = Integer.SIZE - 3;

//线程最大个数(低29位)00011111111111111111111111111111

private static final int CAPACITY = (1 << COUNT_BITS) - 1;

//(高3位):11100000000000000000000000000000

private static final int RUNNING = -1 << COUNT_BITS;

//(高3位):00000000000000000000000000000000

private static final int SHUTDOWN = 0 << COUNT_BITS;

//(高3位):00100000000000000000000000000000

private static final int STOP = 1 << COUNT_BITS;

//(高3位):01000000000000000000000000000000

private static final int TIDYING = 2 << COUNT_BITS;

//(高3位):01100000000000000000000000000000

private static final int TERMINATED = 3 << COUNT_BITS;

// 获取高三位 运行状态

private static int runStateOf(int c) { return c & ~CAPACITY; }

//获取低29位 线程个数

private static int workerCountOf(int c) { return c & CAPACITY; }

//计算ctl新值,线程状态 与 线程个数

private static int ctlOf(int rs, int wc) { return rs | wc; }

线程池状态含义:

RUNNING:接受新任务并且处理阻塞队列里的任务;

SHUTDOWN:拒绝新任务但是处理阻塞队列里的任务;

STOP:拒绝新任务并且抛弃阻塞队列里的任务,同时会中断正在处理的任务;

TIDYING:所有任务都执行完(包含阻塞队列里面任务)当前线程池活动线程为 0,将要调用 terminated 方法;

TERMINATED:终止状态,terminated方法调用完成以后的状态。

线程池状态转换:

1.RUNNING -> SHUTDOWN:显式调用 shutdown() 方法,或者隐式调用了 finalize(),它里面调用了 shutdown() 方法。

2.RUNNING or SHUTDOWN -> STOP:显式调用 shutdownNow() 方法时候。

3.SHUTDOWN -> TIDYING:当线程池和任务队列都为空的时候。

4.STOP -> TIDYING:当线程池为空的时候。

5.TIDYING -> TERMINATED:当 terminated() hook 方法执行完成时候。

execute方法会初始化线程池,

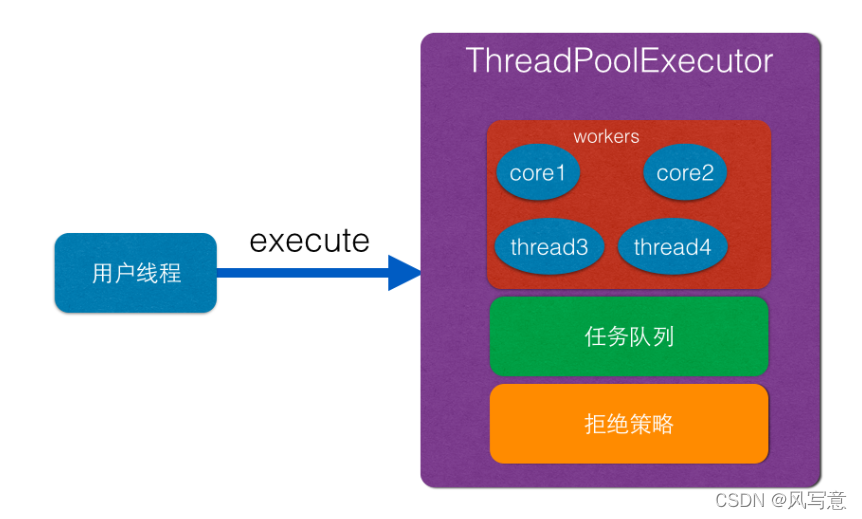

1 public void execute(Runnable command):execute 方法是提交任务 command 到线程池进行执行,用户线程提交任务到线程池的模型图如下所示:

如上图可知 ThreadPoolExecutor 的实现实际是一个生产消费模型,其中当用户添加任务到线程池时候相当于生产者生产元素,workers 线程工作集中的线程直接执行任务或者从任务队列里面获取任务相当于消费者消费元素

//获取当前线程池的状态+线程个数变量的组合值

int c = ctl.get();

//如果工作线程数<核心线程数,添加一个核心Work

if (workerCountOf(c) < corePoolSize) {

if (addWorker(command, true))

return;

c = ctl.get();

}

//反之,阻塞队列添加一个任务

if (isRunning(c) && workQueue.offer(command)) {

int recheck = ctl.get();

if (! isRunning(recheck) && remove(command))

reject(command);

else if (workerCountOf(recheck) == 0)

addWorker(null, false);

}

else if (!addWorker(command, false))

reject(command);

addWorker源码

private boolean addWorker(Runnable firstTask, boolean core) {

retry:

for (;;) {

int c = ctl.get();

int rs = runStateOf(c);

//(6) 检查队列是否只在必要时为空

//1.当前线程池状态为 STOP,TIDYING,TERMINATED;

//2.当前线程池状态为 SHUTDOWN 并且已经有了第一个任务;

//3.当前线程池状态为 SHUTDOWN 并且任务队列为空。

if (rs >= SHUTDOWN &&

! (rs == SHUTDOWN &&

firstTask == null &&

! workQueue.isEmpty()))

return false;

//(7)循环cas增加线程个数

for (;;) {

int wc = workerCountOf(c);

//(7.1)如果线程个数超限则返回false

if (wc >= CAPACITY ||

wc >= (core ? corePoolSize : maximumPoolSize))

return false;

//(7.2)cas增加线程个数,同时只有一个线程成功

if (compareAndIncrementWorkerCount(c))

break retry;

//(7.3)cas失败了,则看线程池状态是否变化了,变化则跳到外层循环重试重新获取线程池状态,否者内层循环重新cas。

c = ctl.get(); // Re-read ctl

if (runStateOf(c) != rs)

continue retry;

}

}

//(8)到这里说明cas成功了

boolean workerStarted = false;

boolean workerAdded = false;

Worker w = null;

try {

//(8.1)创建worker

final ReentrantLock mainLock = this.mainLock;

w = new Worker(firstTask);

final Thread t = w.thread;

if (t != null) {

//(8.2)加独占锁,为了workers同步,因为可能多个线程调用了线程池的execute方法。

mainLock.lock();

try {

//(8.3)重新检查线程池状态,为了避免在获取锁前调用了shutdown接口

int c = ctl.get();

int rs = runStateOf(c);

if (rs < SHUTDOWN ||

(rs == SHUTDOWN && firstTask == null)) {

if (t.isAlive()) // precheck that t is startable

throw new IllegalThreadStateException();

//(8.4)添加任务

workers.add(w);

int s = workers.size();

if (s > largestPoolSize)

largestPoolSize = s;

workerAdded = true;

}

} finally {

mainLock.unlock();

}

//(8.5)添加成功则启动任务

if (workerAdded) {

t.start();

workerStarted = true;

}

}

} finally {

if (! workerStarted)

addWorkerFailed(w);

}

return workerStarted;

}

如上代码主要分两部分,第一部分的双重循环目的是通过 cas 操作增加线程池线程数,第二部分主要是并发安全的把任务添加到 workers 里面,并且启动任务执行。

回到上面看新增线程的 addWorkder 方法,发现内层循环作用是使用 cas 增加线程,代码(7.1)如果线程个数超限则返回 false,否者执行代码(7.2)执行 CAS 操作设置线程个数,cas 成功则退出双循环,CAS 失败则执行代码(7.3)看当前线程池的状态是否变化了,如果变了,则重新进入外层循环重新获取线程池状态,否者进入内层循环继续进行 cas 尝试。

执行到第二部分的代码(8)说明使用 CAS 成功的增加了线程个数,但是现在任务还没开始执行,这里使用全局的独占锁来控制把新增的 Worker 添加到工作集 workers。代码(8.1)创建了一个工作线程 Worker。

代码(8.2)获取了独占锁,代码(8.3)重新检查线程池状态,这是为了避免在获取锁前其他线程调用了 shutdown 关闭了线程池,如果线程池已经被关闭,则释放锁,新增线程失败,否者执行代码(8.4)添加工作线程到线程工作集,然后释放锁,代码(8.5)如果判断如果工作线程新增成功,则启动工作线程。

工作线程 Worker 的执行

当用户线程提交任务到线程池后,具体是使用 worker 来执行的,先看下 Worker 的构造函数:

Worker(Runnable firstTask) {

setState(-1); // 在调用runWorker前禁止中断

this.firstTask = firstTask;

this.thread = getThreadFactory().newThread(this);//创建一个线程

}

如上代码构造函数内首先设置 Worker 的状态为 -1,是为了避免当前 worker 在调用 runWorker 方法前被中断(当其它线程调用了线程池的 shutdownNow 时候,如果 worker 状态 >= 0 则会中断该线程)。这里设置了线程的状态为 -1,所以该线程就不会被中断了。如下代码运行 runWorker 的代码(9)时候会调用 unlock 方法,该方法把 status 变为了 0,所以这时候调用 shutdownNow 会中断 worker 线程了。

//每个worker都实现了Runnable接口,自旋从阻塞队列获取任务

final void runWorker(Worker w) {

Thread wt = Thread.currentThread();

Runnable task = w.firstTask;

w.firstTask = null;

w.unlock(); //(9)status设置为0,允许中断

boolean completedAbruptly = true;

try {

//(10)

while (task != null || (task = getTask()) != null) {

//(10.1)

w.lock();

...

try {

//(10.2)任务执行前干一些事情

beforeExecute(wt, task);

Throwable thrown = null;

try {

task.run();//(10.3)执行任务

} catch (RuntimeException x) {

thrown = x; throw x;

} catch (Error x) {

thrown = x; throw x;

} catch (Throwable x) {

thrown = x; throw new Error(x);

} finally {

//(10.4)任务执行完毕后干一些事情

afterExecute(task, thrown);

}

} finally {

task = null;

//(10.5)统计当前worker完成了多少个任务

w.completedTasks++;

w.unlock();

}

}

completedAbruptly = false;

} finally {

//(11)执行清工作

processWorkerExit(w, completedAbruptly);

}

}

如上代码(10)如果当前 task==null 或者调用 getTask 从任务队列获取的任务返回 null,则跳转到代码(11)执行。如果 task 不为 null 则执行代码(10.1)获取工作线程内部持有的独占锁,然后执行扩展接口代码(10.2)在具体任务执行前做一些事情,代码(10.3)具体执行任务,代码(10.4)在任务执行完毕后做一些事情,代码(10.5)统计当前 worker 完成了多少个任务,并释放锁。

这里在执行具体任务期间加锁,是为了避免任务运行期间,其他线程调用了 shutdown 或者 shutdownNow 命令关闭了线程池。

4.线程池如何回收线程?

private Runnable getTask() {

boolean timedOut = false; // Did the last poll() time out?

for (;;) {

int c = ctl.get();

int rs = runStateOf(c);

// Check if queue empty only if necessary.

if (rs >= SHUTDOWN && (rs >= STOP || workQueue.isEmpty())) {

decrementWorkerCount();

return null;

}

int wc = workerCountOf(c);

// Are workers subject to culling?

boolean timed = allowCoreThreadTimeOut || wc > corePoolSize;

if ((wc > maximumPoolSize || (timed && timedOut))

&& (wc > 1 || workQueue.isEmpty())) {

if (compareAndDecrementWorkerCount(c))

return null;

continue;

}

try {

Runnable r = timed ?

workQueue.poll(keepAliveTime, TimeUnit.NANOSECONDS) :

workQueue.take();

if (r != null)

return r;

timedOut = true;

} catch (InterruptedException retry) {

timedOut = false;

}

}

}

从队列中poll数据,超时了把timedOut设置为true,自旋遇到(timed && timedOut) 返回true,跳出了runWorker的while循环

CAS

1.cas又称无锁(硬件级别还是加锁了),自旋锁,轻量级锁,乐观锁。

2.cas的原子性主要靠汇编指令lock和cmpxchgq来给缓存行/总线行(大于64B升级到总线行),保证cas方法的串行执行。

3.ABA问题可以通过加版本号防止

LongAdder

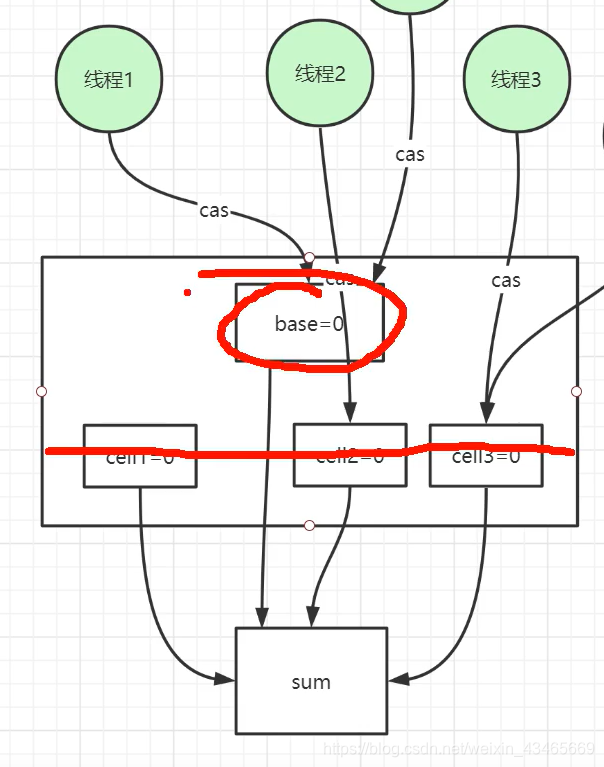

1.采用分段cas算法减少自旋,避免升级成重量级锁

LongAdder的longValue方法就是将cell数组的值相加

public long sum() {

Cell[] as = cells; Cell a;

long sum = base;

if (as != null) {

for (int i = 0; i < as.length; ++i) {

if ((a = as[i]) != null)

sum += a.value;

}

}

return sum;

}

阻塞队列

1.阻塞队列常用方法?

take:取队列中的一个元素,如果队列为空,方法阻塞

offer:往队列添加元素并返回是否添加成功,不阻塞

线程的生命周期和状态

操作系统中的线程有五种状态:创建(NEW),就绪(RUNNABLE),运行(RUNNING,已经拿到了CPU的使用权),阻塞(BLOCKED),死亡(DEAD)

操作系统的阻塞分为3种:

1.等待阻塞:调用wait方法的阻塞,jvm会把该线程放入等待池中,会释放锁,不会主动苏醒

2.同步阻塞:竞争锁的过程,jvm会把该线程放入锁池

3.其他阻塞:调用sleep方法或者IO操作,完成后会重新转入就绪状态

JAVA线程有六种状态:

1)NEW:初始状态,线程被构建,但是还没有调用 start 方法;

2)RUNNABLED:运行状态,JAVA 线程把操作系统中的就绪和运行两种状态统一称为“运行中” ;

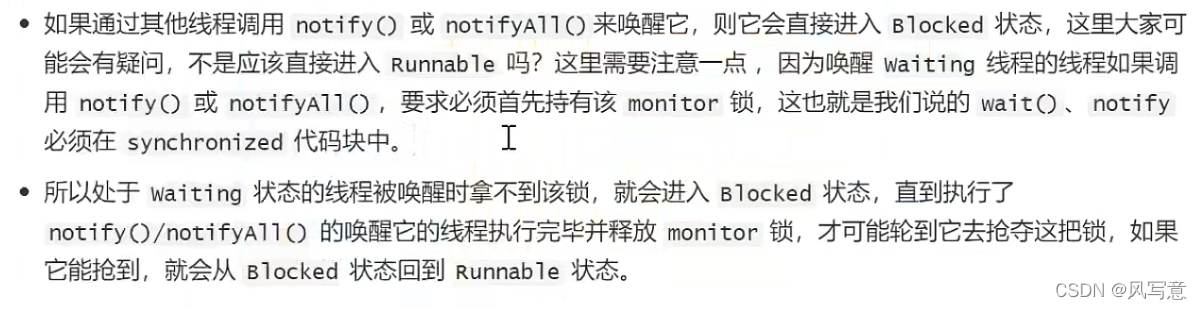

3)BLOCKED:阻塞状态,表示线程进入等待状态,也就是线程因为某种原因放弃了 CPU 使用权(只有synchonied可以)

4)WAITING:等待状态,没有超时时间,要被其他线程或者有其它的中断操作;比如wait()、join()、LockSupport.park();其他锁如ReentLock底层使用park方法是进入waiting状态

5)TIME_WAITING:超时等待状态,超时以后自动返回;

执行 Thread.sleep(long)、wait(long)、join(long)、LockSupport.park(long)、LockSupport.parkNanos(long)、LockSupport.parkUntil(long)

6)TERMINATED:终止状态,表示当前线程执行完毕 。

sleep,wait,yeld,join方法

1.sleep方法调用后,不释放资源,是Thread的静态本地方法,不需要被唤醒,让出CPU的使用权,强制进行上下文切换,在指定时间后线程进入就绪状态。

2.wait方法调用后,线程进入阻塞状态。

3.yeld方法调用后,线程会让出CPU的执行权,但是还保留了执行资格,下次CPU调度还可能执行

4.join方法调用后,线程会进入阻塞状态,比如线程A里调用线程B的join方法,线程A阻塞,直到线程B执行完成

AQS

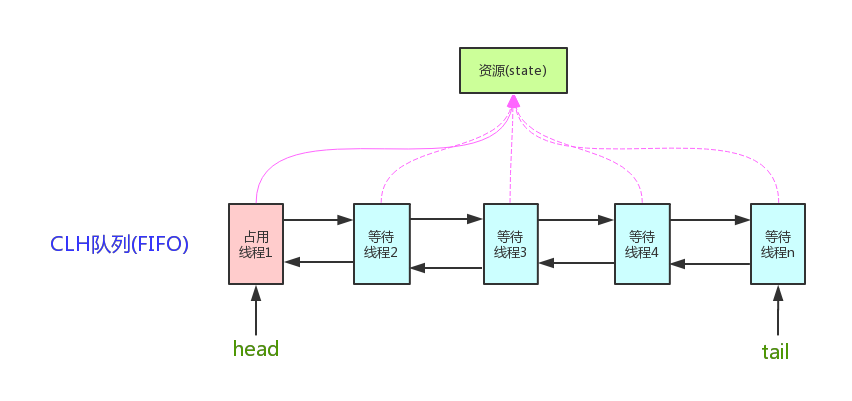

1.抽象的队列式的同步器,AQS定义了一套多线程访问共享资源的同步器框架,许多同步类实现都依赖于它,如常用的ReentrantLock/Semaphore/CountDownLatch…

2.

它维护了一个volatile int state(代表共享资源)和一个FIFO线程等待队列(多线程争用资源被阻塞时会进入此队列)

3.AQS定义两种资源共享方式:Exclusive(独占,只有一个线程能执行,如ReentrantLock)和Share(共享,多个线程可同时执行,如Semaphore/CountDownLatch)。

不同的自定义同步器争用共享资源的方式也不同。自定义同步器在实现时只需要实现共享资源state的获取与释放方式即可,至于具体线程等待队列的维护(如获取资源失败入队/唤醒出队等),AQS已经在顶层实现好了。自定义同步器实现时主要实现以下几种方法:

isHeldExclusively():该线程是否正在独占资源。只有用到condition才需要去实现它。

tryAcquire(int):独占方式。尝试获取资源,成功则返回true,失败则返回false。

tryRelease(int):独占方式。尝试释放资源,成功则返回true,失败则返回false。

tryAcquireShared(int):共享方式。尝试获取资源。负数表示失败;0表示成功,但没有剩余可用资源;正数表示成功,且有剩余资源。

tryReleaseShared(int):共享方式。尝试释放资源,如果释放后允许唤醒后续等待结点返回true,否则返回false。

以ReentrantLock为例,state初始化为0,表示未锁定状态。A线程lock()时,会调用tryAcquire()独占该锁并将state+1。此后,其他线程再tryAcquire()时就会失败,直到A线程unlock()到state=0(即释放锁)为止,其它线程才有机会获取该锁。当然,释放锁之前,A线程自己是可以重复获取此锁的(state会累加),这就是可重入的概念。但要注意,获取多少次就要释放多么次,这样才能保证state是能回到零态的。

再以CountDownLatch以例,任务分为N个子线程去执行,state也初始化为N(注意N要与线程个数一致)。这N个子线程是并行执行的,每个子线程执行完后countDown()一次,state会CAS减1。等到所有子线程都执行完后(即state=0),会unpark()主调用线程,然后主调用线程就会从await()函数返回,继续后余动作。

一般来说,自定义同步器要么是独占方法,要么是共享方式,他们也只需实现tryAcquire-tryRelease、tryAcquireShared-tryReleaseShared中的一种即可。但AQS也支持自定义同步器同时实现独占和共享两种方式,如ReentrantReadWriteLock。

4.源码分析

waitState的枚举值有:

// CANCELLED:由于超时或中断,此节点被取消。节点一旦被取消了就不会再改变状态。特别是,取消节点的线程不会再阻塞。

static final int CANCELLED = 1;

// SIGNAL:此节点后面的节点已(或即将)被阻止(通过park),因此当前节点在释放或取消时必须断开后面的节点

// 为了避免竞争,acquire方法时前面的节点必须是SIGNAL状态,然后重试原子acquire,然后在失败时阻塞。

static final int SIGNAL = -1;

// 此节点当前在条件队列中。标记为CONDITION的节点会被移动到一个特殊的条件等待队列(此时状态将设置为0),直到条件时才会被重新移动到同步等待队列 。(此处使用此值与字段的其他用途无关,但简化了机制。)

static final int CONDITION = -2;

//传播:应将releaseShared传播到其他节点。这是在doReleaseShared中设置的(仅适用于头部节点),以确保传播继续,即使此后有其他操作介入。

static final int PROPAGATE = -3;

//0:以上数值均未按数字排列以简化使用。非负值表示节点不需要发出信号。所以,大多数代码不需要检查特定的值,只需要检查符号。

//对于正常同步节点,该字段初始化为0;对于条件节点,该字段初始化为条件。它是使用CAS修改的(或者在可能的情况下,使用无条件的volatile写入)。

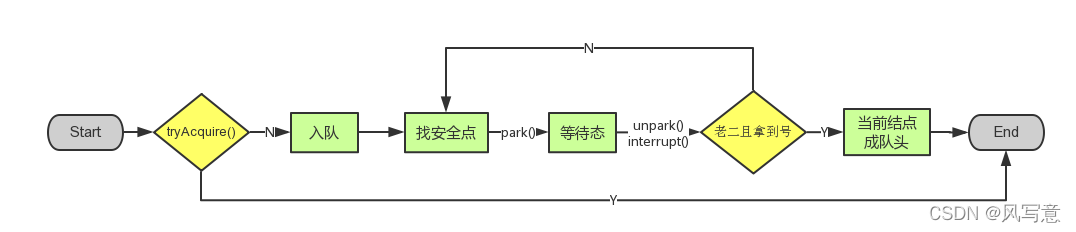

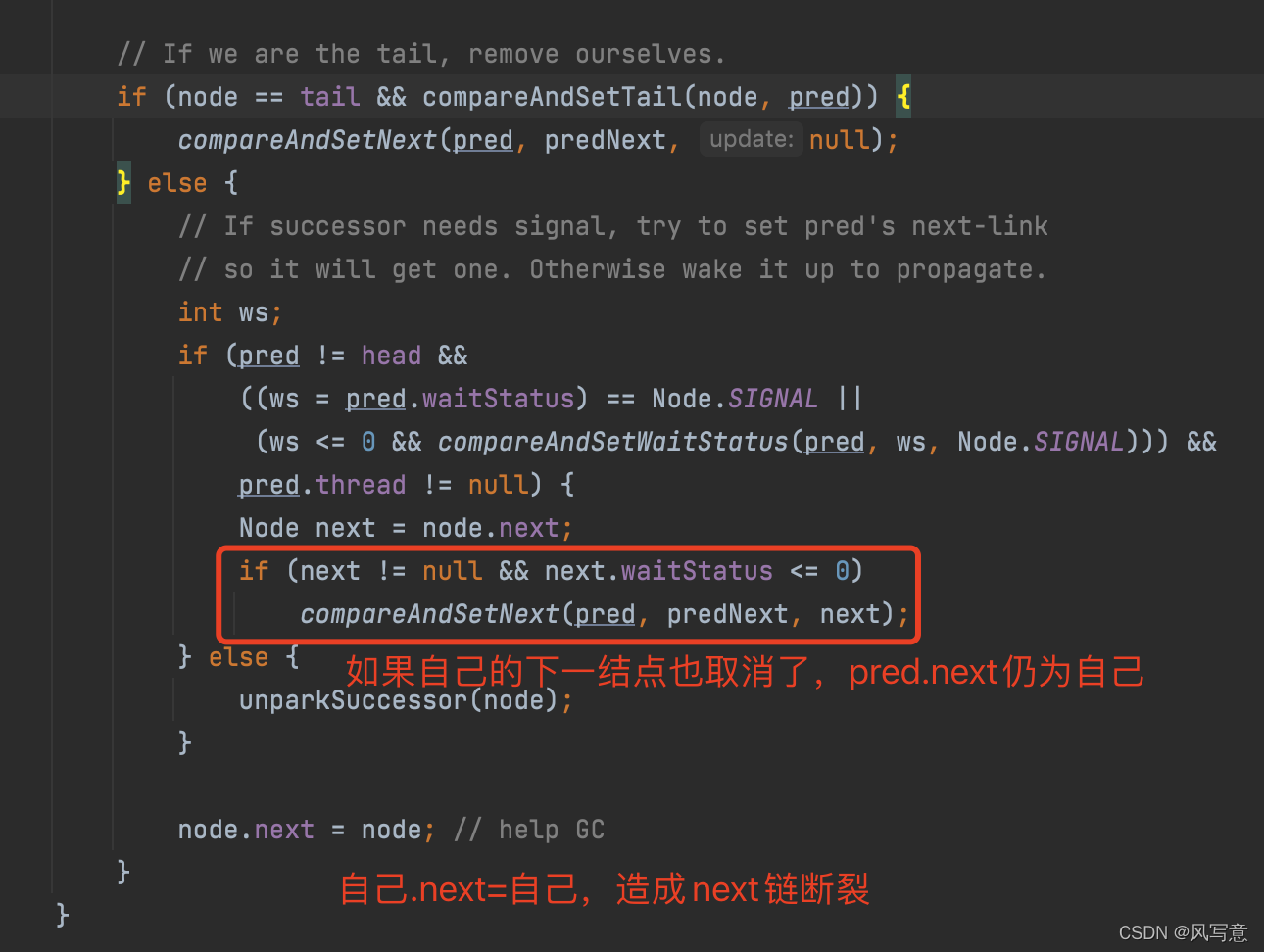

acquire

public final void acquire(int arg) {

if (!tryAcquire(arg) &&

acquireQueued(addWaiter(Node.EXCLUSIVE), arg))

selfInterrupt();

}

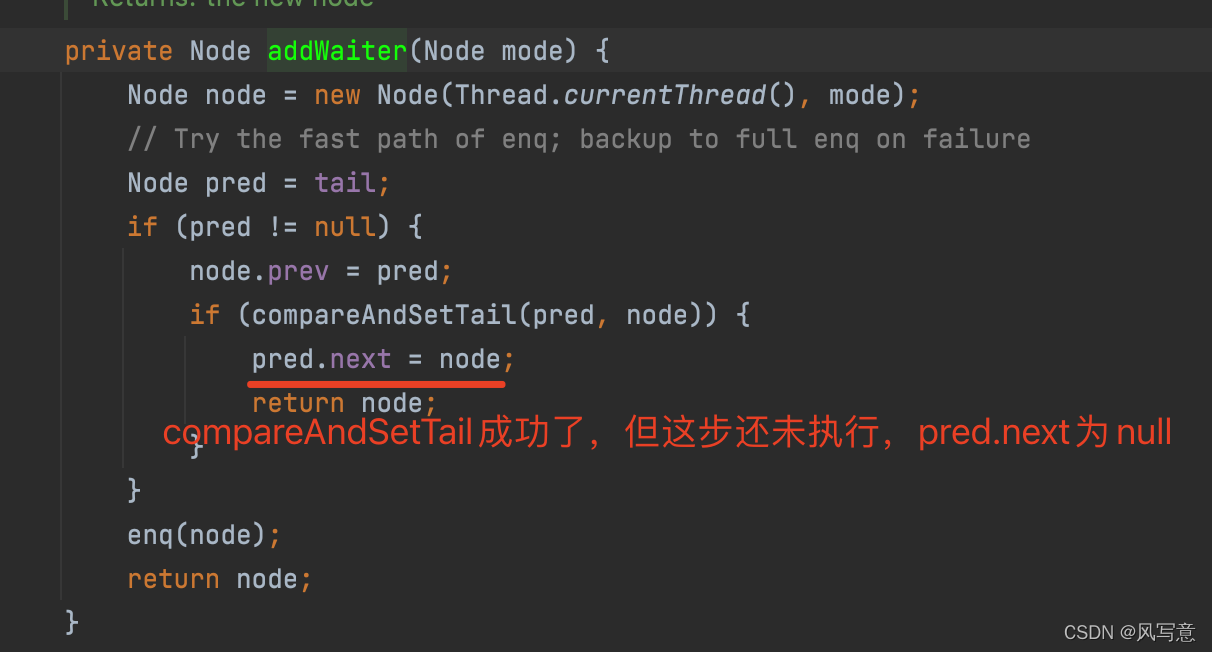

addWaiter

private Node addWaiter(Node mode) {

//以给定模式构造结点。mode有两种:EXCLUSIVE(独占)和SHARED(共享)

Node node = new Node(Thread.currentThread(), mode);

//尝试快速方式直接放到队尾。

Node pred = tail;

if (pred != null) {

node.prev = pred;

if (compareAndSetTail(pred, node)) {

pred.next = node;

return node;

}

}

//上一步失败则通过enq入队。

enq(node);

return node;

}

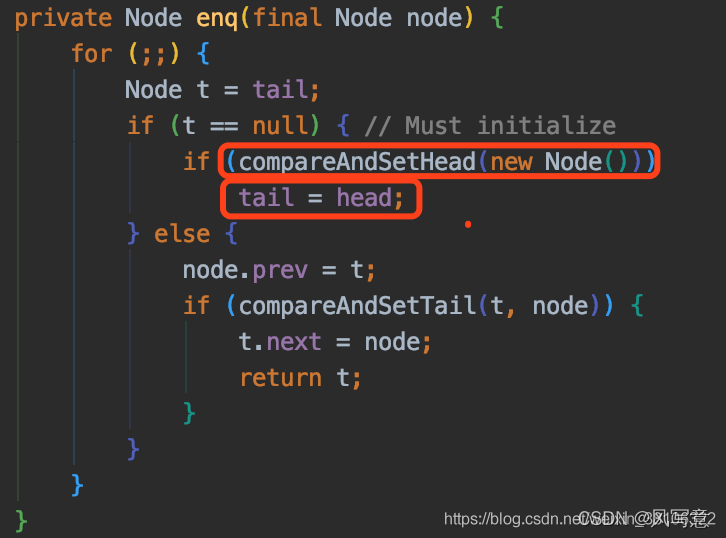

private Node enq(final Node node) {

//CAS"自旋",直到成功加入队尾

for (;;) {

Node t = tail;

if (t == null) { // 队列为空,创建一个空的标志结点作为head结点,并将tail也指向它。

if (compareAndSetHead(new Node()))

tail = head;

} else {//正常流程,放入队尾

node.prev = t;

if (compareAndSetTail(t, node)) {

t.next = node;

return t;

}

}

}

}

进入等待状态休息,直到其他线程彻底释放资源后唤醒自己,自己再拿到资源,然后就可以去干自己想干的事了。没错,就是这样!是不是跟医院排队拿号有点相似~~acquireQueued()就是干这件事:在等待队列中排队拿号(中间没其它事干可以休息),直到拿到号后再返回

acquireQueued

final boolean acquireQueued(final Node node, int arg) {

boolean failed = true;//标记是否成功拿到资源

try {

boolean interrupted = false;//标记等待过程中是否被中断过

//又是一个“自旋”!

for (;;) {

final Node p = node.predecessor();//拿到前驱

//如果前驱是head,即该结点已成老二,那么便有资格去尝试获取资源(可能是老大释放完资源唤醒自己的,当然也可能被interrupt了)。

if (p == head && tryAcquire(arg)) {

setHead(node);//拿到资源后,将head指向该结点。所以head所指的标杆结点,就是当前获取到资源的那个结点或null。

p.next = null; // setHead中node.prev已置为null,此处再将head.next置为null,就是为了方便GC回收以前的head结点。也就意味着之前拿完资源的结点出队了!

failed = false; // 成功获取资源

return interrupted;//返回等待过程中是否被中断过

}

//如果自己可以休息了,就通过park()进入waiting状态,直到被unpark()。如果不可中断的情况下被中断了,那么会从park()中醒过来,发现拿不到资源,从而继续进入park()等待。

if (shouldParkAfterFailedAcquire(p, node) &&

parkAndCheckInterrupt())

interrupted = true;//如果等待过程中被中断过,哪怕只有那么一次,就将interrupted标记为true

}

} finally {

if (failed) // 如果等待过程中没有成功获取资源(如timeout,或者可中断的情况下被中断了),那么取消结点在队列中的等待。

cancelAcquire(node);

}

}

shouldParkAfterFailedAcquire

private static boolean shouldParkAfterFailedAcquire(Node pred, Node node) {

int ws = pred.waitStatus;//拿到前驱的状态

if (ws == Node.SIGNAL)

//如果已经告诉前驱拿完号后通知自己一下,那就可以安心休息了

return true;

if (ws > 0) {

/*

* 如果前驱放弃了,那就一直往前找,直到找到最近一个正常等待的状态,并排在它的后边。

* 注意:那些放弃的结点,由于被自己“加塞”到它们前边,它们相当于形成一个无引用链,稍后就会被保安大叔赶走了(GC回收)!

*/

do {

node.prev = pred = pred.prev;

} while (pred.waitStatus > 0);

pred.next = node;

} else {

//如果前驱正常,那就把前驱的状态设置成SIGNAL,告诉它拿完号后通知自己一下。有可能失败,人家说不定刚刚释放完呢!

compareAndSetWaitStatus(pred, ws, Node.SIGNAL);

}

return false;

}

parkAndCheckInterrupt

private final boolean parkAndCheckInterrupt() {

LockSupport.park(this);//调用park()使线程进入waiting状态

return Thread.interrupted();//如果被唤醒,查看自己是不是被中断的。

}

总结acquireQueued,总结下该函数的具体流程:

1.结点进入队尾后,检查状态,找到安全休息点;

2.调用park()进入waiting状态,等待unpark()或interrupt()唤醒自己;

3.被唤醒后,看自己是不是有资格能拿到号。如果拿到,head指向当前结点,并返回从入队到拿到号的整个过程中是否被中断过;如果没拿到,继续流程1。

总结acquire,总结下该函数的具体流程:

1.调用自定义同步器的tryAcquire()尝试直接去获取资源,如果成功则直接返回;

2.没成功,则addWaiter()将该线程加入等待队列的尾部,并标记为独占模式;

3.acquireQueued()使线程在等待队列中休息,有机会时(轮到自己,会被unpark())会去尝试获取资源。获取到资源后才返回。如果在整个等待过程中被中断过,则返回true,否则返回false。

4.如果线程在等待过程中被中断过,它是不响应的。只是获取资源后才再进行自我中断selfInterrupt(),将中断补上。

release

public final boolean release(int arg) {

if (tryRelease(arg)) {

Node h = head;//找到头结点

if (h != null && h.waitStatus != 0)

unparkSuccessor(h);//唤醒等待队列里的下一个线程

return true;

}

return false;

}

它是根据tryRelease()的返回值来判断该线程是否已经完成释放掉资源了!所以自定义同步器在设计tryRelease()的时候要明确这一点!!

unparkSuccessor

private void unparkSuccessor(Node node) {

//这里,node一般为当前线程所在的结点。

int ws = node.waitStatus;

if (ws < 0)//置零当前线程所在的结点状态,允许失败。

compareAndSetWaitStatus(node, ws, 0);

Node s = node.next;//找到下一个需要唤醒的结点s

if (s == null || s.waitStatus > 0) {//如果为空或已取消

s = null;

for (Node t = tail; t != null && t != node; t = t.prev) // 从后向前找。

if (t.waitStatus <= 0)//从这里可以看出,<=0的结点,都是还有效的结点。

s = t;

}

if (s != null)

LockSupport.unpark(s.thread);//唤醒

}

用unpark()唤醒等待队列中最前边的那个未放弃线程,这里我们也用s来表示吧。此时,再和acquireQueued()联系起来,s被唤醒后,进入if (p == head && tryAcquire(arg))的判断(即使p!=head也没关系,它会再进入shouldParkAfterFailedAcquire()寻找一个安全点。这里既然s已经是等待队列中最前边的那个未放弃线程了,那么通过shouldParkAfterFailedAcquire()的调整,s也必然会跑到head的next结点,下一次自旋p==head就成立啦),然后s把自己设置成head标杆结点,表示自己已经获取到资源了,acquire()也返回了!

为什么从后向前找,而不是从前往后找?从前往后更简单啊。

1)s==null,在新结点入队时可能会出现

// java.util.concurrent.locks.AbstractQueuedSynchronizer

private Node enq(final Node node) {

for (;;) {

Node t = tail;

if (t == null) { // Must initialize

if (compareAndSetHead(new Node()))

tail = head;

} else {

node.prev = t;

if (compareAndSetTail(t, node)) {

t.next = node;

return t;

}

}

}

}

addWaiter就是一个在双端链表添加尾节点的操作,需要注意的是,双端链表的头结点是一个无参构造函数的头结点

2)s.waitStatus > 0,中间有节点取消时会出现(如超时)

总之,由于并发问题,addWaiter()入队操作和cancelAcquire()取消排队操作都会造成next链的不一致,而prev链是强一致的,所以这时从后往前找是最安全的。

为什么prev链是强一致的?因为addWaiter()里每次compareAndSetTail(pred, node)之前都有node.prev = pred,即使compareAndSetTail失败,enq()会反复尝试,直到成功。一旦compareAndSetTail成功,该node.prev就成功挂在之前的tail结点上了,而且是唯一的,这时其他新结点的prev只能尝试往新tail结点上挂。这里的组合用法非常巧妙,能保证CAS之前的prev链强一致,但不能保证CAS后的next链强一致。

acquireShared

public final void acquireShared(int arg) {

if (tryAcquireShared(arg) < 0)

doAcquireShared(arg);

}

负值代表获取失败;0代表获取成功,但没有剩余资源;正数表示获取成功,还有剩余资源,其他线程还可以去获取。所以这里acquireShared()的流程就是:

1.tryAcquireShared()尝试获取资源,成功则直接返回;

2.失败则通过doAcquireShared()进入等待队列,直到获取到资源为止才返回。

doAcquireShared

private void doAcquireShared(int arg) {

final Node node = addWaiter(Node.SHARED);//加入队列尾部

boolean failed = true;//是否成功标志

try {

boolean interrupted = false;//等待过程中是否被中断过的标志

for (;;) {

final Node p = node.predecessor();//前驱

if (p == head) {//如果到head的下一个,因为head是拿到资源的线程,此时node被唤醒,很可能是head用完资源来唤醒自己的

int r = tryAcquireShared(arg);//尝试获取资源

if (r >= 0) {//成功

setHeadAndPropagate(node, r);//将head指向自己,还有剩余资源可以再唤醒之后的线程

p.next = null; // help GC

if (interrupted)//如果等待过程中被打断过,此时将中断补上。

selfInterrupt();

failed = false;

return;

}

}

//判断状态,寻找安全点,进入waiting状态,等着被unpark()或interrupt()

if (shouldParkAfterFailedAcquire(p, node) &&

parkAndCheckInterrupt())

interrupted = true;

}

} finally {

if (failed)

cancelAcquire(node);

}

}

setHeadAndPropagate

private void setHeadAndPropagate(Node node, int propagate) {

Node h = head;

setHead(node);//head指向自己

//如果还有剩余量,继续唤醒下一个邻居线程

if (propagate > 0 || h == null || h.waitStatus < 0) {

Node s = node.next;

if (s == null || s.isShared())

doReleaseShared();

}

}

acquireShared()也要告一段落了。让我们再梳理一下它的流程:

1.tryAcquireShared()尝试获取资源,成功则直接返回;

2.失败则通过doAcquireShared()进入等待队列park(),直到被unpark()/interrupt()并成功获取到资源才返回。整个等待过程也是忽略中断的。

其实跟acquire()的流程大同小异,只不过多了个自己拿到资源后,还会去唤醒后继队友的操作(这才是共享嘛)。

releaseShared

public final boolean releaseShared(int arg) {

if (tryReleaseShared(arg)) {//尝试释放资源

doReleaseShared();//唤醒后继结点

return true;

}

return false;

}

此方法的流程也比较简单,一句话:释放掉资源后,唤醒后继。跟独占模式下的release()相似,但有一点稍微需要注意:独占模式下的tryRelease()在完全释放掉资源(state=0)后,才会返回true去唤醒其他线程,这主要是基于独占下可重入的考量;而共享模式下的releaseShared()则没有这种要求,共享模式实质就是控制一定量的线程并发执行,那么拥有资源的线程在释放掉部分资源时就可以唤醒后继等待结点。例如,资源总量是13,A(5)和B(7)分别获取到资源并发运行,C(4)来时只剩1个资源就需要等待。A在运行过程中释放掉2个资源量,然后tryReleaseShared(2)返回true唤醒C,C一看只有3个仍不够继续等待;随后B又释放2个,tryReleaseShared(2)返回true唤醒C,C一看有5个够自己用了,然后C就可以跟A和B一起运行。而ReentrantReadWriteLock读锁的tryReleaseShared()只有在完全释放掉资源(state=0)才返回true,所以自定义同步器可以根据需要决定tryReleaseShared()的返回值。

doReleaseShared

private void doReleaseShared() {

for (;;) {

Node h = head;

if (h != null && h != tail) {

int ws = h.waitStatus;

if (ws == Node.SIGNAL) {

if (!compareAndSetWaitStatus(h, Node.SIGNAL, 0))

continue;

unparkSuccessor(h);//唤醒后继

}

else if (ws == 0 &&

!compareAndSetWaitStatus(h, 0, Node.PROPAGATE))

continue;

}

if (h == head)// head发生变化

break;

}

}

Condition

public class Test {

final ReentrantLock lock = new ReentrantLock();

final Condition condition = lock.newCondition();

public void awaitTest() throws Exception{

try {

lock.lock();

condition.await();

System.out.println("解除等待");

} finally {

lock.unlock();

}

}

public void signalTest(){

try {

lock.lock();

condition.signal();

System.out.println("继续执行");

} finally {

lock.unlock();

}

}

public static void main(String[] args) {

Test test = new Test();

new Thread(()->{

try {

test.awaitTest();

} catch (Exception e) {

e.printStackTrace();

}

}).start();

new Thread(()->{

test.signalTest();

}).start();

}

}

执行结果如下:

继续执行

解除等待

面的代码是一个Condition最简单的使用方法,第一个方法await,第二个方法signal,执行完signal之后并不是把当前线程挂起去执行await方法,而是把当前方法执行完之后,释放锁之后,执行awaitTest的线程再去获取到锁,继续执行。

new了一个Condition,这段代码就会在AQS中创建一个等待队列,那如果多次执行上面的代码,就会在AQS中创建多个等待队列。

AQS中await/signal原理

当线程执行await,意味着当前线程一定是持有锁的,首先会把当前线程放入到等待队列队尾,之后把当前线程的锁释放掉,在上一篇文章介绍中可知,当当前线程释放锁之后,阻塞队列的第二个节点会获取到锁(正常情况下),当前持有锁的节点是首节点,当释放锁之后,首节点会被干掉,也就是说执行await的线程会从阻塞队列中干掉。

当执行signal的时候,会把位于等待队列中的首节点(首节点是等待时间最长的,因为是从队尾入队的)线程给唤醒,注意这里唤醒之后该线程并不能立即获取到锁,而是会把这个线程加入到阻塞队列队尾,如果阻塞队列中有很多的线程在等待,那被唤醒的线程还会继续挂起,然后慢慢等待去获取锁。

await源码分析

public final void await() throws InterruptedException {

if (Thread.interrupted())

throw new InterruptedException();

//将当前线程放入等待队列

Node node = addConditionWaiter();

//释放锁

int savedState = fullyRelease(node);

int interruptMode = 0;

//判断但概念线程是否从阻塞队列移除成功

while (!isOnSyncQueue(node)) {

//如果从阻塞队列移除成功,就把当前线程挂起

LockSupport.park(this);

if ((interruptMode = checkInterruptWhileWaiting(node)) != 0)

break;

}

//该方法在上一篇介绍AQS已经介绍过,主要作用就是把当前节点的前一个节点状态改成signal

//状态,改成这个状态之后就可以让前一个节点把自己唤醒

if (acquireQueued(node, savedState) && interruptMode != THROW_IE)

interruptMode = REINTERRUPT;

if (node.nextWaiter != null) // clean up if cancelled

//将等待队列上处于CANCELLED(取消)状态的节点给干掉

unlinkCancelledWaiters();

if (interruptMode != 0)

reportInterruptAfterWait(interruptMode);

}

private Node addConditionWaiter() {

//获取等待队列最后一个节点

Node t = lastWaiter;

// If lastWaiter is cancelled, clean out.

//如果最后一个节点状态不是等待状态,说明有可能被取消了,处于取消状态

//为什么会处于取消状态的呢?其实await还有其他类似方法的比如awaitNanos()可以传等待时间,如果超时就是取消状态

if (t != null && t.waitStatus != Node.CONDITION) {

//这个方法就是把队列中处于取消状态的节点给干掉,这个方法代码我觉得写的很怪,就不分析了。

unlinkCancelledWaiters();

t = lastWaiter;

}

//下面的就很简单了,就是把新建的节点挂到队列中

Node node = new Node(Thread.currentThread(), Node.CONDITION);

if (t == null)

firstWaiter = node;

else

t.nextWaiter = node;

lastWaiter = node;

return node;

}

final int fullyRelease(Node node) {

boolean failed = true;

try {

//获取AQS的state,注意这个值不一定是1,如果是重入锁的话,就会大于1

//这里相当于把重入锁都释放掉

int savedState = getState();

//这个release就是上一篇文章中已经介绍的释放锁的过程

if (release(savedState)) {

failed = false;

return savedState;

} else {

throw new IllegalMonitorStateException();

}

} finally {

if (failed)

//如果释放锁失败,就把当前线程改成CANCELLED状态

node.waitStatus = Node.CANCELLED;

}

}

signal分析

public final void signal() {

//判断当前线程是不是持有锁的线程,只有持有锁的线程才可以执行signal

if (!isHeldExclusively())

throw new IllegalMonitorStateException();

//等待队列的首节点

Node first = firstWaiter;

//只有等待队列中有需要被唤醒的才会执行唤醒操作

if (first != null)

doSignal(first);

}

private void doSignal(Node first) {

do {

//将等待队列的首节点指向第二个节点

if ( (firstWaiter = first.nextWaiter) == null)

lastWaiter = null;

first.nextWaiter = null;

//不停的重试唤醒首节点

} while (!transferForSignal(first) &&

(first = firstWaiter) != null);

}

final boolean transferForSignal(Node node) {

//当当前节点的状态改成0,如果不成功一致重试

if (!compareAndSetWaitStatus(node, Node.CONDITION, 0))

return false;

//将等待队列的首节点加入到阻塞队列的队尾,返回的p是阻塞队列倒数第二的节点

Node p = enq(node);

int ws = p.waitStatus;

//如果在阻塞队列当前节点的前一个节点处于取消状态,或者把当前节点的前一个节点改成signal状态失败

//就直接唤醒等待队列中的线程

//这里这么做的原因是,如果在阻塞队列中,当前节点的前一个节点处于取消状态,那他就无法唤醒他之后的节点

//如果改成signal不成功也是一样不能唤醒后面的节点

if (ws > 0 || !compareAndSetWaitStatus(p, ws, Node.SIGNAL))

LockSupport.unpark(node.thread);

return true;

}

CountDownLatch

计数器

//new countDownLatch(5)初始化state=5;用5个线程跑任务最后调用countDown方法逐此减1,主线程调用await方法如果获取锁失败(任务没跑完),把主线程加入队列(若队列已经初始化把该线程放到队尾若未初始化先初始化空头节点,自旋插入到队尾)。加入完队列自旋,判断此节点是不是第二个节点(AQS默认队首是获取到锁的状态),是第二个节点就再次尝试获取锁,这时获取成功就设置该节点为头节点并放行;否则通过前置节点的waitStatus判断该节点线程是不是要park。当最后一个线程跑完调用releaseShared方法中的doReleaseShared方法去自旋unpark队列的第二个节点。

public class CountDownLatchTest {

public static void main(String[] args) {

final CountDownLatch latch = new CountDownLatch(2);

System.out.println("主线程开始执行…… ……");

//第一个子线程执行

ExecutorService es1 = Executors.newSingleThreadExecutor();

es1.execute(new Runnable() {

@Override

public void run() {

try {

Thread.sleep(3000);

System.out.println("子线程:"+Thread.currentThread().getName()+"执行");

} catch (InterruptedException e) {

e.printStackTrace();

}

latch.countDown();

}

});

es1.shutdown();

//第二个子线程执行

ExecutorService es2 = Executors.newSingleThreadExecutor();

es2.execute(new Runnable() {

@Override

public void run() {

try {

Thread.sleep(3000);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("子线程:"+Thread.currentThread().getName()+"执行");

latch.countDown();

}

});

es2.shutdown();

System.out.println("等待两个线程执行完毕…… ……");

try {

latch.await();

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("两个子线程都执行完毕,继续执行主线程");

}

}

原理:基于AQS的共享锁,源码同AQS的共享模式

Semaphore

package com.thread;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

import java.util.concurrent.Semaphore;

public class SemaphoreTest {

public static void main(String[] args) {

ExecutorService service = Executors.newCachedThreadPool();

final Semaphore sp = new Semaphore(3);//创建Semaphore信号量,初始化许可大小为3

for(int i=0;i<10;i++){

try {

Thread.sleep(100);

} catch (InterruptedException e2) {

e2.printStackTrace();

}

Runnable runnable = new Runnable(){

public void run(){

try {

sp.acquire();//请求获得许可,如果有可获得的许可则继续往下执行,许可数减1。否则进入阻塞状态

} catch (InterruptedException e1) {

e1.printStackTrace();

}

System.out.println("线程" + Thread.currentThread().getName() +

"进入,当前已有" + (3-sp.availablePermits()) + "个并发");

try {

Thread.sleep((long)(Math.random()*10000));

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("线程" + Thread.currentThread().getName() +

"即将离开");

sp.release();//释放许可,许可数加1

//下面代码有时候执行不准确,因为其没有和上面的代码合成原子单元

System.out.println("线程" + Thread.currentThread().getName() +

"已离开,当前已有" + (3-sp.availablePermits()) + "个并发");

}

};

service.execute(runnable);

}

}

}

源码

final int nonfairTryAcquireShared(int acquires) {

for (;;) {

int available = getState();

int remaining = available - acquires;

if (remaining < 0 ||

compareAndSetState(available, remaining))

return remaining;

}

}

protected int tryAcquireShared(int acquires) {

for (;;) {

if (hasQueuedPredecessors())

return -1;

int available = getState();

int remaining = available - acquires;

if (remaining < 0 ||

compareAndSetState(available, remaining))

return remaining;

}

}

类似AQS,不再详细阐述

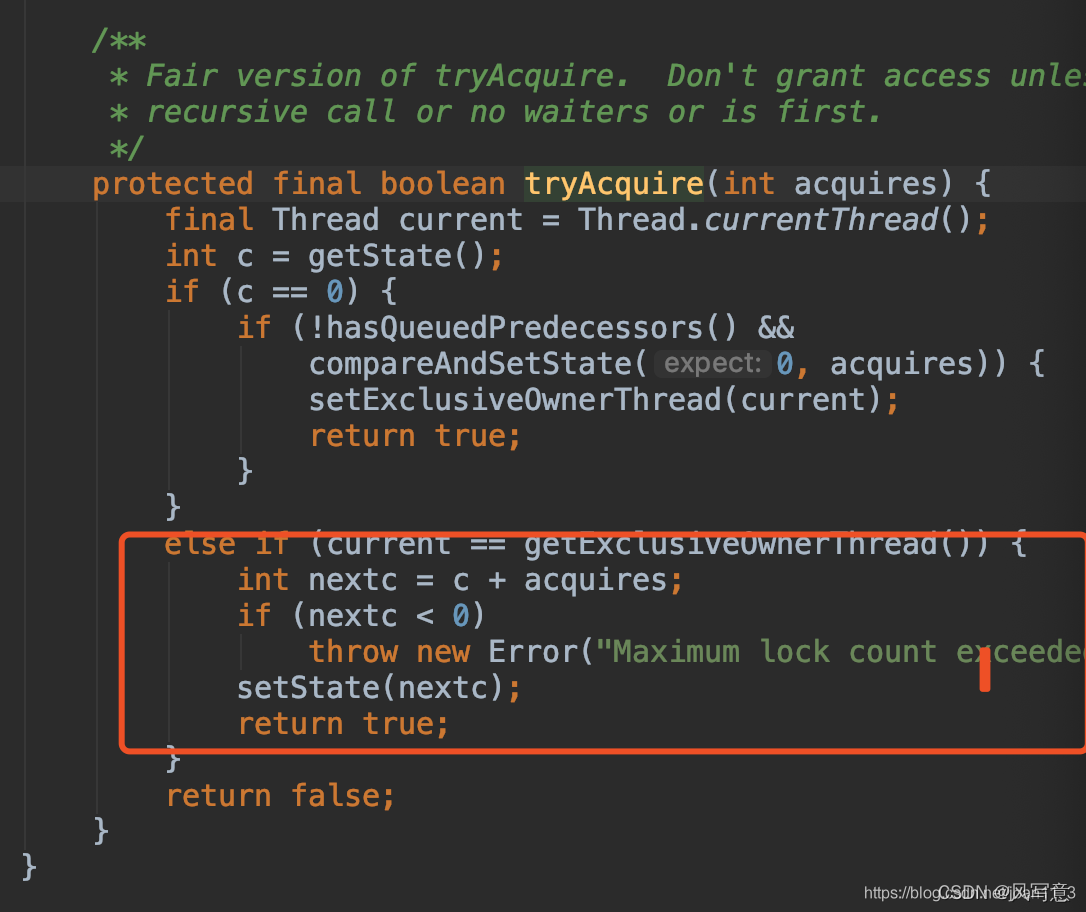

ReentrantLock

独占锁,实现了AQS的tryAcquire方法

红色这段就是可重入锁的实现。

hasQueuedPredecessors代码是判断当前线程是否为列队头中的线程。。。在阻塞的线程中只有头线程才能获取成功锁(此为公平锁的实现),非公平锁少此条件。

非公平锁实现

abstract static class Sync extends AbstractQueuedSynchronizer {

// 序列号

private static final long serialVersionUID = -5179523762034025860L;

// 获取锁

abstract void lock();

// 非公平方式获取

final boolean nonfairTryAcquire(int acquires) {

// 当前线程

final Thread current = Thread.currentThread();

// 获取状态

int c = getState();

if (c == 0) { // 表示没有线程正在竞争该锁

if (compareAndSetState(0, acquires)) { // 比较并设置状态成功,状态0表示锁没有被占用

// 设置当前线程独占

setExclusiveOwnerThread(current);

return true; // 成功

}

}

else if (current == getExclusiveOwnerThread()) { // 当前线程拥有该锁

int nextc = c + acquires; // 增加重入次数

if (nextc < 0) // overflow

throw new Error("Maximum lock count exceeded");

// 设置状态

setState(nextc);

// 成功

return true;

}

// 失败

return false;

}

// 试图在共享模式下获取对象状态,此方法应该查询是否允许它在共享模式下获取对象状态,如果允许,则获取它

protected final boolean tryRelease(int releases) {

int c = getState() - releases;

if (Thread.currentThread() != getExclusiveOwnerThread()) // 当前线程不为独占线程

throw new IllegalMonitorStateException(); // 抛出异常

// 释放标识

boolean free = false;

if (c == 0) {

free = true;

// 已经释放,清空独占

setExclusiveOwnerThread(null);

}

// 设置标识

setState(c);

return free;

}

// 判断资源是否被当前线程占有

protected final boolean isHeldExclusively() {

return getExclusiveOwnerThread() == Thread.currentThread();

}

// 新生一个条件

final ConditionObject newCondition() {

return new ConditionObject();

}

// 返回资源的占用线程

final Thread getOwner() {

return getState() == 0 ? null : getExclusiveOwnerThread();

}

// 返回状态

final int getHoldCount() {

return isHeldExclusively() ? getState() : 0;

}

// 资源是否被占用

final boolean isLocked() {

return getState() != 0;

}

// 自定义反序列化逻辑

private void readObject(java.io.ObjectInputStream s)

throws java.io.IOException, ClassNotFoundException {

s.defaultReadObject();

setState(0); // reset to unlocked state

}

}

从 lock方法的源码可知,每一次都尝试获取锁,而并不会按照公平等待的原则进行等待,让等待时间最久的线程获得锁。Acquire方法是 FairSync和 UnfairSync的父类 AQS中的核心方法。

公平锁总结:lock方法一调用,先尝试获取锁(state不为0且独占线程不是当前线程,获取失败;state不为0且独占线程是当前线程,获取成功;state==0时,如果不需要排队且修改state成功,获取成功,如果需要排队,获取失败排队去。)获取成功执行核心代码,获取失败先加入CLH队列(可能包含初始化队列,加入队列都会把前置节点的waitState从0置为-1),再自旋判断自己是不是第二个节点,不是就根据前置节点的waitState判断要不要park,是就尝试获取锁,获取成功就把自己设置为头节点(在运行的线程放在头节点不参与竞争)并将之前的头节点置为空(方便gc)。unlock方法一调用,先尝试释放锁(解除独占线程),释放成功就唤醒第二个节点。

判断需不需要排队方法逻辑是:

情况一: h != t返回false,那么短路与判断就会直接返回false

1.头节点和尾节点都为null,表示队列都还是空的,甚至都没完成初始化,那么自然返回fasle,无需排队。

2.头节点和尾节点不为null但是相等,说明头节点和尾节点都指向一个元素,表示队列中只有一个节点,这时候自然无需排队,因为队列中的第一个节点是不参与排队的,它持有着同步状态,那么第二个进来的节点就无需排队,因为它的前继节点就是头节点,所以第二个进来的节点就是第一个能正常获取同步状态的节点,第三个节点才需要排队,等待第二个节点释放同步状态。

情况二:h != t返回true,(s = h.next) == null返回false以及s.thread !=

Thread.currentThread()返回false

说明:h != t返回true表示队列中至少有两个不同节点存在。

(s = h.next) == null返回false表示头节点是有后继节点的。

s.thread != Thread.currentThread()返回fasle表示着当前线程和后继节点的线程是相同的,那就说明已经轮到这个线程相关的节点去尝试获取同步状态了,自然无需排队,直接返回fasle。

情况三: h != t返回true,(s = h.next) == null返回true

h != t返回true表示队列中至少有两个不同节点存在。

(s = h.next) == null返回true,说明头节点之后是没有后继节点的,这情况可能发生在如下情景:有另一个线程已经执行到初始化队列的操作了,介于compareAndSetHead(new Node())与tail = head之间,如下:

这时候头节点不为null,而尾节点tail还没有被赋值,所以值为null,所以会满足h != t结果为true的判断,以及头节点的后继节点还是为null的判断,这时候可以直接返回true,表示要排队了,因为在当前线程还在做尝试获取同步状态的操作时,已经有另一个线程准备入队了,当前线程慢人一步,自然就得去排队。

情况四:h != t返回true,(s = h.next) == null返回false,s.thread !=

Thread.currentThread()返回true。

h != t返回true表示队列中至少有两个不同节点存在。

(s = h.next) == null返回false表示首节点是有后继节点的。

s.thread != Thread.currentThread()返回true表示后继节点的相关线程不是当前线程,所以首节点虽然有后继节点,但是后继节点相关的线程却不是当前线程,那当前线程自然得老老实实的去排队。

公平锁与非公平锁

什么叫公平锁呢?也就是在锁上等待时间最长的线程将获得锁的使用权。通俗的理解就是谁排队时间最长谁先执行获取锁

new ReentranLock(true)为公平锁,false或者不传都是非公平锁。

AtomicInteger

public final int incrementAndGet() {

return unsafe.getAndAddInt(this, valueOffset, 1) + 1;

}

底层还是CAS实现的

AtomicStampedReference是解决ABA问题的,加了时间戳作为版本号

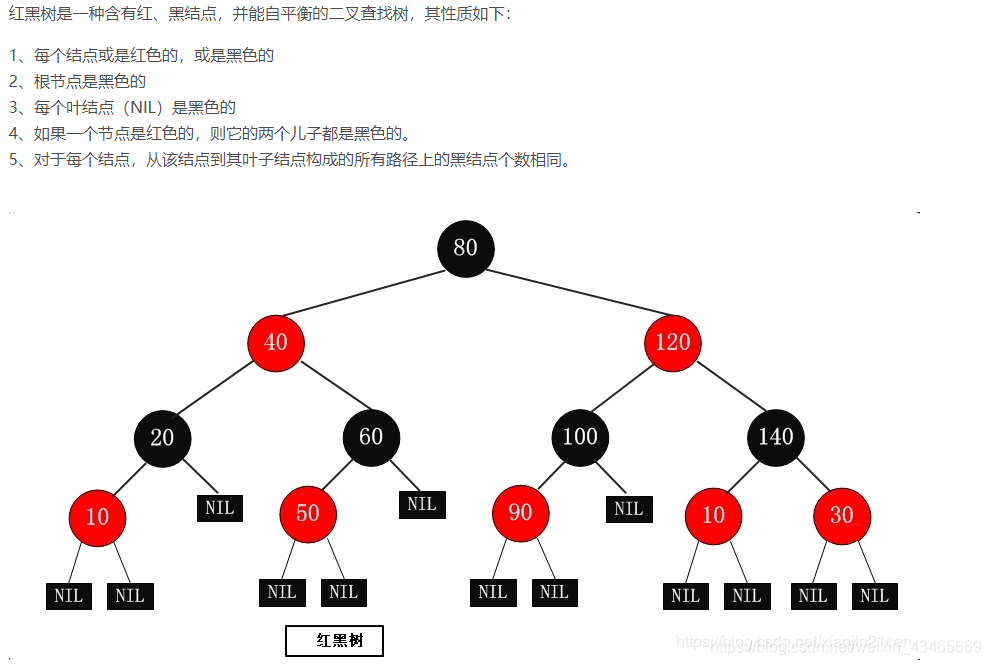

第四章:Map源码分析

HashMap源码

1.Java8为啥要引入红黑树,为啥还要链表不直接使用红黑树?何时从链表转换为红黑树?

解决链表过长查询效率过低。红黑树的插入由于自旋消耗性能,所以小于8的情况使用链表,大于8使用红黑树。

2.HashMap的大小为啥要是2的n次方?

为了存取高效,要尽量较少碰撞,就是要尽量把数据分配均匀。2的n次方实际就是1后面n个0,2的n次方-1 实际就是n个1;

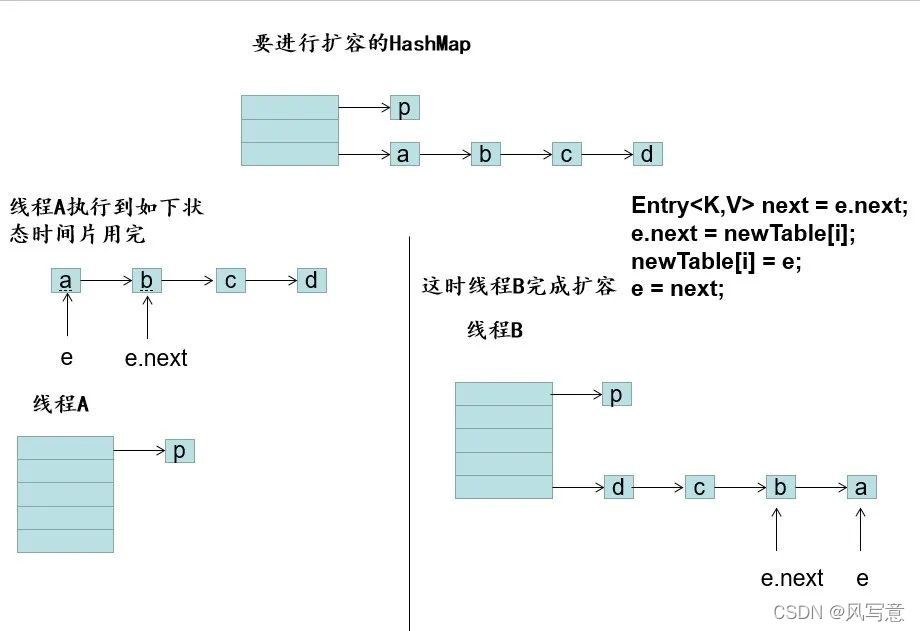

3.HashMap为啥要从头插法转为尾插法?

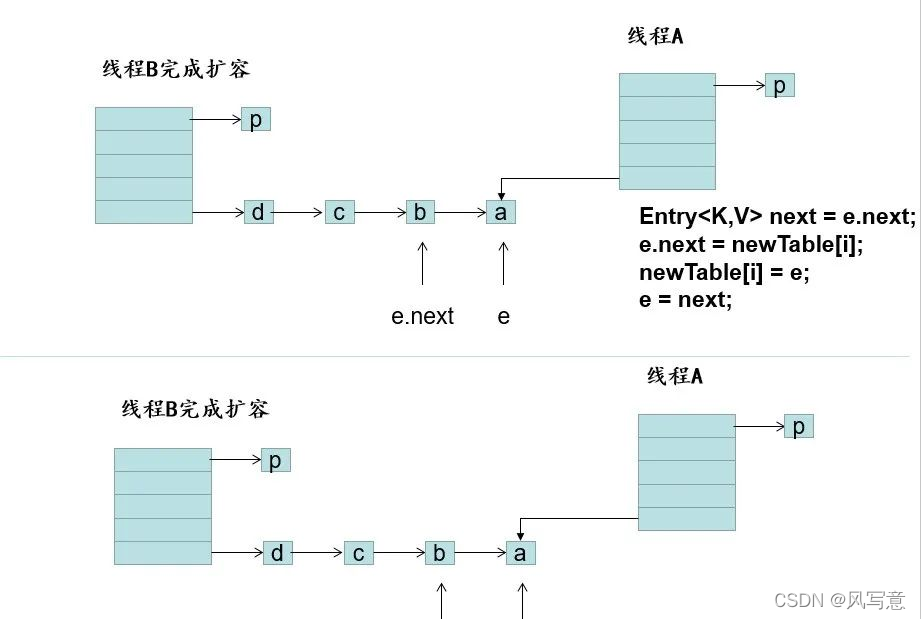

1.7头插可能闭环:

使用头插会改变链表的上的顺序,但是如果使用尾插,在扩容时会保持链表元素原本的顺序,就不会出现链表成环的问题了。

Java8在同样的前提下并不会引起死循环,原因是扩容转移后前后链表顺序不变,保持之前节点的引用关系。

4.HashMap的线程不安全性?

5.HashMap构造函数传table大小为10,实际table初始大小为多少?

tableSizeFor方法处理,将传来的数字最高位取1,后面全取0。10=0b1010.会做n-1与(n-1)的无符号右移1,2,3,4做四次或运算。取成0b1111=15;再加一取成16。

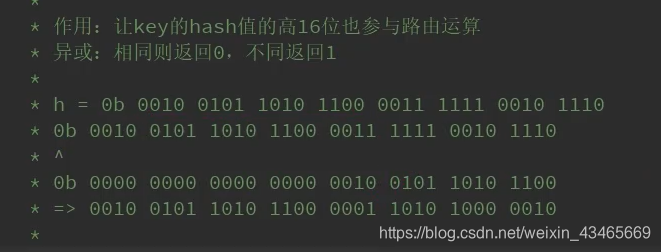

6.HashMap的index寻址?

index=(length-1)& (hash(key))。

是对key做hashCode直接参与运算吗?

不是,为了寻址更加散列,h=hashCode(key)^(h>>>16),使hashCode的高16位也参与计算,异或运算。当数组的长度很短时,只有低位数的hashcode值能参与运算。而让高16位参与运算可以更好的均匀散列,减少碰撞,进一步降低hash冲突的几率。并且使得高16位和低16位的信息都被保留了

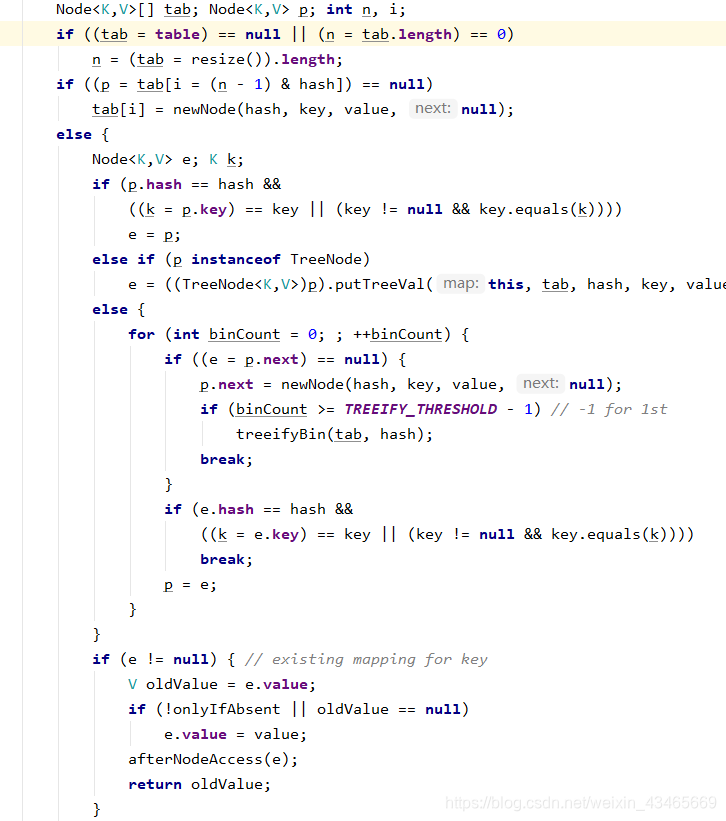

7.put方法过程?

如果table未初始化,则先初始化

如果要插入的元素所在位置上没有元素,直接插入作为头节点

如果要插入的元素和hash冲突的头元素完全相等,则将e赋值为该元素

如果hash冲突的头元素是TreeNode类型,则做TreeNode插入

如果hash冲突的头元素是链表类型,循环链表==》

如果循环到其中一个节点相等时,将e赋值为该元素,跳出循环,否则指针右移。

如果循环到最后一个节点没找到相同元素,则直接尾插并判断是否需要树化。

如果e不为空,根据是否替换配置onlyIfAbsent处理逻辑。

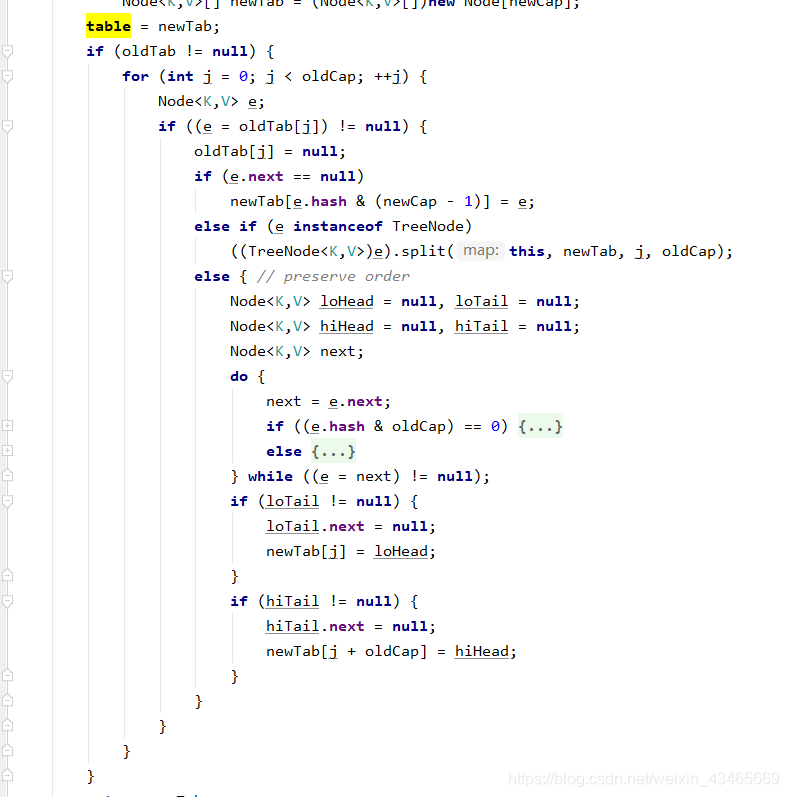

8.resize方法过程?

由于new HashMap()时并不会初始化table,put值会调用resize方法初始化容量和阈值;准备一个新的table,遍历老table,如果桶位上的元素的指针为空,计算在新桶位的索引并赋值newTab[e.hash & (newCap - 1)] = e;

如果桶位上的元素已经被树化,走树化的逻辑;如果桶位上的元素是链表,准备一个高位链表和一个低位链表,循环链表,(e.hash & oldCap) == 0说明该元素的hash一位是0低位,放进低位链表,反之放入高位链表;低位链表插入到新数组的原位置,高位链表插入到新数组的原索引+原数组容量;

比如一个容量为16的链表第15个索引上的元素的hash值一定是

…01111或…11111;才能与1111与的结果还是1111;扩容后与11111与的结果就有15和31两种情况,对应低位链表和高位链表

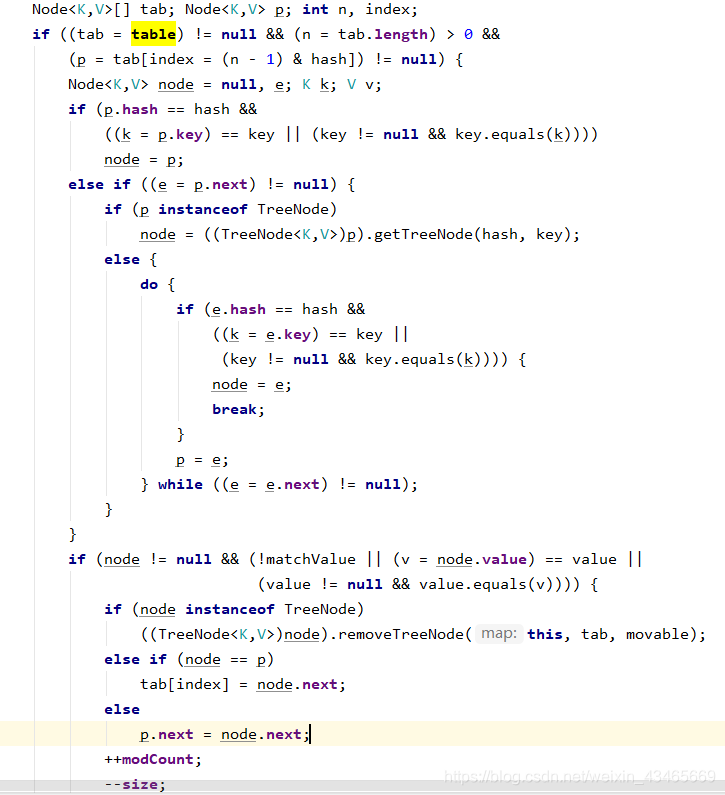

9.remove方法过程?

和put方法类似;只不过删除的时候需要记录前一个节点p和当前要删除的节点node。

10.高并发HashMap的环是如何产生的?

HashMap并发情况下产生的死循环问题在JDK 1.7及之前版本是存在的,JDK 1.8 通过增加loHead头节点和loTail尾节点进行了修复,虽然进行了修复,但是如果涉及到并发情况下需要使用hash表,建议使用CurrentHashMap替代HashMap来确保不会出现线程安全问题

1.7版本

//将老的表中的数据拷贝到新的结构中

void transfer(Entry[] newTable, boolean rehash) {

int newCapacity = newTable.length;//容量

for (Entry<K,V> e : table) { //遍历所有桶

while(null != e) { //遍历桶中所有元素(是一个链表)

Entry<K,V> next = e.next;

if (rehash) {//如果是重新Hash,则需要重新计算hash值

e.hash = null == e.key ? 0 : hash(e.key);

}

int i = indexFor(e.hash, newCapacity);//定位Hash桶

e.next = newTable[i];//元素连接到桶中,这里相当于单链表的插入,总是插入在最前面

newTable[i] = e;//newTable[i]的值总是最新插入的值

e = next;//继续下一个元素

}

}

}

执行后代码如图,当e = a时,这时候这时候再执行

e.next = newTable[i];// a元素指向了b元素,产生了循环

在链表产生了循环后,当get()方法获取元素的时候正好落在这个循环的链表上时,线程会一直在环里遍历,无法跳出,从而导致CPU飙升至100%!

ConcurrentHashMap

1.sizeCtl的含义?

sizeCtl==0表示数组尚未初始化;sizeCtl>0时如果数组未初始化则表示数组初始容量,如果数组已经初始化则表示扩容阈值;sizeCtl=-1表示数组正在初始化;size=-(1+n)<-1表示有n个线程正在扩容

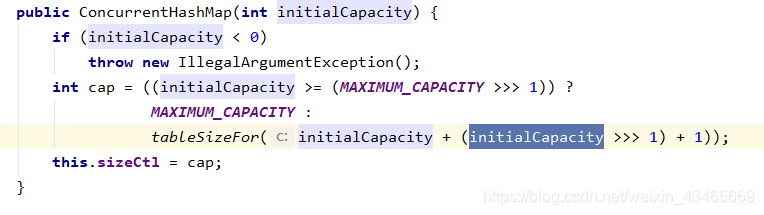

2.new ConcurrentHashMap(15)的数组容量是多少?

15+8+1=24;将24传入tableSizeFor方法中得到32,ConcurrentHashMap容量32;HashMap容量是16;

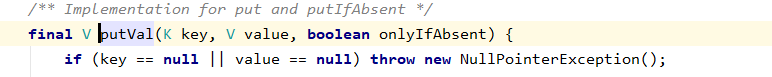

3.ConcurrentHashMap的key可以为空么?

不可以,HashMap可以。

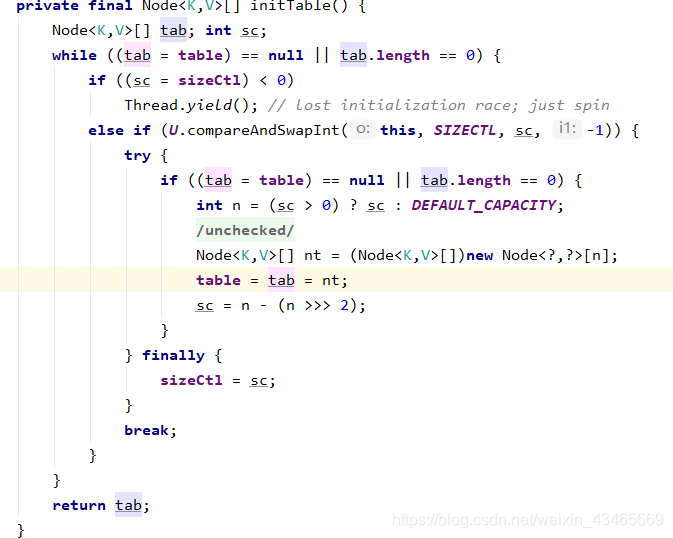

4.初始化如何保证线程安全的?

CAS比较算法判断sizeCtl与sc=0是否相等,等表示未初始化,开始进入初始化方法,其他线程由于已经设置sizeCtl为-1线程让渡;初始化完成后也会相等,再次判断table是否为空以免多次初始化;初始化完成后sizeCtl设为0.75n;整个过程无锁,纯CAS操作

5.put方法过程?

final V putVal(K key, V value, boolean onlyIfAbsent) {

//key为null报错

if (key == null || value == null) throw new NullPointerException();

//(h ^ (h >>> 16)) & HASH_BITS保证hash一定为正,用来区分forward节点

int hash = spread(key.hashCode());

int binCount = 0;

for (Node<K,V>[] tab = table;;) {

Node<K,V> f; int n, i, fh;

//初始化

if (tab == null || (n = tab.length) == 0)

tab = initTable();

//桶位上元素为空,直接cas插入

else if ((f = tabAt(tab, i = (n - 1) & hash)) == null) {

if (casTabAt(tab, i, null,

new Node<K,V>(hash, key, value, null)))

break; // no lock when adding to empty bin

}

//多线程操作时协助扩容(forward节点表示扩容)

else if ((fh = f.hash) == MOVED)

tab = helpTransfer(tab, f);

else {

V oldVal = null;

//对桶位加锁

synchronized (f) {

if (tabAt(tab, i) == f) {

if (fh >= 0) {

binCount = 1;

//循环链表

for (Node<K,V> e = f;; ++binCount) {

K ek;

if (e.hash == hash &&

((ek = e.key) == key ||

(ek != null && key.equals(ek)))) {

oldVal = e.val;

if (!onlyIfAbsent)

e.val = value;

break;

}

//遍历到链表最后一个节点,直接尾插

Node<K,V> pred = e;

if ((e = e.next) == null) {

pred.next = new Node<K,V>(hash, key,

value, null);

break;

}

}

}

else if (f instanceof TreeBin) {

Node<K,V> p;

binCount = 2;

if ((p = ((TreeBin<K,V>)f).putTreeVal(hash, key,

value)) != null) {

oldVal = p.val;

if (!onlyIfAbsent)

p.val = value;

}

}

}

}

if (binCount != 0) {

if (binCount >= TREEIFY_THRESHOLD)

treeifyBin(tab, i);

if (oldVal != null)

return oldVal;

break;

}

}

}

addCount(1L, binCount);

return null;

}

6.size怎么计算的?

在高并发场景下,size的计算采用LongAdder的思想

private final void addCount(long x, int check) {

CounterCell[] as; long b, s;

/**

* 判断counterCells是否为空,

* 1. 如果为空,就通过cas操作尝试修改baseCount变量,对这个变量进行原子累加操作

* (做这个操作的意义是:如果在没有竞争的情况下,仍然采用baseCount来记录元素个数)

* 2. 如果cas失败说明存在竞争,这个时候不能再采用baseCount来累加,而是通过CounterCell来记录

*/

if ((as = counterCells) != null ||

!U.compareAndSwapLong(this, BASECOUNT, b = baseCount, s = b + x)) {

CounterCell a; long v; int m;

//是否冲突标识,默认为没有冲突

boolean uncontended = true;

//这里有几个判断

//1. 计数表为空则直接调用fullAddCount

//2. 从计数表中随机取出一个数组的位置为空,直接调用fullAddCount

//3. 通过CAS修改CounterCell随机位置的值,如果修改失败说明出现并发情况(这里又用到了一种巧妙的方法),调用fullAndCount

//Random在线程并发的时候会有性能问题以及可能会产生相同的随机数,ThreadLocalRandom.getProbe可以解决这个问题,并且性能要比Random高

if (as == null || (m = as.length - 1) < 0 ||

(a = as[ThreadLocalRandom.getProbe() & m]) == null ||

!(uncontended =

U.compareAndSwapLong(a, CELLVALUE, v = a.value, v + x))) {

fullAddCount(x, uncontended);

return;

}

//链表长度小于等于1,不需要考虑扩容

if (check <= 1)

return;

//统计ConcurrentHashMap元素个数

s = sumCount();

}

if (check >= 0) {

Node<K,V>[] tab, nt; int n, sc;

while (s >= (long)(sc = sizeCtl) && (tab = table) != null &&

(n = tab.length) < MAXIMUM_CAPACITY) {

int rs = resizeStamp(n);

if (sc < 0) {

if ((sc >>> RESIZE_STAMP_SHIFT) != rs || sc == rs + 1 ||

sc == rs + MAX_RESIZERS || (nt = nextTable) == null ||

transferIndex <= 0)

break;

if (U.compareAndSwapInt(this, SIZECTL, sc, sc + 1))

transfer(tab, nt);

}

else if (U.compareAndSwapInt(this, SIZECTL, sc,

(rs << RESIZE_STAMP_SHIFT) + 2))

transfer(tab, null);

s = sumCount();

}

}

}

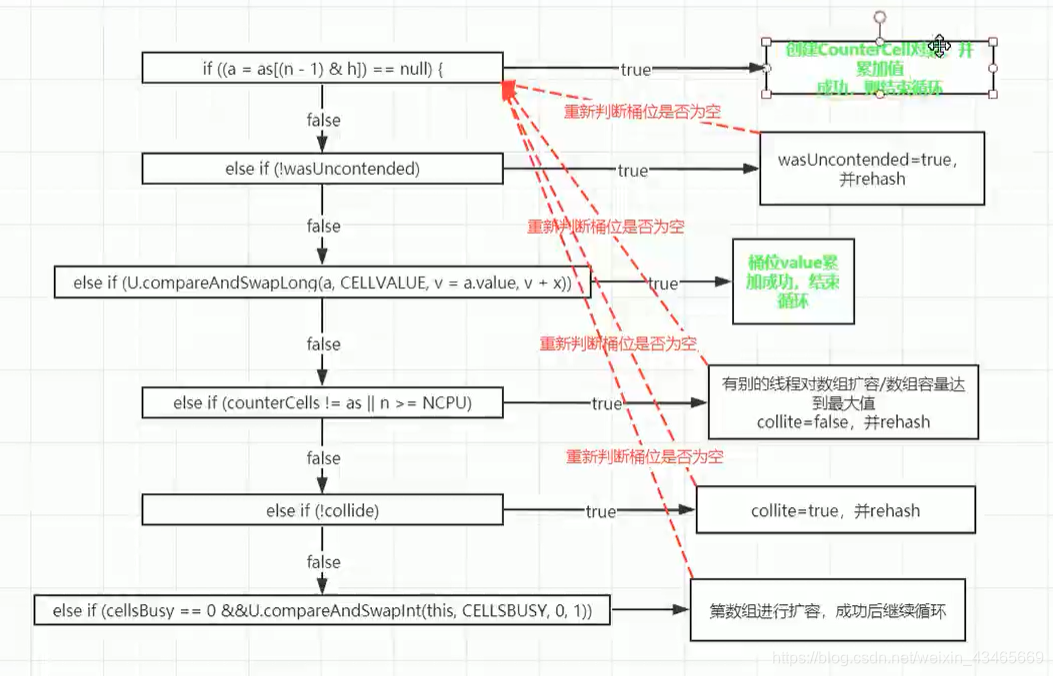

private final void fullAddCount(long x, boolean wasUncontended) {

int h;

//获取当前线程的probe的值,如果值为0,则初始化当前线程的probe的值,probe就是随机数

if ((h = ThreadLocalRandom.getProbe()) == 0) {

ThreadLocalRandom.localInit(); // force initialization

h = ThreadLocalRandom.getProbe();

// 由于重新生成了probe,未冲突标志位设置为true

wasUncontended = true;

}

boolean collide = false; // True if last slot nonempty

//自旋

for (;;) {

CounterCell[] as; CounterCell a; int n; long v;

//说明counterCells已经被初始化过了,我们先跳过这个代码,先看初始化部分

if ((as = counterCells) != null && (n = as.length) > 0) {

// 通过该值与当前线程probe求与,获得cells的下标元素,和hash 表获取索引是一样的

if ((a = as[(n - 1) & h]) == null) {

//cellsBusy=0表示counterCells不在初始化或者扩容状态下

if (cellsBusy == 0) { // Try to attach new Cell

//构造一个CounterCell的值,传入元素个数

CounterCell r = new CounterCell(x); // Optimistic create

//通过cas设置cellsBusy标识,防止其他线程来对counterCells并发处理

if (cellsBusy == 0 &&

U.compareAndSwapInt(this, CELLSBUSY, 0, 1)) {

boolean created = false;

try { // Recheck under lock

CounterCell[] rs; int m, j;

//将初始化的r对象的元素个数放在对应下标的位置

if ((rs = counterCells) != null &&

(m = rs.length) > 0 &&

rs[j = (m - 1) & h] == null) {

rs[j] = r;

created = true;

}

} finally {

//恢复标志位

cellsBusy = 0;

}

if (created)

break;

//说明指定cells下标位置的数据不为空,则进行下一次循环

continue; // Slot is now non-empty

}

}

collide = false;

}

//说明在addCount方法中cas失败了,并且获取probe的值不为空

else if (!wasUncontended) // CAS already known to fail

//设置为未冲突标识,进入下一次自旋

wasUncontended = true; // Continue after rehash

//由于指定下标位置的cell值不为空,则直接通过cas进行原子累加,如果成功,则直接退出

else if (U.compareAndSwapLong(a, CELLVALUE, v = a.value, v + x))

break;

//如果已经有其他线程建立了新的counterCells或者CounterCells大于CPU核心数(很巧妙,线程的并发数不会超过cpu核心数)

else if (counterCells != as || n >= NCPU)

//设置当前线程的循环失败不进行扩容

collide = false; // At max size or stale

//恢复collide状态,标识下次循环会进行扩容

else if (!collide)

collide = true;

//进入这个步骤,说明CounterCell数组容量不够,线程竞争较大,所以先设置一个标识表示为正在扩容

else if (cellsBusy == 0 &&

U.compareAndSwapInt(this, CELLSBUSY, 0, 1)) {

try {

if (counterCells == as) {// Expand table unless stale

//扩容一倍 2变成4,这个扩容比较简单

CounterCell[] rs = new CounterCell[n << 1];

for (int i = 0; i < n; ++i)

rs[i] = as[i];

counterCells = rs;

}

} finally {

//恢复标识

cellsBusy = 0;

}

collide = false;

//继续下一次自旋

continue; // Retry with expanded table

}

//继续下一次自旋

h = ThreadLocalRandom.advanceProbe(h);

}

//cellsBusy=0表示没有在做初始化,通过cas更新cellsbusy的值标注当前线程正在做初始化操作

else if (cellsBusy == 0 && counterCells == as &&

U.compareAndSwapInt(this, CELLSBUSY, 0, 1)) {

boolean init = false;

try { // Initialize table

if (counterCells == as) {

//初始化容量为2

CounterCell[] rs = new CounterCell[2];

//将x也就是元素的个数 放在指定的数组下标位置

rs[h & 1] = new CounterCell(x);

//赋值给counterCells

counterCells = rs;

//设置初始化完成标识

init = true;

}

} finally {

//恢复标识

cellsBusy = 0;

}

if (init)

break;

}

else if (U.compareAndSwapLong(this, BASECOUNT, v = baseCount, v + x))

//竞争激烈,其它线程占据cell 数组,直接累加在base变量中

break; // Fall back on using base

}

7.扩容过程?

//调用该扩容方法的地方有:

//java.util.concurrent.ConcurrentHashMap#addCount 向集合中插入新数据后更新容量计数时发现到达扩容阈值而触发的扩容

//java.util.concurrent.ConcurrentHashMap#helpTransfer 扩容状态下其他线程对集合进行插入、修改、删除、合并、compute 等操作时遇到 ForwardingNode 节点时触发的扩容

//java.util.concurrent.ConcurrentHashMap#tryPresize putAll批量插入或者插入后发现链表长度达到8个或以上,但数组长度为64以下时触发的扩容

private final void transfer(Node<K,V>[] tab, Node<K,V>[] nextTab) {

int n = tab.length, stride;

//计算每条线程处理的桶个数,每条线程处理的桶数量一样,如果CPU为单核,则使用一条线程处理所有桶

//每条线程至少处理16个桶,如果计算出来的结果少于16,则一条线程处理16个桶

if ((stride = (NCPU > 1) ? (n >>> 3) / NCPU : n) < MIN_TRANSFER_STRIDE)

stride = MIN_TRANSFER_STRIDE; // subdivide range

if (nextTab == null) { // 初始化新数组(原数组长度的2倍)

try {

@SuppressWarnings("unchecked")

Node<K,V>[] nt = (Node<K,V>[])new Node<?,?>[n << 1];

nextTab = nt;

} catch (Throwable ex) { // try to cope with OOME

sizeCtl = Integer.MAX_VALUE;

return;

}

nextTable = nextTab;

//将 transferIndex 指向最右边的桶,也就是数组索引下标最大的位置

transferIndex = n;

}

int nextn = nextTab.length;

//新建一个占位对象,该占位对象的 hash 值为 -1 该占位对象存在时表示集合正在扩容状态,key、value、next 属性均为 null ,nextTable 属性指向扩容后的数组

//该占位对象主要有两个用途:

// 1、占位作用,用于标识数组该位置的桶已经迁移完毕,处于扩容中的状态。

// 2、作为一个转发的作用,扩容期间如果遇到查询操作,遇到转发节点,会把该查询操作转发到新的数组上去,不会阻塞查询操作。

ForwardingNode<K,V> fwd = new ForwardingNode<K,V>(nextTab);

//该标识用于控制是否继续处理下一个桶,为 true 则表示已经处理完当前桶,可以继续迁移下一个桶的数据

boolean advance = true;

//该标识用于控制扩容何时结束,该标识还有一个用途是最后一个扩容线程会负责重新检查一遍数组查看是否有遗漏的桶

boolean finishing = false; // to ensure sweep before committing nextTab

//这个循环用于处理一个 stride 长度的任务,i 后面会被赋值为该 stride 内最大的下标,而 bound 后面会被赋值为该 stride 内最小的下标

//通过循环不断减小 i 的值,从右往左依次迁移桶上面的数据,直到 i 小于 bound 时结束该次长度为 stride 的迁移任务

//结束这次的任务后会通过外层 addCount、helpTransfer、tryPresize 方法的 while 循环达到继续领取其他任务的效果

for (int i = 0, bound = 0;;) {

Node<K,V> f; int fh;

while (advance) {

int nextIndex, nextBound;

//每处理完一个hash桶就将 bound 进行减 1 操作

if (--i >= bound || finishing)

advance = false;

else if ((nextIndex = transferIndex) <= 0) {

//transferIndex <= 0 说明数组的hash桶已被线程分配完毕,没有了待分配的hash桶,将 i 设置为 -1 ,后面的代码根据这个数值退出当前线的扩容操作

i = -1;

advance = false;

}

//只有首次进入for循环才会进入这个判断里面去,设置 bound 和 i 的值,也就是领取到的迁移任务的数组区间

else if (U.compareAndSwapInt(this, TRANSFERINDEX, nextIndex, nextBound = (nextIndex > stride ? nextIndex - stride : 0))) {

bound = nextBound;

i = nextIndex - 1;

advance = false;

}

}

if (i < 0 || i >= n || i + n >= nextn) {

int sc;

//扩容结束后做后续工作,将 nextTable 设置为 null,表示扩容已结束,将 table 指向新数组,sizeCtl 设置为扩容阈值

if (finishing) {

nextTable = null;

table = nextTab;

sizeCtl = (n << 1) - (n >>> 1);

return;

}

//每当一条线程扩容结束就会更新一次 sizeCtl 的值,进行减 1 操作

if (U.compareAndSwapInt(this, SIZECTL, sc = sizeCtl, sc - 1)) {

//(sc - 2) != resizeStamp(n) << RESIZE_STAMP_SHIFT 成立,说明该线程不是扩容大军里面的最后一条线程,直接return回到上层while循环

if ((sc - 2) != resizeStamp(n) << RESIZE_STAMP_SHIFT)

return;

//(sc - 2) == resizeStamp(n) << RESIZE_STAMP_SHIFT 说明这条线程是最后一条扩容线程

//之所以能用这个来判断是否是最后一条线程,因为第一条扩容线程进行了如下操作:

// U.compareAndSwapInt(this, SIZECTL, sc, (rs << RESIZE_STAMP_SHIFT) + 2)

//除了修改结束标识之外,还得设置 i = n; 以便重新检查一遍数组,防止有遗漏未成功迁移的桶

finishing = advance = true;

i = n; // recheck before commit

}

}

else if ((f = tabAt(tab, i)) == null)

//遇到数组上空的位置直接放置一个占位对象,以便查询操作的转发和标识当前处于扩容状态

advance = casTabAt(tab, i, null, fwd);

else if ((fh = f.hash) == MOVED)

//数组上遇到hash值为MOVED,也就是 -1 的位置,说明该位置已经被其他线程迁移过了,将 advance 设置为 true ,以便继续往下一个桶检查并进行迁移操作

advance = true; // already processed

else {

synchronized (f) {

if (tabAt(tab, i) == f) {

Node<K,V> ln, hn;

//该节点为链表结构

if (fh >= 0) {

int runBit = fh & n;

Node<K,V> lastRun = f;

//遍历整条链表,找出 lastRun 节点

for (Node<K,V> p = f.next; p != null; p = p.next) {

int b = p.hash & n;

if (b != runBit) {

runBit = b;

lastRun = p;

}

}

//根据 lastRun 节点的高位标识(0 或 1),首先将 lastRun设置为 ln 或者 hn 链的末尾部分节点,后续的节点使用头插法拼接

if (runBit == 0) {

ln = lastRun;

hn = null;

}

else {

hn = lastRun;

ln = null;

}

//使用高位和低位两条链表进行迁移,使用头插法拼接链表

for (Node<K,V> p = f; p != lastRun; p = p.next) {

int ph = p.hash; K pk = p.key; V pv = p.val;

if ((ph & n) == 0)

ln = new Node<K,V>(ph, pk, pv, ln);

else

hn = new Node<K,V>(ph, pk, pv, hn);

}

//setTabAt方法调用的是 Unsafe 类的 putObjectVolatile 方法

//使用 volatile 方式的 putObjectVolatile 方法,能够将数据直接更新回主内存,并使得其他线程工作内存的对应变量失效,达到各线程数据及时同步的效果

//使用 volatile 的方式将 ln 链设置到新数组下标为 i 的位置上

setTabAt(nextTab, i, ln);

//使用 volatile 的方式将 hn 链设置到新数组下标为 i + n(n为原数组长度) 的位置上

setTabAt(nextTab, i + n, hn);

//迁移完成后使用 volatile 的方式将占位对象设置到该 hash 桶上,该占位对象的用途是标识该hash桶已被处理过,以及查询请求的转发作用

setTabAt(tab, i, fwd);

//advance 设置为 true 表示当前 hash 桶已处理完,可以继续处理下一个 hash 桶

advance = true;

}

//该节点为红黑树结构

else if (f instanceof TreeBin) {

TreeBin<K,V> t = (TreeBin<K,V>)f;

//lo 为低位链表头结点,loTail 为低位链表尾结点,hi 和 hiTail 为高位链表头尾结点

TreeNode<K,V> lo = null, loTail = null;

TreeNode<K,V> hi = null, hiTail = null;

int lc = 0, hc = 0;

//同样也是使用高位和低位两条链表进行迁移

//使用for循环以链表方式遍历整棵红黑树,使用尾插法拼接 ln 和 hn 链表

for (Node<K,V> e = t.first; e != null; e = e.next) {

int h = e.hash;

//这里面形成的是以 TreeNode 为节点的链表

TreeNode<K,V> p = new TreeNode<K,V>

(h, e.key, e.val, null, null);

if ((h & n) == 0) {

if ((p.prev = loTail) == null)

lo = p;

else

loTail.next = p;

loTail = p;

++lc;

}

else {

if ((p.prev = hiTail) == null)

hi = p;

else

hiTail.next = p;

hiTail = p;

++hc;

}

}

//形成中间链表后会先判断是否需要转换为红黑树:

//1、如果符合条件则直接将 TreeNode 链表转为红黑树,再设置到新数组中去

//2、如果不符合条件则将 TreeNode 转换为普通的 Node 节点,再将该普通链表设置到新数组中去

//(hc != 0) ? new TreeBin<K,V>(lo) : t 这行代码的用意在于,如果原来的红黑树没有被拆分成两份,那么迁移后它依旧是红黑树,可以直接使用原来的 TreeBin 对象

ln = (lc <= UNTREEIFY_THRESHOLD) ? untreeify(lo) :

(hc != 0) ? new TreeBin<K,V>(lo) : t;

hn = (hc <= UNTREEIFY_THRESHOLD) ? untreeify(hi) :

(lc != 0) ? new TreeBin<K,V>(hi) : t;

//setTabAt方法调用的是 Unsafe 类的 putObjectVolatile 方法

//使用 volatile 方式的 putObjectVolatile 方法,能够将数据直接更新回主内存,并使得其他线程工作内存的对应变量失效,达到各线程数据及时同步的效果

//使用 volatile 的方式将 ln 链设置到新数组下标为 i 的位置上

setTabAt(nextTab, i, ln);

//使用 volatile 的方式将 hn 链设置到新数组下标为 i + n(n为原数组长度) 的位置上

setTabAt(nextTab, i + n, hn);

//迁移完成后使用 volatile 的方式将占位对象设置到该 hash 桶上,该占位对象的用途是标识该hash桶已被处理过,以及查询请求的转发作用

setTabAt(tab, i, fwd);

//advance 设置为 true 表示当前 hash 桶已处理完,可以继续处理下一个 hash 桶

advance = true;

}

}

}

}

}

}

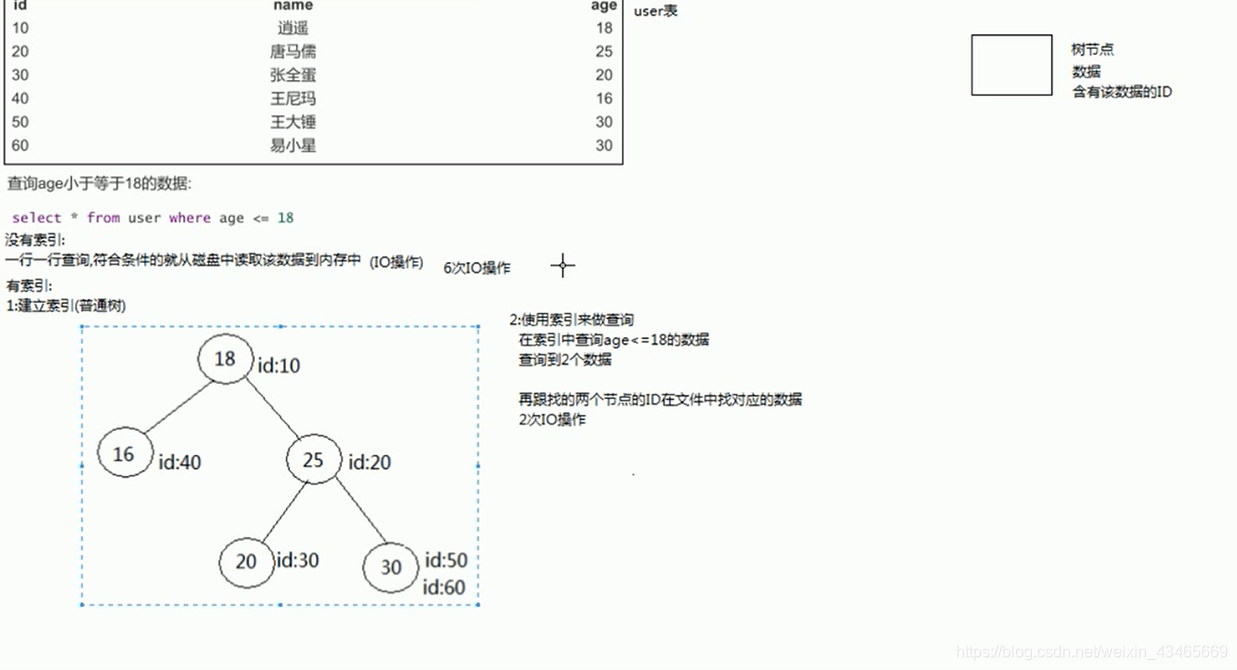

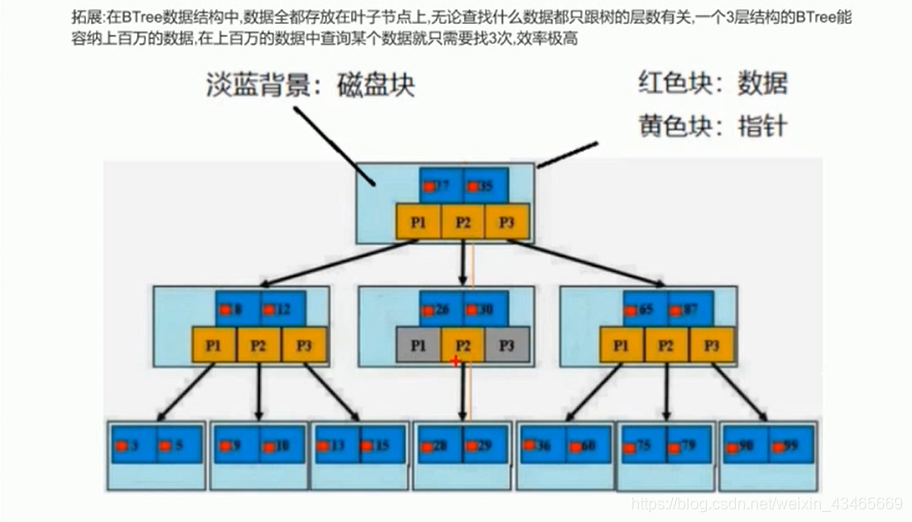

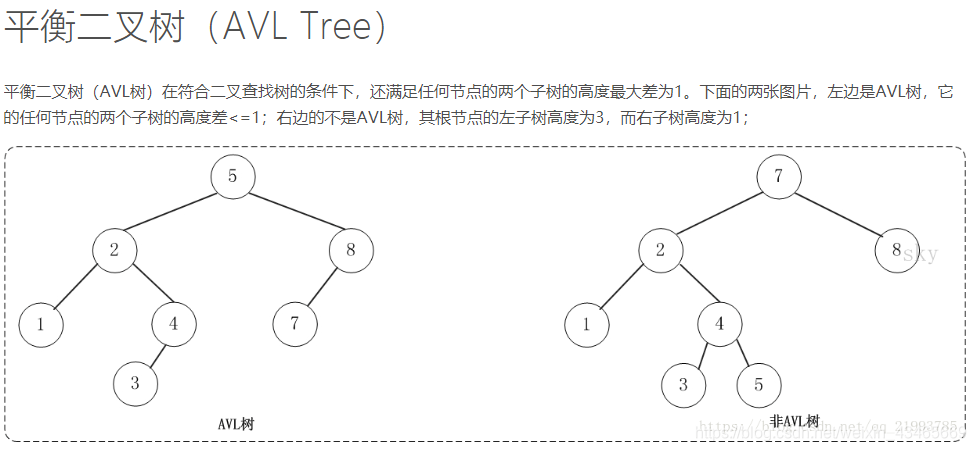

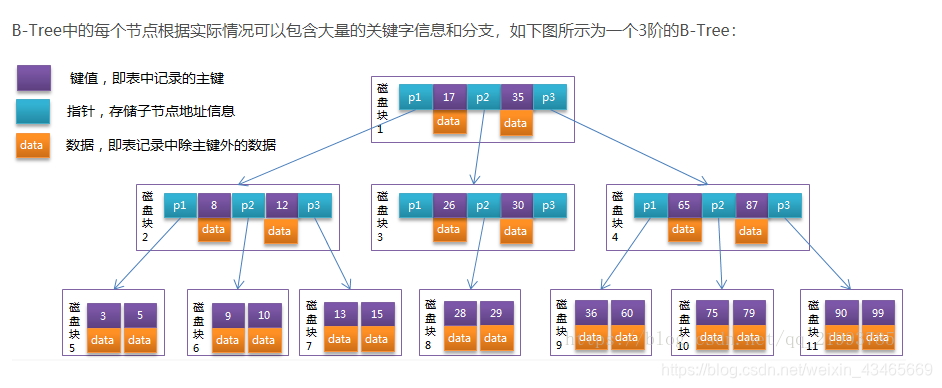

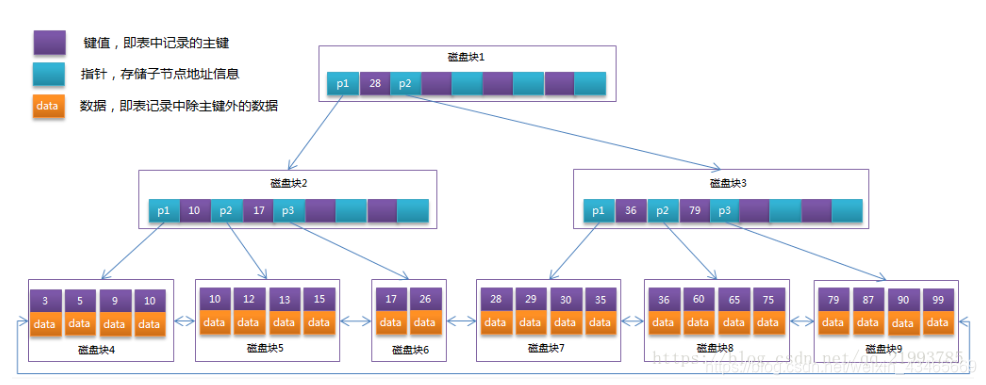

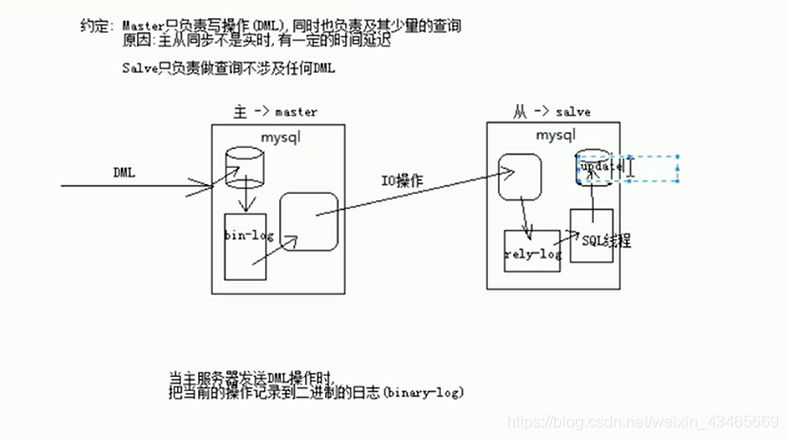

第五章:MySql

为什么sql需要优化

1.执行时间过久(可能数据结构不合理)

2.索引失效

3.sql写的太差(多表)

4.项目需求不合理

5.查询性能低(比如查询非索引列)

6.等待时间过长(可能锁没抢到)

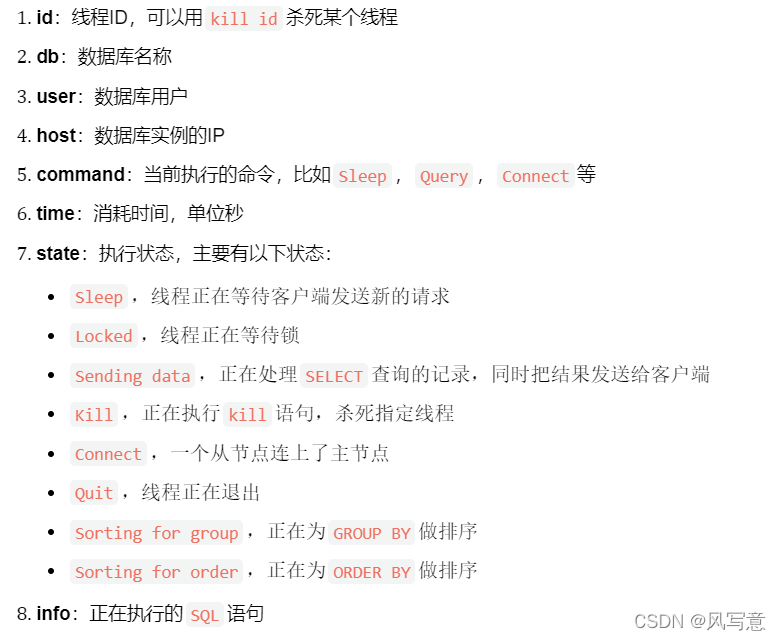

SHOW PROCESSLIST,可以看到当前mysql执行sql语句执行情况,关注state字段看看是不是lock状态(被其他查询锁住了),这样可以对比较慢的sql可以进行优化。

关于批量插入

1.使用LOAD DATA语句要比INSERT语句效率高,因为它批量插入数据行。服务器只需要对一个语句(而不是多个语句)进行语法分析和解释。索引只有在所有数据行处理完之后才需要刷新,而不是每处理一行都刷新。

2.如果你只能使用INSERT语句,那就要使用将多个数据行在一个语句中给出的格式:INSERT INTO table_name VALUES(…),(…),…,这将会减少你需要的语句总数,最大程度地减少了索引刷新的次数。

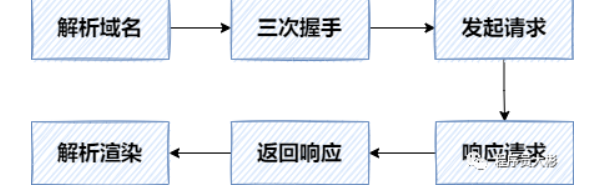

sql执行过程

可以参考

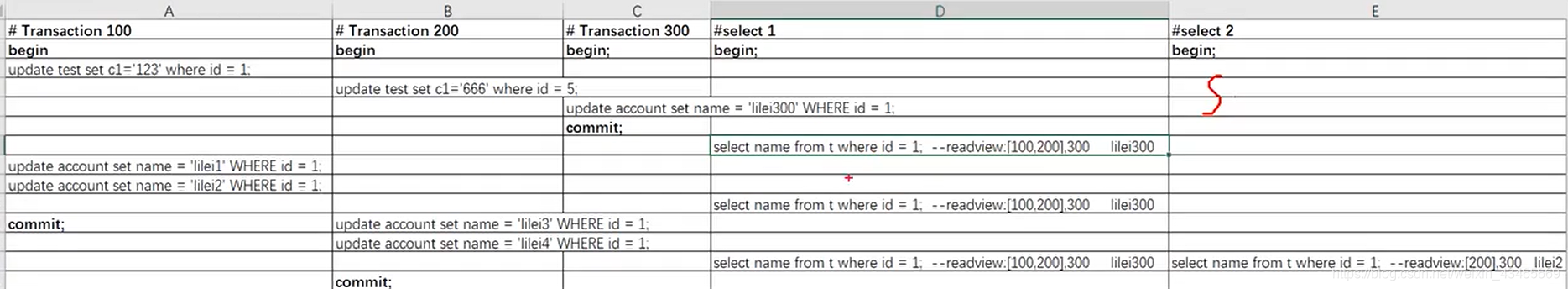

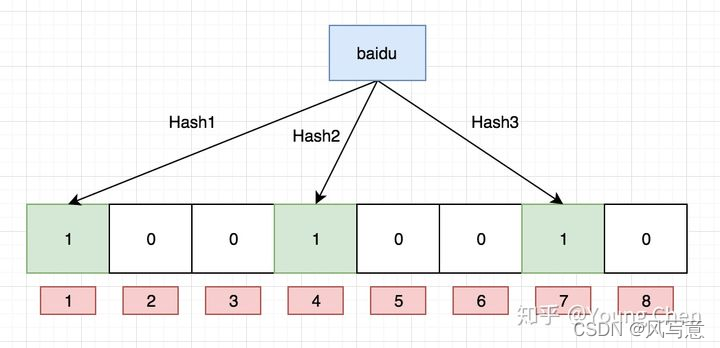

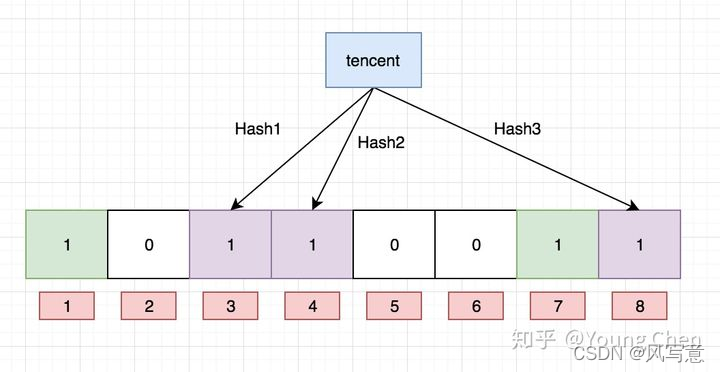

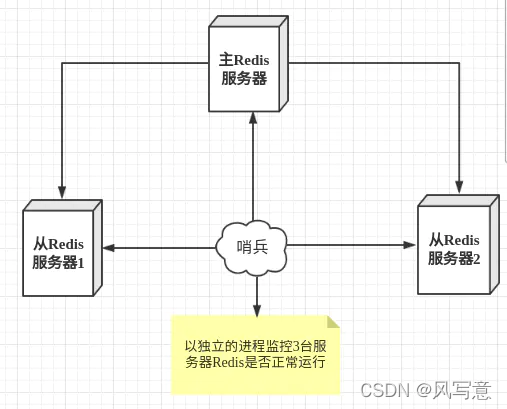

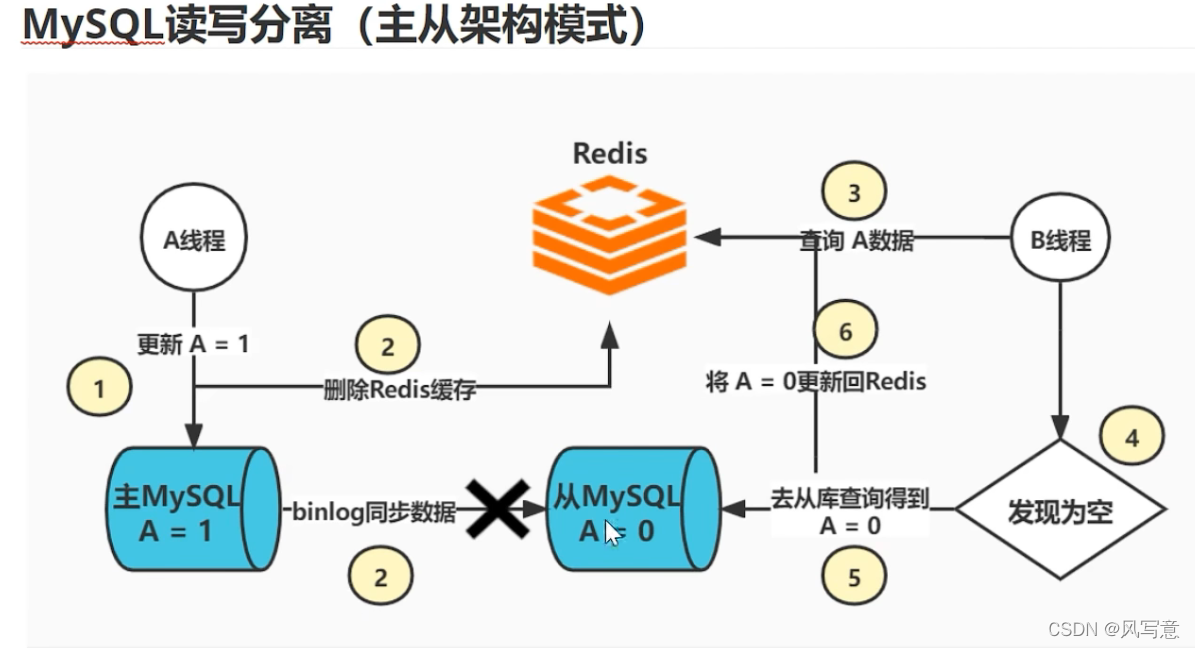

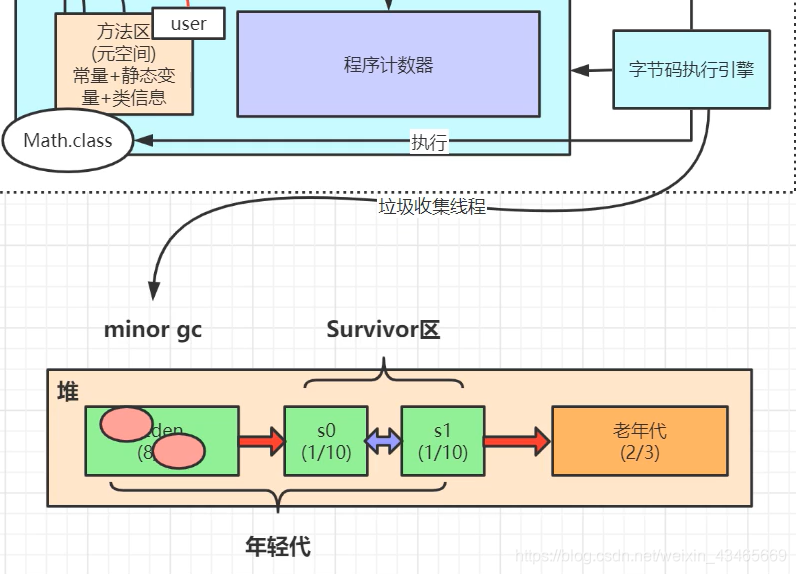

客户端----(通信协议)–查询缓存------解析器-------解析