0. 这篇文章干了啥?

空间计算的发展,包括虚拟和混合现实系统,极大地提升了各类应用中的用户参与度,并推动了对可探索、高质量3D环境的需求。我们认为,理想的虚拟3D场景应满足以下两点:1)在完整的360°×180°视角中,外观和几何形状应呈现高质量和一致性;2)允许在具有清晰视差的复杂场景层次结构中自由探索。近年来,为满足这些需求,提出了许多3D场景生成方法。

一类工作通过利用“导航与想象”策略来创建广泛的场景,该策略连续应用新视角渲染和扩展未见区域以扩展场景。然而,这类方法存在语义漂移问题:长期的连续场景扩展容易因迭代过程中产生的外部绘制伪影累积而导致结果不一致,从而破坏了生成场景的全局一致性和和谐性。

另一类方法采用等距柱状全景图来表示二维中的360°大视野(FOV)环境。然而,大规模全景数据集的缺失限制了全景生成系统的能力,导致生成的图像分辨率低、结构简单且资产稀疏。此外,二维全景图不允许自由场景探索。即使将其提升到全景场景,简单的球形结构也无法提供具有清晰视差的复杂场景层次结构,从而导致生成的3D全景图中出现遮挡空间,造成渲染模糊、歧义和间隙。一些方法通常使用基于修复的去遮挡策略来填充未见空间,但它们需要为每个场景量身定制特定的预定义渲染路径,从而限制了自由探索的潜力。

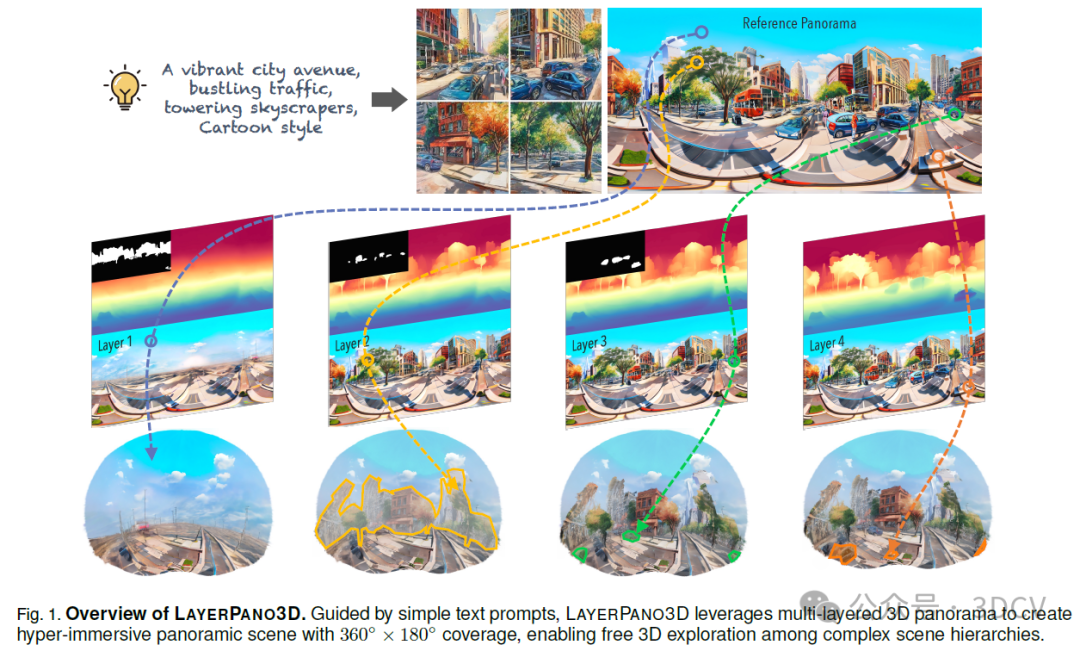

为此,我们提出了LAYERPANO3D,这是一个新颖的框架,它利用多层3D全景图从文本提示中生成全视角一致且可自由探索的场景。主要思想是通过首先生成一个参考全景图并将其视为多层组合来创建分层3D全景图,其中每一层都描绘了在特定深度级别的场景内容。通过这种方式,我们可以通过在不同深度层中以完整外观放置遮挡资产来创建复杂的场景层次结构。

下面一起来阅读一下这项工作~

1. 论文信息

标题:LayerPano3D: Layered 3D Panorama for Hyper-Immersive Scene Generation

作者:Shuai Yang, Jing Tan, Mengchen Zhang, Tong Wu, Yixuan Li, Gordon Wetzstein, Ziwei Liu, Dahua Lin

原文链接:https://arxiv.org/abs/2408.13252

2. 摘要

三维沉浸式场景生成是计算机视觉和图形学领域中一项既具挑战性又至关重要的任务。理想的虚拟三维场景应满足两个条件:1) 展现全方位视图一致性;2) 允许在复杂的场景层次结构中自由探索。现有方法要么依赖于通过修复技术逐步扩展场景,要么采用全景表示法来呈现大视场场景环境。然而,这些方法在场景扩展过程中容易出现语义漂移,且无法处理场景层次结构中的遮挡问题。为应对这些挑战,我们引入了LayerPano3D,这是一种通过单个文本提示生成全视角、可探索的全景三维场景的新型框架。我们的核心见解是将参考二维全景图像分解成不同深度层次上的多个图层,其中每个图层都通过扩散先验揭示出参考视角中不可见的空间。LayerPano3D包含多个专门设计:1) 我们引入了一种新颖的文本引导锚点视图合成管道,用于生成高质量、一致的全景图像;2) 我们首创了分层三维全景图作为底层表示法,以管理复杂的场景层次结构,并将其提升为三维高斯分布,以渲染出具有无约束观看路径的详细360度全方位场景。大量实验表明,我们的框架在全方位视图一致性和沉浸式探索体验方面均生成了最先进的三维全景场景。我们相信,LayerPano3D有望推动三维全景场景创作的发展,并在众多应用中展现其潜力。

3. 效果展示

4. 主要贡献

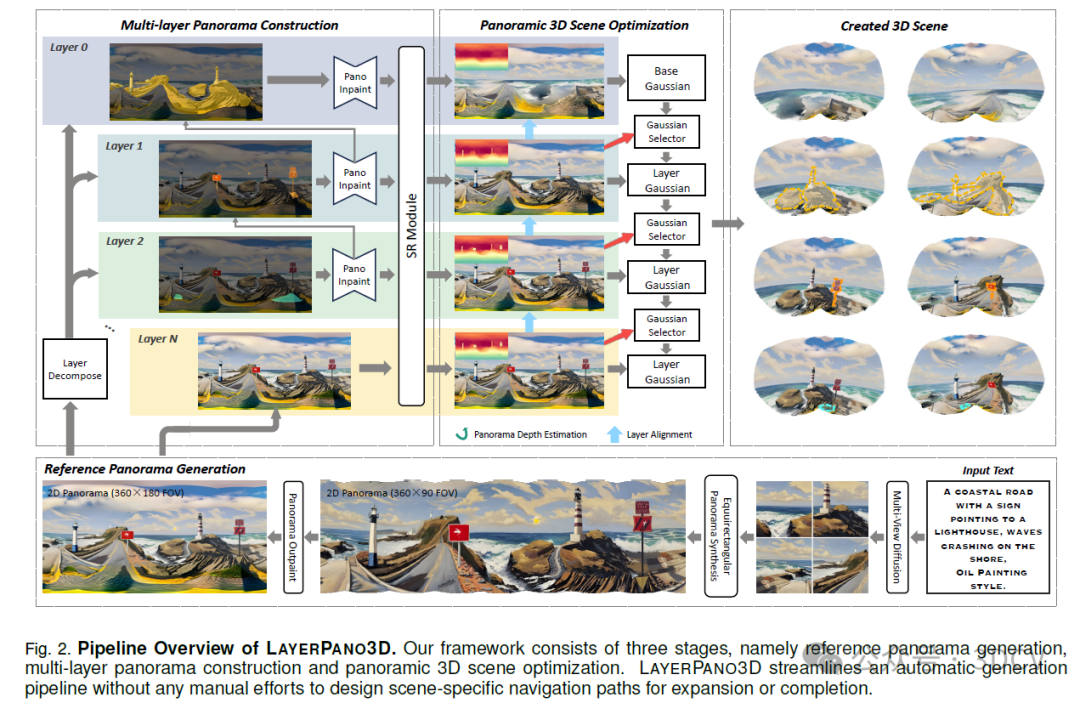

我们的贡献是双重的。首先,为了生成高质量且连贯的360°×180°全景图,我们提出了一种新颖的文本引导锚点视图合成流程。通过微调T2I模型来生成四个正交透视图作为锚点,我们在全景图生成过程中防止了语义漂移,同时确保了所有视图之间地平线的一致性。此外,锚点视图通过融入来自大规模预训练透视图生成器的复杂结构和详细特征来丰富全景图。其次,我们引入了分层3D全景图表示作为处理具有复杂场景层次结构的不同类型场景中遮挡问题的通用解决方案,并将其提升到3D高斯分布以实现自由3D探索。通过利用预训练的泛景分割先验和K-Means聚类,我们简化了自动层构建流程,将参考全景图分解为不同的深度层。每个层的未见空间都通过微调的全景图修复器进行合成。推荐学习:线结构光(单目&双目)三维重建系统教程

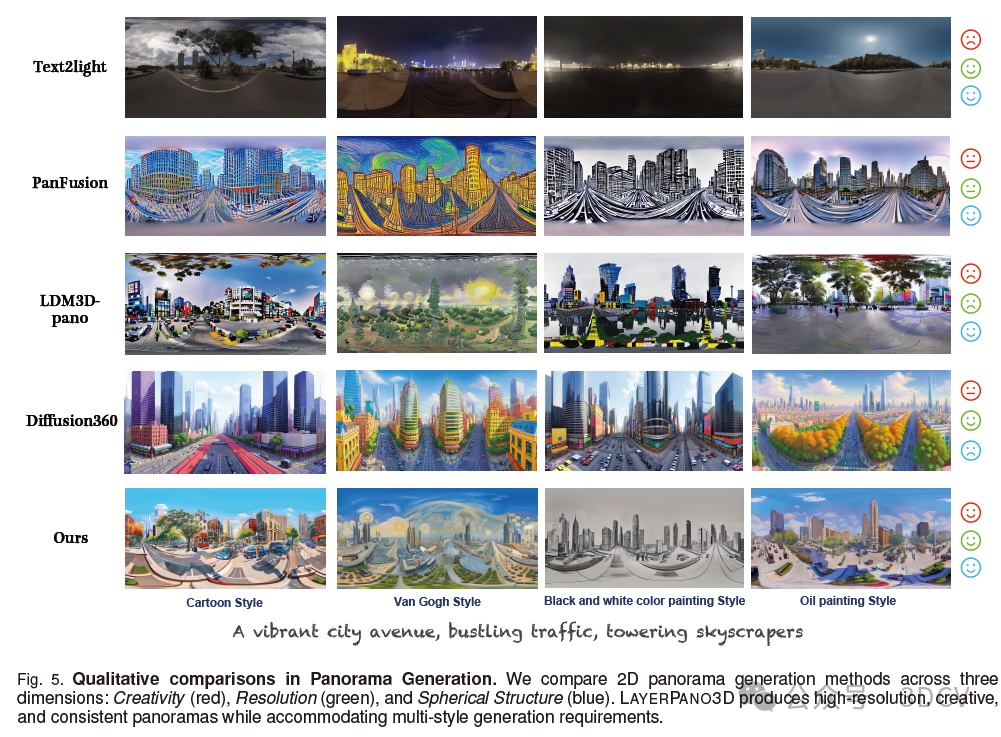

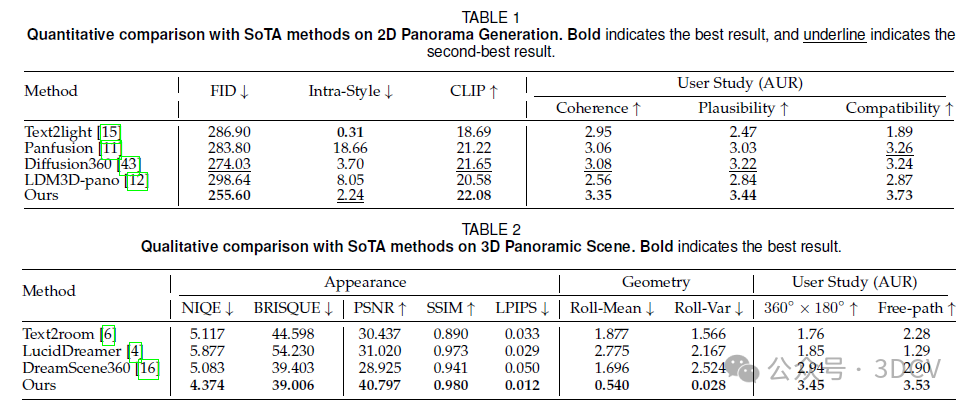

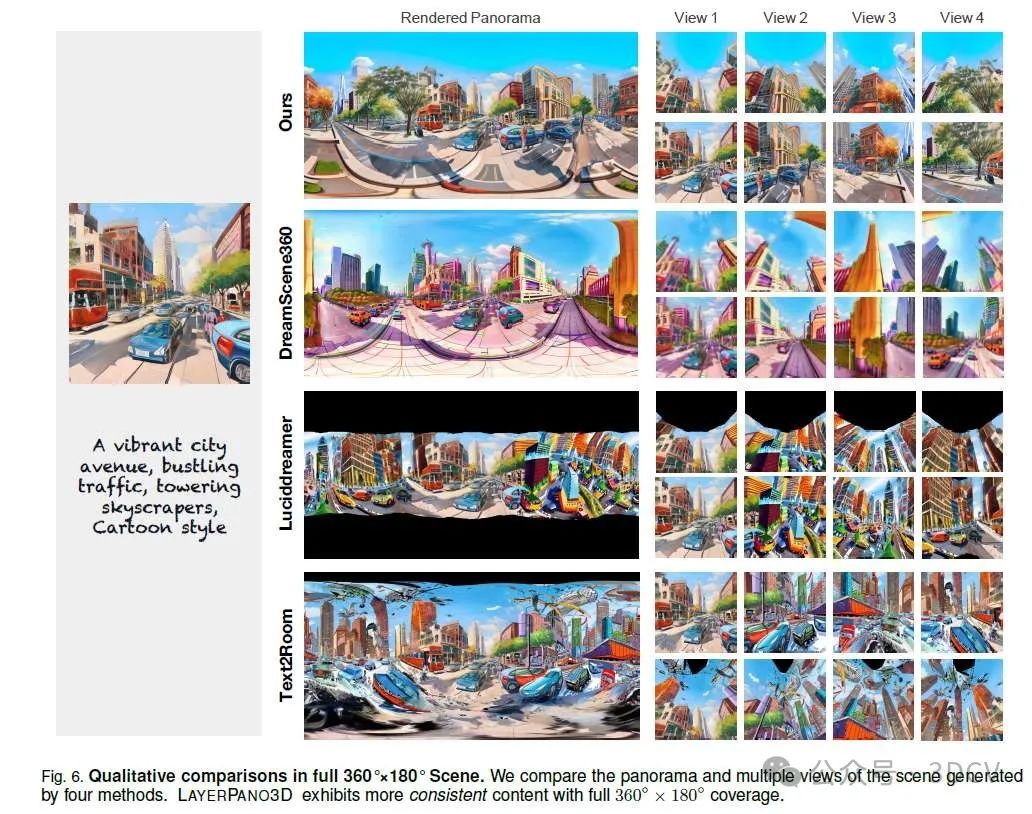

大量实验证明了LAYERPANO3D从单个文本提示中生成超沉浸式分层全景场景的有效性。LAYERPANO3D在创建连贯、合理、与文本对齐的2D全景图和全视角一致、可探索的3D全景环境方面超越了最先进的方法。此外,我们的框架简化了无需任何特定场景导航路径的自动流程,为非专家用户提供了更友好的界面。我们相信,LAYERPANO3D有效提高了全视角、可探索的AIGC 3D环境在现实世界应用中的可及性。

5. 基本原理是啥?

我们的工作目标是创建由文本提示引导的全景场景,该场景涵盖场景中广泛范围内的各个视角的完整360°×180°视野,同时允许无约束的轨迹进行沉浸式探索。LAYERPANO3D包含三个阶段。在第一阶段,我们提出了一个文本引导的关键视图合成流程,并结合全景外推技术,以生成高质量、一致的全景图作为参考。在第二阶段,我们利用参考全景图,通过迭代层分解、补全和对齐过程,构建分层3D全景图表示。在第三阶段,分层3D全景图以级联方式提升为3D高斯表示,以实现自由3D探索。

6. 实验结果

7. 总结 & 未来工作

在本文中,我们提出了LAYERPANO3D,这是一个从单个文本提示生成超沉浸式全景场景的新颖框架。我们的主要贡献有两方面。首先,我们提出了文本引导的关键视图合成流程,以生成详细且一致的全景参考图。其次,我们开创性地提出了分层3D全景图表示,以在多个深度层上展示复杂的场景层次结构,并将其提升为高斯表示,以实现自由3D探索。大量实验表明,LAYERPANO3D在生成各个视角的360°×180°一致全景图以及实现3D空间中的沉浸式漫游方面非常有效。我们相信,LAYERPANO3D有望在学术界和工业界推动高质量、可探索的3D场景创作的发展。

局限性和未来工作。LAYERPANO3D利用良好的预训练先验来构建全景3D场景,即用于3D提升的全景深度先验。因此,创建的场景可能包含由于深度估计不准确而产生的伪影。随着更鲁棒的全景深度估计技术的进步,我们希望能够创建具有更精细资产几何形状的高质量全景3D场景。

对更多实验结果和文章细节感兴趣的读者,可以阅读一下论文原文~

25个顶会论文的课题如下:

1、SLAM/3DGS/三维点云/医疗图像/扩散模型/结构光/Transformer/CNN/Mamba/位姿估计 顶会论文指导

2、基于扩散模型的跨域鲁棒自动驾驶场景理解

3、基于环境信息的定位,重建与场景理解

4、轻量级高保真Gaussian Splatting

5、基于大模型与GS的 6D pose estimation

6、在挑战性遮挡环境下的GS-SLAM系统研究

7、基于零知识先验的实时语义地图构建SLAM系统

8、基于3DGS的实时语义地图构建

9、基于文字特征的城市环境SLAM

10、面向挑战性环境的SLAM系统研究

11、特殊激光传感器融合视觉的稠密SLAM系统

12、多传感器融合的单目深度估计系统研究

13、多帧融合的单目深度估计系统研究

14、复杂天气条件下的单目深度估计系统研究

15、高精度的单目深度估计系统研究

16、基于大模型的单目深度估计系统研究

17、高精度的光流估计系统

18、挑战场景下2D-2D,2D-3D或3D-3D配准问题

19、未知物体同时重建与位姿估计问题

20、类别级或开放词汇位姿估计问题

21、位姿估计中的域差距问题

22、基于图像或点云的 3D Object Detection、Semantic Segmentation、Occupancy Prediction(主要是面向自动驾驶的感知任务,单模态和融合)

23、医疗图像分割任务的模型结构设计

24、可形变对象(软体)的实时三维重建与非刚性配准

25、机器人操作可形变对象建模与仿真

565

565

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?