多媒体文件格式(一):MP4 格式

在互联网常见的格式中,跨平台最好的应该就属MP4文件了。因为MP4文件既可以在PC平台的Flashplayer中播放,又可以在移动平台的Android、iOS等平台中进行播放,而且使用系统默认的播放器即可以播放。

MP4格式是最常见的多媒体文件格式。

MP4 格式标准介绍

MP4格式标准为ISO-14496 Part 12、ISO-14496 Part 14,标准内容不是很多,下面我们来介绍一下格式标准中一些重要的信息。

MP4是一种描述较为全面的容器格式,被认为可以在其中嵌入任何形式的数据,各种编码的视频、音频等都不在话下,常见的大部分的MP4文件存放的AVC(H.264)或MPEG-4(Part 2)编码的视频和AAC编码的音频。MP4格式的官方文件后缀名是“.mp4”,还有其他的以mp4为基础进行的扩展或者是阉割版的格式,如:M4V, 3GP, F4V等。

MP4是由一个个“Box”组成的,大Box中存放小Box,一级嵌套一级来存放媒体信息。下面我们来楚关于Box的几个概念:

- MP4文件由许多个Box与FullBox组成。

- 每个Box由Header和Data两部分组成。

- FullBox是Box的扩展,其在Box结构的基础上,在Header中增加8位version标志和24的flags标志。

- Header包含了整个Box的长度的大小(size)和类型(type),当size等于0时,代表这个Box是文件的最后一个Box。当size等于1时,说明Box长度需要更多的位来描述,在后面会自定义一个64位的largesize用来描述Box的长度。当type等于uuid时,说明这个Box中的数据是用户自定义扩展类型。

- Data为Box的实际数据,可以是纯数据,也可以是更多的子Box。

- 当一个Box中Data是一系列的子Box时,这个Box又可以称为Container(容器)Box。

MP4常用参考标准Box排列方式:https://github.com/renhui/Thinking-in-AV/tree/master/多媒体格式/MP4。

介绍了MP4的格式标准后,下面我们来介绍是三个MP4分析工具,为后续理解MP4文件一些关键信息做辅助工具。

MP4分析工具

可以用来分析MP4封装格式的工具比较多,除了FFmpeg、FFprobe之外,还有一些常用的工具,如Elecard StreamEye、mp4box、mp4info等;下面简单介绍一下这几款常用的工具:

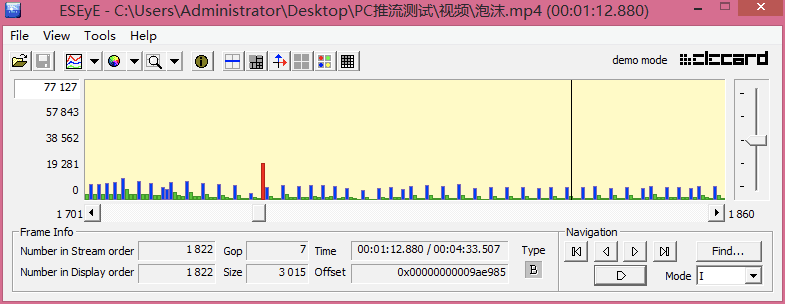

Elecard StreamEye

Elecard StreamEye是一款非常强大的视频信息查看工具,能够查看帧的排列信息,将I帧、P帧、B帧以不同颜色的柱状展现出来,而且柱的长短将根据帧的大小展示。还能够通过Elecard StreamEye分析MP4的封装的内容信息,包括流信息、宏块的信息、文件头顶额信息、图像的信息以及文件的信息等。还能根据每一帧的顺序逐帧查看,可以看到每一帧的详细信息与状态。

示例如图:

mp4box

mp4box 是GPAC项目中的一个组件,可以通过mp4box针对媒体文件进行合成、拆解等操作。

官网地址:https://gpac.wp.imt.fr/mp4box/。

其使用时的常用命令如下:

1) mp4box -h

查看mp4box中的所有帮助信息

2) mp4box -h general

查看mp4box中的通用帮助信息

3) mp4box -info test.mp4

查看test.mp4文件是否有问题

4) mp4box -add test.mp4 test-new.mp4

修复test.mp4文件格式不标准的问题,并把新文件保存在test-new.mp4中

5) mp4box -inter 10000 test-new.mp4

解决开始播放test-new.mp4卡一下的问题,为HTTP下载快速播放有效,10000ms

6) mp4box -add file.avi new_file.mp4

把avi文件转换为mp4文件

7) mp4box -hint file.mp4

为RTP准备,此指令将为文件创建RTP提示跟踪信息。这使得经典的流媒体服务器像darwinstreamingserver或QuickTime的流媒体服务器通过RTSP/RTP传输文件

8) mp4box -cat test1.mp4 -cat test2.mp4 -new test.mp4

把test1.mp4和test2.mp4合并到一个新的文件test.mp4中,要求编码参数一致

9) mp4box -force-cat test1.mp4 -force-cat test2.mp4 -new test.mp4

把test1.mp4和test2.mp4强制合并到一个新的文件test.mp4中,有可能不能播放

10) mp4box -add video1.264 -cat video2.264 -cat video3.264 -add audio1.aac -cat audio2.aac -cat audio3.aac -new muxed.mp4 -fps 24

合并多段音视频并保持同步

11) mp4box -split *time_sec* test.mp4

切取test.mp4中的前面time_sec秒的视频文件

12) mp4box -split-size *size *test.mp4

切取前面大小为size KB的视频文件

13) mp4box -split-chunk *S:E* test.mp4

切取起始为S少,结束为E秒的视频文件

14) mp4box -add 1.mp4####video -add 2.mp4####audio -new test.mp4

test.mp4由1.mp4中的视频与2.mp4中的音频合并生成

而通过mp4box也可以查看mp4的信息,其输出内容格式非常类似ffprobe查看的信息,不过想对ffprobe更完善。

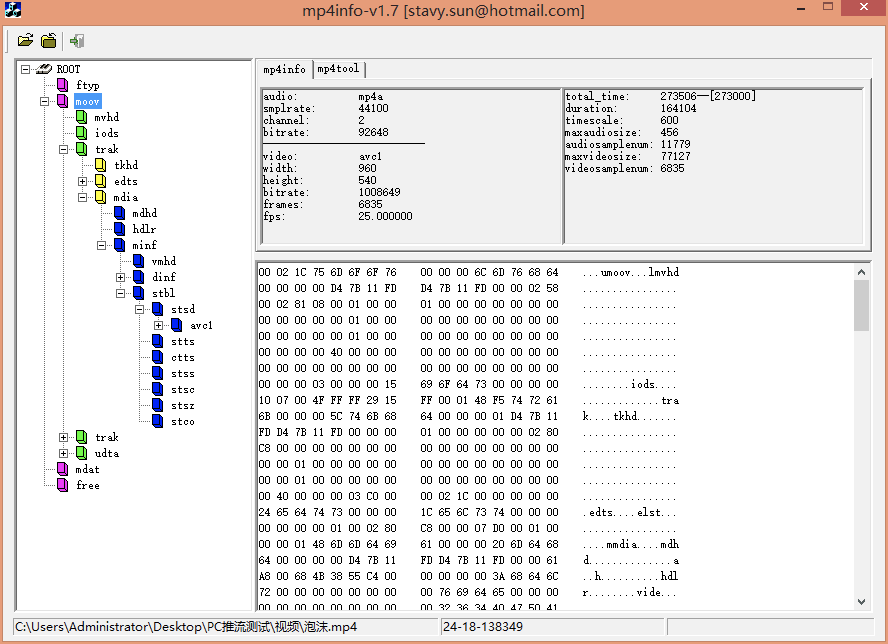

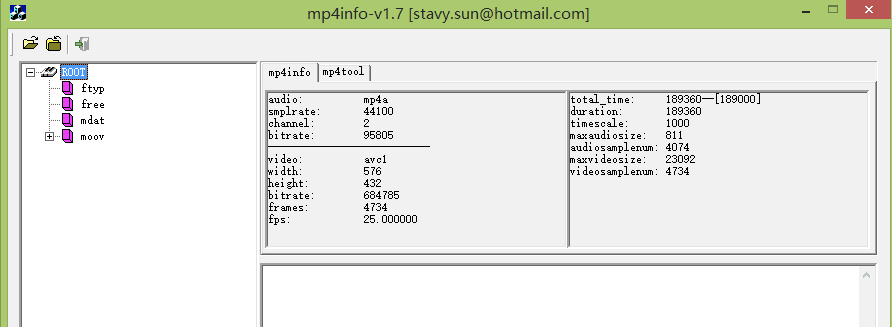

mp4info

mp4info是一个不错的MP4分析工具,而且是可视化的工具,可以将MP4中的各个Box解析出来,并将其中的数据展现出来。分析MP4文件内容时使用mp4info将会更方便。

结合着此工具,理解MP4的Box会更方便,更直观。

MP4格式重要Box

ftyp(File Type Box)

该Box有且只有1个,并且只能被包含在文件层,而不能被其他Box包含。该Box应该被放在文件的最开始,指示该MP4文件应用的相关信息。

“ftyp” body依次包括1个32位的major brand(4个字符),1个32位的minor version(整数)和1个以32位(4个字符)为单位元素的数组Compatible Brands。

moov(Movie Box)

该box包含了文件媒体的metadata信息,“moov”是一个container box,具体内容信息由子box诠释。同File Type Box一样,该box有且只有一个,且只被包含在文件层。一般情况下,“moov”会紧随“ftyp”出现。

moov定义了一个MP4文件中的数据信息,类型是moov,是一个容器Atom,其至少必须包含一下三种Atom中的一种:mvhd标签、cmov标签、rmra标签。

- mvhd标签:Movie Header Atom,存放未压缩过的影片信息的头容器。

- cmov标签:Compressed Movie Atom,压缩鬼哦的电影信息容器,此容器不常用。

- rmra标签:Reference Movie Atom,参考电影信息容器,此容器不常用。

一般情况下,“moov”中会包含1个“mvhd”和若干个“trak”。其中“mvhd”为Header Box,一般作为“moov”的第一个子Box出现(对于其他Container Box来说,Header Box都应作为首个子box出现)。“trak”包含了一个track的相关信息,是一个Container Box。

trak(Track Box)

“trak”也是一个container box,其子box包含了该track的媒体数据引用和描述(hint track除外)。一个MP4文件中的媒体可以包含多个track,且至少有一个track,这些track之间彼此独立,有自己的时间和空间信息。“trak”必须包含一个“tkhd”和一个“mdia”,此外还有很多可选的box(略)。其中“tkhd”为track header box,“mdia”为media box,该box是一个包含一些track媒体数据信息box的container box。

mdat(Meida Data Box)

该box包含于文件层,可以有多个,也可以没有(当媒体数据全部为外部文件引用时),用来存储媒体数据。数据直接跟在box type字段后面,具体数据结构的意义需要参考metadata(主要在sample table中描述)。

free或skip(Free Space Box)

“free”中的内容是无关紧要的,可以被忽略。该box被删除后,不会对播放产生任何影响。

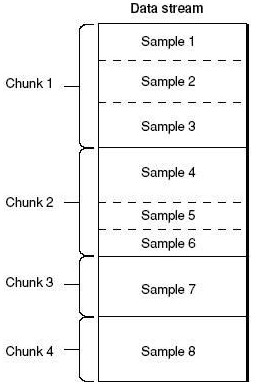

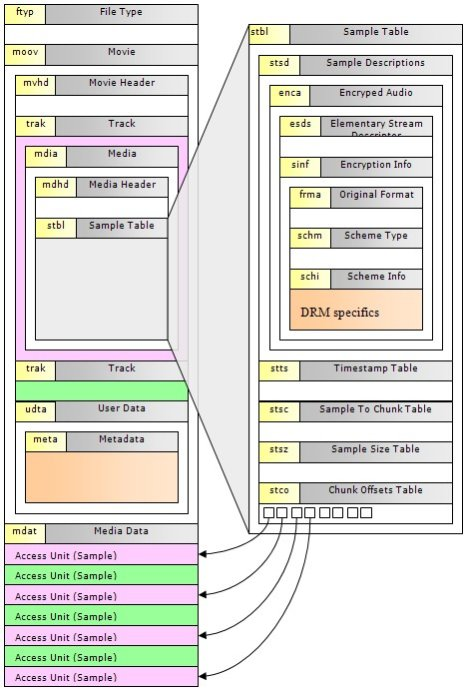

stbl(Sample Table Box)

“stbl”几乎是普通的MP4文件中最复杂的一个box了,首先需要回忆一下sample的概念。sample是媒体数据存储的单位,存储在media的chunk中,chunk和sample的长度均可互不相同,如下图所示。

普通MP4文件的结构重要的部分就讲完了,理解起来可能比较乱,下面这张图是常见的box的树结构图,可以用来大致了解MP4文件的构造。

在MP4文件中,Box的结构与上图中所描述的一般没太大的差别。

MP4格式 与 FFmpeg实战

在FFmpeg中的输出MP4的Demuxer信息

使用命令行 ffmpeg -h demuxder=mp4 查看MP4文件的Demuxer信息:

Demuxer mov,mp4,m4a,3gp,3g2,mj2 [QuickTime / MOV]:

Common extensions: mov,mp4,m4a,3gp,3g2,mj2.

通过FFmepg faststart参数的使用,来理解mdat和moov的顺序的意义

正常情况下,ffmpeg生成的moov是在mdat写完成后再写入的。

下面是一个例子:

ffmpeg -i 好汉歌.flv -c copy -f mp4 好汉歌.mp4

使用mp4info查看容器出现的顺序,如图:

可以看出moov box是在mdat的下面。这时,我们可以使用faststart将上图的moov移动到mdat前面。

使用如下命令行:

ffmpeg -i 好汉歌.flv -c copy -f mp4 -movflags faststart 好汉歌.mp4

然后使用mp4info查看MP4的容器顺序,就可以看到moov被移动到mdat前面了。如下图所示:

因为MP4的标准中描述的moov与mdat的存放位置前后并没有强制要求,所有有些时候moov这个Box在mdat的后面,有时候在mdat的前面。

在互联网的视频点播中,如果希望MP4文件被快速打开,则需要moov存放在mdat的前面;如果放在后面,则需要将MP4文件下载完成后才可以进行播放。

多媒体文件格式(二):FLV 格式

在网络的直播与点播场景中,FLV也是一种常见的格式,FLV是Adobe发布的一种可以作为直播也可以作为点播的封装格式,其封装格式非常简单,均以FLVTAG的形式存在,并且每一个TAG都是独立存在的,接下来就详细介绍一下FLV标准。

FLV 格式标准介绍

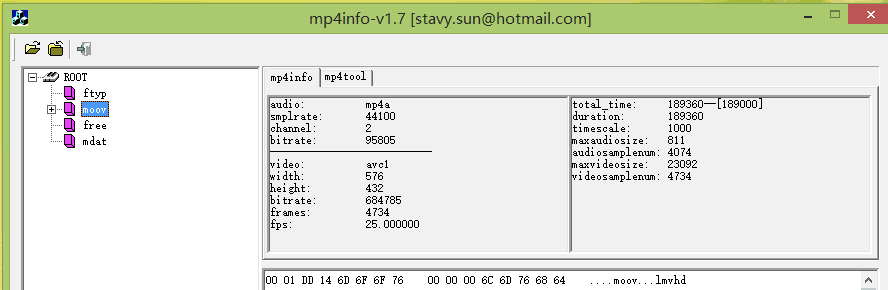

FLV包括文件头(File Header)和文件体(File Body)两部分,其中文件体由一系列的Tag组成。FLV文件的结构如下图:

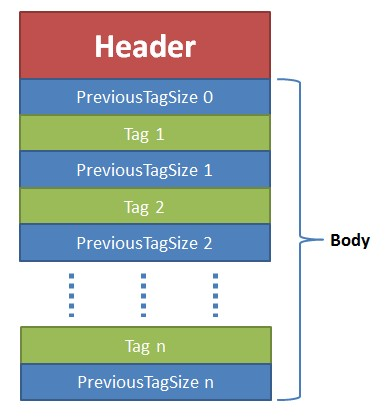

文件头 Header

Header 部分记录了FLV的类型、版本等信息,是FLV的开头。一般差不多占9bytes。具体格式如下:

-

文件标识(3B):总是为”FLV”, 0x46 0x4c 0x56

-

版本(1B):目前为0x01

-

流信息(1B):文件的标志位说明。前5位保留,必须为0;第6位为音频Tag:1表示有音频;第七位保留,为0; 第8位为视频Tag:1表示有视频

-

Header长度(4B):整个Header的长度,一般为9(版本为0x01时);大于9表示下面还有扩展信息。即0x00000009。

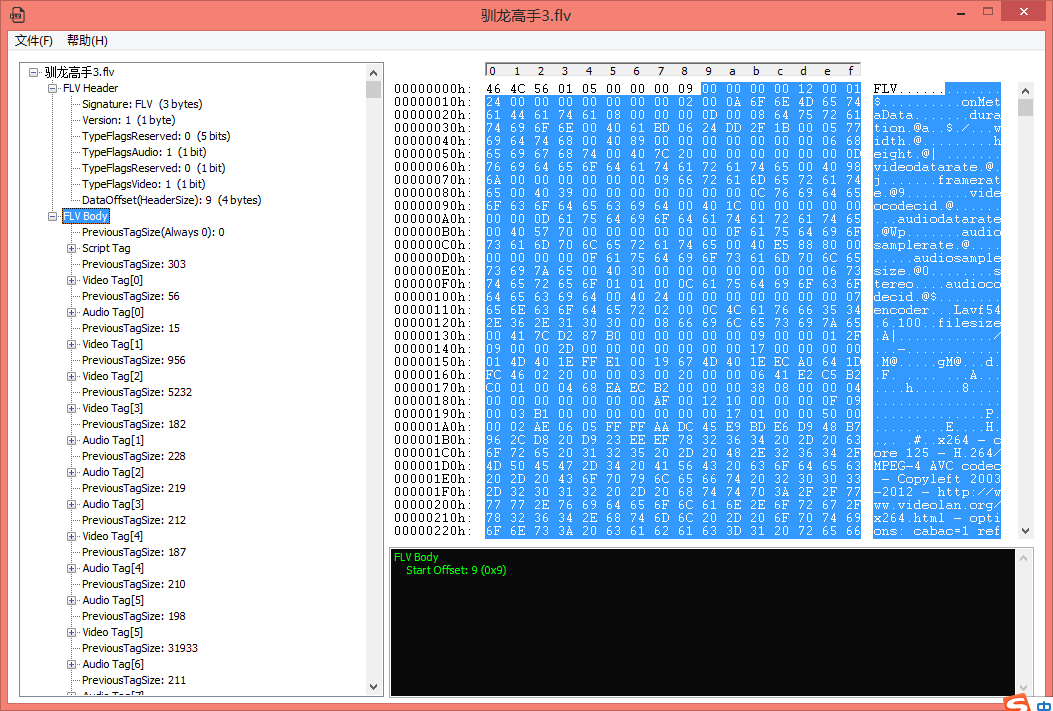

下图是使用工具FlvAnalyzer获取到的FLV的Header的详细信息:

文件体 FLV Body

文件体由一系列的Tag组成。

其中,每个Tag前面还包含了Previous Tag Size字段,表示前面一个Tag的大小。Tag的类型可以是视频、音频和Script,每个Tag只能包含以上三种类型的数据中的一种。

下图是使用FlvAnalyzer获取到的Body信息:

Tag

每个Tag由也是由两部分组成的:Tag Header和Tag Data。Tag Header里存放的是当前Tag的类型、数据区(Tag Data)长度等信息,具体如下:

Tag类型(1):0x08:音频; 0x09:视频; 0x12:脚本; 其他:保留

数据区长度(3):数据区的长度

时间戳(3):整数,单位是毫秒。对于脚本型的tag总是0 (CTS)

时间戳扩展(1):将时间戳扩展为4bytes,代表高8位。很少用到

StreamsID(3):总是0

数据区(由数据区长度决定):数据实体

下面是三个Tag类型说明:

- Audio Tag Data结构(音频类型) :音频Tag Data区域开始的第一个字节包含了音频数据的参数信息,从第二个字节开始为音频流数据。

- video Tag Data结构(视频类型):视频Tag Data开始的第一个字节包含视频数据的参数信息,从第二个字节开始为视频流数据。

- Script Tag Data结构(脚本类型、帧类型):该类型Tag又被称为MetaData Tag,存放一些关于FLV视频和音频的元信息,比如:duration、width、height等。通常该类型Tag会作为FLV文件的第一个tag,并且只有一个,跟在File Header后。

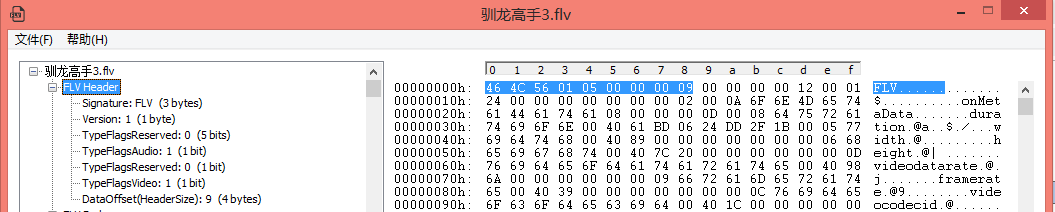

FLV 分析工具

在上节的内容中,我们介绍了FLV的格式信息,同时也提到了FlvAnalyzer工具,下面我们就介绍两个工具,帮助大家整理和学习FLV相关知识:

FlvAnalyzer

通过FlvAnalyzer可以很清晰的看到FLV文件的基本结构,这样能够结合上面了解的FLV的知识,更清晰的查看FLV的格式及结构。

工具地址:https://github.com/renhui/Thinking-in-AV/blob/master/多媒体格式/FLV/FlvAnalyzer.exe

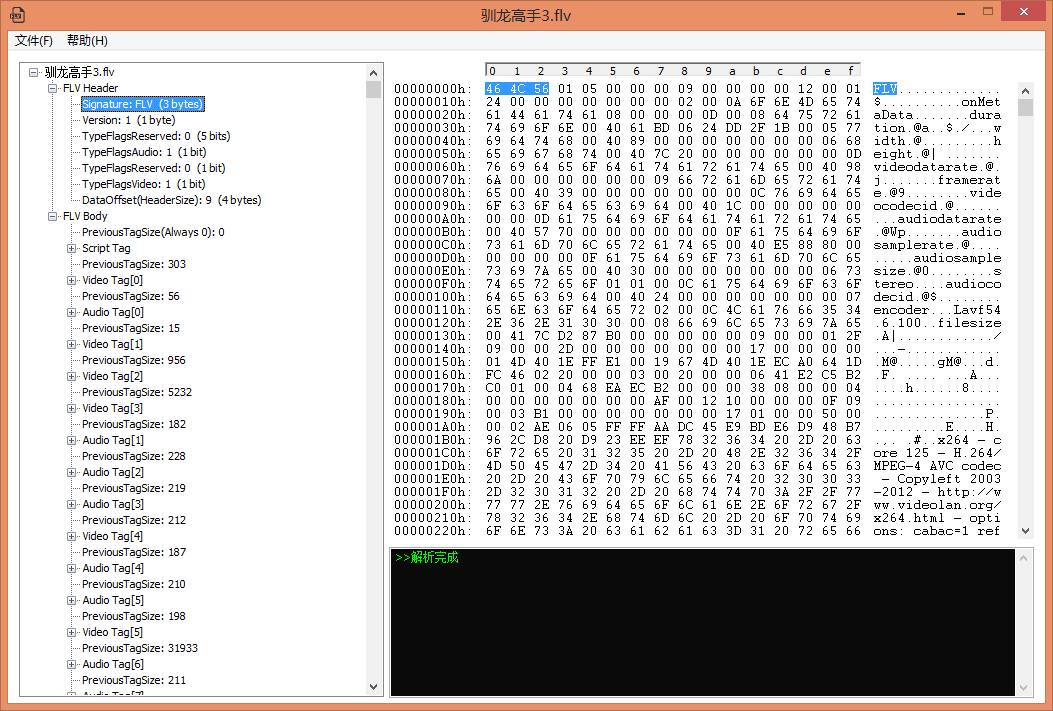

工具使用如图:

左侧树状结构显示flv的信息,可以清楚了解flv文件的结构;

点击左侧节点,右侧显示对应hex与ascii信息,这样就不必打开二进制编辑器了;

通过此工具可以查看audio tag与video tag各个字节(精确到bit)的详细信息,了解每个tag是如何构造的,同时右下角黑色输出框显示某个值的意义;

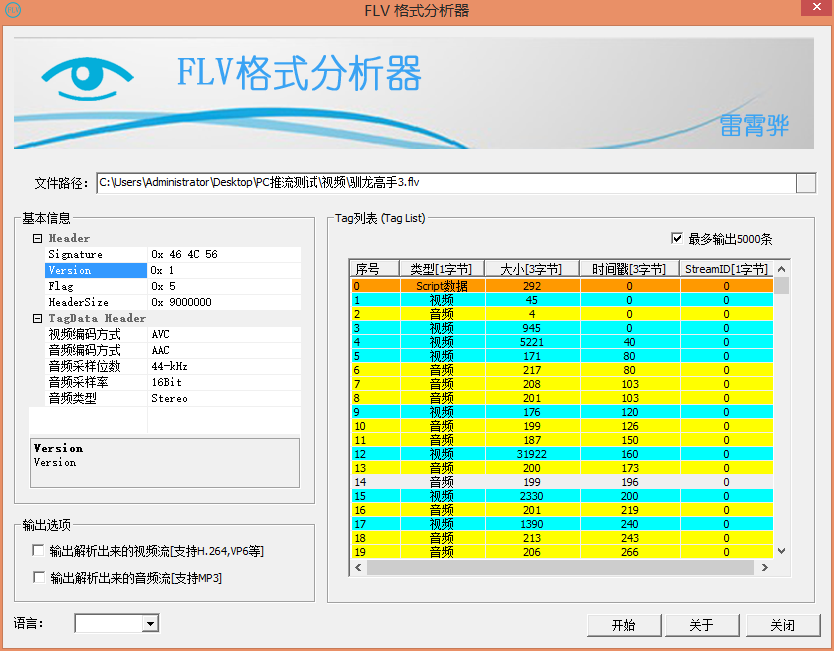

FLV Format Analysis 工具

此工具是雷霄骅整理flvparse的开源代码,制作的flvformatanalysis工具,此工具可以用来帮助学习FLV封装格式结构。此外它还支持分离FLV中的视频流和音频流。

工具地址:https://github.com/renhui/Thinking-in-AV/blob/master/多媒体格式/FLV/SpecialFFLV.exe

工具使用如图:

FLV格式 与 FFmpeg 实战

使用FFmpeg生成带关键索引信息的FLV

在网络视频点播文件为FLV格式文件时,人们经常用工具先对FLV文件进行一次转换,主要是将FLV文件中的关键帧建立一个索引,并将索引写到Metadata头中,这个步骤用FFmpeg可以实现,使用参数add_keyframe_index即可:

ffmpeg -i 好汉歌.mp4 -c copy -f flv -flvflags add_keyframe_index out.flv

生成FLV包含了关键帧索引信息,这些关键帧索引信息并不是FLV的标准字段,但是我们在实际应用中,特别是现在直播的应用中,我们往往需要向FLV格式中写入关键帧索引,并将这些索引文件写在Metadata 中,这些我们再次播放的时候,可以很快通过这些关键帧索引站到对应的位置,然后准确快速渲染播放。

使用ffprobe查看FLV关键帧索引相关信息

除了在第二节介绍的两个工具,我们也可以使用ffprobe来解析FLV文件,并且还能将关键帧索引的相关信息打印出来,命令如下:

ffprobe -v trace -i out.flv

输出如下:

[NULL @ 0x7fc669002a00] Opening 'out.flv' for reading

[file @ 0x7fc667f00480] Setting default whitelist 'file,crypto'

Probing flv score:100 size:2048

Probing mp3 score:1 size:2048

[flv @ 0x7fc669002a00] Format flv probed with size=2048 and score=100

[flv @ 0x7fc669002a00] Before avformat_find_stream_info() pos: 13 bytes read:32768 seeks:0 nb_streams:0

[flv @ 0x7fc669002a00] type:18, size:1184, last:-1, dts:0 pos:21

[flv @ 0x7fc669002a00] keyframe stream hasn't been created

[flv @ 0x7fc669002a00] type:9, size:45, last:-1, dts:0 pos:1220

[flv @ 0x7fc669002a00] keyframe filepositions = 1296 times = 0

[flv @ 0x7fc669002a00] keyframe filepositions = 159283 times = 3000

[flv @ 0x7fc669002a00] keyframe filepositions = 258004 times = 4000

[flv @ 0x7fc669002a00] keyframe filepositions = 272776 times = 4000

[flv @ 0x7fc669002a00] keyframe filepositions = 405340 times = 6000

[flv @ 0x7fc669002a00] keyframe filepositions = 1215104 times = 16000

[flv @ 0x7fc669002a00] keyframe filepositions = 2529035 times = 26000

[flv @ 0x7fc669002a00] keyframe filepositions = 3198814 times = 36000

[flv @ 0x7fc669002a00] keyframe filepositions = 3623757 times = 41000

[flv @ 0x7fc669002a00] keyframe filepositions = 4882191 times = 51000

[flv @ 0x7fc669002a00] keyframe filepositions = 5951597 times = 61000

[flv @ 0x7fc669002a00] keyframe filepositions = 6256906 times = 63000

[flv @ 0x7fc669002a00] keyframe filepositions = 7235927 times = 73000

[flv @ 0x7fc669002a00] keyframe filepositions = 8175324 times = 83000

[flv @ 0x7fc669002a00] keyframe filepositions = 9203399 times = 93000

[flv @ 0x7fc669002a00] keyframe filepositions = 9936528 times = 103000

[flv @ 0x7fc669002a00] keyframe filepositions = 11056393 times = 113000

[flv @ 0x7fc669002a00] keyframe filepositions = 12183978 times = 123000

[flv @ 0x7fc669002a00] keyframe filepositions = 13014068 times = 133000

[flv @ 0x7fc669002a00] keyframe filepositions = 13610750 times = 143000

[flv @ 0x7fc669002a00] keyframe filepositions = 14628601 times = 153000

[flv @ 0x7fc669002a00] keyframe filepositions = 15873046 times = 163000

[flv @ 0x7fc669002a00] keyframe filepositions = 17112198 times = 173000

[flv @ 0x7fc669002a00] keyframe filepositions = 18301365 times = 182000

[flv @ 0x7fc669002a00] keyframe filepositions = 18604436 times = 186000

[flv @ 0x7fc669002a00] 0 17 0

[flv @ 0x7fc669002a00] type:8, size:9, last:-1, dts:0 pos:1280

[flv @ 0x7fc669002a00] 1 AF 0

[flv @ 0x7fc669002a00] type:9, size:2117, last:-1, dts:0 pos:1304

[flv @ 0x7fc669002a00] 0 17 0

[NULL @ 0x7fc668809e00] nal_unit_type: 7, nal_ref_idc: 3

[NULL @ 0x7fc668809e00] nal_unit_type: 8, nal_ref_idc: 3

[NULL @ 0x7fc668809e00] user data:"x264 - core 142 r2 dd79a61 - H.264/MPEG-4 AVC codec - Copyleft 2003-2014 - http://www.videolan.org/x264.html - options: cabac=1 ref=8 deblock=1:-1:-1 analyse=0x1:0x131 me=umh subme=9 psy=1 psy_rd=1.00:0.15 mixed_ref=1 me_range=24 chroma_me=1 trellis=2 8x8dct=0 cqm=0 deadzone=21,11 fast_pskip=0 chroma_qp_offset=-3 threads=24 lookahead_threads=2 sliced_threads=0 nr=0 decimate=1 interlaced=0 bluray_compat=0 stitchable=1 constrained_intra=0 bframes=3 b_pyramid=2 b_adapt=2 b_bias=0 direct=3 weightb=1 open_gop=0 weightp=2 keyint=250 keyint_min=25 scenecut=40 intra_refresh=0 rc_lookahead=60 rc=2pass mbtree=1 bitrate=680 ratetol=1.0 qcomp=0.60 qpmin=0 qpmax=69 qpstep=4 cplxblur=20.0 qblur=0.5 ip_ratio=1.40 aq=1:1.00"

[h264 @ 0x7fc668809e00] nal_unit_type: 7, nal_ref_idc: 3

[h264 @ 0x7fc668809e00] nal_unit_type: 8, nal_ref_idc: 3

[h264 @ 0x7fc668809e00] nal_unit_type: 6, nal_ref_idc: 0

[h264 @ 0x7fc668809e00] nal_unit_type: 5, nal_ref_idc: 3

[h264 @ 0x7fc668809e00] user data:"x264 - core 142 r2 dd79a61 - H.264/MPEG-4 AVC codec - Copyleft 2003-2014 - http://www.videolan.org/x264.html - options: cabac=1 ref=8 deblock=1:-1:-1 analyse=0x1:0x131 me=umh subme=9 psy=1 psy_rd=1.00:0.15 mixed_ref=1 me_range=24 chroma_me=1 trellis=2 8x8dct=0 cqm=0 deadzone=21,11 fast_pskip=0 chroma_qp_offset=-3 threads=24 lookahead_threads=2 sliced_threads=0 nr=0 decimate=1 interlaced=0 bluray_compat=0 stitchable=1 constrained_intra=0 bframes=3 b_pyramid=2 b_adapt=2 b_bias=0 direct=3 weightb=1 open_gop=0 weightp=2 keyint=250 keyint_min=25 scenecut=40 intra_refresh=0 rc_lookahead=60 rc=2pass mbtree=1 bitrate=680 ratetol=1.0 qcomp=0.60 qpmin=0 qpmax=69 qpstep=4 cplxblur=20.0 qblur=0.5 ip_ratio=1.40 aq=1:1.00"

[h264 @ 0x7fc668809e00] Reinit context to 576x432, pix_fmt: yuv420p

[h264 @ 0x7fc668809e00] no picture

[flv @ 0x7fc669002a00] type:9, size:1653, last:-1, dts:40 pos:3436

[flv @ 0x7fc669002a00] 0 27 0(省略......)

[flv @ 0x7fc669002a00] 1 AF 0

[flv @ 0x7fc669002a00] type:9, size:88, last:-1, dts:1600 pos:31870

[flv @ 0x7fc669002a00] 0 27 0

[flv @ 0x7fc669002a00] All info found

[flv @ 0x7fc669002a00] stream 0: start_time: 0.080 duration: -9223372036854776.000

[flv @ 0x7fc669002a00] stream 1: start_time: 0.080 duration: -9223372036854776.000

[flv @ 0x7fc669002a00] format: start_time: 0.080 duration: 189.440 bitrate=787 kb/s

[flv @ 0x7fc669002a00] After avformat_find_stream_info() pos: 31965 bytes read:32768 seeks:0 frames:74

Input #0, flv, from 'out.flv':

Metadata:

major_brand : isom

minor_version : 512

compatible_brands: isomiso2avc1mp41

artist : yinyuetai.com

album : Yinyuetai

date : 04/01/15 15:51:32

comment : Yinyuetai-1TR1026

encoder : Lavf57.83.100

hasVideo : true

hasKeyframes : true

hasAudio : true

hasMetadata : true

canSeekToEnd : true

datasize : 18639072

videosize : 16303552

audiosize : 2335015

lasttimestamp : 189

lastkeyframetimestamp: 187

lastkeyframelocation: 18603951

Duration: 00:03:09.44, start: 0.080000, bitrate: 787 kb/s

Stream #0:0, 41, 1/1000: Video: h264 (Main), 1 reference frame, yuv420p(progressive, left), 576x432, 0/1, 684 kb/s, 25 fps, 25 tbr, 1k tbn, 50 tbc

Stream #0:1, 33, 1/1000: Audio: aac (HE-AAC), 44100 Hz, stereo, fltp, 95 kb/s

[h264 @ 0x7fc668824400] nal_unit_type: 7, nal_ref_idc: 3

[h264 @ 0x7fc668824400] nal_unit_type: 8, nal_ref_idc: 3

[AVIOContext @ 0x7fc667f005c0] Statistics: 32768 bytes read, 0 seeks

从以上内容可以看到,输出信息包含了keyframe关键帧存储在文件中的偏移位置及时间戳。

多媒体文件格式(三):M3U8 格式

M3U8 格式标准介绍

M3U8文件是指UTF-8编码格式的M3U文件。M3U文件是记录了一个索引纯文本文件,打开它时播放软件并不是播放它,而是根据它的索引找到对应的音视频文件的网络地址进行在线播放。

M3U8是一种常见的流媒体格式,主要以文件列表的形式存在,既支持直播又支持点播,尤其在Android、iOS等平台最为常用。

下面是CCTV6直播播放地址:http://ivi.bupt.edu.cn/hls/cctv6hd.m3u8的M3U8的文件列表:

#EXTM3U

#EXT-X-VERSION:3

#EXT-X-MEDIA-SEQUENCE:35232

#EXT-X-TARGETDURATION:10

#EXTINF:10.000,

cctv6hd-1549272376000.ts

#EXTINF:10.000,

cctv6hd-1549272386000.ts

#EXTINF:10.000,

cctv6hd-1549272396000.ts

#EXTINF:10.000,

cctv6hd-1549272406000.ts

#EXTINF:10.000,

cctv6hd-1549272416000.ts

#EXTINF:10.000,

cctv6hd-1549272426000.ts

下面我们来分别说明一下相关的几个字段:

- EXTM3U:这个是M3U8文件必须包含的标签,并且必须在文件的第一行,所有的M3U8文件中必须包含这个标签。

- EXT-X-VERSION:M3U8文件的版本,常见的是3(目前最高版本应该是7)。

- EXT-X-TARGETDURATION:该标签指定了媒体文件持续时间的最大值,播放文件列表中的媒体文件在EXTINF标签中定义的持续时间必须小于或者等于该标签指定的持续时间。该标签在播放列表文件中必须出现一次。

- EXT-X-MEDIA-SEQUENCE:M3U8直播是的直播切换序列,当播放打开M3U8时,以这个标签的值作为参考,播放对应的序列号的切片。

- EXTINF:EXTINF为M3U8列表中每一个分片的duration,如上面例子输出信息中的第一片的duration为10秒。在EXTINF标签中,除了duration值,还可以包含可选的描述信息,主要为标注切片信息,使用逗号分隔开。

关于客户端播放M3U8的标准还有更多的讲究,下面我们来介绍一些:

- 分片必须是动态改变的,序列不能相同,并且序列必须是增序的。

- 当M3U8没有出现EXT-X-ENDLIST标签时,无论这个M3U8列表中有多少分片,播放分片都是从倒数第三片开始播放,如果不满三片则不应该播放。当然如果有些播放器做了特别定制了,则可以不遵照这个原则。

- 以播放当前分片的duration时间刷新M3U8列表,然后做对应的加载动作。

- 前一片分片和后一片分片有不连续的时候,播放可能会出错,那么需要X-DISCONTINUTY标签来解决这个错误。

- 如果播放列表在刷新之后与之前的列表相同,那么在播放当前分片duration一半的时间内在刷新一次。

在上面,我们提到了,一些上面例子没有出现的一些标签字段,下面我们针对一些额外的标签做一些补充说明:

- EXT-X-ENDLIST:若出现EXT-X-ENDLIST标签,则表明M3U8文件不会再产生更多的切片,可以理解为该M3U8已停止更新,并且播放分片到这个标签后结束。M3U8不仅仅是可以作为直播,也可以作为点播存在,在M3U8文件中保存所有切片信息最后使用EXT-X-ENDLIST结尾,这个M3U8即为点播M3U8。EXT-X-ENDLIST标签可能会出现在播放列表文件的任何地方,但是不能出现两次或以上。

- EXT-X-STREAM-INF:EXT-X-STREAM-INF标签出现在M3U8时,主要是出现在多级M3U8文件中时,例如M3U8中包含子M3U8列表,或者主M3U8中包含多码率M3U8时;该标签后需要跟一些属性,下面就来逐一说明一下这些属性:

-

- BANDWIDTH:BANDWIDTH的值为最高码率值,当播放EXT-X-STREAM-INF下对应的M3U8时占用的最大码率(必要参数)。

- AVERAGE-BANDWIDTH:AVERAGE-BANDWIDTH的值为平均码率值,当播放EXT-X-STREAM-INF下对应的M3U8时占用的平均码率。(可选参数)。

- CODECS:CODECS的值用于声明EXT-X-STREAM-INF下面对应M3U8里面的音视频编码、视频编码的信息(可选参数)。

- RESOLUTION:M3U8中视频的宽高信息描述(可选参数)。

- FRAME-RATE:子M3U8中的视频帧率(可选参数)。

HLS 与 M3U8

HLS(全称:Http Live Streaming)是由Apple公司定义的用于实时流传输的协议,HLS基于HTTP协议实现,传输内容包括两部分,一是M3U8描述文件,二是TS媒体文件。

HLS的优势为:自适应码率流播(adaptive streaming)。效果就是客户端会根据网络状况自动选择不同码率的视频流,条件允许的情况下使用高码率,网络繁忙的时候使用低码率,并且能够自动在二者之间随意切换。这对移动设备网络状况不稳定的情况下保障流畅播放非常有帮助。实现方法是服务器端提供多码率视频流,并且在列表文件中注明,播放器根据播放进度和下载速度进行自动调整。

为什么要用 TS 而不是 MP4?这是因为两个 TS 片段可以无缝拼接,播放器能连续播放,而 MP4 文件由于编码方式的原因,两段 MP4 不能无缝拼接,播放器连续播放两个 MP4 文件会出现破音和画面间断,影响用户体验。而且如果要在一段长达一小时的视频中跳转,如果使用单个 MP4 格式的视频文件,并且也是用 HTTP 协议,那么需要代理服务器支持 HTTP range request 获取大文件中的一部分。这样的话,对于代理服务器的性能来说要求较高。而 HTTP Live Streaming 则只需要根据列表文件中的时间轴找出对应的 TS 片段下载即可,不需要 range request,对代理服务器的要求小很多。所有代理服务器都支持小文件的高效缓存。

FFmpeg转HLS文件(M3U8)实战

FFmpeg转MP4为HLS(M3U8)文件

将MP4文件转换成HLS(M3U8)命令行:

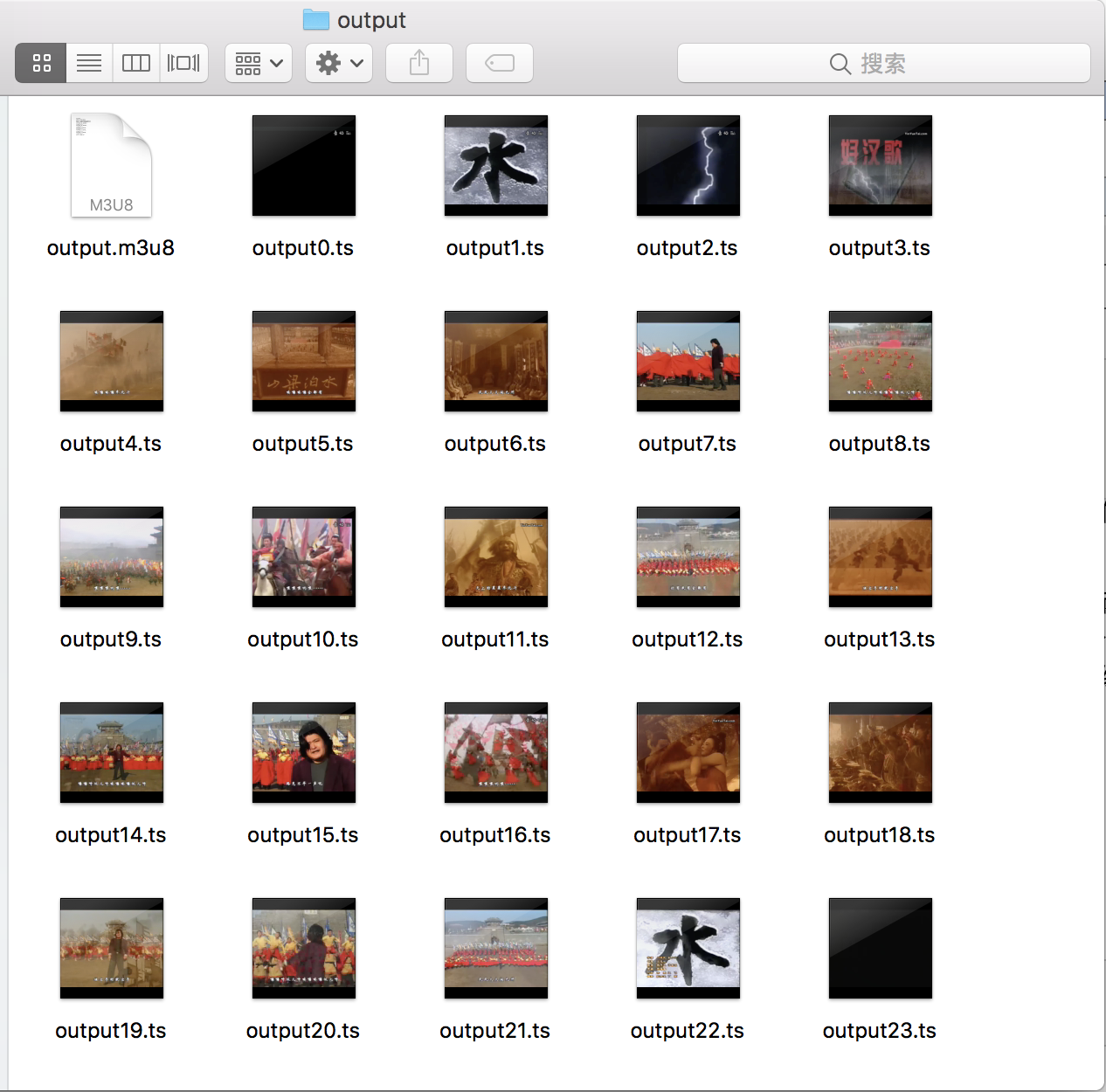

ffmpeg -re -i 好汉歌.mp4 -c copy -f hls -bsf:v h264_mp4toannexb output.m3u8

可以看到生成的M3U8及相应的ts文件:

查看一下生成的M3U8文件:

#EXTM3U

#EXT-X-VERSION:3

#EXT-X-TARGETDURATION:10

#EXT-X-MEDIA-SEQUENCE:19

#EXTINF:10.000000,

output19.ts

#EXTINF:10.000000,

output20.ts

#EXTINF:9.280000,

output21.ts

#EXTINF:4.120000,

output22.ts

#EXTINF:2.440000,

output23.ts

#EXT-X-ENDLIST

细心的人可能发现一个问题,就是生成的m3u8文件里只有最后的五个片段的信息。这是因为ffmpeg 默认的list size 为5,所以只获得最后的5个片段。为了解决这个问题,需要指定参数-hls_list_size 0,这样就能包含所有的片段。

下面是优化后的命令行:

ffmpeg -re -i 好汉歌.mp4 -c copy -f hls -hls_list_size 0 -bsf:v h264_mp4toannexb output.m3u8

这时,我们可以看到从output0.ts到output23.ts的文件列表了。

可能有人会发现,无论是优化之前的命令行,还是优化后的命令行都有一个参数-bsf:v h264_mp4toannexb,这个参数的作用是将MP4中的H.264数据转换成为H.264 AnnexB标准的编码,AnnexB标准的编码常见于实时传输流中。如果源文件为FLV、TS等可以作为直播传输流的视频,则不需要这个参数。

下面我们逐一介绍下使用FFmpeg生成HLS时还可以配置的其他参数。

FFmpeg 转 HLS (M3U8) 文件命令参数

start_number 参数

start_number 参数用于设置M3U8列表中的第一片的序列数。

下面的例子中,我们使用start_number参数设置M3U8中的第一片序列书为100,命令行如下:

ffmpeg -re -i huijia.mp4 -c copy -f hls -start_number 100 -hls_list_size 0 -bsf:v h264_mp4toannexb output.m3u8

输出的M3U8内容如下:

#EXTM3U

#EXT-X-VERSION:3

#EXT-X-TARGETDURATION:3

#EXT-X-MEDIA-SEQUENCE:100

#EXTINF:3.000000,

output100.ts

#EXTINF:3.000000,

output101.ts

#EXTINF:3.000000,

output102.ts

#EXTINF:3.000000,

output103.ts

#EXTINF:3.000000,

output104.ts

#EXTINF:3.000000,

output105.ts

#EXTINF:3.000000,

output106.ts

#EXTINF:1.000000,

output107.ts

#EXT-X-ENDLIST

从输出可以看出,切片的第一片编号是100,上面的命令行参数的-start_number参数已生效。

hls_time 参数

hls_time参数用于设置M3U8列表中切片的duration。

下面的例子中,我们使用hls_time参数设置M3U8的TS文件的每一片时长为9秒左右。命令行如下:

ffmpeg -re -i huijia.mp4 -c copy -f hls -hls_time 9 -hls_list_size 0 -bsf:v h264_mp4toannexb output.m3u8

然后查看输出的M3U8内容如下:

#EXTM3U

#EXT-X-VERSION:3

#EXT-X-TARGETDURATION:9

#EXT-X-MEDIA-SEQUENCE:0

#EXTINF:9.000000,

output0.ts

#EXTINF:9.000000,

output1.ts

#EXTINF:4.000000,

output2.ts

#EXT-X-ENDLIST

可以看到TS的文件每一片的时常都是9秒左右,hls_time参数生效。

( 注意:hls_time设置后效果不一定准确,会受到关键帧大小及其他因素影响。)

如果需要相对非常准确的切片,可以添加hls_flags的子参数split_by_time来保证生成的切片能够与hls_time设置的切片时长差不多。

( 注意:split_by_time参数必须与hls_time配合使用,并且使用split_by_time参数有可能会影响首画面体验,例如花屏或者首画面显示慢的问题,因为视频的第一帧不一定是关键帧。)

hls_list_size 参数

hls_list_size参数用于为M3U8列表中的TS切片的个数。其中设置为0的时候,将包含所有。

这个命令,我们在第3节优化MP4转HLS文件的命令行时使用到了。

下面的例子中,我们使用hls_list_size参数设置只保留2片TS切片。命令行如下:

ffmpeg -re -i huijia.mp4 -c copy -f hls -hls_list_size 2 -bsf:v h264_mp4toannexb output.m3u8

查看输出的M3U8内容如下:

#EXTM3U

#EXT-X-VERSION:3

#EXT-X-TARGETDURATION:3

#EXT-X-MEDIA-SEQUENCE:6

#EXTINF:3.000000,

output6.ts

#EXTINF:1.000000,

output7.ts

#EXT-X-ENDLIST

从输出的M3U8内容可以看出,在M3U8文件中只保留了2片TS的文件信息,可以看出hls_list_size设置生效了。

hls_base_url参数

hls_base_url 参数用于为M3U8列表的文件路径设置前置基本路径参数,因为在FFmpeg中生成M3U8时写入的TS切片路径默认为M3U8生成的路径相同,但是实际上TS所存储的路径既可以为本地绝对路径,也可以为相对路径,还可以为网络路径,因此使用hls_base_url参数可以达到该效果,命令行如下:

ffmpeg -re -i huijia.mp4 -c copy -f hls -hls_base_url /Users/renhui/Desktop/test/ -bsf:v h264_mp4toannexb output.m3u8

查看输出的M3U8内容如下:

#EXTM3U

#EXT-X-VERSION:3

#EXT-X-TARGETDURATION:3

#EXT-X-MEDIA-SEQUENCE:3

#EXTINF:3.000000,

/Users/renhui/Desktop/test/output3.ts

#EXTINF:3.000000,

/Users/renhui/Desktop/test/output4.ts

#EXTINF:3.000000,

/Users/renhui/Desktop/test/output5.ts

#EXTINF:3.000000,

/Users/renhui/Desktop/test/output6.ts

#EXTINF:1.000000,

/Users/renhui/Desktop/test/output7.ts

#EXT-X-ENDLIST

可以看到,TS的路径变为绝对路径了,使用ffplay output.m3u8播放,看到播放是能够正常播放的。这样就可以说明hls_base_url生效了。

多媒体文件格式(四):TS 格式

TS 格式标准介绍

TS是一种音视频封装格式,全称为MPEG2-TS。其中TS即"Transport Stream"的缩写。

先简要介绍一下什么是MPEG2-TS:

DVD的音视频格式为MPEG2-PS,全称是Program Stream。而TS的全称则是Transport Stream。MPEG2-PS主要应用于存储的具有固定时长的节目,如DVD电影,而MPEG-TS则主要应用于实时传送的节目,比如实时广播的电视节目。这两种格式的主要区别是什么呢?简单地打个比喻说,你将DVD上的VOB文件的前面一截cut掉(或者干脆就是数据损坏),那么就会导致整个文件无法解码了,而电视节目是你任何时候打开电视机都能解码(收看)的。

所以,MPEG2-TS格式的特点就是要求从视频流的任一片段开始都是可以独立解码的。

我们可以看出,TS格式是主要用于直播的码流结构,具有很好的容错能力。通常TS流的后缀是.ts、.mpg或者.mpeg,多数播放器直接支持这种格式的播放。TS流中不包含快速seek的机制,只能通过协议层实现seek。HLS协议基于TS流实现的。

TS格式分析工具:链接: 百度网盘-链接不存在 提取码: je5m

TS 格式详解

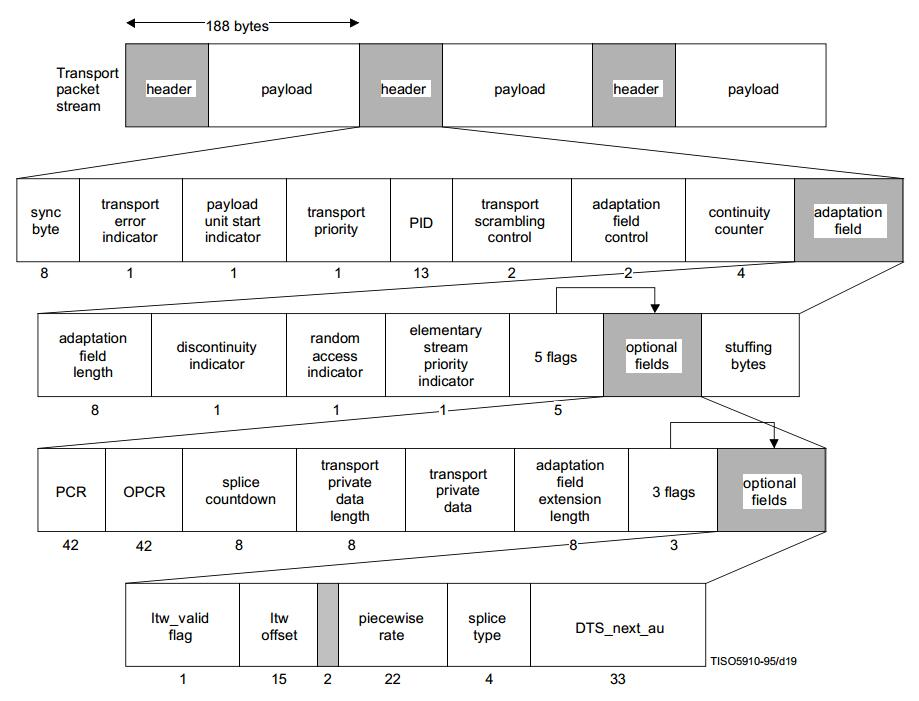

TS文件(流)可以分为三层:TS层(Transport Stream)、PES层(Packet Elemental Stream)、ES层(Elementary Stream)。

ES层就是音视频数据,PES层是在音视频数据上加了时间戳等对数据帧的说明信息,TS层是在PES层上加入了数据流识别和传输的必要信息。TS文件(码流)由多个TS Packet组成的。

下图是TS文件(码流)的分层结构图:

原图可以在:https://github.com/renhui/Thinking-in-AV/blob/master/多媒体格式/TS/1.TS分层结构.jpg 查看。

TS层

TS包大小固定为188字节,TS层分为三个部分:TS Header、Adaptation Field、Payload。

TS Header固定4个字节;Adaptation Field可能存在也可能不存在,主要作用是给不足188字节的数据做填充;Payload是PES数据。

TS Header

TS包的包头提供关于传输方面的信息。

TS包的包头长度不固定,前4个字节是固定的,后面可能跟有自适应字段(适配域)。4个字节是最小包头。

包头的结构体字段如下:

- sync_byte(同步字节):固定为0x47;该字节由解码器识别,使包头和有效负载可相互分离。

- transport_error_indicator(传输错误标志):‘1’表示在相关的传输包中至少有一个不可纠正的错误位。当被置1后,在错误被纠正之前不能重置为0。

- payload_unit_start_indicator(负载起始标志):为1时,表示当前TS包的有效载荷中包含PES或者PSI的起始位置;在前4个字节之后会有一个调整字节,其的数值为后面调整字段的长度length。因此有效载荷开始的位置应再偏移1+[length]个字节。

- transport_priority(传输优先级标志):‘1’表明当前TS包的优先级比其他具有相同PID, 但此位没有被置‘1’的TS包高。

- PID:指示存储与分组有效负载中数据的类型。

- transport_scrambling_control(加扰控制标志):表示TS流分组有效负载的加密模式。空包为‘00’,如果传输包包头中包括调整字段,不应被加密。其他取值含义是用户自定义的。

- adaptation_field_control(适配域控制标志):表示包头是否有调整字段或有效负载。‘00’为ISO/IEC未来使用保留;‘01’仅含有效载荷,无调整字段;‘10’ 无有效载荷,仅含调整字段;‘11’ 调整字段后为有效载荷,调整字段中的前一个字节表示调整字段的长度length,有效载荷开始的位置应再偏移[length]个字节。空包应为‘10’。

- continuity_counter(连续性计数器):随着每一个具有相同PID的TS流分组而增加,当它达到最大值后又回复到0。范围为0~15。

TS Adaptation Field

Adaptation Field的长度要包含传输错误指示符标识的一个字节。

PCR是节目时钟参考,PCR、DTS、PTS都是对同一个系统时钟的采样值,PCR是递增的,因此可以将其设置为DTS值,音频数据不需要PCR。

打包TS流时PAT和PMT表是没有Adaptation Field的,不够的长度直接补0xff即可。

视频流和音频流都需要加adaptation field,通常加在一个帧的第一个ts包和最后一个ts包里,中间的ts包不加。

TS Payload

TS包中Payload所传输的信息包括两种类型:视频、音频的PES包以及辅助数据;节目专用信息PSI。

TS包也可以是空包。空包用来填充TS流,可能在重新进行多路复用时被插入或删除。

视频、音频的ES流需进行打包形成视频、音频的 PES流。辅助数据(如图文电视信息)不需要打成PES包。

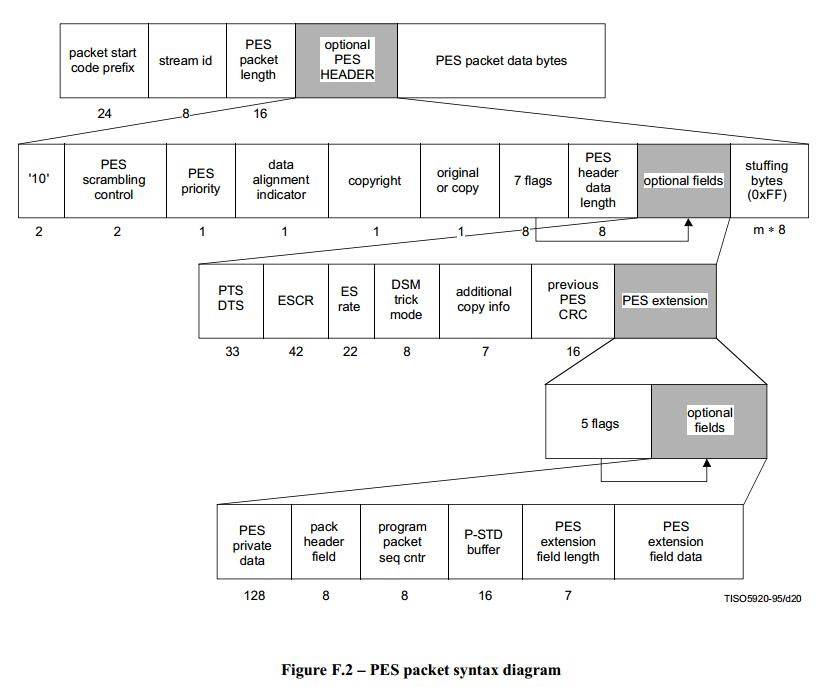

PES层 & ES 层

PES层

PES结构如图:

从上面的结构图可以看出,PES层是在每一个视频/音频帧上加入了时间戳等信息,PES包内容很多,下面我们说明一下最常用的字段:

- pes start code:开始码,固定为0x000001。

- stream id:音频取值(0xc0-0xdf),通常为0xc0;视频取值(0xe0-0xef),通常为0xe0。

- pes packet length:后面pes数据的长度,0表示长度不限制,只有视频数据长度会超过0xffff。

- pes data length:后面数据的长度,取值5或10。

- pts:33bit值

- dts:33bit值

关于时间戳PTS和DTS的说明:

- PTS是显示时间戳、DTS是解码时间戳。

- 视频数据两种时间戳都需要,音频数据的PTS和DTS相同,所以只需要PTS。

有PTS和DTS两种时间戳是B帧引起的,I帧和P帧的PTS等于DTS。如果一个视频没有B帧,则PTS永远和DTS相同。

从文件中顺序读取视频帧,取出的帧顺序和DTS顺序相同。DTS算法比较简单,初始值 + 增量即可,PTS计算比较复杂,需要在DTS的基础上加偏移量。

音频的PES中只有PTS(同DTS),视频的I、P帧两种时间戳都要有,视频B帧只要PTS(同DTS)。

ES 层

ES层指的就是音视频数据。

一般的,视频为H.264视频,音频为AAC音频。

TS流生成及解析流程

TS 流生成流程

- 将原始音视频数据压缩之后,压缩结果组成一个基本码流(ES)。

- 对ES(基本码流)进行打包形成PES。

- 在PES包中加入时间戳信息(PTS/DTS)。

- 将PES包内容分配到一系列固定长度的传输包(TS Packet)中。

- 在传输包中加入定时信息(PCR)。

- 在传输包中加入节目专用信息(PSI) 。

- 连续输出传输包形成具有恒定比特率的MPEG-TS流。

TS 流解析流程

- 复用的MPEG-TS流中解析出TS包;

- 从TS包中获取PAT及对应的PMT;

- 从而获取特定节目的音视频PID;

- 通过PID筛选出特定音视频相关的TS包,并解析出PES;

- 从PES中读取到PTS/DTS,并从PES中解析出基本码流ES;

- 将ES交给解码器,获得压缩前的原始音视频数据。

多媒体文件格式(五):PCM / WAV 格式

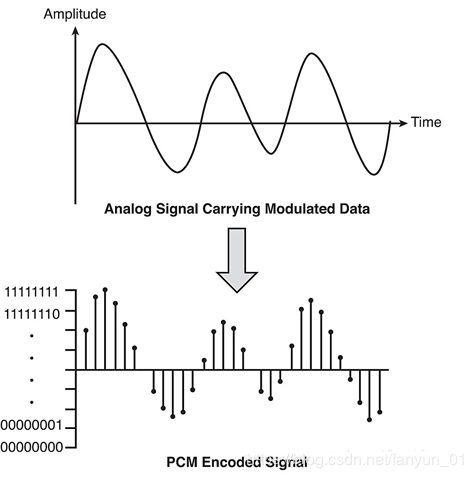

名词解析

PCM(Pulse Code Modulation)也被称为脉码编码调制,PCM中的声音数据没有被压缩,它是由模拟信号经过采样、量化、编码转换成的标准的数字音频数据。采样转换方式参考下图进行了解:

音频采样包含以下几大要素:

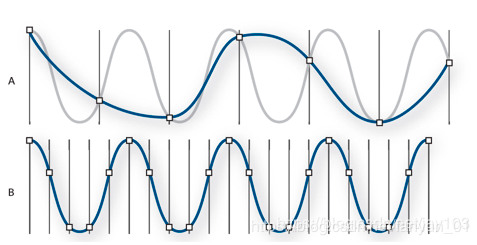

采样率

采样率表示音频信号每秒的数字快照数。该速率决定了音频文件的频率范围。采样率越高,数字波形的形状越接近原始模拟波形。低采样率会限制可录制的频率范围,这可导致录音表现原始声音的效果不佳。根据奈奎斯特采样定理,为了重现给定频率,采样率必须至少是该频率的两倍。例如,一般CD唱片的采样率为每秒 44,100 个采样,因此可重现最高为 22,050 Hz 的频率,此频率刚好超过人类的听力极限 20,000 Hz。

图中A是低采样率的音频信号,其效果已经将原始声波进行了扭曲,B则是完全重现原始声波的高采样率的音频信号。

数字音频常用的采样率如下:

位深度

位深度决定动态范围。采样声波时,为每个采样指定最接近原始声波振幅的振幅值。较高的位深度可提供更多可能的振幅值,产生更大的动态范围、更低的噪声基准和更高的保真度。

位深度越高,提供的动态范围越大。

PCM

在上面的名词解析中我们应该对PCM有了一定的理解和认识,下面我们将对PCM做更多的讲解。

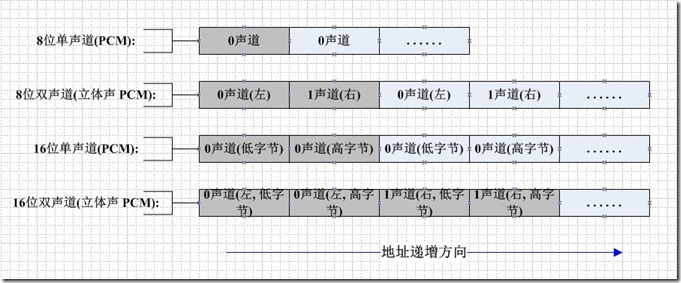

PCM音频数据存储方式

如果是单声道的文件,采样数据按时间的先后顺序依次存入。如果是单声道的音频文件,采样数据按时间的先后顺序依次存入(也可能采用 LRLRLR 方式存储,只是另一个声道的数据为 0)。

如果是双声道的话通常按照 LRLRLR 的方式存储,存储的时候还和机器的大小端有关。(关于字节序大小端的相关内容可参考《字节序问题之大小端模式讲解》进行了解)

PCM的存储方式为小端模式,存储Data数据排列如下图所示:

PCM 音频数据的参数

描述 PCM 音频数据的参数的时候有如下描述方式:

44100HZ 16bit stereo: 每秒钟有 44100 次采样, 采样数据用 16 位(2 字节)记录, 双声道(立体声)

22050HZ 8bit mono: 每秒钟有 22050 次采样, 采样数据用 8 位(1 字节)记录, 单声道

48000HZ 32bit 51ch: 每秒钟有 48000 次采样, 采样数据用 32 位(4 字节浮点型)记录, 5.1 声道

44100Hz 指的是采样率,它的意思是每秒取样 44100 次。采样率越大,存储数字音频所占的空间就越大。

16bit 指的是采样精度,意思是原始模拟信号被采样后,每一个采样点在计算机中用 16 位(两个字节)来表示。采样精度越高越能精细地表示模拟信号的差异。

Stereo 指的是声道数,也即采样时用到的麦克风的数量,麦克风越多就越能还原真实的采样环境(当然麦克风的放置位置也是有规定的)。

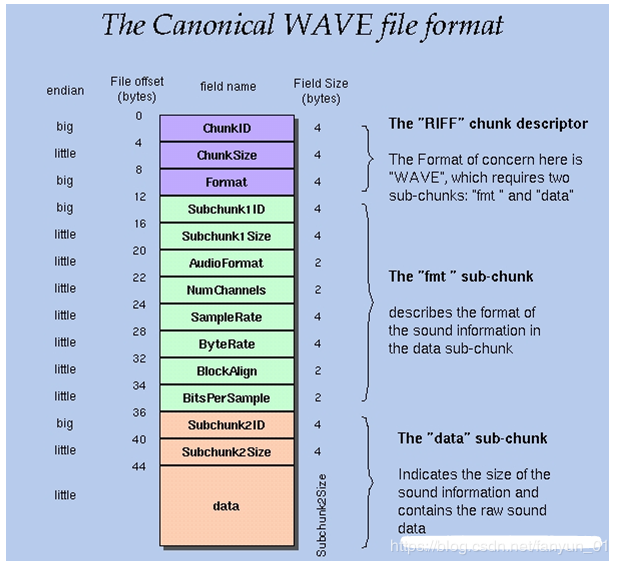

WAV

WAV 是 Microsoft 和 IBM 为 PC 开发的一种声音文件格式,它符合 RIFF(Resource Interchange File Format)文件规范,用于保存 Windows 平台的音频信息资源,被 Windows 平台及其应用程序所广泛支持。WAVE 文件通常只是一个具有单个 “WAVE” 块的 RIFF 文件,该块由两个子块(”fmt” 子数据块和 ”data” 子数据块),它的格式如下图所示:

WAV 格式定义

该格式的实质就是在 PCM 文件的前面加了一个文件头,每个字段的的含义如下:

typedef struct {

char ChunkID[4]; //内容为"RIFF"

unsigned long ChunkSize; //存储文件的字节数(不包含ChunkID和ChunkSize这8个字节)

char Format[4]; //内容为"WAVE“

} WAVE_HEADER;

typedef struct {

char Subchunk1ID[4]; //内容为"fmt"

unsigned long Subchunk1Size; //存储该子块的字节数(不含前面的Subchunk1ID和Subchunk1Size这8个字节)

unsigned short AudioFormat; //存储音频文件的编码格式,例如若为PCM则其存储值为1。

unsigned short NumChannels; //声道数,单声道(Mono)值为1,双声道(Stereo)值为2,等等

unsigned long SampleRate; //采样率,如8k,44.1k等

unsigned long ByteRate; //每秒存储的bit数,其值 = SampleRate * NumChannels * BitsPerSample / 8

unsigned short BlockAlign; //块对齐大小,其值 = NumChannels * BitsPerSample / 8

unsigned short BitsPerSample; //每个采样点的bit数,一般为8,16,32等。

} WAVE_FMT;

typedef struct {

char Subchunk2ID[4]; //内容为“data”

unsigned long Subchunk2Size; //接下来的正式的数据部分的字节数,其值 = NumSamples * NumChannels * BitsPerSample / 8

} WAVE_DATA;

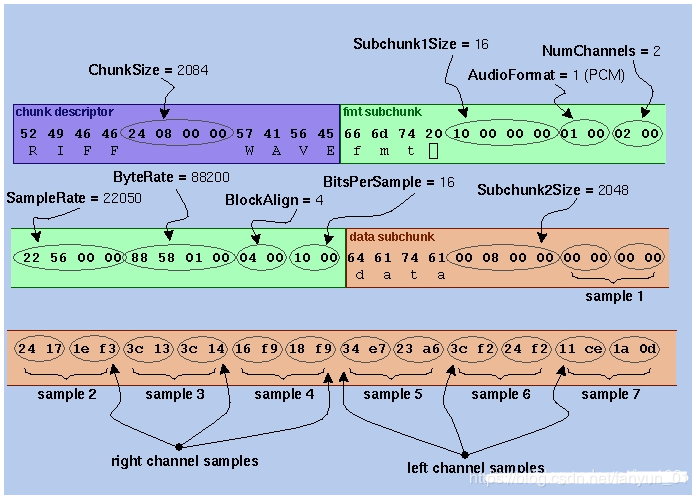

WAV 文件头解析

这里是一个 WAVE 文件的开头 72 字节,字节显示为十六进制数字:

52 49 46 46 | 24 08 00 00 | 57 41 56 45

66 6d 74 20 | 10 00 00 00 | 01 00 02 00

22 56 00 00 | 88 58 01 00 | 04 00 10 00

64 61 74 61 | 00 08 00 00 | 00 00 00 00

24 17 1E F3 | 3C 13 3C 14 | 16 F9 18 F9

34 E7 23 A6 | 3C F2 24 F2 | 11 CE 1A 0D

字段解析如下图:

PCM & WAV 开发实践

PCM格式转为WAV格式(基于C语言)

int simplest_pcm16le_to_wave(const char *pcmpath,int channels,int sample_rate,const char *wavepath)

{

typedef struct WAVE_HEADER{

char fccID[4];

unsigned long dwSize;

char fccType[4];

}WAVE_HEADER;

typedef struct WAVE_FMT{

char fccID[4];

unsigned long dwSize;

unsigned short wFormatTag;

unsigned short wChannels;

unsigned long dwSamplesPerSec;

unsigned long dwAvgBytesPerSec;

unsigned short wBlockAlign;

unsigned short uiBitsPerSample;

}WAVE_FMT;

typedef struct WAVE_DATA{

char fccID[4];

unsigned long dwSize;

}WAVE_DATA;

if(channels==0||sample_rate==0){

channels = 2;

sample_rate = 44100;

}

int bits = 16;

WAVE_HEADER pcmHEADER;

WAVE_FMT pcmFMT;

WAVE_DATA pcmDATA;

unsigned short m_pcmData;

FILE *fp,*fpout;

fp=fopen(pcmpath, "rb");

if(fp == NULL) {

printf("open pcm file error\n");

return -1;

}

fpout=fopen(wavepath, "wb+");

if(fpout == NULL) {

printf("create wav file error\n");

return -1;

}

//WAVE_HEADER

memcpy(pcmHEADER.fccID,"RIFF",strlen("RIFF"));

memcpy(pcmHEADER.fccType,"WAVE",strlen("WAVE"));

fseek(fpout,sizeof(WAVE_HEADER),1);

//WAVE_FMT

pcmFMT.dwSamplesPerSec=sample_rate;

pcmFMT.dwAvgBytesPerSec=pcmFMT.dwSamplesPerSec*sizeof(m_pcmData);

pcmFMT.uiBitsPerSample=bits;

memcpy(pcmFMT.fccID,"fmt ",strlen("fmt "));

pcmFMT.dwSize=16;

pcmFMT.wBlockAlign=2;

pcmFMT.wChannels=channels;

pcmFMT.wFormatTag=1;

fwrite(&pcmFMT,sizeof(WAVE_FMT),1,fpout);

//WAVE_DATA;

memcpy(pcmDATA.fccID,"data",strlen("data"));

pcmDATA.dwSize=0;

fseek(fpout,sizeof(WAVE_DATA),SEEK_CUR);

fread(&m_pcmData,sizeof(unsigned short),1,fp);

while(!feof(fp)){

pcmDATA.dwSize+=2;

fwrite(&m_pcmData,sizeof(unsigned short),1,fpout);

fread(&m_pcmData,sizeof(unsigned short),1,fp);

}

pcmHEADER.dwSize=44+pcmDATA.dwSize;

rewind(fpout);

fwrite(&pcmHEADER,sizeof(WAVE_HEADER),1,fpout);

fseek(fpout,sizeof(WAVE_FMT),SEEK_CUR);

fwrite(&pcmDATA,sizeof(WAVE_DATA),1,fpout);

fclose(fp);

fclose(fpout);

return 0;

}

注意:函数里声明的数据类型unsigned long在有些C编译器上是64位的,这时候要改成unsigned int才可以,否则wav头有88bytes,标准的是44bytes,改完就正常了,对C还不熟悉的人小小的心得,另外,声道数和采样率也要注意,一般采样率有44100/16000/8000,要确认是哪个,声道是1还是2,这两个参数要设置好才会有正确的转换结果。

PCM降低某个声道的音量(基于C语言)

一般来说 PCM 数据中的波形幅值越大,代表音量越大,对于 PCM 音频数据而言,它的幅值(即该采样点采样值的大小)代表音量的大小。

如果我们需要降低某个声道的音量,可以通过减小某个声道的数据的值来实现降低某个声道的音量。

int pcm16le_half_volume_left( char *url ) {

FILE *fp_in = fopen( url, "rb+" );

FILE *fp_out = fopen( "output_half_left.pcm", "wb+" );

unsigned char *sample = ( unsigned char * )malloc(4); // 一次读取一个sample,因为是2声道,所以是4字节

while ( !feof( fp_in ) ){

fread( sample, 1, 4, fp_in );

short* sample_num = ( short* )sample; // 转成左右声道两个short数据

*sample_num = *sample_num / 2; // 左声道数据减半

fwrite( sample, 1, 2, fp_out ); // L

fwrite( sample + 2, 1, 2, fp_out ); // R

}

free( sample );

fclose( fp_in );

fclose( fp_out );

return 0;

}

上述代码做的事情是:在读出左声道的 2 Byte 的取样值之后,将其转成了 C 语言中的一个 short 类型的变量。将该数值除以 2 之后写回到了 PCM 文件中。

分离PCM音频数据左右声道的数据

因为PCM音频数据是按照LRLRLR的方式来存储左右声道的音频数据的,所以我们可以通过将它们交叉的读出来的方式来分离左右声道的数据:

int simplest_pcm16le_split(char *url) {

FILE *fp=fopen(url,"rb+");

FILE *fp1=fopen("output_l.pcm","wb+");

FILE *fp2=fopen("output_r.pcm","wb+");

unsigned char *sample=(unsigned char *)malloc(4);

while(!feof(fp)){

fread(sample,1,4,fp);

//L

fwrite(sample,1,2,fp1);

//R

fwrite(sample+2,1,2,fp2);

}

free(sample);

fclose(fp);

fclose(fp1);

fclose(fp2);

return 0;

}

从PCM16LE单声道音频采样数据中截取一部分数据

本程序中的函数可以从PCM16LE单声道数据中截取一段数据,并输出截取数据的样值。函数的代码如下所示:

/**

* Cut a 16LE PCM single channel file.

* @param url Location of PCM file.

* @param start_num start point

* @param dur_num how much point to cut

*/

int simplest_pcm16le_cut_singlechannel(char *url,int start_num,int dur_num){

FILE *fp=fopen(url,"rb+");

FILE *fp1=fopen("output_cut.pcm","wb+");

FILE *fp_stat=fopen("output_cut.txt","wb+");

unsigned char *sample=(unsigned char *)malloc(2);

int cnt=0;

while(!feof(fp)){

fread(sample,1,2,fp);

if(cnt>start_num&&cnt<=(start_num+dur_num)){

fwrite(sample,1,2,fp1);

short samplenum=sample[1];

samplenum=samplenum*256;

samplenum=samplenum+sample[0];

fprintf(fp_stat,"%6d,",samplenum);

if(cnt%10==0)

fprintf(fp_stat,"\n",samplenum);

}

cnt++;

}

free(sample);

fclose(fp);

fclose(fp1);

fclose(fp_stat);

return 0;

}

将PCM16LE双声道音频采样数据转换为PCM8音频采样数据

本程序中的函数可以通过计算的方式将PCM16LE双声道数据16bit的采样位数转换为8bit。函数的代码如下所示:

/**

* Convert PCM-16 data to PCM-8 data.

* @param url Location of PCM file.

*/

int simplest_pcm16le_to_pcm8(char *url){

FILE *fp=fopen(url,"rb+");

FILE *fp1=fopen("output_8.pcm","wb+");

int cnt=0;

unsigned char *sample=(unsigned char *)malloc(4);

while(!feof(fp)){

short *samplenum16=NULL;

char samplenum8=0;

unsigned char samplenum8_u=0;

fread(sample,1,4,fp);

//(-32768-32767)

samplenum16=(short *)sample;

samplenum8=(*samplenum16)>>8;

//(0-255)

samplenum8_u=samplenum8+128;

//L

fwrite(&samplenum8_u,1,1,fp1);

samplenum16=(short *)(sample+2);

samplenum8=(*samplenum16)>>8;

samplenum8_u=samplenum8+128;

//R

fwrite(&samplenum8_u,1,1,fp1);

cnt++;

}

printf("Sample Cnt:%d\n",cnt);

free(sample);

fclose(fp);

fclose(fp1);

return 0;

}

PCM16LE格式的采样数据的取值范围是-32768到32767,而PCM8格式的采样数据的取值范围是0到255。所以PCM16LE转换到PCM8需要经过两个步骤:第一步是将-32768到32767的16bit有符号数值转换为-128到127的8bit有符号数值,第二步是将-128到127的8bit有符号数值转换为0到255的8bit无符号数值。在本程序中,16bit采样数据是通过short类型变量存储的,而8bit采样数据是通过unsigned char类型存储的。

将PCM16LE双声道音频采样数据的声音速度提高一倍

本程序中的函数可以通过抽象的方式将PCM16LE双声道数据的速度提高一倍,采用采样每个声道奇(偶)数点的样值的方式,函数的代码如下所示:

/**

* Re-sample to double the speed of 16LE PCM file

* @param url Location of PCM file.

*/

int simplest_pcm16le_doublespeed(char *url){

FILE *fp=fopen(url,"rb+");

FILE *fp1=fopen("output_doublespeed.pcm","wb+");

int cnt=0;

unsigned char *sample=(unsigned char *)malloc(4);

while(!feof(fp)){

fread(sample,1,4,fp);

if(cnt%2!=0){

//L

fwrite(sample,1,2,fp1);

//R

fwrite(sample+2,1,2,fp1);

}

cnt++;

}

printf("Sample Cnt:%d\n",cnt);

free(sample);

fclose(fp);

fclose(fp1);

return 0;

}

3039

3039

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?