电商平台评论数据分析

摘要

随着电商平台的发展,商品评论成为消费者决策与商家优化的重要依据。本文以京东平台安井手抓饼的 2000 余条评论为研究对象,运用 Python 进行数据预处理、分词、词频统计及 LDA 主题模型分析,挖掘消费者对产品特性(如口味、价格)和服务(如物流、包装)的评价倾向。研究发现,消费者对产品口感、性价比及京东物流认可度较高,研究结果可为商家改进产品与服务提供参考,也为语言数据分析在电商领域的应用提供实践案例。

关键词: 电商评论;语言数据分析;Python;LDA 主题模型;安井手抓饼

1.引言

1.1 研究背景

在数字化时代,电商平台的商品评论蕴含大量消费者态度与需求信息。这些文本数据不仅反映产品市场反馈,还为商家优化策略提供依据。语言数据分析技术能够从非结构化评论中提取有效信息,成为电商领域研究的重要工具。

1.2 问题定义

本文聚焦京东平台 “安井手抓饼” 的用户评论,旨在通过数据分析回答:消费者对该产品的核心评价维度(如口味、价格、便捷性)是什么?评论中体现的主要情感倾向如何?物流与销售服务对消费体验的影响程度如何?

1.3 相关研究

现有研究多采用文本挖掘方法分析电商评论,如利用情感分析识别用户满意度(张明等,2023),或通过主题模型提取评论焦点(Li et al.,2022)。但针对速冻食品类评论的细分研究较少,本文可补充该领域案例。

1.4 解决思路

首先爬取京东平台安井手抓饼的评论数据,通过 Python 进行清洗与预处理;其次运用分词、词频统计等技术提取关键信息;最后通过 LDA 主题模型挖掘评论主题,结合可视化工具呈现分析结果。

2.方法与工具

2.1 技术工具

采用 Python 编程语言,主要依赖以下库:

- 数据处理:pandas(数据读取、清洗、存储)、numpy(数值计算);

- 文本分析:jieba(中文分词、关键词提取)、sklearn(TF-IDF 转换、LDA 主题模型);

- 可视化:matplotlib、seaborn(图表绘制)、wordcloud(词云生成)。

2.2 核心方法

- 数据预处理:去重、缺失值填充、停用词过滤;

- 文本分析:中文分词(精确模式)、词性标注、词频统计;

- 主题挖掘:LDA(Latent Dirichlet Allocation)主题模型,将评论划分为若干主题并提取特征词。

3.数据描述

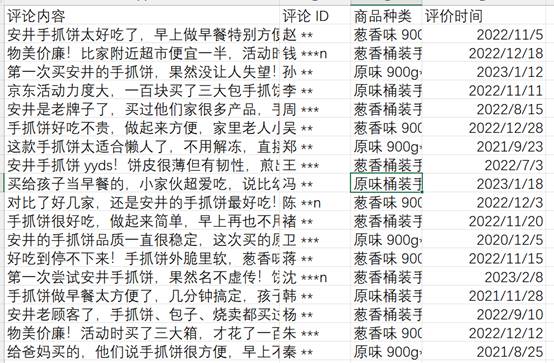

本次选择了京东上面的一个是手抓饼商品的评论,我爬取了2千多条,数据如下:

4.分析过程与结果

4.1数据预处理

|

import pandas as pd import numpy as np import matplotlib.pyplot as plt import seaborn as sns import networkx as nx plt.rcParams['font.sans-serif'] = ['KaiTi'] #指定默认字体 SimHei黑体 plt.rcParams['axes.unicode_minus'] = False #解决保存图像是负号' import jieba stop_list = pd.read_csv("停用词.txt",index_col=False,quoting=3,sep="\t",names=['stopword'], encoding='utf-8') |

读取数据,导入包,由于是文本数据,中文文本要分词处理,读取停用词

定义分词函数,新增一列分词后的列:cutword:

|

#Jieba分词函数 def txt_cut(juzi): lis=[w for w in jieba.lcut(juzi) if w not in stop_list.values] return (" ").join(lis) df=pd.read_excel('result.xlsx') df['cutword']=df['评论'].astype('str').apply(txt_cut) df=df[['id','评价时间','商品种类','评论','cutword']] |

然后去重,填充缺失值:

|

df=df.drop_duplicates(subset=['评论']) df=df.fillna(method='backfill') |

清洗后储存一下:

Python助力安井手抓饼电商评论分析

Python助力安井手抓饼电商评论分析

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?