https://authors.elsevier.com/a/1kyHM15hYd-jac

@article{zhao2025sst,

title={SST: Self-training with self-adaptive thresholding for semi-supervised learning},

author={Zhao, Shuai and Huang, Heyan and Li, Xinge and Chen, Xiaokang and Wang, Rui},

journal={Information Processing \& Management},

volume={62},

number={5},

pages={104158},

year={2025},

publisher={Elsevier}

}摘要

神经网络在监督学习中表现出卓越的性能,这得益于大量高质量的标注数据。然而,在现实场景中获取此类数据的成本高昂且耗费人力。半监督学习(SSL)通过利用少量标注数据和大量未标注数据,为这一问题提供了解决方案。近期的研究,如采用一致性正则化或伪标签的 Semi-ViT 和 Noisy Student,已取得显著成就。然而,它们仍然面临挑战,特别是在准确选择足够的高质量伪标签方面,因为它们依赖于固定的阈值。FlexMatch 和 FreeMatch 等最新方法引入了灵活或自适应的阈值技术,极大地推动了 SSL 的研究。尽管如此,它们在每次迭代中更新阈值的过程被认为是耗时、计算密集且可能是不必要的。为了解决这些问题,我们提出了一种新颖、有效且高效的 SSL 框架:使用自适应阈值的自训练(Self-training with Self-adaptive Thresholding, SST)。SST 可与监督学习(Super-SST)和半监督学习(Semi-SST)相结合。SST 引入了一种创新的自适应阈值(Self-Adaptive Thresholding, SAT)机制,该机制根据模型的学习进度自适应地调整类别特定的阈值。SAT 确保了高质量伪标签数据的选择,减轻了不准确伪标签和确认偏差(模型在训练中强化自身错误)的风险。具体来说,SAT 防止模型过早地采纳低置信度的伪标签,减少了错误的强化,并提升了模型性能。大量的实验表明,SST 在各种架构和数据集上均实现了最先进的性能,并具有显著的效率、泛化能力和可扩展性。值得注意的是,Semi-SST-ViT-Huge 在竞争激烈的 ImageNet-1K SSL 基准测试(无外部数据)上取得了最佳结果,仅使用 1% / 10% 的标注数据就达到了 80.7% / 84.9% 的 Top-1 准确率。相比之下,使用 100% 标注数据的全监督 DeiT-III-ViT-Huge 实现了 84.8% 的 Top-1 准确率,我们的方法仅用 10% 的标注数据就展现出更优的性能。这表明人力标注成本降低了十倍,显著缩小了半监督方法与全监督方法之间的性能差距。这些进展为 SSL 的进一步创新以及在获取标注数据具有挑战性或成本高昂的实际应用铺平了道路。

1.引言

神经网络在各种监督学习任务中表现出卓越的性能 \citep{russakovsky2015imagenet, deng2009imagenet, lin2014microsoft},这得益于大量高质量的标注数据。然而,在现实场景中获取足够的高质量标注数据可能既昂贵又耗费人力。因此,如何从少量标注样本中学习并有效利用大量未标注数据已成为一个紧迫的挑战。半监督学习(SSL) \citep{zhu2005semi, zhu2022introduction, sohn2020fixmatch, van2020survey} 通过利用少量标注数据和大量未标注数据,为这一问题提供了解决方案。

一致性正则化、伪标签和自训练是主要的 SSL 方法。一致性正则化 \citep{laine2016temporal, tarvainen2017mean, miyato2018virtual, xie2020unsupervised, bachman2014learning, rasmus2015semi, berthelot2019mixmatch, sajjadi2016regularization} 促使模型对同一未标注样本在不同扰动下产生一致的预测,从而提升模型性能。伪标签和自训练在 SSL 中密切相关。伪标签为未标注数据分配标签,而自训练则迭代地使用这些伪标签来提升模型性能。

近期的研究,如采用一致性正则化、伪标签或自训练的 Semi-ViT \citep{cai2022semi} 和 Noisy Student \citep{xie2020self},已取得显著成就。然而,它们仍然面临挑战,特别是在准确选择足够的高质量伪标签方面,因为它们依赖于固定的阈值。FlexMatch \citep{zhang2021flexmatch} 和 FreeMatch \citep{wang2023freematch} 等最新方法引入了灵活或自适应的阈值技术,极大地推动了 SSL 的研究。尽管如此,它们在每次迭代中更新阈值的过程被认为是耗时、计算密集且可能是不必要的。此外,FlexMatch 和 FreeMatch 都是基于仍在训练中的模型(而非已收敛的高精度模型)来预测未标注数据并更新阈值。在训练初期,使用性能较低的模型来预测未标注数据不可避免地会引入更多不准确的伪标签,导致不准确性不断增加的反馈循环。这在训练过程中放大并强化了确认偏差 \citep{arazo2020pseudo, chen2022debiased, wang2022debiased},最终导致次优性能。

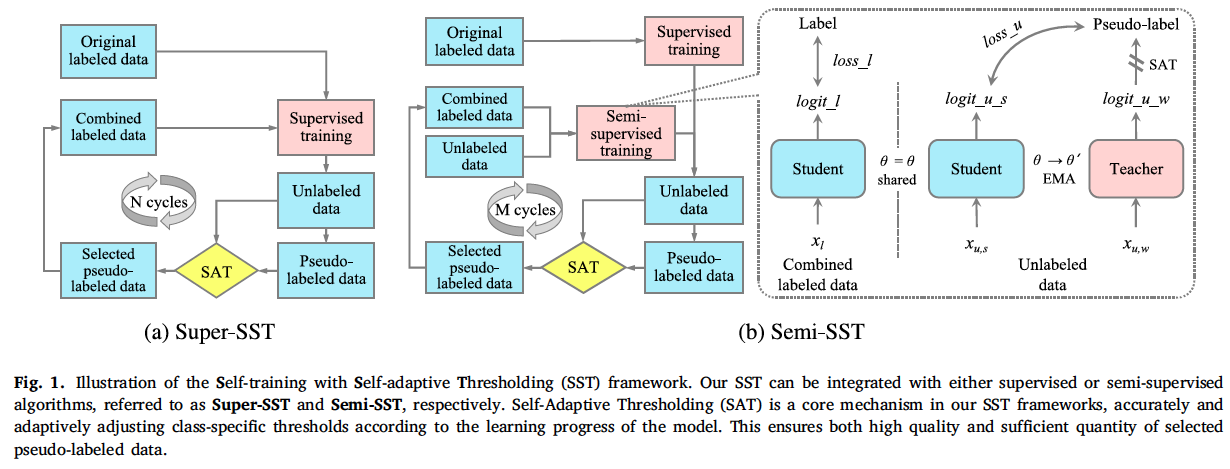

为了解决上述问题,我们提出了一种新颖、有效且高效的 SSL 框架:使用自适应阈值的自训练(Self-training with Self-adaptive Thresholding, SST),该框架显著推动了 SSL 领域的发展。如图1所示,我们的 SST 框架可以与监督或半监督算法相结合。我们将监督训练与 SST 的结合称为 \textit{Super-SST},将半监督训练与 SST 的结合称为 \textit{Semi-SST}。我们的 SST 引入了一种创新的自适应阈值(Self-Adaptive Thresholding, SAT)机制,该机制根据模型的学习进度准确且自适应地调整类别特定的阈值。这种方法确保了所选伪标签数据的高质量和足够数量,减轻了不准确伪标签和确认偏差的风险,从而提升了整体模型性能。

SAT 与现有的动态阈值方法(如 FlexMatch 和 FreeMatch)在三个关键方面有所不同:

\textit{阈值推导}:SAT 采用基于置信度的方法,应用截断值 $C$ 来过滤掉每个类别的低置信度概率,然后对剩余概率进行平均,并乘以一个缩放因子 $S$ 来推导出类别特定的阈值。与 FlexMatch 依赖于基于预测的未标注样本数量和全局阈值的课程学习不同,SAT 避免了这种依赖。与 FreeMatch 使用指数移动平均(EMA)和全局阈值而没有低置信度过滤不同,SAT 引入了截断机制,同时摒弃了 EMA 和全局阈值。

\textit{阈值更新}:SAT 在每个训练周期使用训练良好的模型更新一次阈值,将更新次数限制在个位数。这大大减少了计算开销并减轻了确认偏差。相比之下,FlexMatch 和 FreeMatch 在每次迭代(例如,超过 1,000,000 次更新)中使用仍在训练中的模型更新阈值,产生了巨大的计算成本,并在早期训练中加剧了确认偏差。

\textit{实证优势}:广泛的经验评估证明了 SAT 在多个基准上的优势。例如,在 CIFAR-100 上使用 400、2500 和 10000 个标签时,FreeMatch 使用约 240 GPU 小时达到了 28.71% 的平均错误率。相比之下,由 SAT 机制驱动的 Super-SST 和 Semi-SST 分别以仅 3 和 4 GPU 小时实现了更低的平均错误率 22.74% 和 20.50%,速度提升了 80 倍和 60 倍。

Super-SST 的流程如图1所示,包括以下几个步骤:1) 使用原始标注数据初始化模型。2) 利用训练良好、性能高的模型预测未标注数据。3) 应用自适应阈值(SAT)来准确生成或调整类别特定的阈值。4) 使用类别特定的阈值选择高置信度且可靠的伪标签,减少不准确的伪标签并减轻确认偏差。5) 通过将原始标注数据与精心挑选的伪标签数据相结合来扩展标注训练集,并同等对待它们。6) 使用合并后的标注数据优化模型性能。7) 返回步骤 2 进行迭代训练,在多个周期内不断改进模型,直到其性能收敛。

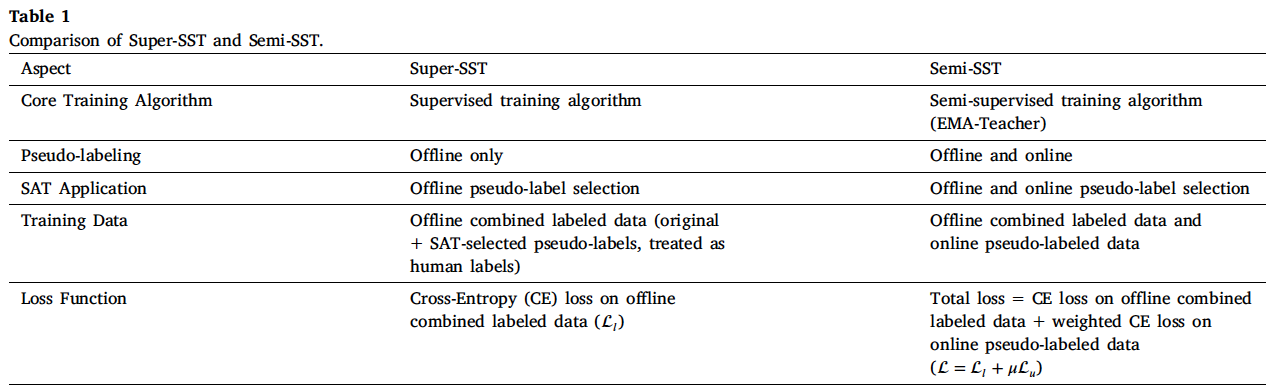

如图1所示,Semi-SST 通过整合 EMA-Teacher 模型 \citep{cai2022semi} 增强了 Super-SST 的离线伪标签流程,引入了动态的在线伪标签来补充离线过程。具体来说,在 EMA-Teacher 中,教师模型在线动态生成伪标签,而学生模型则在离线合并的标注数据和这些在线伪标签数据上进行训练。因此,Semi-SST 同时采用了离线和在线伪标签机制,并在两种情况下都应用 SAT 以确保高置信度伪标签的选择。表1概述了 Super-SST 和 Semi-SST 之间的主要区别。

大量的实验和结果有力地证实了我们的方法在基于 CNN 和基于 Transformer 的架构以及包括 ImageNet-1K、CIFAR-100、Food-101 和 iNaturalist 在内的各种数据集上的有效性、效率、泛化能力和可扩展性。与监督和半监督基线相比,我们的方法仅使用 1%(10%)的标注数据,在 Top-1 准确率上实现了 0.7%-20.7%(0.2%-12.1%)的相对提升。值得注意的是,Semi-SST-ViT-Huge 在竞争激烈的 ImageNet-1K SSL 基准测试(无外部数据)上取得了最佳结果,仅使用 1% / 10% 的标注数据就达到了 80.7% / 84.9% 的 Top-1 准确率。相比之下,使用 100% 标注数据的全监督 DeiT-III-ViT-Huge 实现了 84.8% 的 Top-1 准确率,我们的方法仅用 10% 的标注数据就展现出更优的性能。这表明人力标注成本降低了十倍,显著缩小了半监督方法与全监督方法之间的性能差距。此外,我们的 SST 方法不仅实现了高性能,还表现出卓越的效率,从而带来了极高的性价比。此外,在 ImageNet-1K 基准测试中,Super-SST 的准确率分别比 FlexMatch 和 FreeMatch 高出 6.27% 和 4.99%,且仅需 3 次阈值更新,而 FlexMatch 和 FreeMatch 则需要超过 1,000,000 次阈值更新。

总而言之,我们的贡献有三方面:

我们提出了一个创新的使用自适应阈值的自训练(SST)框架,及其两种变体:Super-SST 和 Semi-SST,显著推动了 SSL 领域的发展。

SST 引入了一种新颖的自适应阈值(SAT)技术,该技术根据模型的学习进度准确且自适应地调整类别特定的阈值。该机制确保了所选伪标签数据的高质量和足够数量,减轻了不准确伪标签和确认偏差的风险,从而提升了整体模型性能。

SST 在各种架构和数据集上实现了最先进(SOTA)的性能,同时展现出卓越的效率,带来了极高的性价比。此外,SST 显著减少了对人工标注的依赖,弥合了半监督学习与全监督学习之间的差距。

2.研究目标

在第1节中讨论的 SSL 方法要么依赖于固定阈值,要么使用成本高昂且性能有限的动态阈值技术来选择伪标签。这两种方法都倾向于在训练早期引入更多的噪声标签,导致不准确性不断增加的反馈循环,并强化确认偏差,最终导致次优性能。为了克服这些挑战,我们提出了 SST 框架及其核心组件 SAT 机制。这些创新旨在训练过程中准确选择高质量且数量充足的伪标签数据,最大限度地降低不准确性和确认偏差的风险,从而提升整体模型性能。我们希望本文能激发未来的研究,并为获取标注数据具有挑战性或成本高昂的实际应用提供经济高效的解决方案。

3.方法

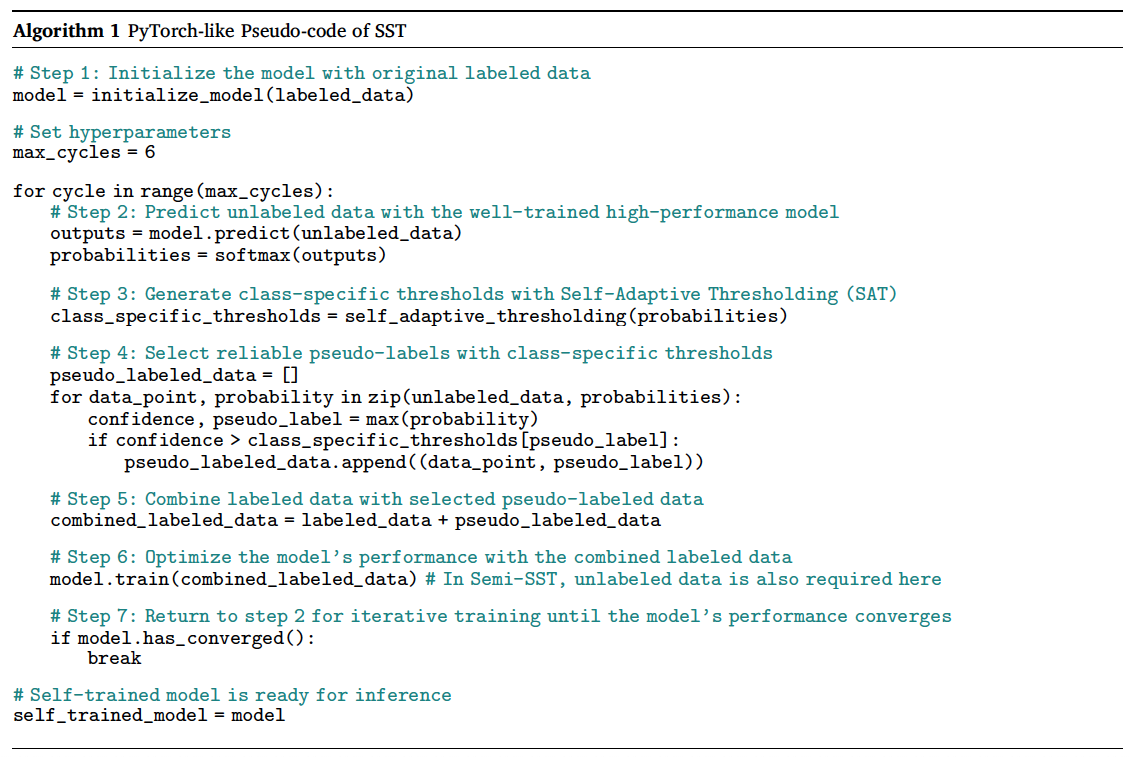

图1提供了 SST 的可视化概览,而算法1展示了其伪代码实现。

4.实验结果

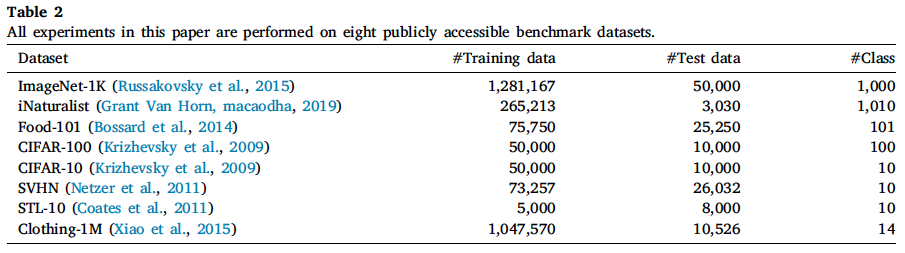

\textbf{数据集}. 如表2所示,我们在八个公开可用的基准数据集上进行了实验:ImageNet-1K、Food-101、iNaturalist、CIFAR-100、CIFAR-10、SVHN、STL-10 和 Clothing-1M。这些数据集共同提供了一个全面的基准,用于评估 SSL 算法在各种领域和复杂度下的性能。本文中的所有 SSL 实验均在每个数据集训练集中随机抽取的标注数据上进行。

ImageNet-1K \citep{russakovsky2015imagenet} 覆盖了广泛的现实世界物体,广泛用于计算机视觉任务。它包含约 128 万张训练图像和 5 万张验证图像,分为 1,000 个类别。

Food-101 \citep{bossard2014food} 包含 101 个类别的 10.1 万张食物图像。每个类别包含 1,000 张图像,分为 750 张训练图像和 250 张测试图像。

iNaturalist \citep{inaturalist-2019-fgvc6} 源自 iNaturalist 社区,记录了全球的生物多样性。它包含 256,213 张训练图像和 3,030 张测试图像,涵盖 1,010 个生物类别。

CIFAR-100 \citep{krizhevsky2009learning} 涵盖了各种现实世界的物体和动物。它包含 6 万张 32$\times$32 的图像,分为 100 个类别,每个类别包含 500 张训练图像和 100 张测试图像。

CIFAR-10 \citep{krizhevsky2009learning} 包含 6 万张 32$\times$32 的彩色图像,分为 10 个不同的类别,每个类别包含 5,000 张训练图像和 1,000 张测试图像。

SVHN \citep{netzer2011reading} 是一个用于数字识别的真实世界数据集,从谷歌街景图像中的门牌号获取。它包含 73,257 个训练样本和 26,032 个测试样本,涵盖 10 个数字类别,另有 531,131 张补充图像。

STL-10 \citep{coates2011analysis} 包含 1.3 万张 96$\times$96 的彩色图像,分为 10 个类别。每个类别包括 500 张带标签的训练图像和 800 张测试图像,并辅以 10 万张未标注图像。

Clothing-1M \citep{xiao2015learning} 是一个大规模数据集,包含约 100 万张从在线购物网站收集的服装图像。这些图像标注有 14 个类别的噪声标签,数据集分为 47,570 张干净的带标签训练图像、100 万张带噪声标签的训练图像、14,313 张验证图像和 10,526 张测试图像,使其成为一个具有挑战性的带噪声标签学习基准。

\textbf{架构}. 对于 Transformer 神经网络,我们使用了标准的 Vision Transformer (ViT) 架构 \citep{dosovitskiy2020image},它由一系列 Transformer 块堆叠而成。每个块包含一个多头自注意力层和一个多层感知器(MLP)块。我们使用 ViT 输出的平均池化进行分类。遵循 Semi-ViT 的做法,我们直接使用了 DINO \citep{caron2021emerging} 预训练的 ViT-Small,以及 MAE \citep{he2022masked} 预训练的 ViT-Base 和 ViT-Huge,这些模型已经为下游任务学习到了有用的视觉表示。对于卷积神经网络,我们使用了标准的 ConvNeXt 架构 \citep{liu2022convnet},该架构结合了 mixup 策略 \citep{zhang2017mixup} 以增强结果,而不是传统的 ResNet \citep{he2016deep}。请注意,自监督预训练在我们的方法中是可选的。我们从头开始训练 ConvNeXt 架构,没有任何预训练。

\textbf{实现细节}. 我们的训练协议很大程度上遵循了 Semi-ViT 中的良好实践,仅有细微差别。模型优化使用 AdamW \citep{loshchilov2017decoupled},采用线性学习率缩放规则 \citep{goyal2017accurate} $lr = base\_lr \times batchsize/256$ 和余弦学习率衰减计划 \citep{loshchilov2016sgdr}。此外,我们在实验中加入了标签平滑 \citep{szegedy2016rethinking}、drop path \citep{huang2016deep} 和 cutmix \citep{yun2019cutmix}。为了公平比较,我们在训练和测试期间都使用了 224$\times$224 的中心裁剪。数据增强策略遵循 \citep{cai2022semi, cubuk2020randaugment, zhong2020random} 中描述的方法。

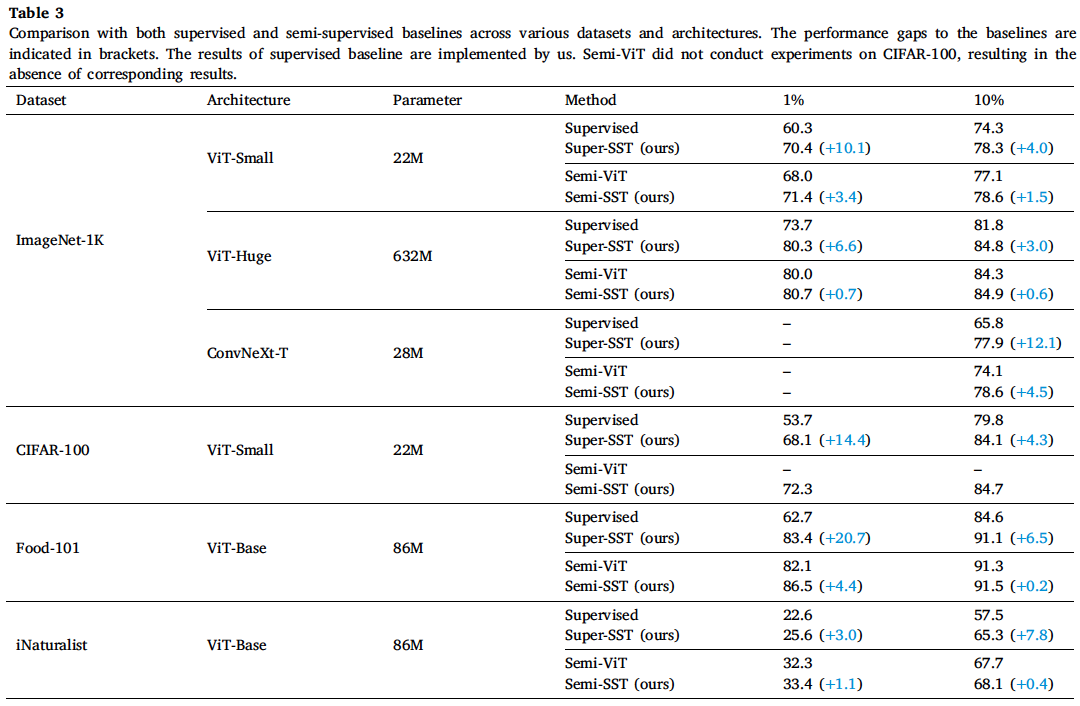

表3展示了 Super-SST 与监督基线的比较,以及 Semi-SST 与半监督基线的比较。该比较涵盖了基于 CNN 和基于 Transformer 的架构,涉及多个数据集,包括 ImageNet-1K、CIFAR-100、Food-101 和 iNaturalist,使用了 1% 和 10% 的标注数据。由于计算资源限制,我们仅在 10% ImageNet-1K 标签上进行了 ConvNeXt-T 的实验。

\textbf{有效性与泛化能力}. 如表3所示,Super-SST 和 Semi-SST 在各种数据集上均持续优于它们各自的监督和半监督基线,展现出强大的泛化能力。值得注意的是,CNN 和 Transformer 架构都从 Super-SST 和 Semi-SST 中显著受益,这突显了它们在不同架构下的有效性和鲁棒性。

\textbf{数据效率}. 表3同时表明,Super-SST 和 Semi-SST 在不同比例的标注数据下都能保持稳健的性能提升。在使用 1% 标注数据时,它们的 Top-1 准确率相对提升了 0.7%-20.7%;在使用 10% 标注数据时,相对提升了 0.2%-12.1%。在标注数据比例较小(例如 1%)时,提升更为显著,这表明 Super-SST 和 Semi-SST 在低数据场景下尤其有效,使其适用于数据高效学习。随着标注数据量从 1% 增加到 10%,相对提升幅度减小,表明随着标注数据的增多,收益递减。

\textbf{可扩展性}. 如表3所示,Super-SST 和 Semi-SST 在使用像 ViT-Huge 这样更大的架构时均显示出显著的改进,表明随着模型容量的增加具有更好的可扩展性。例如,在 1% / 10% 的 ImageNet-1K 标注数据和 ViT-Huge 架构下,Super-SST 相对于监督基线显示出 6.6% / 3.0% 的相对提升,而 Semi-SST 相对于半监督基线显示出 0.7% / 0.6% 的相对提升。

\textbf{Super-SST vs. Semi-SST}. Super-SST 和 Semi-SST 在各种数据集和架构上都表现出具有竞争力的性能,其中 Semi-SST 通常略占优势。如表3所示,Semi-SST 的 Top-1 准确率始终高于 Super-SST。然而,Super-SST 相对于其基线通常能带来更大的相对提升。例如,使用 1% ImageNet-1K 标注数据和 ViT-Small,Super-SST / Semi-SST 达到了 70.4% / 71.4% 的 Top-1 准确率,而相对于监督 / 半监督基线的相对提升分别为 10.1% / 3.4%。

总之,表3表明 Super-SST 和 Semi-SST 在各种数据集和架构上提供了显著的性能改进,尤其在低数据场景下表现出色,并且能很好地随模型容量扩展。虽然 Semi-SST 的 Top-1 准确率通常高于 Super-SST,但 Super-SST 相对于其基线通常能带来更大的提升。我们的方法是有效、可扩展且广泛适用的,这使得它们对于标注数据有限的实际应用非常有价值。

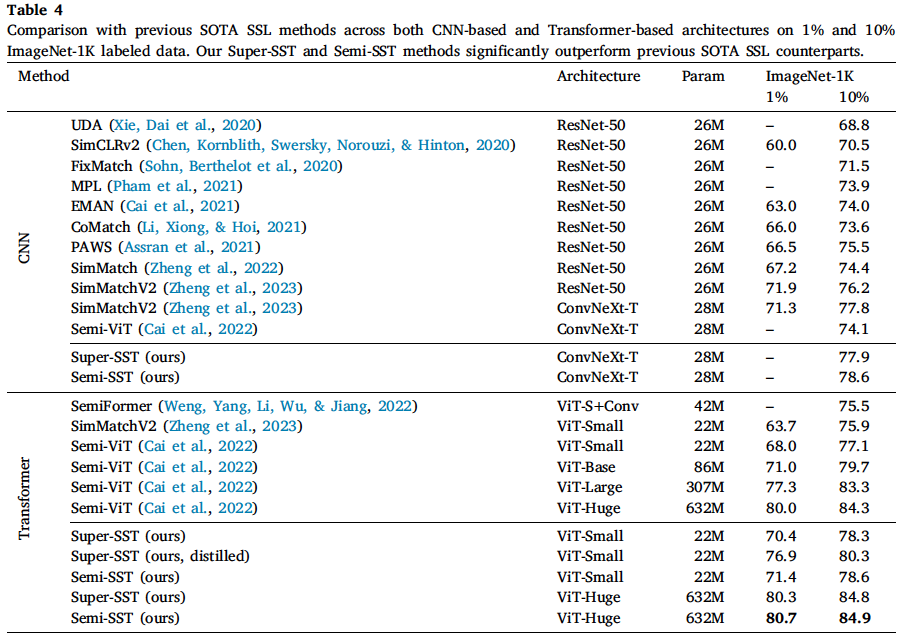

表4展示了我们的方法与先前的 SOTA SSL 方法之间的全面比较,包括 UDA \citep{xie2020unsupervised}、SimCLRv2 \citep{chen2020big}、FixMatch \citep{sohn2020fixmatch}、MPL \citep{pham2021meta}、EMAN \citep{cai2021exponential}、CoMatch \citep{li2021comatch}、PAWS \citep{assran2021semi}、SimMatch \citep{zheng2022simmatch}、SimMatchV2 \citep{zheng2023simmatchv2} 和 Semi-ViT \citep{cai2022semi},重点关注它们在 1% 和 10% ImageNet-1K 标注数据上的性能。我们的方法在基于 CNN 和基于 Transformer 的架构上都进行了评估。遵循 Semi-ViT 的做法,我们使用了最近提出的 ConvNeXt 而不是传统的 ResNet。

\textbf{优越性与鲁棒性}. 对于基于 CNN 的模型,Super-SST 和 Semi-SST 在 10% ImageNet-1K 标注数据上使用 ConvNeXt-T 分别达到了 77.9% 和 78.6% 的 Top-1 准确率,超过了所有先前的同类方法。对于基于 Transformer 的模型,Super-SST / Semi-SST 在 1% 标注数据上使用 ViT-Small 达到了 70.4% / 71.4% 的 Top-1 准确率,在 10% 标注数据上达到了 78.3% / 78.6%,显著优于先前的同类方法。Super-SST 和 Semi-SST 在基于 CNN 和基于 Transformer 的架构上都持续优于同类方法,突显了我们方法的优越性和鲁棒性。

\textbf{可扩展性与数据效率}. 可扩展和数据高效的算法对半监督学习至关重要。如表4所示,Super-SST 和 Semi-SST 都可以轻松扩展到像 ViT-Huge 这样更大的架构。值得注意的是,Semi-SST-ViT-Huge 在 1% / 10% 标注数据上取得了最佳的 80.7% / 84.9% Top-1 准确率,在竞争激烈的 ImageNet-1K SSL 基准测试(无外部数据)上创造了新的 SOTA 性能。此外,像 ViT-Huge 这样更大的架构通常比较小的架构能达到更高的准确率,表明更大的架构是强大的数据高效学习者。这一趋势在 1% 和 10% 标注数据的场景中都是一致的,强调了更大模型在利用稀缺标注数据方面的潜力。

\textbf{知识蒸馏}. 我们已经表明,像 ViT-Huge 这样的大型架构通常比小型架构具有更高的准确率,尤其是在低数据场景下。然而,具有高容量的大型模型在部署期间需要大量的计算资源,这使得它们在实际应用中不切实际且不经济。相反,小型模型更容易部署,但性能往往不如大型模型。这就提出了一个重要问题:在低数据场景下,我们如何训练一个适合实际部署的小型、高性能模型?为了解决这个问题,我们进行了从大到小(huge-to-small)的知识蒸馏 \citep{hinton2015distilling, mirzadeh2020improved, chen2021cross, passalis2018learning, park2019relational, zhu2021complementary, yang2022mixskd} 实验。首先,我们使用 Super-SST 在 1% / 10% 的原始标注数据上训练一个教师模型(即 ViT-Huge),达到了 80.3% / 84.8% 的 Top-1 准确率。然后,我们使用训练好的教师模型和 SAT 技术来获取筛选后的伪标签数据。最后,我们将知识从教师模型蒸馏到学生模型(即 ViT-Small)。学生模型在少量原始标注数据和筛选后的伪标签数据的组合上进行监督训练,在 1% 和 10% 的低数据场景下分别达到了 76.9% 和 80.3% 的 Top-1 准确率。这相对于 Super-SST-ViT-Small 分别代表了 6.5% 和 2.0% 的显著相对提升。因此,我们成功地开发了一个紧凑、轻量级且高性能的模型,非常适合实际部署。

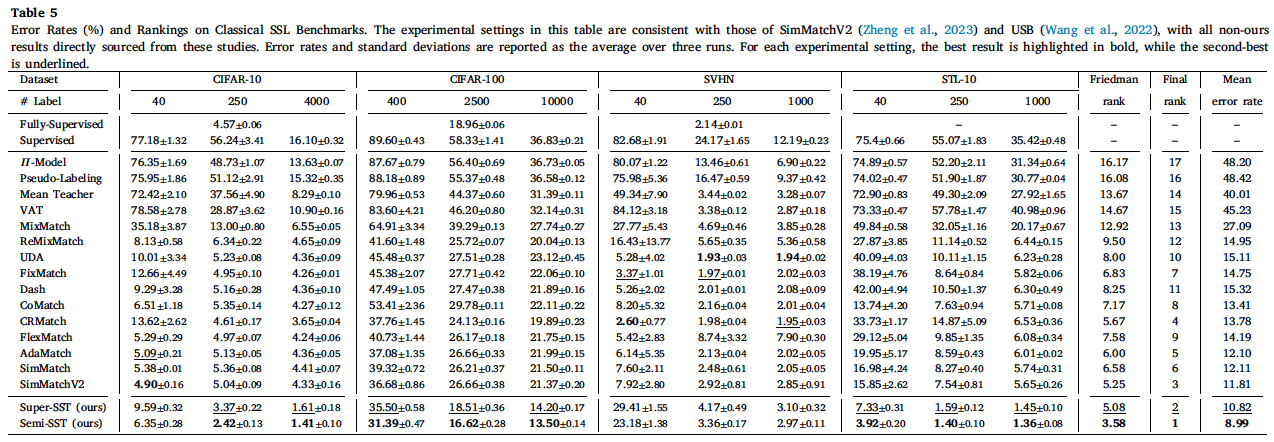

表5中呈现的结果清晰地突显了 Semi-SST 和 Super-SST 在多个基准测试中相较于现有 SSL 方法的优越性能。值得注意的是,Semi-SST 取得了 8.99% 的最低平均错误率,总体排名第一,而 Super-SST 紧随其后,平均错误率为 10.82%,位居第二。值得注意的是,尽管 SVHN 数据集有 531,131 张额外的训练图像,STL-10 数据集有 100,000 张未标注图像,我们的方法在没有利用这些额外资源的情况下仍然取得了具有竞争力的性能,这突显了其数据高效的学习能力。为了进一步评估我们结果的统计显著性,我们进行了弗里德曼检验(Friedman test),得到的 p 值为 $3.11\times10^{-25}$,表明所评估的方法之间存在统计学上的显著差异。Semi-SST 和 Super-SST 的弗里德曼排名分别为第 1 和第 2,表明它们在多个基准测试中具有一致的优势。这些结果为我们方法的有效性提供了强有力的统计支持,同时降低了观察到的改进是由随机变异引起可能性。尽管 Semi-SST 和 Super-SST 展现出强大的整体性能,但它们在仅有 40 个标注样本的 SVHN 数据集上表现出相对较高的错误率。这表明我们的方法,与其他 SSL 技术一样,可能在标注数据极其有限的场景下面临挑战。未来的工作可以探索增强措施,以进一步改善在这种极端情况下的性能。为确保与本文实验配置的一致性,我们使用了来自 DINO 的自监督预训练 ViT-Small,这与先前工作(如 SimMatchV2 \citep{zheng2023simmatchv2} 和 USB \citep{wang2022usb})中使用的架构不同。虽然这种设置可能导致比较不那么直接,但它为研究社区贡献了有价值的数据点,提供了关于基于 Transformer 的架构在 SSL 中性能的见解。

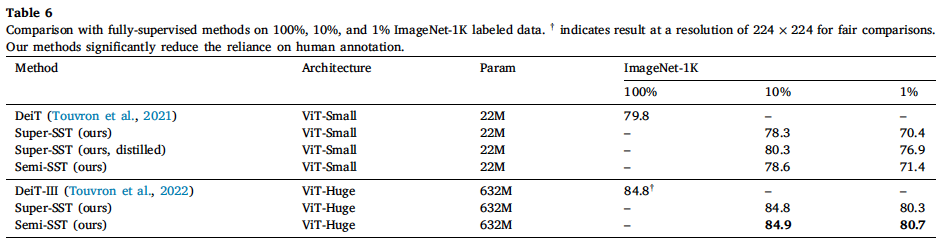

表6将我们的 SST 方法与全监督方法(如 DeiT \citep{touvron2021training} 和 DeiT-III \citep{touvron2022deit})在 ImageNet-1K 上进行了比较。如图所示,全监督的 DeiT-III-ViT-Huge 模型使用 100% 的标注数据达到了 84.8% 的 Top-1 准确率。相比之下,即使标注数据显著减少,我们的方法表现也异常出色。例如,仅使用 10% 的标注数据和 ViT-Huge,Super-SST 和 Semi-SST 分别达到了相同(84.8%)和更高(84.9%)的 Top-1 准确率,这意味着人力标注成本降低了十倍,并突显了我们方法在利用未标注数据方面的有效性。这表明我们的方法在获取标注数据具有挑战性或成本高昂的应用中可以非常有效,从而显著缩小了半监督方法与全监督方法之间的性能差距。此外,使用从大到小的蒸馏技术,Super-SST-ViT-Small 在 10% 标注数据上达到了令人印象深刻的 80.3% Top-1 准确率,超过了全监督 DeiT-ViT-Small 在 100% 标注数据上 79.8% 的 Top-1 准确率。

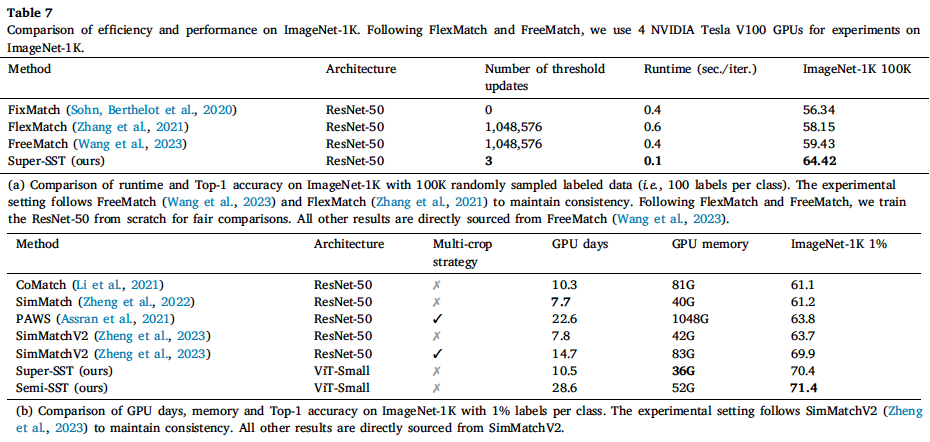

表7展示了我们的方法与其他 SSL 模型在 ImageNet-1K 上的效率和性能比较,重点关注阈值更新、运行时间、GPU 利用率和 Top-1 准确率。

\textbf{阈值更新与运行时间的比较}. 表7提供了 FixMatch、FlexMatch、FreeMatch 和 Super-SST 之间效率和性能的详细比较。请注意,自监督预训练在我们的方法中是可选的。为了公平比较,我们遵循与 FlexMatch 和 FreeMatch 相同的协议,在 10 万 ImageNet-1K 标注数据(即每类 100 个标签)上从头开始训练 ResNet-50。如图所示,FixMatch 使用预定义的恒定阈值,导致零次阈值更新。FlexMatch 和 FreeMatch 都在每次迭代时更新类别特定的阈值,导致超过 1,000,000 次更新,使其计算密集且成本高昂。Super-SST 训练 ResNet-50 共 3 个周期,并且仅在每个训练周期更新一次类别特定阈值,最终仅需 3 次更新。更新次数上的巨大差异使得 Super-SST 在时间和计算成本方面效率高得多。此外,Super-SST 使用训练良好、性能高的模型更新阈值,减少了错误的预测和确认偏差。相比之下,FreeMatch 和 FlexMatch 使用仍在训练中的模型更新阈值,导致在早期阶段产生更多不准确的预测并放大确认偏差,最终导致性能较差。Super-SST 实现了每次迭代 0.1 秒的最快运行时间,而 FixMatch 和 FreeMatch 为 0.4 秒,FlexMatch 为 0.6 秒。这使得 Super-SST 在所比较的方法中成为运行时间更快、阈值更新次数最少的最高效方法。此外,Super-SST 不仅在效率上表现出色,还达到了 64.42% 的最高 Top-1 准确率,显著地大幅超越了所有同类方法。

\textbf{GPU 天数与显存的比较}. 表7比较了 CoMatch、SimMatch、PAWS、SimMatchV2、Super-SST 和 Semi-SST 在 1% ImageNet-1K 标注数据上的 GPU 天数、GPU 显存和 Top-1 准确率。如图所示,PAWS 和 SimMatchV2 使用了多裁剪(multi-crop)策略,处理每个图像的多个裁剪版本,从而带来更好的模型性能,但计算需求显著增加且训练时间更长。例如,包含多裁剪时,SimMatchV2 的训练时间几乎翻倍(从 7.8 天增加到 14.7 天),而不包含多裁剪时,其 Top-1 准确率显著下降了 6.2%。Super-SST 因其在效率和性能之间的出色平衡而脱颖而出,以最低的 GPU 显存使用量和相对适中的 GPU 天数实现了第二高的 Top-1 准确率(70.4%),使其非常适用于准确性和效率都至关重要的实际应用。Semi-SST 以高 GPU 天数和中等 GPU 显存使用量为代价,达到了最高的准确率(71.4%),使其适用于需要最大准确率且计算资源约束较少的场景。我们的方法在准确性上优于其他方法,同时保持了合理的资源使用,标志着 SSL 领域的显著进步。

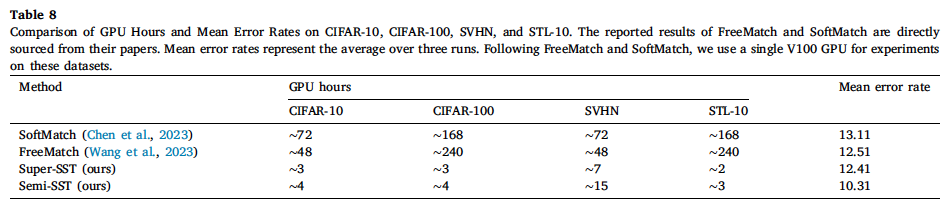

\textbf{GPU 小时的比较}. 表8提供了 FreeMatch、SoftMatch、Super-SST 和 Semi-SST 在多个基准数据集(包括 CIFAR-10、CIFAR-100、SVHN 和 STL-10)上的计算效率和平均错误率的全面比较。在计算平均错误率时,我们复用了表5中的实验结果。需要注意的是,与我们的研究以及 SimMatchV2 和 USB 相比,FreeMatch 和 SoftMatch 采用了一套略有不同的基准配置。具体来说,FreeMatch 报告了 CIFAR-10(10 个标签)的结果,但没有提供 STL-10(250 个标签)的结果。同时,SoftMatch 没有报告 SVHN 和 STL-10(250 个标签)的结果。为了与 USB 和 SimMatchV2 保持一致,我们的研究排除了 CIFAR-10(10 个标签),但包含了 SVHN 和 STL-10(250 个标签)。为确保公平一致的比较,我们考虑了这些基准配置的交集,最终包含了 10 种设置:CIFAR-10(含 40、250 和 4000 个标签)、CIFAR-100(含 400、2500 和 10000 个标签)、SVHN(含 40 和 1000 个标签)以及 STL-10(含 40 和 1000 个标签)。如表 8所示,Super-SST 和 Semi-SST 在保持优越性能的同时显著降低了计算成本。在 CIFAR-100 上,FreeMatch 需要大约 240 GPU 小时,而 Super-SST 和 Semi-SST 分别以约 3 和 4 GPU 小时取得了更好的性能,速度分别提升了 80 倍和 60 倍。类似地,在 STL-10 上,FreeMatch 消耗约 240 GPU 小时,而 Super-SST 和 Semi-SST 分别需要约 2 和 3 GPU 小时,将计算成本降低了 120 倍和 80 倍。在 CIFAR-10 和 SVHN 上也观察到了类似的趋势,Super-SST 和 Semi-SST 所需的 GPU 小时始终比 FreeMatch 和 SoftMatch 少一个数量级。除了效率之外,Semi-SST 取得了最佳的整体性能,平均错误率达到 10.31,低于 SoftMatch(13.11)、FreeMatch(12.51)和 Super-SST(12.41)。值得注意的是,这种改进是在 GPU 小时数大幅减少的情况下实现的,进一步证明了我们的方法在减轻确认偏差的同时保持轻量级计算足迹的有效性。结果突显了我们提出的 SST 方法的效率和有效性。通过显著减少训练时间同时保持或超越最先进的性能,我们的方法为现有的半监督学习方法提供了一个引人注目的替代方案。这些发现强调了 SST 作为一种极具成本效益的解决方案在大规模 SSL 应用中的潜力,尤其是在计算资源受限的场景中。请注意,我们使用了 ViT-Small 架构,而 FreeMatch 和 SoftMatch 采用了 Wide ResNet (WRN) 架构 \citep{zagoruyko2016wide},这可能导致比较不那么直接。

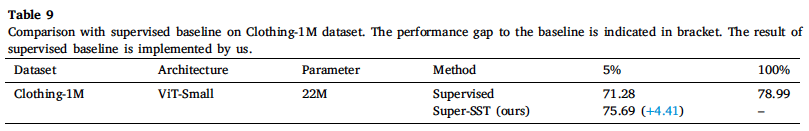

Clothing-1M \citep{xiao2015learning} 是一个大规模数据集,包含约 100 万张从在线购物网站收集的服装图像。该数据集同时表现出严重的类别不平衡和标签噪声,使其成为对鲁棒学习算法特别具有挑战性的基准。类别分布高度倾斜,一些常见的服装类别(如 T 恤、夹克)数量过多,而其他类别(如泳衣、围巾)的样本则少得多。这种不平衡性,加上带噪声的标注,增加了模型训练的难度,因为标准学习方法可能会偏向高频类别,并且难以泛化到代表性不足的类别。我们从干净标注的训练图像中随机抽取 5% 的样本,剩余图像与 100 万带噪声样本合并作为未标注数据。如表9所示,Super-SST 仅使用 5% 的 Clothing-1M 干净标注数据就达到了 75.69% 的 top-1 准确率,比监督基线高出 4.41%,并表现出对类别不平衡和标签噪声的强大鲁棒性。值得注意的是,尽管依赖的标注样本少得多,这一性能已接近 78.99% 的全监督上限,进一步突显了其在现实世界不平衡场景中的有效性。

类似地,iNaturalist \citep{inaturalist-2019-fgvc6} 是一个大规模、真实世界的数据集,表现出极端的类别不平衡,因为每个类别的图像数量遵循长尾分布。少数几个主要物种拥有数千张图像,而许多稀有物种仅由少量样本代表。这种高度倾斜的分布给学习算法带来了巨大挑战,因为在 iNaturalist 上训练的模型往往偏向多数类别,难以泛化到代表性不足的物种。因此,iNaturalist 是评估旨在解决长尾识别、类别平衡学习和数据重加权策略的技术的关键基准。如表3所示,我们的方法在极端类别不平衡条件下取得了显著改进。在 1% / 10% 的标注 iNaturalist 数据和 ViT-Base 架构下,Super-SST 比监督基线高出 3.0% / 7.8%,而 Semi-SST 相对于半监督基线实现了 1.1% / 0.4% 的相对提升。这些结果表明,我们的方法有效减轻了类别不平衡的影响,并在高度倾斜的分布下增强了模型泛化能力,进一步巩固了其在现实世界长尾学习挑战中的适用性。

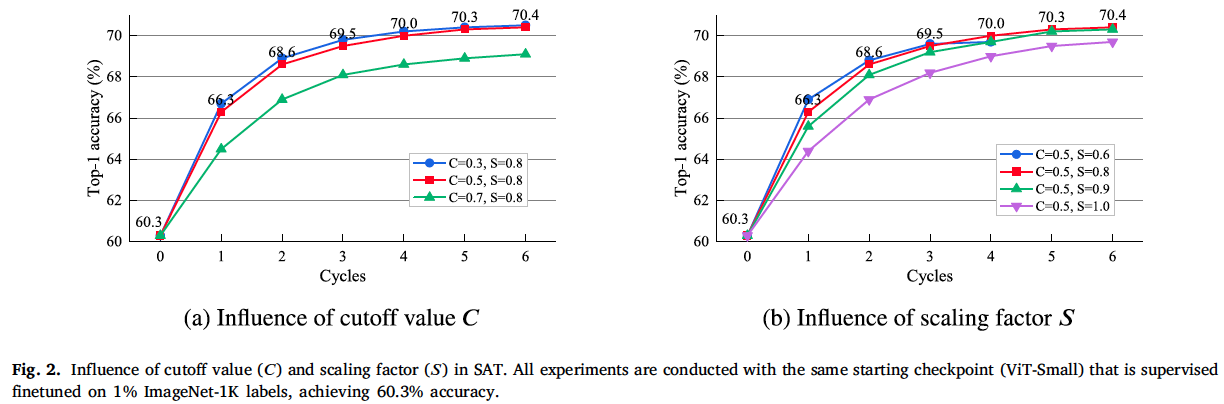

图2探讨了不同截断值 $C$ 和缩放因子 $S$ 对多个训练周期内 Top-1 准确率的影响。每个子图关注一个特定变量,同时保持另一个变量不变,以观察它们的个体效应对性能的影响。所有实验均使用相同的起始检查点(即 ViT-Small)进行,该检查点在 1% ImageNet-1K 标注数据上进行了监督微调,达到了 60.3% 的 Top-1 准确率。如图2所示,较低的截断值(C=0.3 和 0.5)导致更快、更高的准确率提升。较高的截断值(C=0.7)性能不如较低的截断值,表明高截断值可能会阻碍模型性能。如图2所示,较低的缩放因子(S=0.6)导致准确率提升更快,但很快稳定在较低水平,表明在多个训练周期内改进不足。较高的缩放因子(S=1.0)导致改进较慢且峰值准确率较低。中等的缩放因子(S=0.8 和 0.9)提供了更好的性能。基于这些观察,我们在 ImageNet-1K 上为 ViT-Small 设置 $C$ 为 0.5, $S$ 为 0.8;为 ViT-Huge 设置 $S$ 为 0.9。

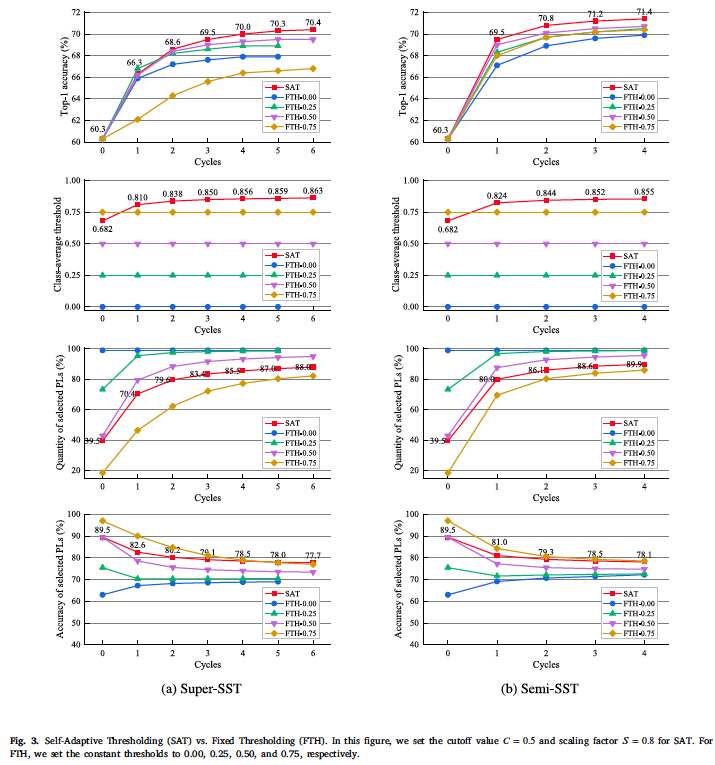

图3展示了自适应阈值(SAT)与各种固定阈值(FTH)设置在 Super-SST 和 Semi-SST 中的全面比较。分析的指标包括 Top-1 准确率、类别平均阈值、以及多个训练周期内筛选出的伪标签(PLs)的数量和准确率。所有实验均使用相同的起始检查点(即 ViT-Small)进行,该检查点在 1% ImageNet-1K 标注数据上进行了监督微调,达到了 60.3% 的 Top-1 准确率。

\textbf{Top-1 准确率}. 在 Super-SST / Semi-SST 中,SAT 以 60.3% 的 Top-1 准确率开始,在第 1 周期迅速增加到 66.3% / 69.5%,到第 6 / 4 周期达到峰值 70.4% / 71.4%。虽然 FTH 设置表现出类似的上升趋势,但它们的最终性能低于 SAT。

\textbf{类别平均阈值}. 在 Super-SST 和 Semi-SST 中,SAT 的类别平均阈值从 0.682 开始,分别逐渐增加到 0.863 和 0.855。由于 FTH 方法的固定性质,它们保持恒定的阈值(即 0.00、0.25、0.50 和 0.75),在各个周期中没有变化。SAT 的动态特性使其能够根据模型的性能准确且自适应地调整类别特定阈值,与静态的 FTH 方法相比,提供了更鲁棒和响应更灵敏的学习过程。

\textbf{筛选出的 PLs 的数量和准确率}. 筛选出的 PLs 的高质量和足够数量之间的平衡至关重要。在 Super-SST / Semi-SST 中,SAT 开始时筛选出 39.5% 的 PLs,并逐渐增加到 88.0% / 89.9%。此外,筛选出的 PLs 的准确率从 89.5% 开始,逐渐下降到 77.7% / 78.1%,这可能是由于引入了更多噪声标签。我们的 SAT 机制因其在高质量和足够数量的筛选 PLs 之间的出色平衡而脱颖而出。与 SAT 相比,FTH 方法难以平衡筛选 PLs 的高质量和足够数量。例如,FTH-0.00 不加区分地使用所有 PLs,导致 PLs 的准确率最低。FTH-0.75 保持与 SAT 相似的 PLs 准确率,但通常筛选出的 PLs 比 SAT 少。

总之,图3突显了 SAT 在 Super-SST 和 Semi-SST 框架中相对于 FTH 方法的明显优越性。SAT 的动态阈值机制能够持续提高 top-1 准确率,并有效平衡筛选 PLs 的高质量和足够数量,使其成为 SSL 任务的更优选择。FTH 方法的静态特性意味着它们无法响应训练动态的变化,导致 PLs 选择要么过于保守,要么过于宽松,从而限制了模型性能的提升。

5.相关工作

我们的工作与利用阈值技术的 SSL 方法密切相关。诸如 Semi-ViT \citep{cai2022semi}、Noisy Student \citep{xie2020self}、UDA \citep{xie2020unsupervised} 和 FixMatch \citep{sohn2020fixmatch} 等方法依赖于固定的阈值策略来选择预测置信度得分高于预定义常数的未标注样本。Dash \citep{xu2021dash} 采用逐渐增加的阈值,以便在早期训练阶段纳入更多未标注数据。Adsh \citep{guo2022class} 通过优化每个类别的伪标签数量来推导用于不平衡 SSL 的自适应阈值。AdaMatch \citep{berthelot2021adamatch} 使用基于标注数据置信度的 EMA 自适应估计的相对阈值。FlexMatch \citep{zhang2021flexmatch} 使用一个较高的常数作为数据集特定的全局阈值,并根据预测到每个类别的有置信度的未标注样本数量进行调整。FreeMatch \citep{wang2023freematch} 通过未标注数据置信度的 EMA 来估计数据集特定的全局阈值,并根据每个类别预测的 EMA 期望值进一步调整它。SoftMatch \citep{chen2023softmatch} 引入了一种新颖的半监督学习方法,通过解决伪标签中的数量-质量权衡问题,平衡了大量低置信度样本和高置信度样本的使用。通过结合软阈值机制,SoftMatch 有效地提高了标签效率并增强了模型在各种 SSL 基准上的性能。USB \citep{wang2022usb} 是一个统一且具有挑战性的 SSL 基准,包含计算机视觉、自然语言处理和音频领域的 15 个任务,用于公平一致的评估。USB 提供了多种 SSL 算法的实现,包括 FixMatch、FlexMatch、SimMatch、SoftMatch 和 FreeMatch。

我们的 SAT 机制在三个主要方面区别于现有的动态阈值技术:生成机制、阈值更新次数和性能改进。SAT 是一种基于置信度的方法,首先使用截断值 $C$ 来丢弃每个类别中较低且不可靠的概率。然后,它计算每个类别剩余的较高且可靠概率的平均值,并将其乘以缩放因子 $S$ 以获得类别特定的阈值。与 FlexMatch 不同,我们的 SAT 不依赖于预测到每个类别的未标注样本数量,也不使用数据集特定的全局阈值。与 FreeMatch 不同,SAT 采用了 FreeMatch 所缺乏的截断机制。此外,SAT 不像 FreeMatch 那样使用 EMA 和全局阈值。SAT 与 FlexMatch 或 FreeMatch 最显著的区别在于阈值更新的次数。FlexMatch 和 FreeMatch 在每次迭代时都使用仍在训练中的模型更新阈值,导致超过 1,000,000 次更新。这带来了极高的计算和时间成本,并且倾向于在训练早期放大确认偏差,从而导致较差的模型性能。相比之下,SAT 在每个训练周期使用训练良好、性能高的模型更新一次阈值,导致更新次数为个位数,计算和时间成本可以忽略不计。详细的理论分析和广泛的实验结果有力地证实了 SAT 的创新性、独特性和优越性。这些优势使得 SST 能够在性能和效率上显著超越先前的同类方法,使其成为 SSL 领域的一个里程碑。

自训练(Self-training)和伪标签(Pseudo-labeling)是 SSL 中密切相关的方法,通常一起使用。自训练是一个综合框架,它迭代地使用伪标签以及其他策略来提升模型性能。伪标签是一种特定技术,它为未标注数据生成伪标签,使其成为自训练框架不可或缺的一部分。自训练和伪标签的原理起源于早期的研究 \citep{scudder1965probability, mclachlan1975iterative, yarowsky1995unsupervised, riloff1996automatically, riloff2003learning, lee2013pseudo},并在近期的 SSL 研究中得以复兴。Pseudo-Labeling \citep{lee2013pseudo} 利用从模型预测中导出的硬伪标签来指导未标注数据上的自训练过程。Noisy Student \citep{xie2020self} 将自训练与噪声注入相结合以提升模型性能。CBST \citep{zou2018unsupervised} 通过生成具有平衡类别分布的伪标签来解决语义分割中的类别不平衡挑战。CReST \citep{wei2021crest} 使用类别再平衡技术,根据特定类别的采样率调整每个类别的伪标签样本数量。Debiased Self-Training \citep{chen2022debiased} 旨在通过使用独立的头来生成和利用伪标签,以减轻自训练中的训练偏差。ST++ \citep{yang2022st++} 通过以课程学习 \citep{bengio2009curriculum} 的方式利用逐步精炼的伪标签,扩展了传统的自训练方法。UDA \citep{xie2020unsupervised} 通过锐化模型预测而不是将其转换为硬伪标签来增强 SSL 模型。FixMatch \citep{sohn2020fixmatch} 将弱增强预测转换为用于强增强数据的硬伪标签。Label Propagation \citep{iscen2019label} 采用直推式方法,预测整个数据集以生成伪标签。SimMatch \citep{zheng2022simmatch} 利用带标签的内存缓冲区来传播语义和实例伪标签。

我们的 SST 方法通过几项关键创新从传统的自训练和伪标签方法中脱颖而出。主要的区别在于自训练与我们创新的 SAT 机制的结合,该机制根据模型的学习进度准确且自适应地调整类别特定的阈值。该机制确保了筛选出的伪标签的高质量和足够数量,减少了不准确性和确认偏差的风险,从而提升了整体模型性能。此外,SST 框架展现出显著的灵活性,因为它不仅可以与监督算法集成,还可以与诸如 EMA-Teacher \citep{cai2021exponential, cai2022semi} 等半监督算法集成。这种灵活性也使其区别于传统的自训练方法。

6.局限性

尽管 Semi-SST 和 Super-SST 展现出强大的整体性能,但在标注数据极其有限的场景下(例如,仅有 40 个标注样本的 SVHN),它们表现出相对较高的错误率。这表明我们的方法可能在超低标签场景下面临挑战。这一局限性与 SSL 中更广泛的挑战一致,即极端的标签稀缺性放大了对伪标签噪声和模型初始化的敏感性。未来的工作可以探索缓解此问题的策略。此外,我们的方法是专门为计算机视觉任务设计的,目前尚未配置用于自然语言处理(NLP)基准测试。虽然对文本数据的实验很有意义,但将我们的框架应用于 NLP 任务需要进行重大的架构修改。未来的研究可以探索将我们的方法推广到更广泛模态的方法,包括 NLP 和多模态学习。另外,虽然我们在 Clothing-1M \citep{xiao2015learning} 数据集上进行了实验并提供了相应结果,但我们对噪声数据、类别不平衡和域迁移场景的研究仍然有限。由于计算资源的限制,我们对这些挑战的分析不够全面。这项工作的未来迭代将旨在系统地探索这些挑战,从而在更现实和多样化的条件下提供对 SSL 性能更深入的见解。

7.结论

在本文中,我们引入了一个创新的使用自适应阈值的自训练(SST)框架,及其两种变体:Super-SST 和 Semi-SST,显著推动了 SSL 领域的发展。我们框架的核心创新是自适应阈值(SAT)机制,它根据模型的学习进度准确且自适应地调整类别特定的阈值。SAT 机制确保了筛选出的伪标签数据的高质量和足够数量,减轻了不准确伪标签和确认偏差的风险,从而提升了整体模型性能。大量的实验和结果有力地证实了 SST 框架在各种架构和数据集上的有效性、效率、泛化能力和可扩展性。值得注意的是,Semi-SST-ViT-Huge 在竞争激烈的 ImageNet-1K SSL 基准测试上取得了最佳结果,仅使用 1% / 10% 的标注数据就达到了 80.7% / 84.9% 的 Top-1 准确率。相比之下,使用 100% 标注数据的全监督 DeiT-III-ViT-Huge 实现了 84.8% 的 Top-1 准确率,我们的方法仅用 10% 的标注数据就展现出更优的性能。这表明人力标注成本降低了十倍,显著缩小了半监督学习与全监督学习之间的差距。此外,SST 在各种架构和数据集上实现了 SOTA 性能,同时展现出卓越的效率,带来了极高的性价比。这些进展为 SSL 的进一步创新以及在获取标注数据困难或昂贵的实际应用奠定了基础。在未来的研究中,我们打算将我们的方法扩展到更实际的应用中,并增强我们的阈值技术和模型优化策略。我们期望这项工作能够激励未来的研究,并为更广泛的社区贡献有价值的见解。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?