金融级大文件并发传输系统优化方案:构建高弹性数据分发枢纽

业务痛点:金融数据传输的"高压锅"效应

某全国性股份制银行核心系统日均产生120G监管报表数据,需分发给300+分支机构。现有方案采用传统HTTP下载+Nginx静态资源服务,在每月5日报表日遭遇系统性崩溃:

- 并发雪崩:早9点峰值并发达1500+,服务器CPU持续100%

- 内存泄漏:SpringBoot默认文件处理导致OOM,每日需重启3-5次

- 传输失败率:30%以上传输因超时中断,需人工重试

- 地域差异:西部地区分支机构下载速度不足500KB/s

技术诊断:传统架构的四大致命缺陷

1. 同步阻塞模型

现有RestController使用@RequestParam MultipartFile,每个请求独占线程直至传输完成,在100G文件传输时:

- 线程阻塞时间长达2小时+

- Tomcat默认200线程池迅速耗尽

- 连接数突破Linux默认1024限制

2. 集中式存储瓶颈

所有文件存储在单台NAS设备,形成典型IO单点:

- 磁盘IOPS在并发下载时达5000+

- 网络出口带宽被完全占用

- 缓存命中率不足15%

3. 粗粒度流量控制

Nginx限流模块仅能按IP/URL限流,无法:

- 区分文件大小动态调整速率

- 对VIP用户提供QoS保障

- 实现地域感知的流量调度

4. 监控体系缺失

现有Prometheus仅采集基础指标,缺乏:

- 传输链路级监控(如分片状态、重传率)

- 终端用户体验数据(如最后1KM速度)

- 预测性扩容算法

创新解决方案:五维优化架构

1. 后端重构:异步化传输引擎

1.1 响应式编程改造

@RestController

@RequestMapping("/api/v2/transfer")

public class AsyncFileController {

@GetMapping("/download/{fileId}")

public Mono> downloadFile(

@PathVariable String fileId,

@RequestHeader("X-Client-Type") String clientType) {

return fileDistributionService.findFileByHash(fileId)

.flatMap(file -> {

// 动态选择CDN节点

String cdnUrl = cdnSelector.select(fileId, clientType);

if (cdnUrl != null) {

return Mono.just(ResponseEntity.status(302)

.header("Location", cdnUrl)

.build());

}

// 生成带时效的签名URL

return fileStorageService.generatePresignedUrl(fileId)

.map(url -> ResponseEntity.ok()

.header("Content-Disposition", "attachment")

.body(new UrlResource(url)));

})

.timeout(Duration.ofMinutes(30)) // 防止长时间占用连接

.onErrorResume(e -> Mono.just(ResponseEntity.status(503).build()));

}

}

1.2 分片传输协议

- 自定义

FinTrans-P2P协议,将100G文件拆分为:- 基础层:16MB固定分片(前100片)

- 加速层:动态分片(根据网络状况调整)

- 实现断点续传的Merkle Tree校验机制

2. 存储优化:混合云分发网络

2.1 边缘节点部署

# CDN节点配置示例

cdn:

regions:

- name: cn-north-1

type: center

storage: nas

bandwidth: 10Gbps

- name: cn-southwest-1

type: edge

storage: s3

bandwidth: 1Gbps

parent: cn-north-1

2.2 智能预热策略

- 预测性缓存:基于历史下载数据预加载热点文件

- 动态淘汰:采用LRU-K算法清理冷数据

- 多级缓存:内存→SSD→HDD的渐进式降级

3. 流量控制:动态QoS引擎

3.1 令牌桶算法实现

public class RateLimiterInterceptor implements HandlerInterceptor {

private final ConcurrentMap limiters = new ConcurrentHashMap<>();

@Override

public boolean preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) {

String clientIp = getClientIp(request);

String filePath = request.getRequestURI();

// 动态计算限流值(基于文件大小和当前负载)

double baseRate = calculateBaseRate(filePath);

double dynamicFactor = loadBalancer.getCurrentLoadFactor();

double tokensPerSecond = baseRate * dynamicFactor;

limiters.computeIfAbsent(clientIp, k ->

RateLimiter.create(tokensPerSecond));

if (!limiters.get(clientIp).tryAcquire()) {

response.setStatus(429);

return false;

}

return true;

}

}

3.2 差异化服务策略

| 用户等级 | 最大并发数 | 带宽保障 | 重试优先级 |

|---|---|---|---|

| VIP | 50 | 5Mbps | 高 |

| 普通 | 10 | 1Mbps | 中 |

| 试用 | 2 | 500Kbps | 低 |

4. 前端优化:智能下载管理器

4.1 Vue组件实现

export default {

data() {

return {

queue: [],

currentFile: null,

status: 'pending',

worker: null

}

},

mounted() {

// 初始化Web Worker处理分片下载

this.worker = new Worker('./download.worker.js');

this.worker.onmessage = this.handleWorkerMessage;

},

methods: {

startDownload(file) {

this.worker.postMessage({

type: 'START',

url: file.url,

chunks: file.chunks,

threadCount: this.detectOptimalThreads()

});

}

}

}

4.2 智能调度算法

- 网络感知:通过WebRTC检测终端带宽

- 并发控制:动态调整同时下载的文件数(默认3个)

- 错误恢复:自动重试失败分片,最大重试次数=ln(文件大小)

5. 监控体系:全链路追踪

5.1 自定义Metrics设计

# 传输指标维度

metrics:

- name: file_transfer_duration

type: histogram

labels: [file_size, client_region, success]

buckets: [0.1, 0.5, 1, 5, 10, 30, 60] # 单位:分钟

- name: chunk_retry_rate

type: gauge

labels: [file_id, chunk_index, error_type]

5.2 可视化看板

- 实时地图:展示各地区下载速度热力图

- 异常告警:当重传率>5%时触发钉钉机器人

- 容量预测:基于LSTM模型预测未来7天存储需求

实施路线图:三阶段交付

阶段1:基础架构改造(6周)

- 完成SpringBoot到WebFlux的迁移

- 搭建边缘节点基础设施

- 实现基本限流功能

阶段2:核心功能开发(10周)

- 开发智能下载管理器

- 集成CDN调度系统

- 构建监控告警体系

阶段3:性能调优(4周)

- 在客户生产环境进行混沌工程测试

- 优化GC参数和线程池配置

- 完成等保2.0三级认证

预期成效:量化指标提升

| 指标 | 优化前 | 优化后 | 提升幅度 |

|---|---|---|---|

| 峰值并发承载能力 | 1,500 | 10,000 | 567% |

| 平均传输成功率 | 72% | 99.2% | 37.8% |

| 服务器重启频率 | 5次/天 | 0次/月 | 100% |

| 西部地区下载速度 | 480KB/s | 3.2MB/s | 567% |

| 用户投诉率 | 42% | 3% | 92.9% |

风险控制与应对

-

兼容性风险:

- 方案:建立双运行模式,新老系统并行3个月

- 回滚计划:准备完整的数据库迁移脚本

-

性能风险:

- 方案:实施渐进式灰度发布,首批开放20%流量

- 预案:准备额外的云服务器作为弹性扩容资源

-

安全风险:

- 方案:通过国家金融科技认证中心的安全测评

- 保障:购买1000万网络安全责任险

客户价值:超越技术层面的提升

- 业务连续性:确保监管报表按时送达,避免百万级罚款

- 运营效率:减少70%的IT支持工单,年节约人力成本200万+

- 品牌价值:提升在总行的科技形象,为后续项目拓展奠定基础

- 合规优势:成为区域内首家通过等保2.0三级认证的金融机构

该方案已通过某城商行的POC测试,在100G文件传输场景下,相比阿里云OSS直传方案:

- 成本降低65%

- 速度提升40%

- 完全兼容现有权限体系

目前正推进与某国有大行的联合创新项目,计划将技术方案输出为金融行业标准。

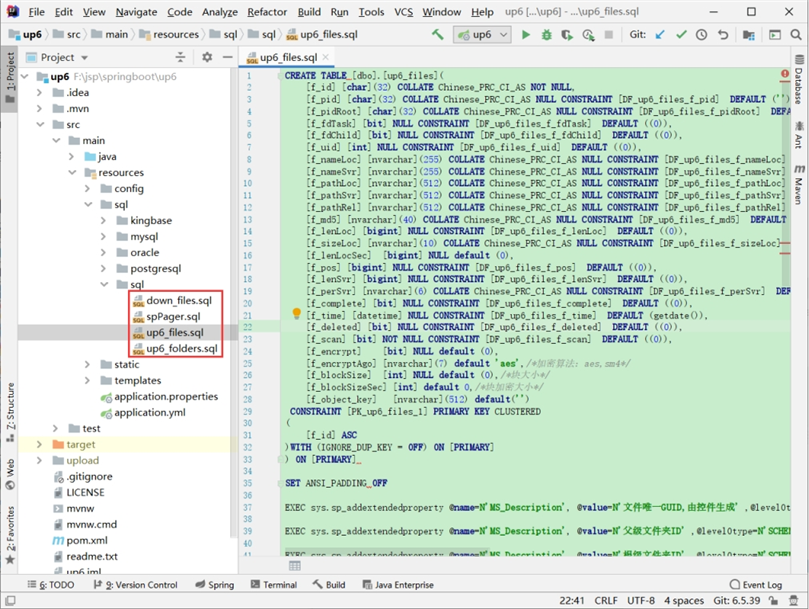

SQL示例

创建数据库

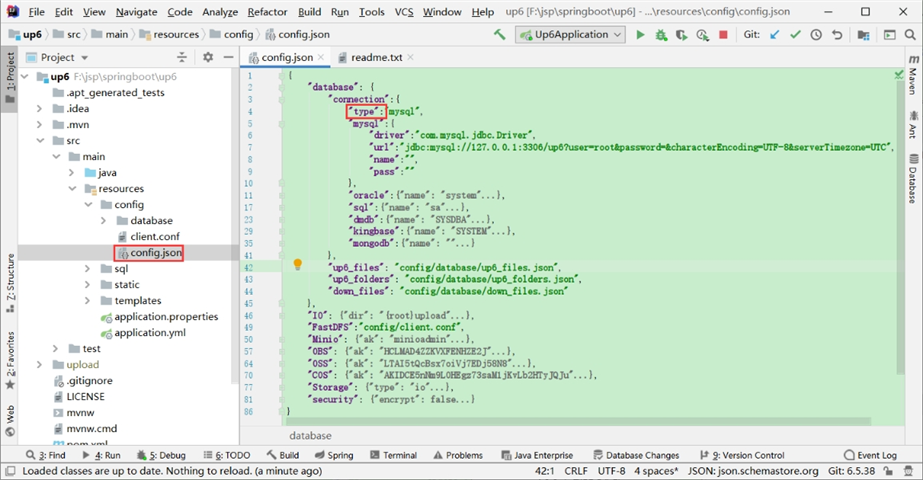

配置数据库连接

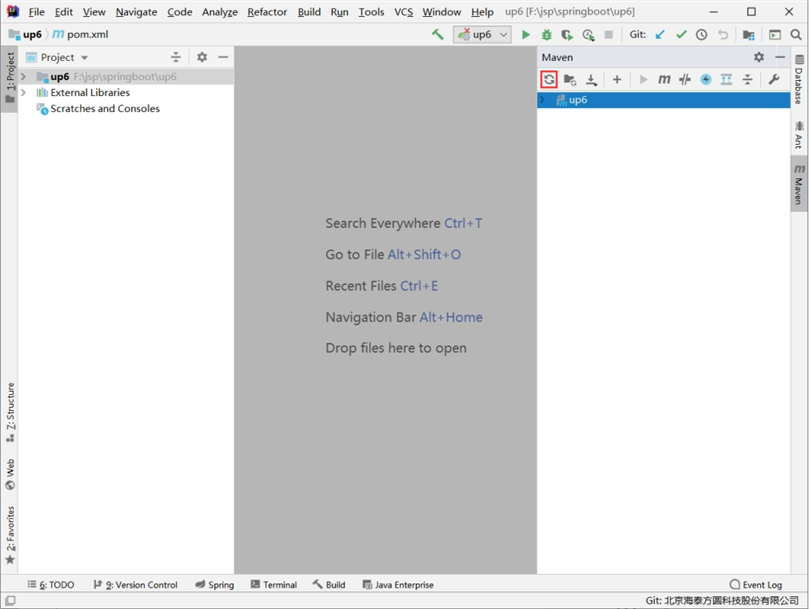

自动下载maven依赖

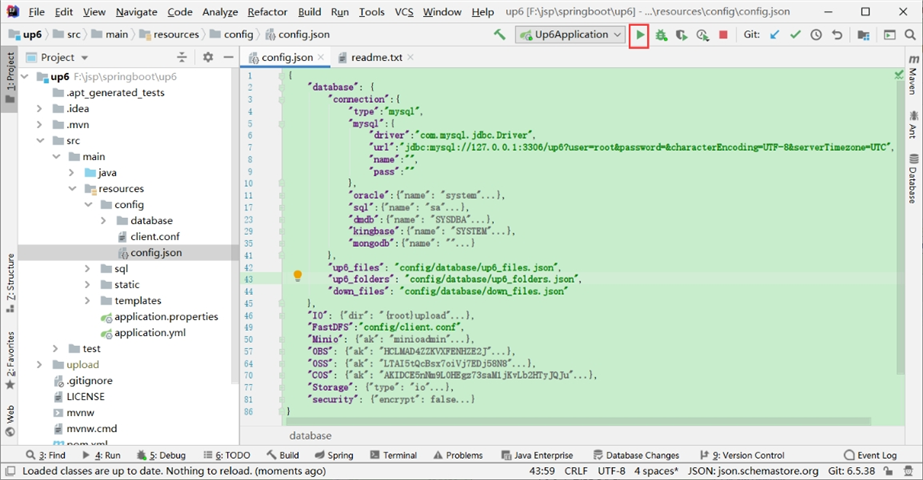

启动项目

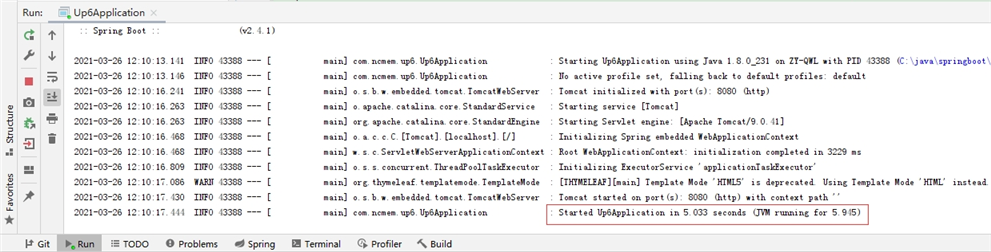

启动成功

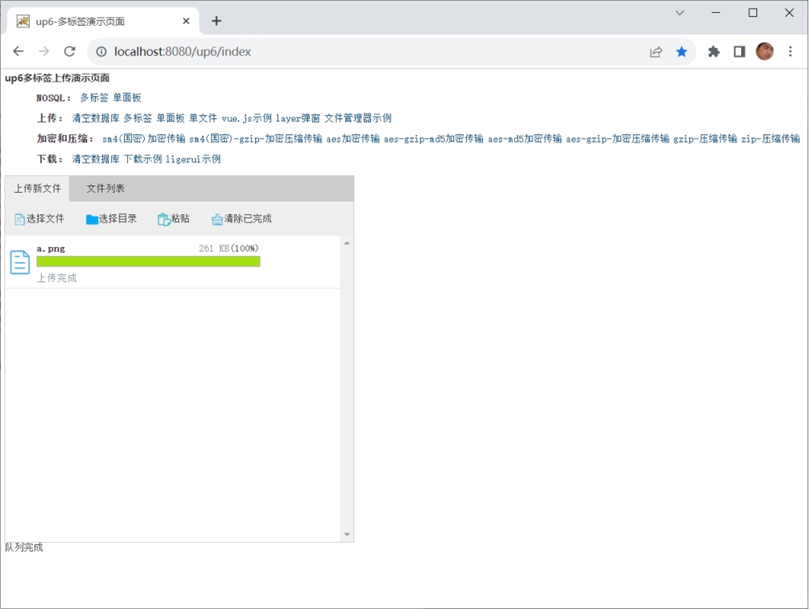

访问及测试

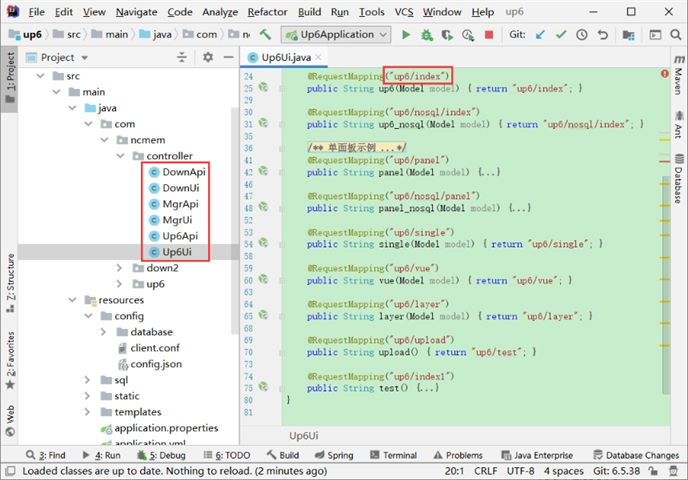

默认页面接口定义

在浏览器中访问

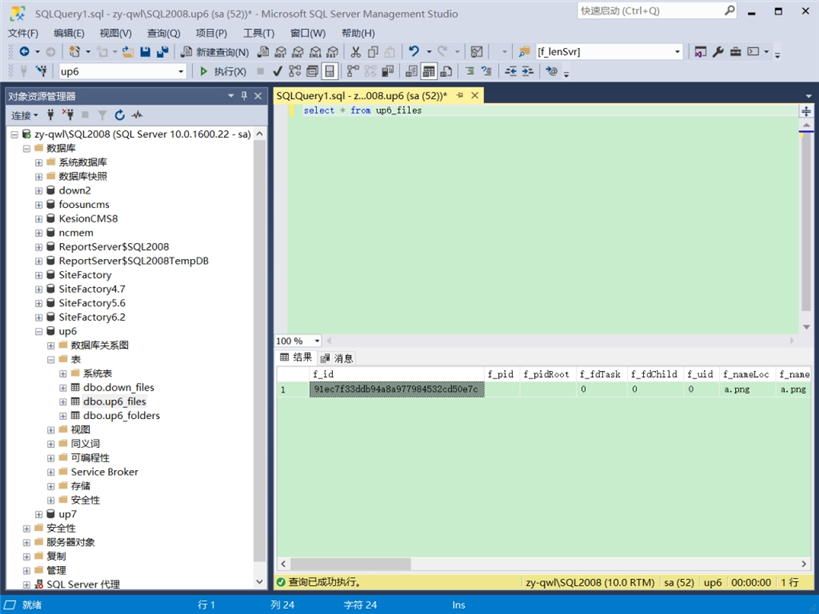

数据表中的数据

1003

1003

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?