模型简介

这是一类新型的多模态扩散基础模型,旨在在不同领域(如文本推理、多模态理解和文本到图像生成)实现卓越的性能。MMaDA 的三大创新特点是:

–MMaDA 采用统一的扩散架构,具有共享的概率公式和模态不可知的设计,无需模态特定的组件。

–MMaDA 引入了一种混合长链 (CoT) 微调策略,该策略可跨模态策划统一的 CoT 格式。

–MMaDA 采用统一的基于策略梯度的 RL 算法,我们称之为 UniGRPO,专为扩散基础模型量身定制。利用多样化的奖励建模,UniGRPO 统一了推理和生成任务的后训练,确保一致的性能改进。

MMaDA: Multimodal Large Diffusion Language Models

一、研究背景与动机

随着大型语言模型(LLMs)在自然语言处理(NLP)领域的成功应用,从文本生成到复杂推理任务,研究者们开始探索将其扩展到多模态领域。多模态大型语言模型(MLLMs)或视觉 - 语言模型(VLMs)旨在提供一个统一的框架,以理解和生成不同类型的数据,如文本和图像。早期方法将语言模型与扩散模型结合,分别处理离散和连续模态。后续的自回归(AR)方法简化了架构,但现有统一多模态基础模型主要关注模型架构设计和预训练策略,而在非自回归设置中的后训练方法研究较少。为填补这一空白,本文提出了一种新颖的多模态扩散基础模型 MMaDA。

二、研究方法

-

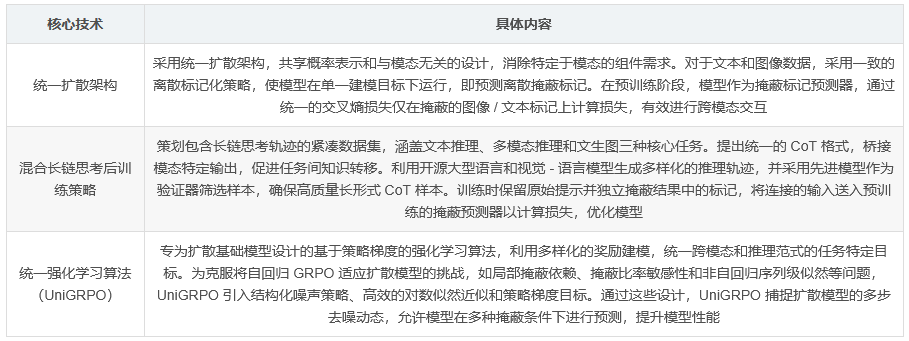

统一扩散架构 :MMaDA 采用统一扩散架构,共享概率表示和与模态无关的设计,消除了特定于模态的组件需求。对于文本和图像数据,采用一致的离散标记化策略,使模型能够在单一建模目标下运行,即预测离散掩蔽标记。在预训练阶段,模型被训练为掩蔽标记预测器,通过统一的交叉熵损失仅在掩蔽的图像 / 文本标记上计算损失,从而有效进行跨模态交互。

-

混合长链思考后训练策略 :为增强模型在统一多模态扩散框架中的后训练效果,研究者策划了一个包含长链思考轨迹的紧凑数据集,涵盖文本推理、多模态推理和文生图三种核心任务。提出统一的 CoT 格式,将模态特定输出桥接起来,促进任务间知识转移。此外,利用开源大型语言和视觉 - 语言模型生成多样化的推理轨迹,并采用先进模型作为验证器筛选样本,确保高质量长形式 CoT 样本。在训练过程中,保留原始提示并独立掩蔽结果中的标记,将连接的输入送入预训练的掩蔽预测器以计算损失,优化模型。

-

统一强化学习算法(UniGRPO) :UniGRPO 是一种基于策略梯度的强化学习算法,专为扩散基础模型设计。它利用多样化的奖励建模,统一了跨模态和推理范式的任务特定目标。为克服将自回归 GRPO 适应扩散模型的挑战,如局部掩蔽依赖、掩蔽比率敏感性和非自回归序列级似然等问题,UniGRPO 引入结构化噪声策略、高效的对数似然近似和策略梯度目标。通过这些设计,UniGRPO 捕捉扩散模型的多步去噪动态,允许模型在多种掩蔽条件下进行预测,提升模型性能。

三、实验

-

实验设置 :使用多种数据集训练 MMaDA,包括基础语言和多模态数据、指令调整数据、推理数据和强化学习数据。在多模态理解任务上,采用 POPE、MME、Flickr30k、VQAv2、GQA 和 MMMU 等基准进行评估;在文生图任务上,使用 CLIP 得分和 ImageReward 等指标评估生成质量;在文本生成任务上,评估指令遵循和推理性能,与多个基准模型进行比较。

-

多模态理解实验结果 :MMaDA 在多模态理解基准测试中表现出色,与专用理解模型相比在大多数基准上取得相当甚至更优的结果,且在多个基准上超越其他统一模型,如 SEED-X、DreamLLM、Janus、Emu3 和 Show-o 等,证明了统一架构在融合生成和理解任务方面的潜力。

-

文生图实验结果 :MMaDA 在 CLIP 得分和 ImageReward 等指标上均取得最高性能,归因于在 UniGRPO 训练阶段与这些指标明确对齐的奖励。在 GenEval 测试中,其在对象计数和颜色属性等任务上展现出优越的组合性和对象计数能力。在 WISE 文化基准测试中,由于在基于文本的推理联合训练方面的优势,显著超越先前方法。

-

文本推理实验结果 :MMaDA 在多个基准测试中展现出与强大基线模型相当甚至更优的性能。在 MMLU、ARC-C 等通用任务以及 GSM8K、MATH、GPQA 等数学任务上,尽管在特定任务标记和仅开源文本数据上训练有限,但与 LLaMA2-7B、Qwen2-7B 和 LLaDA-8B 等基线模型相比,MMaDA 在数学基准测试中始终优于 LLaDA-8B,并在多项任务中与 Qwen2-7B 和 LLaMA3-8B 表现相当。

四、关键结论

MMaDA 作为一种统一的扩散基础模型,将文本推理、多模态理解和生成整合在一个单一的概率框架内。它是首个系统性探索基于扩散的基础模型设计空间的研究,并提出了新颖的后训练策略。广泛的实验表明,MMaDA 在多种视觉 - 语言任务上的表现与专用模型相当甚至更优,突显了扩散模型作为下一代多模态智能基础范式的潜力。然而,由于当前模型尺寸较小(8B 参数),其性能存在一定局限性,未来可通过使用更大模型尺寸来提升性能。

以下是论文中的核心技术汇总表格:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?