摘要/前言: 大模型圈又地震了。 Gemini 3.0 刚刚发布, Banana Pro 也开始在多模态领域发力。 作为开发者,我们最头疼的不是技术, 而是昂贵的订阅费和复杂的网络环境。 今天,分享一个能够统一调用所有 SOTA 模型的 API 聚合方案。 实测延迟低,兼容 OpenAI 格式, 文末附赠开发者专属的调试福利。

一、 为什么你需要“模型聚合层”?

在传统的开发模式中, 如果你想对比 GPT-4 和 Gemini 3.0 的效果, 你需要维护两套 SDK, 支付两份订阅费用, 处理两种不同的鉴权逻辑。

这非常不优雅。

向量引擎(Vector Engine) 的出现, 解决了这个问题。 它就像设计模式中的 “适配器模式” (Adapter Pattern)。

它向下屏蔽了不同厂商的接口差异, 向上提供统一的 OpenAI 兼容接口。 你只需要改一行 base_url, 就能在几秒钟内, 从 GPT-4 切换到 Gemini 3.0 或 Banana Pro。

二、 核心优势:技术视角

1. 极低的接入成本 不需要绑定国外信用卡, 不需要搭建复杂的代理服务, 直接通过 API Key 即可调用。

2. 真正的按量付费 (Pay-as-you-go) 很多开发者用不完 $20 的月费。 API 模式下,用多少 Token 扣多少钱。 对于测试阶段的项目, 成本几乎可以忽略不计。

3. 极速响应 实测 API 的 TTFT (首字生成时间) 极低, 非常适合构建实时对话应用。

三、 Python 代码实战演示

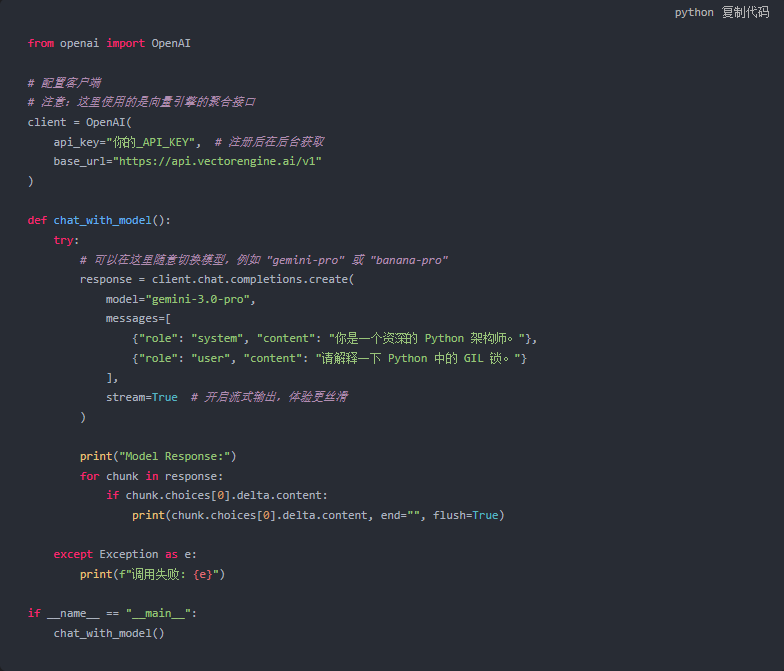

废话不多说,直接上代码。 这里演示如何通过 Python SDK, 调用最新的 Gemini 模型。

环境准备:

bash

pip install openai

调用脚本 (main.py):

代码解析: 你看,代码结构与官方 OpenAI SDK 完全一致。 你现有的 LangChain、AutoGPT 等项目, 几乎不需要重构, 只需修改配置即可无缝迁移。

四、 热门模型推荐

1. Gemini 3.0 Google 的最新力作。 在长文本理解和逻辑推理上, 已经不仅是“追赶”,而是“超越”。 非常适合用来做代码审计和文档分析。

2. Banana Pro 这是一个在特定领域非常惊艳的模型。 如果你在做多模态应用, 或者需要更具创意的生成能力, 一定要试试它。

五、 开发者专属福利 (Dry Goods)

技术不仅要学,更要动手试。 为了方便大家进行接口调试和压力测试, 我申请了一波开发者专属额度。

注册地址 (官方通道): 点击此处注册向量引擎

详细文档: 《向量引擎集成指南》

🎁 重点福利: 如果你注册后想要深度测试, 请关注并咨询。 直接赠送 10 美刀 测试额度!

这大约等于 500万 Token。 足够你把上面的 Python 脚本跑上几万次, 或者完成一个中型项目的开发测试了。

技术在变, 但掌握工具的人永远不会被淘汰。 Happy Coding!

51万+

51万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?