之前做过一段时间的人脸姿态估计研究,取得了比较理想的效果,拿出来和大家分享一下,第一次写博客,肯定有表达不清晰的地方,还请大家多多批评哈!

当时自己刚开始这方面的研究,特别想找到关于这方面的博客介绍,可惜没有,于是产生了写一篇该方向上博客的想法,废话不多说,开始介绍!

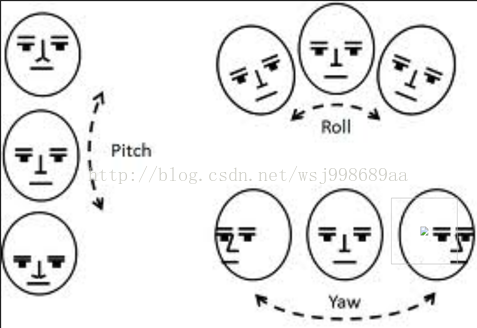

人脸姿态估计,顾名思义,给定一张人脸图像,确定其姿态,姿态由什么构成呢?很简单(pitch,yaw,roll)三种角度,分别代表上下翻转,左右翻转,平面内旋转的角度。

目前,人脸姿态估计有多种方法,可以分为基于模型的方法,基于表观的方法,基于分类的方法。我之前做过 这方面的调研,调研的结果很明显,基于模型的方法得到的效果最好,因为其得到的人脸姿态是连续的,而另外两种,是离散的,并且很耗时间。

人脸姿态估计算法一般当做很多人脸对齐相关论文的副产品被提出,近期,比较“出名”的人脸对齐论文主要来自于CVPR,ICCV等,如下:

《Supervised Descent Method and its Applications to Face Alignment》,这篇论文提供了demo,并且附加了人脸姿态估计功能,估计精度还不错。

《Face Alignment at 3000 FPS via Regressing Local Binary Features》,这篇文章是最新的人脸对齐算法,基于随机森林的算法,速度比较快,精度基本和上一篇持平。

《Face Alignment by Explicit Shape Regression》这篇文章很出名,作者也和上一篇是同一人。

还有经典的人脸对齐鼻祖算法ASM,AAM,想必大家也都知道,这里不再多说,因为咱这篇博客的主题是人脸姿态估计嘛!~

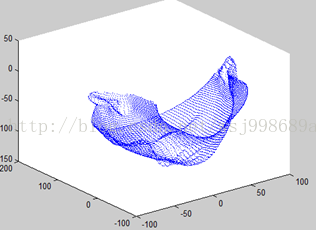

基于模型的估计方法的前提是,手头必须具备两样东西,一个是人脸特征点(眼镜,嘴巴,鼻子等处的像素位置),另外一个,是需要自己制作一个3维的,正面的“标准模型”。

这个模型的好坏很重要,人脸的特征点精度可以不高,因为后面的姿态估计算法可以采用鲁棒方法予以弥补,但是标准模型一旦有问题,势必会导致姿态估计的精度偏低。

算法最重要的还是思想,其余诸如流程什么的,都是实现思想的手段而已。人脸姿态估计的思想:旋转三维标准模型一定角度,直到模型上“三维特征点”的“2维投影”,与待测试图像上的特征点(图像上的特征点显然是2维)尽量重合。这时候我们脑海中就应该浮现出一种诡异的场景:在幽暗的灯光中,一个发着淡蓝色光芒的人皮面具一点点的“自我调整”,突然一下子“完美无缺”的“扣在了你的脸上”。这就是人脸姿态估计的思想。

想到了什么没?这貌似听起来像是某种数学中常常介绍的一种方法。是的,大部分论文中也经常利用这种方式来建立模型。这个方法就叫做“非线性最小二乘”。

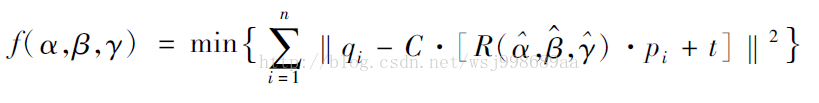

我们也可以利用非线性最小二乘方法来建立我们的模型,模型公式如下:

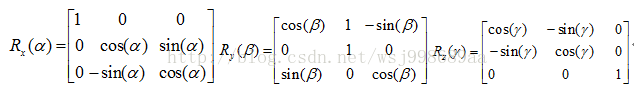

其中,(α,β,γ)代表人脸姿态三个旋转角度, N代表着一张人脸上标定特征点的个数,qi代表着待测试人脸特征点,pi代表对应着的三维通用标准模型特征点,R代表旋转矩阵, t为空间偏移向量,s为伸缩因子。R的具体形式是如下三个矩阵相乘:

给出了人脸姿态估计的模型,我们可以发现,这个公式的形式,刚好对应于刚刚提出的人脸姿态估计算法思想。数学是奇妙的!

更奇妙的在下面.....

这个公式看起来很直观,很好的解释了人脸姿态估计的内涵,但是,这个公式怎么求解?

对了,别忘记,这是“烂大街的”非线性最小二乘算法,从牛顿爷爷开始,就有着大把的优化方法,梯度下降,牛顿高斯,信赖域,马夸尔特等等等等等用于解决它,等到下一篇博客,我会尽量用通俗的语言,为大家介绍姿态估计的下一个重要阶段:迭代求精。

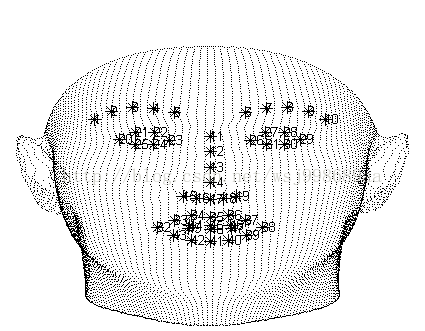

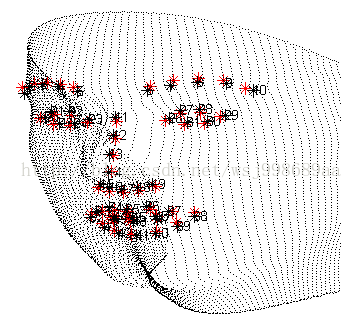

附图(姿态估计效果图):

原图 3D标准模型正面照 姿态估计算法拟合图

8953

8953

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?