第 6 章

情绪建模

情绪是人类思考、决策和与他人互动的关键部分。它们引导我们理解情境、做出选择并建立关系。安东尼奥·达马西奥(Antonio Damasio)在其著作《笛卡尔的错误》(Descartes’ Error)[25] 中解释说,情绪与逻辑并非相互分离。相反,它们与我们的推理和行为方式紧密相连。在开发大语言模型(LLM)智能体时,添加情感能力有可能使这些系统更智能、适应性更强,并更好地理解周围世界。

对于大语言模型智能体而言,情绪可以像对人类一样,充当决策工具。情绪帮助我们确定任务优先级、理解风险并适应新挑战。马文·明斯基(Marvin Minsky)在《情绪机器》(The Emotion Machine)[420] 中将情绪描述为调整我们思维过程的一种方式,帮助我们以更灵活、更有创造性的方式解决问题。类似地,具备类情绪特征的大语言模型智能体可以提高其解决复杂问题和以更接近人类风格做出决策的能力。

然而,将情绪融入大语言模型智能体仍处于早期阶段。研究人员才刚刚开始探索情感能力如何改进这些系统。此外,大语言模型智能体在支持人类情绪健康方面具有巨大潜力,无论是通过共情对话、心理健康支持,还是仅仅与用户建立更好的连接。这个充满希望但又具挑战性的领域需要心理学、认知科学和人工智能伦理学等领域之间的合作。随着研究的进展,理解情绪的大语言模型智能体可能会重新定义我们与技术的互动方式,在人与机器之间建立更深的信任和更有意义的关系。

在接下来的小节中,我们将深入探讨情绪在塑造大语言模型智能体中的作用。我们将探索如何利用情绪来增强学习和适应性,大语言模型如何理解人类情绪,以及这些系统如何表达和建模自身的情绪状态。我们还将研究如何操控情绪以影响大语言模型智能体的行为和个性,以及这些能力所带来的伦理和安全问题。这些讨论都建立在情绪对创建更智能、更具共情力并与人类价值观保持一致的大语言模型智能体的基础重要性之上。

6.1 情绪的心理学基础

情绪的心理学和神经科学理论为开发具有情感智能的大语言模型智能体提供了必要的框架。这些理论可以分为几个主要方法,每种方法都对情绪如何运作以及如何在 AI 系统中实现它们提供了独特的视角。

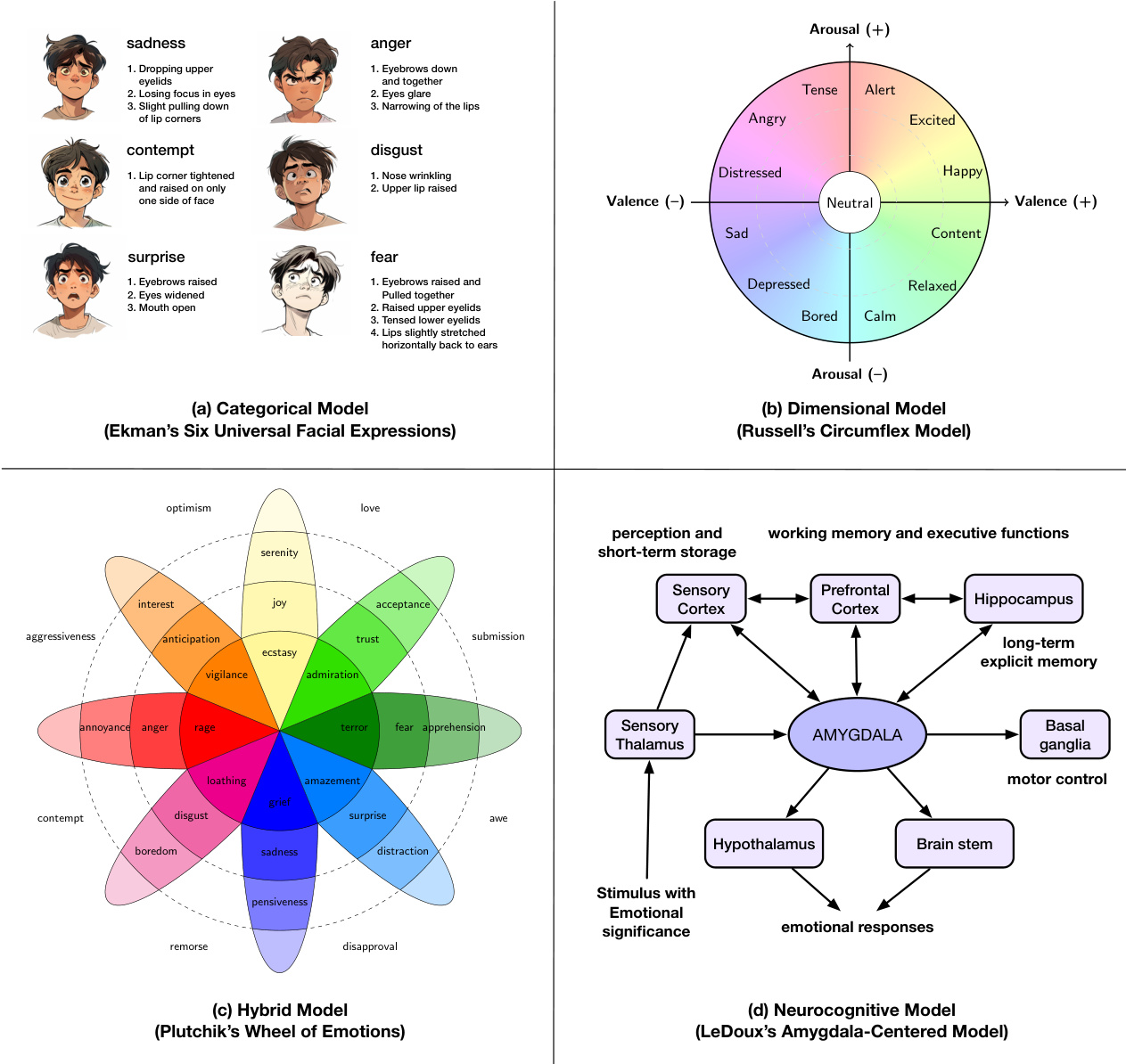

类别理论(Categorical Theories)。这些模型假定情绪以离散、普遍的类别存在,具有独特的生理和行为特征。埃克曼(Ekman)的基本情绪理论 [421] 确定了六种基本情绪(愤怒、厌恶、恐惧、快乐、悲伤和惊讶),这些情绪在不同文化中都能被识别,并通过特定的面部表情来表达。这种离散方法对情感计算产生了显著影响,许多 AI 中的情绪分类系统都采用这些标签进行训练 [422, 423]。对于大语言模型智能体,类别框架为分类用户情绪和生成适当响应提供了清晰的分类体系。然而,它们因过度简化了人类情感体验的复杂、混合性质而受到批评 [424],并且可能无法捕捉情绪表达中的文化差异 [425]。

维度模型(Dimensional Models)。维度方法并非采用离散类别,而是将情绪表示为由基本维度定义的连续空间中的点。罗素(Russell)的环状模型(Circumplex Model)[426] 将情绪映射到两个主要维度:效价(愉悦-不悦)和唤醒度(激活-失活)。该框架能够更细致地追踪情绪状态。它可以区分高唤醒度的恐慌和低唤醒度的焦虑,尽管两者都具有负效价。PAD(愉悦-唤醒-主导)模型 [427] 通过增加一个主导维度来扩展此模型,捕捉与情绪状态相关的控制感或权力感。这些连续表示已被证明对于需要生成情感分级响应或追踪用户情感随时间微妙变化的大语言模型系统很有价值 [428, 429, 430]。维度模型允许对生成内容进行细粒度控制,使人类或智能体能够沿着连续尺度调节语气,而不是在离散的情绪状态之间切换。

混合与成分框架(Hybrid and Componential Frameworks)。认识到纯类别或维度方法的局限性,一些理论整合了两者的方面。普拉切克(Plutchik)的情绪轮(Wheel of Emotions)[431] 将八种主要情绪排列在一个轮状结构中,具有强度梯度和维度属性,允许表示复杂的情感混合(例如,爱是快乐和信任的混合)。与此同时,像谢勒(Scherer)的成分过程模型(Component Process Model, CPM)[432] 这样的成分模型将情绪概念化为由认知评估、生理唤醒、行动倾向和主观感受等同步成分共同产生。在 AI 研究中特别有影响力的是 OCC(Ortony-Clore-Collins)模型 [433],它根据事件、行为主体或对象相对于目标和标准如何被评估来定义了 22 种情绪类型。这些基于评估的框架已在通过基于规则的情境评估来生成情绪响应的对话系统中实现 [434, 435]。对于大语言模型智能体,此类模型提供了评估文本输入和选择上下文适当的情绪响应的计算结构,从而提高了连贯性和感知到的共情能力 [436, 437]。

神经认知视角(Neurocognitive Perspectives)。情绪神经科学为大语言模型架构提供了额外的见解。达马西奥(Damasio)的躯体标记假说(somatic marker hypothesis)[25] 强调了情绪如何通过身体-大脑互动来指导决策,将生理状态与预期结果联系起来。边缘系统和皮层之间的这种互动展示了一个双过程架构:边缘系统中的快速“警报”信号,如杏仁核处理的信号,与皮层中较慢、更审慎的推理并行工作。当代大语言模型系统已开始实施类似的架构,其中快速情感检测模块与更彻底的思维链(chain-of-thought)推理并行工作 [436, 437]。最近的证据进一步表明,纹状体中的拮抗回路通过编码整个概率分布而不仅仅是平均奖励,从而实现了分布式强化学习,为不确定性下受情绪影响的决策提供了神经基础 [438]。类似地,勒杜(LeDoux)关于“低通路”(快速、自动)和“高通路”(较慢、认知)恐惧处理的区别 [24] 提示了需要即时安全响应和细致情绪理解的系统的设计模式。明斯基(Minsky)将情绪框定为重组认知过程的“思考方式”[420] 的观点,影响了像 EmotionPrompt [428] 和 Emotion-LLaMA [423] 这样的框架,其中情绪上下文动态地重塑大语言模型推理。

这些理论框架越来越多地为开发具有情感智能的大语言模型智能体提供信息。类别模型为情绪分类任务提供了清晰的标签 [423, 429],而维度嵌入则实现了对生成文本的连续控制 [428]。混合方法帮助系统处理混合情绪和情绪强度。基于评估的方法,特别是源自 OCC 模型的方法,允许大语言模型根据上下文评估叙事事件或用户陈述,选择能培养融洽关系和信任的适当情绪响应 [439]。受神经科学启发的双过程架构结合了“快速”情感检测和“慢速”审慎推理,使得既能快速做出安全响应,又能进行更深层次的情绪理解 [436, 437]。虽然明确的神经认知机制(如专用的“类杏仁核”通路)在当前的大语言模型管道中仍然罕见,但新兴研究探索了受生物启发的模块,以处理紧急情绪信号并在扩展交互中保持一致的情绪状态 [440, 441]。

情绪是人类智能的关键部分,它很可能成为大语言模型智能体的关键组成部分或设计考虑之一。一个关键的未来方向是系统地将这些心理学和神经科学理论转化为大语言模型智能体的内部过程。转化的技术可能包括使用维度模型(例如,效价/唤醒度/主导度)作为影响生成的潜在状态,或采用明确的基于规则的评估(OCC)来标记用户消息并塑造智能体的后续行动。混合方法提供了一种引人注目的平衡:大语言模型可以首先识别一个离散类别(例如,“恐惧”),但也可以衡量其强度和控制维度,以实现更细粒度的对话。这种融入情绪的架构可能会随着时间的推移产生更连贯的“情绪”,类似于人类维持情感状态而不是在每次互动时重置。将情绪明确地与心理学理论对齐也增强了解释性:设计者可以通过将智能体的响应与公认的情绪结构进行比较来调试或改进,而不是处理不透明的涌现行为。

第二个方向是利用这些理论来改善亲和或支持性互动,通常称为情感对齐(emotional alignment)。例如,基于环状模型或 PAD 模型的追踪可以帮助大语言模型检测用户文本中的负效价和高唤醒度,并以安抚的方式响应(例如,降低唤醒度,提供共情的重新评估)。在心理健康或咨询场景中,基于评估的方法可以让智能体验证用户的情感,并从目标不一致或感知到的责备角度理解他们的情况,这有助于构建传达真正共情的回应。将情绪输出建立在认知理论的基础上(例如,如果避免了负面结果则产生“宽慰”,或者当用户帮助系统时产生“感激”)同样使互动感觉更自然且符合伦理。随着大语言模型进入客户服务、老年护理和辅导等现实世界应用,这些增强功能尤为重要,因为在这些场景中,情绪敏感性可以改善结果和用户福祉。通过融入强大的心理学和边缘系统见解,开发者可以设计出不仅能更有效地推理,还能提供真诚情感支持的大语言模型智能体,从而弥合计算精度与以人为中心的关怀之间的差距。

图 6.1:主要情绪理论类别的可视化与示例。(a) 类别理论:埃克曼的六种基本情绪 [421],显示离散的情绪状态。(b) 维度模型:罗素的环状模型 [426],将情绪表示为连续空间中的坐标。© 混合/成分框架:普拉切克的情绪轮 [431],将强度梯度与类别情绪相结合。(d) 神经认知视角:勒杜的以杏仁核为中心的模型 [24],显示情绪刺激的双通路处理。这些心理学基础为 AI 系统中不同的情绪建模方法提供了信息,从离散分类到维度表示、基于评估的推理和多通路信息处理。

6.2 在 AI 智能体中融入情绪

将情感智能整合到大语言模型(LLM)中已成为增强其性能和适应性的一种变革性方法。最近的研究,例如 EmotionPrompt [422] 的研究,突显了嵌入提示中的情绪刺激如何显著改善各种任务的结果,包括在生成任务指标(如真实性和责任感)方面取得显著的 10.9% 的改进。通过影响大语言模型的注意力机制,富含情绪的提示丰富了表示层,并产生了更细致的输出 [422]。这些进步将 AI 与情感智能联系起来,为更好地模拟人类认知和决策(特别是在需要社交推理和共情的环境中)的训练范式提供了基础。

多模态方法进一步提升了情绪整合的影响。像 Emotion-LLaMA [440] 这样的模型展示了结合音频、视觉和文本数据如何实现更好的情绪识别和推理。使用像 MERR [440] 这样的数据集,这些模型将多模态输入对齐到共享表示中,促进了情绪理解和生成的改进。这项创新超越了语言改进,为人类计算机交互和自适应学习提供了应用。总的来说,这些方法强调了情绪在弥合技术稳健性与以人为中心的 AI 开发之间的关键作用,为既智能又具共情力的系统铺平了道路。

6.3 通过 AI 理解人类情绪

文本方法(Textual Approaches)。最近的工作突显了大语言模型执行关于潜在情感和情绪的详细推理的能力。研究人员使用逐步提示策略,例如思维链推理,使大语言模型能够推断情感,即使在没有明确线索的情况下也是如此 [436]。除了单轮推理,基于协商的框架通过利用多个相互评估彼此输出的大语言模型来进一步细化情绪判断,有效地模仿了更审慎的人类推理过程 [437]。这些技术强调了迭代的、上下文感知的策略对于从纯文本输入中捕捉微妙情绪信号的重要性。

多模态方法(Multimodal Approaches)。大语言模型也已扩展到整合来自音频、视频和图像的信号。最近的努力表明,如何将额外的上下文或世界知识与视觉和文本信息融合,以捕捉更深层次的情感状态 [442]。此外,将语音信号转换为文本提示的框架表明,可以在不改变底层模型架构的情况下将声音的细微差别嵌入到大语言模型的推理中 [443]。这种多模态整合,结合可解释的方法,允许对情绪内容进行更丰富、更透明的表示 [444]。

专门框架(Specialized Frameworks)。除了通用技术,专门的系统处理那些情绪识别需要更高水平的模糊性意识 [439]、上下文敏感性和生成适应性 [445] 的任务。这些方法强调人类情绪固有的复杂性,将其视为动态和概率性的,而非严格的类别性。它们使用灵活的大语言模型指令范式,为更好地解释模糊的情绪表达和整合上下文线索(例如,对话历史)提供了途径,使大语言模型更接近类人的情绪理解。

评估与基准(Evaluation and Benchmarks)。为了全面评估大语言模型的情感智能,研究人员提出了各种基准套件。一些侧重于跨不同模态和社交环境的广义情绪识别 [446, 447],而另一些则比较不同规模模型的性能和效率 [448]。还有专门的基准评估多语言能力 [449]、标注质量 [450] 或共情对话系统 [451]。此外,像 EMOBENCH [441] 和 MEMO-Bench [452] 这样的框架测试文本和图像中细致的情绪理解和表达,而 MERBench [453] 和大规模评估 [454] 则解决了多模态情绪识别中的标准化问题。总的来说,这些基准揭示了大语言模型对人类情绪的掌握程度正在增长但仍不完美,突显了持续存在的挑战,如内隐情感检测、文化适应和依赖上下文的共情 [455]。

6.4 分析 AI 的情绪与个性

LLM 人格量表的可靠性(Reliability of Personality Scales for LLMs)。大语言模型(LLM)在通过以人为中心的人格测试进行评估时显示出相互矛盾的证据。一方面,一些研究质疑常用指标的有效性,报告了诸如“同意偏差”(agree bias)和不一致的因子结构等偏见,引发了对这些工具是否捕捉到真实特质的怀疑 [456, 457]。另一方面,系统性实验表明,大语言模型可以表现出稳定、类似人类的特质模式,甚至在特定提示下适应不同的人格 [458, 459]。然而,关于行为一致性、自我知识对齐以及角色扮演智能体是否真正忠于其指定角色的担忧仍然存在 [460, 461]。

心理测量方法与认知建模方法(Psychometric Methods & Cognitive Modeling Approaches)。最近的工作应用严格的心理测量测试、认知任务和基于群体的分析来揭示大语言模型如何处理和表示心理结构 [462, 463, 464]。在人类行为数据上进行微调可以将模型与反映个体层面认知的决策模式对齐,而基于群体的抽样技术则揭示了神经反应的可变性 [465, 466]。通过将心理学理论与先进的提示和嵌入方法相结合,研究人员阐明了诸如焦虑或冒险等结构的潜在表示,展示了大语言模型如何在各种任务中近似人类推理。

情绪建模(Emotion Modeling)。关于基于大语言模型的情感智能的研究揭示了其在解释细微情感和预测充满情绪的结果方面具有显著能力,在标准测试中通常超过人类平均基线 [423, 429]。然而,这些模型并不一定模仿类似人类的情感过程;它们依赖于高维模式匹配,有时在变化的上下文、负面输入或冲突线索下会失败 [467, 468]。但是,分层的情绪结构、应对策略和类似共情的行为可以在更大规模的模型中涌现,这既突显了情感对齐的前景,也指出了在创建看起来并且偶尔能作为情感智能体运作的 AI 系统时所面临的伦理挑战。

6.5 操控 AI 的情绪反应

基于提示的方法(Prompt-based Methods)。最近的研究表明,通过精心设计的提示采用特定的人格或角色可以偏置大语言模型的认知,从而实现有针对性的情绪或个性结果 [469, 470, 471, 472]。通过插入诸如“如果你是一个[人格]”之类的指令,大语言模型不仅会调整其主题风格,还会调整其潜在的情感立场。这种方法对于实时操控非常强大,尽管它在不同任务和模型变体之间可能不一致,这突显了需要更系统化的方法。

基于训练的方法(Training-based Methods)。微调和参数高效策略提供了更深入、更稳定的方式来诱导或改变大语言模型的情绪 [473, 428, 474]。量化低秩适应(Quantized Low-Rank Adaptation, QLoRA)和专门的数据集可以将细致的特质(如大五人格或 MBTI 类型)直接嵌入到模型的学习权重中。这些方法使大语言模型能够自发地表现出特定特质的行为(包括使用表情符号)并在更长的对话中维持其情绪状态,同时通过神经元级别的激活模式提供可解释性。

基于神经元的方法(Neuron-based Methods)。最近的一项进展是分离出特定人格的神经元并直接操纵它们以引发或抑制情绪特质 [475]。通过切换通过基于心理学基准(例如 PersonalityBench)精确定位的神经元激活,大语言模型可以体现目标情绪维度,而无需重新训练整个网络。这种以神经元为中心的方法为模型行为提供了细粒度、动态的控制,代表了在大语言模型中情绪操控的精确性和效率方面的一大飞跃。

6.6 总结与讨论

操控与隐私担忧(Manipulation and Privacy Concerns)。情感 AI 在广告和政治中的迅速采用引发了重大的操控和隐私风险 [476, 477]。情感 AI 通常收集敏感的生物特征数据,如面部表情和语音语调,以推断情绪状态,从而实现有针对性的广告或政治影响。然而,这些系统可能为了利润或政治利益而利用人类情绪,侵犯基本权利并在公共场所助长过度监视 [478, 477]。像 GDPR 和欧盟 AI 法案这样的监管框架对于负责任地减轻这些风险至关重要。

对齐问题(Alignment Issues)。情感 AI 检测和解释情绪的能力通常与其预期结果不符,导致不准确和偏见。例如,引发焦虑的提示已被证明会加剧大语言模型(LLM)中的偏见,影响医疗保健和教育等高风险领域的输出 [479, 480]。AI 系统对情绪线索的误解,如在工作场所应用中所见,可能加剧歧视和权力失衡 [481]。像基于人类反馈的强化学习(RLHF)这样的技术已被证明在缓解这些问题方面是有效的,但需要进一步发展以确保在不同环境中的稳健对齐 [479, 423]。

伦理影响(Ethical Implications)。AI 系统的信任度和接受度在很大程度上受其表现出共情能力和维持社会适当行为的能力的影响 [482, 483]。然而,在工作场所管理和客户服务中情绪的商品化引发了对合乎道德的劳动实践和 AI-人类关系的担忧 [481]。此外,情感 AI 依赖拟人化特征而缺乏足够的共情能力可能会损害用户信任 [482]。像 SafeguardGPT 这样融合了心理治疗技术的框架,展示了培养信任并将 AI 行为与社会规范对齐的有前景的方法 [484]。尽管如此,在确保隐私、公平性和文化敏感性方面仍然存在挑战 [484, 483]。

区分 AI 情绪模仿与人类体验(Distinguishing AI Emotional Mimicry from Human Experience)。尽管大语言模型智能体的情绪建模取得了进展,但一个根本的区别仍然存在:这些系统实际上并不像人类那样“感受”情绪,而只是通过概率建模显示出类似人类情绪的模式。虽然大语言模型可以令人信服地模拟情绪反应、识别情绪模式并生成情感输出,但它们缺乏定义人类情绪的那种具身的、现象学的体验。这种模拟与现实之间的差距既带来了技术挑战,也带来了伦理挑战。用户经常会将表现出类情绪行为的 AI 系统拟人化 [482],可能导致错误的信任或期望。在研究和部署环境中都需要仔细考虑这种区别,因为大语言模型感知到的情感能力会影响人机关系、伦理框架和监管方法。未来的工作应在增强大语言模型的情感智能与保持其作为非感知系统的基本局限性的透明度之间取得平衡。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?