在广告推荐系统中,利用用户和广告之间的信息作为预测的特征

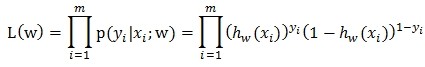

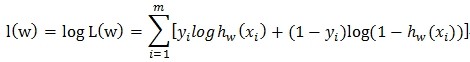

预测的过程其实就是一个二分类的问题,主要就是判定一个用户对这个广告点击或者是不点击的概率是多少

而这个过程是一个伯努利函数,整个过程是一个伯努利分布

1 广义线性模型:

指数家族分布:

是广义线性模型的基础,所以先简单了解一下指数分布族。

当固定T时,这个分布属于指数家族中的哪种分布就由a和b两个函数决定。 自然参数 η 是分布的参数。

同事广义线性模型需要满足三个条件:

如何构建GLM呢?在给定x和参数后,y的条件概率p(y|x,θ) 需要满足下面三个假设:

assum1) y | x; θ ∼ ExponentialFamily(η). 参数x,y必须是符合指数家族分布的情况

assum2) h(x) = E[y|x]. 即给定x,目标是预测T(y)的期望,通常问题中T(y)=y. 模型预测输出仍然可以认为是

本文探讨了广告推荐系统中使用逻辑回归进行预测的原理。逻辑回归在二分类问题中,通过伯努利分布来预测用户点击广告的概率,其核心是广义线性模型。内容包括指数家族分布、逻辑回归函数的构建以及线性回归的计算方法,解释了为何在处理非线性关系时需要采用逻辑回归而非线性回归。

本文探讨了广告推荐系统中使用逻辑回归进行预测的原理。逻辑回归在二分类问题中,通过伯努利分布来预测用户点击广告的概率,其核心是广义线性模型。内容包括指数家族分布、逻辑回归函数的构建以及线性回归的计算方法,解释了为何在处理非线性关系时需要采用逻辑回归而非线性回归。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2367

2367

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?