最近在处理项目组的一个数据集,数据量每张表在百万级,由于数据量较大在数据下载和处理方面都可以说是旷日持久,这篇记录一下相关的经验。

「数据下载」

拿到的数据是在远程数据库里面,原先打算直接从远程库里下载 csv 或 txt 到电脑上,但在 mysql 上进行这样的操作好像不是很方便速度也很慢。

目前在使用的方法是将远程数据库里面的数据导出为 sql 到本地,导入本地数据库后进行操作,但这一过程也很缓慢,一个百万级数据库在 navicat 里面可能要导个半个小时,在命令行可能会快一点但没有尝试。

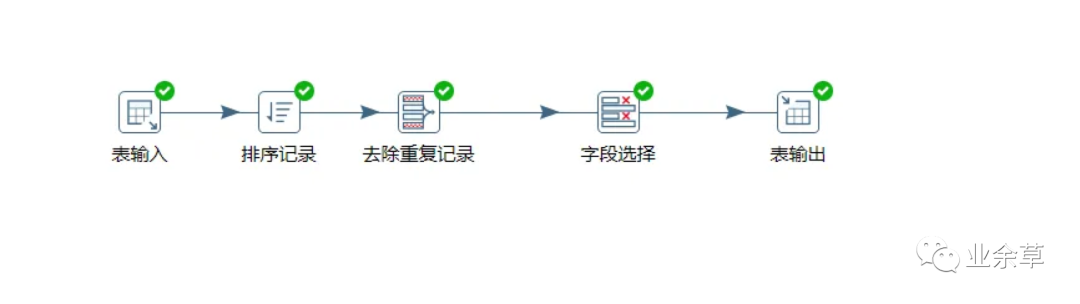

「MySQL中的去重」

基本思路是复制原表 A 结构新建一个表 B,对表 B 添加 UNIQUE 约束,然后将表 A 中的数据逐条插入表 B,约束会自动实现去重。

复制表结构

CREATE TABLE newTable LIKE oldTable;

修改表字段,因为 httpURL 太大

ALTER TABLE newTable MODIFY httpURL VARCHAR(300);

为表格添加约束条件(在Mysql5中,如果约束字段过大,则报错,因此要先执行上面的修改表字段)

ALTER TABLE newTable ADD UNIQUE(IP,timeStart);

为新表中添加数据(约束条件自动去重)

INSERT IGNORE newTable

SELECT \* FROM newTable

ORDER BY IP,timeStart;

测试的表数据量在三百万左右,去重后数据在二百万左右,在 navicat 实现时间2168.470s,命令行应该会更快。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?