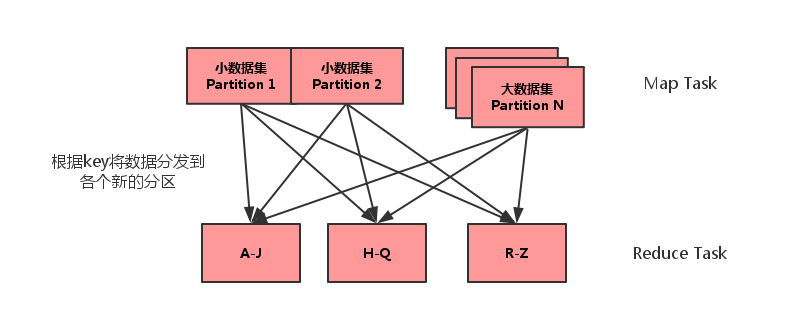

将多份数据进行关联是数据处理过程中非常普遍的用法,不过在分布式计算系统中,这个问题往往会变的非常麻烦,因为框架提供的 join 操作一般会将所有数据根据 key 发送到所有的 reduce 分区中去,也就是 shuffle 的过程。造成大量的网络以及磁盘IO消耗,运行效率极其低下,这个过程一般被称为 reduce-side-join。

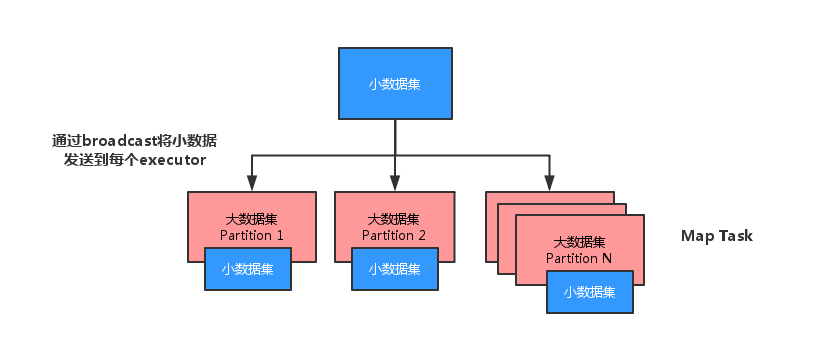

如果其中有张表较小的话,我们则可以自己实现在 map 端实现数据关联,跳过大量数据进行 shuffle 的过程,运行时间得到大量缩短,根据不同数据可能会有几倍到数十倍的性能提升。

下文将会以一个 demo 对优化过程进行说明。

原理

以前写过一篇关于spark-sql中利用broadcast join进行优化的文章,原理与那篇文章相同,这里重新画了图。

http://blog.csdn.net/lsshlsw/article/details/48694893

reduce-side-join 的缺陷在于会将key相同的数据发送到同一个partition中进行运算,大数据集的传输需要长时间的IO,同时任务并发度收到限制,还可能造成数据倾斜。

reduce-side-join 运行图如下

map-side-join 运行图如下

代码说明

数据1(个别人口信息):

身份证 姓名 ...

110 lsw

222 yyy

数据2(全国学生信息):

身份证 学校名称 学号 ...

110 s1 211

111 s2 222

112 s3 233

113 s2 244

期望得到的数据 :

身份证 姓名 学校名称

110 lsw s1

将少量的数据转化为Map进行广播,广播会将此 Map 发送到每个节点中,如果不进行广播,每个task执行时都会去获取该Map数据,造成了性能浪费。

val people_info = sc.parallelize(Array(("110","lsw"),("222","yyy"))).collectAsMap()

val people_bc = sc.broadcast(people_info)

对大数据进行遍历,使用mapPartition而不是map,因为mapPartition是在每个partition中进行操作,因此可以减少遍历时新建broadCastMap.value对象的空间消耗,同时匹配不到的数据也不会返回()。

val res = student_all.mapPartitions(iter =>{

val stuMap = people_bc.value

val arrayBuffer = ArrayBuffer[(String,String,String)]()

iter.foreach{case (idCard,school,sno) =>{

if(stuMap.contains(idCard)){

arrayBuffer.+= ((idCard, stuMap.getOrElse(idCard,""),school))

}

}}

arrayBuffer.iterator

})

也可以使用 for 的守卫机制来实现上述代码

val res1 = student_all.mapPartitions(iter => {

val stuMap = people_bc.value

for{

(idCard, school, sno) <- iter

if(stuMap.contains(idCard))

} yield (idCard, stuMap.getOrElse(idCard,""),school)

})

完整代码

<code class="hljs scala has-numbering"><span class="hljs-keyword">import</span> org.apache.spark.{SparkContext, SparkConf}

<span class="hljs-keyword">import</span> scala.collection.mutable.ArrayBuffer

<span class="hljs-class"><span class="hljs-keyword">object</span> <span class="hljs-title">joinTest</span> <span class="hljs-keyword">extends</span> <span class="hljs-title">App</span>{</span>

<span class="hljs-keyword">val</span> conf = <span class="hljs-keyword">new</span> SparkConf().setMaster(<span class="hljs-string">"local[2]"</span>).setAppName(<span class="hljs-string">"test"</span>)

<span class="hljs-keyword">val</span> sc = <span class="hljs-keyword">new</span> SparkContext(conf)

<span class="hljs-javadoc">/**

* map-side-join

* 取出小表中出现的用户与大表关联后取出所需要的信息

* */</span>

<span class="hljs-comment">//部分人信息(身份证,姓名)</span>

<span class="hljs-keyword">val</span> people_info = sc.parallelize(Array((<span class="hljs-string">"110"</span>,<span class="hljs-string">"lsw"</span>),(<span class="hljs-string">"222"</span>,<span class="hljs-string">"yyy"</span>))).collectAsMap()

<span class="hljs-comment">//全国的学生详细信息(身份证,学校名称,学号...)</span>

<span class="hljs-keyword">val</span> student_all = sc.parallelize(Array((<span class="hljs-string">"110"</span>,<span class="hljs-string">"s1"</span>,<span class="hljs-string">"211"</span>),

(<span class="hljs-string">"111"</span>,<span class="hljs-string">"s2"</span>,<span class="hljs-string">"222"</span>),

(<span class="hljs-string">"112"</span>,<span class="hljs-string">"s3"</span>,<span class="hljs-string">"233"</span>),

(<span class="hljs-string">"113"</span>,<span class="hljs-string">"s2"</span>,<span class="hljs-string">"244"</span>)))

<span class="hljs-comment">//将需要关联的小表进行关联</span>

<span class="hljs-keyword">val</span> people_bc = sc.broadcast(people_info)

<span class="hljs-javadoc">/**

* 使用mapPartition而不是用map,减少创建broadCastMap.value的空间消耗

* 同时匹配不到的数据也不需要返回()

* */</span>

<span class="hljs-keyword">val</span> res = student_all.mapPartitions(iter =>{

<span class="hljs-keyword">val</span> stuMap = people_bc.value

<span class="hljs-keyword">val</span> arrayBuffer = ArrayBuffer[(String,String,String)]()

iter.foreach{<span class="hljs-keyword">case</span> (idCard,school,sno) =>{

<span class="hljs-keyword">if</span>(stuMap.contains(idCard)){

arrayBuffer.+= ((idCard, stuMap.getOrElse(idCard,<span class="hljs-string">""</span>),school))

}

}}

arrayBuffer.iterator

})

<span class="hljs-javadoc">/**

* 使用另一种方式实现

* 使用for的守卫

* */</span>

<span class="hljs-keyword">val</span> res1 = student_all.mapPartitions(iter => {

<span class="hljs-keyword">val</span> stuMap = people_bc.value

<span class="hljs-keyword">for</span>{

(idCard, school, sno) <- iter

<span class="hljs-keyword">if</span>(stuMap.contains(idCard))

} <span class="hljs-keyword">yield</span> (idCard, stuMap.getOrElse(idCard,<span class="hljs-string">""</span>),school)

})

res.foreach(println)

</code>

273

273

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?