前言

Stable Diffusion 实战教程

目录

来聊,教会。

Stable Diffusion-安装(整合版)

一、概述

二、Stable Diffusion(SD)简介

三、Stable Diffusion基本概念

四、Stable Diffusion 整合包下载

五、Stable Diffusion 安装

六、Stable Diffusion 基础使用教程

Stable Diffusion-安装(整合版)

一、概述

使用秋叶大佬发布的【绘世整合包】作为软件,它是目前市面上最易于使用的整合包之一,无需对网络和Python有太多的前置知识,已经为AI绘画的普及做出了巨大贡献。绘世启动器整合包于2023年4月16日发布,集成了过去几个月中AI绘画集中引爆的核心需求,例如ControlNet插件和最新的深度学习技术。它能够与外部环境完全隔离开来,即使对编程没有任何知识的人也可以从零开始学习使用Stable Diffusion,而且几乎无需调整就能够体验到最新、最核心的技术。

二、Stable Diffusion(SD)简介

Stable Diffusion是一种深度学习模型,于2022年发布,由创业公司Stability AI与多个学术研究者和非营利组织合作开发。它采用了潜在扩散模型,现已开源其源代码和模型,由全球开发人员共同维护于Github上,AUTOMATIC1111维护了一个完整项目。由于Stable Diffusion的完整版需要满足网络的需求,国内多位开发者制作了不同版本的封装包,开源社区为其普及化做出了难以磨灭的贡献。

Stable Diffusion最大的特点在于其开源性,可以在配备至少8GB显存的适度GPU的大多数消费级硬件上离线运行。笔者建议显存线至少为8G。

由于AI训练和产出本质上是软硬件结合的深度学习原理,因此常常使用英伟达公司的显卡及其相关技术,比如CUDA、CUDNN和一些深度学习组件如xformer和pytorch。对学习AI的进阶非常重要,但这些要求大量的额外编程知识,容易让新手感到困难。

本文以及秋叶包都将避免这些内容,使得它们更容易理解和部署,相对于原版来说更加易于操作。

三、Stable Diffusion基本概念

大模型: 通过使用素材和SD低模生成的深度学习大模型,可以直接应用于生成图像。大模型是创作的核心素材,决定了最终作品的方向和风格。这些大模型的扩展名一般为CKPT或SAFETENSORS。建议使用至少8GB显存的GPU进行操作。

VAE: VAE是对大模型的补充,类似于滤镜,可以稳定画面的色彩范围,提高作品的美观度。VAE的扩展名一般为CKPT或SAFETENSORS。建议使用不低于8GB显存的GPU进行操作。

LoRA: LoRA是一种模型插件,需要在基于某个大模型的基础上进行深度学习后生成小型模型。需要与大模型配合使用,可以在涵盖中小范围内的风格上产生影响或增加大模型缺失的元素。如果基于SD低模生成,则在不同大模型之间更换使用时具有更好的通用性和适用性。LoRA的扩展名一般为CKPT或SAFETENSORS。

ControlNet: ControlNet是一个神级插件,让SD具备了分析图片中线条和景深等信息的能力,并反推到处理图片上。这对于创作出真正自然、真实的图像非常有用。

Stable Diffusion Web-UI(SD-WEBUI): SD-WEBUI是使用Stability AI算法制作的开源软件,可以通过浏览器操作SD。这个开源软件不仅插件齐全、易于使用,而且可以随时得到更新和支持。SD-WEBUI运行环境基于Python,因此需要一定的编程知识进行操作。

秋叶整合包: 秋叶整合包是中国大神秋叶开发的整合包,内置了与电脑本身系统隔离的Python环境和Git。可以忽略网络需求和Python环境的门槛,让更多人轻松地使用SD-WEBUI。但是,由于使用者版本和环境的不同,可能需要一定的配置和操作,还是建议具备基本的编程知识。

四、Stable Diffusion 整合包下载

网上关于这方面的教程虽然很多,但都琐碎不够完整,无法系统且有效的学习,所以我们总结出一套可以在工作中应用到的系统完整的教学!

五、Stable Diffusion 安装

为了更容易地使用SD-WEBUI,可以按以下安装步骤:

1.安装启动器运行依赖 先安装启动器的运行依赖,这是一个必须的步骤。打开“启动器运行依赖-dotnet-6.0.11.exe”文件运行来进行安装。

- 解压秋叶包,接下来,解压“sd-webui-aki-v4.2.7z”下载文件,可以在文件夹中找到SD-WEBUI本体。

通过以上步骤完成后, SD-WEBUI就可以正常运行了。建议用户多尝试各种不同的模型和插件,使用它们来创造不同的作品。

六、Stable Diffusion 基础使用教程

安装和配置完成后,即可启动SD-WEBUI。以下是启动步骤:

- 找到启动器程序

在SD-WEBUI安装目录下,找到“启动器.exe”文件,并双击打开。

- 点击“一键启动”

在打开的启动器程序窗口,点击右下角的“一键启动”按钮。

- 等待界面启动

启动器会在界面中自动运行,此时需要等待一段时间,直到程序界面正常打开。

- 浏览器中打开

启动成功后,SD-WEBUI会在浏览器中自动打开。需要注意的是,SD-WEBUI需要连接GPU才能正常运行,如果没有GPU,需要使用CPU版本。

然后这个工具会自动在浏览器中打开SD WebUI的窗口。不小心关了的时候,也可以用 http://127.0.0.1:7860 再次打开。打开的界面如下图所示:

想要在内网访问,可以看专栏里面的其他文章。

stable diffusion 局域网访问

- 运行生成图像

在SD-WEBUI界面中,输入所需素材和配置,即可生成图像。可以根据需要进行清晰度、颜色范围等参数的调整。

提示词:A girl, walking in the forest, the sun fell on her body, (masterpiece:1,2), best quality, masterpiece, highres, original, extremely detailed wallpaper, perfect lighting,(extremely detailed CG:1.2), drawing, paintbrush, looking at viewer, close-up, upper body

反向提示词:Negative prompt: Negative prompt: Negative prompt: NSFW, (worst quality:2), (low quality:2), (normal quality:2), lowres, normal quality, ((monochrome)), ((grayscale)), skin spots, acnes, skin blemishes, age spot, (ugly:1.331), (duplicate:1.331), (morbid:1.21), (mutilated:1.21), (tranny:1.331), mutated hands, (poorly drawn hands:1.5), blurry, (bad anatomy:1.21), (bad proportions:1.331), extra limbs, (disfigured:1.331), (missing arms:1.331), (extra legs:1.331), (fused fingers:1.61051), (too many fingers:1.61051), (unclear eyes:1.331), lowers, bad hands, missing fingers, extra digit,bad hands, missing fingers, (((extra arms and legs)))

参数配置:Steps: 29, Sampler: DPM++ SDE Karras, CFG scale: 7, Seed: 1518063087, Size: 512x512, Model hash: 7f96a1a9ca, Model: anything-v5-PrtRE, Clip skip: 2, Version: v1.3.2

此外,用户还可以通过下载更多的大模型和LoRA模型,来扩展SD-WEBUI的功能和应用。用户也可以自行下载已训练好的模型,以便应用到SD-WEBUI中。需要注意,在使用SD-WEBUI时,需要有足够的存储空间和显存。

这里直接将该软件分享出来给大家吧~

1.stable diffusion安装包

随着技术的迭代,目前 Stable Diffusion 已经能够生成非常艺术化的图片了,完全有赶超人类的架势,已经有不少工作被这类服务替代,比如制作一个 logo 图片,画一张虚拟老婆照片,画质堪比相机。

最新 Stable Diffusion 除了有win多个版本,就算说底端的显卡也能玩了哦!此外还带来了Mac版本,仅支持macOS 12.3或更高版本。

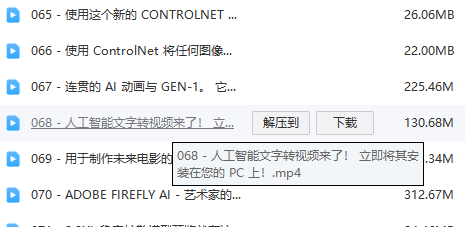

2.stable diffusion视频合集

我们在学习的时候,往往书籍源码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,一步步带你入坑stable diffusion,科学有趣才能更方便的学习下去。

3.stable diffusion模型下载

stable diffusion往往一开始使用时图片等无法达到理想的生成效果,这时则需要通过使用大量训练数据,调整模型的超参数(如学习率、训练轮数、模型大小等),可以使得模型更好地适应数据集,并生成更加真实、准确、高质量的图像。

4.stable diffusion提示词

提示词是构建由文本到图像模型解释和理解的单词的过程。可以把它理解为你告诉 AI 模型要画什么而需要说的语言,整个SD学习过程中都离不开这本提示词手册。

5.SD从0到落地实战演练

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名SD大神的正确特征了。

这份完整版的stable diffusion资料我已经打包好,需要的点击下方插件,即可前往免费领取!

2340

2340

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?