文章目录

一、概述

1.1 大数据概念

大数据是需要新处理模式才能具有更强的决策力、洞察发现力和流程优化能力来适应海量、高增长率和多样化的信息资产。

1.2 大数据面临的问题

存储:单机存储有限,需要使用集群(多台机器)存储数据;硬件上必须有足够的存储容量,软件上有对应的容灾机制。

分析:单机算力有限,也需要使用集群进行计算(需要在合理的时间内将数据变废为宝)

1.3 大数据的特点

4V Volume 数据量大 Velocity 时效性 Variety 多样性 Value 价值大

1)数据量大

B-KB-MB-GB-TB-PB-EB-ZB…

各种个人云存储解决方案:百度网盘、腾讯微云、115、lanzou、诚通、OneDriver、GoogleDriver 等

大数据产生于21世纪的互联网时代,日益进步的科技和日益增长的物质文化需求,导致了数据的大爆炸;

淘宝、支付宝、微信、QQ、抖音这些App是目前国内顶尖的流量,使用人数及其的庞大,每天可以产生极多的数据量。

2)数据时效性

双十一、618

大数据是在短时间内迅速产生(产生的时效性非常高),分析的时效性就必须因场景而异,需要在合理的时间内分析出有价值的数据。

3)数据多样性

(1)数据存储类型多样性

结构化的数据:表格、文本、SQL等

非结构化数据:视频、音频、图片

(2)数据分析类型多样性

地理位置:来自北京、中国、上海

设备信息:来自PC、手机、平板、手表、手环、眼镜

个人喜好:美女、面膜、ctrl、 数码、篮球、足球

社交网络:A可能认识B 、C ,B就可能认识C

电话号码:110,10086

网络身份证:设备MAC+电话+IP+地区

4)数据价值

警察叔叔:只关注的是否哪里违规

AI研究:犯罪预测、下棋、无人驾驶

所以在海量数据中有用的数据最为关键、这是分析数据的第一步,也就是对数据进行降噪处理(数据清洗|数据预处理)

1.4 应用场景

1)个人推荐

根据用户喜好,推荐相关资源

千人一面、千人千面、一人千面

2)风控

大数据实时流处理,根据用户行为模型进行支撑,判断该行为是否正常

3)成本预测

4)气候预测

5)人工智能

1.5 工作方向

1 业务

电商推荐、智能广告系统、专家系统、智能交通、智能医疗

2 工作方向

大数据开发工程师(实时计算、批处理、ETL、数据挖掘)、大数据运维工程师

1.6分布式

为了解决大数据存储和计算的问题,需要使用一定数量的机器,硬件设施必须足够,那软件解决方案怎么办?

如何使用软件去解决存储和分析的问题?

二、Hadoop

Hadoop由 Apache Software Foundation 公司于 2005 年秋天作为Lucene的子项目Nutch的一部分正式引入。它受到最先由 Google Lab 开发的 Map/Reduce 和 Google File System(GFS) 的启发。

2006 年 3 月份,Map/Reduce 和 Nutch Distributed File System (NDFS) 分别被纳入称为 Hadoop 的项目中。

Hadoop 是最受欢迎的在 Internet 上对搜索关键字进行内容分类的工具,但它也可以解决许多要求极大伸缩性的问题。例如,如果您要 grep 一个 10TB 的巨型文件,会出现什么情况?在传统的系统上,这将需要很长的时间。但是 Hadoop 在设计时就考虑到这些问题,采用并行执行机制,因此能大大提高效率。

HDFS:Hadoop Distributed File System 作为Hadoop 生态体系中数据的存储的软件解决方案

MapReduce:Hadoop中分布式计算框架(只需要实现少量的代码,就可以开发一个分布式的应用程序),对海量数据并行分析和计算

2.1 Hadoop生态系统

HDFS:Hadoop Distributed File System 作为Hadoop 生态体系中数据的存储的软件解决方案

MapReduce:Hadoop中分布式计算框架(只需要实现少量的代码,就可以开发一个分布式的应用程序),对海量数据并行分析和计算

HBase: 基于HDFS 的列式存储的NoSql

Hive:是一款SQL解释引擎,能够将SQL语句翻译成MR代码

Flume:分布式的日志收集系统,用于收集海量日志数据,并将其存储在hdfS中

kafka:消息队列,实现对分布式应用程序间的解耦和数据缓冲

Zookeeper:分布式协调服务,用户注册中心、配置中心、集群选举、状态检测、分布式锁

2.2 大数据分析方案

MapReduce:大数据离线批处理(代表基于磁盘,延迟30分钟+)

Spark:大数据离线批处理(代表基于内存,速度相对于MR来说快的多)

Strom/Spark Streaming/Kafka Streaming/Flink:实时流处理框架,达到对记录级别消息的毫秒级处理

三、HDFS

3.1 安装(伪集群)

1)准备虚拟机

更改IP vi /etc/sysconfig/network-scripts/ifcfg-eth0

删除MAC地址 rm -rf /etc/udev/rules.d/70-persistent-net.rules

更改主机名 vi /etc/sysconfig/network

2)安装JDK 8

略

3)配置Java环境变量

export JAVA_HOME=/home/java/jdk1.8.0_181

export PATH=$PATH:$JAVA_HOME/bin

4)配置主机名与IP的映射关系

[root@HadoopNode00 ~]# vi /etc/sysconfig/network

NETWORKING=yes

HOSTNAME=HadoopNode00

[root@HadoopNode00 ~]# vi /etc/hosts

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

192.168.11.20 HadoopNode00

5)关闭防火墙

[root@HadoopNode00 ~]# service iptables stop # 关闭防火墙

[root@HadoopNode00 ~]# chkconfig iptables off # 关闭防火墙开机自动启动

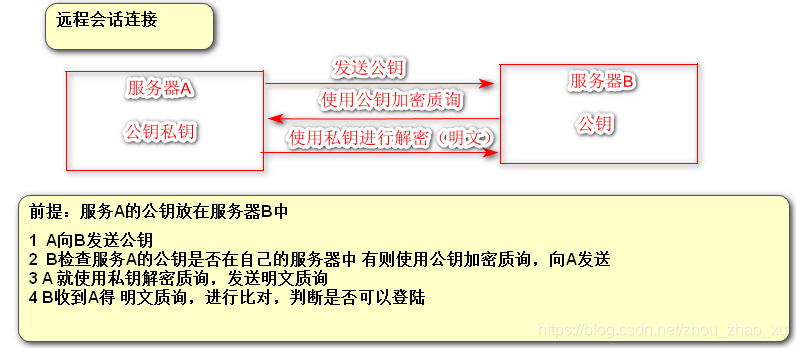

6)ssh免密登陆

SSH是Secure Shell 的缩写,SSH为建立在应用层山的安全协议,专为远程登陆会话和其他网络服务提供安全协议支持。

基于口令的安全验证:基于用户名和密码 root | 123456

基于密钥的安全验证:需要依靠密钥

[root@HadoopNode00 ~]# ssh-keygen -t rsa # 生成密钥

[root@HadoopNode00 ~]# ssh-copy-id HadoopNOde00

7)解压Hadoop

解压Hadoop到指定目录

[root@HadoopNode00 ~]# mkdir /home/hadoop/

[root@HadoopNode00 ~]# tar -zxvf /home/hadoop/hadoop-2.6.0.tar.gz -C /home/hadoop

8)配置Hadoop环境变量

export HADOOP_HOME=/home/hadoop/hadoop-2.6.0

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

HADOOP_HOME环境变量被第三方依赖,hbase hive flume在集成HADOOP的时候,是通过HADOOP_HOME找到hadoop的位置

9)配置 etc/hadoop/core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://HadoopNode00:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/hadoop-2.6.0/hadoop-${user.name}</value>

</property>

10)配置 etc/hadoop/hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

11)格式化namenode

第一次启动hdfs的时候,需要格式化namenode

[root@HadoopNode00 ~]# hdfs namenode -format

[root@HadoopNode00 ~]# tree /home/hadoop/hadoop-2.6.0/hadoop-root

/home/hadoop/hadoop-2.6.0/hadoop-root

└── dfs

└── name

└── current

├── fsimage_0000000000000000000

├── fsimage_0000000000000000000.md5

├── seen_txid

└── VERSION

3 directories, 4 files

12)启动hdfs

start-dfs.sh # 开启HDFS

stop-dfs.sh # 关闭hdfs

进入web界面

http://主机名:50070

windows下 配置域名与ip的映射:C:\Windows\System32\drivers\etc \hosts

3.2 HDFS Shell 相关操作

1)hdfs shell

[root@HadoopNode00 ~]# hadoop fs

Usage: hadoop fs [generic options]

[-appendToFile <localsrc> ... <dst>]

[-cat [-ignoreCrc] <src> ...]

[-checksum <src> ...]

[-chgrp [-R] GROUP PATH...]

[-chmod [-R] <MODE[,MODE]... | OCTALMODE> PATH...]

[-chown [-R] [OWNER][:[GROUP]] PATH...]

[-copyFromLocal [-f] [-p] [-l] <localsrc> ... <dst>]

[-copyToLocal [-p] [-ignoreCrc] [-crc] <src> ... <localdst>]

[-count [-q] [-h] <path> ...]

[-cp [-f] [-p | -p[topax]] <src> ... <dst>]

[-createSnapshot <snapshotDir> [<snapshotName>]]

[-deleteSnapshot <snapshotDir> <snapshotName>]

[-df [-h] [<path> ...]]

[-du [-s] [-h] <path> ...]

[-expunge]

[-get [-p] [-ignoreCrc] [-crc] <src> ... <localdst>]

[-getfacl [-R] <path>]

[-getfattr [-R] {

-n name | -d} [-e en] <path>]

[-getmerge [-nl] <src> <localdst>]

[-help [cmd ...]]

[ ..]

[-usage [cmd ...]]

Generic options supported are

-conf <configuration file> specify an application configuration file

-D <property=value> use value for given property

-fs <local|namenode:port> specify a namenode

-jt <local|resourcemanager:port> specify a ResourceManager

-files <comma separated list of files> specify comma separated files to be copied to the map reduce cluster

-libjars <comma separated list of jars> specify comma separated jar files to include in the classpath.

-archives <comma separated list of archives> specify comma separated archives to be unarchived on the compute machines.

The general command line syntax is

bin/hadoop command [genericOptions] [commandOptions]

2)上传文件

# 上传 root目录下的install.log 到hdfs 根目录下

[root@HadoopNode00 ~]# hadoop fs -put /root/install.log /1.txt

3 ) ls文件

# 找到到了刚才上传为文件命名为1.txt

[root@HadoopNode00 ~]# hadoop fs -ls /

Found 1 items

-rw-r--r-- 1 root supergroup 8901 2019-09-17 23:28 /1.txt

4)下载文件

[root@HadoopNode00 ~]# hadoop fs -get /1.txt /root/baizhi.txt

5)删除文件

[root@HadoopNode00 ~]# hadoop fs -rm /2.txt

19/09/17 23:36:05 INFO fs.TrashPolicyDefault: Namenode trash configuration: Deletion interval = 0 minutes, Emptier interval = 0 minutes.

Deleted /2.txt

6)查看文件

[root@HadoopNode00 ~]# hadoop fs -cat /1.txt

Installing libgcc-4.4.7-23.el6.x86_64

warning: libgcc-4.4.7-23.el6.x86_64: Header V3 RSA/SHA1 Signature, key ID c105b9de: NOKEY

Installing setup-2.8.14-23.el6.noarch

7)创建文件夹

[root@HadoopNode00 ~]# hadoop fs -mkdir /baizhi

[root@HadoopNode00 ~]# hadoop fs -ls /

Found 2 items

-rw-r--r-- 1 root supergroup 8901 2019-09-17 23:28 /1.txt

drwxr-xr-x - root supergroup 0 2019-09-17 23:37 /baizhi

8)复制文件

[root@HadoopNode00 ~]# hadoop fs -cp /1.txt /baizhi/

[root@HadoopNode00 ~]# hadoop fs -ls /

Found 2 items

-rw-r--r-- 1 root supergroup 8901 2019-09-17 23:28 /1.txt

drwxr-xr-x - root supergroup 0 2019-09-17 23:38 /baizhi

[root@HadoopNode00 ~]# hadoop fs -ls /baizhi

Found 1 items

-rw-r--r-- 1 root supergroup 8901 2019-09-17 23:38 /baizhi/1.txt

9)开启回收站机制

core-site.xml

<property>

<name>fs.trash.interval</name>

<value>1</value>

</property>

设置一分钟延迟

3.3 Java API 操作HDFS

(1) 依赖

<!-- https://mvnrepository.com/artifact/org.apache.hadoop/hadoop-common -->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.6.0</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.hadoop/hadoop-hdfs -->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.6.0</version>

</dependency>

(2)Windows 配置Hadoop环境

- 解压hadoop到指定的目录

- 拷贝hadoop.dll和winutils.exe到hadoop/bin 目录下

- 配置Hadoop环境变量

- 配置主机名和IP的映射关系

(3)权限不足解决方案

org.apache.hadoop.security.AccessControlException: Permission denied: user=Administrator, access=WRITE, inode="/baizhi":root:supergroup:drwxr-xr-x

1)配置 hdfs-site.xml

将权限检查关闭

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

2)方案2

-DHADOOP_USER_NAME=root

3)方案3

System.setProperty("HADOOP_USER_NAME", "root");

(3)相关操作

package com.baizhi.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.*;

import org.apache.hadoop.io.IOUtils;

import org.junit.Before;

import org.junit.Test;

import org.junit.experimental.theories.suppliers.TestedOn;

import sun.awt.geom.AreaOp;

import java.io.FileInputStream;

import java.io.FileOutputStream;

import java.io.IOException;

public class App {

private Configuration configuration;

private FileSystem fileSystem;

@Before

public void getClient() throws Exception {

System.setProperty("HADOOP_USER_NAME", "root");

/*

* 准备配置对象

* */

configuration = new Configuration();

/*

* 添加相应的配置文件*/

configuration.addResource("core-site.xml");

configuration.addResource("hdfs-site.xml");

/*

* 通过FileSystem.newInstance 获得客户端对象*/

fileSystem = FileSystem.newInstance(configuration);

}

@Test

public void testUpload01() throws Exception {

/*

*

* 源文件 | 目标文件

* Path 对象

* */

fileSystem.copyFromLocalFile(new Path("G:\\A.docx"), new Path("/baizhi/2.docx"));

}

@Test

public void testUpload02() throws Exception {

/*

* 准备 本地输入流

* */

FileInputStream inputStream = new FileInputStream("G:\\A.docx");

/*

* 准备 hdfs 输出流

* */

FSDataOutputStream outputStream = fileSystem.create(new Path("/baizhi/3.docx"));

/*

* 使用工具类进行拷贝

* */

IOUtils.copyBytes(inputStream, outputStream, 1024, true);

}

@Test

public void testDownload01() throws Exception {

fileSystem.copyToLocalFile(false, new Path("/1.txt"), new Path("G:\\3.txt"), true);

}

@Test

public void testDownload02() throws Exception {

FileOutputStream outputStream = new FileOutputStream("G:\\4.txt");

FSDataInputStream inputStream = fileSystem.open(new Path("/1.txt"));

IOUtils.copyBytes(inputStream, outputStream, 1024, true);

}

@Test

public void test011() throws IOException {

RemoteIterator<LocatedFileStatus> list = fileSystem.listFiles(new Path("/"), true);

while (list.hasNext()) {

LocatedFileStatus locatedFileStatus = list.next();

Path path = locatedFileStatus.getPath();

System.out.println(path.toString());

}

}

@Test

public void test02() throws Exception{

fileSystem.delete(new Path("/baizhi"),false);

}

@Test

public void test03() throws Exception{

boolean exists = fileSystem.exists(new Path("/1.txt"));

if (exists){

System.out.println("文件存在");

}else {

System.out.println("文件不存在");

}

}

@Test

public void testy04() throws Exception{

fileSystem.mkdirs(new Path("/baizhi1243"));

}

}

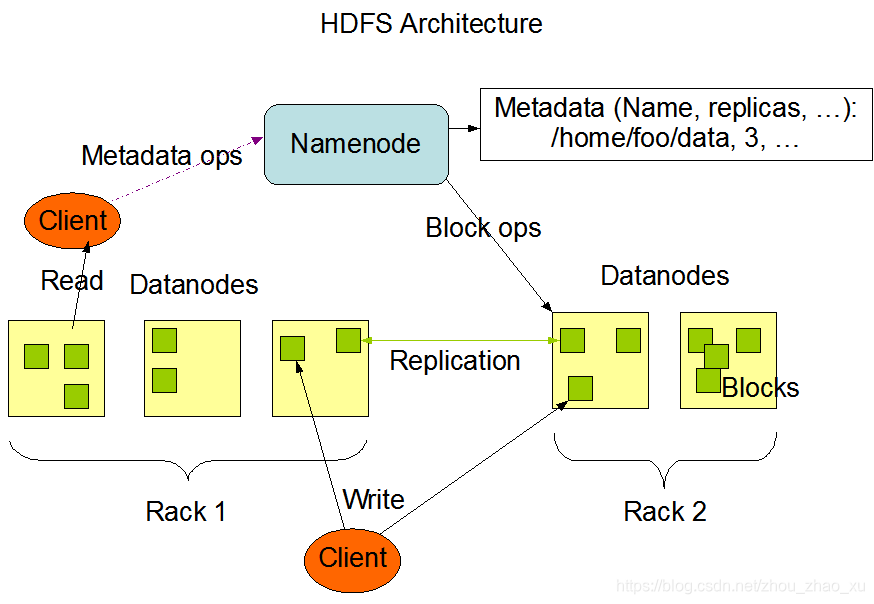

3.4 HDFS Architecture

HDFS为主从架构,HDFS中有一个主的NameNode,管理系统命名空间和管理客户端对文件的访问,其中还有DataNode负责和NameNode进行协调工作,DataNode负责数据的存储,在存储数据(文件)的过程中一个文件会被分成一个块或者多个块,在NameNode中存储了一些数据(存储的数据是块到DataNode的映射关系),datanode还根据NameNode的指令创建删除复制块。

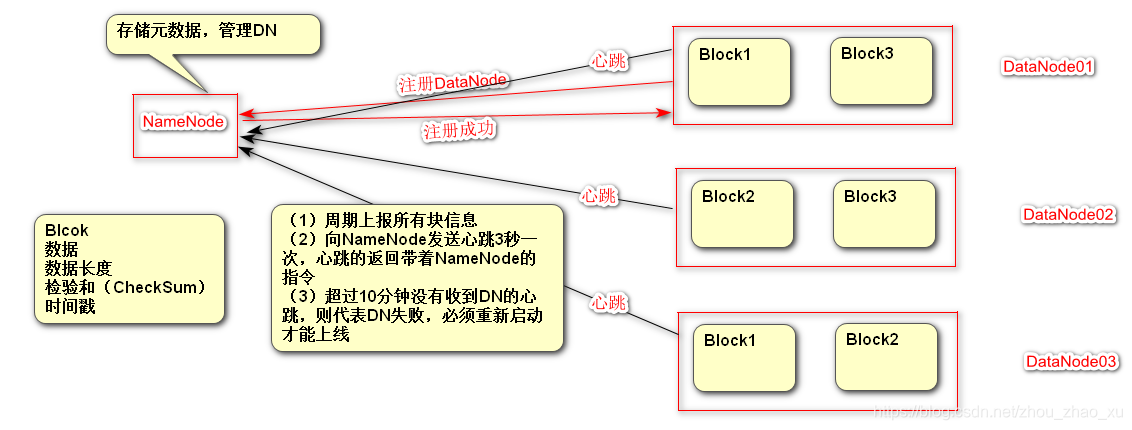

namenode:存储元数据(用户描述数据的数据),负责管理DataNode

datanode:用于存储数据块的节点,负责响应客户端的对块的读写请求,向NameNode汇报自己的块信息

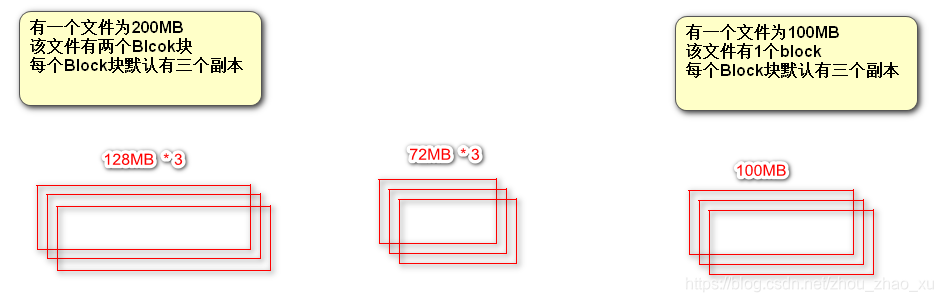

block块:数据块,hdfs中对文件拆分的最小单元,切分尺度默认为128MB,每个块在默认情况下有三个副本

rack:机架,使用机架配置文件对存储节点进行物理编排,用于优化存储和计算

1)什么是Block块

<property>

<name>dfs.blocksize</name>

<value>134217728</value>

<description>

The default block size for new files, in bytes.

You can use the following suffix (case insensitive):

k(kilo), m(mega), g(giga), t(tera), p(peta), e(exa) to specify the size (such as 128k, 512m, 1g, etc.),

Or provide complete size in bytes (such as 134217728 for 128 MB).

</description>

</property>

(1)为什么块的大小为128MB?

在Hadoop1.x 块大小默认为64MB,在Hadoop2.x 默认为128MB

工业限制:一般来说机械硬盘的读取速度100MB左右

软件优化:通常认为最佳状态为寻址时间为传输时间的100分之一

(2)Block块的大小能否随意设置?

不能,如果BlockSize过大,可能导致多余存储空间浪费,导致存取时间过长 如果BlockSize过小,会导致寻址时间过长,同样造成效率低下。

(3)HDFS为什么不适合存储小文件

| 文件 | namenode内存占用 | datanode磁盘占用 |

|---|---|---|

| 128MB 单文件 | 1个Blcok元数据的大小 | 128MB |

| 128*1MB | 128个Block元数据的大小 | 128MB |

namenode内存会过于紧张

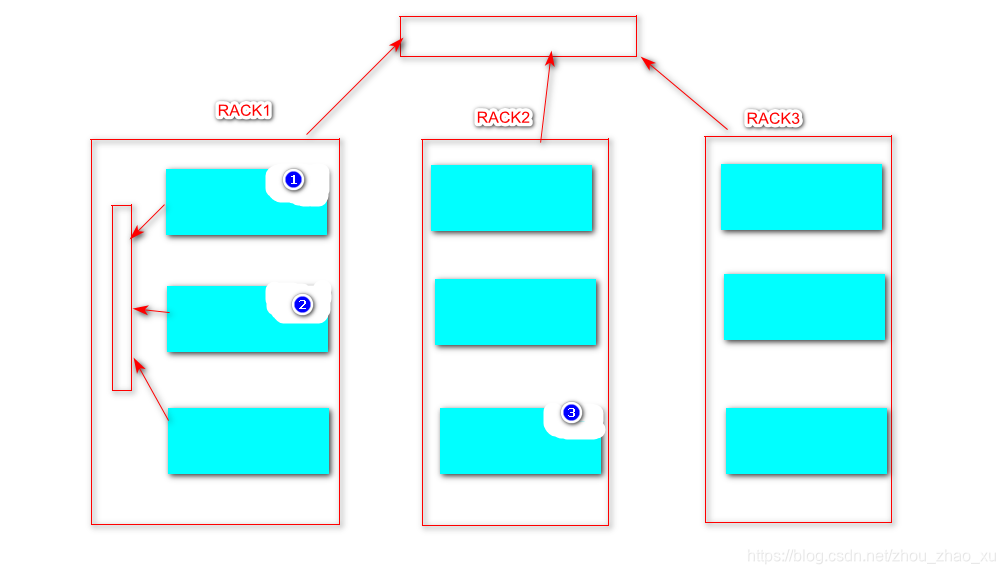

2)Rack Awareness 机架感知

对于常见情况,当复制因子为3时,HDFS的放置策略是将一个副本放在本地机架中的一个节点上,另一个放在本地机架中的另一个节点上,将最后一个放在另一个机架中的另一个节点上。此策略可以减少机架间写入流量,从而提高写入性能。机架故障的可能性远小于节点故障的可能性;此策略不会影响数据可靠性和可用性保证。但是,它确实减少了读取数据时使用的聚合网络带宽,因为块只放在两个唯一的机架而不是三个。使用此策略时,文件的副本不会均匀分布在机架上。三分之一的副本位于一个节点上,三分之二的副本位于一个机架上,另外三个副本均匀分布在剩余的机架上。此策略可提高写入性能,而不会影响数据可靠性或读取性能。

查看默认机架

[root@HadoopNode00 ~]# hdfs dfsadmin -printTopology

Rack: /default-rack

192.168.11.20:50010 (HadoopNode00)

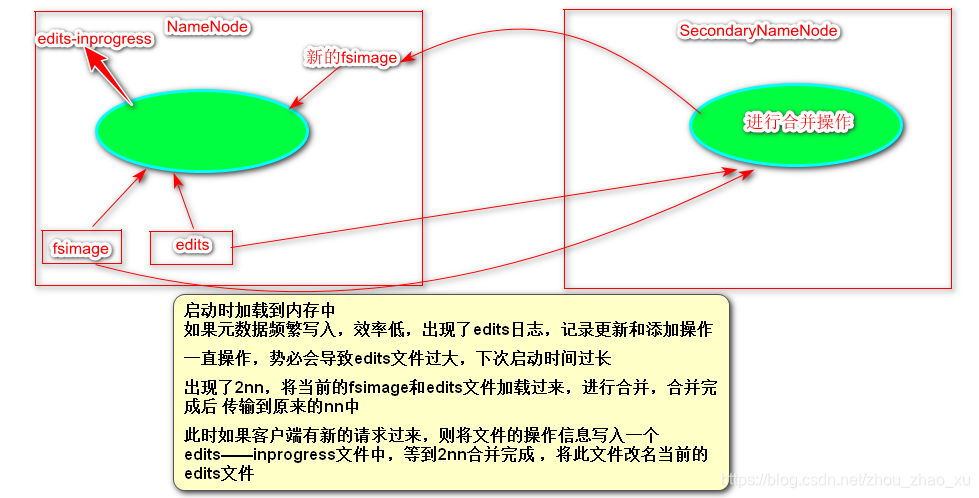

3)NameNode 和 SecondaryNameNode 的 关系 (重点)

fsimage文件:元数据信息的备份,会被加载到内存中

edits文件:Edits文件帮助记录增加和更新操作,提高效率

namenode在启动时会加载fsimage和edits的文件,所以在第一次启动的时候需要格式化namenode

当用户上传文件的时候或者进行其他操作的时候,操作记录会写入edits文件中,这样edits和fsimage文件加起来的元数据永远是最新的。

如果此时用户一直进行操作的话,edits文件会越来越大,这就导致了在下次启动的时候启动速度过慢。

为了解决这个问题,出现了SecondaryNameNode ,将当前的NameNode的edits和fsimage文件拷贝到自己的节点上,进行合并操作,在合并完成后,将新的fsimage文件传输到原来的namenode中,此时namanode再去加载最新的fsimage。

新的问题:在SecondaryNameNode 进行拷贝操作的时候,如果有客户端读写请求过来,势必要追加相应的操作记录到edits文件中,但是此时正在进行拷贝操作,改变则代表会造成数据紊乱,怎么办?解办法是:会有一个新的叫做edits-inprogress的文件被创建,新的操作将写入此文件中,等待SecondaryNameNode合并完成,将edits-inprogress文件改名成为当前的edits文件。

4)检查点

namenode使用fsimage和edits文件保存元数据,2nn会定期的下载主的(Active)namenode的fsimage文件和edits 文件,并在本地进行合并。

合并的时机就称之为检查点

检查点有两种触发机制:

(1) 默认一个小时进行合并

(2) 操作数量达到100W次进行合并

<property>

<name>dfs.namenode.checkpoint.period</name>

<value>3600s</value>

<description>

The number of seconds between two periodic checkpoints.

Support multiple time unit suffix(case insensitive), as described

in dfs.heartbeat.interval.

</description>

</property>

<property>

<name>dfs.namenode.checkpoint.txns</name>

<value>1000000</value>

<description>The Secondary NameNode or CheckpointNode will create a checkpoint

of the namespace every 'dfs.namenode.checkpoint.txns' transactions, regardless

of whether 'dfs.namenode.checkpoint.period' has expired.

</description>

</property>

5)Safemode

在启动时候加载fsimage和edits文件,等待其他的DataNode报告块信息,直至大部分块可用。在次期间,集群处于SafeMode,NameNode的安全模式本质上是HDFS集群的只读模式,它不允许对文件系统或块进行任何修改。

通常,在DataNode报告大多数文件系统块可用之后,NameNode会自动离开Safemode。

可以手动的进入或者退出SafeMode

[root@HadoopNode00 ~]# hdfs dfsadmin -safemode enter

Safe mode is ON

[root@HadoopNode00 ~]# hadoop fs -put /root/1.txt /

put: Cannot create file/1.txt._COPYING_. Name node is in safe mode.

[root@HadoopNode00 ~]# hdfs dfsadmin -safemode leave

Safe mode is OFF

[root@HadoopNode00 ~]# hadoop fs -put /root/1.txt /

6)DataNode工作机制

启动的时候会注册DataNode

周期向NameNode上报块信息,并且对其信息状态进行反馈,DataNode进行相应的操作

心跳不能出现10分钟以上的断连,必须重启DataNode才能重现上线

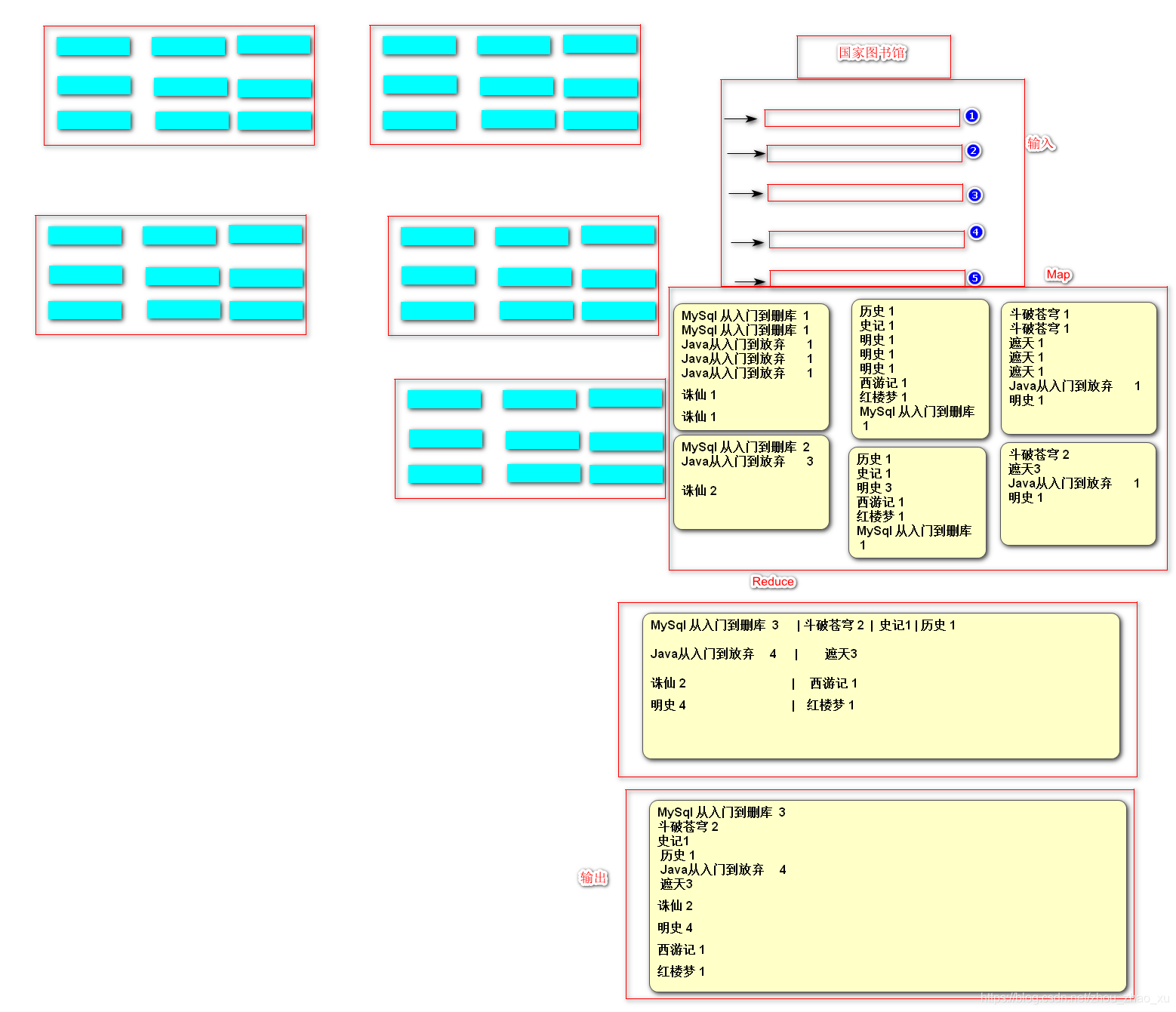

四、MapReduce

4.1 概述

MapReduce是一种编程模型,用于大规模数据集(大于1TB)的并行运算。概念"Map(映射)“和"Reduce(归约)”,是它们的主要思想,都是从函数式编程语言里借来的,还有从矢量编程语言里借来的特性。它极大地方便了编程人员在不会分布式并行编程的情况下,将自己的程序运行在分布式系统上。 当前的软件实现是指定一个Map(映射)函数,用来把一组键值对映射成一组新的键值对,指定并发的Reduce(归约)函数,用来保证所有映射的键值对中的每一个共享相同的键组。

MapReduce是Hadoop框架的一个并行计算框架,将一个计算任务拆分成两个阶段:Map和Reduce

MapReduce计算框架充分利用了 存储节点(DataNode)所在物理主机的计算资源进行并行计算

默认情况下NodeManager会将本进程运行 的节点的计算资源抽像成8个计算单元,每个单元称之为一个Contioner,所有的NodeManager都由ResourceManager调度,ResourceManager负责计算资源的统筹分配。

一是软件框架 二是并行处理 三 可靠容错 四 大规模计算 五 处理海量数据

MapReduce擅长做大数据处理,MapReduce的思想就是分而治之

-

Map负责**”分“**,即把庞大且复杂的任务分解成若干个”简单的任务“来处理,简单的任务包含三层

- 是对数据或者计算模型相对于原任务要大大缩小

- 就近计算原则,就是任务会被分配到存放所需数据的节点上进行计算

- 这些小任务不止一个且并行计算,而且彼此间没有依赖关系

-

Reducer负责对Map的计算结果进行汇总

4.2 为什么使用MR?

package com.baizhi.hdfs;

import java.io.BufferedReader;

import java.io.File;

import java.io.FileReader;

import java.io.FileWriter;

public class CleanApp {

public static void main(String[] args) throws Exception {

File file = new File("G:\\Note\\Day02-Hadoop\\数据文件\\access.tmp2019-05-19-10-28.log");

BufferedReader bufferedReader = new BufferedReader(new FileReader(file));

FileWriter fileWriter = new FileWriter("G:\\Note\\Day02-Hadoop\\数据文件\\clean.log");

while (true) {

String line = bufferedReader.readLine();

if (line == null) {

bufferedReader.close();

fileWriter.close();

return;

}

boolean contains = line.contains("thisisshortvideoproject'slog");

if (contains) {

String s = line.split("thisisshortvideoproject'slog")[0];

fileWriter.write(s.trim() + "\n");

fileWriter.flush();

}

}

}

}

上述代码是对日志进行简单的清晰,在数据量少的时候一点问题都没有,但是数据量一旦增加,就可能无法胜任需求,因为无法在合理的时间内完成计算,此时单机性能已经成为计算的瓶颈,但是手写分布式应用程序难度太大,有现成的框架可以使用,那就是MR!

4.3 YARN 环境搭建

(1)什么是 YARN ?

Yarn作为一个资源调度平台,有一个全局的管理者叫做ResourceManager,ResourceManager负责对集群的整体计算及资源做统筹规划,有各个节点的管理者叫做NodeManager,负责向ResourceManager报告其计算资源的使用情况,在NodeManger中有一个MRAppMaster管理这里当前运行的MRApp,其任务是协调来自ResourceManager的资源,并与NodeManager一起执行和监视任务。

ResourceManager:负责对集群的整体计算及资源做统筹规划

NodeManager:管理主机上的计算组员,负责向RM 汇报自身的状态信息

MRAppMaster:计算任务的Master,负责申请计算资源,协调计算任务

YARN Child:负责做实际计算任务

Container:计算资源的抽象单元

(2)配置YARN

etc/hadoop/yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<description>The hostname of the RM.</description>

<name>yarn.resourcemanager.hostname</name>

<value>HadoopNode00</value>

</property>

etc/hadoop/mapred-site.xml

etc/hadoop/ 下其实是没有这个文件 的但是有yitmp结尾的文件,将其改名即可

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

(3)启动YARN

[root@HadoopNode00 ~]# start-yarn.sh

starting yarn daemons

starting resourcemanager, logging to /home/hadoop/hadoop-2.6.0/logs/yarn-root-resourcemanager-HadoopNode00.out

localhost: starting nodemanager, logging to /home/hadoop/hadoop-2.6.0/logs/yarn-root-nodemanager-HadoopNode00.out

[root@HadoopNode00 ~]# jps

60192 Jps

60046 ResourceManager

60142 NodeManager

web 界面: hostname:8088

4.4 MR 入门程序

需求:

wangkai gjf zkf suns gzy

wangkai zkf suns gzy

zkf suns gzy hxz leijun

wangkai 2

gjf 1

zkf 3

suns 3

gzy 3

hxz 1

leijun 1

(1)依赖

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.6.0</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.6.0</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-mapreduce-client-jobclient</artifactId>

<version>2.6.0</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-mapreduce-client-core</artifactId>

<version>2.6.0</version>

</dependency>

(2)Mapper 逻辑

package com.baizhi.mr.test01;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

import java.io.IOException;

/*

* keyIn LongWritable (Long) 输入文本字节偏移量

* valueIn Text (String) 输入文本行

* keyOut Text(String)

* valueOut IntWritable(Int)

* */

public class WCMapper extends Mapper<LongWritable, Text,Text, IntWritable> {

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

String[] names = value

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

947

947

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?