6 . reduceByKey运行多个reduce操作,每个key对应一个reduce操作,只不过reduce返回的是结果,reduceByKey返回的是一个新的RDD。

7 . Spark有很多根据键来合并数据的操作,其中大部分都是用combineByKey来实现的。下面是一个利用combineByKey来计算每个key的value平均值的例子。

val input = sc.textFile("...",2)

val result = input.combineByKey(

(v)=>(v,1),

(acc:(Int,Int),v)=>(acc._1+v,acc._2+1),

(acc1:(Int,Int),acc2:(Int,Int))=>(acc1._1+acc2._1,acc1._2+acc2._2)).map{

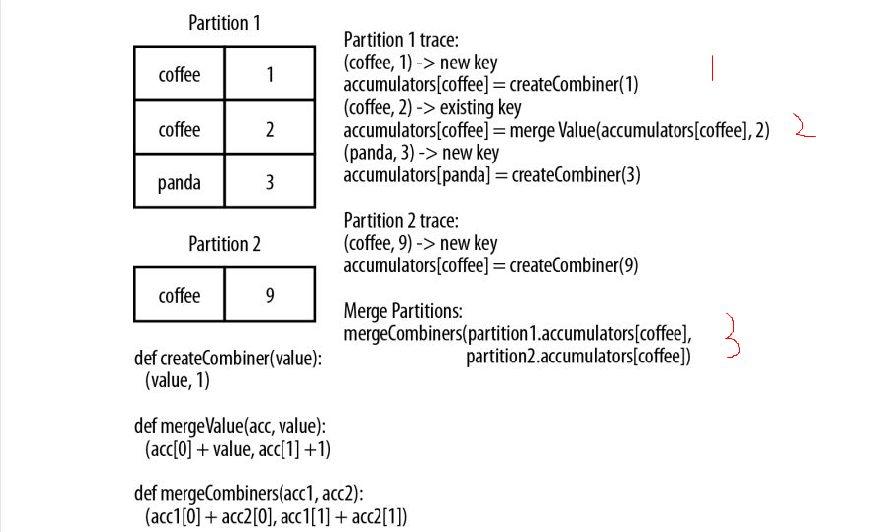

case (key,value) => (key,value._1/value._2.toDouble)}用上面这个例子来看看combineByKey的执行过程。如下图所示:

首先在各个分区内,如果碰到一个新的key就要创建一个Combiner并要赋予初值,这是图片中标1的地方;如果是碰到一个之前已有的key,则创建mergeValue,如图中标2的地方;在每个分区中都要这样创建Combiner和mergeValue,这样在分区内结束后,就要创建mergeCombiners,来合并每个分区的combiner。combineByKey并不要求输入输出的类型一致。

本文介绍了Spark中的reduceByKey操作,它用于对每个key执行reduce操作,并返回新的RDD。同时,文章重点探讨了combineByKey函数,通过一个实例展示了如何使用它来计算key的value平均值,并详细解释了其执行流程,包括在各分区内部创建Combiner、mergeValue以及mergeCombiners的过程。

本文介绍了Spark中的reduceByKey操作,它用于对每个key执行reduce操作,并返回新的RDD。同时,文章重点探讨了combineByKey函数,通过一个实例展示了如何使用它来计算key的value平均值,并详细解释了其执行流程,包括在各分区内部创建Combiner、mergeValue以及mergeCombiners的过程。

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?