前言

想必HDFS集群的起停操作对于HDFS的使用者来说绝对不是一件陌生的事情.一般情况下我们重启集群服务是出于这2点原因:1).集群新增配置项,需要重启集群服务才能生效.2).对集群相关jar包程序进行了更新,需要重启服务来运行最新的jar包.于是我们重启了集群,一般的我们看它是否启动成功,一定会关注它的输出日志.比如说在HDFS中,我们会比较关注NameNode的启动日志.当然这的确是一个有效的办法,但是我们是否有其他更方便快捷的方法呢?比如说我不想登到NameNode所在节点上去看日志.最后的答案是有的.至于这里面到底是什么一个过程和原理呢?这就是本文将要重点阐述的主题:HDFS的StartupProgress.

HDFS的StartupProgress

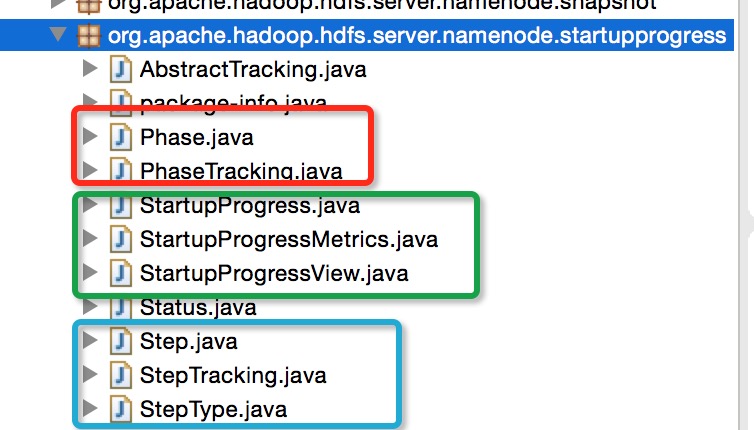

这里可以把StartupProgress理解为Startup,Startup就是启动的意思.HDFS的Startup启动过程主要指的是NameNode的启动.在hdfs server端的project下有专门的package目录来存放这部分的代码.正如StartupProgress名称所展示的那样,此模块的功能并不是一个HDFS启动控制的角色,而是说是一种启动跟踪,并进行进度汇报的一个角色.因为HDFS的StartupProgress包下的代码并不多,我们可以做一个详细的分析.相关类文件如下图所示:

在上图中,我总共将此包下的相关类分成了3大类:

第一大类,StartupProgress启动进度信息核心类:此大类中包括了以StartupProgress为核心的类以及相关周边类, StartupProgressView和StartupProgressMetrics.前者是StartupProgress类的一个”瞬时数据拷贝”,后者是StartupProgress的统计计数类.

第二大类,Phase阶段类:在NameNode的启动过程中,会经历很多个阶段,而每个阶段的执行情况就是由这里的Phase类所控制.

第三大类,Set阶段步骤类:Set步骤相比于Phase阶段而言,是更细粒度一级的单位,用一句话来概况就是每个Phase阶段内包含了一个或多个Step.

背景知识: NameNode的启动过程

在学习了解HDFS StartupProgress内部代码之前,我们有必要事先了解NameNode的启动过程.下面是NameNode启动过程的简要描述:

1.NameNode启动开始,首先加载fsImage镜像文件,里面将会花比较多的时间解析这个文件.

2.FsImage镜像文件加载完毕之后,apply应用editlog日志文件到NameNode的内存中,如果editlog非常多,也会消耗一定的时间.

3.EditLog应用完毕,NameNode会做一次checkpoint操作.此时会生成一个新的fsImage镜像文件,也就是说,此时的fsImage文件已经是最新的元数据了.

4.以上文件数据全部加载完毕之后,NameNode将会进入SafeMode安全模式,等待DataNode块的上报.上报块数达到安全模式所规定的阈值要求,安全模式自然就会退出,随后NameNode正式启动完毕.

StartupProgress内的阶段和步骤

上节NameNode的4个启动过程在StartupProgress的Phase类都有相对应的声明,代码如下:

public enum Phase {

/**

* The namenode is loading the fsimage file into memory.

*/

LOADING_FSIMAGE("LoadingFsImage", "Loading fsimage"),

/**

* The namenode is loading the edits file and applying its operations to the

* in-memory metadata.

*/

LOADING_EDITS("LoadingEdits", "Loading edits"),

/**

* The namenode is saving a new checkpoint.

*/

SAVING_CHECKPOINT("SavingCheckpoint", "Saving checkpoint"),

/**

* The namenode has entered safemode, awaiting block reports from data nodes.

*/

SAFEMODE("SafeMode", "Safe mode");

...在每个阶段内,由更细粒度的Step构成.StartupProgress包下的StepType类中总共定义了如下几类的Step:

public enum StepType {

/**

* The namenode has entered safemode and is awaiting block reports from

* datanodes.

*/

AWAITING_REPORTED_BLOCKS("AwaitingReportedBlocks", "awaiting reported blocks"),

/**

* The namenode is performing an operation related to delegation keys.

*/

DELEGATION_KEYS("DelegationKeys",

本文详细探讨了HDFS的StartupProgress,它是NameNode启动过程的跟踪和进度报告工具。通过分析HDFS StartupProgress的代码结构,揭示了NameNode启动的Phase和Step,以及它们的状态变化。此外,文章还介绍了如何通过StartupProgressView获取启动进度信息,并提供了通过HTTP请求查看启动进度的方法。

本文详细探讨了HDFS的StartupProgress,它是NameNode启动过程的跟踪和进度报告工具。通过分析HDFS StartupProgress的代码结构,揭示了NameNode启动的Phase和Step,以及它们的状态变化。此外,文章还介绍了如何通过StartupProgressView获取启动进度信息,并提供了通过HTTP请求查看启动进度的方法。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

349

349

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?