前置条件:

1、已经装好jdk的机器

2、已经存在了一套zookeeper

3、已经下载好安装包(http://kafka.apache.org/downloads)

4、会敲键盘

开始安装:

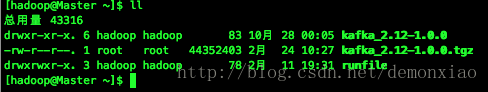

在这边,我选择的是kafka_2.12的版本,下载好之后是一个tgz的压缩包,传到服务器后用tar命令解压

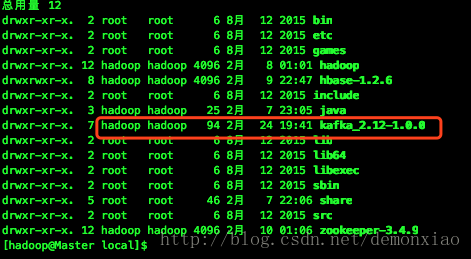

tar -zxvf kafka_2.12-1.0.0.tgz接着把解压后的文件移动到/usr/local/目录下

进入目录里面。使用mkdir命令创建一个logs文件夹用于后续存放运行时的日志用:

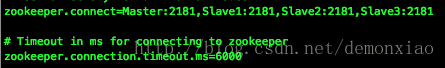

mkdir logs接着到config中。使用vi命令打开 server.properties,然后修改下列配置:

broker.id //当前节点的ID,直接用数值表示0123456即可,别重复就好

num.partitions //控制设定分区

zookeeper.connect //zookeeper的集群地址

其他的就默认了。

接着把配置完成的目录用scp命令传送到其他的节点当中,有几个节点就复制几份。

scp -r /usr/local/kafka_2.12-1.0.0 Slave1:/home/hadoop/复制完成之后,记得修改/config/server.properties文件当中的broker.id的值,根据顺序加上去。

最后在每个节点中的bin目录下。启动kafka:

sh ./kafka-server-start.sh /usr/local/kafka_2.12-1.0.0/config/server.properties > /usr/local/kafka_2.12-1.0.0/logs/logs &

启动完成之后。就可以使用命令测试了。

测试kafka:

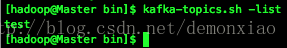

首先使用命令创建一个名为test的topic:

./kafka-topics.sh -create -zookeeper Master:2181,Slave1:2181,Slave2:2181,Slave3:2181 --replication-factor 4 --partitions 4 --topic test创建完成之后,使用命令查询一下topic:

./kafka-topics.sh -list -zookeeper Master:2181,Slave1:2181,Slave2:2181,Slave3:2181

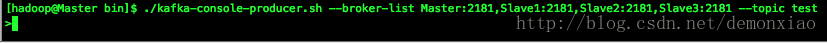

接着,我们新建一个发布端:

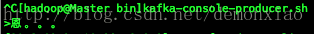

./kafka-console-producer.sh --broker-list Master:2181,Slave1:2181,Slave2:2181,Slave3:2181 --topic test接着在其他节点,新建消费端:

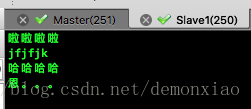

./kafka-console-consumer.sh --zookeeper Master:2181,Slave1:2181,Slave2:2181,Slave3:2181 --topic test --from-beginning新建完成之后。在发布端里随便输入点东西试试:

消费端:

以上

691

691

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?