使用的开发工具:scala2.10.4、Idea16、JDK8

对于电脑配置不错或和Spark集群在同一个网下的朋友,可以使用方法1;若不是请使用方法2

方法1

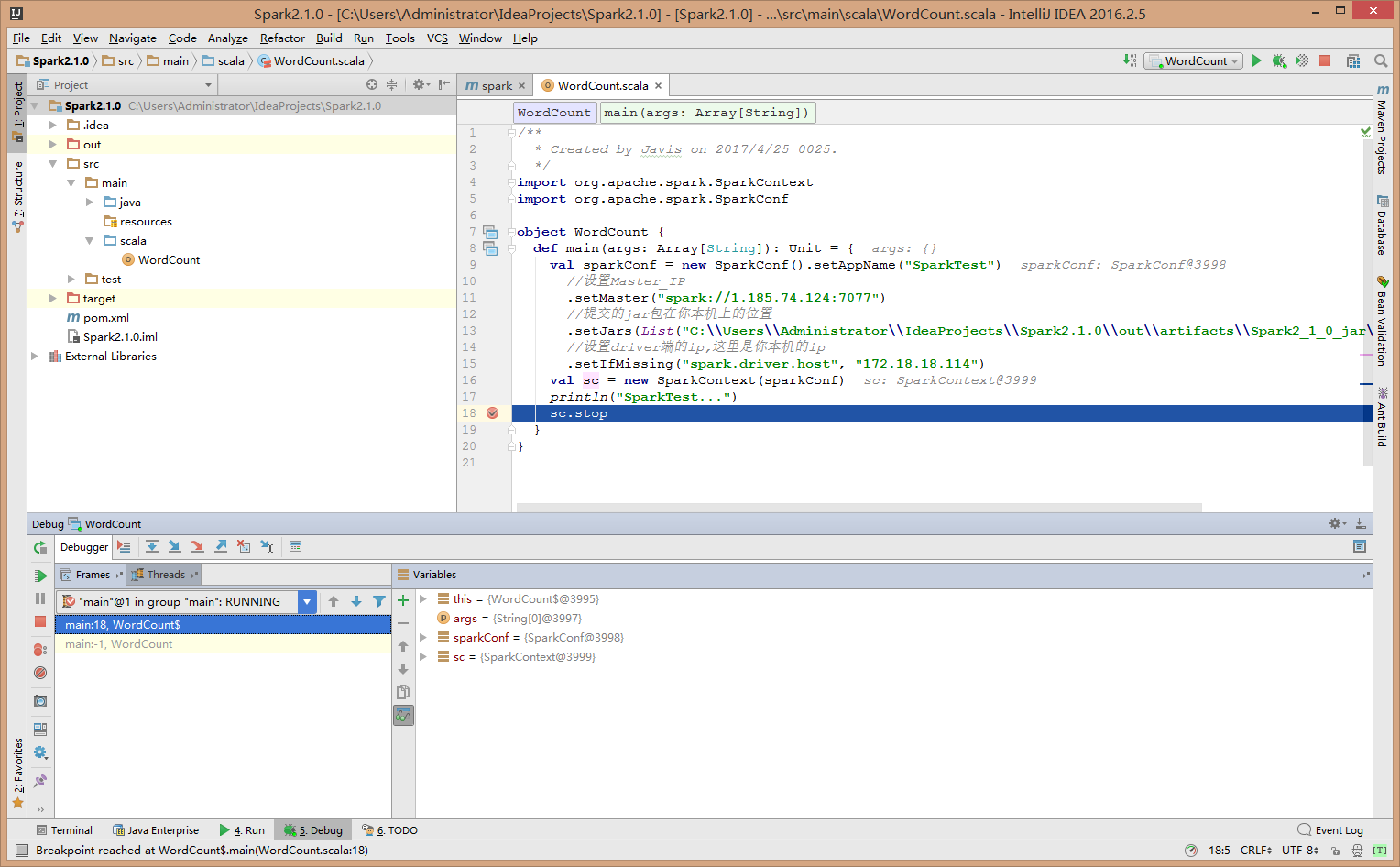

把自己的电脑作为Driver端,直接把jar包提交到集群,此时Spark的Master与Worker会一直和本机的Driver端保持连接,调试比较方便。

import org.apache.spark.SparkContext

import org.apache.spark.SparkConf

object WordCount {

def main(args: Array[String]): Unit = {

val sparkConf = new SparkConf().setAppName("SparkTest")

//设置Master_IP

.setMaster("spark://1.185.74.124:7077")

//提交的jar包在你本机上的位置

.setJars(List("C:\\Users\\Administrator\\IdeaProjects\\Spark2.1.0\\out\\artifacts\\Spark2_1_0_jar\\Spark2.1.0.jar"))

//设置driver端的ip,这里是你本机的ip

.setIfMissing("spark.driver.host", "172.18.18.114")

val sc = new SparkContext(sparkConf)

println("SparkTest...")

sc.stop

}

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1565

1565

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?