Ceph已然成为开源社区极为火爆的分布式存储开源方案,最近需要调研Openstack与Ceph的融合方案,因此开始了解Ceph,当然从搭建Ceph集群开始。

我搭建机器使用了6台虚拟机,包括一个admin节点,一个monitor节点,一个mds节点,两个osd节点,一个client节点。机器的配置是:

> lsb_release -a

LSB Version: :core-4.1-amd64:core-4.1-noarch

Distributor ID: CentOS

Description: CentOS Linux release 7.1.1503 (Core)

Release: 7.1.1503

Codename: Core

3.10.0-229.el7.x86_64

0.集群安装前的准备工作

a)文件系统采用官方推荐的xfs(brtfs)

>df -T

>umount -l /data(去掉挂载点)

>mkfs.xfs -f /dev/vdb(强制转换文件系统)

>mount /dev/vdb /data(重新挂载)

> hostnamectl set-hostname {name}

d)选择合适的内核版本:

http://docs.ceph.org.cn/start/os-recommendations

> lsb_release -a

> uname -r

把软件包源加入软件仓库。用文本编辑器创建一个YUM(Yellowing Updater,Modified)库文件,其路径/etc/yum.repos.d/ceph.repo。例如:

> sudo vim /etc/yum.repos.d/ceph.repo

[ceph-noarch]

name=Ceph noarch packages

baseurl=http://download.ceph.com/rpm-{ceph-release}/{distro}/noarch

enabled=1

gpgcheck=1

type=rpm-md

gpgkey=https://download.ceph.com/keys/release.asc

更新软件库并安装ceph-deploy:

> sudo yum update && sudo yum install ceph-deploy注:很多资料说是用ssh-copy-id,笔者尝试并不work,就将admin的key添加到其他机器上去即可。

0.3 配置ntp服务

# yum -y install ntp ntpdate ntp-doc

# ntpdate 0.us.pool.ntp.org

# hwclock --systohc

# systemctl enable ntpd.service

# systemctl start ntpd.service0.4 关闭防火墙或者开放 6789/6800~6900端口、关闭SELINUX

# sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config

# setenforce 0# yum -y install firewalld

# firewall-cmd --zone=public --add-port=6789/tcp --permanent

# firewall-cmd --zone=public --add-port=6800-7100/tcp --permanent

# firewall-cmd --reload

1.集群角色分配:

10.221.83.246 ceph-adm-node

10.221.83.247 ceph-mon-node

10.221.83.248 ceph-mds-node

10.221.83.249 ceph-osd-node1

10.221.83.250 ceph-osd-node2

10.221.83.251 ceph-client-node

2.部署monitor服务

2.1 创建目录

mkdir -p ~/my-cluster

cd ~/my-cluster

2.2 创建monitor节点:

>ceph-deploy new ceph-mon-node

>ceph.conf >ceph.log >ceph.mon.keyring

2.3 修改副本数

把Ceph配置文件的默认副本数从3改成2,这样只有两个osd也能达到active+clean状态,把下面这行加入到[global]段:

> osd pool default size = 2>ceph-deploy install ceph-adm-node ceph-mon-node ceph-mds-node ceph-osd-node1 ceph-osd-node2 ceph-client-node>ceph-deploy mon create ceph-mon-node

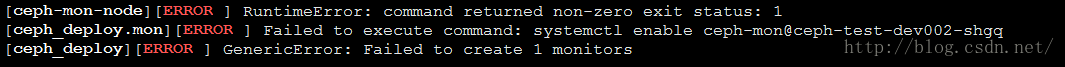

解决方法:

通过"hostnamectl set-hostname {name}"命令将所有主机名设置成与/etc/hosts里面对应的主机名一致。

2.6 收集各个节点的keyring文件

>ceph-deploy gatherkeys ceph-mon-node

3.部署osd服务

3.1 添加osd节点(所有osd节点执行)

ssh ceph-osd-node{id}

mkdir -p /var/local/osd{id}

exit

3.2 激活osd

#创建osd

ceph-deploy osd prepare ceph-osd-node1:/var/local/osd1 ceph-osd-node2:/var/local/osd2

#激活osd

ceph-deploy osd activate ceph-osd-node1:/var/local/osd1 ceph-osd-node2:/var/local/osd2

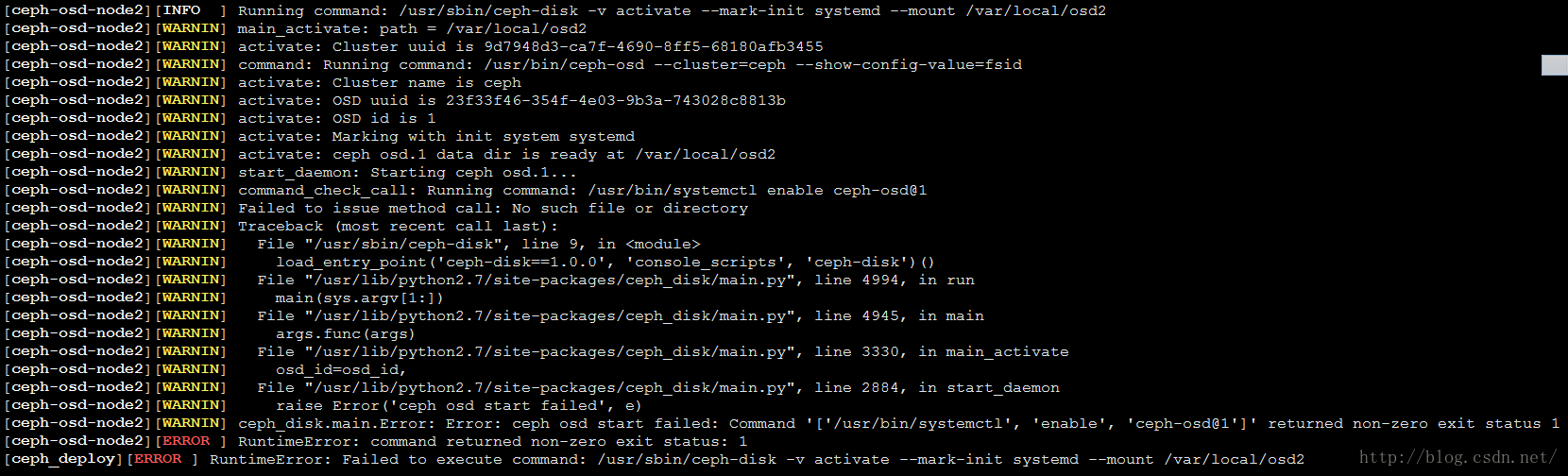

prepare->activate会出现上述问题,主要问题是:

根本就没有命令:systemctl enable

ceph-osd@0.service

应该是:systemctl status/start

ceph-osd@0.service

解决方案,直接create来代替prepare和activate命令:

ceph-deploy osd create ceph-osd-node1:/var/local/osd1 ceph-osd-node2:/var/local/osd2

查看状态:

ceph-deploy osd list ceph-osd-node1 ceph-osd-node2

[ceph-osd-node1][INFO ] Running command: /usr/sbin/ceph-disk list

[ceph-osd-node1][INFO ] ----------------------------------------

[ceph-osd-node1][INFO ] ceph-0

[ceph-osd-node1][INFO ] ----------------------------------------

[ceph-osd-node1][INFO ] Path /var/lib/ceph/osd/ceph-0

[ceph-osd-node1][INFO ] ID 0

[ceph-osd-node1][INFO ] Name osd.0

[ceph-osd-node1][INFO ] Status up

[ceph-osd-node1][INFO ] Reweight 1.0

[ceph-osd-node1][INFO ] Active ok

[ceph-osd-node1][INFO ] Magic ceph osd volume v026

[ceph-osd-node1][INFO ] Whoami 0

[ceph-osd-node1][INFO ] Journal path /var/local/osd1/journal

[ceph-osd-node1][INFO ] ----------------------------------------[ceph-osd-node2][INFO ] Running command: /usr/sbin/ceph-disk list

[ceph-osd-node2][INFO ] ----------------------------------------

[ceph-osd-node2][INFO ] ceph-1

[ceph-osd-node2][INFO ] ----------------------------------------

[ceph-osd-node2][INFO ] Path /var/lib/ceph/osd/ceph-1

[ceph-osd-node2][INFO ] ID 1

[ceph-osd-node2][INFO ] Name osd.1

[ceph-osd-node2][INFO ] Status up

[ceph-osd-node2][INFO ] Reweight 1.0

[ceph-osd-node2][INFO ] Active ok

[ceph-osd-node2][INFO ] Magic ceph osd volume v026

[ceph-osd-node2][INFO ] Whoami 1

[ceph-osd-node2][INFO ] Journal path /var/local/osd2/journal

[ceph-osd-node2][INFO ] ----------------------------------------> ceph-deploy admin ceph-*(all ceph node)

> 例如:ceph-deploy admin ceph-osd-node1 ceph-osd-node2 ceph-mon-node ceph-mds-node ceph-client-node

>

chmod +r /etc/ceph/ceph.client.admin.keyring

3.5 检查是否成功:

> 将keyring文件移动到到/etc/ceph下面:mv *.keyring /etc/ceph

> ceph health

等peering完成后,集群应该达到active+clean状态。

3.6 查看osd状态

> ceph-disk activate-all

4.部署msd服务

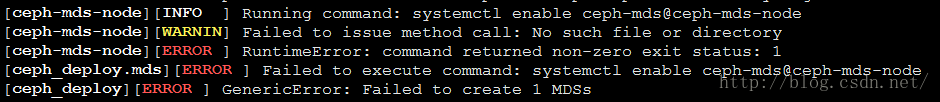

> ceph-deploy mds create ceph-mds-node

原因:在mds机器ceph-mds-node上面没有找到ceph-mds@ceph-mds-node.service。

解决方案:在ceph-mds-node机器上:

cp

ceph-mds@.service

ceph-mds@ceph-mds-node.service

5.集群验证

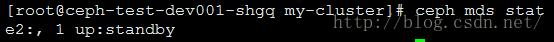

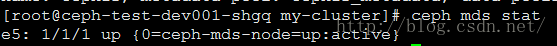

5.1 验证mds节点

> ps -ef | grep mds

> ceph mds stat

> ceph mds dump

5.2 验证mon节点

> ps -ef | grep mon

5.3 验证osd节点

> ps -ef | grep osd

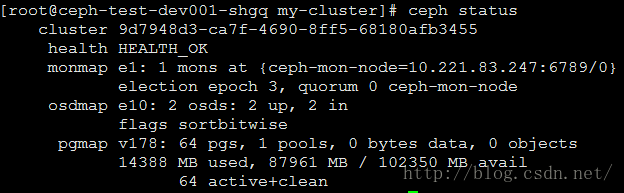

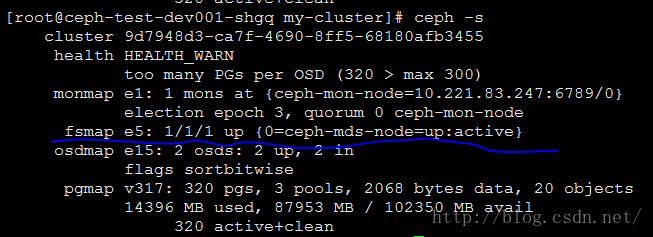

5.4 集群状态

> ceph -s

以上基本上完成了ceph存储集群的搭建,那么现在就需要进一步对特定的存储方式进行配置。

6.创建ceph文件系统

6.1 在管理节点,通过ceph-deploy把ceph安装到ceph-client节点上

> ceph-deploy install ceph-client-node

6.2 创建文件系统(http://docs.ceph.org.cn/cephfs/createfs/)

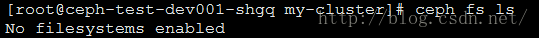

创建之前:

> ceph osd pool create cephfs_data <pg_num>

> ceph osd pool create cephfs_metadata <pg_num>

> ceph fd new <fs_name> cephfs_metadata cephfs_data

其中:<pg_num> = 128 , <fs_name> = cephfs

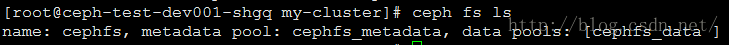

创建之后:

> ceph fs ls

> ceph mds stat

> ceph -s

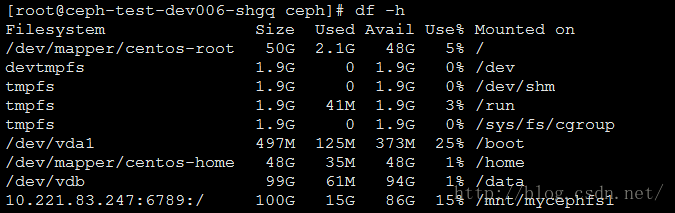

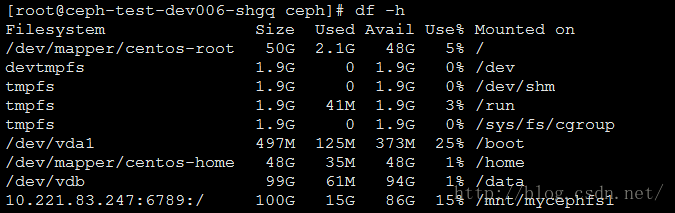

7.挂载ceph文件系统

7.0 在管理节点使用ceph-deploy拷贝ceph配置文件以及ceph.client.admin.keyring到ceph-client-node上面:

>ceph-deploy admin ceph-client-node> sudo chmod +r /etc/ceph/ceph.client.admin.keyring

7.1 内核驱动挂载Ceph文件系统

7.1.1 创建挂载点

> sudo mkdir -p /mnt/mycephfs1

7.1.2 存储密钥

>

cat /etc/ceph/ceph.client.admin.keyring

将key对应的值复制下来保存到文件:/etc/ceph/admin.secret中。

7.1.3 挂载

>

sudo mount -t ceph 10.221.83.247:6789:/ /mnt/mycephfs1 -o name=admin,secretfile=/etc/ceph/admin.secret

7.1.4 取消挂载

> sudo umount -l /mnt/mycephfs1

7.2 用户控件挂载Ceph文件系统

7.2.1 创建挂载点

> sudo mkdir -p /mnt/mycephfs2> sudo yum install -y ceph-fuse

7.2.3 挂载

> sudo ceph-fuse -m 10.221.83.247:6789 /mnt/mycephfs2

7.2.4 取消挂载

> fusermount -u /mnt/mycephfs2/

其他:

清理机器上的ceph相关配置:

停止所有进程:sudo stop ceph-all

卸载所有ceph程序:ceph-deploy uninstall [{ceph-node}]

删除ceph相关的安装包:ceph-deploy purge {ceph-node} [{ceph-data}]

删除ceph相关的配置:ceph-deploy purgedata {ceph-node} [{ceph-data}]

删除key:ceph-deploy forgetkeys

卸载ceph-deploy管理:

yum -y remove ceph-deploy

Author:忆之独秀

Email:leaguenew@qq.com

注明出处:http://blog.csdn.net/lavorange/article/details/52052520

4158

4158

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?