相信每位刚接触神经网络的时候都会先碰到BP算法的问题,如何形象快速地理解BP神经网络就是我们学习的高级乐趣了(画外音:乐趣?你在跟我谈乐趣?)

本篇博文就是要简单粗暴地帮助各位童鞋快速入门采取BP算法的神经网络。

BP神经网络是怎样的一种定义?看这句话:一种按“误差逆传播算法训练”的多层前馈网络。

BP的思想就是:利用输出后的误差来估计输出层前一层的误差,再用这层误差来估计更前一层误差,如此获取所有各层误差估计。这里的误差估计可以理解为某种偏导数,我们就是根据这种偏导数来调整各层的连接权值,再用调整后的连接权值重新计算输出误差。直到输出的误差达到符合的要求或者迭代次数溢出设定值。

说来说去,“误差”这个词说的很多嘛,说明这个算法是不是跟误差有很大的关系?

没错,BP的传播对象就是“误差”,传播目的就是得到所有层的估计误差。

它的学习规则是:使用最速下降法,通过反向传播(就是一层一层往前传)不断调整网络的权值和阈值,最后使全局误差系数最小。

它的学习本质就是:对各连接权值的动态调整。

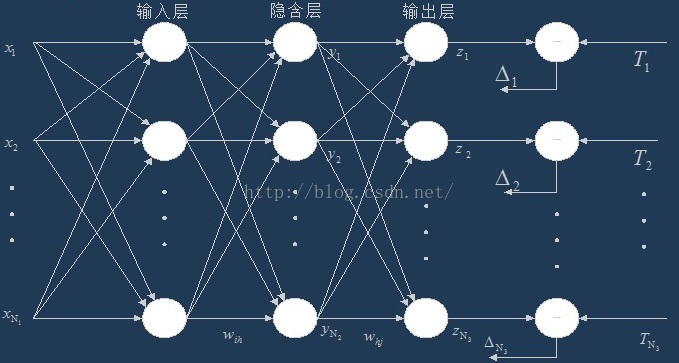

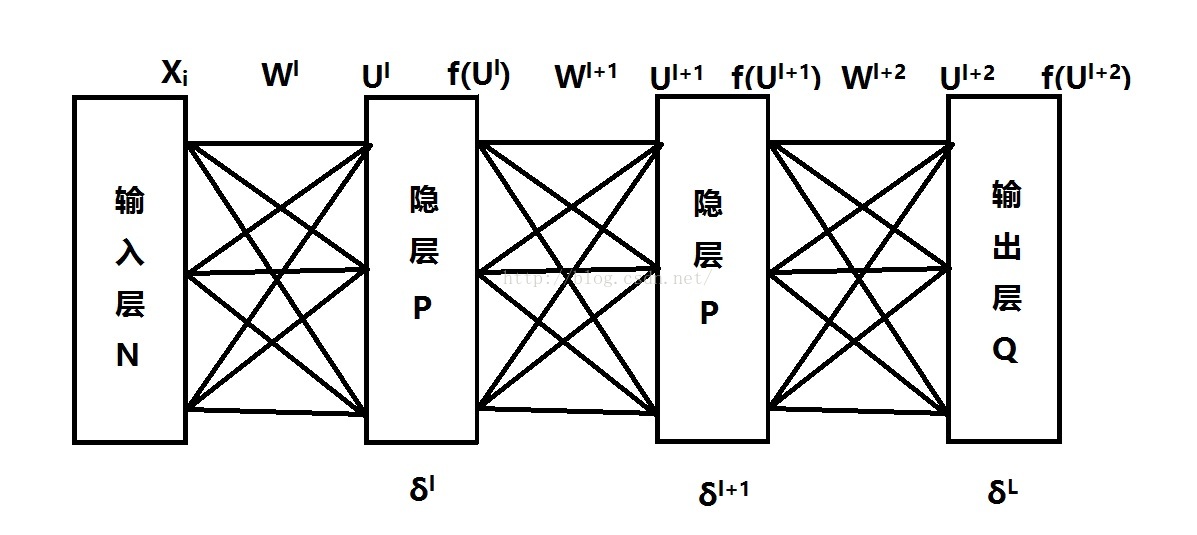

拓扑结构如上图:输入层(input),隐藏层(hide layer),输出层(output)

BP网络的优势就是能学习和储存大量的输入输出的关系,而不用事先指出这种数学关系。那么它是如何学习的?

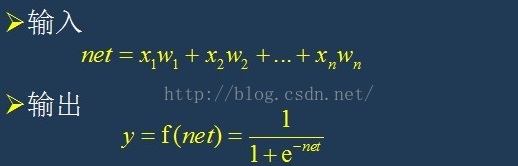

BP利用处处可导的激活函数来描述该层输入与该层输出的关系,常用S型函数δ来当作激活函数。

我们现在开始有监督的BP神经网络学习算法:

1、正向传播得到输出层误差e

=>输入层输入样本=>各隐藏层=>输出层

2、判断是否反向传播

=>若输出层误差与期望不符=>反向传播

3、误差反向传播

=>误差在各层显示=>修正各层单元的权值,直到误差减少到可接受程度。

算法阐述起来比较简单,接下来通过数学公式来认识BP的真实面目。

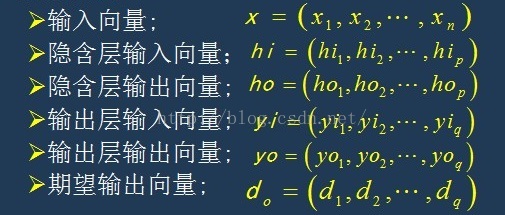

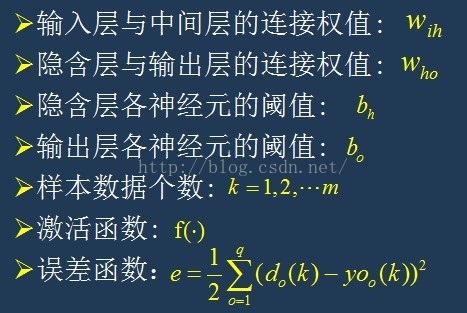

假设我们的网络结构是一个含有N个神经元的输入层,含有P个神经元的隐层,含有Q个神经元的输出层。

这些变量分别如下:

认识好以上变量后,开始计算:

一、用(-1,1)内的随机数初始化误差函数,并设定精度ε,最多迭代次数M

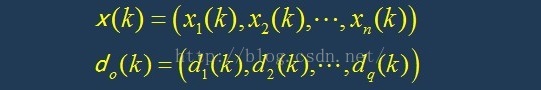

二、随机选取第k个输入样本及对应的期望输出

重复以下步骤至误差达到要求:

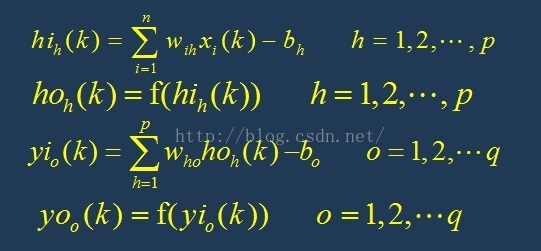

三、计算隐含层各神经元的输入和输出

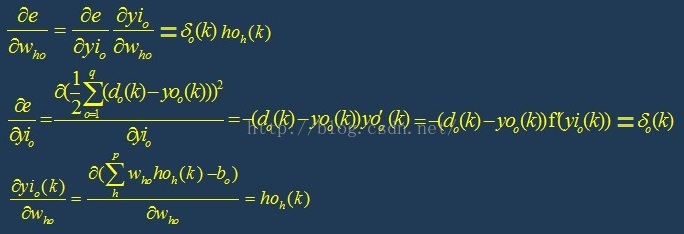

四、计算误差函数e对输出层各神经元的偏导数,根据输出层期望输出和实际输出以及输出层输入等参数计算。

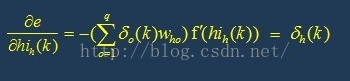

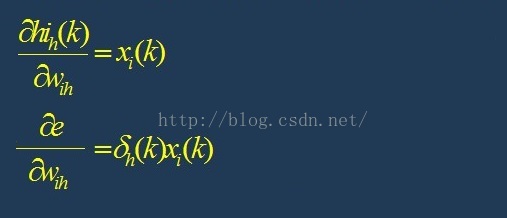

五、计算误差函数对隐藏层各神经元的偏导数,根据后一层(这里即输出层)的灵敏度(稍后介绍灵敏度)δo(k),后一层连接权值w,以及该层的输入值等参数计算

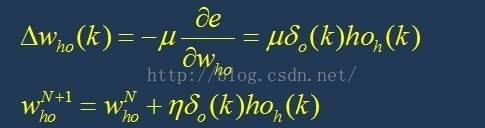

六、利用第四步中的偏导数来修正输出层连接权值

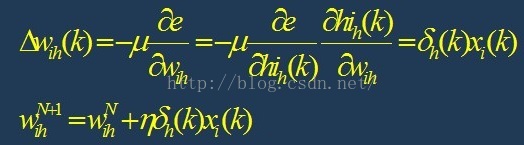

七、利用第五步中的偏导数来修正隐藏层连接权值

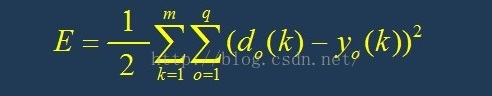

八、计算全局误差(m个样本,q个类别)

比较具体的计算方法介绍好了,接下来用比较简洁的数学公式来大致地概括这个过程,相信看完上述的详细步骤都会有些了解和领悟。

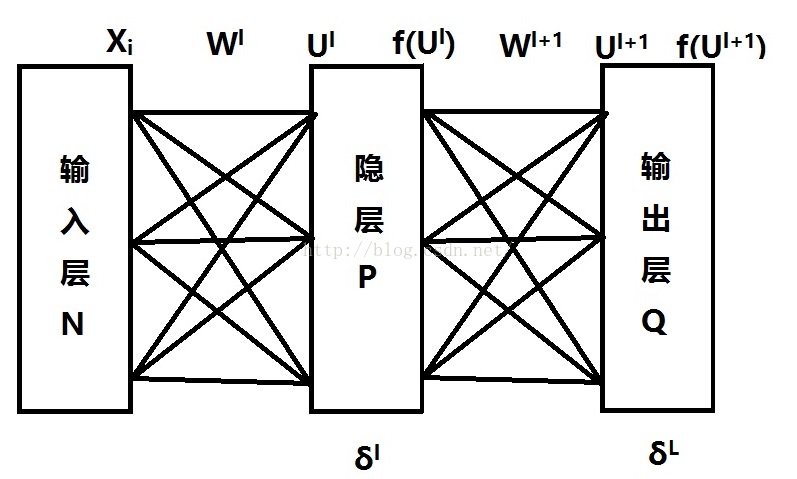

假设我们的神经网络是这样的,此时有两个隐藏层。

我们先来理解灵敏度是什么?

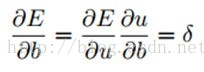

看下面一个公式:

这个公式是误差对b的一个偏导数,这个b是怎么?它是一个基,灵敏度δ就是误差对基的变化率,也就是导数。

因为∂u/∂b=1,所以∂E/∂b=∂E/∂u=δ,也就是说bias基的灵敏度∂E/∂b=δ等于误差E对一个节点全部输入u的导数∂E/∂u。

也可以认为这里的灵敏度等于误差E对该层输入的导数,注意了,这里的输入是上图U级别的输入,即已经完成层与层权值计算后的输入。

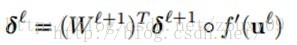

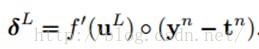

每一个隐藏层第l层的灵敏度为:

这里的“◦”表示每个元素相乘,不懂的可与上面详细公式对比理解

而输出层的灵敏度计算方法不同,为:

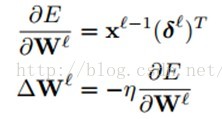

而最后的修正权值为灵敏度乘以该层的输入值,注意了,这里的输入可是未曾乘以权值的输入,即上图的Xi级别。

对于每一个权值(W)ij都有一个特定的学习率ηIj,由算法学习完成。

2588

2588

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?