正文开始前 ,先介绍几个概念

序列化

所谓序列化,是指将结构化对象转化为字节流,以便在网络上传输或写到磁盘进行永久存储。

反序列化

是指将字节流转回到结构化对象的逆过程

序列化在分布式数据处理的两个大领域经常出现:进程间通信和永久存储

在Hadoop中,系统中多个节点上进程间的通信是通过"远程过程调用"(remote procedure call,RPC)实现的 。RPC协议将消息序列化成二进制流后发送到远程节点,远程节点接着将二进制流反序列化为原始消息

Hadoop使用了自己写的序列化格式 Writable,它格式紧凑,速度快,但是它很难用Java以外的语言进行拓展或使用,因为Writable是Hadoop的核心,大多数MapReduce程序都会为键和值使用它

简单来说,RPC协议是让程序员可以调用远程计算机进程上的代码的一套工具

打个比方 就是A通过网络调用B的某个进程方法

通信中的协议是由程序员自己规定的,比如你可以规定说当A向B发送数字1, B就打印hello hadoop, 并返回数字1给A, 如果发送数字2,B就打印hello world并发送数字2给A.

序列化------------>写 write(DataOutput out)

反序列化-------->读 readFields(DataInput in)

首先声明:我是基于Hadoop2.6.4版本

一. Hadoop内置的数据类型

BooleanWritable:标准布尔型数值

ByteWritable:单字节数值

DoubleWritable:双字节数值

FloatWritable:浮点数

IntWritable:整型数

LongWritable:长整型数

Text:使用UTF8格式存储的文本

NullWritable:当<key, value>中的key或value为空时使用

Hadoop中的数据类型都要实现Writable接口,以便用这些类型定义的数据可以被网络传输和文件存储。

二. 用户自定义数据类型的实现

1.继承接口Writable,实现其方法write()和readFields(), 以便该数据能被序列化后完成网络传输或文件输入/输出;

2.如果该数据需要作为主键key使用,或需要比较数值大小时,则需要实现WritalbeComparable接口,实现其方法write(),readFields(),CompareTo() 。

3.数据类型,必须要有一个无参的构造方法,为了方便反射,进行创建对象。

下面讲数据输入输出格式和自定义数据输入输出格式 ,然后把上面讲过的自定义数据类型整合进去

序列化

所谓序列化,是指将结构化对象转化为字节流,以便在网络上传输或写到磁盘进行永久存储。

反序列化

是指将字节流转回到结构化对象的逆过程

序列化在分布式数据处理的两个大领域经常出现:进程间通信和永久存储

在Hadoop中,系统中多个节点上进程间的通信是通过"远程过程调用"(remote procedure call,RPC)实现的 。RPC协议将消息序列化成二进制流后发送到远程节点,远程节点接着将二进制流反序列化为原始消息

Hadoop使用了自己写的序列化格式 Writable,它格式紧凑,速度快,但是它很难用Java以外的语言进行拓展或使用,因为Writable是Hadoop的核心,大多数MapReduce程序都会为键和值使用它

简单来说,RPC协议是让程序员可以调用远程计算机进程上的代码的一套工具

打个比方 就是A通过网络调用B的某个进程方法

通信中的协议是由程序员自己规定的,比如你可以规定说当A向B发送数字1, B就打印hello hadoop, 并返回数字1给A, 如果发送数字2,B就打印hello world并发送数字2给A.

序列化------------>写 write(DataOutput out)

反序列化-------->读 readFields(DataInput in)

首先声明:我是基于Hadoop2.6.4版本

一. Hadoop内置的数据类型

BooleanWritable:标准布尔型数值

ByteWritable:单字节数值

DoubleWritable:双字节数值

FloatWritable:浮点数

IntWritable:整型数

LongWritable:长整型数

Text:使用UTF8格式存储的文本

NullWritable:当<key, value>中的key或value为空时使用

Hadoop中的数据类型都要实现Writable接口,以便用这些类型定义的数据可以被网络传输和文件存储。

二. 用户自定义数据类型的实现

1.继承接口Writable,实现其方法write()和readFields(), 以便该数据能被序列化后完成网络传输或文件输入/输出;

2.如果该数据需要作为主键key使用,或需要比较数值大小时,则需要实现WritalbeComparable接口,实现其方法write(),readFields(),CompareTo() 。

3.数据类型,必须要有一个无参的构造方法,为了方便反射,进行创建对象。

4.在自定义数据类型中,建议使用java的原生数据类型,最好不要使用Hadoop对原生类型进行封装的数据类型。比如 int x ;//IntWritable 和String s; //Text 等等

下面是一个自定义的数据类型 3D坐标轴

package com.tg.type;

import java.io.DataInput;

import java.io.DataOutput;

import java.io.IOException;

import org.apache.hadoop.io.WritableComparable;

public class Point3D implements WritableComparable<Point3D> {

public float x, y, z;

public Point3D(float fx, float fy, float fz) {

this.x = fx;

this.y = fy;

this.z = fz;

}

public Point3D() {

this(0.0f, 0.0f, 0.0f);

}

public void readFields(DataInput in) throws IOException {

x = in.readFloat();

y = in.readFloat();

z = in.readFloat();

}

@Override

public void write(DataOutput out) throws IOException {

out.writeFloat(x);

out.writeFloat(y);

out.writeFloat(z);

}

public String toString() {

return "X:"+Float.toString(x) + ", "

+ "Y:"+Float.toString(y) + ", "

+ "Z:"+Float.toString(z);

}

public float distanceFromOrigin() {

return (float) Math.sqrt( x*x + y*y +z*z);

}

public int compareTo(Point3D other) {

return Float.compare(

distanceFromOrigin(),

other.distanceFromOrigin());

}

public boolean equals(Object o) {

if( !(o instanceof Point3D)) {

return false;

}

Point3D other = (Point3D) o;

return this.x == other.x && this.y == other.y && this.z == other.z;

}

/* 实现 hashCode() 方法很重要

* Hadoop的Partitioners会用到这个方法,后面再说

*/

public int hashCode() {

return Float.floatToIntBits(x)

^ Float.floatToIntBits(y)

^ Float.floatToIntBits(z);

}

}下面讲数据输入输出格式和自定义数据输入输出格式 ,然后把上面讲过的自定义数据类型整合进去

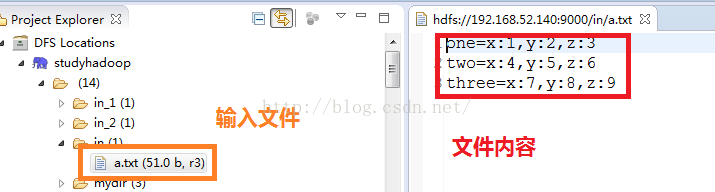

首先看看输入文件a.txt

数据输入格式(InputFormat

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4282

4282

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?