0、前言

最近一段时间忙着实习,又被老师逼着写论文,加上最近身体也不太舒服。所以写博客的时间都没了。其实写这个

博客的初衷是希望自己再日后回想的时候能有所凭借,能回忆起自己当初是怎么去思考,怎么理解的。好了,下面

就开始 逻辑回归问题和其过拟合的解决

1、Logistic Regression

上一篇讲到了线性回归,尽管线性分类器方法足够简单并且使用广泛,但是线性模型对于输出的 y 没有界限,y 可以

取任意大或者任意小(负数)的值,对于某些问题来说不够 adequate, 比如我们想得到 0 到 1 之间的 probability 输出,这

时候就要用到比 linear regression 更加强大的 logistic regression 了。

logistic regression的(此处来自Machine Learning Action)

优点:计算代价不高,易于理解和实现

缺点:容易欠拟合,分类精度不高

适用的数据类型:数值类型和标称数据类型

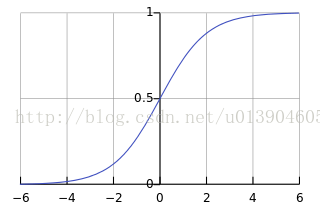

另外我们需要知道一个函数 Sigmoid 函数:

我们的 logistic regression的方程就可以写成

当横坐标很大的时候,我们的函数看起来就像是阶跃函数了,h(x)>0.5时输出1,h(x)<=0.5时输出0。

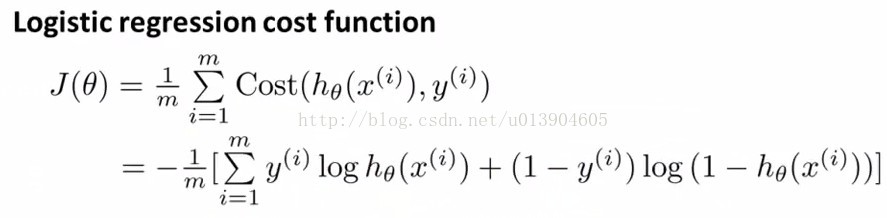

2、Logistic Regression Cost Function

Logsitic regression 输出的是分到每一类的概率,参数估计的方法自然就是最大似然估计(此处MAL和MAP

其实一样,因为分类曲线的先验概率都一样嘛)。对于训练样本来说,假设每个样本是独立的,输出为y = {0, 1},

样本的似然函数将所有训练样本 label 对应的输出节点上的概率相乘, 令 p = P(Y=1|x) ,如果 y = 1, 概率就是 p, 如

果 y = 0, 概率就是 1 - p ,可以得到似然函数:

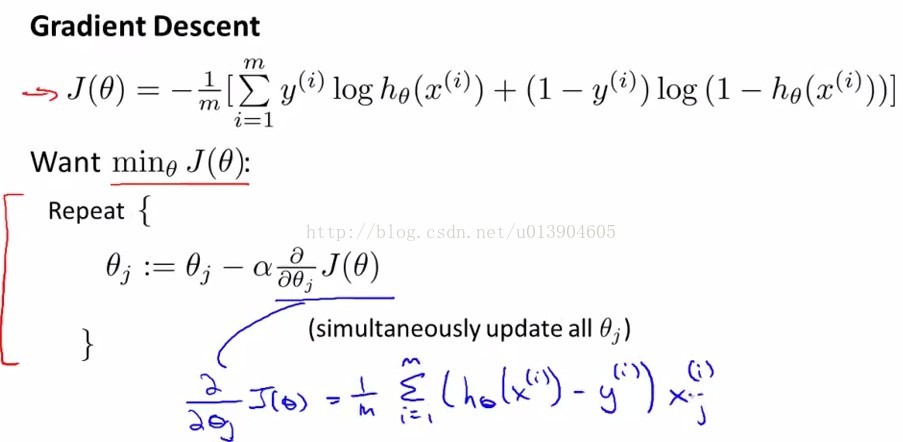

利用梯度下降算法就可以求解问题了

求解J(theta)的偏导可以得到和linear Regression的一样的公式

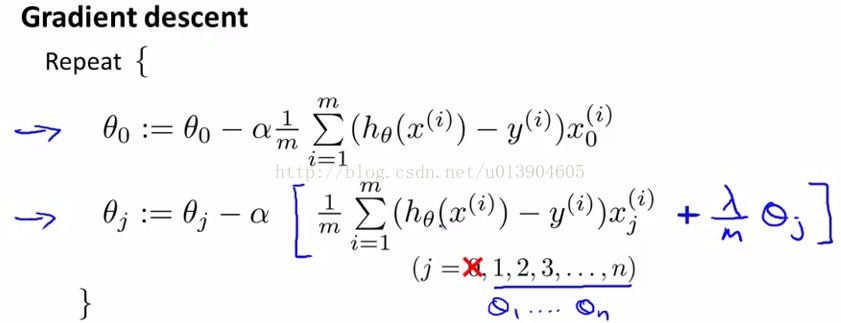

3、Logistic Regression Regularization

和上篇一样,由于over fitting的存在,所以我们需要对式子的过拟合问题进行处理,和linear Regression一样,在cost fuction最后添加一项

5、reference

Andrew Ng视频

Machine Learning Action

19万+

19万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?