1、安装环境

- hadoop2.5.0

- centOS6.4

- jdk7

- hue3.7.0

2、hadoop配置

2.1、配置hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!-- historyserver configue start-->

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

<!-- historyserver configue end-->

<!-- hue configure start -->

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

<!-- hue configure end -->2.2、配置core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://xuxudede.com:9000</value>

</property>

<!-- hue configure start-->

<property>

<name>hadoop.proxyuser.hue.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.hue.groups</name>

<value>*</value>

</property>

<!-- hue configure end-->2.3、配置yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>xuxudede.com</value>

</property>

<!-- historyserver############ -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>106800</value>

</property>

<!-- historyserver############ -->2.4、配置httpfs-site.xml

<configuration>

<!-- hue configure start-->

<property>

<name>httpfs.proxyuser.hue.hosts</name>

<value>*</value>

</property>

<property>

<name>httpfs.proxyuser.hue.groups</name>

<value>*</value>

</property>

<!-- hue configure end-->

</configuration>3、hue配置

hue的配置位于HUE_HOME/desktop/conf下的hue.ini文件

3.1、配置【hdfs_clusters】

# Enter the filesystem uri

fs_defaultfs=hdfs://xuxudede.com:9000

# Use WebHdfs/HttpFs as the communication mechanism.

# Domain should be the NameNode or HttpFs host.

# Default port is 14000 for HttpFs.

webhdfs_url=http://xuxudede.com:50070/webhdfs/v1

# This is the home of your Hadoop HDFS installation

hadoop_hdfs_home=xuxudede.com

# Use this as the HDFS Hadoop launcher script

hadoop_bin=xuxudede.com

# Directory of the Hadoop configuration

hadoop_conf_dir=/home/xusy/share/cdh5.3.6/hadoop-2.5.0-cdh5.3.6/etc/hadoop3.2、配置【yarn_clusters】

# Enter the host on which you are running the ResourceManager

resourcemanager_host=xuxudede.com

# The port where the ResourceManager IPC listens on

resourcemanager_port=8032

# Whether to submit jobs to this cluster

submit_to=True

# URL of the ResourceManager API

resourcemanager_api_url=http://xuxudede.com:8088

# URL of the ProxyServer API

proxy_api_url=http://xuxudede.com:8088

# URL of the HistoryServer API

history_server_api_url=http://xuxudede.com:198884、重启hadoop进程

命令如下:

sbin/yarn-daemon.sh stop nodemanager

sbin/yarn-daemon.sh stop resourcemanager

sbin/mr-jobhistory-daemon.sh stop historyserver

sbin/hadoop-daemon.sh stop datanode

sbin/hadoop-daemon.sh stop namenode

sbin/hadoop-daemon.sh start namenode

sbin/hadoop-daemon.sh start datanode

sbin/mr-jobhistory-daemon.sh start historyserver

sbin/yarn-daemon.sh start resourcemanager

sbin/yarn-daemon.sh start nodemanager

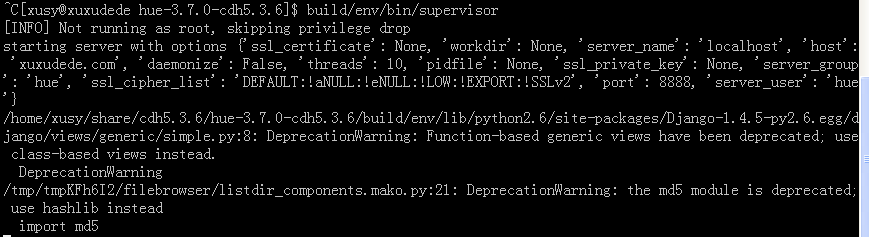

5、启动hue

到hue根目录下,执行

build/env/bin/supervisor 如下图:

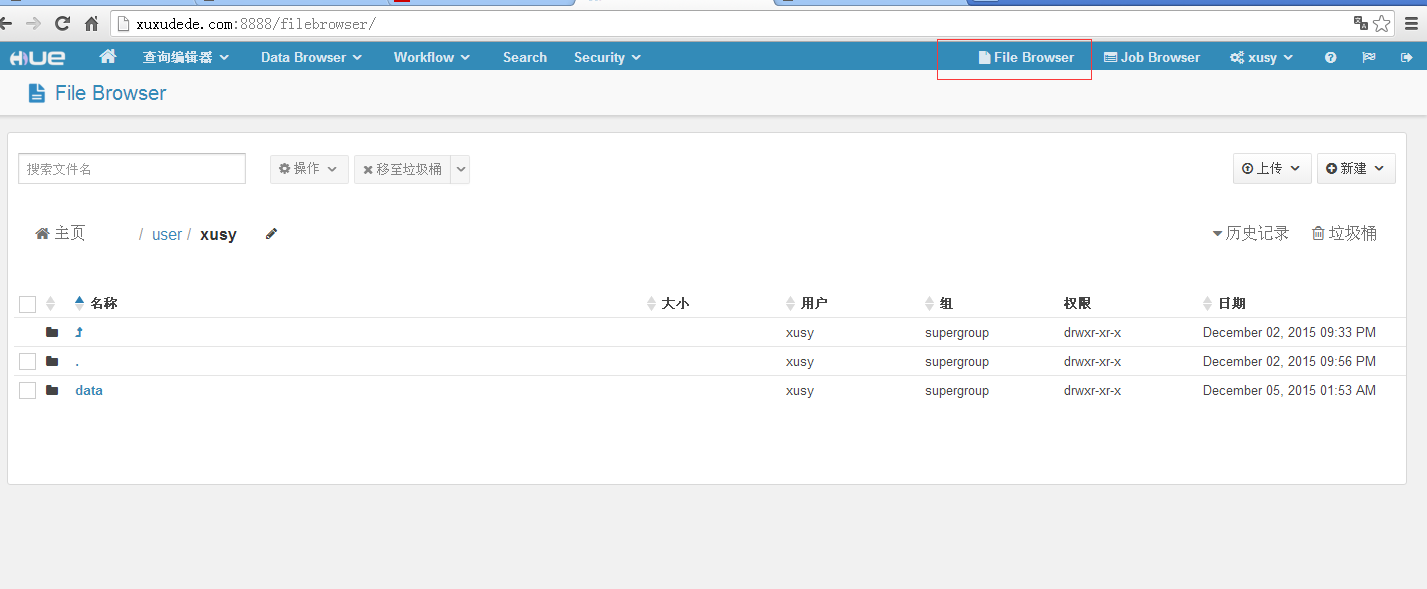

6、HDFS测试

进入HDFS如下图:

6.1、文件操作

注意:需要选中某一个文件才能对其进行操作,不用敲命令也可以达到修改文件的效果,非常棒!

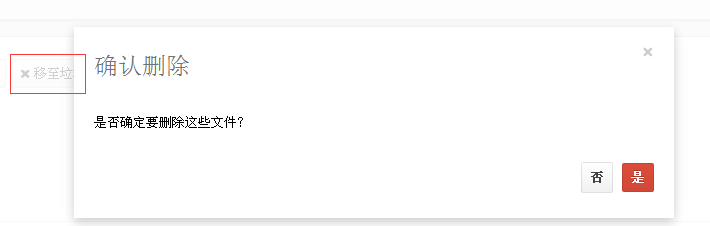

6.2、删除文件

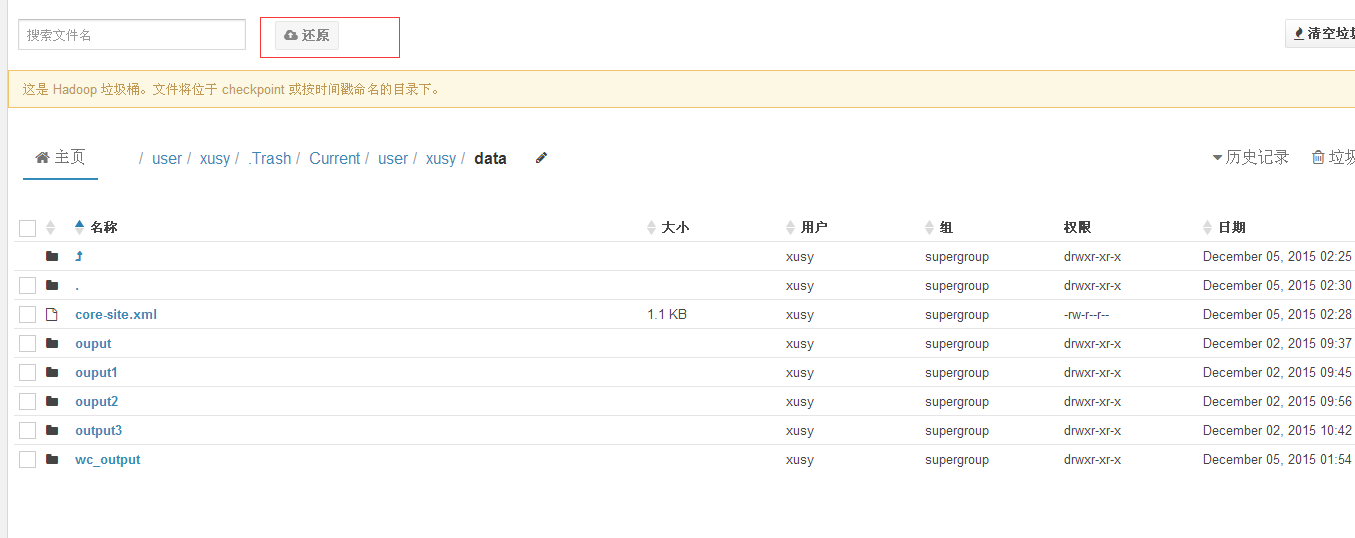

6.3、还原已经删除的文件

进入垃圾桶

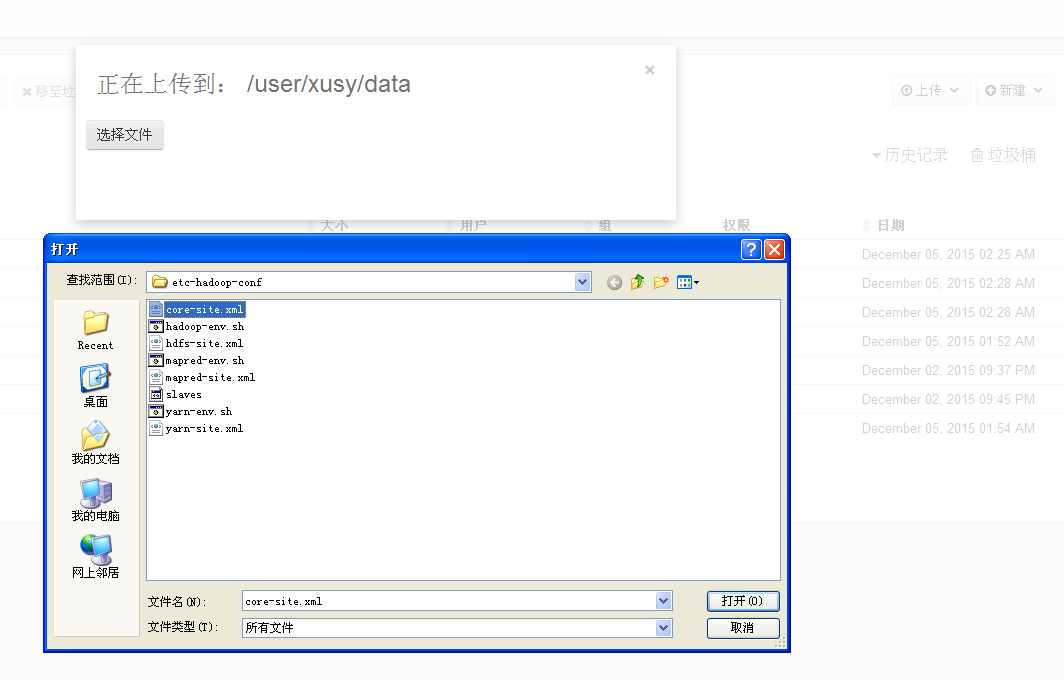

6.4、上传文件

上传宿主机文件

上传linux系统上的文件的话,需要安装samba服务器,将linux文件系统映射到宿主机。

另外,还可以对文件进行创建等等的操作,集成了hadoop成功后自己对进行操作测试。

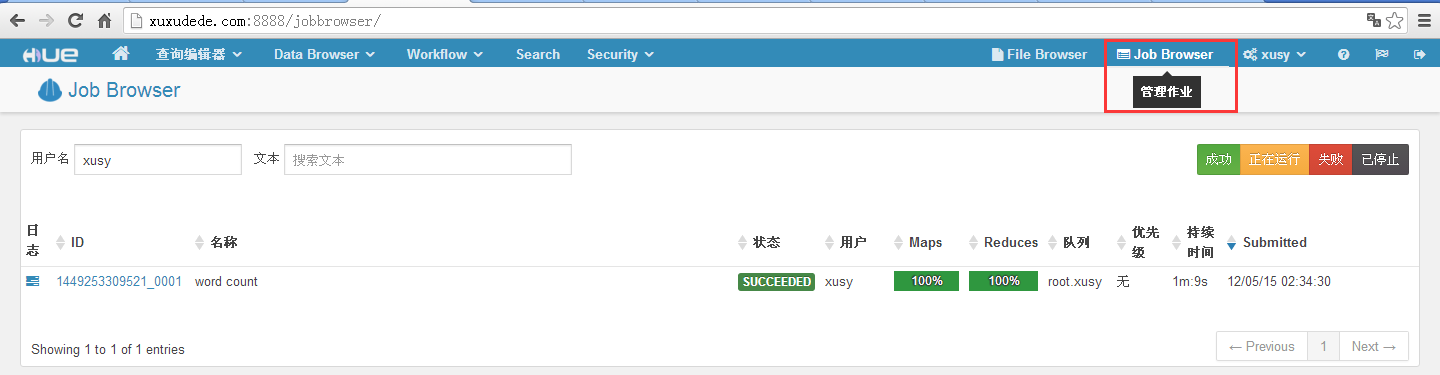

7、mapreduce测试

查看job页面如下图所示:

当前只有一个运行成功的job,可以选择查看“正在运行”、“失败”等的job。

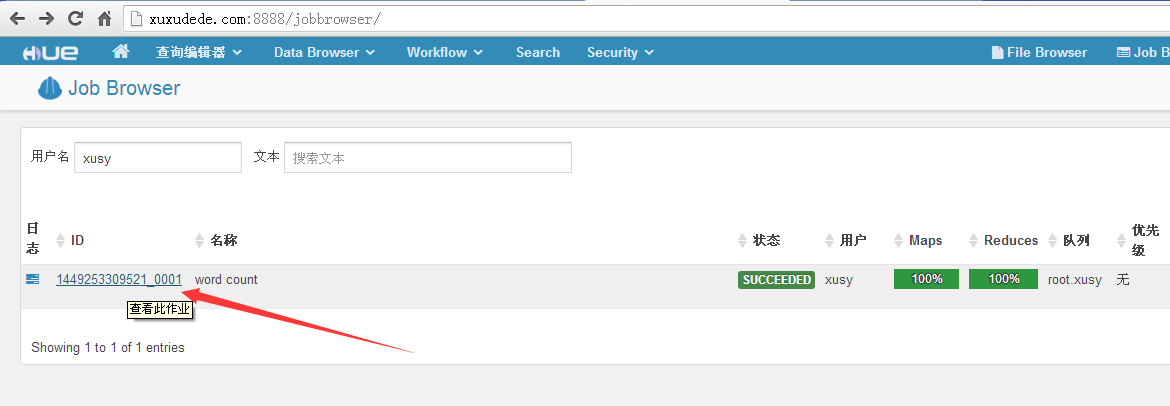

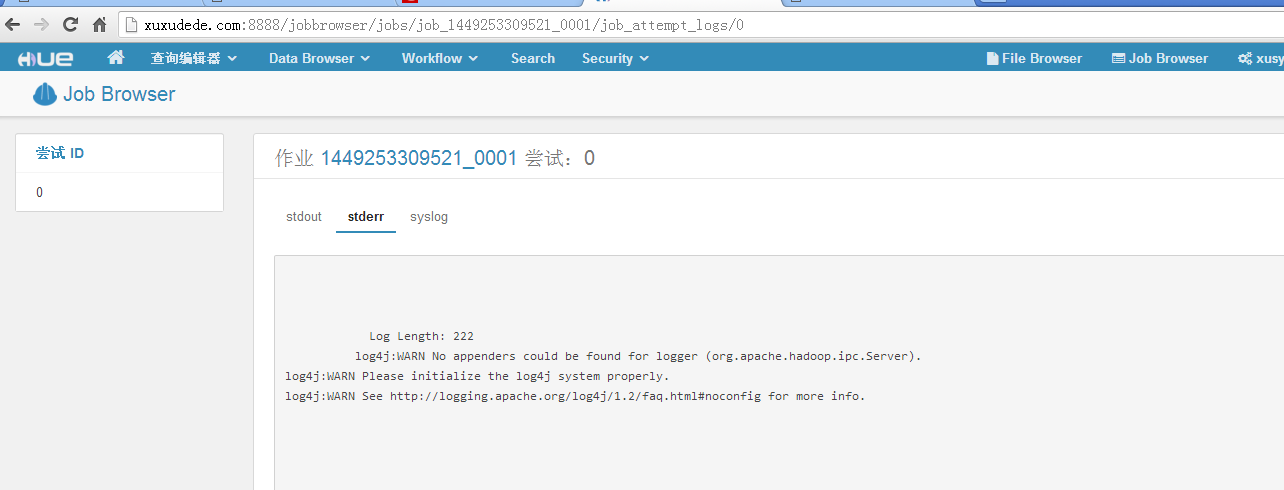

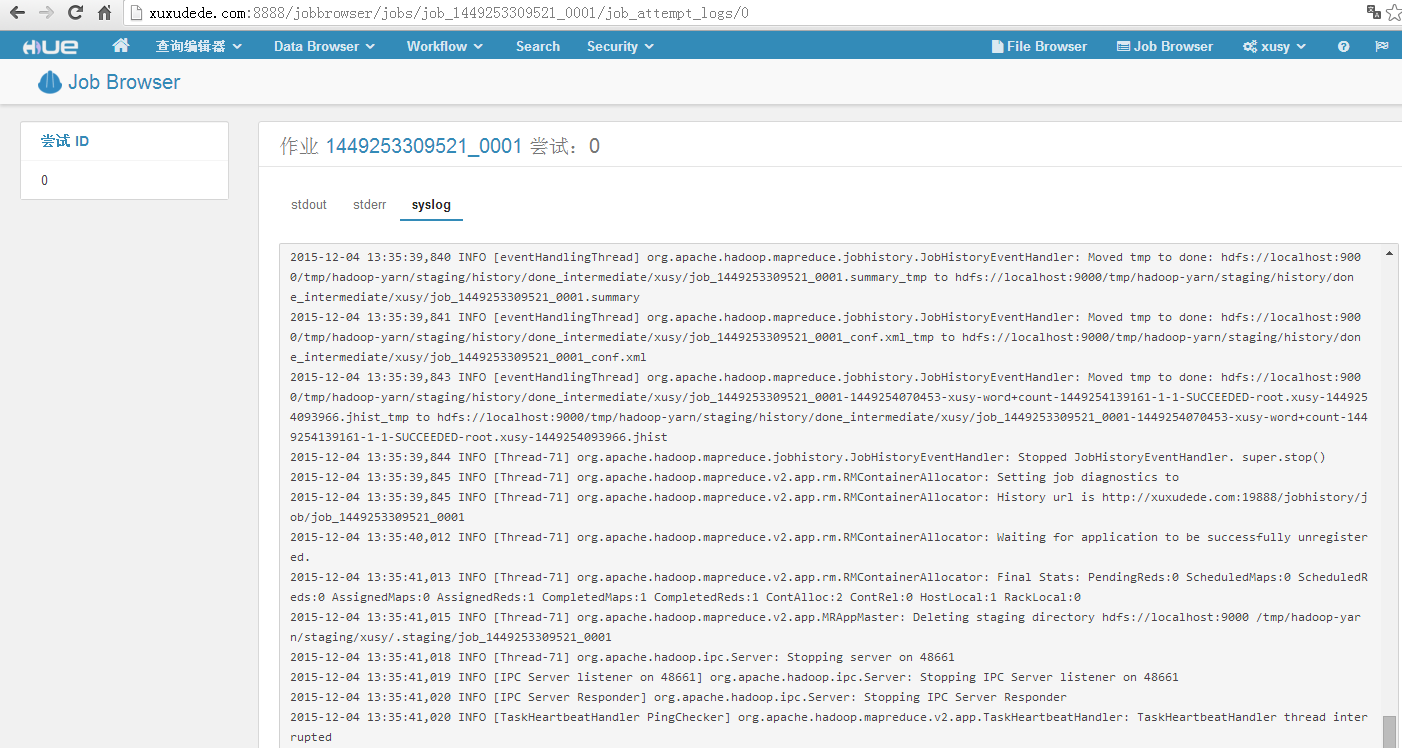

8、查看日志、计数器等

点击id查看此作业:

任务查询:

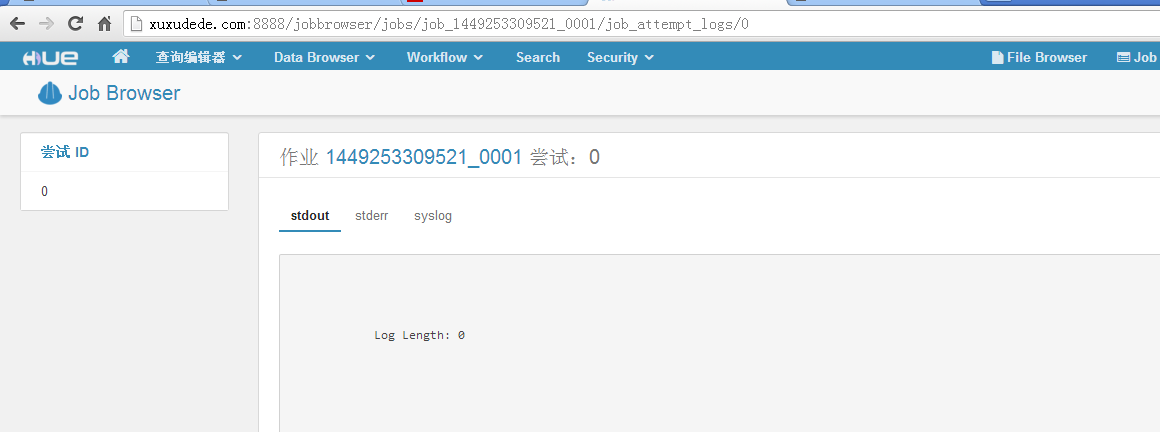

标准输出日志:

标准错误日志:

系统日志:

2501

2501

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?