第一:到spark的官网,下载spark,已spark-1.6.2.tgz为例子。

第二:执行解压命令 tar zxvf spark-1.6.2.tgz,

然后 cd spark-1.6.2

cd bin

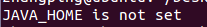

第三:执行./pyspark,出现以下提示:

说明需要配置JAVA环境,配置步骤。配置完成后

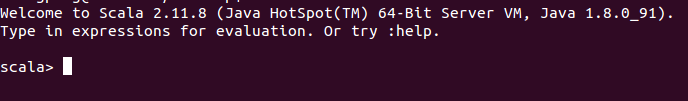

第四:执行./pyspark,出现以下提示:

应该没有找到scala的开发环境。

第五:下载scala,以scala-2.11.8.tgz为例

执行以下命令 tar zxvf scala-2.11.8.tgz,

sudo mv scala-2.11.8 /usr/local/scala

配置scala的环境变量

sudo gedit /etc/profile(/etc/bash.bashrc)

export SCALA_HOME=/usr/local/scala/scala-2.11.8

export PATH=$PATH:/usr/local/scala/scala-2.11.8/bin

source /etc/bash.bashrc

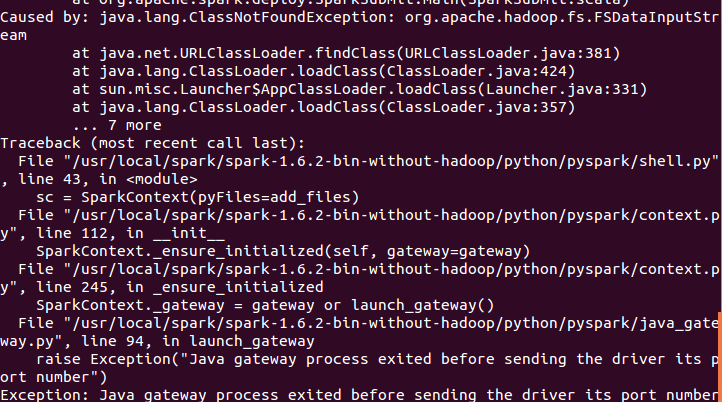

在终端执行:scala,显示

-----------------------以上把scala的环境变量配置完成----------------------------

然后再次执行

./pyspark,还是提示以下错误

【注意环境变量配置在/etc/profile和/etc/bash.bashrc的区别】,

/etc/profile只针对当前的终端,同一个用户的不同终端,需要source /etc/profile才行。

因此将环境变量配置在

/etc/bash.bashrc中

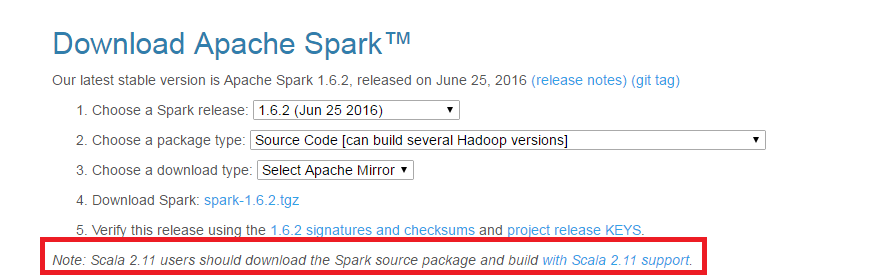

-----------------------------------------------我猜测是版本的问题------------------------------------------------

这里说的很清楚如果用Scala2.11版本的的话,需要充新编译。

我改用scala-2.10.4

继续改spark的版本为spark-1.3.10。

然后配置环境变量

sudo gedit /etc/bash.basrc

#set java environment

export JAVA_HOME=/usr/local/java/jdk1.8.0_91

export JRE_HOME=/usr/local/java/jdk1.8.0_91/jre

export CLASSPATH=$JAVA_HOME/lib:$JRE_HOME/lib:$CLASSPATH

#set scala environment

export SCALA_HOME=/usr/local/scala/scala-2.10.4

#set spark environment

export SPARK_HOME=/usr/local/spark/spark-1.3.0-bin-hadoop2.4

#set path

export PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin:$SCALA_HOME/bin:$SPARK_HOME/bin:/usr/local/cmake/bin:/usr/local/opencv/bin:

然后打开终端:

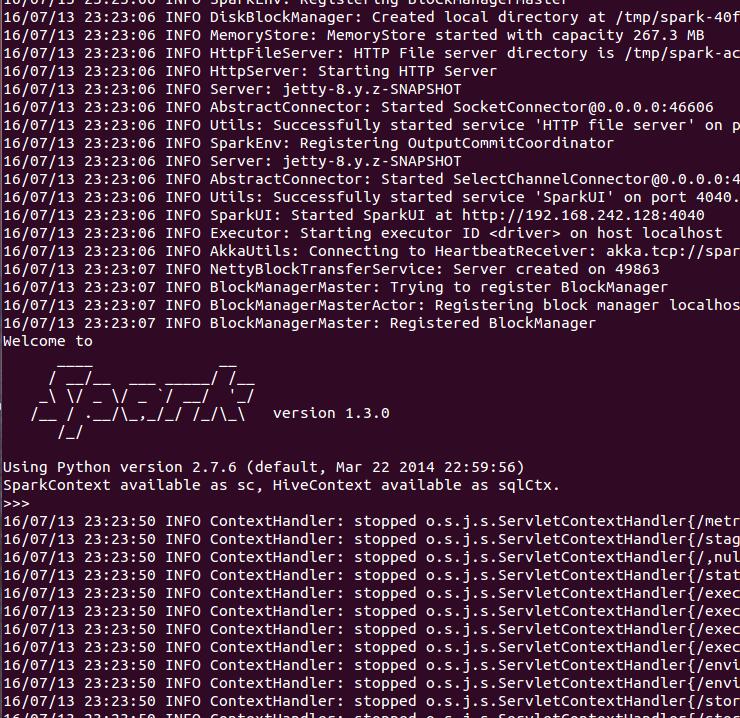

$pyspark

-----说明已经成功

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?