为了更好的微调模型,我阅读了几篇关于优化大模型性能的文章,这里总结在博客里。

基于不同形式的思维链构造方法

在人工智能领域,大型语言模型(LLMs)的 能力已经得到了广泛的认可,它们能够处理复杂的 自然语言任务,如问答、文本生成等。然而,当面对需要深度推理的任务时,如数学推理、常识推理 和符号推理,LLMs 的性能往往不尽如人意。为了 解决这一问题,研究者们提出了多种构造方法,旨 在提高 LLMs 的推理能力。这些方法大致可以分为 三类:手动 XoT、自动 XoT 和半自动 XoT。

手动构造

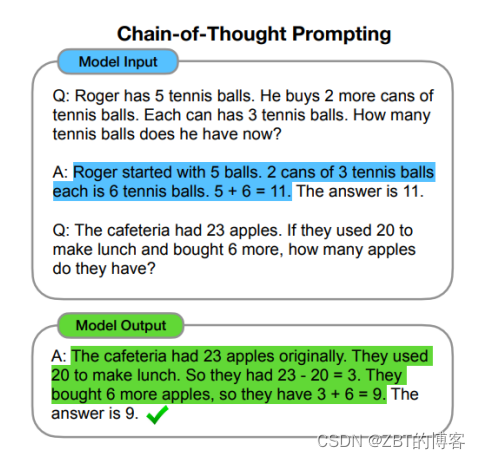

Wei et al. (2022b) 首先提出手动提供思维 链提示,给定一个由三组组成的提示:输入、思维 链、输出。来进一步确保推理过程中的确定性,探 索了语言模型在推理任务中执行 Few-shot 提示的 能力,该模型只暴露于一组上下文示例,这些示例 是基于它们与复杂问题的接近程度而选择的,而这 些问题可能不包含对需要采取的中间步骤的最佳监 督。PAL (Gao et al., 2023) 旨在解决大型语言模 型(LLMs)在进行算术和符号推理任务时,尽管能 够通过少数几个示例进行问题分解,但仍经常在解 决方案部分出现逻辑和计算错误的问题。PAL 的核 心思想是利用 LLM 来阅读自然语言问题并生成程 序作为中间推理步骤,但将解决方案步骤加载到一 个运行环境中,如 Python 解释器。这样做的目的是 让 LLM 专注于它擅长的自然语言理解和分解任务, 而将解决问题和计算的部分交给精确的解释器来执 行。

自动构造

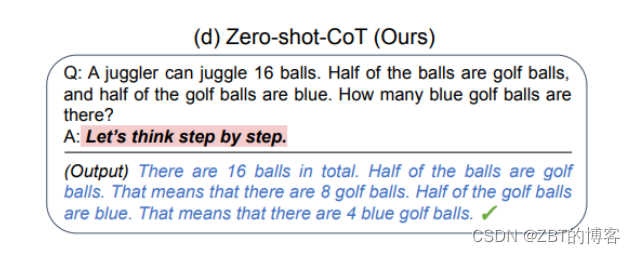

手动 XoT 的构建成本高昂,为了降低手工制 作 Few-shot 样本的成本,Kojima et al. (2022) 提出了 Zero-shot-CoT(Chain of Thought)提示方 法。该方法通过在每个答案前简单添加“Let’s think step by step”(让我们一步一步思考)的提示,引导 大型语言模型(LLMs)进行逐步推理。这种方法不 仅强调了在设计微调数据集或少量示例之前,深入 探索和分析 LLMs 内部隐藏的 zero-shot 知识的重 要性,而且揭示了 LLMs 在高级、多任务方面的广 泛认知能力。随后,Auto-CoT(Zhang et al., 2023f) 进一步提出了自动 CoT 提示方法。该方法通 过以下步骤自动构建示范:首先,将给定数据集中 的问题按类别聚类;接着,从每个类别中选择一个 代表性问题,并使用 Zero-Shot-CoT 提示生成其推 理链;然后,应用简单启发式规则选择符合条件的 问题和推理链作为示范;最后,利用生成的示范进 行上下文学习,以提升模型在特定任务上的表现。 COSP (Wan et al., 2023)引入问题的结果熵来 辅助演示选择。为了消除手动操作,Zero-shotCoT 将目标问题声明与“Let’s think step-by-step”连接 起来,作为 LLM 的输入提示。

半自动构造

半自动 XoT 方法巧妙融合了手动和自动构造 方法的精髓,有效降低了成本,同时显著提升了 思维链的质量。Shao et al. (2023)提出了合 成提示策略,它借助少量的人工示例来引导模型,通过交替的生成过程不断扩展示例集合。这一过 程中,模型不仅能选择有效的演示来增强推理能 力,还能通过反向过程生成与当前推理相匹配的 问题链,确保问题的可解决性和明确性。正向过程 则进一步细化问题的推理链,提升示例的整体质 量。Automate-CoT (Shum et al., 2023) 则引 入了一种创新的策略,即 AutomateC-oT。该方法 首先从一个小型标记数据集出发,通过修剪低质量 的推理链来构建机器生成的基本原理链候选池。随 后,它采用方差减少的提示策略梯度方法,从候选 池中选取最佳组合的几个基本原理链,以优化每 个示例的重要性评估。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?