作者@小郭

4. iSCSI 服务器

iSCSI 服务介绍

SCSI(Small Computer System Interface,小型计算机系统接口),一种用于计算机和智能设备之间(硬盘、软驱、光驱、打印机、扫描仪等)连接标准。

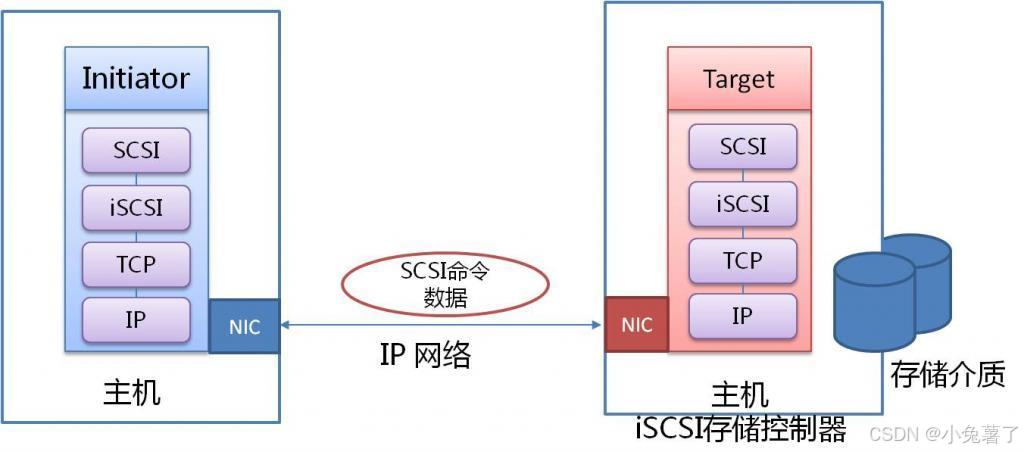

iSCSI(Internet Small Computer System Interface,Internet 小型计算机系统接口),又称为IP-SAN,是IBM公司研究开发的IP SAN技术,该技术是将现有SCSI接口与以太网络(Ethernet)技术结合,基于TCP/IP的协议连接iSCSI服务端(Target)和客户端(Initiator),使得封装后的SCSI数据包可以在互联网传输,最终实现iSCSI服务端提供存储给客户端。

通常,iSCSI使用专用的10 Gb以太网或更好的网络,以最大程度地提高性能。

从物理服务器到存储的电缆通常封闭在数据中心内,并且理想情况下不直接连接到LAN网络,所以SAN流量通常不加密,以最大程度地提高性能。 为了实现WAN安全,iSCSI管理员可以使用IPsec加密流量。

iSCSI 架构

iSCSI服务是C/S架构。访问的iSCSI目标在客户端系统上显示为本地且未格式化的SCSI快设备,等同于通过SCSI布线、FC直连或FC交换光线连接的设备。

-

Initiator,iSCSI客户端,通常以软件方式部署,也可以使用iSCSI Host Bus Adapters (HBAs) (HBA)硬件。 Initiator必须具有唯一的名称(请参见IQN)。

-

Target,iSCSI服务器上的iSCSI存储资源。 Target必须具有唯一的名称(请参见IQN)。 每个目标都提供一个或多个块设备或逻辑单元(LUN-logical units)。 在大多数情况下,Target只提供一个设备,但一台服务器可以提供多个目标。

-

IQN(iSCSI Qualified Name)全球唯一的名称,用于标识发起者和目标。 IQN具有以下格式:

iqn.YYYY-MM.com.reversed.domain:name_string- YYYY-MM,年和月。示例,2020年6月为2020-06。该日期有助于确保IQN唯一性。

- com.reversed.domain,反向域名。 例如,

server.redhat.fun的反向域名为cloud.gcf.www。 - name_string,用于标识您管理的特定目标。 如果服务器只具有一个目标,则有时会省略此名称。

-

Portal,指定服务器监听的地址和端口,例如,172.25.250.50:3260。

-

LUN(Logical Unit Number),代表Target提供的块设备。 每个目标可以提供一个或多个LUN。

-

ACL(Access Control List),使用Initiator的IQN限制客户端访问Target。

-

TPG(Target Portal Group),是目标的完整配置,包括Portal,LUN和ACL。 几乎所有目标都使用一个TPG,但是高级配置有时可能会定义多个TPG。

-

discovery,查询服务器上有Target列表。

-

login,向Target验证,验证通过后即可以使用Target服务器提供的块设备。

配置 iSCSI Targets

配置 iSCSI Targets需要安装以下软件:

- targetd,服务端软件。

- targetcli,targetd服务配置工具。

# 安装软件

[root@storage ~ 13:40:51]# yum install -y targetcli targetd

# 启用并启动服务

[root@storage ~ 13:43:08]# systemctl enable target --now

Created symlink from /etc/systemd/system/multi-user.target.wants/target.service to /usr/lib/systemd/system/target.service.

[root@storage ~ 13:43:50]# systemctl status target

● target.service - Restore LIO kernel target configuration

Loaded: loaded (/usr/lib/systemd/system/target.service; enabled; vendor preset: disabled)

Active: active (exited) since Fri 2025-11-21 13:43:50 CST; 11s ago

Process: 1857 ExecStart=/usr/bin/targetctl restore (code=exited, status=0/SUCCESS)

Main PID: 1857 (code=exited, status=0/SUCCESS)

Nov 21 13:43:50 storage.gcf.cloud systemd[1]: Starting Restore LIO kernel t....

Nov 21 13:43:50 storage.gcf.cloud target[1857]: No saved config file at /et...g

Nov 21 13:43:50 storage.gcf.cloud systemd[1]: Started Restore LIO kernel ta....

Hint: Some lines were ellipsized, use -l to show in full.

#创建共享逻辑卷。

[root@storage ~ 13:47:08]# vgcreate webapp /dev/sdb

Physical volume "/dev/sdb" successfully created.

Volume group "webapp" successfully created

[root@storage ~ 13:47:20]# lvcreate -n webapp01 -L 50G webapp

Logical volume "webapp01" created.

当您不带任何选项运行targetcli时,该命令将进入交互模式。

在以下示例中,使用ls命令显示当前布局。

[root@storage ~ 13:44:02]# targetcli

Warning: Could not load preferences file /root/.targetcli/prefs.bin.

targetcli shell version 2.1.53

Copyright 2011-2013 by Datera, Inc and others.

For help on commands, type 'help'.

/> ls

o- / .................................................................... [...]

o- backstores ......................................................... [...]

| o- block ............................................. [Storage Objects: 0]

| o- fileio ............................................ [Storage Objects: 0]

| o- pscsi ............................................. [Storage Objects: 0]

| o- ramdisk ........................................... [Storage Objects: 0]

o- iscsi ....................................................... [Targets: 0]

o- loopback .................................................... [Targets: 0]

/> exit

Global pref auto_save_on_exit=true

Configuration saved to /etc/target/saveconfig.json

配置 backstore 对象

backstore类型:

- block:服务器中的块设备,例如磁盘驱动器,磁盘分区或逻辑卷。

- fileio:本地文件系统中的常规文件。targetcli将该文件用作磁盘映像。

- pscsi:物理SCSI设备。 这种类型的存储允许客户端通过网络访问服务器上的物理SCSI设备。

- ramdisk:内存中的磁盘设备。 这种类型的存储不会持久存储数据。 服务器重新启动后,数据将丢失。

要使用targetcli创建后备存储,请使用其create命令。 该命令的行为取决于您在配置树中的当前位置。

步骤:

/> cd /backstores/block

## 语法:create name dev

/backstores/block> create webapp01 /dev/webapp/webapp01

Created block storage object webapp01 using /dev/webapp/webapp01.

/backstores/block> ls

o- block ................................................. [Storage Objects: 1]

o- webapp01 ......... [/dev/webapp/webapp01 (50.0GiB) write-thru deactivated]

o- alua .................................................. [ALUA Groups: 1]

o- default_tg_pt_gp ...................... [ALUA state: Active/optimized]

配置 Target IQN

在/iscsi伪目录中,创建IQN,将您选择的IQN名称作为其第一个参数。

/backstores/block> cd /iscsi

/iscsi> ls

o- iscsi ......................................................... [Targets: 0]

#就是这样命名的:iqn.年-月.反向域名: 自定义的业务用途标识.

/iscsi> create iqn.2025-11.cloud.gcf.storage.x8664:webapp

Created target iqn.2025-11.cloud.gcf.storage.x8664:webapp.

Created TPG 1.

Global pref auto_add_default_portal=true

Created default portal listening on all IPs (0.0.0.0), port 3260.

/iscsi> ls

o- iscsi ......................................................... [Targets: 1]

o- iqn.2025-11.cloud.gcf.storage.x8664:webapp ..................... [TPGs: 1]

o- tpg1 ............................................ [no-gen-acls, no-auth]

o- acls ....................................................... [ACLs: 0]

o- luns ....................................................... [LUNs: 0]

o- portals ................................................. [Portals: 1]

o- 0.0.0.0:3260 .................................................. [OK]

#解释一下为什么后面有x8664,当只写create时它会自动给你创建一个,会发现自动创建的IQN有写这个,x86_64 的简写形式,它指的是64 位的 x86 架构处理器。写不写都行。

/iscsi> create

Created target iqn.2003-01.org.linux-iscsi.storage.x8664:sn.422f1995ff5b.

Created TPG 1.

Global pref auto_add_default_portal=true

Created default portal listening on all IPs (0.0.0.0), port 3260.

配置 ACL

创建ACL,以允许客户端启动程序访问目标。在Red Hat Enterprise Linux上,启动器的IQN存储在/etc/iscsi/initiatorname.iscsi文件中。

#设置具备特定的iqn的客户端可以访问。

/iscsi> cd /iscsi/iqn.2025-11.cloud.gcf.storage.x8664:webapp/tpg1/

/iscsi/iqn.20...4:webapp/tpg1> cd acls #这里不要带/

/iscsi/iqn.20...app/tpg1/acls> create iqn.2025-11.cloud.gcf.storage.x8664:nginx

Created Node ACL for iqn.2025-11.cloud.gcf.storage.x8664:nginx

配置 LUN

#设置可以访问的设备。

#在处于acls目录下时,不能直接cd到luns下面,因为luns 目录并不在 acls 下面,而是和 acls 同级,都在 tpg1 目录下。

/iscsi/iqn.20...app/tpg1/acls> cd luns

No such path /iscsi/iqn.2025-11.cloud.gcf.storage.x8664:webapp/tpg1/acls/luns

#cd 出来到tpg1下面就可以进入luns

/iscsi/iqn.20...app/tpg1/acls> cd ..

iscsi/iqn.20...4:webapp/tpg1> cd luns

/iscsi/iqn.20...app/tpg1/luns> create /backstores/block/webapp01

Created LUN 0.

Created LUN 0->0 mapping in node ACL iqn.2025-11.cloud.gcf.storage.x8664:nginx

配置 Portal

#删除默认的portals

/iscsi/iqn.20...4:webapp/tpg1> portals/

/iscsi/iqn.20.../tpg1/portals> delete 0.0.0.0 3260

Deleted network portal 0.0.0.0:3260

##设置只允许10.1.8.10 3260

/iscsi/iqn.20.../tpg1/portals> create 10.1.8.10 3260

Using default IP port 3260

Created network portal 10.1.8.10:3260.

保存配置

退出targetcli shell时,该命令将配置保存在/etc/target/saveconfig.json文件中。

#回到目录下,查看所有条目确认是否正确。

/iscsi/iqn.20...app/tpg1/acls> cd /

/> ls

o- / ........................................................... [...]

o- backstores ................................................ [...]

| o- block .................................... [Storage Objects: 1]

| | o- webapp01 [/dev/webapp/webapp01 (50.0GiB) write-thru activated]

| | o- alua ..................................... [ALUA Groups: 1]

| | o- default_tg_pt_gp ......... [ALUA state: Active/optimized]

| o- fileio ................................... [Storage Objects: 0]

| o- pscsi .................................... [Storage Objects: 0]

| o- ramdisk .................................. [Storage Objects: 0]

o- iscsi .............................................. [Targets: 1]

| o- iqn.2025-11.cloud.gcf.storage.x8664:webapp .......... [TPGs: 1]

| o- tpg1 ................................. [no-gen-acls, no-auth]

| o- acls ............................................ [ACLs: 1]

| | o- iqn.2025-11.cloud.gcf.storage.x8664:nginx [Mapped LUNs: 1]

| | o- mapped_lun0 ................ [lun0 block/webapp01 (rw)]

| o- luns ............................................ [LUNs: 1]

| | o- lun0 [block/webapp01 (/dev/webapp/webapp01) (default_tg_pt_gp)]

| o- portals ...................................... [Portals: 1]

| o- 10.1.8.10:3260 ..................................... [OK]

o- loopback ........................................... [Targets: 0]

#退出直接exit就行,需要注意的是此时退出的时候处于什么位置下,接下来再等进来的时候仍会处于什么位置。

/iscsi/iqn.20...4:webapp/tpg1> exit

Global pref auto_save_on_exit=true

Last 10 configs saved in /etc/target/backup/.

Configuration saved to /etc/target/saveconfig.json

非交互式管理 Targets

#非交互式写好命令直接粘贴进去,直接生成。

[root@storage ~ 14:43:18]# targetcli /backstores/block create webapp01 /dev/webapp/webapp01

Created block storage object webapp01 using /dev/webapp/webapp01.

[root@storage ~ 14:44:03]# targetcli /iscsi create iqn.2025-11.cloud.gcf.storage.x8664:webapp

Created target iqn.2025-11.cloud.gcf.storage.x8664:webapp.

Created TPG 1.

Global pref auto_add_default_portal=true

Created default portal listening on all IPs (0.0.0.0), port 3260.

[root@storage ~ 14:45:30]# targetcli /iscsi/iqn.2025-11.cloud.gcf.storage.x8664:webapp/tpg1/acls/ \

> create iqn.2025-11.cloud.gcf.storage.x8664:nginx

Created Node ACL for iqn.2025-11.cloud.gcf.storage.x8664:nginx

[root@storage ~ 14:47:04]# targetcli /iscsi/iqn.2025-11.cloud.gcf.storage.x8664:webapp/tpg1/luns/ \

> create /backstores/block/webapp01

Created LUN 0.

Created LUN 0->0 mapping in node ACL iqn.2025-11.cloud.gcf.storage.x8664:ngin

[root@storage ~ 14:47:04]# targetcli /iscsi/iqn.2025-11.cloud.gcf.storage.x8664:webapp/tpg1/portals/ \

> delete 0.0.0.0 3260

Deleted network portal 0.0.0.0:3260

[root@storage ~ 14:47:04]# targetcli /iscsi/iqn.2025-11.cloud.gcf.storage.x8664:webapp/tpg1/portals/ \

> create 10.1.8.10 3260

Using default IP port 3260

Created network portal 10.1.8.10:3260.

#保存。

[root@storage ~ 14:47:04]# targetcli saveconfig

Last 10 configs saved in /etc/target/backup/.

Configuration saved to /etc/target/saveconfig.json

提示:与交互式使用targetcli不同,命令行模式必须显式运行saveconfig子命令以保存配置。

访问 iSCSI 存储

iSCSI 启动器通常以软件方式实现。 使用基于软件的iSCSI启动器需要连接到具有足够带宽的现有以太网网络,以承载存储流量。

您也可以使用硬件启动器-主机总线适配器(HBA),从而减轻了其他系统资源的负担。

准备系统

配置iSCSI客户端启动程序需要安装iscsi-initiator-utils软件包,该软件包包括iscsi和iscsid服务以及**/etc/iscsi/iscsid.conf和/etc/iscsi/initiatorname.iscsi**配置文件。

#配置客户端nginx服务访问存储。

[root@nginx ~ 13:41:20]# yum install -y iscsi-initiator-utils

作为iSCSI启动器,客户端需要其自己的唯一iSCSI合格名称(IQN)。在安装iscsi-initiator-utils的过程中,该软件包生成唯一的IQN,并存储到/etc/iscsi/initiatorname.iscsi文件中。 管理员通常需要更改该名称。

#设置客户端iqn,这里的iqn是storage的acl条目。

[root@nginx ~ 14:58:00]# echo InitiatorName=iqn.2025-11.cloud.gcf.storage.x8664:nginx > /etc/iscsi/initiatorname.iscsi

[root@nginx ~ 15:00:17]# cat /etc/iscsi/initiatorname.iscsi

InitiatorName=iqn.2025-11.cloud.gcf.storage.x8664:nginx

/etc/iscsi/iscsid.conf文件包含您连接的目标的默认设置。 这些设置包括iSCSI超时,重试以及用于身份验证的用户名和密码参数。

软件包安装会自动配置iscsid服务,以便启动器在系统启动时自动重新连接到任何已发现的目标。 每当您修改启动程序的配置文件时,请重新启动iscsid服务。

连接 iSCSI 目标

在使用远程设备之前,首先需要发现目标。 发现过程使用/etc/iscsi/iscsid.conf中的配置将目标信息和设置存储在/var/lib/iscsi/nodes/目录中。

您可以使用以下命令执行远程目标的发现:

[root@nginx ~]# iscsiadm -m discovery -t st -p portal_ip[:port]

参数说明:

- portal_ip参数是目标门户的IP地址。

- 如果未指定port参数,它将使用默认端口3260。

步骤:

#发现设备

[root@nginx ~ 15:00:25]# iscsiadm -m discovery -t st -p 10.1.8.10

10.1.8.10:3260,1 iqn.2025-11.cloud.gcf.storage.x8664:webapp

要使用列出的目标之一,请使用以下命令登录到该目标:

[root@nginx ~]# iscsiadm -m node -T Target -p portal_ip[:port] -l

步骤:

#重启服务。

[root@nginx ~ 15:09:50]# systemctl restart iscsid

#登录设备,出现successful表示成功。

#-l 代表登入。

[root@nginx ~ 15:11:09]# iscsiadm -m node -T iqn.2025-11.cloud.gcf.storage.x8664:webapp -l

Logging in to [iface: default, target: iqn.2025-11.cloud.gcf.storage.x8664:webapp, portal: 10.1.8.10,3260] (multiple)

Login to [iface: default, target: iqn.2025-11.cloud.gcf.storage.x8664:webapp, portal: 10.1.8.10,3260] `successful.`

格式化 iSCSI 设备

如果发现的块设备已经具有分区,文件系统或LVM卷,则可以使用常规命令(如mount)访问该数据。 您可以使用lsblk --fs命令检查设备。

#查看块设备,注意这里在虚拟机里面添加的是SATA块设备。

[root@nginx ~ 15:14:32]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 200G 0 disk

├─sda1 8:1 0 1G 0 part /boot

└─sda2 8:2 0 199G 0 part

├─centos-root 253:0 0 50G 0 lvm /

├─centos-swap 253:1 0 3.9G 0 lvm [SWAP]

└─centos-home 253:2 0 145.1G 0 lvm /home

sdb 8:16 0 50G 0 disk

sr0 11:0 1 4.4G 0 rom

多个启动程序同时从同一目标安装同一文件系统,会导致文件系统损坏或尝试读取数据时出现不一致。 本地文件系统(例如ext4或XFS)不支持从多个系统并发安装。如果需要允许从多个系统同时访问基于iSCSI的块设备,请使用群集文件系统(例如GFS2)。

如果磁盘为空,则可以对其进行格式化,创建分区或将其用作LVM物理卷。

# 假设客户端发现的设备名称是/dev/sdb

#格式化

[root@nginx ~ 15:14:44]# mkfs.xfs /dev/sdb

meta-data=/dev/sdb isize=512 agcount=4, agsize=3276800 blks

= sectsz=512 attr=2, projid32bit=1

= crc=1 finobt=0, sparse=0

data = bsize=4096 blocks=13107200, imaxpct=25

= sunit=0 swidth=0 blks

naming =version 2 bsize=4096 ascii-ci=0 ftype=1

log =internal log bsize=4096 blocks=6400, version=2

= sectsz=512 sunit=0 blks, lazy-count=1

realtime =none extsz=4096 blocks=0, rtextents=0

#挂载

[root@nginx ~ 15:15:18]# mount /dev/sdb /usr/share/nginx/html/

#部署欢迎界面,方便验证。

[root@nginx ~ 15:16:21]# echo Hello World From iSCSI > /usr/share/nginx/html/index.html

#storage端端验证

[root@storage ~ 15:10:11]# curl http://10.1.8.11

Hello World From iSCSI

#nginx端也会显示挂载点。

[root@nginx ~ 15:16:38]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 200G 0 disk

├─sda1 8:1 0 1G 0 part /boot

└─sda2 8:2 0 199G 0 part

├─centos-root 253:0 0 50G 0 lvm /

├─centos-swap 253:1 0 3.9G 0 lvm [SWAP]

└─centos-home 253:2 0 145.1G 0 lvm /home

`sdb 8:16 0 50G 0 disk /usr/share/nginx/html`

sr0 11:0 1 4.4G 0 rom

补充:当时错误:

#当去连接nginx端时,出现这个情况是因为nginx端nginx服务未启动。

[root@storage ~ 14:11:49]# curl http://10.1.8.11

curl: (7) Failed connect to 10.1.8.11:80; Connection refused

#如果已经挂载过。

[root@nginx ~ 14:21:20]# df /dev/sdb

Filesystem 1K-blocks Used Available Use% Mounted on

/dev/sdb 52403200 32992 52370208 1% /usr/share/nginx/html

#再去登录设备就不会有输出结果,因为已经登录过了,第二次登录就不会显示。

[root@nginx ~ 14:34:29]# iscsiadm -m node -T iqn.2025-11.cloud.gcf.storage.x8664:webapp -l

#可应用该命令去查看。

[root@nginx ~ 14:24:51]# iscsiadm -m session -o show

tcp: [1] 10.1.8.10:3260,1 iqn.2025-11.cloud.gcf.storage.x8664:webapp (non-flash)

要理解 “为什么一定要开启 nginx 服务”,核心逻辑是:80 端口(HTTP 协议)的服务端功能必须由专门的软件监听并响应请求 ——nginx 就是这个 “服务端软件”,没有它,10.1.8.11 服务器的 80 端口就是 “空的”,无法处理外部的 HTTP 请求。

持久化挂载

在/etc/fstab中的iSCSI目标上持久地挂载文件系统时,请确保遵循以下建议:

- 使用带有–fs选项的lsblk命令来确定文件系统UUID,然后使用该UUID挂载文件系统。 不要使用设备名称(

/dev/sd*)。 iSCSI 设备是通过网络发现和连接的。在系统启动时,哪个 iSCSI 设备先响应、先被识别,它就会被分配一个设备名(如 /dev/sdb)。这个顺序不是固定的。如果系统重启后,设备的响应顺序发生变化,原本的 /dev/sdb 可能变成了 /dev/sdc,而 /dev/sdb 被分配给了另一个 iSCSI 设备。这时,如果你在 /etc/fstab 里写的是 /dev/sdb,系统就会把错误的设备挂载到你的目录下,导致数据错乱或服务故障。 - 在/etc/fstab中使用 _netdev 挂载选项。 因为iSCSI依赖网络访问远程设备,所以在开机时, _netdev 告诉系统:“这是一个需要网络的设备”。系统会等待网络服务和 iSCSI 启动器服务都准备好之后,再尝试挂载这个设备,避免因网络未就绪而挂载失败

示例:

#最后一行添加。

[root@nginx ~ 16:01:50]# vim /etc/fstab

`/dev/sdb /usr/share/nginx/html xfs _netdev 0 0 `

还需要确保服务iscsi开机自动启动,该服务默认是开机自动启动的。

[root@nginx ~ 15:09:50]# systemctl enable iscsi

[root@nginx ~ 15:09:50]# systemctl restart iscsid

断开目标连接

要停止使用iSCSI目标,请执行以下步骤:

-

确保没有使用目标提供的任何设备。 例如,卸载文件系统。

-

从/etc/fstab等位置删除对目标的所有持久引用。

-

从iSCSI目标注销。

#断开时先卸载。 [root@nginx ~ 14:50:30]# umount /usr/share/nginx/html #使用-u 登出。 [root@nginx ~ 14:51:05]# iscsiadm -m node -T iqn.2025-11.cloud.gcf.storage.x8664:webapp -p 10.1.8.10 -u Logging out of session [sid: 1, target: iqn.2025-11.cloud.gcf.storage.x8664:webapp, portal: 10.1.8.10,3260] Logout of [sid: 1, target: iqn.2025-11.cloud.gcf.storage.x8664:webapp, portal: 10.1.8.10,3260] successful. #也可以写成这样。 [root@nginx ~]# iscsiadm -m node -T iqn.2024-12.cloud.gcf.server:disk1 \ > -p 10.1.8.10:3260 -u -

删除 iSCSI目标的本地记录,以使启动器在引导过程中不会自动登录到目标。

#永久删除 iSCSI Target 节点配置。 #-o 是 --op 或 --operation 的简写,代表指定要执行的操作类型。 [root@nginx ~ 14:51:08]# iscsiadm -m node -T iqn.2025-11.cloud.gcf.storage.x8664:webapp -p 10.1.8.10 -o delete

注意:这里的-u与-o有本质区别,-u:仅终止连接,设备下次登录可恢复,-o:永久删除配置文件,彻底移除 Target 记录,需重新执行 discovery 发现 Target 才能再次连接。

故障处理

如果发现成功,但是启动器登录到发现的目标时遇到问题,则该问题很可能与访问控制或身份验证有关。客户端上的IQN与服务器上的IQN不匹配会导致目标登录失败。

如果问题是由于客户端上的启动器IQN不正确引起的,请在客户端的/etc/iscsi/initiatorname.iscsi文件中修复IQN,然后重新启动iscsid服务以使更改生效。

[root@nginx ~ 15:09:25]# iscsiadm -m node -T iqn.2025-11.cloud.gcf.storage.x8664:webapp -l

Logging in to [iface: default, target: iqn.2025-11.cloud.gcf.storage.x8664:webapp, portal: 10.1.8.10,32

iscsiadm: Could not login to [iface: default, target: iqn.2025-11.cloud.gcf.storage.x8664:webapp, porta

iscsiadm: initiator reported error (24 - iSCSI login `failed due to authorization failure)`

iscsiadm: Could not log into all portals

#若是遇到这个问题。

原因:iscsid 服务缓存了之前客户端扫描时使用的IQN。

处理方法:停止 iscsid 服务,释放之前客户端扫描时使用的IQN。

[root@nginx ~ 15:09:50]# systemctl restart iscsid

# 重新发现

[root@nginx ~ 15:00:25]# iscsiadm -m discovery -t st -p 10.1.8.10

10.1.8.10:3260,1 iqn.2025-11.cloud.gcf.storage.x8664:webapp

# 重新登录

[root@nginx ~ 15:11:09]# iscsiadm -m node -T iqn.2025-11.cloud.gcf.storage.x8664:webapp -l

Logging in to [iface: default, target: iqn.2025-11.cloud.gcf.storage.x8664:webapp, portal: 10.1.8.10,3260] (multiple)

Login to [iface: default, target: iqn.2025-11.cloud.gcf.storage.x8664:webapp, portal: 10.1.8.10,3260] `successful.`

多路径访问

服务端准备

准备两个网络,targetcli中的portal也配置两个。效果如下:

#nginx端和storage端都加一个仅主机模式的NAT1网卡

[root@nginx ~ 16:04:07]# ip -br a

lo UNKNOWN 127.0.0.1/8 ::1/128

ens32 UP 10.1.8.11/24 fe80::3985:5d93:8e44:149c/64

ens33 UP 10.1.1.11/24 fe80::1b7b:b22d:5f3:42d/64

[root@storage ~ 15:17:03]# ip -br a

lo UNKNOWN 127.0.0.1/8 ::1/128

ens32 UP 10.1.8.10/24 fe80::fa6d:6d2a:7014:f7c7/64

ens34 UP 10.1.1.10/24 fe80::87d0:f4a7:1bcd:d4ec/64

#添加一条路径

[root@storage ~ 16:13:33]# targetcli /iscsi/iqn.2025-11.cloud.gcf.storage.x8664:webapp/tpg1/portals/ \

> create 10.1.1.10 3260

Using default IP port 3260

Created network portal 10.1.1.10:3260.

#保存。

[root@storage ~ 16:27:36]# targetcli saveconfig

Configuration saved to /etc/target/saveconfig.json

#最后出现这样的效果

[root@storage ~ 16:27:38]# targetcli ls

......

[Portals: 2]

| o- 10.1.1.10:3260 ............................................................ [OK]

| o- 10.1.8.10:3260 ............................................................ [OK]

o- loopback .................................................................. [Targets: 0]

#在nginx端重新发现并登录。

[root@nginx ~ 16:02:03]# iscsiadm -m discovery -t sendtargets -p 10.1.8.10

10.1.8.10:3260,1 iqn.2025-11.cloud.gcf.storage.x8664:webapp

10.1.1.10:3260,1 iqn.2025-11.cloud.gcf.storage.x8664:webapp

[root@nginx ~ 16:03:59]# iscsiadm -m node -T iqn.2025-11.cloud.gcf.storage.x8664:webapp -l

Logging in to [iface: default, target: iqn.2025-11.cloud.gcf.storage.x8664:webapp, portal: 10.1.1.10,3260] (multiple)

Login to [iface: default, target: iqn.2025-11.cloud.gcf.storage.x8664:webapp, portal: 10.1.1.10,3260] successful.

什么是多路径

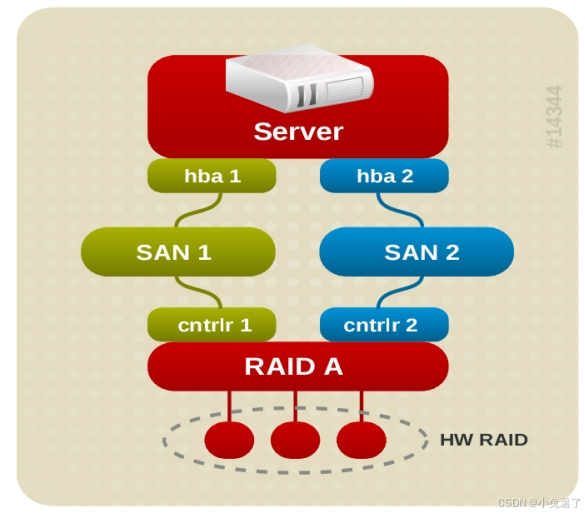

多路径是指服务器和存储阵列存在多个物理连接方式使用虚拟设备,这种方式可以提供更加弹性的存储连接(一个路径down掉不会影响连接性),也可以聚合存储带宽提供性能。

示例:

多路径由dm-multipath子系统提供,使用内核device mapper系统获得虚拟设备,有multipathd进程和multipath命令行工具管理。

软件包device-mapper-multipath提供必要的binaries daemon和kernel modules。安装、配置、启动后,多路径设备节点会创建在两个位置。

出于管理目的,multipath设备创建在/dev/mapper,如果选择了user-friendly名称,这些设备也可以命名为mpathN[pM],或者配置在World Wide ID(WWID)之后。管理员也可以自定义多路径设备名,这些自定义名称在multipaths配置文件的multipaths部分使用alias选项定义。

多路径设备也会创建在/dev目录,格式/dev/dm-N与/dev/mapper下的文件匹配。这些设备提供给系统内部使用,禁止管理目的直接使用。

重要:多路径提供存储访问路径down情况的保护。如果存储本身不可用,访问访问存储也会不可用。

创建多路径设备,不同的路径将会合并到组中,取决于/etc/multipath.conf配置。典型情况,同一时刻只能激活一个组,一个组可以包含多个路径。当某个组故障,多路径进程将切换流量到不同组中。

配置多路径

安装软件包

[root@nginx ~ 16:05:07]# yum install -y device-mapper-multipath

启用多路径

创建配置文件 /etc/multipath.conf 最简单的方法是使用mpathconf工具:

-

如果文件不存在,使用以下命令生成配置文件。也可以从默认位置/usr/share/doc/device-mapper-multipath-*/multipath.conf拷贝过来。

[root@nginx ~ 16:05:44]# mpathconf --enable [root@nginx ~ 16:05:57]# ls /etc/multipath.conf /etc/multipath.conf -

如果文件已经存在,则以下命令会修改文件配置。

[root@client ~]# mpathconf --enable --with_multipathd y --with_chkconfig y

编辑配置文件后,使用 systemctl 命令 enable 和 start multipathd 进程。

[root@nginx ~ 16:06:15]# systemctl enable multipathd.service --now

发现设备

过程省略。

确定设备是同一设备

WWN(World Wide Name),全球唯一名称,是由 IEEE 标准化的全球唯一标识符,用于标识存储设备(如硬盘、RAID 阵列、光纤交换机等),每个设备具有全球唯一名称。应用场景:在光纤通道(FC)、iSCSI 等存储网络中,用于识别和定位存储设备。

WWN 是判断多路径设备是否指向同一存储设备的 核心依据:所有属于同一多路径设备的物理路径(如sdb、sdc),其对应的存储设备 WWN 必然相同。

scsi_id 命令

[root@nginx ~ 16:04:39]# /usr/lib/udev/scsi_id -g -u /dev/sdb

36001405d0fbfbafbc904a3b8694e61e4

[root@nginx ~ 16:05:05]# /usr/lib/udev/scsi_id -g -u /dev/sdc

36001405d0fbfbafbc904a3b8694e61e4

udevadm 命令

[root@nginx ~]# udevadm info --query=property --name=/dev/sdb | grep ID_WWN_W

ID_WWN_WITH_EXTENSION=0x600140559c2883e039048cbbce4320b4

[root@nginx ~]# udevadm info --query=property --name=/dev/sdC | grep ID_WWN_W

ID_WWN_WITH_EXTENSION=0x600140559c2883e039048cbbce4320b4

通过 UUID 或其他标识符辅助判断

[root@nginx ~]# blkid /dev/sdb

/dev/sdb: UUID="3c4cd1fc-8e65-4ce5-a85d-0b9a79e582b4" TYPE="xfs"

[root@nginx ~]# blkid /dev/sdc

/dev/sdc: UUID="3c4cd1fc-8e65-4ce5-a85d-0b9a79e582b4" TYPE="xfs"

监控多路径

multipath命令也可用于多路径状态监控。

- -l 选项,显示多路径拓扑简介。

- -ll 选项,会检测所有路径是否active,如果没有问题,路径的状态为active和ready。命令输出还会包括每个多路径设备的信息,有三个部分组成:多路径设备,path group,path group成员。

示例:

[root@nginx ~ 16:20:58]# multipath -ll

mpatha (36001405d0fbfbafbc904a3b8694e61e4) dm-3 LIO-ORG ,webapp01

size=50G features='0' hwhandler='0' wp=rw

|-+- policy='service-time 0' prio=1 status=active

| `- 33:0:0:0 sdb 8:16 active ready running

`-+- policy='service-time 0' prio=1 status=enabled

`- 35:0:0:0 sdc 8:32 active ready running

#如果-ll没有输出结果的话,说明多路径设备识别有问题,需要卸载,再重启服务,就可以了。

[root@nginx ~ 16:13:54]# multipath -ll

[root@nginx ~ 16:13:58]# umount /dev/sdb

[root@nginx ~ 16:20:37]# multipath -ll

[root@nginx ~ 16:20:42]# systemctl restart multipathd.service

[root@nginx ~ 16:20:58]# multipath -ll

mpatha (36001405d0fbfbafbc904a3b8694e61e4) dm-3 LIO-ORG ,webapp01

size=50G features='0' hwhandler='0' wp=rw

|-+- policy='service-time 0' prio=1 status=active

| `- 33:0:0:0 sdb 8:16 active ready running

`-+- policy='service-time 0' prio=1 status=enabled

`- 35:0:0:0 sdc 8:32 active ready running

#解决后要记得重新加载。

[root@nginx ~ 16:21:02]# mount /dev/mapper/mpatha /usr/share/nginx/html/

-

第一部分是多路径设备信息。

-

第一行:alias wwid 设备名 vendor 和产品信息。

WWID(World Wide Identifier),全球唯一标识符,是 Linux 多路径软件(

multipath)使用的逻辑标识符,用于标识多路径设备(由多个物理路径聚合而成的逻辑设备)。 -

第二行:size enabled features hardware handlers和写权限。

-

-

第二部分是多路径设备的path group,包括调度策略,优先级和path group 状态,紧随的是其成员path。对于每个path,也就是设备节点名,包括设备major和minor信息,path的状态。

- 状态为up,随时可以执行IO操作的path,显示的状态为ready。

- 状态为down,显示为faulty。

failover 的策略是active-passive配置,因此在任一时刻,只有一个路径是active状态,另外一个是enabled状态。

配置文件

配置文件 /etc/multipath.conf,包含5个部分:

-

defaults,定义了所有多路径的默认配置,会被devices和multipaths块配置覆盖。

-

blacklist,定义了多路径设备中不允许使用的设备。

-

blacklist_exceptions,定义了多路径设备中应该包含的设备,即使设备已经定义在blacklist中。

-

devices,指定特定设备类型,会被multipaths块覆盖。device是通过他们的vendor product和revision(修正)关键字识别(来自于sysfs的正则表达式匹配)。

-

multipaths,包含指定路径,会覆盖defaults块和devices块中定义的设备。多路径基于他们的WWIDs识别(使用getuid_callout函数获得)。

覆盖方式:multipaths > devices > defaults。

Defaults

完整的默认设置可以参考/usr/share/doc/device-mapper-multipath-*/multipath.conf.defaults。

一些有趣的设置:

-

path_selector:定义了组中下一次IO路径选择的算法。默认是“service-time 0”,提供给服务消耗时间最少的路径。备用算法,“round-robin 0”,分发IO给组中所有路径。rr_min_io_rq,定义每个IO路径发送多少个请求后转换到下一个IO路径。“queue-length 0”,定义下一个IO请求发送给最短队列长度的路径。

-

path_grouping_policy:多路径是如何合并到priority组中。默认是failover,每个路径放入单独的组。multibus,所有可能的路径都聚合到一个组中。在使用multibus前,确保存储控制器支持active-active连接。

-

path_check:定义multipathd进程如何确定路径是否healthy。包括硬件独立选项,directio和readsector0等,默认为directio,一般会被devices{}配置覆盖。

-

features:定义启用的多路径功能。语法格式:num list。num代表启用的功能,list代表启用的功能列表。例如,queue_if_no_path和no_partitions。

-

user_friendly_names:定义在未定义alias情况下,多路径名称是否为mpathN。

在mpathconf命令创建的默认配置文件中,默认开启了user_friendly_names选项,多路径设备名称以用户友好方式命名为mpathN。只有一个多路径设备的时候比较有用,但有多个多路径设备,这些设备名称就会混淆。禁用用户友好名称,mpathconf命令创建时指定选项–user_friendly_names n,多路径设备名称将命名在他们的WWIDs之后。

警告:如果启用了queue_if_no_path,设置features “1 queue_if_no_path”,路径fail,处理IO的进程将挂起直到路径恢复。这个行为在集群部署中是不希望看到的,因为一个节点的IO挂起会导致集群其他节点访问存储。解决方法,指定no_path_retry参数值为fail,路径失败后将会立刻通知更高层,而非阻塞IO直到路径恢复。

multipaths

用于为特定多路径设定不同的path_grouping策略,设定多路径alias。

multipaths {

multipath {

wwid 360014057202ac29e3cd4d24850ed82f3

alias ClusterStorage

path_grouping_policy failover

}

}

#进入文件将设备名修改,防止重启时系统识别不到出现错误。

[root@nginx ~ 16:24:27]# vim /etc/fstab

/dev/mapper/webapp /usr/share/nginx/html xfs _netdev 0 0

#修改配置文件。

[root@nginx ~ 16:29:40]# vim /etc/multipath.conf

#最后一行加上下面的内容。

multipaths {

multipath {

wwid 36001405d0fbfbafbc904a3b8694e61e4

alias webapp

path_grouping_policy failover

}

}

#卸载。

[root@nginx ~ 16:30:18]# umount /usr/share/nginx/html

#重启服务。

[root@nginx ~ 16:30:30]# systemctl restart multipathd.service

#验证,多路径名称变成了webapp。

[root@nginx ~ 16:31:01]# multipath -ll

`webapp` (36001405d0fbfbafbc904a3b8694e61e4) dm-3 LIO-ORG ,webapp01

size=50G features='0' hwhandler='0' wp=rw

|-+- policy='service-time 0' prio=1 status=active

| `- 33:0:0:0 sdb 8:16 active ready running

`-+- policy='service-time 0' prio=1 status=enabled

`- 35:0:0:0 sdc 8:32 active ready running

使用设备

多路径设备名称为 /dev/mapper/mpatha,识别到设备后就可以正常使用。

示例:划分分区,格式化,挂载。

[root@nginx ~ 16:23:28]# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 200G 0 disk

├─sda1 8:1 0 1G 0 part /boot

└─sda2 8:2 0 199G 0 part

├─centos-root 253:0 0 50G 0 lvm /

├─centos-swap 253:1 0 3.9G 0 lvm [SWAP]

└─centos-home 253:2 0 145.1G 0 lvm /home

sdb 8:16 0 50G 0 disk

└─mpatha 253:3 0 50G 0 mpath /usr/share/nginx/html

sdc 8:32 0 50G 0 disk

└─mpatha 253:3 0 50G 0 mpath /usr/share/nginx/html

sr0 11:0 1 4.4G 0 rom

[root@nginx ~ 16:21:02]# mount /dev/mapper/mpatha /usr/share/nginx/html/

[root@nginx ~ 16:23:36]# df /usr/share/nginx/html/

Filesystem 1K-blocks Used Available Use% Mounted on

/dev/mapper/mpatha 52403200 32996 52370204 1% /usr/share/nginx/html

持久化挂载

[root@client ~]# vim /etc/fstab

# 最后增加一条

/dev/mapper/mpatha1 /usr/share/nginx/html xfs _netdev 0 0

[root@client ~]# systemctl daemon-reload

[root@client ~]# umount /usr/share/nginx/html

[root@client ~]# mount -a

[root@client ~]# df -h /usr/share/nginx/html

Filesystem Size Used Avail Use% Mounted on

/dev/mapper/mpatha1 10G 104M 9.9G 2% /var/www/html

高可用性测试

测试1:断开server端第二块网卡

[root@server ~ 16:35:07]# nmcli device disconnect ens34

Device 'ens34' successfully disconnected.

以下显示了passive状态的path group发生了故障。active状态的path group保持不变。

[root@nginx ~ 16:33:02]# watch multipath -ll

Every 2.0s: multipath -ll Sat Nov 22 16:36:44 2025

webapp (36001405d0fbfbafbc904a3b8694e61e4) dm-3 LIO-ORG ,webapp01

size=50G features='0' hwhandler='0' wp=rw

|-+- policy='service-time 0' prio=1 status=active

| `- 33:0:0:0 sdb 8:16 active ready running

`-+- policy='service-time 0' prio=0 status=enabled

`- 35:0:0:0 sdc 8:32 `failed faulty `running

#第二块网卡的状态变成failed faulty

#重新启用第二块网卡

[root@server ~ 16:37:20]# nmcli connection up ens34

Connection successfully activated (D-Bus active path: /org/freedesktop/NetworkManager/ActiveConnection/5)

#又恢复状态了

[root@nginx ~ 16:33:02]# watch multipath -ll

Every 2.0s: multipath -ll Sat Nov 22 16:37:48 2025

webapp (36001405d0fbfbafbc904a3b8694e61e4) dm-3 LIO-ORG ,webapp01

size=50G features='0' hwhandler='0' wp=rw

|-+- policy='service-time 0' prio=1 status=active

| `- 33:0:0:0 sdb 8:16 active ready running

`-+- policy='service-time 0' prio=1 status=enabled

`- 35:0:0:0 sdc 8:32 `active ready `running

测试2:断开server端第一块网卡

#断开第一块网卡。

[root@server ~ 16:37:20]# nmcli connection up ens34

Connection successfully activated (D-Bus active path: /org/freedesktop/NetworkManager/ActiveConnection/5)

#观察状态,发现第二块网卡由enabled变成了active。

[root@nginx ~ 16:40:46]# watch multipath -ll

Every 2.0s: multipath -ll Sat Nov 22 16:46:02 2025

webapp (36001405d0fbfbafbc904a3b8694e61e4) dm-3 LIO-ORG ,webapp01

size=50G features='0' hwhandler='0' wp=rw

|-+- policy='service-time 0' prio=0 status=enabled

| `- 33:0:0:0 sdb 8:16 failed faulty running

`-+- policy='service-time 0' prio=1 status=active

`- 35:0:0:0 sdc 8:32 active ready running

重要:故障路径恢复后,当前的active path保持不变,即使恢复的路径之前是active path,可以通过手动切换回来。

andler=‘0’ wp=rw

|-± policy=‘service-time 0’ prio=1 status=active

| - 33:0:0:0 sdb 8:16 active ready running -± policy=‘service-time 0’ prio=1 status=enabled

- 35:0:0:0 sdc 8:32 active ready `running

**测试2**:断开server端第一块网卡

```bash

#断开第一块网卡。

[root@server ~ 16:37:20]# nmcli connection up ens34

Connection successfully activated (D-Bus active path: /org/freedesktop/NetworkManager/ActiveConnection/5)

#观察状态,发现第二块网卡由enabled变成了active。

[root@nginx ~ 16:40:46]# watch multipath -ll

Every 2.0s: multipath -ll Sat Nov 22 16:46:02 2025

webapp (36001405d0fbfbafbc904a3b8694e61e4) dm-3 LIO-ORG ,webapp01

size=50G features='0' hwhandler='0' wp=rw

|-+- policy='service-time 0' prio=0 status=enabled

| `- 33:0:0:0 sdb 8:16 failed faulty running

`-+- policy='service-time 0' prio=1 status=active

`- 35:0:0:0 sdc 8:32 active ready running

重要:故障路径恢复后,当前的active path保持不变,即使恢复的路径之前是active path,可以通过手动切换回来。

939

939

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?