- 是否支持公平锁/非公平锁

所谓的公平锁,是指当拥有锁的线程释放锁后,锁的下一个获取者就是锁等待队列中的第一个元素,而非公平锁并没有这个限制,ReentrantLock支持,而synchronized不支持。

1.2 共享锁

与互斥锁相对应的是共享锁,所谓的共享锁是同一时间可以被多个线程共同申请,一个非常经典的使用场景就是读写锁。

例如在一个缓存场景,在一个商品系统中,为了提供对商品的访问性能,通常会引入一个缓存区(Map)来缓存商品的数据,缓存数据对查询请求(读请求)是可以并行执行的,即多个线程同时查询缓存区的数据,这个是一个非常安全的操作,但不允许多个线程对缓存区进行修改。这里共享锁的意义就发挥出来了。

既然多个线程对缓存区可以同时进行读操作,那为什么还要加共享锁呢?主要的目的是避免写操作与读操作同时进行。

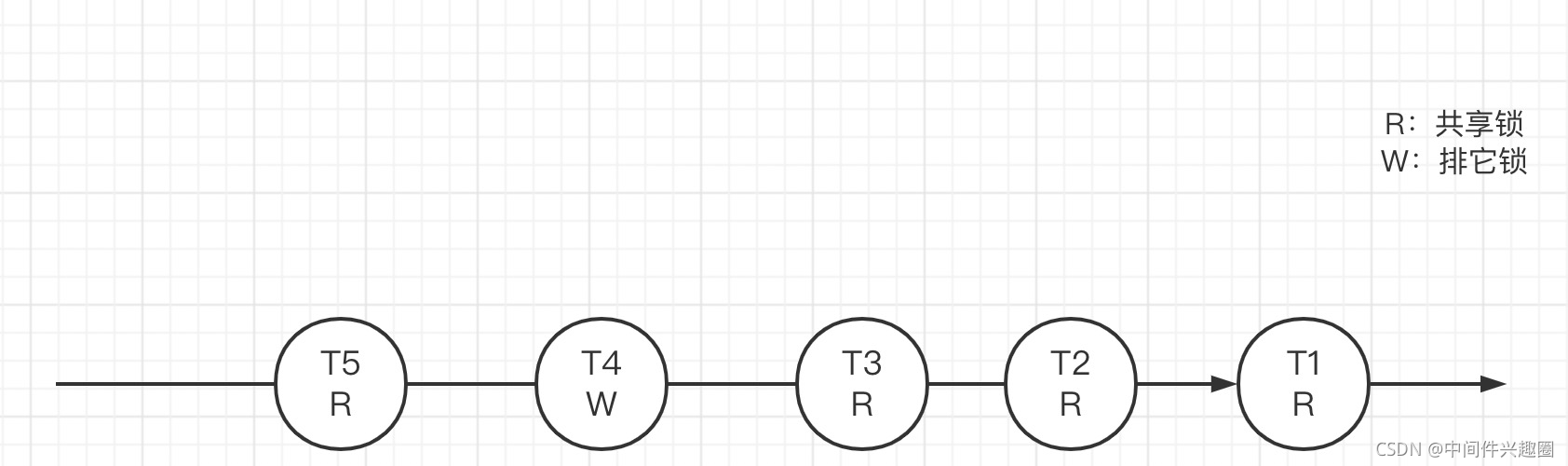

只要当前有读操作在进行,写操作就需要排队,请看如下示例图:

如上图所示:例如 线程T1,T2,T3连续申请共享锁,然后T4申请写锁,再T5申请读锁,那各个线程的并发执行情况如下所示:

-

线程 T1、T2、T3 将并发执行

-

T4由于是申请的写锁,必须等 T1、T2、T3释放锁后,才能执行。

-

T5虽然申请是共享锁,但由于T4持有写锁,故T5也需要阻塞,直至T4释放锁。

在Java等世界中按锁的排斥性来分基本就包含排它锁与共享锁,其他读写锁、间隙锁等是以锁的粒度这个纬度进行细分。

在了解了锁的基本语意义之后,我们有必要来阐述一下锁的实现原理。

从某种意义上来说,锁的实现原理就是两个队列:同步阻塞队列、条件等待队列。

2.1 阻塞队列

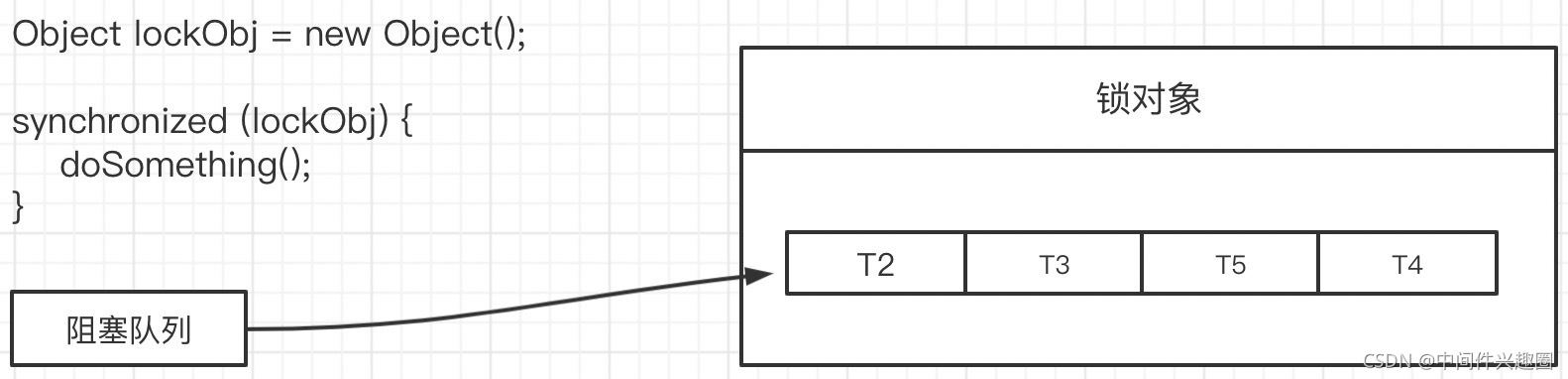

阻塞队列的作用说明如下图所示:

上面使用来synchronized,其传入的是一个锁对象,如果此时有5个线程同时去执行这段代码,由于锁的互斥性,同一时间只有一个线程能获得锁,其他线程需要排队等待,故需要引入一个队列来存储在这些排队的线程,所以synchronized的实现机制中,会在锁对象中开辟一个队列,用来存储等待获取当前锁的线程。

2.2 条件等待队列

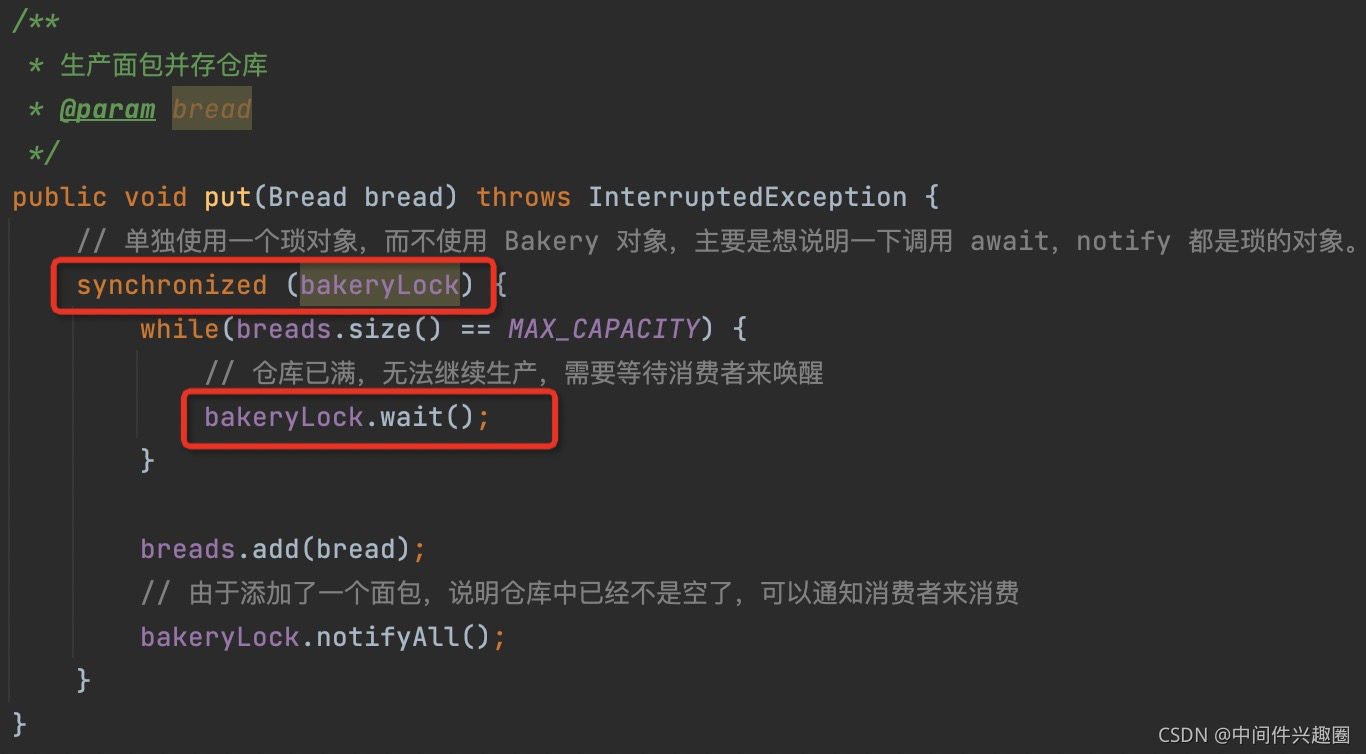

Object对象中有一对特殊的方法:wait()/notify()/notifyAll(),大家在前文中应该看到消费者/生产者中示例中,使用过wait,notify方法,示例代码如下:

wait方法必须在synchronized中调用,并且通常是线程调用锁对象的wait方法,表示当前继续往下执行的条件不足,当前线程需要等待,故需要为锁对象再维护一个个队列,用来存储等待的线程,俗称条件等待队列。

当其他线程调用锁对象的notify方法或notifyAll方法,会唤醒等待队列中的线程。

温馨提示:上述还有几个关键点:

- Object.wait方法,会使当前线程进入等待状态,并且释放锁。

- 通常条件等待会使用while语句,避免条件不满足时被误唤醒,故使用while对条件进行再一次的判断。

- 当被唤醒后,并不立即去执行while条件判断,而是需要重新去申请锁,即可能会进入到阻塞队列。

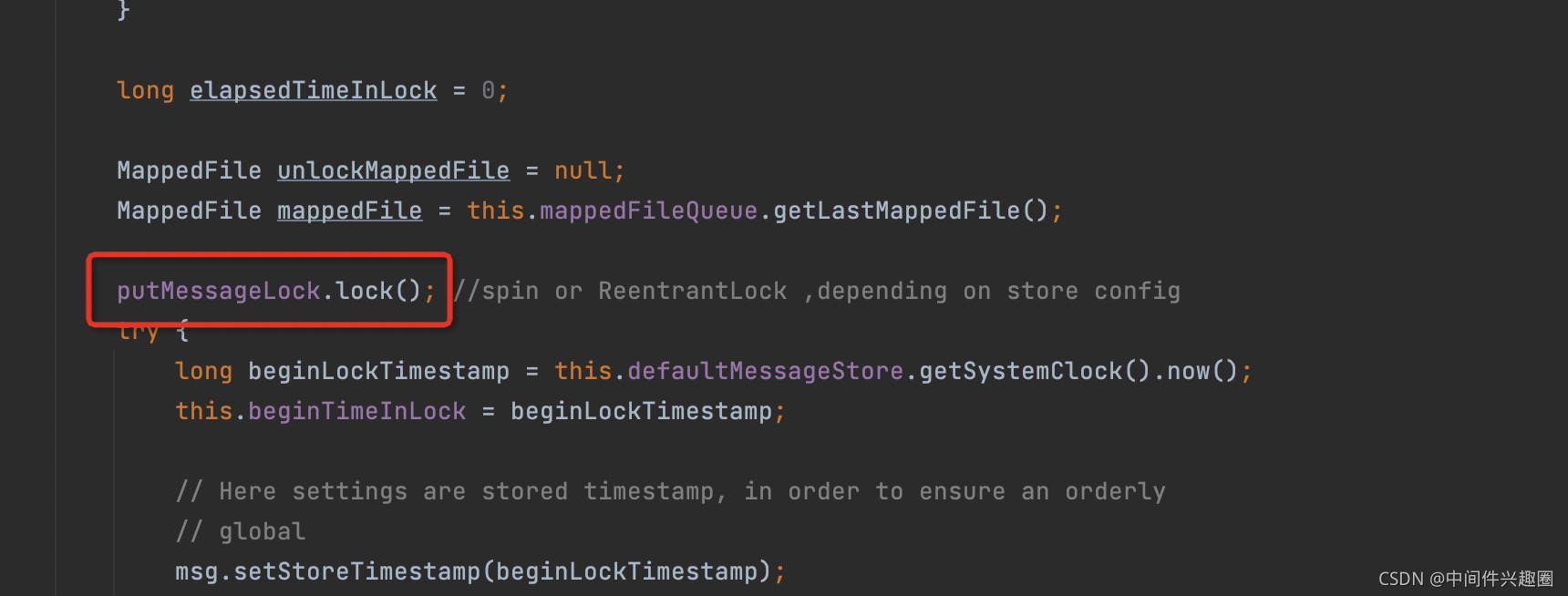

我相信作为一个程序员,大家都对锁很敏感,因为性能低下,但锁肯定有其存在的原因,主要解决数据访问的安全性,大家可能会感到惊讶,作为一款高性能的消息中间件(RocketMQ),在消息写入时也使用了锁,其代码如下:

这是因为RocketMQ是顺序写文件,多个请求同时申请写一个文件,必须排队执行,否则会带来逻辑异常,此时锁是不用不行了。

对锁的优化策略,通常基于如下原则:能不用锁就不使用锁,必须使用锁则尽量保证被锁包裹代码的快速执行、降低锁的粒度。

3.1 优化锁执行时间

当然能不用锁就不用锁,但有些场景是必须使用锁来保证多线程环境下结果的正确性,就以RocketMQ顺序写commitlog文件为例,对同一个文件写入,需要记录当前的写入位置,然后另外一个线程就进行追加,故这个为写入位置是多线程不安全的,故必须引入锁,那RocketMQ作为一款高性能的消息中间件,是如何做到消息发送的高并发,低延迟能力低呢?

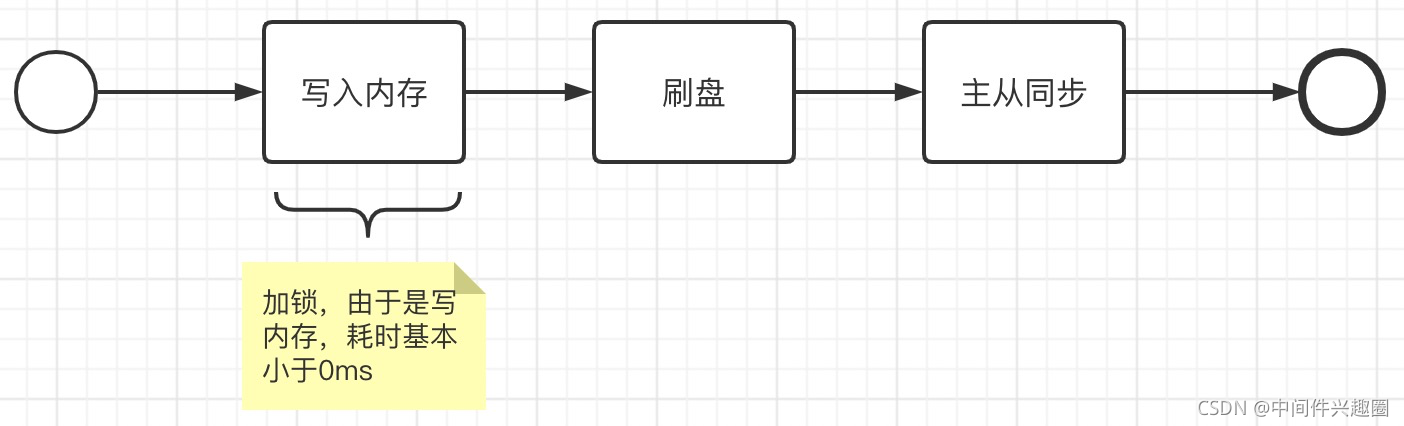

核心法宝:控制锁的范围,确保被锁包含的代码执行性能高效,接下来我们看一下RocketMQ消息写入的几个重要步骤:

并不是需要将上述三个步骤都加锁,而是只对写内存这段加锁即可,这段代码非常高效。

3.2 优化锁的粒度

锁的性能优化是一个永恒的主旨,另外一个核心思路是:降低锁的粒度,提高并发度。

接下来我们以JDK中的HashTable与ConcurrentHashMap的实现原理为例,让大家体会一下如何降低锁的粒度从而提高并发度。

Hashtable的性能低下是众所周知,因为整个容器就一把锁,因为它的get、put都是被synchronized修饰,synchronized用来修饰非static方法,其锁对象为Hashtable是对象锁。

并发度:同一时间只有一个线程能向该容器添加数据、获取数据。

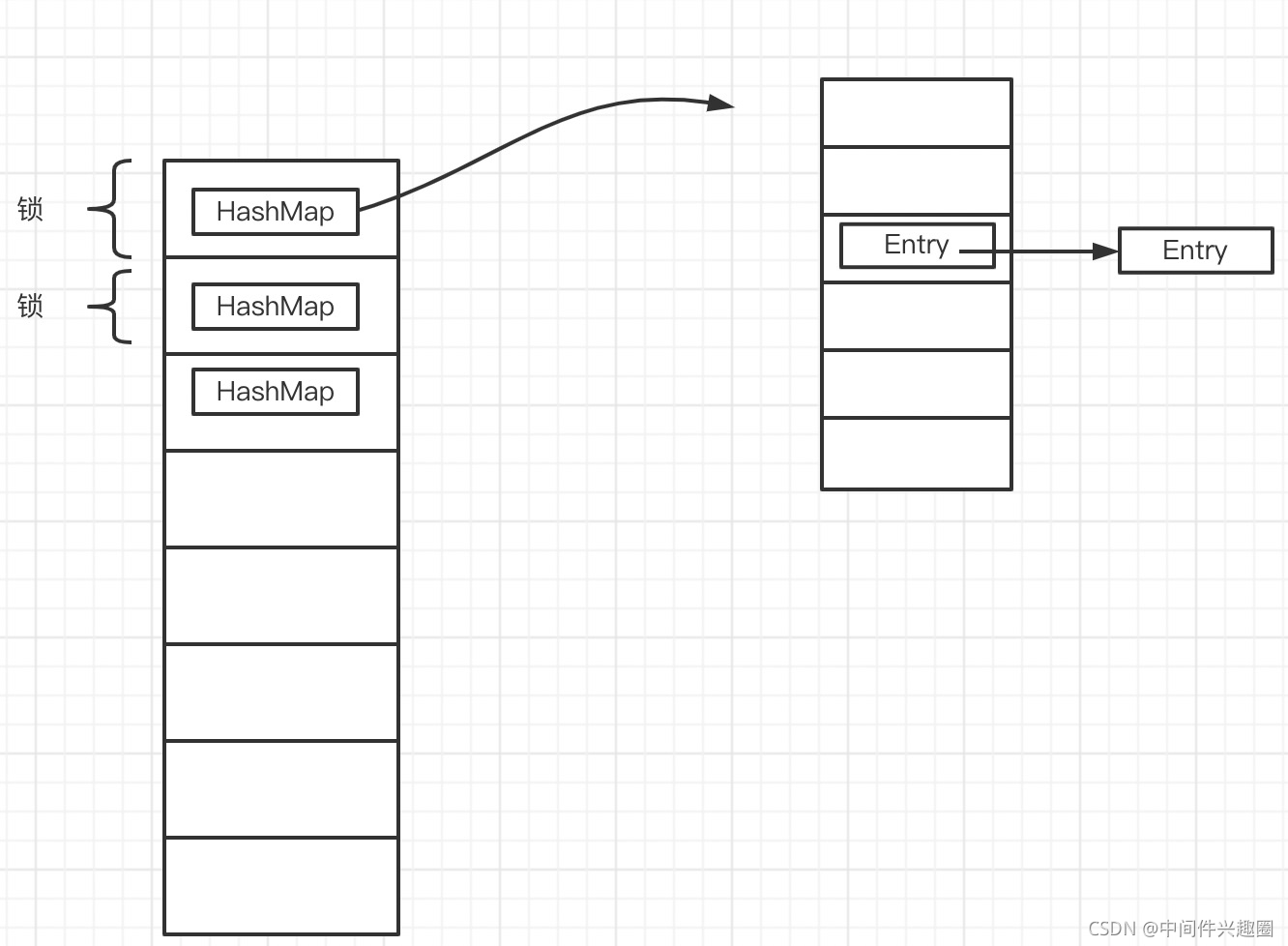

而jkd1.7及其版本,ConcurrentHashMap的内部数据结构如下图所示:

可以看出ConcurrentHashMap的设计思路是将整个HashMap分割成多个小的HashMap,然后为每一个HashMap加锁,从而降低锁的粒度,从而提高并发度。

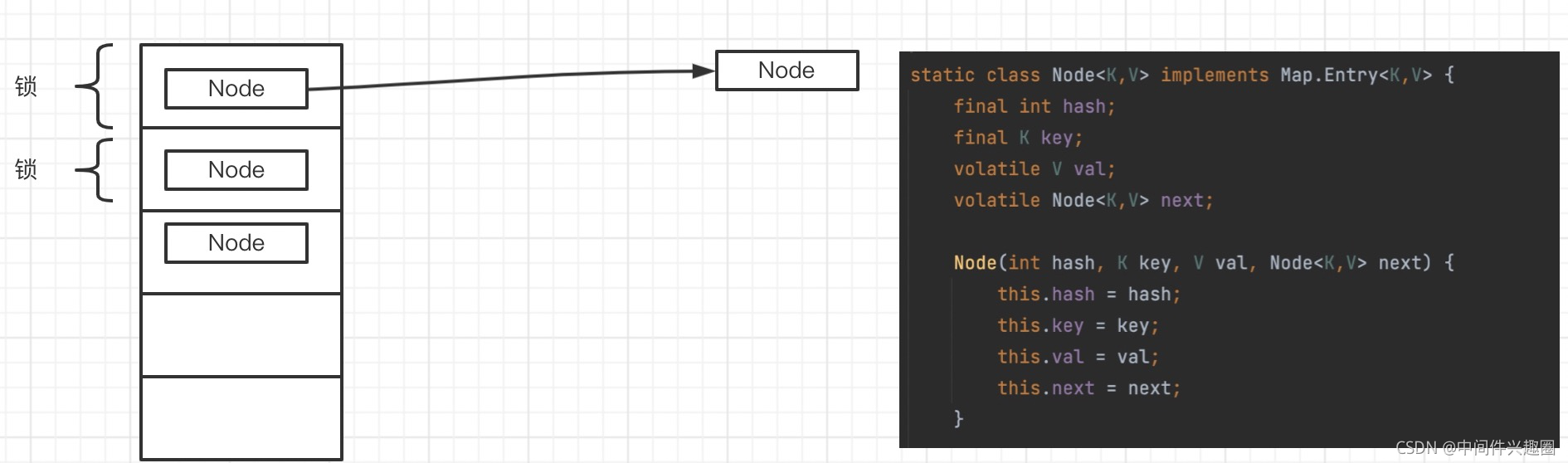

在JDK1.8及版本后,ConcurrentHashMap的存储结构又发了很大改变,摒弃分段思想,使用来数组 + Node ,进一步释放读写的并发度,其数据结构如下图所示:

其中,对每一个链表的Node节点,写操作时会加锁,但在查询时候,并不会对各个Node加锁,提高读操作的并发度;并且会基于CAS机制实现无锁化处理,使用volatile保证可见性。

本文并不准备去剖析ConcurrentHashMap的实现细节,后续专门从源码实现的角度深度剖析,敬请期待,也请持续关注我。

3.3 无锁化设计

锁的存在必然有其使用场景,特别是需要被锁保护的资源众多,即临界区中的逻辑复杂,对其进行拆分会使代码变的臃肿,直接使用锁保护会清晰明了,但评估是否需要引入锁时需要慎重,特别是一些对吞吐量有极高要求的场景,能不用锁就不要用锁.

无锁化设计的基础:CAS,比较和交换。

在Java领域也提供了对应的原子操作工具:CAS,CAS 操作包含三个操作数 —— 内存位置(V)、预期原值(A)和新值(B)。 如果内存位置的值与预期原值相匹配,那么处理器会自动将该位置值更新为新值 。否则,处理器不做任何操作。CAS是CPU指令级命令。

最后

2020年在匆匆忙忙慌慌乱乱中就这么度过了,我们迎来了新一年,互联网的发展如此之快,技术日新月异,更新迭代成为了这个时代的代名词,坚持下来的技术体系会越来越健壮,JVM作为如今是跳槽大厂必备的技能,如果你还没掌握,更别提之后更新的新技术了。

更多JVM面试整理:

来了新一年,互联网的发展如此之快,技术日新月异,更新迭代成为了这个时代的代名词,坚持下来的技术体系会越来越健壮,JVM作为如今是跳槽大厂必备的技能,如果你还没掌握,更别提之后更新的新技术了。

[外链图片转存中…(img-MOSGnodq-1714505680847)]

更多JVM面试整理:

[外链图片转存中…(img-QJWZEyyL-1714505680848)]

7809

7809

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?