运行

创建好自定义的类后,切换到Comics路径下,运行命令,启动爬虫任务开始爬取网页。

scrapy crawl comics

打印的结果为爬虫运行过程中的信息,和目标爬取网页的html源码。

2016-11-26 22:04:35 [scrapy] INFO: Scrapy 1.2.1 started (bot: Comics)

2016-11-26 22:04:35 [scrapy] INFO: Overridden settings: {‘ROBOTSTXT_OBEY’: True, ‘BOT_NAME’: ‘Comics’, ‘NEWSPIDER_MODULE’: ‘Comics.spiders’, ‘SPIDER_MODULES’: [‘Comics.spiders’]}

2016-11-26 22:04:35 [scrapy] INFO: Enabled extensions:

[‘scrapy.extensions.corestats.CoreStats’,

‘scrapy.extensions.telnet.TelnetConsole’,

‘scrapy.extensions.logstats.LogStats’]

…

此时,一个基本的爬虫创建完成了,下面是具体过程的实现。

爬取漫画图片

起始地址

爬虫的起始地址为:

http://www.xeall.com/shenshi

我们主要的关注点在于页面中间的漫画列表,列表下方有显示页数的控件。如下图所示

1.jpg

爬虫的主要任务是爬取列表中每一部漫画的图片,爬取完当前页后,进入下一页漫画列表继续爬取漫画,依次不断循环直至所有漫画爬取完毕。

起始地址的url我们放在了start_requests函数的urls数组中。其中start_requests是重载了父类的方法,爬虫任务开始时会执行到这个方法。

start_requests方法中主要的执行在这一行代码:请求指定的url,请求完成后调用对应的回调函数self.parse

scrapy.Request(url=url, callback=self.parse)

对于之前的代码其实还有另一种实现方式:

#coding:utf-8 import scrapy class Comics(scrapy.Spider): name = “comics” start_urls = [‘http://www.xeall.com/shenshi’] def parse(self, response): self.log(response.body);

start_urls是框架中提供的属性,为一个包含目标网页url的数组,设置了start_urls的值后,不需要重载start_requests方法,爬虫也会依次爬取start_urls中的地址,并在请求完成后自动调用parse作为回调方法。

不过为了在过程中方便调式其它的回调函数,demo中还是使用了前一种实现方式。

爬取漫画url

从起始网页开始,首先我们要爬取到每一部漫画的url。

当前页漫画列表

起始页为漫画列表的第一页,我们要从当前页中提取出所需信息,动过实现回调parse方法。

在开头导入BeautifulSoup库

from bs4 import BeautifulSoup

请求返回的html源码用来给BeautifulSoup初始化。

def parse(self, response): content = response.body; soup = BeautifulSoup(content, “html5lib”)

初始化指定了html5lib解释器,若没安装这里会报错。BeautifulSoup初始化时若不提供指定解释器,则会自动使用自认为匹配的最佳解释器,这里有个坑,对于目标网页的源码使用默认最佳解释器为lxml,此时解析出的结果会有问题,而导致无法进行接下来的数据提取。所以当发现有时候提取结果又问题时,打印soup看看是否正确。

查看html源码可知,页面中显示漫画列表的部分为类名为listcon的ul标签,通过listcon类能唯一确认对应的标签

2.jpg

提取包含漫画列表的标签

listcon_tag = soup.find(‘ul’, class_=‘listcon’)

上面的find方法意为寻找class为listcon的ul标签,返回的是对应标签的所有内容。

在列表标签中查找所有拥有href属性的a标签,这些a标签即为每部漫画对应的信息。

com_a_list = listcon_tag.find_all(‘a’, attrs={‘href’: True})

然后将每部漫画的href属性合成完整能访问的url地址,保存在一个数组中。

comics_url_list = []

base = ‘http://www.xeall.com’

for tag_a in com_a_list:

url = base + tag_a[‘href’]

comics_url_list.append(url)

此时comics_url_list数组即包含当前页每部漫画的url。

下一页列表

看到列表下方的选择页控件,我们可以通过这个地方来获取到下一页的url。

3.jpg

获取选择页标签中,所有包含href属性的a标签

page_tag = soup.find(‘ul’, class_=‘pagelist’)

page_a_list = page_tag.find_all(‘a’, attrs={‘href’: True})

这部分源码如下图,可看到,所有的a标签中,倒数第一个代表末页的url,倒数第二个代表下一页的url,因此,我们可以通过取page_a_list数组中倒数第二个元素来获取到下一页的url。

5.jpg

但这里需要注意的是,若当前为最后一页时,不需要再取下一页。那么如何判断当前页是否是最后一页呢?

可以通过select控件来判断。通过源码可以判断,当前页对应的option标签会具有selected属性,下图为当前页为第一页

4.jpg

下图为当前页为最后一页

6.jpg

通过当前页数与最后一页页数做对比,若相同则说明当前页为最后一页。

select_tag = soup.find(‘select’, attrs={‘name’: ‘sldd’})

option_list = select_tag.find_all(‘option’)

last_option = option_list[-1]

current_option = select_tag.find(‘option’ ,attrs={‘selected’: True})

is_last = (last_option.string == current_option.string)

当前不为最后一页,则继续对下一页做相同的处理,请求依然通过回调parse方法做处理

if not is_last: next_page = ‘http://www.xeall.com/shenshi/’ + page_a_list[-2][‘href’] if next_page is not None: print(‘\n------ parse next page --------’) print(next_page) yield scrapy.Request(next_page, callback=self.parse)

通过同样的方式依次处理每一页,直到所有页处理完成。

爬取漫画图片

在parse方法中提取到当前页的所有漫画url时,就可以开始对每部漫画进行处理。

在获取到comics_url_list数组的下方加上下面代码:

for url in comics_url_list:

yield scrapy.Request(url=url, callback=self.comics_parse)

对每部漫画的url进行请求,回调处理方法为self.comics_parse,comics_parse方法用来处理每部漫画,下面为具体实现。

当前页图片

首相将请求返回的源码构造一个BeautifulSoup,和前面基本一致

def comics_parse(self, response): content = response.body; soup = BeautifulSoup(content, “html5lib”)

提取选择页控件标签,页面显示和源码如下所示

7.jpg

8.jpg

提取class为pagelist的ul标签

page_list_tag = soup.find(‘ul’, class_=‘pagelist’)

查看源码可以看到当前页的li标签的class属性thisclass,以此获取到当前页页数

current_li = page_list_tag.find(‘li’, class_=‘thisclass’)

page_num = current_li.a.string

当前页图片的标签和对应源码

9.jpg

10.jpg

获取当前页图片的url,以及漫画的标题。漫画标题之后用来作为存储对应漫画的文件夹名称。

li_tag = soup.find(‘li’, id=‘imgshow’)

img_tag = li_tag.find(‘img’)

img_url = img_tag[‘src’]

title = img_tag[‘alt’]

保存到本地

当提取到图片url时,便可通过url请求图片并保存到本地

self.save_img(page_num, title, img_url)

定义了一个专门用来保存图片的方法save_img,具体完整实现如下

先导入库

import os

import urllib

import zlib

def save_img(self, img_mun, title, img_url):

将图片保存到本地

self.log('saving pic: ’ + img_url)

保存漫画的文件夹

document = ‘/Users/moshuqi/Desktop/cartoon’

每部漫画的文件名以标题命名

comics_path = document + ‘/’ + title

exists = os.path.exists(comics_path)

if not exists:

self.log('create document: ’ + title)

os.makedirs(comics_path)

每张图片以页数命名

pic_name = comics_path + ‘/’ + img_mun + ‘.jpg’

检查图片是否已经下载到本地,若存在则不再重新下载

exists = os.path.exists(pic_name)

if exists:

self.log('pic exists: ’ + pic_name)

return

try:

user_agent = ‘Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)’

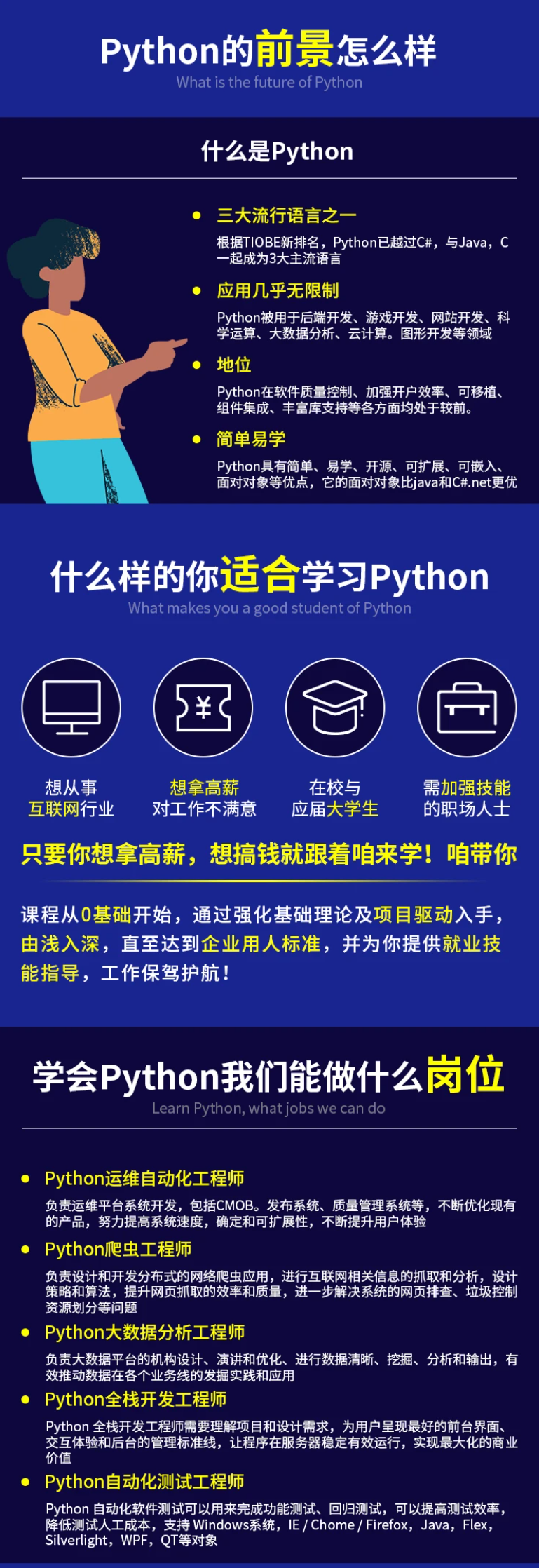

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数Python工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Python开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Python开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加V获取:vip1024c (备注Python)

最后

不知道你们用的什么环境,我一般都是用的Python3.6环境和pycharm解释器,没有软件,或者没有资料,没人解答问题,都可以免费领取(包括今天的代码),过几天我还会做个视频教程出来,有需要也可以领取~

给大家准备的学习资料包括但不限于:

Python 环境、pycharm编辑器/永久激活/翻译插件

python 零基础视频教程

Python 界面开发实战教程

Python 爬虫实战教程

Python 数据分析实战教程

python 游戏开发实战教程

Python 电子书100本

Python 学习路线规划

ython)**

[外链图片转存中…(img-ldUi3cK3-1711958434481)]

最后

不知道你们用的什么环境,我一般都是用的Python3.6环境和pycharm解释器,没有软件,或者没有资料,没人解答问题,都可以免费领取(包括今天的代码),过几天我还会做个视频教程出来,有需要也可以领取~

给大家准备的学习资料包括但不限于:

Python 环境、pycharm编辑器/永久激活/翻译插件

python 零基础视频教程

Python 界面开发实战教程

Python 爬虫实战教程

Python 数据分析实战教程

python 游戏开发实战教程

Python 电子书100本

Python 学习路线规划

663

663

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?