操作easyexcel最简单方式,使用阿里巴巴组件easyexcel(操作简单需求,复杂excel可以考虑使用apache的poi,之后有时间也会出poi的文章)

可以参考官方文档 https://easyexcel.opensource.alibaba.com/docs/current/

一、导入easyexcel的pom文件

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>easyexcel</artifactId>

<version>3.0.5</version>

</dependency>

二、接收excel实体类示例(@ExcelProperty(index = 0),index指定列)每个属性代表excel的一列

@Data

public class FactoryTypeDetailDto {

@ExcelProperty(index = 0)//index0表示对应excel文件的第一列

private String id;

@ExcelProperty(index = 1)

private String name;

@ExcelProperty(index = 2)

private String subId;

@ExcelProperty(index = 3)

private Integer typeDetail;

}

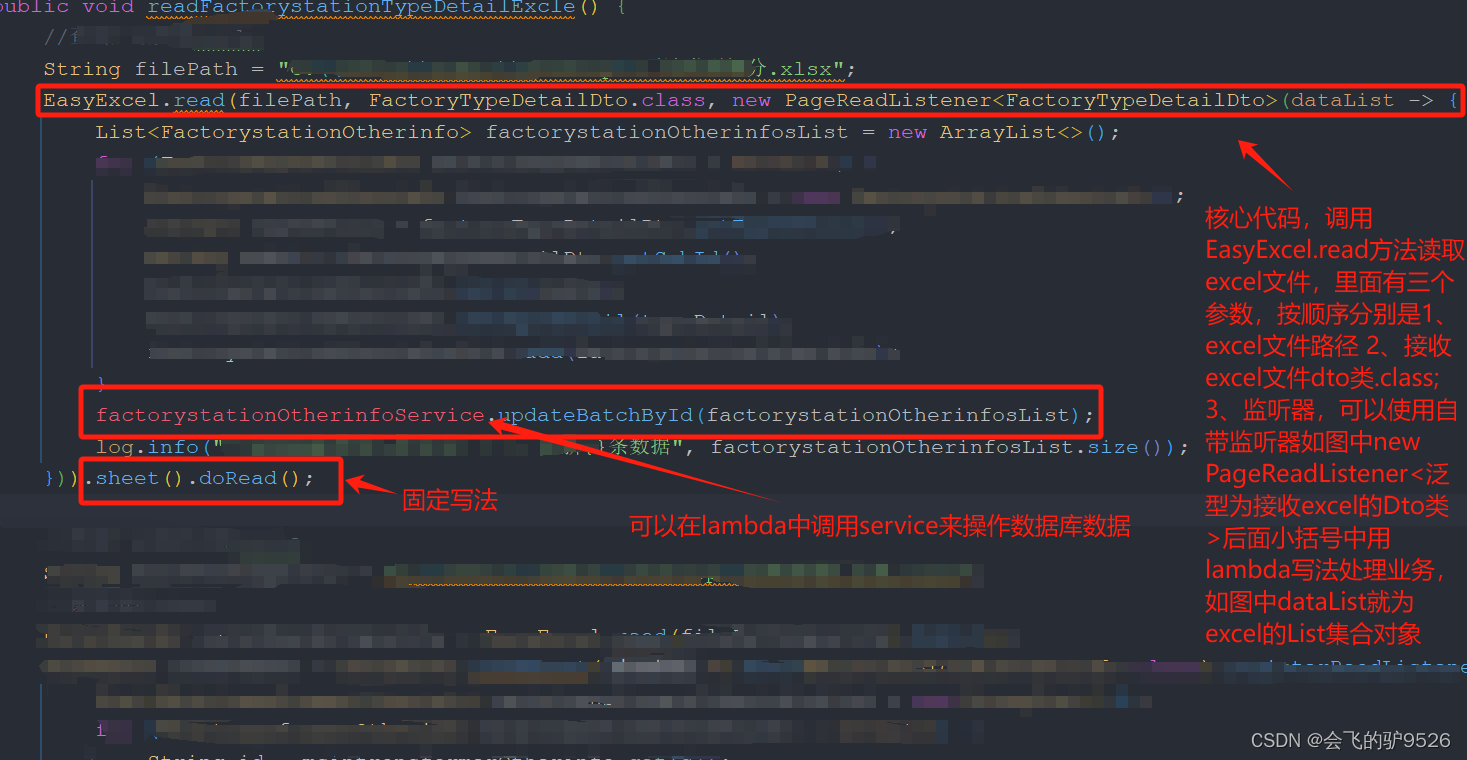

三、1、业务代码示例(以下为使用自带监听器,这是最简单的使用方式;也可以手动新建一个监听器类来更灵活的配置)适用于只有一个sheet的excel

2.监听器使用第二种方式手动创建监听器

package com.situ.balance.util.excle_listener;

import cn.hutool.core.util.StrUtil;

import com.alibaba.excel.context.AnalysisContext;

import com.alibaba.excel.read.listener.ReadListener;

import com.alibaba.excel.util.ListUtils;

import com.alibaba.fastjson2.JSON;

import lombok.extern.slf4j.Slf4j;

import java.util.List;

@Slf4j

public class SubstationListener implements ReadListener<SubstationInstalledcapacity> {

/**

* 每隔5条存储数据库,实际使用中可以100条,然后清理list ,方便内存回收

*/

private static final int BATCH_COUNT = 100;

/**

* 缓存的数据

*/

private List<SubstationInstalledcapacity> cachedDataList = ListUtils.newArrayListWithExpectedSize(BATCH_COUNT);

/**

* 假设这个是一个DAO,当然有业务逻辑这个也可以是一个service。当然如果不用存储这个对象没用。

*/

private SubstationInstalledcapacityService substationInstalledcapacityService;

public SubstationListener() {

// 这里是demo,所以随便new一个。实际使用如果到了spring,请使用下面的有参构造函数

}

/**

* 如果使用了spring,请使用这个构造方法。每次创建Listener的时候需要把spring管理的类传进来

*

* @param

*/

public SubstationListener(SubstationInstalledcapacityService substationInstalledcapacityService) {

this.substationInstalledcapacityService = substationInstalledcapacityService;

}

/**

* 这个每一条数据解析都会来调用

*

* @param data one row value. Is is same as {@link AnalysisContext#readRowHolder()}

* @param context

*/

@Override

public void invoke(SubstationInstalledcapacity data, AnalysisContext context) {

log.info("解析到一条数据:{}", JSON.toJSONString(data));

cachedDataList.add(data);

// 达到BATCH_COUNT了,需要去存储一次数据库,防止数据几万条数据在内存,容易OOM

if (cachedDataList.size() >= BATCH_COUNT) {

saveData();

// 存储完成清理 list

cachedDataList = ListUtils.newArrayListWithExpectedSize(BATCH_COUNT);

}

}

/**

* 所有数据解析完成了 都会来调用

*

* @param context

*/

@Override

public void doAfterAllAnalysed(AnalysisContext context) {

// 这里也要保存数据,确保最后遗留的数据也存储到数据库

log.info("所有数据解析完成!");

}

/**

* 加上存储数据库

*/

private void saveData() {

log.info("{}条数据,开始存储数据库!", cachedDataList.size());

//保存数据库

substationInstalledcapacityService.saveOrUpdateBatch(cachedDataList);

log.info("存储数据库成功!");

}

}

使用监听器时将所需service作为参数传进去,因为监听器不会被spring管理

例如:

EasyExcel.read(filePath, 你自己接收excel的类.class, new ReadListener<你自己接收excel的类>(你需要用到的service)).sheet().doRead();

四、指定sheet用法

String excelpath= "aaa.xlsx"; ExcelReader excelReader = EasyExcel.read(excelpath).build(); //readSheet(0)代表读取第一个sheet ReadSheet readSheet = EasyExcel.readSheet(0).head(excel接收类.class).registerReadListener(new PageReadListener<excel接收类>(dataList -> { })).build();//第二个sheet

ReadSheet readSheet1 = EasyExcel.readSheet(1).head(excel接收类.class).registerReadListener(new PageReadListener<excel接收类>(dataList -> { })).build();//最后调用read方法

excelReaderPoli.read(readSheet , readSheet1 );

2845

2845

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?