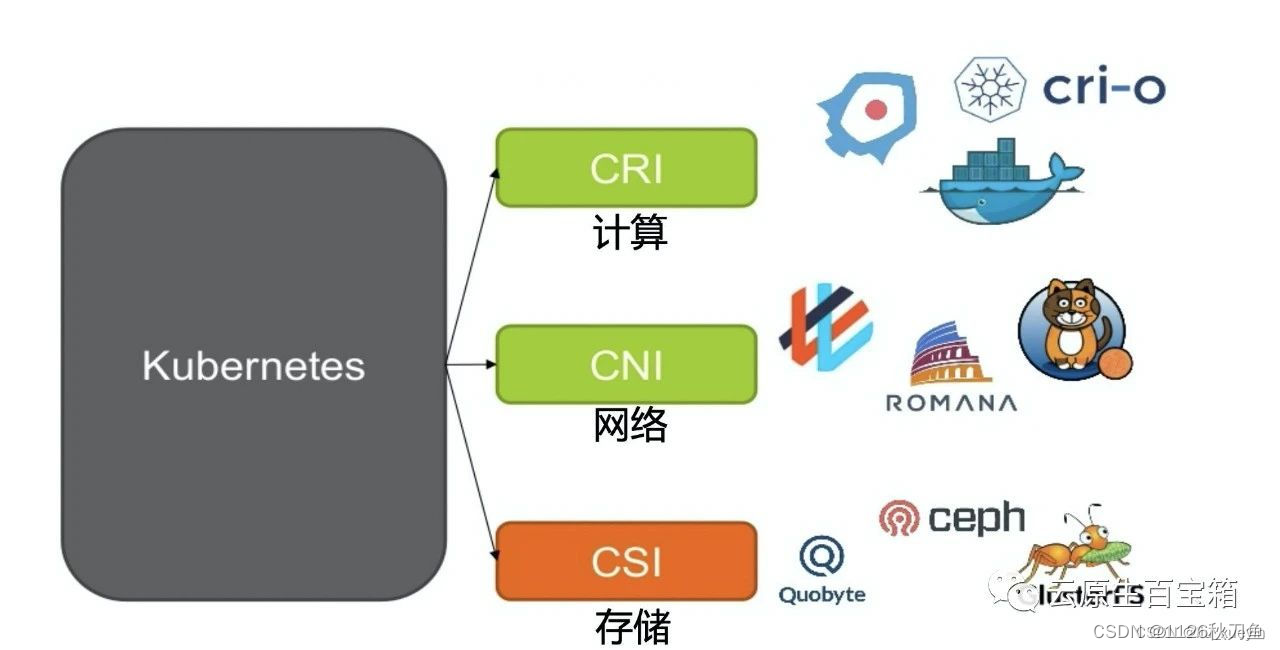

一、k8s集群的三种接口

前言,k8s集群有三大接口:

CRI:容器进行时接口,连接容器引擎--docker、containerd、cri-o、podman(k8s本身是容器编排工具,不具备运行容器的能力,因此要通过容器进行接口去运行)

CNI:容器网络接口,用于连接网络插件如:flannel、calico、cilium(pod容器跨节点依然能像在本机里面通信)

CSI:容器存储接口,如nfs、ceph、gfs、oss、s3、minio

二、k8s的三种网络模式

关于k8s的三种类型的网络IP

节点网络:nodeIP---node节点的物理网卡ip,实现node节点之间的通信

Pod网络:PodIP---Pod与Pod之间通过PodIP进行通信

service网络:clusterIP---k8s集群内部,service资源的clusterIP实现对Pod集群的网络代理

k8s集群中pod网络通信分类

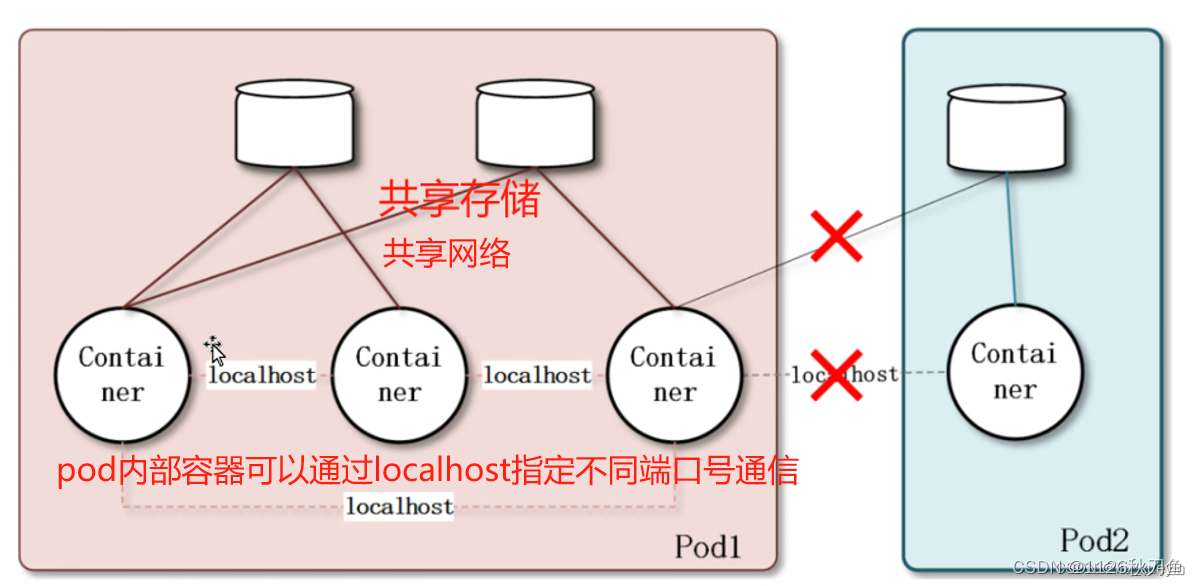

1、pod内容器之间的通信

在同一个 Pod 内的容器(Pod 内的容器是不会跨宿主机的)共享同一个网络命令空间,相当于它们在同一台机器上一样,可以用 localhost 地址访问彼此的端口。

2、同一个node节点中pod之间通信

每个 Pod 都有一个真实的全局 IP 地址,同一个 Node 内的不同 Pod 之间可以直接采用对方 Pod 的 IP 地址进行通信,Pod1 与 Pod2 都是通过 Veth 连接到同一个 docker0 网桥,网段相同,所以它们之间可以直接通信。

3、不同的node节点的pod之间通信

Pod 地址与 docker0 在同一网段,docker0 网段与宿主机网卡是两个不同的网段,且不同 Node 之间的通信只能通过宿主机的物理网卡进行。

要想实现不同 Node 上 Pod 之间的通信,就必须想办法通过主机的物理网卡 IP 地址进行寻址和通信。因此要满足两个条件:①Pod 的 IP 不能冲突;将 Pod 的 IP 和所在的 Node 的 IP 关联起来,②通过这个关联让不同 Node 上 Pod 之间直接通过内网 IP 地址通信。

总结:因此引入了cni网络插件的核心原因实际上就是为了解决不同node节点上的不同pod之间的通信,即pod跨主机通信

Overlay Network

叠加网络,在二层或者三层基础网络上叠加的一种虚拟网络技术模式,该网络中的主机通过虚拟链路隧道连接起来(类似于VPN)

个人理解为正常的数据包是一层 也就是【mac头+ip头+udp/tcp头+真实数据】,这种叠加网络就是说把【mac头+ip头+udp/tcp头+真实数据】看做一个整体,作为真实数据 再次封装,{【mac头+ip头+udp/tcp头】+【mac头+ip头+udp/tcp头+真实数据】} 这种看成一个整体

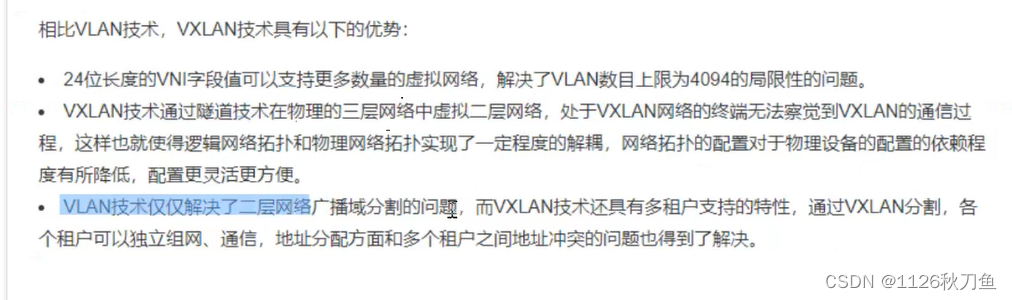

VXLAN

将源数据包封装到UDP中,并使用基础网络的IP/MAC作为外层报文头进行封装,然后在以太网上传输,到达目的地后由隧道端点解封装并将数据发送给目标地址。

补充:vxlan与vlan的区别:

vlan:是2的12次方个 两个都具有隔离广播域的功能

三、flannel网络插件

Flannel 的功能是让集群中的不同节点主机创建的 Docker 容器都具有全集群唯一的虚拟 IP 地址。(让pod的虚拟ip作为唯一ip)

Flannel 是 Overlay 网络的一种,也是将 TCP 源数据包封装在另一种网络包里面进行路由转发和通信,目前支持 udp、vxlan(性能最好)、 host-GW 3种数据转发方式。

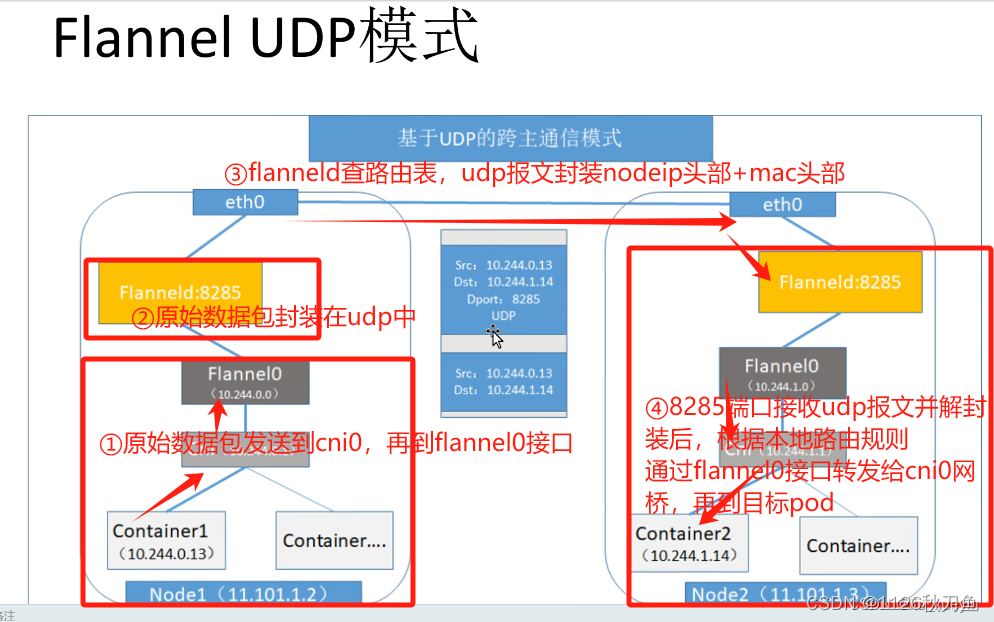

1、flannel插件模式之UDP模式(8285端口)

总结:udp模式的工作核心是基于flanneld应用进行原始数据包封装在udp报文中,属于overlay网络的一种

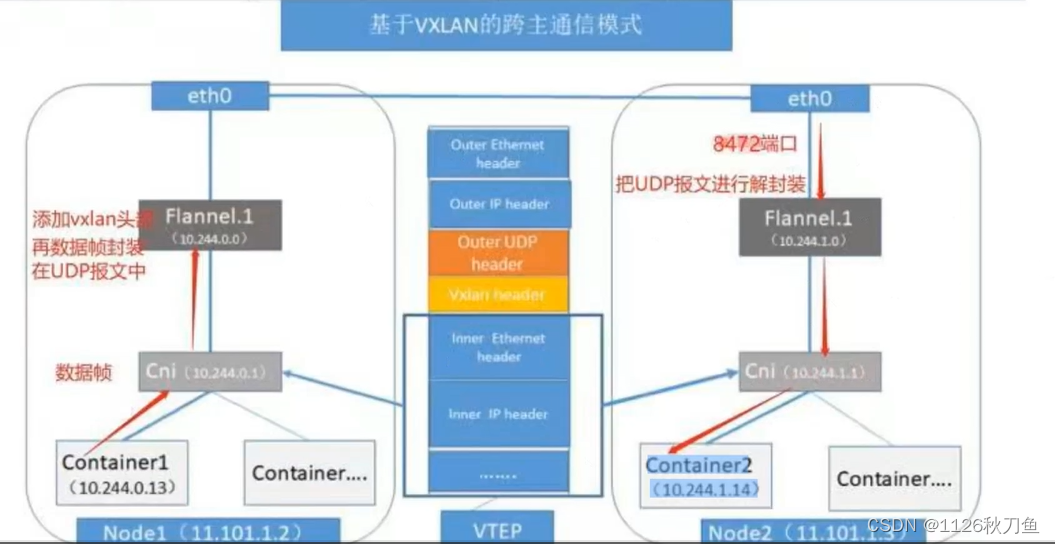

2、flannel插件模式之VXLAN模式

(在传输层是数据段 网络层是数据包 数据链路层是数据帧 物理层是比特流)

第一步:原始数据帧从源主机的pod容器发出到cni0网桥,再由cni0转发给flannel.1虚拟接口

第二步:flannel.1接口接收数据帧以后先添加vxlan头部,然后在内核将原始数据帧封装在UDP报文中

第三步:flanneld会查询etcd中的路由表信息获取目标pod的nodeip,然后再udp报文外封装nodeip头部和mac头部,通过物理网卡发送给目标node节点

第四步:报文会通过8472端口到目标node节点的flannel.1接口,并在内核中解封装,最后根据本地的路由规则转发到cni0网桥,再发送到目标pod容器

3、总结flannel插件的三大模式

部署网络组件

部署 flannel

在Node1节点上操作 node2 一样的操作方式

#上传 cni-plugins-linux-amd64-v0.8.6.tgz 和 flannel.tar 到 /opt 目录中

cd /opt/

docker load -i flannel.tar

mkdir /opt/cni/bin

tar zxvf cni-plugins-linux-amd64-v0.8.6.tgz -C /opt/cni/bin

在Master1节点上操作

#上传 kube-flannel.yml 文件到 /opt/k8s 目录中,部署 CNI 网络

cd /opt/k8s

kubectl apply -f kube-flannel.yml

kubectl get pods -n kube-system

NAME READY STATUS RESTARTS AGE

kube-flannel-ds-lk4t8 0/1 Init:0/1 0 8s

kubectl get nodes

NAME STATUS ROLES AGE VERSION

192.168.241.23 NotReady <none> 21h v1.20.11

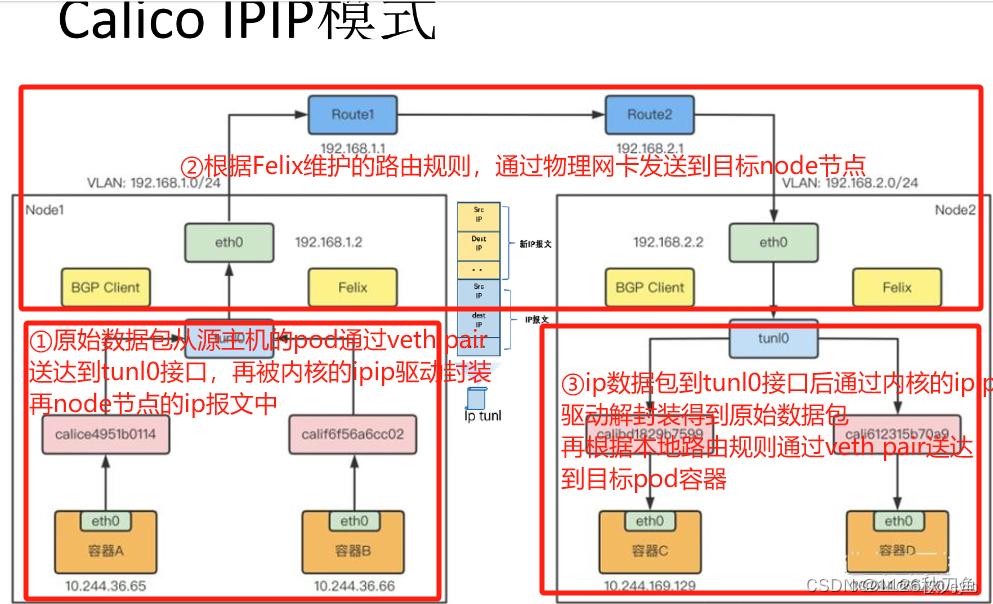

calico网络插件

2、calico插件模式之BGP模式(无法跨网段使用)

calico的BGP模式工作原理(本质就是通过路由规则来实现Pod之间的通信)

每个Pod容器都有一个 veth pair 设备,一端接入容器,另一个接入宿主机网络空间,并设置一条路由规则。

这些路由规则都是 Felix 维护配置的,由 BIRD 组件基于 BGP 动态路由协议分发路由信息给其它节点。

1)原始数据包从源主机的Pod容器发出,通过 veth pair 设备送达到宿主机网络空间

2)根据Felix维护的路由规则通过物理网卡发送到目标node节点

3)目标node节点接收到数据包后,会根据本地路由规则通过 veth pair 设备送达到目标Pod容器

3、总结calico插件三大模式

(1)从模式来讲

flannel插件的模式有:udp、vxlan、host-gw

calico插件的模式有:IPIP、BGP、CrossSubnet(混合模式)

(2)从默认网段来讲

flannel默认的网段是10.244.0.0/16

calico默认的网段是192.168.0.0/16

(3)从模式的性能来讲

flannel

通常会采用VXLAN模式,用的是叠加网络、IP隧道方式传输数据,对性能有一定的影响。

Flannel产品成熟,依赖性较少,易于安装,功能简单,配置方便,利于管理。但是不具备复杂的网络策略配置能力。

calico

使用IPIP模式可以实现跨子网传输,但是传输过程中需要额外的封包和解包过程,对性能有一定的影响。

使用BGP模式会把每个node节点看作成路由器,通过Felix、BIRD组件来维护和分发路由规则,可实现直接通过BGP路由协议实现路由转发,传输过程中不需要额外封包和解包过程,因此性能较好,但是只能在同一个网段里使用,无法跨子网传输。

calico不使用cni0网桥,而使通过路由规则把数据包直接发送到目标主机,所以性能较高;而且还具有更丰富的网络策略配置管理能力,功能更全面,但是维护起来较为复杂。

(4)从使用场景来讲

对于较小规模且网络要求简单的K8S集群,可以采用flannel作为cni网络插件;

对于K8S集群规模较大且要求更多的网络策略配置时,可以考虑采用性能更好功能更全面的calico或cilium。

部署Calico

- 在 master01 节点上操作

-

cd /opt/k8s #切换目录 #上传 calico.yaml 文件到 /opt/k8s 目录中,部署 CNI 网络 ------------------------------------------------------------------------------------------------------ vim calico.yaml #修改里面定义 Pod 的网络(CALICO_IPV4POOL_CIDR),需与前面 kube-controller-manager 配置文件指定的 cluster-cidr 网段一样 - name: CALICO_IPV4POOL_CIDR value: "10.244.0.0/16" #Calico 默认使用的网段为 192.168.0.0/16 ------------------------------------------------------------------------------------------------------ kubectl apply -f calico.yaml #指定yml文件启动calico服务 kubectl get pods -n kube-system #查询指定命名空间(namespace)下的 Pod 资源 #等 Calico Pod 都 Running,节点也会准备就绪 kubectl get nodes #查看集群所有节点信息(STATUS:Ready)

- node01节点

部署 CoreDNS

- CoreDNS:可以为集群中的 service 资源创建一个域名 与 IP 的对应关系解析

-

准备需要的镜像

- 在所有 node 节点上操作

-

cd /opt #切换目录 #上传 coredns.tar 到 /opt 目录中 docker load -i coredns.tar #将镜像文件导入到镜像库中 - node01节点

- node02节点

准备yml文件启动coredns服务

- 在 master01 节点上操作

cd /opt/k8s

#切换目录

#上传 coredns.yaml 文件到 /opt/k8s 目录中,部署 CoreDNS

--------------------------------------------------------------------------------------------------------

# __MACHINE_GENERATED_WARNING__

apiVersion: v1

kind: ServiceAccount

metadata:

name: coredns

namespace: kube-system

labels:

kubernetes.io/cluster-service: "true"

addonmanager.kubernetes.io/mode: Reconcile

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

labels:

kubernetes.io/bootstrapping: rbac-defaults

addonmanager.kubernetes.io/mode: Reconcile

name: system:coredns

rules:

- apiGroups:

- ""

resources:

- endpoints

- services

- pods

- namespaces

verbs:

- list

- watch

- apiGroups:

- ""

resources:

- nodes

verbs:

- get

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

annotations:

rbac.authorization.kubernetes.io/autoupdate: "true"

labels:

kubernetes.io/bootstrapping: rbac-defaults

addonmanager.kubernetes.io/mode: EnsureExists

name: system:coredns

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: system:coredns

subjects:

- kind: ServiceAccount

name: coredns

namespace: kube-system

---

apiVersion: v1

kind: ConfigMap

metadata:

name: coredns

namespace: kube-system

labels:

addonmanager.kubernetes.io/mode: EnsureExists

data:

Corefile: |

.:53 {

errors

health {

lameduck 5s

}

ready

kubernetes cluster.local in-addr.arpa ip6.arpa {

pods insecure

fallthrough in-addr.arpa ip6.arpa

ttl 30

}

prometheus :9153

forward . /etc/resolv.conf {

max_concurrent 1000

}

cache 30

loop

reload

loadbalance

}

---

apiVersion: apps/v1

kind: Deployment

metadata:

name: coredns

namespace: kube-system

labels:

k8s-app: kube-dns

kubernetes.io/cluster-service: "true"

addonmanager.kubernetes.io/mode: Reconcile

kubernetes.io/name: "CoreDNS"

spec:

# replicas: not specified here:

# 1. In order to make Addon Manager do not reconcile this replicas parameter.

# 2. Default is 1.

# 3. Will be tuned in real time if DNS horizontal auto-scaling is turned on.

strategy:

type: RollingUpdate

rollingUpdate:

maxUnavailable: 1

selector:

matchLabels:

k8s-app: kube-dns

template:

metadata:

labels:

k8s-app: kube-dns

spec:

securityContext:

seccompProfile:

type: RuntimeDefault

priorityClassName: system-cluster-critical

serviceAccountName: coredns

affinity:

podAntiAffinity:

preferredDuringSchedulingIgnoredDuringExecution:

- weight: 100

podAffinityTerm:

labelSelector:

matchExpressions:

- key: k8s-app

operator: In

values: ["kube-dns"]

topologyKey: kubernetes.io/hostname

tolerations:

- key: "CriticalAddonsOnly"

operator: "Exists"

nodeSelector:

kubernetes.io/os: linux

containers:

- name: coredns

image: k8s.gcr.io/coredns:1.7.0

imagePullPolicy: IfNotPresent

resources:

limits:

memory: 170Mi

requests:

cpu: 100m

memory: 70Mi

args: [ "-conf", "/etc/coredns/Corefile" ]

volumeMounts:

- name: config-volume

mountPath: /etc/coredns

readOnly: true

ports:

- containerPort: 53

name: dns

protocol: UDP

- containerPort: 53

name: dns-tcp

protocol: TCP

- containerPort: 9153

name: metrics

protocol: TCP

livenessProbe:

httpGet:

path: /health

port: 8080

scheme: HTTP

initialDelaySeconds: 60

timeoutSeconds: 5

successThreshold: 1

failureThreshold: 5

readinessProbe:

httpGet:

path: /ready

port: 8181

scheme: HTTP

securityContext:

allowPrivilegeEscalation: false

capabilities:

add:

- NET_BIND_SERVICE

drop:

- all

readOnlyRootFilesystem: true

dnsPolicy: Default

volumes:

- name: config-volume

configMap:

name: coredns

items:

- key: Corefile

path: Corefile

---

apiVersion: v1

kind: Service

metadata:

name: kube-dns

namespace: kube-system

annotations:

prometheus.io/port: "9153"

prometheus.io/scrape: "true"

labels:

k8s-app: kube-dns

kubernetes.io/cluster-service: "true"

addonmanager.kubernetes.io/mode: Reconcile

kubernetes.io/name: "CoreDNS"

spec:

selector:

k8s-app: kube-dns

clusterIP: 10.0.0.2

ports:

- name: dns

port: 53

protocol: UDP

- name: dns-tcp

port: 53

protocol: TCP

- name: metrics

port: 9153

protocol: TCP

--------------------------------------------------------------------------------------------------------

kubectl apply -f coredns.yaml

#指定yml配置文件启动coredns服务

kubectl get pods -n kube-system

#查询指定命名空间(namespace)下的 Pod 资源

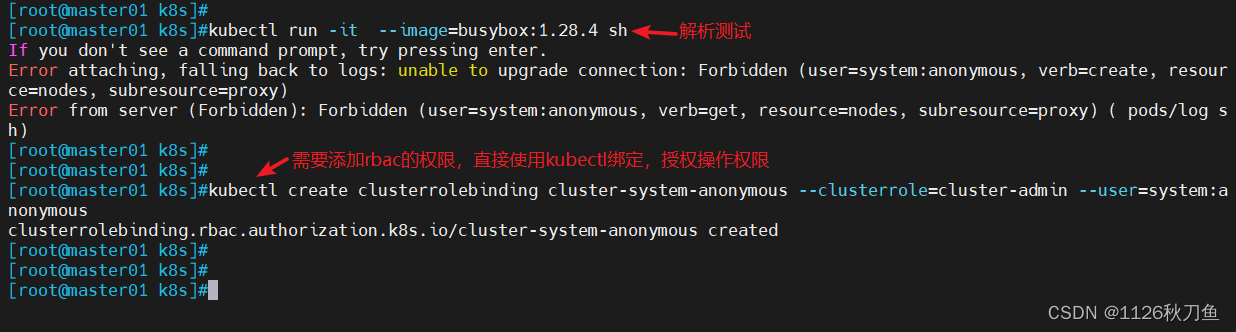

DNS 解析测试

kubectl run -it --image=busybox:1.28.4 sh

#DNS 解析测试

-----------------------------------------------------------------------------------------------------

如果出现以下报错

[root@master01 k8s]#kubectl run -it --image=busybox:1.28.4 sh

If you don't see a command prompt, try pressing enter.

Error attaching, falling back to logs: unable to upgrade connection: Forbidden (user=system:anonymous, verb=create, resource=nodes, subresource=proxy)

Error from server (Forbidden): Forbidden (user=system:anonymous, verb=get, resource=nodes, subresource=proxy) ( pods/log sh)

-----------------------------------------------------------------------------------------------------

kubectl create clusterrolebinding cluster-system-anonymous --clusterrole=cluster-admin --user=system:anonymous

#需要添加 rbac的权限,直接使用kubectl绑定,clusteradmin 管理员集群角色,授权操作权限

1412

1412

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?