建议各个节点下同一个存储池pool下的osd在各个节点中容量和读写性能大致一致,且所有osd节点保持相同osd数量,不一致的采取添加磁盘的方式进行平衡。

对于容量完全不一致的,可以使用raid或zfs的方式先组成性能和容量相当的磁盘。

对不同性能的磁盘如ssd和hdd,可使用crush rule进行分组,分组后有pool类型下的osd仍然不均的可只修改对应pool类型下的crush map type,参考下面解决方案二。

2、解决方案二

调整crushmap的type,从host 调整为osd,crushmap的type为host的时,同一数据的不同副本会默认在不同的host主机之间找数据块进行存储,以防止同一个数据块的不同重复分布在同一故障主机的不同osd中,这样会造成ceph的数据在线服务中断。

但一般情况下主机down的情况比单个osd down的几率要小一些,如不在意数据在线服务的中断,只关心数据存储,可以将crush的type设置为osd,这样数据存储时只考虑将数据重复副本分布在不同的磁盘中即可,尤其是在osd节点数低于3个和osd数及容量、性能不均的情况下使用是很有效的。

osd crush map type修改:

###调整前请先注意暂停数据迁移和恢复动作,尽量在数据平衡和恢复停止后开始操作

#停止数据恢复和心跳

for i in noout nodown nobackfill norecover norebalance noscrub nodeep-scrub;do ceph osd set $i;done

###获取当前ceph的crushmap

ceph osd getcrushmap -o crushmap_compiled_file

###将获取的crushmap转换为普通文本

crushtool -d crushmap_compiled_file -o crushmap_decompiled_file

###编辑普通文本的crushmap file

vim crushmap_decompiled_file

#找到rules下的不同rule,以下是crush map中rules部分:

#################################

# rules

rule replicated_rule { ##默认情况下只有replicated_rule,表示数据不同重复副本的存储规则,默认为host方式,即同一数据块的不同重复分布在不同主机的osd中。

id 0

type replicated

step take default

step chooseleaf firstn 0 type host

step emit

}

rule rule-ssd {

id 1

type replicated

step take default class ssd

step chooseleaf firstn 0 type host ##固态硬盘在各节点分布均匀,且节点数大于3个,所以不用修改

step emit

}

rule rule-hdd {

id 3

type replicated

step take default class hdd

step chooseleaf firstn 0 type osd ###机械硬盘的分布不均,修改为osd类型,

step emit

}

####################################

存储池crush rule可自定义,根据实际需求设置crush type即可

####################################

###退出编辑保存,然后将编译后的文本类型crush map文件转换为可设置map文件:

crushtool -c crushmap_decompiled_file -o newcrushmap

###使用新生成的map文件设置crush rule

ceph osd setcrushmap -i newcrushmap

###打开心跳和数据平衡迁移

for i in noout nodown nobackfill norecover norebalance noscrub nodeep-scrub;do ceph osd unset $i;done

#观察数据平衡状态,集群会自动按照osd平衡的方式重新平衡数据

ceph -s

ceph osd df tree

下面是个人调整后的osd分布情况:

3 解决方案三:

直接添加新的osd分组,将指定pool应用新的规则,创建crush 类型时直接指定按照osd方式存储重复副本

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

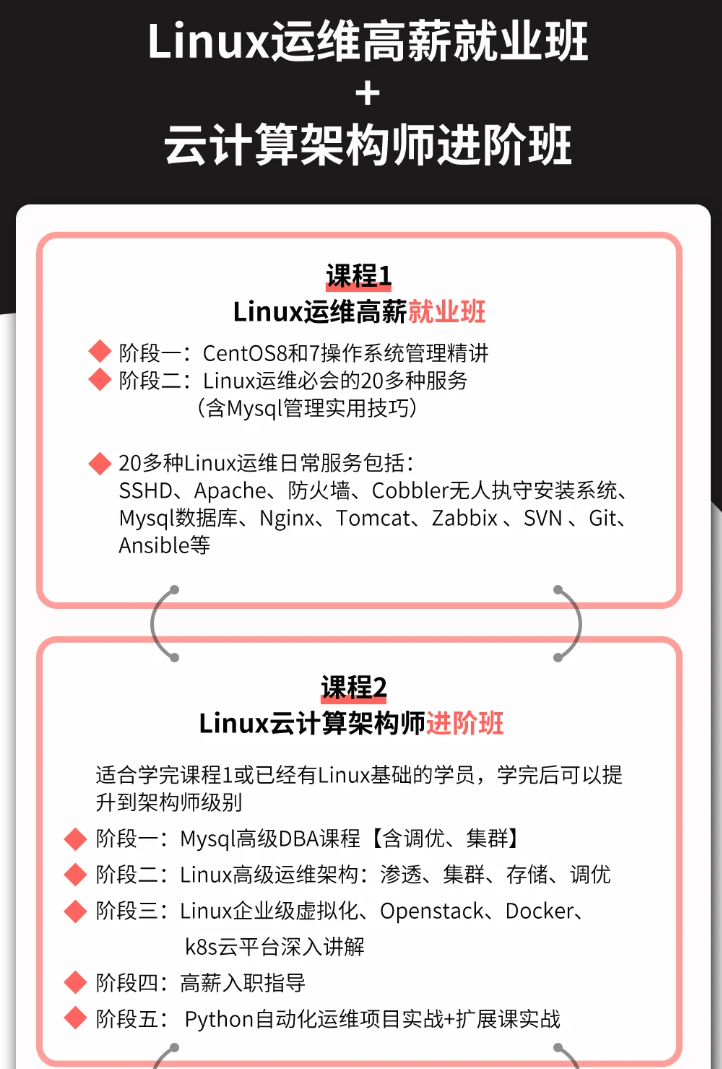

深知大多数Linux运维工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Linux运维全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Linux运维知识点,真正体系化!

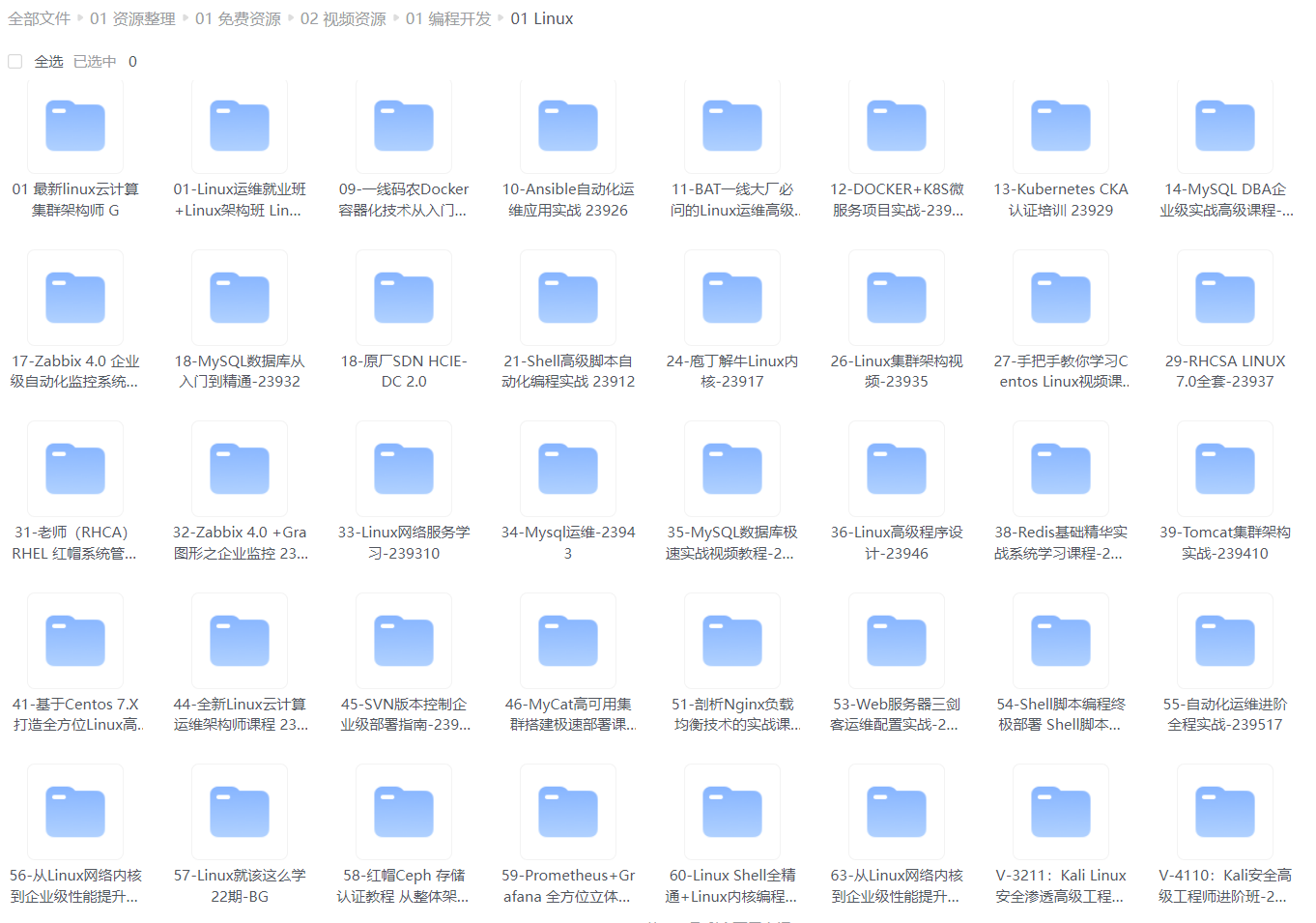

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加VX:vip1024b (备注Linux运维获取)

最后的话

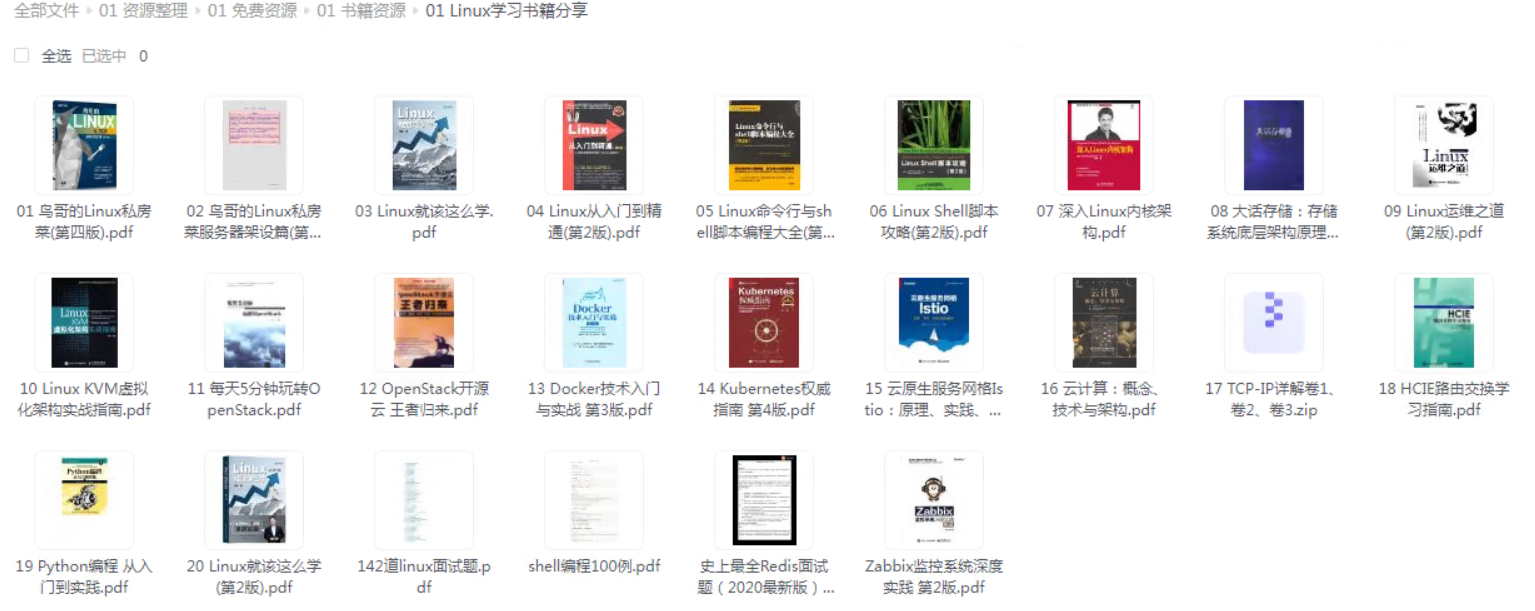

最近很多小伙伴找我要Linux学习资料,于是我翻箱倒柜,整理了一些优质资源,涵盖视频、电子书、PPT等共享给大家!

资料预览

给大家整理的视频资料:

给大家整理的电子书资料:

如果本文对你有帮助,欢迎点赞、收藏、转发给朋友,让我有持续创作的动力!

一个人可以走的很快,但一群人才能走的更远。不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎扫码加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

群人才能走的更远。不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎扫码加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

[外链图片转存中…(img-cO6tvxm3-1712891620495)]

1545

1545

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?