目录

引言

众所周知,CNN与循环神经网络(RNN)或生成对抗网络(GAN)等算法结合,可以更好地处理序列数据和生成更逼真的图像。

今天讲rnn,在人工智能和机器学习的浪潮中,循环神经网络(Recurrent Neural Network,简称RNN)以其独特的序列建模能力,成为了处理时间序列数据的重要工具。

无论是语音识别、自然语言处理,还是时间序列预测等领域,RNN都展现出了强大的应用潜力。

本文将详细解析RNN算法的基本原理、优化方法,探讨其应用场景,并展望其未来发展。

二、RNN的基本原理

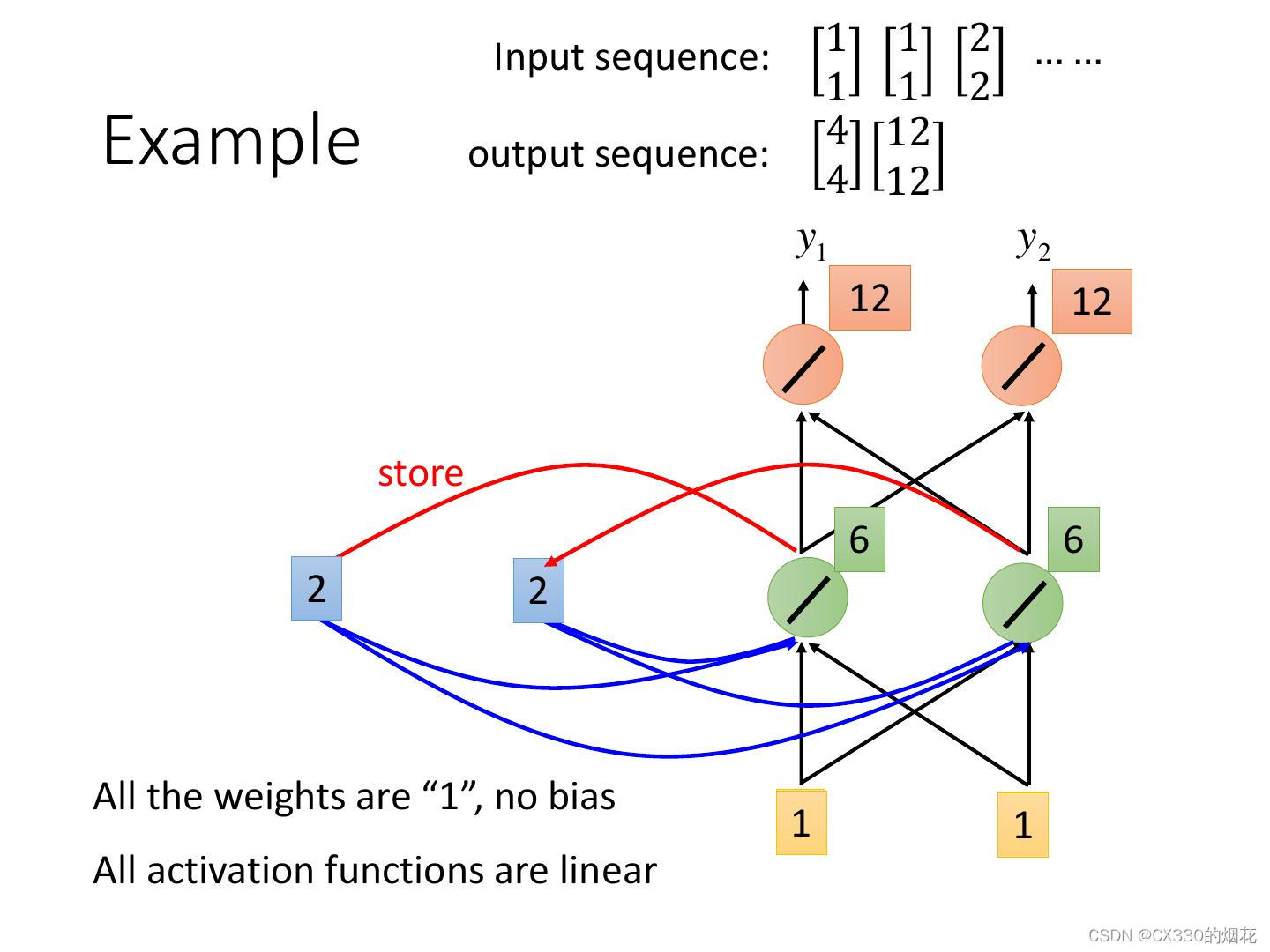

RNN是一种特殊的神经网络,其结构允许信息在内部循环传递。与传统的神经网络不同,RNN在处理序列数据时,能够利用前一个时间步的输出作为下一个时间步的输入,从而捕捉序列中的时间依赖关系。这种循环结构使得RNN能够处理任意长度的序列数据,并有效地提取序列中的特征信息。

RNN的基本结构包括输入层、隐藏层和输出层。在每个时间步,输入层接收当前的输入数据,并将其与隐藏层的状态进行组合,然后传递给输出层。同时,隐藏层的状态也会被更新,并作为下一个时间步的输入。这种循环机制使得RNN能够捕捉序列中的长期依赖关系。

代码事例

这段代码定义了一个简单的RNN模型,其中包含一个RNN层和一个全连接层。在前向传播中,我们首先初始化隐藏状态h0,然后通过RNN层进行前向传播。我们取出最后一个时间步的隐藏状态,通过全连接层得到输出。最后,我们假设了一个批量的输入数据,并通过模型进行前向传播。

请注意,为了运行这段代码,你需要有一个支持PyTorch的环境,并且可能还需要一个支持CUDA的GPU(如果你的代码中有.to(device)的部分并且你想在GPU上运行)。如果你没有GPU,可以简单地移除.to(device)相关的代码,代码将在CPU上运行。

import torch

import torch.nn as nn

# 定义一个简单的RNN模型

class SimpleRNN(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(SimpleRNN, self).__init__()

self.hidden_size = hidden_size

self.rnn = nn.RNN(input_size, hidden_size, batch_first=True)

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, x):

# 初始化隐藏状态

h0 = torch.zeros(1, x.size(0), self.hidden_size).to(x.device) # (num_layers * num_directions, batch, hidden_size)

# RNN的前向传播

out, _ = self.rnn(x, h0) # out: tensor of shape (batch, seq_len, hidden_size)

# 取最后一个时间步的隐藏状态作为输出

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?