一、监督学习概述

1.1 什么是监督学习

监督学习(Supervised Learning)是机器学习中最常见、应用最广泛的学习范式之一。

在这种学习方式中,算法通过从带有标签的训练数据中学习,建立一个输入到输出的映射关系。

所谓"监督",指的是在学习过程中,每个训练样本都提供了明确的"正确答案"(即标签),系统可以通过比较预测输出与实际标签的差异来调整模型参数。

监督学习的核心思想可以概括为:给定一组输入变量(特征)X和对应的输出变量(标签)Y,通过学习一个函数f:X→Y,使得f能够尽可能准确地预测新的、未见过的数据的输出。

这种学习方式与人类的有指导学习过程类似,如同学生在老师的指导下通过大量练习题(带答案)来掌握某种解题方法。

1.2 监督学习的基本要素

一个完整的监督学习系统通常包含以下几个基本要素:

-

输入数据(特征):描述样本特性的变量集合,可以是数值型、类别型或更复杂的数据类型。

-

输出数据(标签):我们希望预测的目标变量,在分类任务中是类别标签,在回归任务中是连续值。

-

训练数据集:由大量(input, output)样本对组成的数据集合,用于模型训练。

-

假设空间:模型可以选择的所有可能的函数的集合。

-

学习算法:从假设空间中选择最优函数的机制。

-

损失函数:衡量预测结果与真实标签差异的函数,指导模型参数调整。

1.3 监督学习的数学表述

从数学角度看,监督学习可以表述为一个函数逼近问题。给定训练数据集D={(x₁,y₁),(x₂,y₂),...,(xₙ,yₙ)},其中xᵢ∈X是输入特征,yᵢ∈Y是对应的输出标签,我们的目标是找到一个函数h:X→Y(称为假设),使得h(x)能够很好地预测y。

通常,我们会定义一个损失函数L(y, h(x))来衡量预测值与真实值的差异,然后通过最小化经验风险(即训练集上的平均损失)来寻找最优假设:

h* = argminₕ (1/n)ΣL(yᵢ, h(xᵢ))

二、监督学习的类型

监督学习主要分为两大类:分类问题和回归问题

两者的主要区别在于输出变量的类型。

2.1 Classification

当输出变量是离散的类别标签时,我们称之为分类问题。

分类问题的目标是建立一个模型,能够将输入数据划分到预定义的类别中。

根据类别数量的不同,分类问题又可以分为:

-

二分类问题:只有两个可能的输出类别。例如:

-

垃圾邮件检测(垃圾邮件/非垃圾邮件)

-

疾病诊断(患病/健康)

-

信用风险评估(违约/不违约)

-

-

多分类问题:输出类别多于两个。例如:

-

手写数字识别(0-9共10个类别)

-

图像分类(猫、狗、鸟等)

-

新闻主题分类(体育、政治、科技等)

-

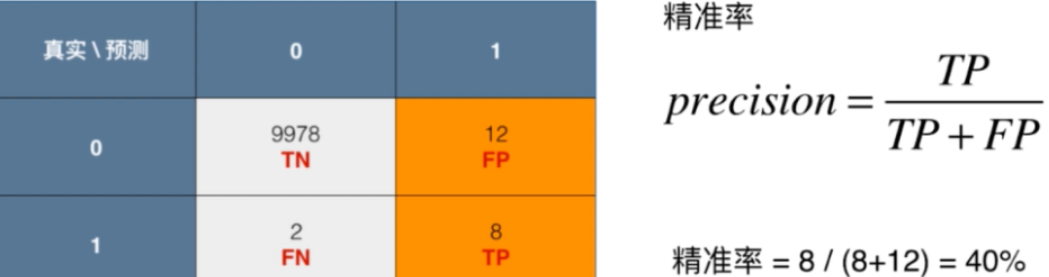

分类问题中常用的评价指标包括准确率、精确率、召回率、F1分数、ROC曲线和AUC等。

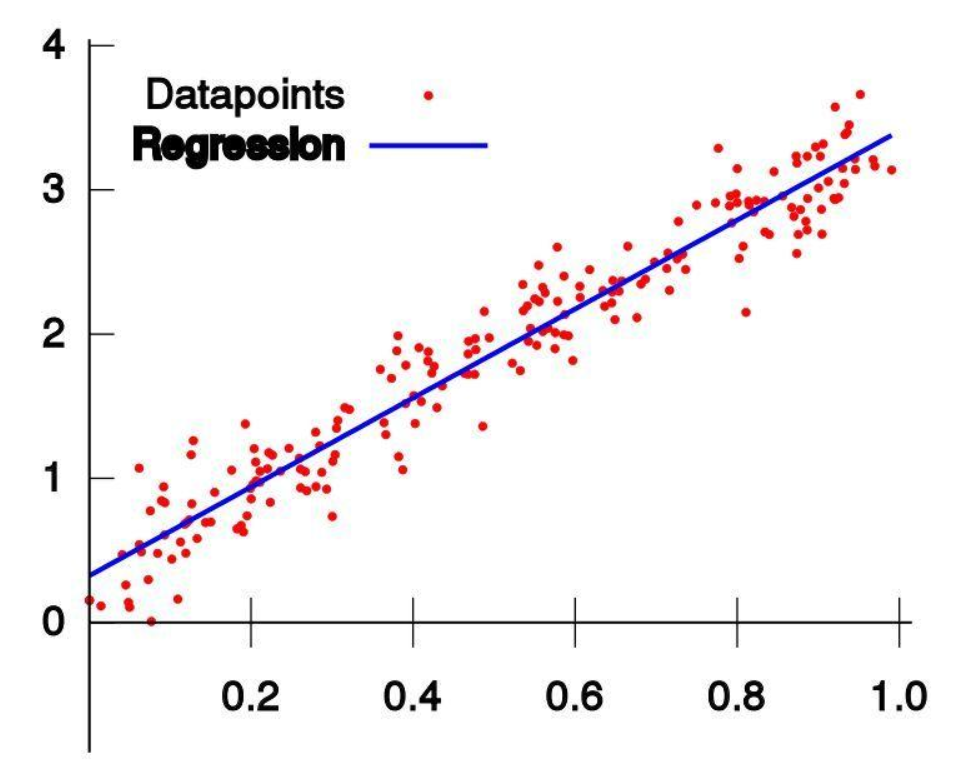

2.2 Regression

当输出变量是连续的数值时,我们称之为回归问题。

回归问题的目标是建立一个模型,能够预测连续的输出值。例如:

-

房价预测(预测房屋售价)

-

股票价格预测

-

销售额预测

-

温度预测

回归问题中常用的评价指标包括均方误差(MSE)、均方根误差(RMSE)、平均绝对误差(MAE)和决定系数(R²)等。

2.3 分类与回归的比较

| 特征 | 分类 | 回归 |

|---|---|---|

| 输出类型 | 离散类别 | 连续数值 |

| 目标 | 预测类别标签 | 预测数值量 |

| 评价指标 | 准确率、精确率、召回率等 | MSE、RMSE、R²等 |

| 算法示例 | 逻辑回归、决策树、SVM等 | 线性回归、多项式回归等 |

| 输出解释 | 类别概率或直接类别判断 | 具体的数值预测 |

三、监督学习的主要算法

监督学习领域发展出了众多算法,每种算法都有其特点和适用场景。

下面介绍几种最基础和广泛使用的监督学习算法。

3.1 Linear Regression

线性回归是最简单、最直观的回归算法,它假设输入特征与输出之间存在线性关系。模型形式为:

y = w₀ + w₁x₁ + w₂x₂ + ... + wₚxₚ + ε

其中w是模型参数,ε是误差项。线性回归通过最小化残差平方和(即最小二乘法)来估计参数:

min Σ(yᵢ - ŷᵢ)²

线性回归虽然简单,但在许多实际问题中表现良好,且模型具有很好的可解释性。其扩展形式包括多项式回归、岭回归(Ridge Regression)和Lasso回归等。

3.2 Logistic Regression

尽管名称中有"回归",逻辑回归实际上是一种分类算法,特别适用于二分类问题。

它通过逻辑函数(sigmoid函数)将线性组合的输出映射到(0,1)区间,表示属于正类的概率:

P(y=1|x) = 1/(1 + exp(-(wᵀx + b)))

逻辑回归通过最大似然估计来求解参数,可以使用梯度下降等优化算法进行求解。逻辑回归的优点是计算效率高、可解释性强,可以通过系数了解各特征对结果的影响程度。

3.3 Decision Tree

决策树是一种基于树结构的分类和回归方法,它通过一系列的判断规则对数据进行递归划分。

决策树学习包括三个主要步骤:特征选择、树的生成和树的剪枝。

在分类问题中,常用的决策树算法有ID3、C4.5和CART;在回归问题中,主要使用CART算法。决策树的优点包括:

-

模型直观,易于理解和解释

-

不需要过多的数据预处理

-

能够处理数值型和类别型特征

-

可以捕捉特征间的交互作用

然而,单独的决策树容易过拟合,且对数据的小变化敏感,这引出了随机森林等集成方法的发展。

3.4 Support Vector Machine

SVM是一种强大的监督学习算法,可用于分类和回归问题。

在分类问题中,SVM的基本思想是找到一个最优分离超平面,使得两个类别之间的边界最大化。

对于线性可分情况,SVM寻找满足以下条件的超平面wᵀx + b = 0:

min ||w||²/2

s.t. yᵢ(wᵀxᵢ + b) ≥ 1, ∀i

对于非线性可分情况,SVM通过核技巧(Kernel Trick)将数据映射到高维空间,使其在高维空间中线性可分。常用的核函数包括多项式核、高斯核(RBF)和sigmoid核等。

SVM的优点包括在高维空间中表现良好、对异常值相对鲁棒、可以处理非线性问题等。

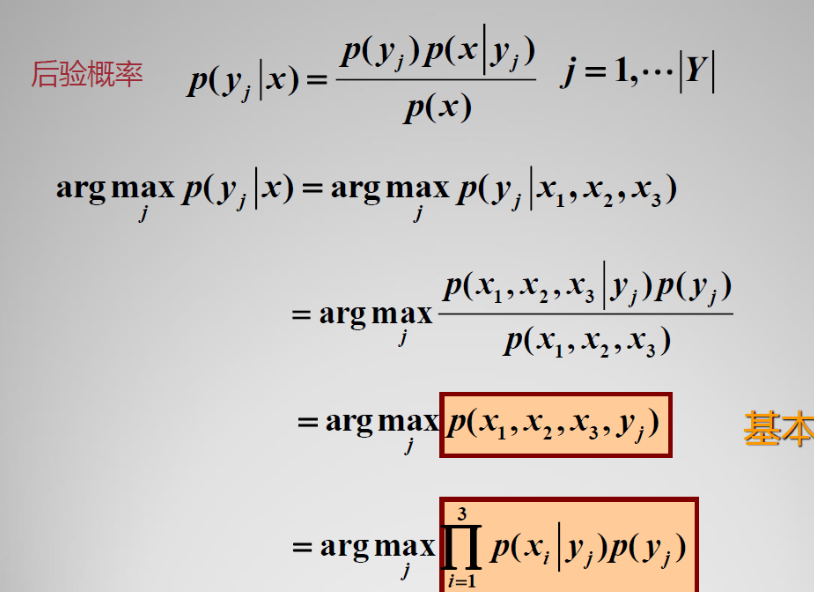

3.5 Naive Bayes

朴素贝叶斯是基于贝叶斯定理和特征条件独立假设的分类方法。

尽管"朴素"的独立性假设在现实中很少成立,但该算法在许多实际应用中表现 surprisingly well,特别是在文本分类领域。

朴素贝叶斯的基本公式为:

P(y|x₁,...,xₙ) ∝ P(y)ΠP(xᵢ|y)

根据特征分布的不同假设,朴素贝叶斯有多种变体:

-

高斯朴素贝叶斯:假设连续特征服从正态分布

-

多项式朴素贝叶斯:适用于离散计数数据

-

伯努利朴素贝叶斯:适用于二值特征

朴素贝叶斯的优点是训练和预测速度快、对小规模数据表现良好、对无关特征相对鲁棒。

3.6 k-Nearest Neighbors,

k-NN是一种基于实例的学习算法,它不显式地学习模型,而是在预测时根据输入样本的k个最近邻的训练样本进行决策。

对于分类问题,采用投票机制;对于回归问题,采用平均值。

k-NN的关键参数是k值的选择和距离度量方式(如欧氏距离、曼哈顿距离等)。

k-NN的优点是实现简单、无需训练过程(惰性学习)、对数据分布没有假设;缺点是计算复杂度高(特别是对于大规模数据)、对不平衡数据敏感、需要精心选择距离度量和k值。

四、监督学习的评估方法

为了衡量监督学习模型的性能,并避免过拟合或欠拟合问题,我们需要采用适当的评估方法。

以下是几种常用的评估方法和技术。

4.1 训练集与测试集划分

最简单的评估方法是将数据集随机划分为训练集和测试集,通常比例为70%-30%或80%-20%。

模型在训练集上学习,然后在未见过的测试集上评估性能。

这种方法实现简单,但当数据量较小时,评估结果可能不够稳定。

4.2 交叉验证(Cross-Validation)

交叉验证是一种更稳健的评估方法,特别是对于小规模数据集。最常用的是k折交叉验证:

-

将数据集随机划分为k个大小相似的子集(称为"折")

-

每次使用k-1折作为训练集,剩余的1折作为验证集

-

重复k次,每次使用不同的验证集

-

最终性能取k次结果的平均

常见的k值选择为5或10。交叉验证提供了更可靠的性能估计,但计算成本更高。

4.3 分类问题的评估指标

对于分类问题,常用的评估指标包括:

-

准确率(Accuracy):正确预测的样本比例

Accuracy = (TP + TN)/(TP + TN + FP + FN) -

精确率(Precision):预测为正类的样本中实际为正类的比例

Precision = TP/(TP + FP) -

召回率(Recall,又称灵敏度):实际为正类的样本中被正确预测的比例

Recall = TP/(TP + FN) -

F1分数:精确率和召回率的调和平均

F1 = 2(PrecisionRecall)/(Precision + Recall) -

ROC曲线与AUC:通过改变分类阈值,绘制真正例率(TPR)对假正例率(FPR)的曲线,曲线下面积(AUC)越大表示性能越好

4.4 回归问题的评估指标

对于回归问题,常用的评估指标包括:

-

均方误差(MSE):

MSE = (1/n)Σ(yᵢ - ŷᵢ)² -

均方根误差(RMSE):

RMSE = √MSE -

平均绝对误差(MAE):

MAE = (1/n)Σ|yᵢ - ŷᵢ| -

决定系数(R²):表示模型解释的目标变量方差的比例

R² = 1 - Σ(yᵢ - ŷᵢ)²/Σ(yᵢ - ȳ)²

4.5 偏差-方差权衡

监督学习模型的泛化误差可以分解为三个部分:

-

偏差(Bias):模型预测值与真实值的系统性差异,高偏差导致欠拟合

-

方差(Variance):模型对训练数据微小变化的敏感性,高方差导致过拟合

-

不可约误差(Irreducible Error):数据本身的噪声

理想的模型需要在偏差和方差之间取得平衡,这可以通过调整模型复杂度、正则化、集成方法等技术实现。

五、监督学习的实践流程

在实际应用中,一个完整的监督学习项目通常包含以下几个关键步骤:

5.1 问题定义与数据收集

明确要解决的业务问题,确定输入特征和输出目标,收集相关数据。这一阶段需要考虑:

-

问题的可解性:是否有足够的信息来预测目标变量

-

数据的可获得性:能否获取足够数量和质量的训练数据

-

评估标准:如何衡量模型的业务价值

5.2 数据探索与预处理

对收集到的数据进行探索性分析(EDA)和预处理,包括:

-

处理缺失值:删除、插补或标记缺失

-

处理异常值:检测并决定保留、修正或删除

-

特征编码:将类别型特征转换为数值表示(如独热编码)

-

特征缩放:标准化或归一化数值特征

-

特征工程:创建新的有意义的特征

-

数据可视化:发现模式、关系和异常

5.3 模型选择与训练

根据问题类型和数据特点选择合适的算法:

-

对于小型结构化数据:逻辑回归、决策树、SVM等

-

对于大型结构化数据:随机森林、梯度提升树等

-

对于图像、文本等非结构化数据:深度学习模型

训练过程中可能需要调整学习率、正则化参数等超参数。

5.4 模型评估与调优

使用前述的评估方法评估模型性能,并通过以下方式调优:

-

网格搜索或随机搜索进行超参数优化

-

使用交叉验证选择最佳参数组合

-

尝试不同的特征组合或工程方法

-

考虑集成方法提升性能

六、监督学习的挑战与解决方案

尽管监督学习在实践中取得了巨大成功,但仍面临诸多挑战,下面介绍几个主要挑战及其应对策略。

6.1 过拟合与欠拟合

过拟合指模型在训练集上表现很好,但在测试集上表现差,即模型过于复杂,捕捉了训练数据中的噪声和偶然模式。解决方案包括:

-

增加训练数据量

-

使用正则化(L1/L2正则化)

-

减少模型复杂度

-

使用早停(Early Stopping)

-

采用dropout(对于神经网络)

欠拟合指模型在训练集和测试集上都表现不佳,即模型过于简单,无法捕捉数据中的基本模式。

解决方案包括:

-

增加模型复杂度

-

添加更多相关特征

-

减少正则化强度

-

延长训练时间

6.2 数据不平衡

在许多分类问题中(如欺诈检测、罕见疾病诊断),不同类别的样本数量差异很大,这会导致模型偏向多数类。解决方法包括:

-

重采样技术:

-

过采样少数类(如SMOTE算法)

-

欠采样多数类

-

-

算法层面调整:

-

使用类别权重

-

选择对不平衡数据鲁棒的算法(如决策树)

-

-

评估指标选择:

-

关注精确率-召回率而非准确率

-

使用F1分数、AUC等指标

-

6.3 维度灾难

当特征维度很高而样本数量相对不足时,模型性能会下降,这种现象称为维度灾难。解决方法包括:

-

特征选择:

-

过滤法:基于统计检验、互信息等选择特征

-

包装法:通过模型性能评估特征子集

-

嵌入法:通过正则化自动选择特征(如Lasso)

-

-

特征提取:

-

主成分分析(PCA)

-

线性判别分析(LDA)

-

t-SNE等非线性降维方法

-

6.4 标记数据获取困难

监督学习需要大量标记数据,但数据标记通常成本高昂。解决方案包括:

-

半监督学习:同时利用标记和未标记数据

-

主动学习:智能选择最有价值的样本进行标记

-

迁移学习:利用预训练模型进行微调

-

数据增强:通过变换生成更多训练样本

-

合成数据:使用生成模型创建人工数据

七、监督学习的应用领域

监督学习技术已成功应用于众多领域,下面列举几个典型的应用场景。

7.1 计算机视觉

-

图像分类:识别图像中的主要对象

-

目标检测:定位并识别图像中的多个对象

-

人脸识别:识别或验证个人身份

-

医学影像分析:辅助疾病诊断

7.2 自然语言处理

-

文本分类:新闻分类、情感分析

-

命名实体识别:从文本中提取人名、地名等

-

机器翻译:将文本从一种语言翻译到另一种语言

-

问答系统:回答用户提出的问题

7.3 金融领域

-

信用评分:评估贷款申请人的信用风险

-

欺诈检测:识别异常交易模式

-

算法交易:预测股票价格走势

-

风险管理:评估投资组合风险

7.4 医疗健康

-

疾病诊断:基于症状和检查结果预测疾病

-

药物发现:预测分子化合物的活性

-

个性化治疗:根据患者特征推荐最佳治疗方案

-

医疗影像分析:自动解读X光、MRI等影像

7.5 推荐系统

-

电子商务:基于用户历史行为推荐商品

-

内容平台:推荐新闻、视频或音乐

-

社交媒体:推荐可能认识的人或感兴趣的内容

-

广告投放:精准定位潜在客户

八、监督学习的未来发展趋势

随着技术的不断进步,监督学习领域也在持续发展,以下几个方向值得关注:

8.1 自动化机器学习(AutoML)

AutoML旨在自动化机器学习流程中的各个步骤,包括特征工程、模型选择和超参数调优,降低机器学习的应用门槛。主要技术包括:

-

神经架构搜索(NAS)

-

元学习(Learning to Learn)

-

高效的超参数优化算法

8.2 可解释性与可信AI

随着AI系统在关键领域的应用增加,对模型可解释性和可信度的需求日益增长。研究方向包括:

-

开发可解释的模型(如决策树、线性模型)

-

模型事后解释技术(LIME、SHAP)

-

公平性检测与消除算法偏见

-

模型不确定性量化

8.3 大规模分布式学习

应对大数据挑战,分布式学习技术不断发展:

-

高效的参数服务器架构

-

联邦学习(保护数据隐私)

-

边缘计算与设备端学习

8.4 多模态学习

结合多种数据模态(文本、图像、音频等)进行学习:

-

跨模态表示学习

-

多任务学习

-

模态间的知识迁移

8.5 神经符号整合

结合神经网络的数据驱动学习与符号系统的逻辑推理:

-

神经符号系统

-

可微分逻辑编程

-

结合深度学习和知识图谱

结语

监督学习作为机器学习中最成熟、应用最广泛的分支,为解决现实世界中的各种预测和决策问题提供了强大工具。

从简单的线性回归到复杂的深度神经网络,监督学习算法家族不断丰富和发展。

然而,成功的监督学习应用不仅依赖于算法选择,更需要深入理解问题领域、精心准备数据、合理设计实验和持续监控维护。

随着计算能力的提升、数据的积累和算法的进步,监督学习必将在更多领域发挥更大作用,同时也面临着可解释性、数据效率、适应性和安全性等方面的挑战。

未来的发展将更加注重将监督学习与其他学习范式(如无监督学习、强化学习)相结合,构建更加智能、鲁棒和可信的人工智能系统。

对于从业者而言,掌握监督学习的基本原理和方法论是进入机器学习领域的坚实基础,而持续学习和实践则是应对这一领域快速发展的关键。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?