image = tf.cast(image, tf.float32)

image = tf.math.round(image/255.)

return image, tf.cast(image, tf.int32)

该函数需要两个输入——图像和标签。该函数的前两行将图像转换为二进制float32格式,即0.0或1.0。并且,我们将二进制图像转换为整数并返回,以遵循使用整数作为标签的惯例而已。返回的数据,将作为网络训练的输入和标签,都是28 x 28 x 1的二进制MNIST图像,它们仅在数据类型上有所不同。

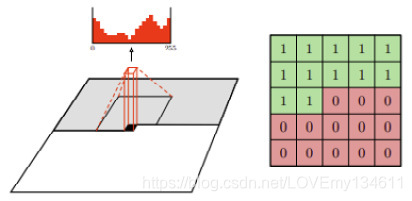

掩膜

与PixelRNN逐行读取不同,PixelCNN在图像中从左到右,从上到下滑动卷积核。当执行卷积以预测当前像素时,传统的卷积核能够看到当前输入像素及其周围的像素,其中包括当前像素之后的像素信息,这与在简介部分的条件概率假设相悖。

为了避免这种情况,我们需要确保CNN在预测输出像素 x i x_i xi时不会看到输入像素 x i x_i xi。

这是通过使用掩膜卷积来实现的,其中在执行卷积之前将掩膜应用于卷积核权重。下图显示了一个7 x 7卷积核的掩膜,其中从中心开始的权重为0。这会阻止CNN看到它正在预测的像素(卷积核的中心)以及所有之后的像素。这称为A型掩膜,仅应用于输入层。

由于中心像素在第一层中被遮挡,因此我们不再需要在后面的层中隐藏中心要素。实际上,我们需要将卷积核中心设置为1,以使其能够读取先前层的特征,这称为B型掩膜。

实现自定义层

现在,我们将为掩膜卷积创建一个自定义层。我们可以使用从基类tf.keras.layers.Layer继承的子类在TensorFlow2.x中创建自定义层,以便将能够像使用其他Keras层一样使用它。以下是自定义层类的基本结构:

class MaskedConv2D(tf.keras.layers.Layer):

def init(self):

…

def build(self, input_shape):

…

def call(self, inputs):

…

return output

build()将输入张量的形状作为参数,我们将使用此信息来确保创建正确形状的变量。构建图层时,此函数仅运行一次。我们可以通过声明不可训练的变量或常量来创建掩码,以使TensorFlow知道它不需要梯度来反向传播:

def build(self, input_shape):

self.w = self.add_weight(shape=[self.kernel,

self.kernel,

input_shape[-1],

self.filters],

initializer=‘glorot_normal’,

trainable=True)

self.b = self.add_weight(shape=(self.filters,),

initializer=‘zeros’,

trainable=True)

mask = np.ones(self.kernel**2, dtype=np.float32)

center = len(mask)//2

mask[center+1:] = 0

if self.mask_type == ‘A’:

mask[center] = 0

mask = mask.reshape((self.kernel, self.kernel, 1, 1))

self.mask = tf.constant(mask, dtype=‘float32’)

call()用来执行前向传递。在掩膜卷积层中,在使用低级tf.nn API执行卷积之前,我们将权重乘以掩码后将下半部分的值设为零:

def call(self, inputs):

masked_w = tf.math.multiply(self.w, self.mask)

output=tf.nn.conv2d(inputs, masked_w, 1, “SAME”) + self.b

return output

网络架构

PixelCNN架构非常简单。在使用A型掩膜的第一个7 x 7 conv2d图层之后,有几层带有B型掩膜的残差块:

Model: “PixelCnn”

Layer (type) Output Shape Param #

=================================================================

input_2 (InputLayer) [(None, 28, 28, 1)] 0

masked_conv2d_22 (MaskedConv (None, 28, 28, 128) 6400

residual_block_7 (ResidualBl (None, 28, 28, 128) 53504

residual_block_8 (ResidualBl (None, 28, 28, 128) 53504

residual_block_9 (ResidualBl (None, 28, 28, 128) 53504

residual_block_10 (ResidualB (None, 28, 28, 128) 53504

residual_block_11 (ResidualB (None, 28, 28, 128) 53504

residual_block_12 (ResidualB (None, 28, 28, 128) 53504

residual_block_13 (ResidualB (None, 28, 28, 128) 53504

conv2d_2 (Conv2D) (None, 28, 28, 64) 8256

conv2d_3 (Conv2D) (None, 28, 28, 1) 65

=================================================================

Total params: 389,249

Trainable params: 389,249

Non-trainable params: 0

下图说明了PixelCNN中使用的残差块架构:

交叉熵损失

交叉熵损失也称为对数损失,它衡量模型的性能,其中输出的概率在0到1之间。以下是二进制交叉熵损失的方程,其中只有两个类,标签y可以是0或1, p ( x ) p(x) p(x)是模型的预测:

B C E = − 1 N ∑ i = 1 N ( y i l o g p ( x ) + ( 1 − y i ) l o g ( 1 − p ( x ) ) ) BCE = -\frac1N\sum_{i=1}^N(y_ilogp(x)+(1-y_i)log(1-p(x))) BCE=−N1i=1∑N(yilogp(x)+(1−yi)log(1−p(x)))

在PixelCNN中,单个图像像素用作标签。在二值化MNIST中,我们要预测输出像素是0还是1,这使其成为使用交叉熵作为损失函数的分类问题。

最后,编译和训练神经网络,我们对损失和度量均使用二进制交叉熵,并使用RMSprop作为优化器。有许多不同的优化器可供使用,它们的主要区别在于它们根据过去的统计信息调整学习率的方式。没有一种最佳的优化器可以在所有情况下使用,因此建议尝试使用不同的优化器。

编译和训练pixelcnn模型:

pixelcnn = SimplePixelCnn()

pixelcnn.compile(

loss = tf.keras.losses.BinaryCrossentropy(),

optimizer=tf.keras.optimizers.RMSprop(learning_rate=0.001),

metrics=[ tf.keras.metrics.BinaryCrossentropy()])

pixelcnn.fit(ds_train, epochs = 10, validation_data=ds_test)

接下来,我们将根据先前的模型生成一个新图像。

采样生成图片

训练后,我们可以通过以下步骤使用该模型生成新图像:

-

创建一个具有与输入图像相同形状的空张量,并用

1填充。将其馈入网络并获得 p ( x 1 ) p(x1) p(x1),即第一个像素的概率。 -

从 p ( x 1 ) p(x_1) p(x1)进行采样,并将采样值分配给输入张量中的像素 x 1 x_1 x1。

-

再次将输入提供给网络,并对下一个像素执行步骤2。

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数Python工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Python开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Python开发知识点,真正体系化!

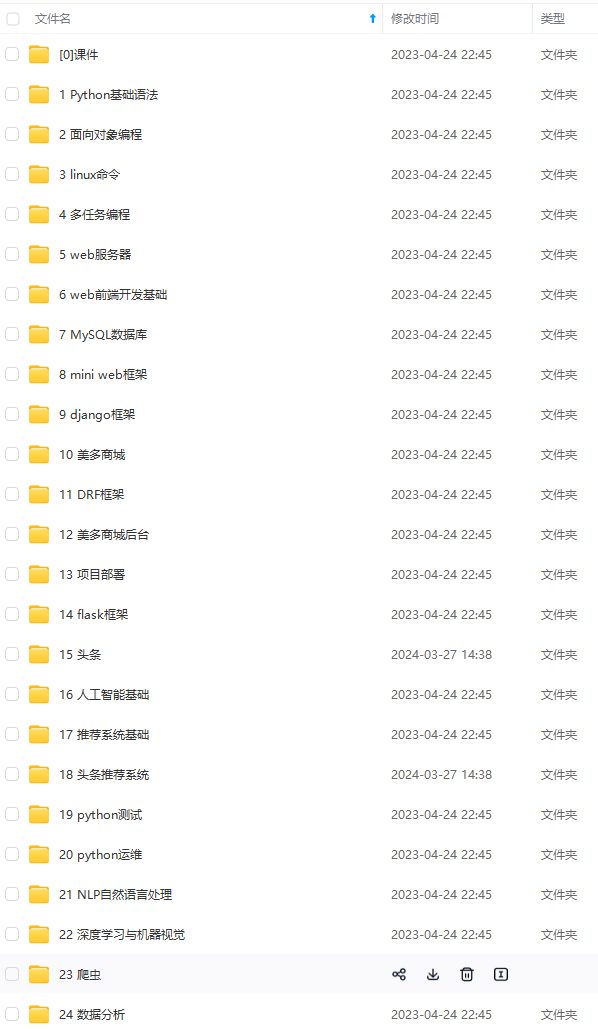

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加V获取:vip1024c (备注Python)

(1)Python所有方向的学习路线(新版)

这是我花了几天的时间去把Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

最近我才对这些路线做了一下新的更新,知识体系更全面了。

(2)Python学习视频

包含了Python入门、爬虫、数据分析和web开发的学习视频,总共100多个,虽然没有那么全面,但是对于入门来说是没问题的,学完这些之后,你可以按照我上面的学习路线去网上找其他的知识资源进行进阶。

(3)100多个练手项目

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了,只是里面的项目比较多,水平也是参差不齐,大家可以挑自己能做的项目去练练。

一个人可以走的很快,但一群人才能走的更远。不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎扫码加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了,只是里面的项目比较多,水平也是参差不齐,大家可以挑自己能做的项目去练练。

一个人可以走的很快,但一群人才能走的更远。不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎扫码加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

[外链图片转存中…(img-pyXIOYIX-1712531120022)]

905

905

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?