4)任意复制一个商品信息, 空白处右击再点击"查看网页源代码", 在源码查找该商品, 即可看到该商品的信息.

5)对比网页源代码和"Response"响应内容, 发现源代码中的商品信息被替换, 这便是采用了JS加密

6)如果去请求上面的URL, 得到的则是加密过的信息, 这时就可以利用Selenium库来模拟浏览器, 进而得到商品信息.

- 请求网站

-- coding: utf-8 --

from selenium import webdriver #从selenium导入浏览器驱动

browser = webdriver.Chrome() #声明驱动对象, 即Chrome浏览器

def get_one_page():

‘’‘获取单个页面’‘’

browser.get(“https://www.xxxxx.com”) #请求网站

- 输入"男装", 在输入之前, 需要判断输入框是否存在, 如果存在则输入"男装", 不存在则等待显示成功.

-- coding: utf-8 --

from selenium import webdriver

from selenium.webdriver.common.by import By #导入元素定位方法模块

from selenium.webdriver.support.ui import WebDriverWait #导入等待判断模块

from selenium.webdriver.support import expected_conditions as EC #导入判断条件模块

browser = webdriver.Chrome()

def get_one_page():

‘’‘获取单个页面’‘’

browser.get(“https://www.xxxxx.com”)

input = WebDriverWait(browser,10).until( #等待判断

EC.presence_of_element_located((By.CSS_SELECTOR,“#q”))) #若输入框显示成功,则获取,否则等待

input.send_keys(“男装”) #输入商品名称

- 下一步就是点击"搜索"按钮, 按钮具有属性: 可点击, 那么加入判断条件.

-- coding: utf-8 --

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

browser = webdriver.Chrome()

def get_one_page():

‘’‘获取单个页面’‘’

browser.get(“https://www.xxxxx.com”)

input = WebDriverWait(browser,10).until(

EC.presence_of_element_located((By.CSS_SELECTOR,“#q”))) #

input.send_keys(“男装”)

button = WebDriverWait(browser,10).until( #等待判断

EC.element_to_be_clickable((By.CSS_SELECTOR,“#J_TSearchForm > div.search-button > button”))) #若按钮可点击, 则获取, 否则等待

button.click() #点击按钮

- 获取总的页数, 同样加入等待判断.

-- coding: utf-8 --

import re

from selenium import webdriver

from selenium.common.exceptions import TimeoutException

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

browser = webdriver.Chrome()

def get_one_page():

‘’‘获取单个页面’‘’

browser.get(“https://www.xxxxx.com”)

input = WebDriverWait(browser, 10).until(

EC.presence_of_element_located((By.CSS_SELECTOR, “#q”)))

input.send_keys(“男装”)

button = WebDriverWait(browser, 10).until(

EC.element_to_be_clickable(

(By.CSS_SELECTOR, “#J_TSearchForm > div.search-button > button”)))

button.click()

pages = WebDriverWait(browser, 10).until( # 等待判断

EC.presence_of_element_located(

(By.CSS_SELECTOR, “#mainsrp-pager > div > div > div > div.total”))) # 若总页数加载成功,则获取总页数,否则等待

return pages.text

def main():

pages = get_one_page()

print(pages)

if name == ‘main’:

main()

- 打印出来的不是我们想要的结果, 利用正则表达式获取, 最后再利用try…except捕捉异常

-- coding: utf-8 --

import re

from selenium import webdriver

from selenium.common.exceptions import TimeoutException

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

browser = webdriver.Chrome()

def get_one_page():

‘’‘获取单个页面’‘’

try:

browser.get(“https://www.xxxxx.com”)

input = WebDriverWait(browser,10).until(

EC.presence_of_element_located((By.CSS_SELECTOR,“#q”)))

input.send_keys(“男装”)

button = WebDriverWait(browser,10).until(

EC.element_to_be_clickable((By.CSS_SELECTOR,“#J_TSearchForm > div.search-button > button”)))

button.click()

pages = WebDriverWait(browser,10).until(

EC.presence_of_element_located((By.CSS_SELECTOR,“#mainsrp-pager > div > div > div > div.total”)))

return pages.text

except TimeoutException:

return get_one_page() #如果超时,继续获取

def main():

pages = get_one_page()

pages = int(re.compile(“(\d+)”).findall(pages)[0]) #采用正则表达式提取文本中的总页数

print(pages)

if name == ‘main’:

main()

采用获取"到第 页"输入框方式, 切换到下一页, 同样是等待判断

需要注意的是, 最后要加入判断: 高亮是否是当前页

def get_next_page(page):

try:

input = WebDriverWait(browser, 10).until(

EC.presence_of_element_located((By.CSS_SELECTOR, “#mainsrp-pager > div > div > div > div.form > input”))) # 若输入框加载成功,则获取,否则等待

input.send_keys(page) # 输入页码

button = WebDriverWait(browser, 10).until(

EC.element_to_be_clickable((By.CSS_SELECTOR, “#mainsrp-pager > div > div > div > div.form > span.btn.J_Submit”))) # 若按钮可点击,则获取,否则等待

button.click() # 点击按钮

WebDriverWait(browser,10).until(

EC.text_to_be_present_in_element((By.CSS_SELECTOR,“#mainsrp-pager > div > div > div > ul > li.item.active > span”),str(page))) # 判断高亮是否是当前页

except TimeoutException: # 超时, 继续请求

return get_next_page(page)

def main():

pages = get_one_page()

pages = int(re.compile(“(\d+)”).findall(pages)[0])

for page in range(1,pages+1):

get_next_page(page)

if name == ‘main’:

main()

首先, 判断信息是否加载成功, 紧接着获取源码并初始化, 进而解析.

需要注意的是, 在"get_one_page"和"get_next_page"中调用之后, 才可执行

def get_info():

“”“获取详情”“”

WebDriverWait(browser,20).until(EC.presence_of_element_located((

By.CSS_SELECTOR,“#mainsrp-itemlist .items .item”))) #判断商品信息是否加载成功

text = browser.page_source #获取网页源码

html = pq(text) #初始化网页源码

items = html(‘#mainsrp-itemlist .items .item’).items() #采用items方法会得到生成器

for item in items: #遍历每个节点对象

data = []

image = item.find(“.pic .img”).attr(“data-src”) #用find方法查找子孙节点,用attr方法获取属性名称

price = item.find(“.price”).text().strip().replace(“\n”,“”) #用text方法获取文本,strip()去掉前后字符串,默认是空格

deal = item.find(“.deal-cnt”).text()[:-2]

title = item.find(“.title”).text().strip()

shop = item.find(“.shop”).text().strip()

location = item.find(“.location”).text()

data.append([shop, location, title, price, deal, image])

print(data)

def save_to_mysql(data):

“”“存储到数据库”“”

创建数据库连接对象

db= pymysql.connect(host = “localhost”,user = “root”,password = “password”,port = 3306, db = “spiders”,charset = “utf8”)

获取游标

cursor = db.cursor()

#创建数据库

cursor.execute(“CREATE TABLE IF NOT EXISTS {0}(shop VARCHAR(20),location VARCHAR(10),title VARCHAR(255),price VARCHAR(20),deal VARCHAR(20), image VARCHAR(255))”.format(“男装”))

#SQL语句

sql = “INSERT INTO {0} values(%s,%s,%s,%s,%s,%s)”.format(“男装”)

try:

#传入参数sql,data

if cursor.execute(sql,data):

#插入数据库

db.commit()

print(“已入库**”)

except:

print(“#########入库失败#########”)

#回滚,相当什么都没做

db.rollback()

#关闭数据库

db.close()

-- coding: utf-8 --

import re

import pymysql

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数Python工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Python开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

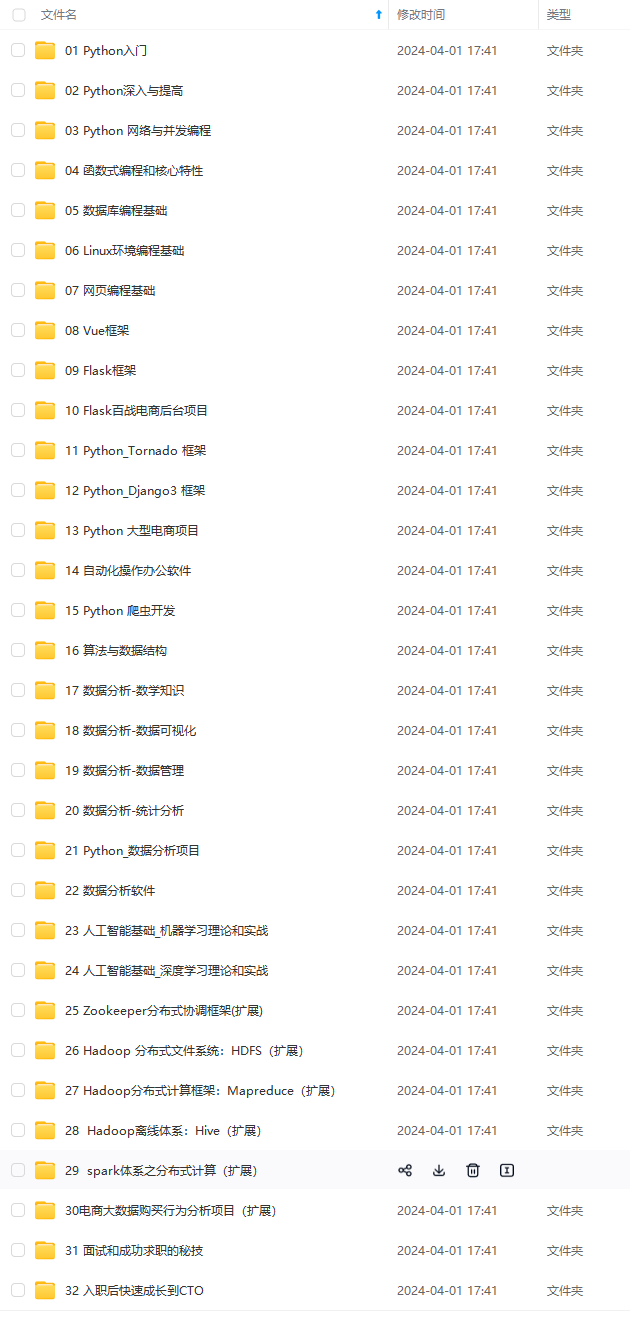

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上前端开发知识点,真正体系化!

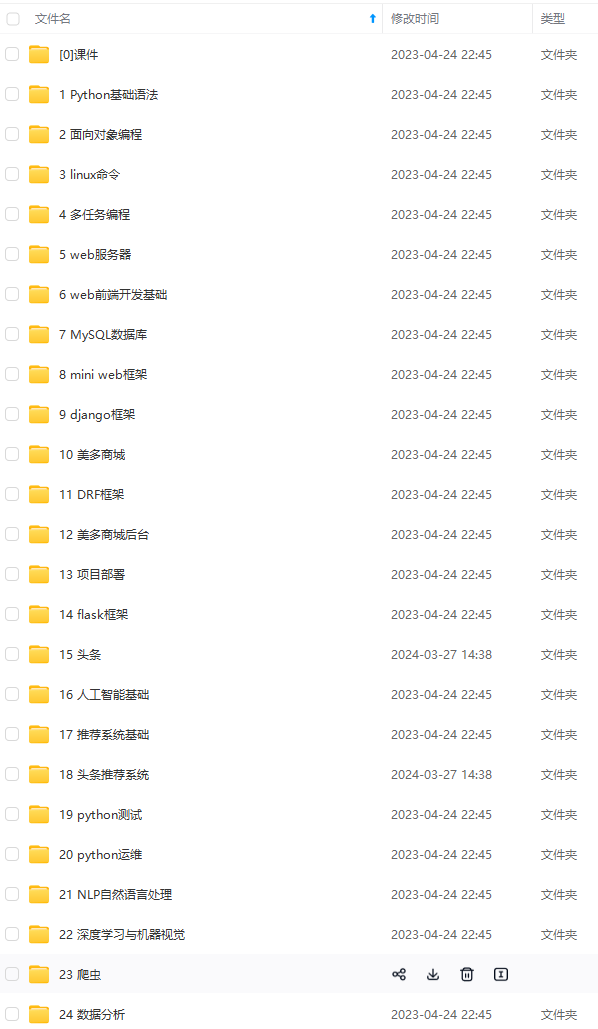

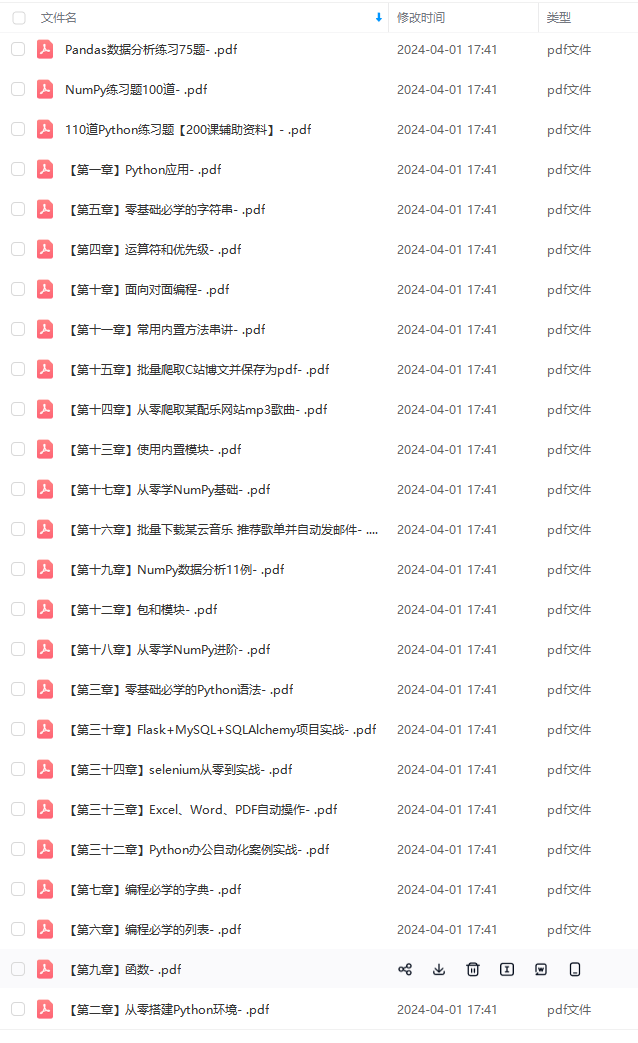

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以扫码获取!!!(备注:Python)

787673427)]

[外链图片转存中…(img-bu0N1NBq-1713787673427)]

[外链图片转存中…(img-M6AvFFV1-1713787673428)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上前端开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以扫码获取!!!(备注:Python)

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?